Périphériques technologiques

Périphériques technologiques

IA

IA

Comment construire des systèmes de synthèse vocale hautes performances avec des représentations vocales compactes

Comment construire des systèmes de synthèse vocale hautes performances avec des représentations vocales compactes

Comment construire des systèmes de synthèse vocale hautes performances avec des représentations vocales compactes

L'équipe d'algorithmes intelligents multimédia de Xiaohongshu et l'Université chinoise de Hong Kong ont proposé conjointement pour la première fois le schéma de synthèse vocale haute performance MSMC-TTS basé sur une représentation vocale compacte multi-livres de codes en plusieurs étapes. L'analyseur de caractéristiques basé sur un auto-encodeur variationnel quantifié vectoriel (VQ-VAE) utilise plusieurs livres de codes pour coder les caractéristiques acoustiques par étapes afin de former un ensemble de séquences latentes avec différentes résolutions temporelles. Ces séquences latentes peuvent être prédites à partir du texte par un prédicteur à plusieurs étapes et converties en audio cible par un vocodeur neuronal. Par rapport au système de base Fastspeech basé sur Mel-Spectrogram, cette solution présente des améliorations significatives en termes de qualité sonore et de naturel. Ce travail a maintenant été résumé dans l'article « A Multi-Stage Multi-Codebook VQ-VAE Approach to High-Performance Neural TTS » et a été accepté par la conférence du domaine vocal INTERSPEECH 2022.

1. Introduction générale

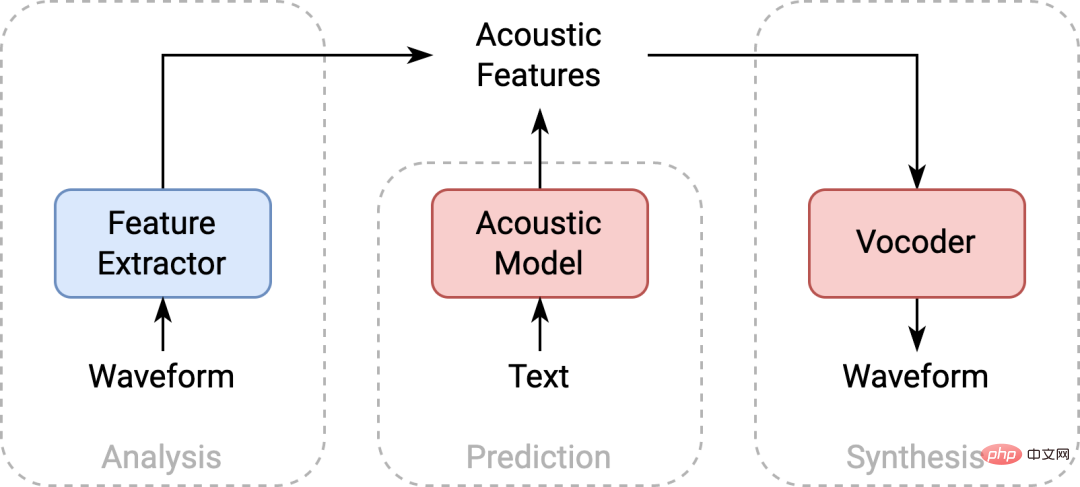

La synthèse vocale (TTS) est une technologie qui convertit le texte en parole. Elle est largement utilisée dans le doublage vidéo, la création de contenu audio et vidéo, l'interaction homme-machine intelligente et d'autres produits. La technologie de modélisation acoustique back-end des systèmes de synthèse vocale traditionnels comprend généralement trois parties : un extracteur de caractéristiques, un modèle acoustique et un vocodeur. TTS effectue généralement une modélisation acoustique sur les caractéristiques acoustiques obtenues sur la base du traitement du signal (comme le spectrogramme de Mel). Cependant, limitée par la capacité d'ajustement du modèle, il existe une certaine différence de distribution entre les caractéristiques acoustiques prédites et les données réelles. il est difficile pour un vocodeur formé sur des données réelles de générer un son de haute qualité à partir de fonctionnalités prédites.

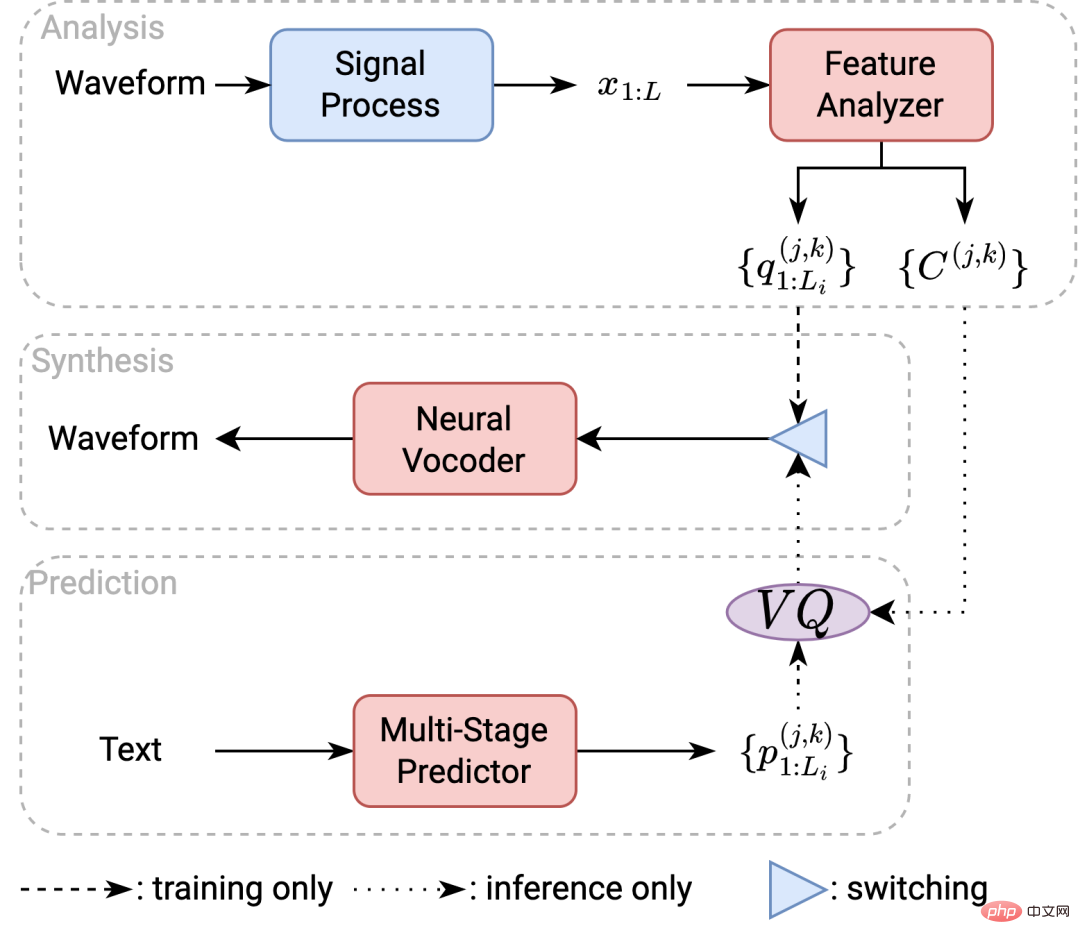

Diagramme du cadre du système TTS

En réponse à ce problème, la communauté universitaire a utilisé des structures de modèles plus complexes et des algorithmes génératifs plus nouveaux pour réduire les erreurs de prédiction et les différences de distribution. Ce travail adopte une approche différente, prenant la représentation compacte de la parole comme point de départ pour considérer le problème. Pour la synthèse vocale, 1) une bonne compacité des caractéristiques acoustiques peut garantir des résultats de prédiction de modèle plus précis et une génération de forme d'onde plus robuste 2) une bonne exhaustivité des caractéristiques acoustiques peut garantir une meilleure reconstruction des signaux vocaux ; Sur la base de ces deux considérations, cet article propose d'utiliser un auto-encodeur variationnel de quantification vectorielle (VQ-VAE) pour extraire une meilleure représentation compacte à partir des données cibles.

2. L'apprentissage des représentations MSMC VQ-VAE

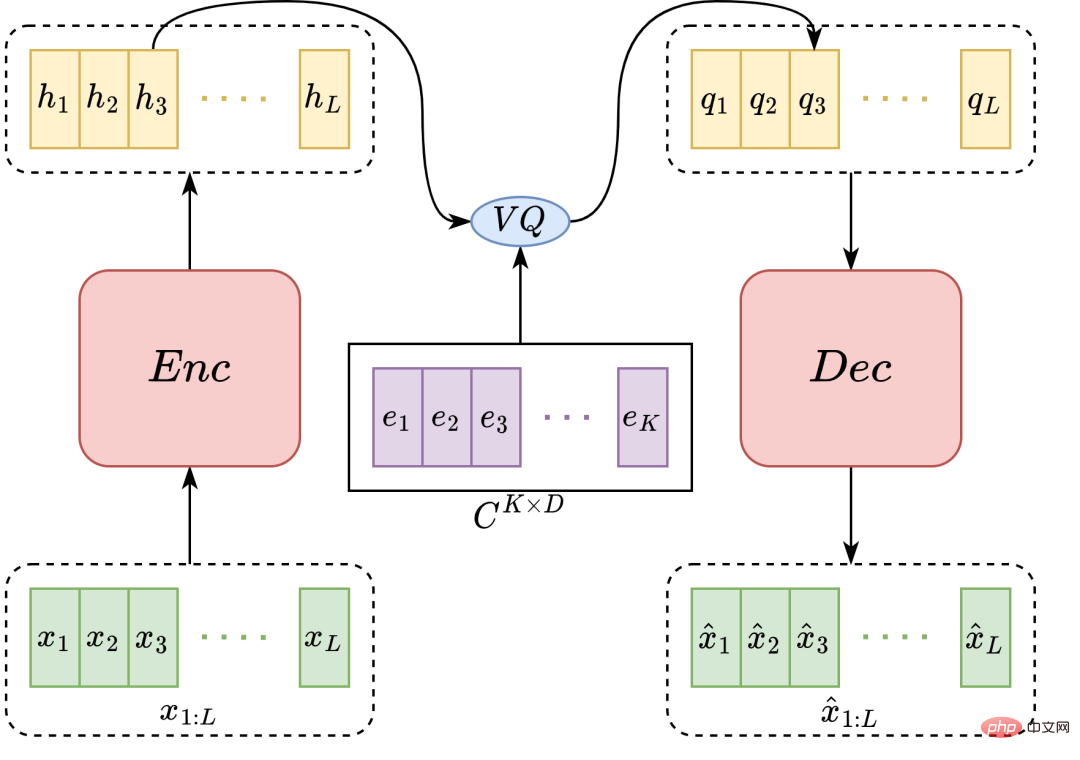

VQ-VAE comprend un encodeur et un décodeur. Le codeur traite la séquence de caractéristiques acoustiques d'entrée en une séquence latente et la quantifie à l'aide du livre de codes correspondant. Le décodeur restaure la séquence quantifiée à la séquence de caractéristiques acoustiques d'origine. Cette séquence quantifiée a une meilleure compacité (moins de nombre de paramètres caractéristiques) qu'une représentation discrétisée. Plus le degré de quantification est élevé, c'est-à-dire plus la capacité du livre de codes est petite, plus les caractéristiques sont compactes. Mais cela entraîne également une compression des informations, ce qui aggrave l’exhaustivité des fonctionnalités. Afin de garantir une exhaustivité suffisante, davantage de mots de passe sont généralement utilisés. Cependant, à mesure que la capacité du livre de codes augmente, la quantité de données requises pour la mise à jour du livre de codes et le nombre de temps de formation augmenteront de façon exponentielle, ce qui rend difficile pour VQ-VAE d'améliorer efficacement l'exhaustivité de la représentation en augmentant le livre de codes. Pour résoudre ce problème, cet article propose la méthode de quantification vectorielle multi-têtes (MHVQ).

Diagramme de structure du modèle VQ-VAE

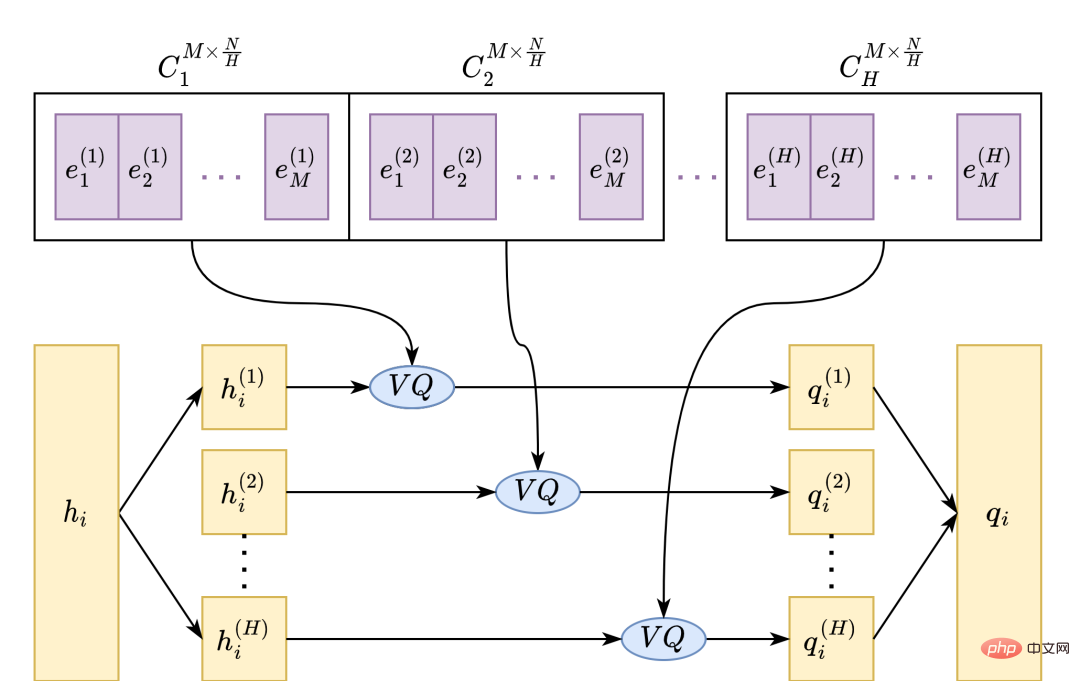

MHVQ divise un seul livre de codes en plusieurs sous-livres de codes en fonction de la direction des dimensions des fonctionnalités. Lors de la quantification, chaque vecteur d'entrée est également découpé en plusieurs sous-vecteurs, quantifiés respectivement avec les sous-livres de codes correspondants, et enfin épissé en un vecteur de sortie. De cette manière, nous pouvons améliorer plus efficacement l'utilisation du livre de codes et la capacité de représentation sans augmenter la quantité de paramètres du livre de codes. Par exemple, pour réduire le taux de compression d'un facteur 1, les mots de code doivent être augmentés jusqu'au carré du numéro du livre de codes d'origine. Après avoir utilisé MHVQ, le même taux de compression peut être obtenu en divisant simplement le livre de codes en deux parties. Par conséquent, cette méthode peut réguler plus efficacement l’exhaustivité des représentations quantitatives.

exemple d'image MHVQ

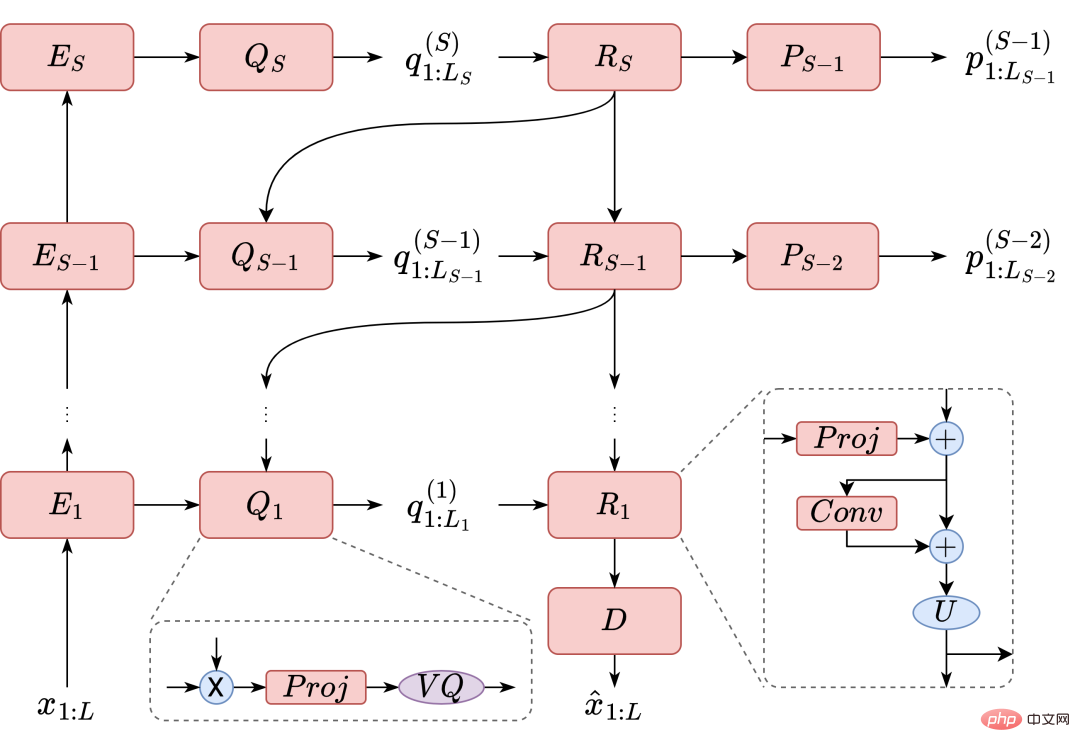

De plus, lors de la quantification de la séquence vocale, divers types d'informations contenues dans les caractéristiques vocales sont perdues à des degrés divers. Ces informations sont différentes en termes de granularité temporelle, comme le timbre à gros grain, le style de prononciation, etc., et la tonalité à grain fin, les détails de prononciation, etc. La surcompression des informations à n'importe quelle échelle de temps peut entraîner un certain degré de dégradation de la qualité de la parole. Pour pallier ce problème, ce travail propose une méthode de modélisation de la parole à plusieurs échelles de temps. Comme le montre la figure, la séquence de caractéristiques acoustiques est codée par étapes à différentes échelles de temps via plusieurs encodeurs, puis quantifiée couche par couche via le décodeur, décodée pour obtenir plusieurs séquences quantifiées avec différentes résolutions temporelles. La représentation composée de ce type d'ensemble de séquences est la représentation multi-étapes multi-codebook proposée dans ce travail.

Diagramme d'exemple de modélisation multi-étapes

3. Modélisation acoustique MSMC-TTS

En vue de la caractérisation multi-étapes multi-codebooks MSMCR, cet article propose un système TTS correspondant, à savoir le système MSMC-TTS . Le système comprend trois parties : analyse, synthèse et prédiction. Lors de la formation système, le système entraîne d’abord le module d’analyse. L'audio de l'ensemble de formation est converti en fonctionnalités acoustiques de haute complétude (telles que les fonctionnalités Mel-Spectrogram utilisées dans ce travail) après traitement du signal. Ces caractéristiques acoustiques sont utilisées pour entraîner l'analyseur de caractéristiques basé sur MSMC-VQ-VAE. À la fin de la formation, elles sont converties en MSMCR correspondant, puis le modèle acoustique et le vocodeur neuronal sont entraînés. Pendant le décodage, le système utilise un modèle acoustique pour prédire le MSMCR à partir du texte, puis utilise un vocodeur neuronal pour produire l'audio cible.

Diagramme du cadre du système MSMC-TTS

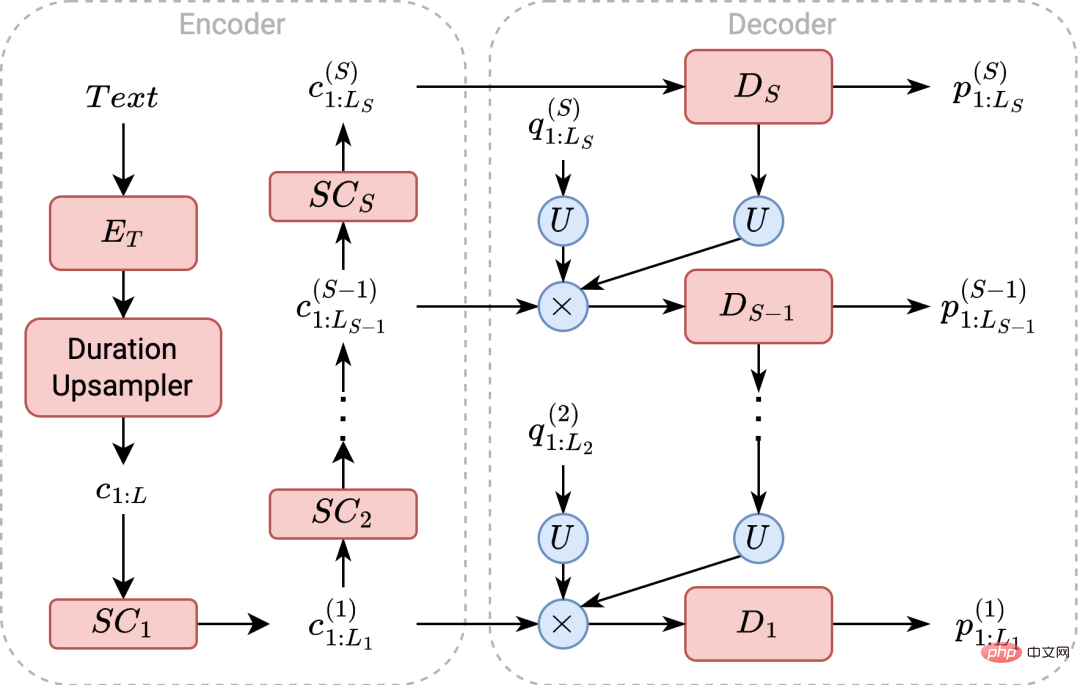

Ce travail propose également un prédicteur multi-étapes pour adapter la modélisation MSMCR. Ce modèle est implémenté sur la base de FastSpeech, mais diffère du côté du décodeur. Le modèle code d'abord le texte et suréchantillonne le texte en fonction des informations de durée prédites. La séquence est ensuite sous-échantillonnée à chaque résolution temporelle correspondant à MSMCR. Ces séquences seront décodées et quantifiées étape par étape de la basse résolution à la haute résolution par différents décodeurs. Dans le même temps, la séquence quantifiée à basse résolution est envoyée au décodeur de l'étage suivant pour faciliter la prédiction. Enfin, le MSMCR prédit est introduit dans le vocodeur neuronal pour générer l'audio cible.

Diagramme de structure du prédicteur à plusieurs étapes

Lors de la formation et de l'inférence du prédicteur à plusieurs étapes, ce travail choisit de prédire directement la représentation cible dans un espace continu. Cette méthode permet de mieux prendre en compte la relation de distance entre les vecteurs et les mots de code dans un espace linéaire continu. En plus de la fonction de perte MSE couramment utilisée pour la modélisation TTS, le critère d'entraînement utilise également une « perte triplet » pour éloigner le vecteur de prédiction des mots de code non cibles et le rapprocher du mot de code cible. En combinant les deux termes de la fonction de perte, le modèle est capable de mieux prédire le mot de code cible.

4. Résultats expérimentaux

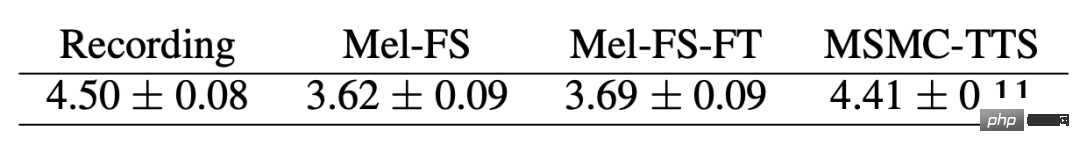

Ce travail a été mené sur l'ensemble de données public monolocuteur anglais Nancy (Blizzard Challenge 2011). Nous avons organisé un test de score d'opinion subjectif (MOS) pour évaluer l'effet de synthèse MSMC-TTS. Les résultats expérimentaux montrent que lorsque l'enregistrement original est de 4,50 points, le score MSMC-TTS est de 4,41 points et le système de base Mel-FS (FastSpeech basé sur Mel-Spectrogram) est de 3,62 points. Nous avons réglé le vocodeur du système de base pour qu'il corresponde aux caractéristiques de sortie Mel-FS, et le résultat était de 3,69 points. Ce résultat de comparaison prouve l'amélioration significative du système TTS proposé par la méthode proposée dans cet article.

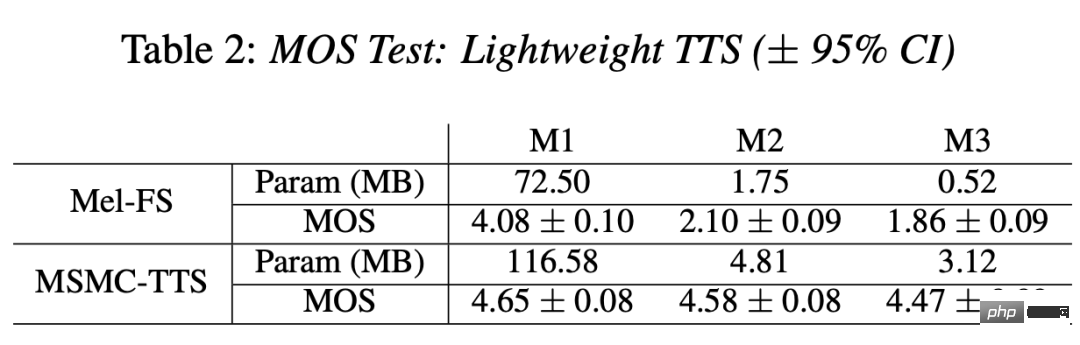

De plus, nous avons discuté plus en détail de l'impact de la complexité de la modélisation sur les performances de TTS. Le nombre de paramètres du modèle diminue de façon exponentielle de M1 à M3 et l'effet de synthèse Mel-FS chute à 1,86 points. En revanche, pour MSMC-TTS, la réduction du nombre de paramètres n’a pas eu d’impact significatif sur la qualité de la synthèse. Lorsque la taille du paramètre du modèle acoustique est de 3,12 Mo, le MOS peut toujours conserver 4,47 points. Cela démontre non seulement les exigences de faible complexité de la modélisation MSMC-TTS basée sur des fonctionnalités compactes, mais démontre également le potentiel de cette méthode à être appliquée aux systèmes TTS légers.

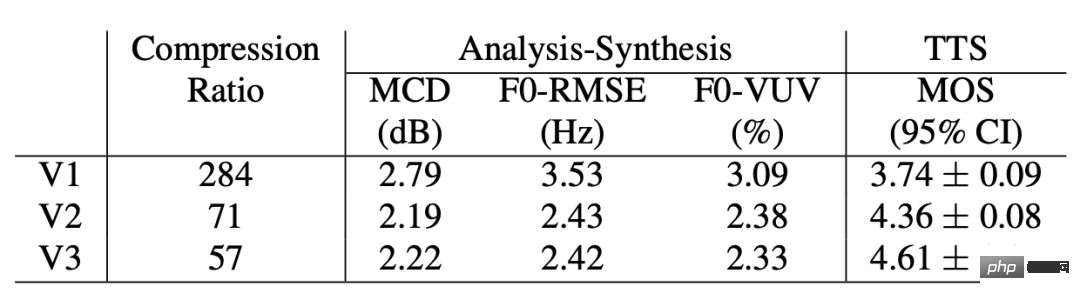

Enfin, nous avons effectué une comparaison MSMC-TTS basée sur différents MSMCR pour explorer l'impact du MHVQ et de la modélisation multi-étapes sur le TTS. Parmi eux, le système V1 utilise une représentation de livre de codes unique en une seule étape, le système V2 utilise une quantification vectorielle à 4 têtes basée sur V1 et le système V3 utilise une modélisation en deux étapes basée sur V2. Premièrement, la représentation utilisée par le système V1 a le taux de compression des caractéristiques le plus élevé, mais présente la plus faible exhaustivité dans les expériences de synthèse d'analyse et la pire qualité de synthèse dans les expériences TTS. Après que MHVQ ait amélioré l'exhaustivité, le système V2 a également été considérablement amélioré en termes d'effet TTS. Bien que la représentation multi-étapes utilisée par la V3 n'ait pas montré d'autres améliorations en termes d'exhaustivité, elle a montré les meilleurs résultats sur TTS, avec des améliorations significatives à la fois du naturel rythmique et de la qualité audio. Cela montre en outre que la modélisation à plusieurs étapes et la conservation des informations à plusieurs échelles revêtent une grande importance dans MSMC-TTS.

5. Résumé

Ce travail propose une nouvelle méthode de modélisation TTS (MSMC-TTS) haute performance dans la perspective de l'étude de la représentation compacte de la parole. Le système extrait des représentations multi-livres de codes en plusieurs étapes à partir de l'audio à la place des caractéristiques acoustiques traditionnelles. Le texte d'entrée peut être converti en cette représentation vocale composée de multiples séquences avec différentes résolutions temporelles par un prédicteur à plusieurs étages et converti en un signal vocal cible par un vocodeur neuronal. Les résultats expérimentaux montrent que, comparé au système FastSpeech traditionnel basé sur Mel-Spectrogram, ce système présente une meilleure qualité de synthèse et des exigences moindres en matière de complexité de modélisation.

6. Informations sur l'auteur

Guo Haohan : stagiaire de l'équipe d'algorithmes intelligents multimédia de Xiaohongshu. Il est diplômé de la Northwestern Polytechnical University avec un baccalauréat et a étudié dans le laboratoire ASLP sous la direction du professeur Xie Lei. Actuellement, il étudie pour son doctorat au laboratoire HCCL de l'Université chinoise de Hong Kong, sous la direction du professeur Meng Meiling. Jusqu'à présent, en tant que premier auteur, six articles ont été publiés lors des conférences internationales ICASSP, INTERSPEECH et SLT.

Xie Fenglong : responsable de la technologie vocale de l'équipe d'algorithmes intelligents multimédia de Xiaohongshu. Il a publié plus de dix articles dans des conférences et des revues vocales telles que ICASSP, INTERSPEECH et SPEECHCOM. Il a longtemps été critique pour de grandes conférences vocales telles que ICASSP et INTERSPEECH. Son principal domaine de recherche est le traitement et la modélisation des signaux vocaux.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

Video Face Swap

Échangez les visages dans n'importe quelle vidéo sans effort grâce à notre outil d'échange de visage AI entièrement gratuit !

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Sujets chauds

Méthodes et étapes d'utilisation de BERT pour l'analyse des sentiments en Python

Jan 22, 2024 pm 04:24 PM

Méthodes et étapes d'utilisation de BERT pour l'analyse des sentiments en Python

Jan 22, 2024 pm 04:24 PM

BERT est un modèle de langage d'apprentissage profond pré-entraîné proposé par Google en 2018. Le nom complet est BidirectionnelEncoderRepresentationsfromTransformers, qui est basé sur l'architecture Transformer et présente les caractéristiques d'un codage bidirectionnel. Par rapport aux modèles de codage unidirectionnels traditionnels, BERT peut prendre en compte les informations contextuelles en même temps lors du traitement du texte, de sorte qu'il fonctionne bien dans les tâches de traitement du langage naturel. Sa bidirectionnalité permet à BERT de mieux comprendre les relations sémantiques dans les phrases, améliorant ainsi la capacité expressive du modèle. Grâce à des méthodes de pré-formation et de réglage fin, BERT peut être utilisé pour diverses tâches de traitement du langage naturel, telles que l'analyse des sentiments, la dénomination

Analyse des fonctions d'activation de l'IA couramment utilisées : pratique d'apprentissage en profondeur de Sigmoid, Tanh, ReLU et Softmax

Dec 28, 2023 pm 11:35 PM

Analyse des fonctions d'activation de l'IA couramment utilisées : pratique d'apprentissage en profondeur de Sigmoid, Tanh, ReLU et Softmax

Dec 28, 2023 pm 11:35 PM

Les fonctions d'activation jouent un rôle crucial dans l'apprentissage profond. Elles peuvent introduire des caractéristiques non linéaires dans les réseaux neuronaux, permettant ainsi au réseau de mieux apprendre et simuler des relations entrées-sorties complexes. La sélection et l'utilisation correctes des fonctions d'activation ont un impact important sur les performances et les résultats de formation des réseaux de neurones. Cet article présentera quatre fonctions d'activation couramment utilisées : Sigmoid, Tanh, ReLU et Softmax, à partir de l'introduction, des scénarios d'utilisation, des avantages, Les inconvénients et les solutions d'optimisation sont abordés pour vous fournir une compréhension complète des fonctions d'activation. 1. Fonction sigmoïde Introduction à la formule de la fonction SIgmoïde : La fonction sigmoïde est une fonction non linéaire couramment utilisée qui peut mapper n'importe quel nombre réel entre 0 et 1. Il est généralement utilisé pour unifier le

Au-delà d'ORB-SLAM3 ! SL-SLAM : les scènes de faible luminosité, de gigue importante et de texture faible sont toutes gérées

May 30, 2024 am 09:35 AM

Au-delà d'ORB-SLAM3 ! SL-SLAM : les scènes de faible luminosité, de gigue importante et de texture faible sont toutes gérées

May 30, 2024 am 09:35 AM

Écrit précédemment, nous discutons aujourd'hui de la manière dont la technologie d'apprentissage profond peut améliorer les performances du SLAM (localisation et cartographie simultanées) basé sur la vision dans des environnements complexes. En combinant des méthodes d'extraction de caractéristiques approfondies et de correspondance de profondeur, nous introduisons ici un système SLAM visuel hybride polyvalent conçu pour améliorer l'adaptation dans des scénarios difficiles tels que des conditions de faible luminosité, un éclairage dynamique, des zones faiblement texturées et une gigue importante. Notre système prend en charge plusieurs modes, notamment les configurations étendues monoculaire, stéréo, monoculaire-inertielle et stéréo-inertielle. En outre, il analyse également comment combiner le SLAM visuel avec des méthodes d’apprentissage profond pour inspirer d’autres recherches. Grâce à des expériences approfondies sur des ensembles de données publiques et des données auto-échantillonnées, nous démontrons la supériorité du SL-SLAM en termes de précision de positionnement et de robustesse du suivi.

Intégration d'espace latent : explication et démonstration

Jan 22, 2024 pm 05:30 PM

Intégration d'espace latent : explication et démonstration

Jan 22, 2024 pm 05:30 PM

L'intégration d'espace latent (LatentSpaceEmbedding) est le processus de mappage de données de grande dimension vers un espace de faible dimension. Dans le domaine de l'apprentissage automatique et de l'apprentissage profond, l'intégration d'espace latent est généralement un modèle de réseau neuronal qui mappe les données d'entrée de grande dimension dans un ensemble de représentations vectorielles de basse dimension. Cet ensemble de vecteurs est souvent appelé « vecteurs latents » ou « latents ». encodages". Le but de l’intégration de l’espace latent est de capturer les caractéristiques importantes des données et de les représenter sous une forme plus concise et compréhensible. Grâce à l'intégration de l'espace latent, nous pouvons effectuer des opérations telles que la visualisation, la classification et le regroupement de données dans un espace de faible dimension pour mieux comprendre et utiliser les données. L'intégration d'espace latent a de nombreuses applications dans de nombreux domaines, tels que la génération d'images, l'extraction de caractéristiques, la réduction de dimensionnalité, etc. L'intégration de l'espace latent est le principal

Des bases à la pratique, passez en revue l'historique du développement de la récupération de vecteurs Elasticsearch.

Oct 23, 2023 pm 05:17 PM

Des bases à la pratique, passez en revue l'historique du développement de la récupération de vecteurs Elasticsearch.

Oct 23, 2023 pm 05:17 PM

1. Introduction La récupération de vecteurs est devenue un élément essentiel des systèmes modernes de recherche et de recommandation. Il permet une correspondance de requêtes et des recommandations efficaces en convertissant des objets complexes (tels que du texte, des images ou des sons) en vecteurs numériques et en effectuant des recherches de similarité dans des espaces multidimensionnels. Des bases à la pratique, passez en revue l'historique du développement d'Elasticsearch. vector retrieval_elasticsearch En tant que moteur de recherche open source populaire, le développement d'Elasticsearch en matière de récupération de vecteurs a toujours attiré beaucoup d'attention. Cet article passera en revue l'historique du développement de la récupération de vecteurs Elasticsearch, en se concentrant sur les caractéristiques et la progression de chaque étape. En prenant l'historique comme guide, il est pratique pour chacun d'établir une gamme complète de récupération de vecteurs Elasticsearch.

Comprendre en un seul article : les liens et les différences entre l'IA, le machine learning et le deep learning

Mar 02, 2024 am 11:19 AM

Comprendre en un seul article : les liens et les différences entre l'IA, le machine learning et le deep learning

Mar 02, 2024 am 11:19 AM

Dans la vague actuelle de changements technologiques rapides, l'intelligence artificielle (IA), l'apprentissage automatique (ML) et l'apprentissage profond (DL) sont comme des étoiles brillantes, à la tête de la nouvelle vague des technologies de l'information. Ces trois mots apparaissent fréquemment dans diverses discussions de pointe et applications pratiques, mais pour de nombreux explorateurs novices dans ce domaine, leurs significations spécifiques et leurs connexions internes peuvent encore être entourées de mystère. Alors regardons d'abord cette photo. On constate qu’il existe une corrélation étroite et une relation progressive entre l’apprentissage profond, l’apprentissage automatique et l’intelligence artificielle. Le deep learning est un domaine spécifique du machine learning, et le machine learning

Super fort! Top 10 des algorithmes de deep learning !

Mar 15, 2024 pm 03:46 PM

Super fort! Top 10 des algorithmes de deep learning !

Mar 15, 2024 pm 03:46 PM

Près de 20 ans se sont écoulés depuis que le concept d'apprentissage profond a été proposé en 2006. L'apprentissage profond, en tant que révolution dans le domaine de l'intelligence artificielle, a donné naissance à de nombreux algorithmes influents. Alors, selon vous, quels sont les 10 meilleurs algorithmes pour l’apprentissage profond ? Voici les meilleurs algorithmes d’apprentissage profond, à mon avis. Ils occupent tous une position importante en termes d’innovation, de valeur d’application et d’influence. 1. Contexte du réseau neuronal profond (DNN) : Le réseau neuronal profond (DNN), également appelé perceptron multicouche, est l'algorithme d'apprentissage profond le plus courant lorsqu'il a été inventé pour la première fois, jusqu'à récemment en raison du goulot d'étranglement de la puissance de calcul. années, puissance de calcul, La percée est venue avec l'explosion des données. DNN est un modèle de réseau neuronal qui contient plusieurs couches cachées. Dans ce modèle, chaque couche transmet l'entrée à la couche suivante et

AlphaFold 3 est lancé, prédisant de manière exhaustive les interactions et les structures des protéines et de toutes les molécules de la vie, avec une précision bien plus grande que jamais

Jul 16, 2024 am 12:08 AM

AlphaFold 3 est lancé, prédisant de manière exhaustive les interactions et les structures des protéines et de toutes les molécules de la vie, avec une précision bien plus grande que jamais

Jul 16, 2024 am 12:08 AM

Editeur | Radis Skin Depuis la sortie du puissant AlphaFold2 en 2021, les scientifiques utilisent des modèles de prédiction de la structure des protéines pour cartographier diverses structures protéiques dans les cellules, découvrir des médicaments et dresser une « carte cosmique » de chaque interaction protéique connue. Tout à l'heure, Google DeepMind a publié le modèle AlphaFold3, capable d'effectuer des prédictions de structure conjointe pour des complexes comprenant des protéines, des acides nucléiques, de petites molécules, des ions et des résidus modifiés. La précision d’AlphaFold3 a été considérablement améliorée par rapport à de nombreux outils dédiés dans le passé (interaction protéine-ligand, interaction protéine-acide nucléique, prédiction anticorps-antigène). Cela montre qu’au sein d’un cadre unique et unifié d’apprentissage profond, il est possible de réaliser