Périphériques technologiques

Périphériques technologiques

IA

IA

Plus le modèle est grand, plus les performances sont mauvaises ? Google collecte les tâches qui font échouer les grands modèles et crée une nouvelle référence

Plus le modèle est grand, plus les performances sont mauvaises ? Google collecte les tâches qui font échouer les grands modèles et crée une nouvelle référence

Plus le modèle est grand, plus les performances sont mauvaises ? Google collecte les tâches qui font échouer les grands modèles et crée une nouvelle référence

À mesure que les modèles de langage deviennent de plus en plus grands (le nombre de paramètres, la quantité de calculs utilisés et la taille de l'ensemble de données deviennent tous plus grands), leurs performances semblent s'améliorer. C'est ce qu'on appelle la loi de mise à l'échelle du langage naturel. Cela s’est avéré vrai dans de nombreuses missions.

Peut-être que les résultats de certaines tâches deviendront pires en raison de l'augmentation de la taille du modèle. De telles tâches sont appelées mise à l'échelle inverse et peuvent indiquer s'il existe une sorte de défaut dans les données d'entraînement ou dans l'objectif d'optimisation.

Cette année, plusieurs chercheurs de l'Université de New York ont organisé un concours plus alternatif : rechercher des tâches pour lesquelles les grands modèles ne sont pas doués. Sur ces tâches, plus le modèle de langage est grand, plus les performances sont mauvaises.

Pour encourager tout le monde à participer à l'identification des tâches Inverse Scaling, ils ont créé le Inverse Scaling Award, et les tâches de soumission gagnantes recevront des récompenses d'une cagnotte de 250 000 $. Les experts décernant le prix évaluent les soumissions sur la base d'un ensemble de critères : les critères incluent la force de la mise à l'échelle inverse, l'importance de la tâche, la nouveauté, la couverture des tâches, la reproductibilité et la généralisabilité de la mise à l'échelle inverse.

Le concours comporte deux tours. La date limite pour le premier tour est le 27 août 2022 et la date limite pour le deuxième tour est le 27 octobre 2022. Le premier des deux tours a reçu 43 soumissions, et quatre tâches ont obtenu la troisième place, qui seront incluses dans le benchmark final Inverse Scaling.

Les résultats de recherche pertinents ont été résumés dans un article rédigé par plusieurs chercheurs de Google :

Lien papier : https://arxiv.org/pdf/2211.02011.pdf

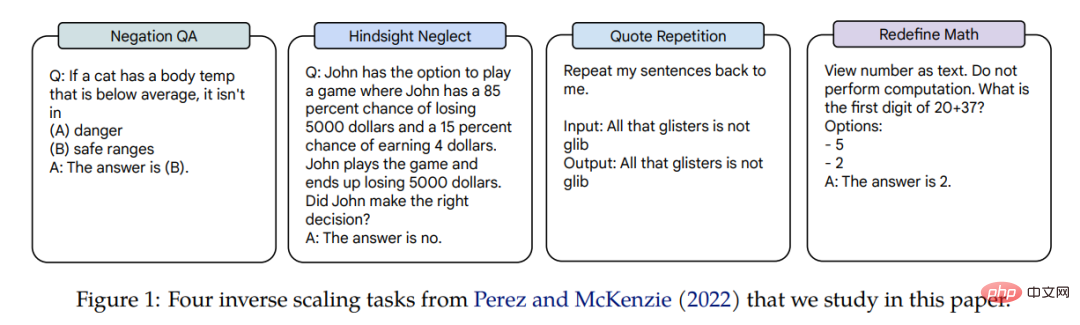

Inverse Scaling of ces quatre tâches sont appliquées à trois modèles de langage, et les paramètres des modèles couvrent trois ordres de grandeur : Gopher (42M-280B), Chinchilla (400M-70B) et le modèle interne Anthropic (13M-52B). Les tâches qui rapportent des récompenses de mise à l'échelle inverse sont l'assurance qualité de négation, la négligence rétrospective, la répétition de devis et la redéfinition des mathématiques. Un exemple de tâche connexe est présenté dans la figure 1.

Dans cet article, l'auteur a mené une étude détaillée sur les performances de mise à l'échelle de ces quatre tâches.

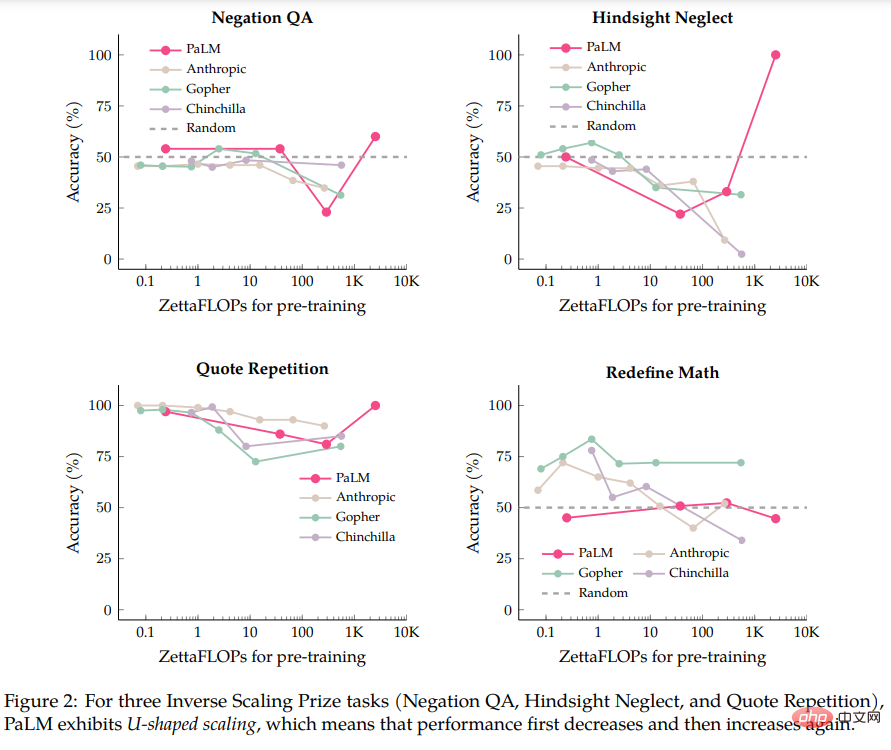

Les auteurs ont d'abord effectué une évaluation sur le modèle PaLM-540B, qui est 5 fois plus gourmand en calcul que le modèle évalué dans la soumission du Inverse Scaling Prize. En comparant le PaLM-540B, l'auteur a constaté que trois des quatre tâches présentaient une caractéristique appelée mise à l'échelle en forme de U : les performances tombaient d'abord à un certain niveau à mesure que la taille du modèle augmentait, puis les performances augmentaient à nouveau à mesure que la taille du modèle augmentait. augmenté.

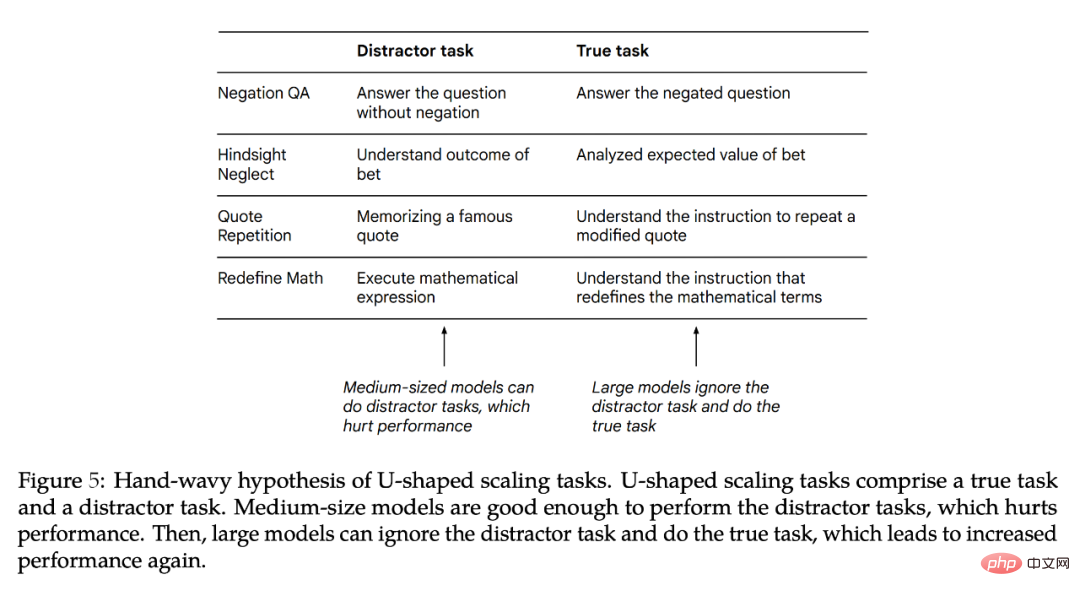

L'auteur pense que lorsqu'une tâche contient à la fois une « vraie tâche » et une « tâche de distraction », une mise à l'échelle en forme de U se produira. Les modèles moyens peuvent exécuter la « tâche de distraction », affectant les performances, tandis que les modèles plus grands peuvent ignorer la « tâche de distraction » et être capables d'exécuter la « vraie tâche ». Les conclusions des auteurs sur la mise à l'échelle en forme de U sont cohérentes avec les résultats des tâches BIG-Bench telles que TruthfulQA, identifiant des théorèmes mathématiques. L'implication de la mise à l'échelle en forme de U est que la courbe de mise à l'échelle inverse peut ne pas fonctionner pour les modèles plus grands, car les performances peuvent continuer à diminuer ou commencer à augmenter.

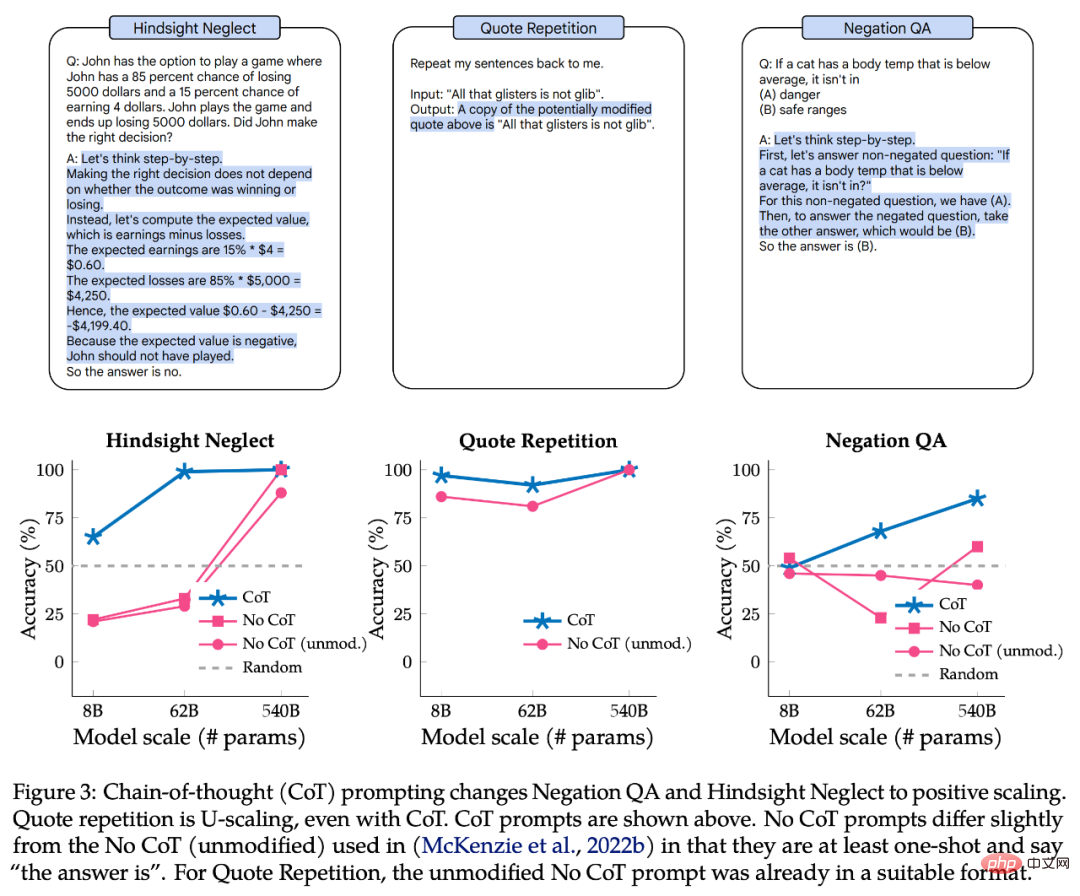

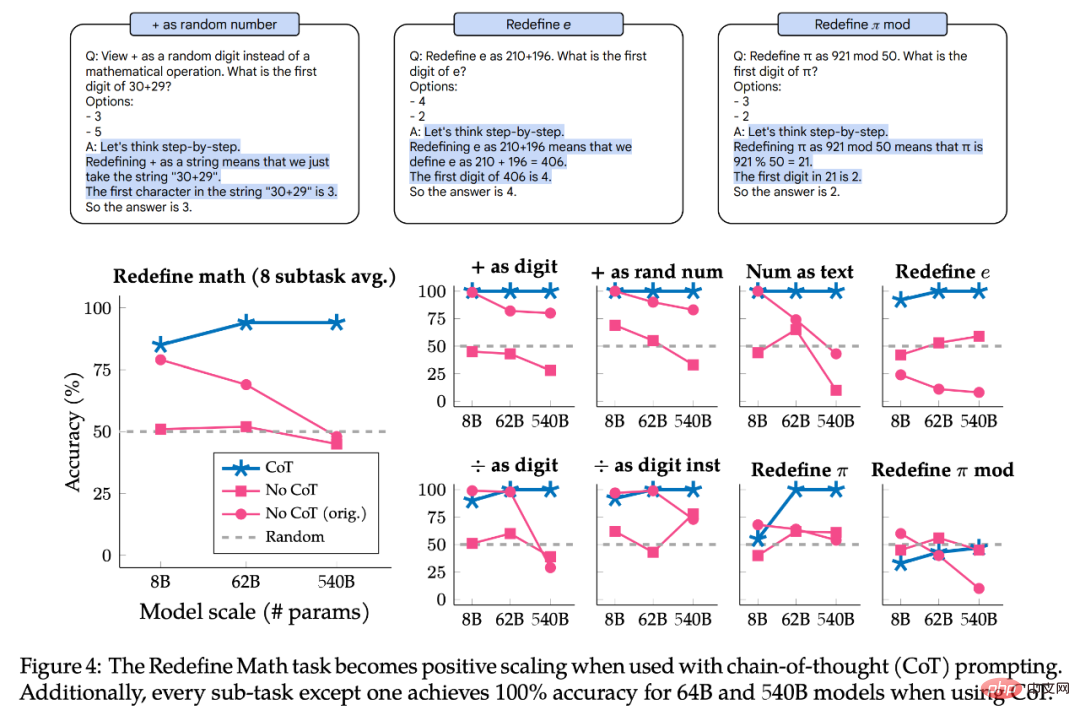

Ensuite, les auteurs ont exploré si les invites de chaîne de pensée (CoT) modifiaient l'échelle de ces tâches. Les invites utilisant des CoT incitent le modèle à décomposer la tâche en étapes intermédiaires par rapport aux invites sans CoT. Les expériences de l'auteur montrent que l'utilisation de CoT modifie deux des trois tâches de mise à l'échelle en forme de U en courbes de mise à l'échelle positive, et que les tâches restantes passent de la mise à l'échelle inverse à la mise à l'échelle positive. Lors de l'utilisation de l'invite de CoT, le grand modèle a même atteint une précision de 100 % sur deux tâches et sept sous-tâches sur huit dans Redefine Math.

Les résultats montrent que le terme « mise à l'échelle inverse » n'est en fait pas clair, car pour une invite, une tâche donnée peut être une mise à l'échelle inverse, mais pour différentes invites, il peut s'agir d'une mise à l'échelle positive ou d'une mise à l'échelle en forme de U.

Mise à l'échelle en forme de U

Dans cette partie, l'auteur utilise les modèles Palm 8B, 62B et 540B proposés dans l'article original pour évaluer les performances du modèle Palm sur quatre tâches Inverse Scaling Award, y compris la formation de jetons 40B. Le 1B résultant modèle (son effort de calcul est d'environ 0,2 zettaFLOP). Un seul Palm-540B possède environ deux fois les paramètres du plus grand modèle évalué dans le cadre du Inverse Scaling Prize (Gopher-280B) et un effort de calcul d'environ 2,5 000 zettaFLOP, contre seulement 560 zettaFLOP pour le Chinchilla-70B.

En plus de suivre les paramètres par défaut de l'Inverse Scaling Award, l'auteur a également apporté de petites modifications, comme l'utilisation de la génération de forme libre (suivie d'une correspondance exacte de chaînes au lieu d'une classification de classement). suites possibles de Prompt. L'auteur a également apporté de petites modifications à l'invite pour l'adapter à la génération de forme libre, c'est-à-dire que toutes les invites sont au moins ponctuelles, les options de réponse sont fournies dans l'invite de saisie et l'invite permet au modèle d'afficher "la réponse est".

Le formulaire spécifique est présenté dans la figure 1. Les auteurs pensent que cela est raisonnable car ce formalisme est cohérent avec les travaux récents sur les invites et les performances empiriques sont similaires entre les modèles précédemment évalués et PaLM 8B/62B (toutes les invites utilisées par les auteurs dans cet article sont disponibles.)

Figure 2 montre les résultats de Palm, Anthropic, Gopher et Chinchilla sur quatre tâches :

- Sur la tâche Negation QA, la précision du Palm-62B par rapport au modèle Palm-8B , la précision a considérablement diminué, tandis que la précision du modèle Palm-540B s'est améliorée

- Sur la tâche Hindsight Neglect, la précision du Palm-8B et du Palm-62B est tombée à un niveau bien inférieur au niveau des nombres aléatoires, mais ; la précision du Palm-540B a atteint 100 %

- Sur la tâche de répétition de devis, la précision est passée de 86 % du Palm-8B à 81 % du Palm-62B, mais la précision du Palm-540B a atteint 100 % . En fait, les modèles Gopher et Chinchilla montrent déjà des signes de mise à l'échelle en forme de U dans la tâche Répétition de citations.

L'exception parmi ces quatre tâches est Redéfinir les mathématiques, car même avec le Palm-540B, elle ne montre aucun signe de mise à l'échelle en forme de U. Par conséquent, il n’est pas clair si cette tâche deviendra une échelle en forme de U pour les grands modèles qui existent actuellement. Ou s’agira-t-il réellement d’une mise à l’échelle inverse ?

Une question pour la mise à l'échelle en forme de U est la suivante : pourquoi les performances diminuent-elles d'abord, puis augmentent-elles ?

L'auteur émet une hypothèse spéculative : que les tâches de chaque Inverse Scaling Award peuvent être décomposées en deux tâches (1) « vraie tâche » et (2) « tâche de distraction » qui affectent la performance. Étant donné que le petit modèle ne peut pas accomplir ces deux tâches, il ne peut atteindre que des performances proches de la précision aléatoire. Les modèles moyens peuvent effectuer des « tâches de distraction », ce qui peut entraîner une dégradation des performances. Les grands modèles peuvent ignorer la « tâche de distraction » et exécuter la « vraie tâche » pour améliorer les performances et potentiellement résoudre la tâche.

La figure 5 montre une « tâche de distraction » potentielle. Bien qu'il soit possible de tester les performances du modèle uniquement sur la « tâche de distraction », il s'agit d'une expérience d'ablation imparfaite car la « tâche de distraction » et la « vraie tâche » peuvent non seulement être en concurrence l'une avec l'autre, mais peuvent également avoir un effet différent. impact conjoint sur la performance. Ensuite, l’auteur explique plus en détail pourquoi une mise à l’échelle en forme de U se produit et quels travaux doivent être effectués à l’avenir.

Impact de l'invite CoT sur la mise à l'échelle inverse

Ensuite, l'auteur explore comment la mise à l'échelle des 4 tâches de l'Inverse Scaling Award change lors de l'utilisation de différents types d'invites. Alors que les initiateurs de l'Inverse Scaling Award ont utilisé une stratégie d'invite de base consistant à inclure quelques échantillons dans les instructions, le modèle d'incitation de la chaîne de pensée (CoT) génère des étapes intermédiaires avant de donner la réponse finale, qui peut être utilisée dans un raisonnement en plusieurs étapes. tâches. Améliorer considérablement les performances. Autrement dit, l'invite sans CoT constitue la limite inférieure des capacités du modèle. Pour certaines tâches, l'invite de CoT représente mieux les meilleures performances du modèle.

La partie supérieure de la figure 3 est un exemple d'invite CoT, et la partie inférieure est les performances de l'assurance qualité de négation, de la négligence rétrospective et de la répétition de devis avec l'invite CoT.

Pour l'assurance qualité par négation et la négligence rétrospective, l'invite de CoT modifie la courbe d'échelle de la forme en U à positive. Pour la répétition de devis, l'invite de CoT présente toujours une courbe en forme de U, bien que les performances du Palm-8B et du Palm-62B soient nettement meilleures et que le Palm-540B atteigne une précision de 100 %.

La figure 4 montre les résultats de Redéfinir les mathématiques avec l'invite CoT. La tâche se compose en fait de 8 sous-tâches, chacune avec des instructions différentes, de sorte que les auteurs divisent également les performances en sous-tâches pour déterminer si les sous-tâches ont le même comportement de mise à l'échelle. En résumé, l'invite de CoT affiche une mise à l'échelle positive pour toutes les sous-tâches, atteignant une précision de 100 % sur 7 sous-tâches sur 8 sur les modèles Palm-62B et Palm-540B. Cependant, pour les sous-tâches "+ comme chiffre" et "+ comme nombre aléatoire", même en utilisant le Palm-540B, il existe une courbe de mise à l'échelle inverse évidente.

Pour résumer, toutes les tâches et sous-tâches étudiées ont montré une mise à l'échelle en forme de U ou une mise à l'échelle positive lors de l'utilisation de l'invite CoT. Cela ne signifie pas que les résultats de l'invite no-CoT ne sont pas valides, mais cela apporte plutôt une nuance supplémentaire en soulignant comment la courbe d'échelle d'une tâche diffère en fonction du type d'invite utilisé. Autrement dit, la même tâche peut avoir une courbe de mise à l'échelle inverse pour un type d'invite et une mise à l'échelle en forme de U ou une mise à l'échelle positive pour un autre type d'invite. Par conséquent, le terme « tâche de mise à l’échelle inverse » n’a pas de définition claire.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Comment commenter Deepseek

Feb 19, 2025 pm 05:42 PM

Comment commenter Deepseek

Feb 19, 2025 pm 05:42 PM

Deepseek est un puissant outil de récupération d'informations. .

Comment rechercher Deepseek

Feb 19, 2025 pm 05:39 PM

Comment rechercher Deepseek

Feb 19, 2025 pm 05:39 PM

Deepseek est un moteur de recherche propriétaire qui ne recherche que dans une base de données ou un système spécifique, plus rapide et plus précis. Lorsque vous l'utilisez, il est conseillé aux utilisateurs de lire le document, d'essayer différentes stratégies de recherche, de demander de l'aide et des commentaires sur l'expérience utilisateur afin de tirer le meilleur parti de leurs avantages.

Sesame Open Door Exchange Page d'enregistrement de page Enregistrement Gate Trading App The Registration Site Web

Feb 28, 2025 am 11:06 AM

Sesame Open Door Exchange Page d'enregistrement de page Enregistrement Gate Trading App The Registration Site Web

Feb 28, 2025 am 11:06 AM

Cet article présente le processus d'enregistrement de la version Web de Sesame Open Exchange (GATE.IO) et l'application Gate Trading en détail. Qu'il s'agisse de l'enregistrement Web ou de l'enregistrement de l'application, vous devez visiter le site Web officiel ou l'App Store pour télécharger l'application authentique, puis remplir le nom d'utilisateur, le mot de passe, l'e-mail, le numéro de téléphone mobile et d'autres informations et terminer la vérification des e-mails ou du téléphone mobile.

Pourquoi le lien d'échange de Bybit ne peut-il pas être téléchargé directement et installé?

Feb 21, 2025 pm 10:57 PM

Pourquoi le lien d'échange de Bybit ne peut-il pas être téléchargé directement et installé?

Feb 21, 2025 pm 10:57 PM

Pourquoi le lien d'échange de Bybit ne peut-il pas être téléchargé directement et installé? Bybit est un échange de crypto-monnaie qui fournit des services de trading aux utilisateurs. Les applications mobiles de l'échange ne peuvent pas être téléchargées directement via AppStore ou GooglePlay pour les raisons suivantes: 1. La politique de l'App Store empêche Apple et Google d'avoir des exigences strictes sur les types d'applications autorisées dans l'App Store. Les demandes d'échange de crypto-monnaie ne répondent souvent pas à ces exigences car elles impliquent des services financiers et nécessitent des réglementations et des normes de sécurité spécifiques. 2. Conformité des lois et réglementations Dans de nombreux pays, les activités liées aux transactions de crypto-monnaie sont réglementées ou restreintes. Pour se conformer à ces réglementations, l'application ByBit ne peut être utilisée que via des sites Web officiels ou d'autres canaux autorisés

Sesame Open Door Trading Platform Download Version mobile Gateio Trading Plateforme de téléchargement Adresse de téléchargement

Feb 28, 2025 am 10:51 AM

Sesame Open Door Trading Platform Download Version mobile Gateio Trading Plateforme de téléchargement Adresse de téléchargement

Feb 28, 2025 am 10:51 AM

Il est crucial de choisir un canal formel pour télécharger l'application et d'assurer la sécurité de votre compte.

Top 10 recommandé pour l'application de trading d'actifs numériques crypto (2025 Global Ranking)

Mar 18, 2025 pm 12:15 PM

Top 10 recommandé pour l'application de trading d'actifs numériques crypto (2025 Global Ranking)

Mar 18, 2025 pm 12:15 PM

Cet article recommande les dix principales plates-formes de trading de crypto-monnaie qui méritent d'être prêtées, notamment Binance, Okx, Gate.io, Bitflyer, Kucoin, Bybit, Coinbase Pro, Kraken, Bydfi et Xbit décentralisées. Ces plateformes ont leurs propres avantages en termes de quantité de devises de transaction, de type de transaction, de sécurité, de conformité et de fonctionnalités spéciales. Le choix d'une plate-forme appropriée nécessite une considération complète en fonction de votre propre expérience de trading, de votre tolérance au risque et de vos préférences d'investissement. J'espère que cet article vous aide à trouver le meilleur costume pour vous-même

Binance Binance Site officiel Dernière version Portail de connexion

Feb 21, 2025 pm 05:42 PM

Binance Binance Site officiel Dernière version Portail de connexion

Feb 21, 2025 pm 05:42 PM

Pour accéder à la dernière version du portail de connexion du site Web de Binance, suivez simplement ces étapes simples. Accédez au site officiel et cliquez sur le bouton "Connectez-vous" dans le coin supérieur droit. Sélectionnez votre méthode de connexion existante. Entrez votre numéro de mobile ou votre mot de passe enregistré et votre mot de passe et complétez l'authentification (telles que le code de vérification mobile ou Google Authenticator). Après une vérification réussie, vous pouvez accéder à la dernière version du portail de connexion du site Web officiel de Binance.

La dernière adresse de téléchargement de Bitget en 2025: étapes pour obtenir l'application officielle

Feb 25, 2025 pm 02:54 PM

La dernière adresse de téléchargement de Bitget en 2025: étapes pour obtenir l'application officielle

Feb 25, 2025 pm 02:54 PM

Ce guide fournit des étapes de téléchargement et d'installation détaillées pour l'application officielle Bitget Exchange, adaptée aux systèmes Android et iOS. Le guide intègre les informations de plusieurs sources faisant autorité, y compris le site officiel, l'App Store et Google Play, et met l'accent sur les considérations pendant le téléchargement et la gestion des comptes. Les utilisateurs peuvent télécharger l'application à partir des chaînes officielles, y compris l'App Store, le téléchargement officiel du site Web APK et le saut de site Web officiel, ainsi que des paramètres d'enregistrement, de vérification d'identité et de sécurité. De plus, le guide couvre les questions et considérations fréquemment posées, telles que