Périphériques technologiques

Périphériques technologiques

IA

IA

Gagnant rapidement 2 500 étoiles, Andrej Karpathy a réécrit une bibliothèque minGPT

Gagnant rapidement 2 500 étoiles, Andrej Karpathy a réécrit une bibliothèque minGPT

Gagnant rapidement 2 500 étoiles, Andrej Karpathy a réécrit une bibliothèque minGPT

En tant qu'œuvre représentative de « l'esthétique violente » dans le domaine de l'intelligence artificielle, on peut dire que GPT a volé la vedette Des 117 millions de paramètres de GPT au début de sa naissance, il est passé à 175. milliards de paramètres de GPT-3. Avec la sortie de GPT-3, OpenAI a ouvert son API commerciale à la communauté, encourageant tout le monde à tenter davantage d'expériences en utilisant GPT-3. Cependant, l’utilisation de l’API nécessite une application, et votre application risque d’aboutir à rien.

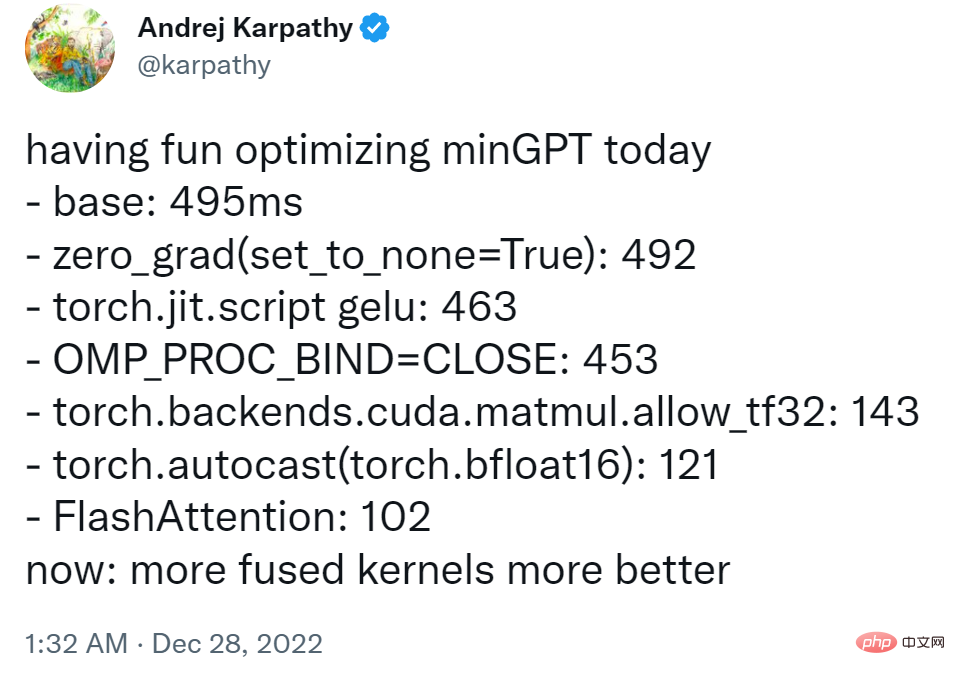

Afin de permettre aux chercheurs disposant de ressources limitées de découvrir le plaisir de jouer avec de grands modèles, l'ancien directeur de Tesla AI, Andrej Karpathy, a écrit une petite bibliothèque de formation GPT basée sur PyTorch avec seulement environ 300 lignes de code. Ce minGPT peut effectuer des opérations d'addition et une modélisation du langage au niveau des caractères, et la précision n'est pas mauvaise.

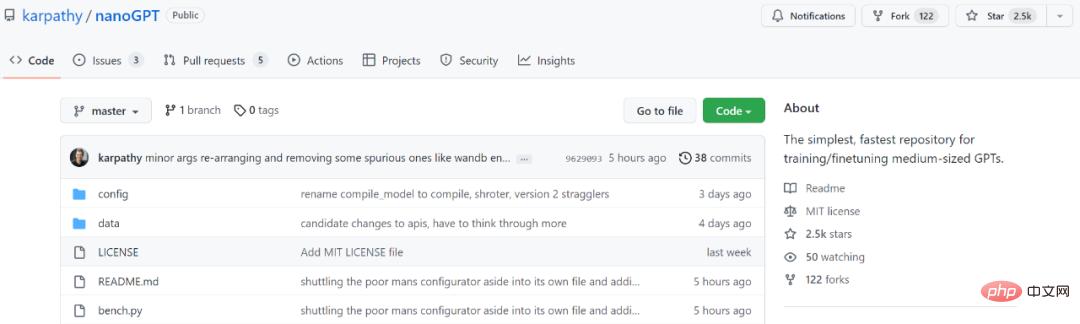

Après deux ans, minGPT a été mis à jour et Karpathy a lancé une nouvelle version nommée NanoGPT. Cette bibliothèque est utilisée pour entraîner et affiner les GPT de taille moyenne. Quelques jours seulement après son lancement, il a récolté 2,5 000 étoiles.

Adresse du projet : https://github.com/karpathy/nanoGPT

Dans l'introduction du projet, Karpathy a écrit : "NanoGPT est utilisé pour la formation et le réglage fin du support- scale La bibliothèque la plus simple et la plus rapide pour GPT. C'est une réécriture de minGPT, car minGPT est si compliqué que je suis réticent à l'utiliser. NanoGPT est toujours en cours de développement et travaille actuellement à la reproduction de GPT sur l'ensemble de données OpenWebText 2.

.L'objectif de conception du code NanoGPT est d'être simple et facile à lire, où train.py est un code d'environ 300 lignes ; model.py est une définition de modèle GPT d'environ 300 lignes, qui peut éventuellement charger des poids GPT-2. d'OpenAI 》

Afin de présenter l'ensemble de données, l'utilisateur doit d'abord tokeniser certains documents dans un simple tableau d'index 1D.

$ cd data/openwebtext $ python prepare.py

Cela générera deux fichiers : train.bin et val.bin, chacun contenant une séquence brute de uint16 octets représentant l'identifiant du jeton GPT-2 BPE. Ce script de formation tente de répliquer la plus petite version de GPT-2 fournie par OpenAI, qui est la version 124M.

$ python train.py

Si vous souhaitez utiliser le parallélisme de données distribué (DDP) PyTorch pour la formation, veuillez utiliser torchrun pour exécuter le script.

$ torchrun --standalone --nproc_per_node=4 train.py

Pour rendre le code plus efficace, les utilisateurs peuvent également échantillonner à partir du modèle :

$ python sample.py

Karpathy a déclaré que le projet a actuellement une perte d'entraînement d'environ 3,74 sur 1 GPU A100 40 Go pendant la nuit, et sur 4 La perte d'entraînement sur GPU est d'environ 3,60. La formation est tombée à 3,1 ATM avec 400 000 itérations (~ 1 jour) sur 8 nœuds A100 de 40 Go.

Pour savoir comment affiner GPT sur un nouveau texte, les utilisateurs peuvent visiter data/shakespeare et consulter prepare.py. Contrairement à OpenWebText, cela s'exécutera en quelques secondes. Le réglage fin prend très peu de temps, par exemple quelques minutes sur un seul GPU. Voici un exemple de réglage fin

$ python train.py config/finetune_shakespeare.py

Dès que le projet a été mis en ligne, les gens ont déjà commencé à l'essayer :

Les amis qui veulent l'essayer peuvent se référer au projet original opération.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

J'ai essayé le codage d'ambiance avec Cursor Ai et c'est incroyable!

Mar 20, 2025 pm 03:34 PM

J'ai essayé le codage d'ambiance avec Cursor Ai et c'est incroyable!

Mar 20, 2025 pm 03:34 PM

Le codage des ambiances est de remodeler le monde du développement de logiciels en nous permettant de créer des applications en utilisant le langage naturel au lieu de lignes de code sans fin. Inspirée par des visionnaires comme Andrej Karpathy, cette approche innovante permet de dev

Top 5 Genai Lunets de février 2025: GPT-4.5, Grok-3 et plus!

Mar 22, 2025 am 10:58 AM

Top 5 Genai Lunets de février 2025: GPT-4.5, Grok-3 et plus!

Mar 22, 2025 am 10:58 AM

Février 2025 a été un autre mois qui change la donne pour une IA générative, nous apportant certaines des mises à niveau des modèles les plus attendues et de nouvelles fonctionnalités révolutionnaires. De Xai's Grok 3 et Anthropic's Claude 3.7 Sonnet, à Openai's G

Comment utiliser YOLO V12 pour la détection d'objets?

Mar 22, 2025 am 11:07 AM

Comment utiliser YOLO V12 pour la détection d'objets?

Mar 22, 2025 am 11:07 AM

Yolo (vous ne regardez qu'une seule fois) a été un cadre de détection d'objets en temps réel de premier plan, chaque itération améliorant les versions précédentes. La dernière version Yolo V12 introduit des progrès qui améliorent considérablement la précision

Meilleurs générateurs d'art AI (gratuit & amp; payé) pour des projets créatifs

Apr 02, 2025 pm 06:10 PM

Meilleurs générateurs d'art AI (gratuit & amp; payé) pour des projets créatifs

Apr 02, 2025 pm 06:10 PM

L'article passe en revue les meilleurs générateurs d'art AI, discutant de leurs fonctionnalités, de leur aptitude aux projets créatifs et de la valeur. Il met en évidence MidJourney comme la meilleure valeur pour les professionnels et recommande Dall-E 2 pour un art personnalisable de haute qualité.

Chatgpt 4 o est-il disponible?

Mar 28, 2025 pm 05:29 PM

Chatgpt 4 o est-il disponible?

Mar 28, 2025 pm 05:29 PM

Chatgpt 4 est actuellement disponible et largement utilisé, démontrant des améliorations significatives dans la compréhension du contexte et la génération de réponses cohérentes par rapport à ses prédécesseurs comme Chatgpt 3.5. Les développements futurs peuvent inclure un interg plus personnalisé

Quelle IA est la meilleure que Chatgpt?

Mar 18, 2025 pm 06:05 PM

Quelle IA est la meilleure que Chatgpt?

Mar 18, 2025 pm 06:05 PM

L'article traite des modèles d'IA dépassant Chatgpt, comme Lamda, Llama et Grok, mettant en évidence leurs avantages en matière de précision, de compréhension et d'impact de l'industrie. (159 caractères)

Comment utiliser Mistral OCR pour votre prochain modèle de chiffon

Mar 21, 2025 am 11:11 AM

Comment utiliser Mistral OCR pour votre prochain modèle de chiffon

Mar 21, 2025 am 11:11 AM

Mistral OCR: révolutionner la génération de la récupération avec une compréhension du document multimodal Les systèmes de génération (RAG) (RAG) de la récupération ont considérablement avancé les capacités d'IA, permettant à de vastes magasins de données pour une responsabilité plus éclairée

Assistants d'écriture de l'IA pour augmenter votre création de contenu

Apr 02, 2025 pm 06:11 PM

Assistants d'écriture de l'IA pour augmenter votre création de contenu

Apr 02, 2025 pm 06:11 PM

L'article traite des meilleurs assistants d'écriture d'IA comme Grammarly, Jasper, Copy.ai, WireSonic et Rytr, en se concentrant sur leurs fonctionnalités uniques pour la création de contenu. Il soutient que Jasper excelle dans l'optimisation du référencement, tandis que les outils d'IA aident à maintenir le ton