Après la sortie du modèle « diviser tout » de Meta, les gens de l'industrie se sont déjà exclamés que le CV n'existe pas.

Juste un jour après la sortie de SAM, l'équipe nationale a proposé une version évoluée "Grounded-SAM" basée sur celui-ci.

Remarque : Le logo du projet a été réalisé par l'équipe en une heure à l'aide de Midjourney

Grounded-SAM intègre SAM avec BLIP et Stable Diffusion pour "segmenter" et "détecter les images" " et " Générer" trois capacités sont combinées en une seule, devenant ainsi l'application visuelle Zero-Shot la plus puissante.

Les internautes ont exprimé que c'était trop bouclé !

Wenhu Chen, chercheur scientifique chez Google Brain et professeur adjoint d'informatique à l'Université de Waterloo, a déclaré "C'est trop rapide."

Le patron de l'IA, Shun Xiangyang, a également recommandé ce dernier projet à tout le monde :

Grounded-Segment-Anything : détecte, segmente et génère automatiquement tout ce qui concerne la saisie d'images et de texte. La segmentation des bords peut être encore améliorée.

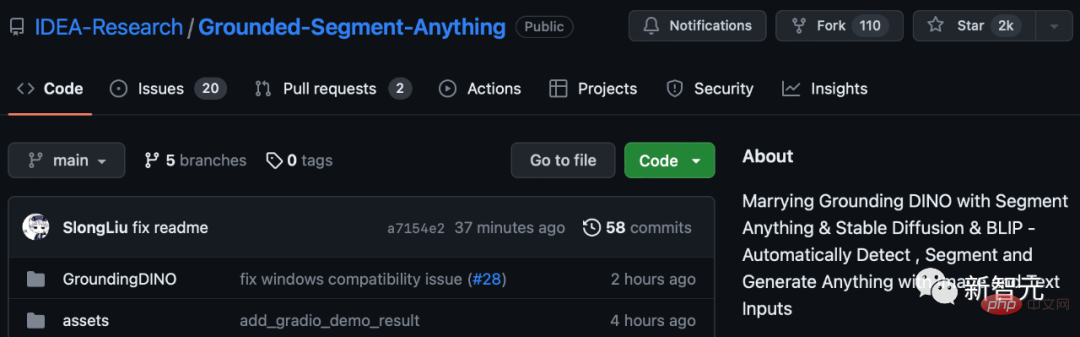

Jusqu'à présent, ce projet a récolté 2 000 étoiles sur GitHub.

La semaine dernière, la sortie de SAM a donné à CV son moment GPT-3. Même Meta AI affirme qu’il s’agit du premier modèle de segmentation d’images de base de l’histoire.

Ce modèle peut spécifier un point, un cadre de délimitation et une phrase dans l'encodeur d'invite du cadre unifié pour segmenter directement n'importe quel objet en un seul clic.

SAM a une grande polyvalence, c'est-à-dire qu'il a la capacité de transfert sans échantillon, ce qui est suffisant pour couvrir divers cas d'utilisation. Il ne nécessite pas de formation supplémentaire et peut être utilisé immédiatement. dans de nouveaux champs d'image, qu'il s'agisse d'une photo sous-marine ou d'un microscope cellulaire.

On peut voir que SAM peut être considéré comme extrêmement fort.

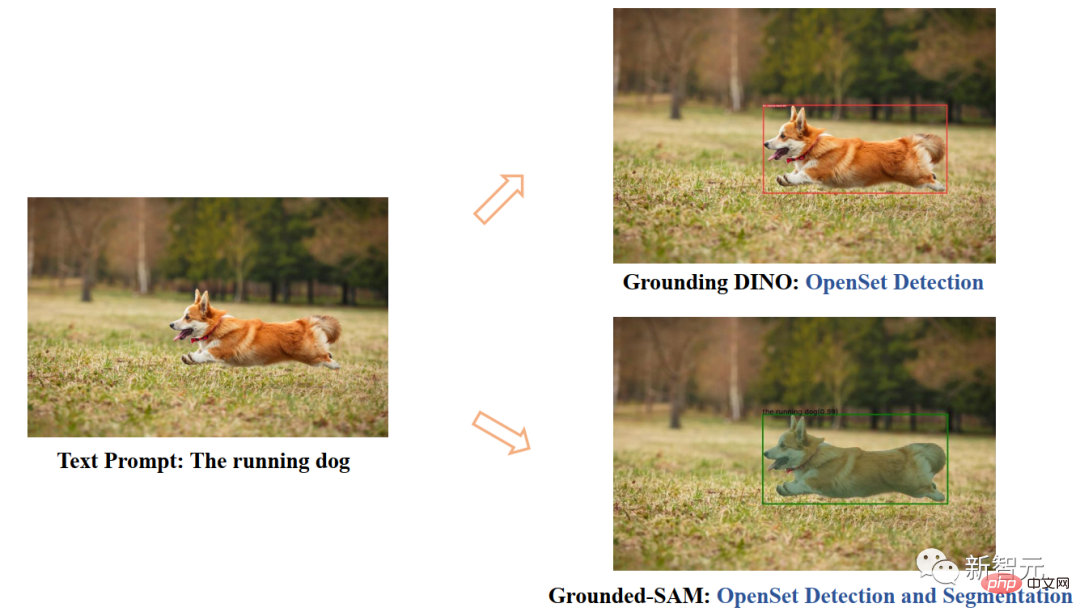

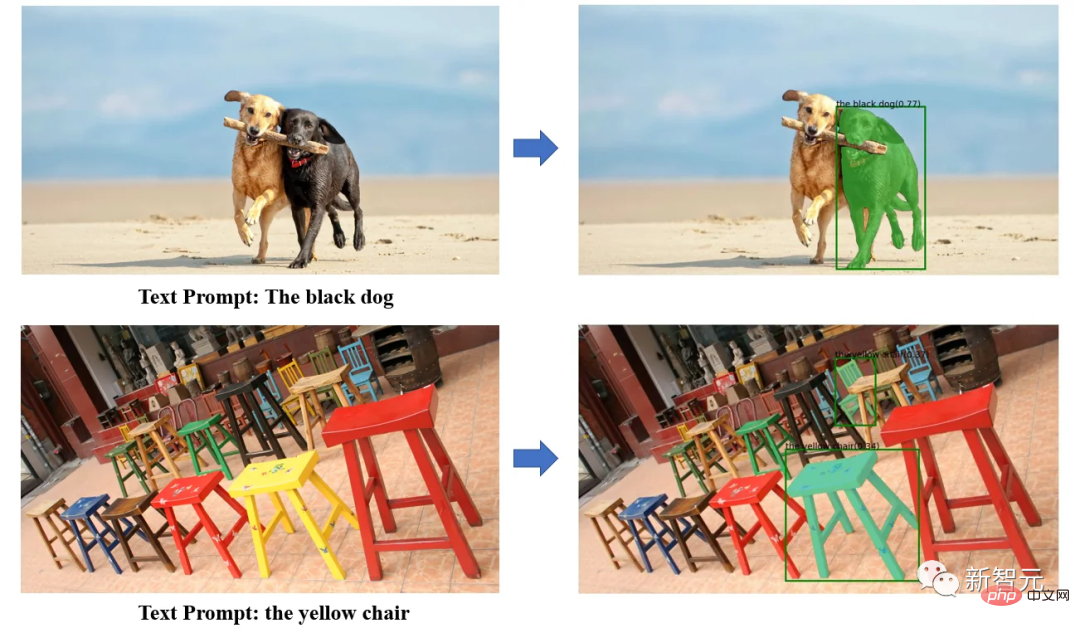

Maintenant, des chercheurs nationaux ont proposé de nouvelles idées basées sur ce modèle en combinant le puissant détecteur de cible à échantillon zéro Grounding DINO, ils peuvent tout détecter et segmenter via la saisie de texte.

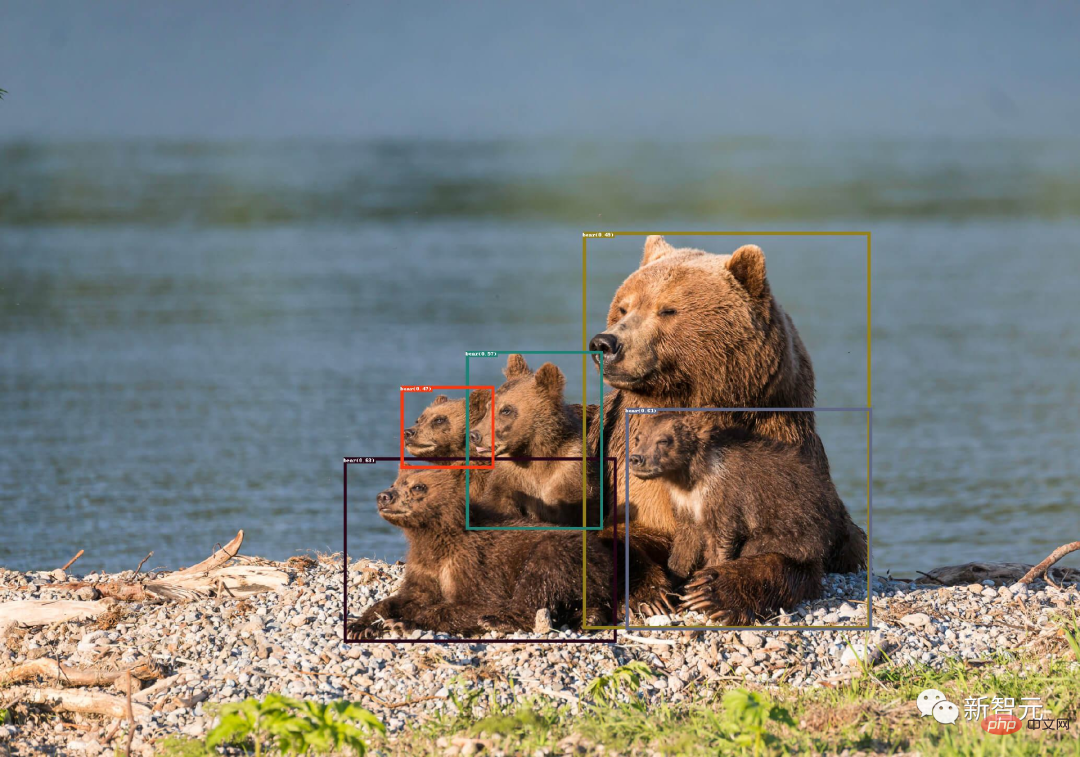

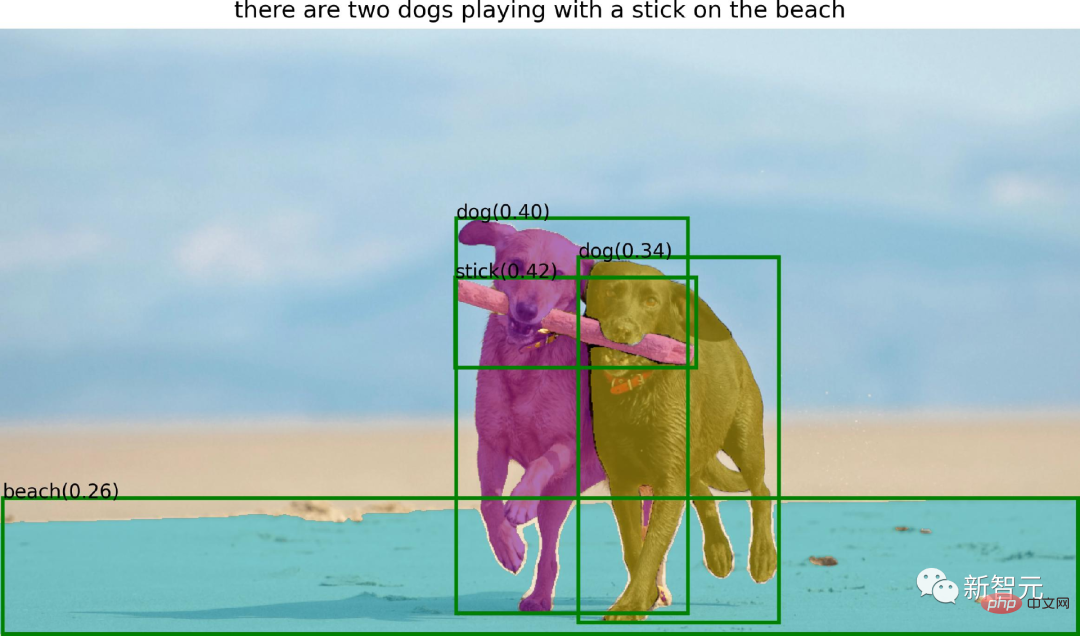

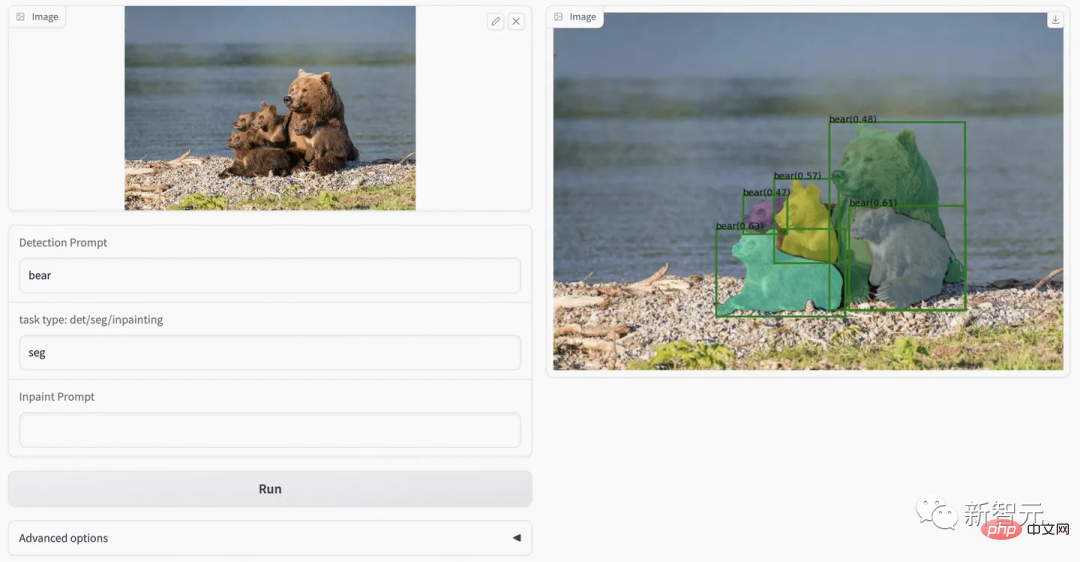

Grâce à la puissante capacité de détection d'échantillon zéro de Grounding DINO, Grounded SAM peut trouver n'importe quel objet dans l'image via une description textuelle, puis utiliser la puissante capacité de segmentation de SAM pour segmenter mas avec une granularité fine.

Enfin, vous pouvez également utiliser Stable Diffusion pour générer du texte et des graphiques contrôlables sur les zones segmentées.

Dans la pratique spécifique de Grounded-SAM, les chercheurs ont combiné Segment-Anything avec 3 puissants modèles Zero-shot pour créer un processus de système d'étiquetage automatique et ont montré des résultats très, très impressionnants !

Ce projet combine les modèles suivants :

· BLIP : un puissant modèle d'annotation d'image

· Grounding DINO : un détecteur zéro-shot de pointe

· Segment -Tout : Puissant modèle de segmentation sans tir

· Diffusion stable : Excellent modèle génératif

Tous les modèles peuvent être utilisés en combinaison ou indépendamment. Créez un modèle de flux de travail visuel puissant. L’ensemble du flux de travail a la capacité de tout détecter, de tout segmenter et de tout générer. Les caractéristiques de ce système incluent :

· Système d'annotation semi-automatique : Détecte le texte saisi et fournit une annotation précise des cases et des masques.

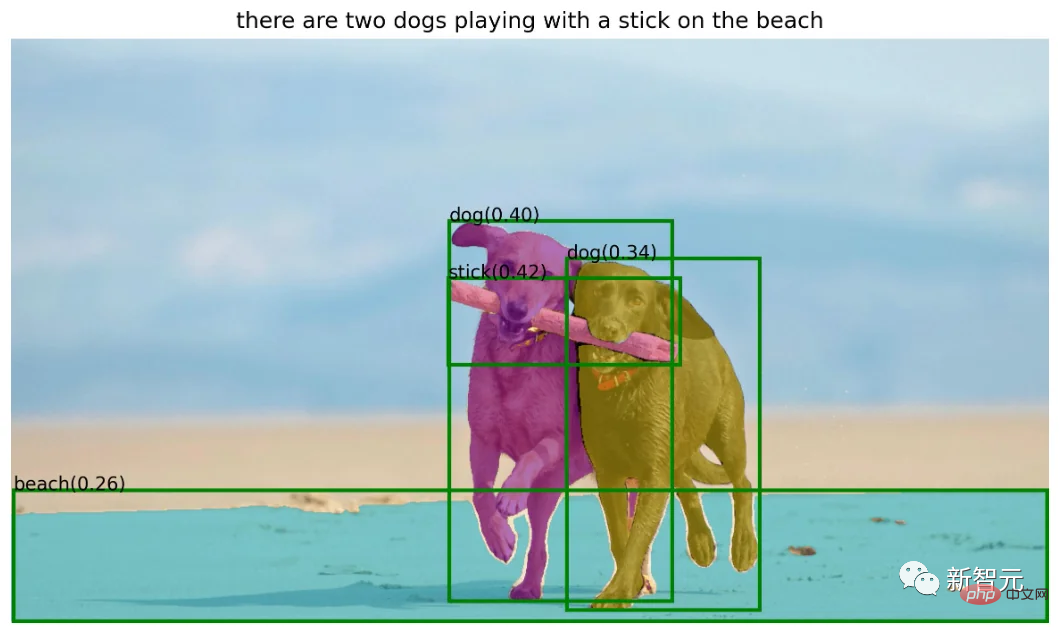

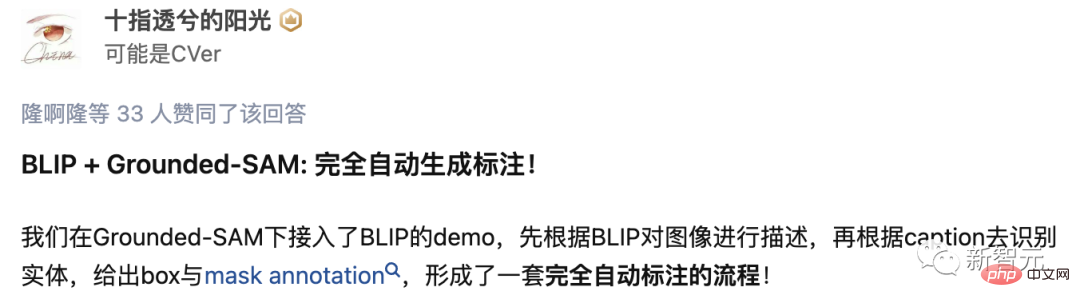

· Système d'annotation entièrement automatique :

utilise d'abord le modèle BLIP pour générer des annotations fiables pour l'image d'entrée, puis laisse Grounding DINO détecter les entités dans les annotations, puis utilise SAM sur sa boîte conseils Effectuer une segmentation d'instance.

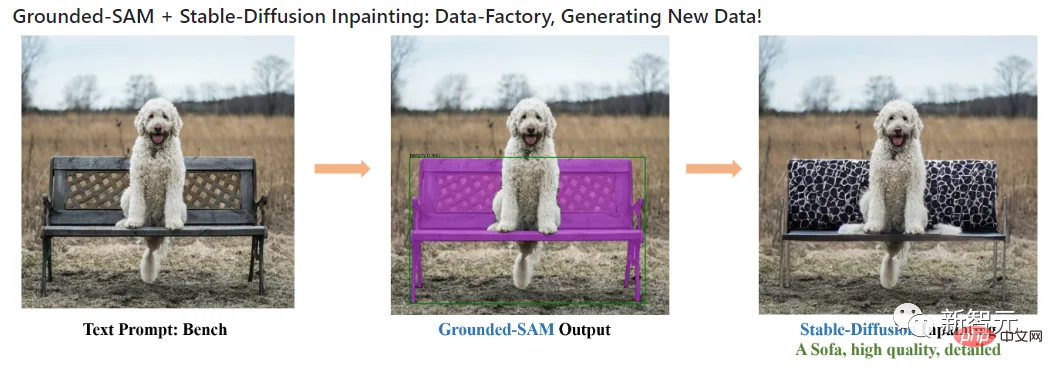

Stable Diffusion+Grounded-SAM=Data Factory

· Utilisé comme usine de données pour générer de nouvelles données :

Vous pouvez utiliser le modèle de réparation par diffusion pour générer de nouvelles données basées sur le masque.

Segment Anything+HumanEditing

Dans cette branche, l'auteur utilise Segment Anything pour éditer des cheveux/visages humains. L'auteur a quelques suggestions pour Grounded-S. Modèle AM Recherches futures possibles directions :

Générer automatiquement des images pour créer de nouveaux ensembles de données ; un modèle de base plus puissant pré-entraîné pour la segmentation ; une collaboration avec les modèles (Chat-)GPT ; générer une nouvelle image.

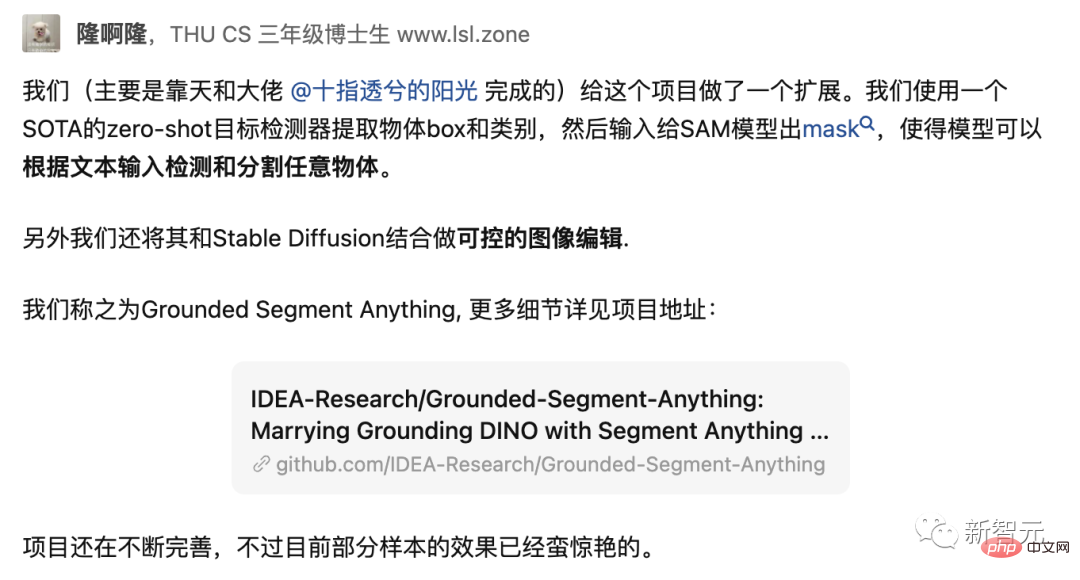

L'un des chercheurs du projet Grounded-SAM est Liu Shilong, doctorant en troisième année au Département d'informatique de l'Université Tsinghua.

Il a récemment présenté le dernier projet que lui et son équipe ont réalisé sur GitHub, et a déclaré qu'il était toujours en cours d'amélioration.

Maintenant, Liu Shilong est stagiaire au Centre de recherche en vision par ordinateur et en robotique de l'Institut de recherche sur l'économie numérique de la région de la Grande Baie Guangdong-Hong Kong-Macao (Institut de recherche IDEA). Il est guidé par le professeur Zhang Lei His. les principales orientations de recherche sont la détection de cibles et l'apprentissage multimodal.

Avant cela, il a obtenu un baccalauréat en génie industriel de l'Université Tsinghua en 2020 et a effectué un stage à Megvii pendant un certain temps en 2019.

Page d'accueil personnelle : http://www.lsl.zone/

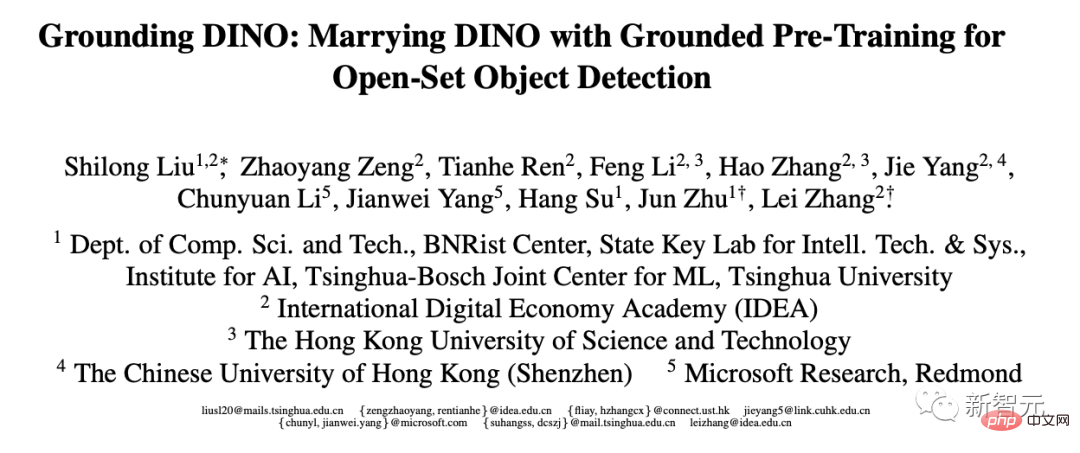

À propos, Liu Shilong est également une œuvre du modèle de détection de cible Grounding DINO sorti en mars de cette année.

De plus, 4 de ses articles ont été acceptés par le CVPR 2023, 2 articles ont été acceptés par l'ICLR 2023 et 1 article a été accepté par l'AAAI 2023.

Adresse papier : https://arxiv.org/pdf/2303.05499.pdf

Et le grand patron mentionné par Liu Shilong - Ren Tianhe, est actuellement chercheur à l'Institut de recherche IDEA Ingénieur en algorithmie de vision par ordinateur, également supervisé par le professeur Zhang Lei, dont les principaux axes de recherche sont la détection de cibles et la multimodalité.

De plus, les collaborateurs du projet comprennent Li Kunchang, doctorant en troisième année à l'Université de l'Académie chinoise des sciences, dont les principaux axes de recherche sont la compréhension vidéo et l'apprentissage multimodal ; au Centre de recherche en vision par ordinateur et en robotique de l'Institut IDEA, dont la principale direction de recherche est les modèles génératifs et Chen Jiayu, ingénieur senior en algorithmes chez Alibaba Cloud ;

Ren Tianhe, Liu Shilong

Le projet nécessite l'installation de python 3.8 et supérieur, pytorch 1.7 et supérieur et torchvision 0.8 et supérieur. De plus, l'auteur recommande fortement d'installer PyTorch et TorchVision qui prennent en charge CUDA.

Installer Segment Anything :

python -m pip install -e segment_anything

Installer GroundingDINO :

python -m pip install -e GroundingDINO

Installer les diffuseurs :

pip install --upgrade diffusers[torch]

Installer le post-traitement du masque, enregistrer le masque au format COCO, exemple de carnet et exporter le modèle au format ONNX Obligatoire dépendances facultatives. Dans le même temps, le projet nécessite également que jupyter exécute l'exemple de notebook.

pip install opencv-python pycocotools matplotlib onnxruntime onnx ipykernel

Téléchargez le point de contrôle groundingdino :

cd Grounded-Segment-Anything wget https://github.com/IDEA-Research/GroundingDINO/releases/download/v0.1.0-alpha/groundingdino_swint_ogc.pth

Exécuter la démo :

export CUDA_VISIBLE_DEVICES=0 python grounding_dino_demo.py --config GroundingDINO/groundingdino/config/GroundingDINO_SwinT_OGC.py --grounded_checkpoint groundingdino_swint_ogc.pth --input_image assets/demo1.jpg --output_dir "outputs" --box_threshold 0.3 --text_threshold 0.25 --text_prompt "bear" --device "cuda"

La visualisation de prédiction du modèle sera enregistrée dans output_dir comme indiqué ci-dessous :

La génération automatique de pseudo-étiquettes est simple :

1. Utilisez BLIP (ou un autre modèle d'annotation) pour générer une annotation.

2. Extrayez les balises des annotations et utilisez ChatGPT pour traiter des phrases potentiellement complexes.

3. Utilisez Grounded-Segment-Anything pour générer des boîtes et des masques.

export CUDA_VISIBLE_DEVICES=0 python automatic_label_demo.py --config GroundingDINO/groundingdino/config/GroundingDINO_SwinT_OGC.py --grounded_checkpoint groundingdino_swint_ogc.pth --sam_checkpoint sam_vit_h_4b8939.pth --input_image assets/demo3.jpg --output_dir "outputs" --openai_key your_openai_key --box_threshold 0.25 --text_threshold 0.2 --iou_threshold 0.5 --device "cuda"

伪标签和模型预测可视化将保存在output_dir中,如下所示:

CUDA_VISIBLE_DEVICES=0 python grounded_sam_inpainting_demo.py --config GroundingDINO/groundingdino/config/GroundingDINO_SwinT_OGC.py --grounded_checkpoint groundingdino_swint_ogc.pth --sam_checkpoint sam_vit_h_4b8939.pth --input_image assets/inpaint_demo.jpg --output_dir "outputs" --box_threshold 0.3 --text_threshold 0.25 --det_prompt "bench" --inpaint_prompt "A sofa, high quality, detailed" --device "cuda"

python gradio_app.py

作者在此提供了可视化网页,可以更方便的尝试各种例子。

对于这个项目logo,还有个深层的含义:

一只坐在地上的马赛克风格的熊。坐在地面上是因为ground有地面的含义,然后分割后的La version super évoluée de Meta Divide Everything est là ! IDEA dirige la meilleure équipe nationale pour créer : détecter, segmenter et générer tout, et récupérer 2 000 étoiles可以认为是一种马赛克风格,而且马塞克谐音mask,之所以用熊作为logo主体,是因为作者主要示例的La version super évoluée de Meta Divide Everything est là ! IDEA dirige la meilleure équipe nationale pour créer : détecter, segmenter et générer tout, et récupérer 2 000 étoiles是熊。

看到Grounded-SAM后,网友表示,知道要来,但没想到来的这么快。

项目作者任天和称,「我们用的Zero-Shot检测器是目前来说最好的。」

未来,还会有web demo上线。

最后,作者表示,这个项目未来还可以基于生成模型做更多的拓展应用,例如多领域精细化编辑、高质量可信的数据工厂的构建等等。欢迎各个领域的人多多参与。

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Prix de la pièce U aujourd'hui

Prix de la pièce U aujourd'hui

définirIntervalle

définirIntervalle

localhost8080 ne peut pas accéder à la solution

localhost8080 ne peut pas accéder à la solution

Comment installer WordPress après l'avoir téléchargé

Comment installer WordPress après l'avoir téléchargé

Temps de panne du service Windows 10

Temps de panne du service Windows 10

Comment changer phpmyadmin en chinois

Comment changer phpmyadmin en chinois

Programmation en langage de haut niveau

Programmation en langage de haut niveau

Quelles sont les différences entre hiberner et mybatis

Quelles sont les différences entre hiberner et mybatis