Périphériques technologiques

Périphériques technologiques

IA

IA

USB : le premier benchmark d'apprentissage de classification semi-supervisé qui unifie les tâches de classification visuelle, linguistique et audio

USB : le premier benchmark d'apprentissage de classification semi-supervisé qui unifie les tâches de classification visuelle, linguistique et audio

USB : le premier benchmark d'apprentissage de classification semi-supervisé qui unifie les tâches de classification visuelle, linguistique et audio

Actuellement, le développement de l’apprentissage semi-supervisé bat son plein. Cependant, les critères d'apprentissage semi-supervisés existants se limitent pour la plupart aux tâches de classification en vision par ordinateur, excluant une évaluation cohérente et diversifiée des tâches de classification telles que le traitement du langage naturel et le traitement audio. De plus, la plupart des articles semi-supervisés sont publiés par de grandes institutions, et il est souvent difficile pour les laboratoires universitaires de participer aux progrès du domaine en raison des ressources informatiques limitées.

À cette fin, des chercheurs de Microsoft Research Asia, en collaboration avec des chercheurs de l'Université de Westlake, de l'Institut de technologie de Tokyo, de l'Université Carnegie Mellon, de l'Institut Max Planck et d'autres institutions, ont proposé le Unified SSL Benchmark (USB) : le premier semi- référence d'apprentissage de classification supervisée qui unifie les tâches de classification visuelle, linguistique et audio.

Cet article présente non seulement des domaines d'application plus diversifiés, mais utilise également pour la première fois un modèle visuel de pré-formation pour réduire considérablement le temps de vérification des algorithmes semi-supervisés, rendant ainsi la recherche semi-supervisée plus conviviale pour les chercheurs, en particulier petits groupes de recherche. Les articles pertinents ont été acceptés par NeurIPS 2022, la plus grande conférence universitaire internationale dans le domaine de l'intelligence artificielle.

Lien de l'article : https://arxiv.org/pdf/2208.07204.pdf

Lien du code : https://github.com/microsoft/Semi-supervised-learning

L'apprentissage supervisé crée des modèles adaptés aux données étiquetées. Lorsque l'apprentissage supervisé est utilisé pour former une grande quantité de données étiquetées de haute qualité, le modèle de réseau neuronal produit des résultats compétitifs.

Par exemple, selon les statistiques du site Web Paperswithcode, sur l'ensemble de données d'ImageNet au niveau d'un million, les méthodes traditionnelles d'apprentissage supervisé peuvent atteindre une précision de plus de 88 %. Cependant, l’obtention de grandes quantités de données étiquetées prend souvent du temps et est laborieuse.

Afin d'atténuer la dépendance aux données étiquetées, l'apprentissage semi-supervisé (SSL) s'engage à utiliser une grande quantité de données non étiquetées pour améliorer la généralisation du modèle lorsqu'il n'y a qu'une petite quantité de données étiquetées. L’apprentissage semi-supervisé est également l’un des sujets importants du machine learning. Avant l’apprentissage profond, les chercheurs dans ce domaine proposaient des algorithmes classiques tels que les machines à vecteurs de support semi-supervisées, la régularisation de l’entropie et l’entraînement collaboratif.

Apprentissage profond semi-supervisé

Avec l'essor du deep learning, les algorithmes d'apprentissage profond semi-supervisé ont également fait de grands progrès. Dans le même temps, des entreprises technologiques telles que Microsoft, Google et Meta ont également reconnu l’énorme potentiel de l’apprentissage semi-supervisé dans des scénarios pratiques.

Par exemple, Google utilise la formation d'étudiants bruyants, un algorithme semi-supervisé, pour améliorer ses performances en recherche [1]. Les algorithmes semi-supervisés les plus représentatifs utilisent actuellement la perte d'entropie croisée pour l'entraînement sur des données étiquetées et la régularisation de cohérence sur des données non étiquetées pour encourager les prédictions invariantes des perturbations d'entrée.

Par exemple, l'algorithme FixMatch[2] proposé par Google à NeurIPS 2020 utilise des technologies d'ancrage d'augmentation et de seuil fixe pour améliorer la généralisation du modèle à des données améliorées avec différentes forces et réduire l'influence des pseudo-étiquettes bruyantes. Pendant la formation, FixMatch filtre les données non étiquetées en dessous d'un seuil fourni/prédéfini par l'utilisateur.

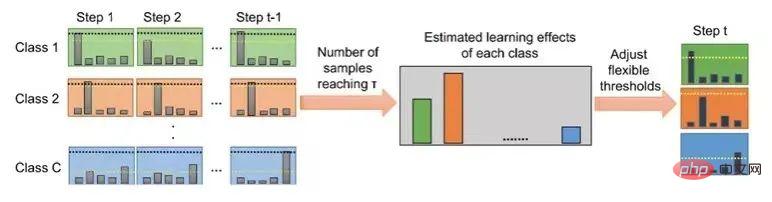

FlexMatch[3], proposé conjointement par Microsoft Research Asia et l'Institut de technologie de Tokyo à NeurIPS 2021, prend en compte les différentes difficultés d'apprentissage entre les différentes catégories, il propose donc une technologie de pseudo-étiquetage des programmes. Les classes devraient adopter des seuils différents.

Plus précisément, pour les catégories faciles à apprendre, le modèle doit définir un seuil élevé pour réduire l'impact des pseudo-étiquettes bruyantes ; pour les catégories difficiles à apprendre, le modèle doit définir un seuil bas pour encourager l'adaptation ; de cette catégorie. L'évaluation des difficultés d'apprentissage de chaque classe dépend du nombre d'échantillons de données non étiquetés entrant dans cette classe et dépassant une valeur fixe.

Dans le même temps, des chercheurs de Microsoft Research Asia ont également collaboré pour proposer une bibliothèque de codes de méthodes semi-supervisée unifiée basée sur Pytorch, TorchSSL[4], qui unifie les méthodes approfondies, les ensembles de données couramment utilisés et les résultats de référence dans ce domaine. soutien.

Figure 1 : Flux de l'algorithme FlexMatch

Figure 1 : Flux de l'algorithme FlexMatch

Problèmes et défis dans la bibliothèque de codes d'apprentissage semi-supervisé actuelle

Bien que le développement de l'apprentissage semi-supervisé bat son plein, les chercheurs ont remarqué que la plupart des codes d'apprentissage semi-supervisés actuels articles dans le sens semi-supervisé En se concentrant uniquement sur les tâches de classification de vision par ordinateur (CV), les chercheurs ne peuvent pas savoir si ces algorithmes efficaces dans les tâches de CV sont toujours efficaces dans différents domaines pour d'autres domaines, tels que le traitement du langage naturel (NLP) et l'audio. traitement (audio).

De plus, la plupart des articles semi-supervisés sont publiés par de grandes institutions, et il est souvent difficile pour les laboratoires académiques de participer à la promotion du développement de ce domaine en raison des limitations des ressources informatiques. De manière générale, les référentiels d'apprentissage semi-supervisé rencontrent actuellement les deux problèmes suivants :

(1) Diversité insuffisante. La plupart des critères d'apprentissage semi-supervisé existants se limitent aux tâches de classification des CV (c'est-à-dire CIFAR-10/100, SVHN, STL-10 et ImageNet), excluant une évaluation cohérente et diversifiée des tâches de classification telles que la PNL, l'audio, etc. , tandis qu'en PNL, le manque de données étiquetées suffisantes dans et audio est également un problème courant.

(2) Cela prend beaucoup de temps et n'est pas convivial pour le monde universitaire. Les références d'apprentissage semi-supervisé existantes telles que TorchSSL prennent souvent du temps et ne sont pas respectueuses de l'environnement, car elles nécessitent souvent de former des modèles de réseaux neuronaux profonds à partir de zéro. Plus précisément, l'évaluation de FixMatch[1] à l'aide de TorchSSL nécessite environ 300 jours GPU. Des coûts de formation aussi élevés rendent la recherche liée au SSL inabordable pour de nombreux laboratoires de recherche (en particulier ceux du milieu universitaire ou des petits groupes de recherche), entravant ainsi le progrès du SSL.

USB : une nouvelle bibliothèque de référence avec des tâches diverses et plus conviviale pour les chercheurs

Afin de résoudre les problèmes ci-dessus, des chercheurs de Microsoft Research Asia se sont associés à l'Université Westlake, à l'Institut de technologie de Tokyo, à l'Université Carnegie Mellon, à Max- Des chercheurs de l'Institut Planck et d'autres institutions ont proposé le Unified SSL Benchmark (USB), qui est le premier benchmark d'apprentissage de classification semi-supervisé qui unifie les tâches de classification visuelle, linguistique et audio.

Par rapport aux précédents benchmarks d'apprentissage semi-supervisé (tels que TorchSSL) qui se concentraient uniquement sur un petit nombre de tâches de vision, ce benchmark introduit non seulement des domaines d'application plus diversifiés, mais utilise également un modèle de vision pré-entraîné (vision pré-entraînée Transformer) pour la première fois afin de réduire considérablement le nombre de tâches visuelles. Le temps de vérification des algorithmes semi-supervisés a été réduit (de 7 000 heures GPU à 900 heures GPU), rendant la recherche semi-supervisée plus conviviale pour les chercheurs, en particulier les petites recherches. groupes.

Les articles pertinents ont été acceptés par NeurIPS 2022, la plus grande conférence universitaire dans le domaine de l'intelligence artificielle internationale. (Cliquez sur "Lire le texte original" pour en savoir plus)

Solution fournie par USB

Alors, comment l'USB peut-il résoudre d'un seul coup les problèmes des benchmarks semi-supervisés actuels ? Les chercheurs ont principalement apporté les améliorations suivantes :

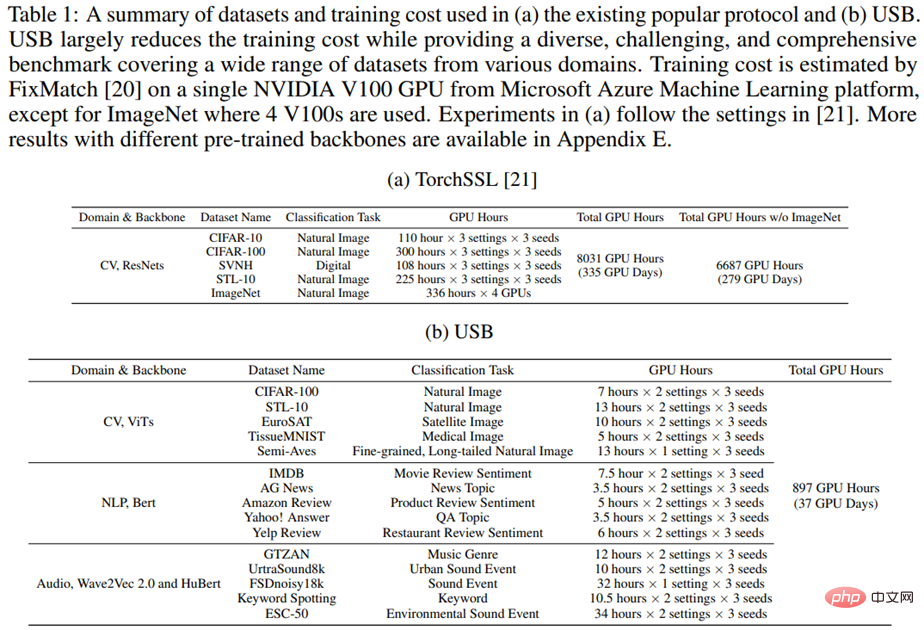

(1) Pour améliorer la diversité des tâches, l'USB a introduit 5 ensembles de données CV, 5 ensembles de données PNL et 5 ensembles de données audio, et a fourni des critères de référence diversifiés et stimulants, permettant une évaluation cohérente sur plusieurs tâches provenant de différents domaines. Le tableau 1 fournit une comparaison détaillée des tâches et du temps de formation entre USB et TorchSSL.

Tableau 1 : Comparaison des tâches et du temps de formation entre les frameworks USB et TorchSSL

(2) Afin d'améliorer l'efficacité de la formation, les chercheurs ont introduit Vision Transformer pré-entraîné dans SSL au lieu de en partant de zéro Formation ResNets. Plus précisément, les chercheurs ont découvert que l'utilisation de modèles pré-entraînés peut réduire considérablement le nombre d'itérations d'entraînement sans affecter les performances (par exemple, réduire le nombre d'itérations d'entraînement pour une tâche CV de 1 million d'étapes à 200 000 étapes).

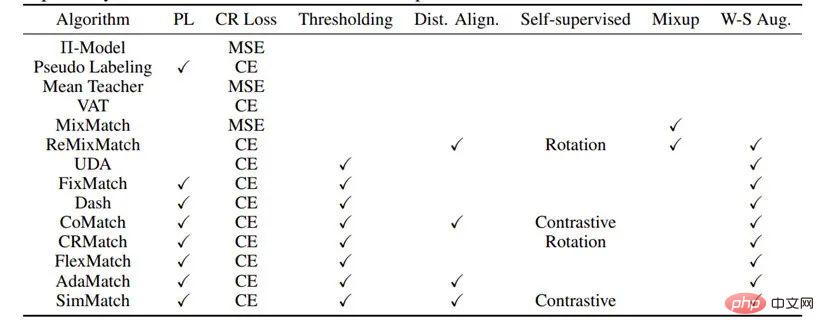

(3) Afin d'être plus conviviaux pour les chercheurs, les chercheurs ont implémenté 14 algorithmes SSL en open source et ont ouvert une bibliothèque de codes modulaires et des fichiers de configuration associés permettant aux chercheurs de reproduire facilement les résultats dans le rapport USB. Pour démarrer rapidement, USB fournit également une documentation détaillée et des didacticiels. De plus, USB fournit également le package pip permettant aux utilisateurs d'appeler directement l'algorithme SSL. Les chercheurs promettent de continuer à ajouter de nouveaux algorithmes (tels que des algorithmes semi-supervisés déséquilibrés, etc.) et des ensembles de données plus complexes à l'USB à l'avenir. Le tableau 2 montre les algorithmes et modules déjà pris en charge en USB.

Tableau 2 : Algorithmes et modules pris en charge en USB

L'apprentissage semi-supervisé a d'importantes recherches futures en exploitant de grandes quantités de données non étiquetées pour former des modèles et une valeur d'application plus précis et plus robustes. Les chercheurs de Microsoft Research Asia sont impatients d'utiliser ces travaux USB pour aider le monde universitaire et l'industrie à progresser davantage dans le domaine de l'apprentissage semi-supervisé.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Comment terminer la mission du couloir d'horreur dans Goat Simulator 3

Feb 25, 2024 pm 03:40 PM

Comment terminer la mission du couloir d'horreur dans Goat Simulator 3

Feb 25, 2024 pm 03:40 PM

Le Terror Corridor est une mission dans Goat Simulator 3. Comment pouvez-vous accomplir cette mission ? Maîtriser les méthodes de dédouanement détaillées et les processus correspondants, et être capable de relever les défis correspondants de cette mission. Ce qui suit vous apportera Goat Simulator 3 Horror Corridor. Guide pour apprendre les informations connexes. Goat Simulator 3 Terror Corridor Guide 1. Tout d’abord, les joueurs doivent se rendre à Silent Hill dans le coin supérieur gauche de la carte. 2. Ici vous pouvez voir une maison avec RESTSTOP écrit sur le toit. Les joueurs doivent faire fonctionner la chèvre pour entrer dans cette maison. 3. Après être entré dans la pièce, nous allons d'abord tout droit, puis tournons à droite. Il y a une porte au bout ici, et nous entrons directement à partir d'ici. 4. Après être entré, nous devons également d'abord avancer, puis tourner à droite. Lorsque nous atteignons la porte ici, la porte sera fermée. Nous devons faire demi-tour et la trouver.

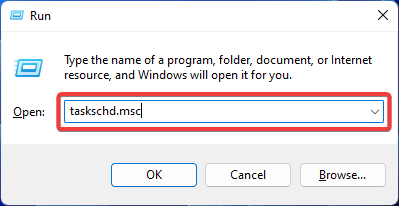

Correctif : erreur de demande refusée par l'opérateur dans le Planificateur de tâches Windows

Aug 01, 2023 pm 08:43 PM

Correctif : erreur de demande refusée par l'opérateur dans le Planificateur de tâches Windows

Aug 01, 2023 pm 08:43 PM

Pour automatiser les tâches et gérer plusieurs systèmes, un logiciel de planification de mission est un outil précieux dans votre arsenal, notamment en tant qu'administrateur système. Le Planificateur de tâches Windows fait parfaitement le travail, mais dernièrement, de nombreuses personnes ont signalé des erreurs de demande rejetée par l'opérateur. Ce problème existe dans toutes les itérations du système d’exploitation, et même s’il a été largement signalé et couvert, il n’existe pas de solution efficace. Continuez à lire pour découvrir ce qui pourrait réellement fonctionner pour d’autres personnes ! Quelle est la demande dans le Planificateur de tâches 0x800710e0 qui a été refusée par l'opérateur ou l'administrateur ? Le planificateur de tâches permet d'automatiser diverses tâches et applications sans intervention de l'utilisateur. Vous pouvez l'utiliser pour planifier et organiser des applications spécifiques, configurer des notifications automatiques, aider à transmettre des messages, et bien plus encore. il

Comment réussir la mission Imperial Tomb dans Goat Simulator 3

Mar 11, 2024 pm 01:10 PM

Comment réussir la mission Imperial Tomb dans Goat Simulator 3

Mar 11, 2024 pm 01:10 PM

Goat Simulator 3 est un jeu avec un gameplay de simulation classique, permettant aux joueurs de profiter pleinement du plaisir de la simulation d'action occasionnelle. Parmi elles, la tâche Goat Simulator 3 Imperial Tomb oblige les joueurs à trouver le clocher. Certains joueurs ne savent pas comment faire fonctionner les trois horloges en même temps. Voici le guide de la mission Tomb of the Tomb dans Goat Simulator 3. Le guide de la mission Tomb of the Tomb dans Goat Simulator 3 consiste à faire sonner les cloches ! en ordre. Extension détaillée des étapes 1. Tout d'abord, les joueurs doivent ouvrir la carte et se rendre au cimetière de Wuqiu. 2. Montez ensuite au clocher. Il y aura trois cloches à l'intérieur. 3. Ensuite, du plus grand au plus petit, suivez 222312312 pour vous familiariser avec les tapotements colériques. 4. Après avoir frappé, vous pouvez terminer la mission et ouvrir la porte pour obtenir le sabre laser.

Comment faire la mission de sauvetage de Steve dans Goat Simulator 3

Feb 25, 2024 pm 03:34 PM

Comment faire la mission de sauvetage de Steve dans Goat Simulator 3

Feb 25, 2024 pm 03:34 PM

Rescue Steve est une tâche unique dans Goat Simulator 3. Que faut-il faire exactement pour la terminer ? Cette tâche est relativement simple, mais nous devons faire attention à ne pas mal comprendre le sens. Ici, nous allons vous amener à sauver Steve dans Goat Simulator. 3 stratégies de mission peuvent vous aider à mieux accomplir les tâches connexes. Goat Simulator 3 Rescue Steve Mission Stratégie 1. Arrivez d’abord à la source chaude dans le coin inférieur droit de la carte. 2. Après être arrivé à la source chaude, vous pouvez déclencher la tâche de sauvetage de Steve. 3. Notez qu'il y a un homme dans la source chaude. Bien qu'il s'appelle Steve, il n'est pas la cible de cette mission. 4. Trouvez un poisson nommé Steve dans cette source chaude et ramenez-le à terre pour accomplir cette tâche.

Où puis-je trouver les tâches du groupe de fans Douyin ? Le fan club de Douyin va-t-il perdre du niveau ?

Mar 07, 2024 pm 05:25 PM

Où puis-je trouver les tâches du groupe de fans Douyin ? Le fan club de Douyin va-t-il perdre du niveau ?

Mar 07, 2024 pm 05:25 PM

En tant que l’une des plateformes de médias sociaux les plus populaires du moment, TikTok a attiré un grand nombre d’utilisateurs. Sur Douyin, il existe de nombreuses tâches de groupe de fans que les utilisateurs peuvent accomplir pour obtenir certaines récompenses et avantages. Alors, où puis-je trouver les tâches du fan club Douyin ? 1. Où puis-je consulter les tâches du fan club Douyin ? Afin de trouver les tâches du groupe de fans de Douyin, vous devez visiter la page d'accueil personnelle de Douyin. Sur la page d'accueil, vous verrez une option appelée « Fan Club ». Cliquez sur cette option et vous pourrez parcourir les groupes de fans que vous avez rejoints et les tâches associées. Dans la colonne des tâches du fan club, vous verrez différents types de tâches, telles que les likes, les commentaires, le partage, le transfert, etc. Chaque tâche a des récompenses et des exigences correspondantes. De manière générale, après avoir terminé la tâche, vous recevrez une certaine quantité de pièces d'or ou de points d'expérience.

Au-delà d'ORB-SLAM3 ! SL-SLAM : les scènes de faible luminosité, de gigue importante et de texture faible sont toutes gérées

May 30, 2024 am 09:35 AM

Au-delà d'ORB-SLAM3 ! SL-SLAM : les scènes de faible luminosité, de gigue importante et de texture faible sont toutes gérées

May 30, 2024 am 09:35 AM

Écrit précédemment, nous discutons aujourd'hui de la manière dont la technologie d'apprentissage profond peut améliorer les performances du SLAM (localisation et cartographie simultanées) basé sur la vision dans des environnements complexes. En combinant des méthodes d'extraction de caractéristiques approfondies et de correspondance de profondeur, nous introduisons ici un système SLAM visuel hybride polyvalent conçu pour améliorer l'adaptation dans des scénarios difficiles tels que des conditions de faible luminosité, un éclairage dynamique, des zones faiblement texturées et une gigue importante. Notre système prend en charge plusieurs modes, notamment les configurations étendues monoculaire, stéréo, monoculaire-inertielle et stéréo-inertielle. En outre, il analyse également comment combiner le SLAM visuel avec des méthodes d’apprentissage profond pour inspirer d’autres recherches. Grâce à des expériences approfondies sur des ensembles de données publiques et des données auto-échantillonnées, nous démontrons la supériorité du SL-SLAM en termes de précision de positionnement et de robustesse du suivi.

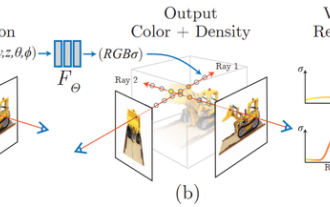

Qu'est-ce que le NeRF ? La reconstruction 3D basée sur NeRF est-elle basée sur des voxels ?

Oct 16, 2023 am 11:33 AM

Qu'est-ce que le NeRF ? La reconstruction 3D basée sur NeRF est-elle basée sur des voxels ?

Oct 16, 2023 am 11:33 AM

1 Introduction Les champs de rayonnement neuronal (NeRF) constituent un paradigme relativement nouveau dans le domaine de l'apprentissage profond et de la vision par ordinateur. Cette technologie a été introduite dans l'article ECCV2020 « NeRF : Representing Scenes as Neural Radiation Fields for View Synthesis » (qui a remporté le prix du meilleur article) et est depuis devenue extrêmement populaire, avec près de 800 citations à ce jour [1 ]. Cette approche marque un changement radical dans la manière traditionnelle dont l’apprentissage automatique traite les données 3D. Représentation de la scène du champ de rayonnement neuronal et processus de rendu différenciable : compositer des images en échantillonnant des coordonnées 5D (position et direction de visualisation) le long des rayons de la caméra ; introduire ces positions dans un MLP pour produire des densités de couleur et volumétriques et composer ces valeurs à l'aide de techniques de rendu volumétrique ; ; la fonction de rendu est différentiable, elle peut donc être transmise

Analyse du timing Guerrier du Pentagone ! L'Université Tsinghua propose TimesNet : leader en matière de prédiction, de remplissage, de classification et de détection

Apr 11, 2023 pm 07:34 PM

Analyse du timing Guerrier du Pentagone ! L'Université Tsinghua propose TimesNet : leader en matière de prédiction, de remplissage, de classification et de détection

Apr 11, 2023 pm 07:34 PM

Atteindre l’universalité des tâches est une question centrale dans la recherche de modèles de base d’apprentissage profond, et constitue également l’un des principaux objectifs de l’orientation récente des grands modèles. Cependant, dans le domaine des séries chronologiques, les différents types de tâches d'analyse varient considérablement. Il existe des tâches de prédiction qui nécessitent des tâches de modélisation et de classification fines qui nécessitent l'extraction d'informations sémantiques de haut niveau. La manière de construire un modèle de base profond unifié pour accomplir efficacement diverses tâches d'analyse temporelle n'a pas encore été établie. À cette fin, une équipe de l’École de logiciels de l’Université Tsinghua a mené des recherches sur la question fondamentale de la modélisation des changements de timing et a proposé TimesNet, un modèle de base de timing universel pour les tâches. Le document a été accepté par l’ICLR 2023. Liste des auteurs : Wu Haixu*, Hu Tengge*, Liu Yong*, Zhou Hang, Wang Jianmin, Long Mingsheng Lien : https://ope