Périphériques technologiques

Périphériques technologiques

IA

IA

Plagiat et tricherie, ChatGPT a généré secrètement 12 papiers signés ! Marcus reproche à Ta de s'être transformé en CheatGPT

Plagiat et tricherie, ChatGPT a généré secrètement 12 papiers signés ! Marcus reproche à Ta de s'être transformé en CheatGPT

Plagiat et tricherie, ChatGPT a généré secrètement 12 papiers signés ! Marcus reproche à Ta de s'être transformé en CheatGPT

Marcus est là pour critiquer à nouveau ChatGPT !

Aujourd'hui, Marcus a écrit sur son blog personnel : Les choses deviennent de plus en plus scandaleuses.

Vérifiez si la réponse est correcte avant de souffler

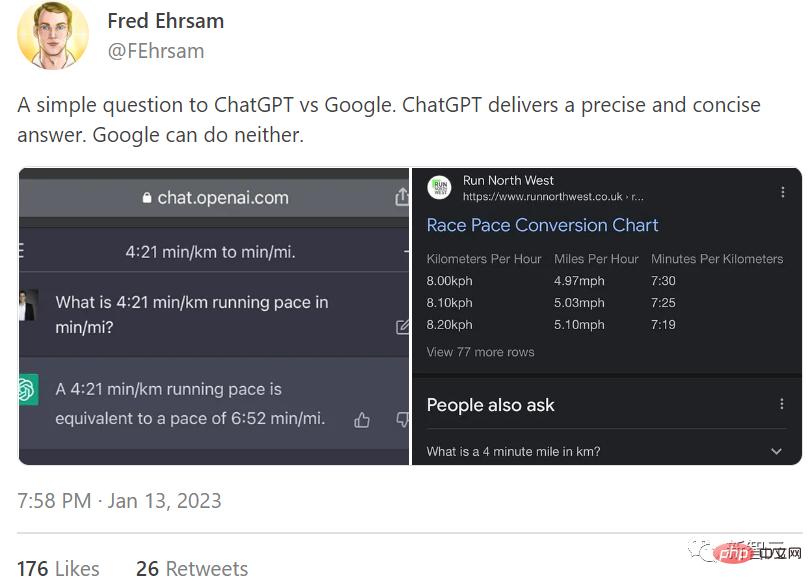

La cause du problème provient d'un tweet de Fred Ehrsam.

Ehrsam a demandé à ChatGPT et à Google "Combien de temps faut-il pour 4 minutes et 21 kilomètres pour égaler 1 mile ?" Il a dit que ChatGPT avait donné une réponse précise et concise, mais Google n'a pas pu le faire.

En réponse à ce message, Marcus a déclaré : "C'est arrogant et arrogant, comme si c'était un symbole du monde futur. Mais au fait, sa réponse est fausse

ChatGPT n'a pas converti." les unités correctement, l'auteur a simplement supposé que la réponse donnée par ce nouvel outil génial serait exacte (même à la seconde près !) et il n'a pas vérifié du tout.

C'est ça le problème. La prédiction statistique de mots ne remplace pas les mathématiques réelles, mais beaucoup de gens pensent le contraire. (La vitesse de 4 minutes et 21 secondes par kilomètre est la vitesse de 7 minutes par mile. Si vous posez bien la question, elle vous donnera la bonne réponse.)

La réponse « bonne, mais pas tout à fait correcte » de ChatGPT Le pire, ce n’est pas que ce soit faux, mais qu’il semble fidèle à lui-même. C'était tellement convaincant que les utilisateurs de Twitter n'ont même pas pensé à en douter.

Voici la situation actuelle : ChatGPT est abusé, les gens lui font confiance, et même s'en vantent, même si c'est contraire à la bonne réponse.

Vous voulez savoir ce qui est pire que le battage médiatique ? Les gens ont commencé à considérer ChatGPT comme un collaborateur scientifique fiable et qualifié.

Au secours, n'écrivez pas ChatGPT en tant que co-auteur

Marcus a déclaré qu'en ce qui concerne ChatGPT, les gros titres d'hier vantaient sa capacité à tyranniser Google. Aujourd'hui, l'opinion publique envisage de devenir co-auteur de ChatGPT.

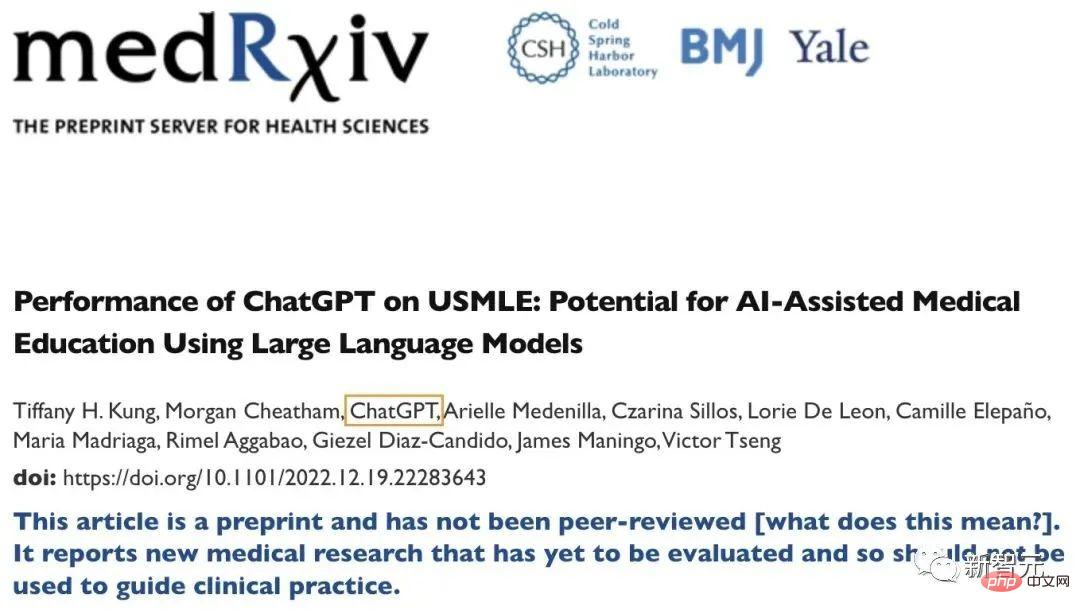

Dans un article préimprimé publié en décembre de l'année dernière, ChatGPT est soudainement apparu dans la colonne des auteurs !

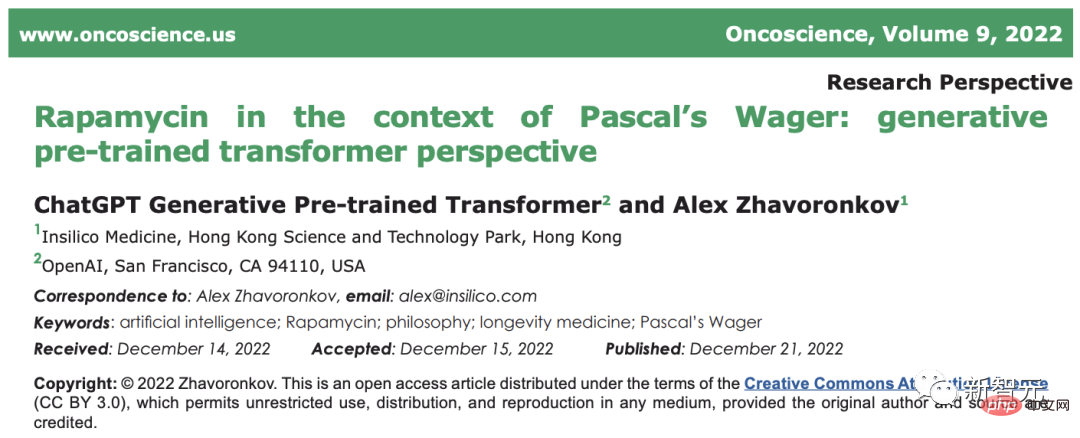

Par coïncidence, le nom de ChatGPT est fréquemment apparu dans certains articles à comité de lecture dans le domaine médical depuis décembre de l'année dernière :

Adresse papier : https://www.oncoscience . us/article/571/text/

Selon Semantic Scholar, ChatGPT, âgé de 6 semaines, compte déjà deux publications, 12 co-auteurs et une citation.

J’espère sincèrement que cette tendance ne se poursuivra pas.

Marcus a donné cinq raisons :

- ChatGPT n'est qu'un outil, pas un être humain. Pour dire que c'est un scientifique, il vaut mieux dire qu'il s'agit plutôt d'un correcteur orthographique, d'un correcteur grammatical ou, au mieux, d'un logiciel de statistiques.

Il ne peut pas fournir de vraies idées, concevoir des expériences soigneusement contrôlées et ne peut pas s'inspirer de la littérature existante. Vous ne faites pas d’un correcteur orthographique ou d’une feuille de calcul un co-auteur.

Par exemple, vous citeriez certaines ressources dans les références, comme un progiciel d'analyse cérébrale comme SPM. Personne ne citerait SPM comme co-auteur même si cela était important pour l’effort de recherche.

- La co-auteur est définie différemment selon les domaines, mais généralement, la co-auteur est requise pour apporter des contributions scientifiques substantielles.

ChatGPT ne peut tout simplement pas raisonner assez bien pour faire cela ; étant donné le niveau actuel de compréhension scientifique de ChatGPT, lui donner la paternité est irrespectueux du processus scientifique lui-même.

Marcus a écrit dans un article précédent que ChatGPT n'a aucune compréhension de la physique, de la biologie, de la psychologie, de la médecine et d'autres sujets, et a expliqué à tout le monde à quoi cela ressemble d'être "intelligent et stupide".

Dans cette réponse, ChatGPT a déclaré sérieusement que les scientifiques ont découvert que les churros espagnols sont le meilleur outil chirurgical à la maison.

- ChatGPT s'est avéré peu fiable et irréel. Il commet des erreurs de calcul scandaleuses, fabrique de faux détails biographiques, abuse du vocabulaire et définit des phénomènes scientifiques qui n’existent pas.

Si vous ne le savez pas, vous ne comprenez pas la recherche sur l’IA ; si vous le savez et que vous ne vous en souciez pas, c’est encore pire. Si vous en faites un co-auteur, cela montre que vous essayez simplement de suivre la foule plutôt que de réellement faire des recherches.

- Les gens sont trop forts sur les filtres ChatGPT.

Vous ne croiriez pas une calculatrice qui n’est correcte qu’à 75 %. Alors, si vous déclarez ouvertement que vous êtes enthousiasmé par « l’écriture » d’un article en utilisant un « mauvais » outil d’intelligence artificielle, pourquoi devrais-je le faire ? Vous faites confiance ?

- Le but de la rédaction scientifique est d'enseigner clairement la vérité aux autres.

Si vous considérez ChatGPT comme un être sensible, ce qui n'est clairement pas le cas, vous induisez le public en erreur en lui faisant ressentir la même chose, vous ne diffusez pas d'idées scientifiques, vous ne faites que dire des conneries. Veuillez arrêter ce comportement.

Finalement, Marcus a conclu : un véritable ami ne permettra pas à ChatGPT d'être co-auteur de votre article.

Si Marcus a eu un débat passionné avec LeCun et d'autres sur les perspectives de l'intelligence artificielle et la faisabilité de l'AGI, et a accusé LeCun de s'attribuer le mérite des autres pour sa "feuille de route de l'intelligence artificielle", c'était plus ou moins une rancune personnelle Si tel est le cas, alors cette fois, les inquiétudes et la vigilance exprimées à propos de ChatGPT sont très pertinentes.

En fait, ce que Marcus a mentionné ci-dessus à propos de ChatGPT, de la fraude papier et des litiges en matière de droits d'auteur est devenu une réalité quelques semaines seulement après le lancement de ChatGPT.

Récemment, Darren Schick, professeur de philosophie à l'Université Furman, a découvert qu'un article soumis par un étudiant était généré par l'intelligence artificielle.

Hick a déclaré qu'il était devenu méfiant lorsqu'il avait vu les informations apparemment soigneusement rédigées mais fausses dans le journal.

Il a soumis l'article au détecteur ChatGPT d'Open AI, et les résultats ont montré qu'il y avait 99 % de chances que cet article soit généré par l'intelligence artificielle.

Par coïncidence, Antony Aumann, professeur à la Northern Michigan University, a également déclaré qu'il avait également découvert que deux étudiants avaient soumis des articles écrits par ChatGPT.

Après avoir remarqué que quelque chose n'allait pas dans le style d'écriture des deux articles, Orman a soumis les articles au chatbot et a demandé quelle était la probabilité qu'ils aient été écrits par le programme. Lorsque le chatbot a déclaré qu'il était sûr à 99 % qu'il avait été écrit par ChatGPT, il a transmis le résultat à l'étudiant.

Schick et Orman ont déclaré qu'après avoir confronté les étudiants, tous ont finalement admis les violations. Les élèves de Hick ont échoué au cours et Ohman a demandé à ses élèves de réécrire le devoir à partir de zéro.

Bien que l'article comporte des erreurs, il est bien écrit

Les deux professeurs ont déclaré que des traces évidentes peuvent être vues dans certains points clés des deux articles générés par l'IA. Schick a déclaré que le document qu'il avait trouvé mentionnait plusieurs faits non mentionnés en classe et faisait une affirmation sans objet.

Il a déclaré : « Sur le papier, c'est un article bien écrit, mais à y regarder de plus près, une déclaration sur le prolifique philosophe David Hume n'a aucun sens, voire complètement fausse. »

Ce genre de parfaitement Une erreur de finition est le plus gros défaut de l'écriture fantôme de l'IA.

Pour Orman, le chatbot est tout simplement trop parfaitement écrit. "Je pense que cet outil de chat est mieux écrit que 95 % de mes étudiants."

"C'est juste que tout d'un coup, vous avez quelqu'un qui n'a pas montré ce niveau de réflexion ou de capacité d'écriture en écrivant quelque chose qui convient parfaitement à tous. Les exigences contenaient une grammaire complexe et des idées complexes, qui étaient directement liées aux invites de l'article, et cela semblait immédiatement faux », a-t-il déclaré.

Christopher Bartell, professeur de philosophie à l'Appalachian State University, a déclaré que si la grammaire des articles générés par l'IA est presque parfaite, le contenu de fond manque souvent de détails.

"Pas d'expérience, pas de profondeur, pas de perspicacité."

Plagiat difficile à prouver : rien ne peut être fait sans avouer

Mais cela dit, plusieurs étudiants de professeurs ont admis avoir recours à l'écriture fantôme par l'IA. En fait, les universitaires risquent d'être en difficulté si les étudiants refusent d'admettre qu'ils utilisent l'intelligence artificielle pour rédiger des articles.

Battle a déclaré que les règles actuelles de certains établissements universitaires n'ont pas été développées pour lutter contre ce type de tricherie. Si un étudiant fait tout son possible pour nier avoir recours à l’intelligence artificielle, il est en réalité difficile de prouver définitivement une telle tricherie.

Il a également déclaré que les outils de détection d'IA fournis par OpenAI sont bons, mais pas parfaits.

Cet outil effectue une analyse statistique sur la possibilité que le texte ait été généré par l'intelligence artificielle et donne une probabilité.

La politique actuelle est généralement qu'il doit y avoir des preuves claires et vérifiables pour prouver que le papier est faux avant de pouvoir être considéré comme un marteau, ce qui nous met dans une position très difficile. Si le résultat renvoyé est à 95 % susceptible d’être un article généré par l’intelligence artificielle, et à 5 % non.

Dans le cas de Hick, bien que le site Web de test ait déclaré qu'il était "certain à 99%" que le papier avait été généré par l'intelligence artificielle, en fait, la clé réside dans le fait que l'étudiant lui-même l'admet, sinon sur la base de ce seul résultat de probabilité. , ce n’est pas correct. La confirmation de la tricherie ne suffit pas en soi.

Hick a déclaré que les aveux sont importants, mais à part cela, tout le reste est une preuve circonstancielle. Pour le contenu généré par l'intelligence artificielle, il n'y a généralement aucune preuve matérielle, et les preuves matérielles ont plus de poids que les preuves indirectes. "

Oman a déclaré que même s'il pense que l'analyse du chatbot constitue une preuve suffisante pour agir, l'utilisation de l'intelligence artificielle pour plagier et tricher reste un nouveau défi pour les collèges et les universités.

Après tout, ChatGPT a désormais la capacité pour paraître réel et faux Tant que l'utilisateur le souhaite, il peut devenir CheatGPT en quelques minutes seulement

.Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

Video Face Swap

Échangez les visages dans n'importe quelle vidéo sans effort grâce à notre outil d'échange de visage AI entièrement gratuit !

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Sujets chauds

ChatGPT permet désormais aux utilisateurs gratuits de générer des images en utilisant DALL-E 3 avec une limite quotidienne

Aug 09, 2024 pm 09:37 PM

ChatGPT permet désormais aux utilisateurs gratuits de générer des images en utilisant DALL-E 3 avec une limite quotidienne

Aug 09, 2024 pm 09:37 PM

Le DALL-E 3 a été officiellement introduit en septembre 2023 en tant que modèle considérablement amélioré par rapport à son prédécesseur. Il est considéré comme l’un des meilleurs générateurs d’images IA à ce jour, capable de créer des images avec des détails complexes. Cependant, au lancement, c'était exclu

Le papier Stable Diffusion 3 est enfin publié, et les détails architecturaux sont révélés. Cela aidera-t-il à reproduire Sora ?

Mar 06, 2024 pm 05:34 PM

Le papier Stable Diffusion 3 est enfin publié, et les détails architecturaux sont révélés. Cela aidera-t-il à reproduire Sora ?

Mar 06, 2024 pm 05:34 PM

L'article de StableDiffusion3 est enfin là ! Ce modèle est sorti il y a deux semaines et utilise la même architecture DiT (DiffusionTransformer) que Sora. Il a fait beaucoup de bruit dès sa sortie. Par rapport à la version précédente, la qualité des images générées par StableDiffusion3 a été considérablement améliorée. Il prend désormais en charge les invites multithèmes, et l'effet d'écriture de texte a également été amélioré et les caractères tronqués n'apparaissent plus. StabilityAI a souligné que StableDiffusion3 est une série de modèles avec des tailles de paramètres allant de 800M à 8B. Cette plage de paramètres signifie que le modèle peut être exécuté directement sur de nombreux appareils portables, réduisant ainsi considérablement l'utilisation de l'IA.

La combinaison parfaite de ChatGPT et Python : créer un chatbot de service client intelligent

Oct 27, 2023 pm 06:00 PM

La combinaison parfaite de ChatGPT et Python : créer un chatbot de service client intelligent

Oct 27, 2023 pm 06:00 PM

La combinaison parfaite de ChatGPT et Python : Création d'un chatbot de service client intelligent Introduction : À l'ère de l'information d'aujourd'hui, les systèmes de service client intelligents sont devenus un outil de communication important entre les entreprises et les clients. Afin d'offrir une meilleure expérience de service client, de nombreuses entreprises ont commencé à se tourner vers les chatbots pour effectuer des tâches telles que la consultation des clients et la réponse aux questions. Dans cet article, nous présenterons comment utiliser le puissant modèle ChatGPT et le langage Python d'OpenAI pour créer un chatbot de service client intelligent afin d'améliorer

Comment installer chatgpt sur un téléphone mobile

Mar 05, 2024 pm 02:31 PM

Comment installer chatgpt sur un téléphone mobile

Mar 05, 2024 pm 02:31 PM

Étapes d'installation : 1. Téléchargez le logiciel ChatGTP depuis le site officiel ou la boutique mobile de ChatGTP ; 2. Après l'avoir ouvert, dans l'interface des paramètres, sélectionnez la langue chinoise 3. Dans l'interface de jeu, sélectionnez le jeu homme-machine et définissez la langue. Spectre chinois ; 4. Après avoir démarré, entrez les commandes dans la fenêtre de discussion pour interagir avec le logiciel.

Comment développer un chatbot intelligent en utilisant ChatGPT et Java

Oct 28, 2023 am 08:54 AM

Comment développer un chatbot intelligent en utilisant ChatGPT et Java

Oct 28, 2023 am 08:54 AM

Dans cet article, nous présenterons comment développer des chatbots intelligents à l'aide de ChatGPT et Java, et fournirons quelques exemples de code spécifiques. ChatGPT est la dernière version du Generative Pre-training Transformer développé par OpenAI, une technologie d'intelligence artificielle basée sur un réseau neuronal qui peut comprendre le langage naturel et générer du texte de type humain. En utilisant ChatGPT, nous pouvons facilement créer des discussions adaptatives

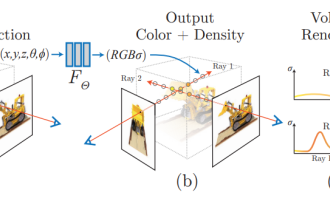

NeRF et le passé et le présent de la conduite autonome, résumé de près de 10 articles !

Nov 14, 2023 pm 03:09 PM

NeRF et le passé et le présent de la conduite autonome, résumé de près de 10 articles !

Nov 14, 2023 pm 03:09 PM

Depuis que Neural Radiance Fields a été proposé en 2020, le nombre d'articles connexes a augmenté de façon exponentielle. Il est non seulement devenu une branche importante de la reconstruction tridimensionnelle, mais est également progressivement devenu actif à la frontière de la recherche en tant qu'outil important pour la conduite autonome. . NeRF a soudainement émergé au cours des deux dernières années, principalement parce qu'il ignore l'extraction et la mise en correspondance des points caractéristiques, la géométrie et la triangulation épipolaires, le PnP plus l'ajustement du faisceau et d'autres étapes du pipeline de reconstruction CV traditionnel, et ignore même la reconstruction du maillage, la cartographie et le traçage de la lumière. , directement à partir de la 2D L'image d'entrée est utilisée pour apprendre un champ de rayonnement, puis une image rendue qui se rapproche d'une photo réelle est sortie du champ de rayonnement. En d’autres termes, supposons qu’un modèle tridimensionnel implicite basé sur un réseau neuronal s’adapte à la perspective spécifiée.

Comment créer un robot de service client intelligent en utilisant ChatGPT PHP

Oct 28, 2023 am 09:34 AM

Comment créer un robot de service client intelligent en utilisant ChatGPT PHP

Oct 28, 2023 am 09:34 AM

Comment utiliser ChatGPTPHP pour créer un robot de service client intelligent Introduction : Avec le développement de la technologie de l'intelligence artificielle, les robots sont de plus en plus utilisés dans le domaine du service client. L'utilisation de ChatGPTPHP pour créer un robot de service client intelligent peut aider les entreprises à fournir des services client plus efficaces et personnalisés. Cet article explique comment utiliser ChatGPTPHP pour créer un robot de service client intelligent et fournit des exemples de code spécifiques. 1. Installez ChatGPTPHP et utilisez ChatGPTPHP pour créer un robot de service client intelligent.

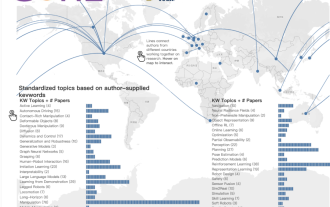

L'équipe chinoise a remporté les prix du meilleur article et du meilleur article système, et les résultats de la recherche CoRL ont été annoncés.

Nov 10, 2023 pm 02:21 PM

L'équipe chinoise a remporté les prix du meilleur article et du meilleur article système, et les résultats de la recherche CoRL ont été annoncés.

Nov 10, 2023 pm 02:21 PM

Depuis sa première tenue en 2017, CoRL est devenue l'une des conférences universitaires les plus importantes au monde à l'intersection de la robotique et de l'apprentissage automatique. CoRL est une conférence à thème unique pour la recherche sur l'apprentissage des robots, couvrant plusieurs sujets tels que la robotique, l'apprentissage automatique et le contrôle, y compris la théorie et l'application. La conférence CoRL 2023 se tiendra à Atlanta, aux États-Unis, du 6 au 9 novembre. Selon les données officielles, 199 articles provenant de 25 pays ont été sélectionnés pour CoRL cette année. Les sujets populaires incluent les opérations, l’apprentissage par renforcement, etc. Bien que CoRL soit à plus petite échelle que les grandes conférences universitaires sur l'IA telles que l'AAAI et le CVPR, à mesure que la popularité de concepts tels que les grands modèles, l'intelligence incarnée et les robots humanoïdes augmente cette année, des recherches pertinentes dignes d'attention seront également