Périphériques technologiques

Périphériques technologiques

IA

IA

Ne paniquez pas si vous révisez votre article 100 fois ! Meta publie un nouveau modèle de langage d'écriture PEER : des références seront ajoutées

Ne paniquez pas si vous révisez votre article 100 fois ! Meta publie un nouveau modèle de langage d'écriture PEER : des références seront ajoutées

Ne paniquez pas si vous révisez votre article 100 fois ! Meta publie un nouveau modèle de langage d'écriture PEER : des références seront ajoutées

En près de deux ans et demi depuis sa sortie en mai 2020, GPT-3 a très bien aidé les humains à écrire grâce à ses capacités magiques de génération de texte.

Mais en dernière analyse, GPT-3 est un modèle de génération de texte, dont on peut dire qu'il est complètement différent du processus d'écriture humain.

Par exemple, si nous voulons rédiger un article ou une composition, nous devons d'abord construire un cadre dans notre esprit, vérifier les informations pertinentes, rédiger un brouillon, puis trouver un tuteur pour réviser et peaufiner constamment le texte pendant cette période. , nous pouvons aussi réviser les idées, et enfin nous pouvons devenir un bon article.

Le texte obtenu par le modèle génératif ne peut répondre qu'aux exigences grammaticales, mais n'a aucune logique dans la disposition du contenu et n'a pas la capacité de s'auto-modifier, il est donc encore loin de laisser l'IA écrire de manière indépendante.

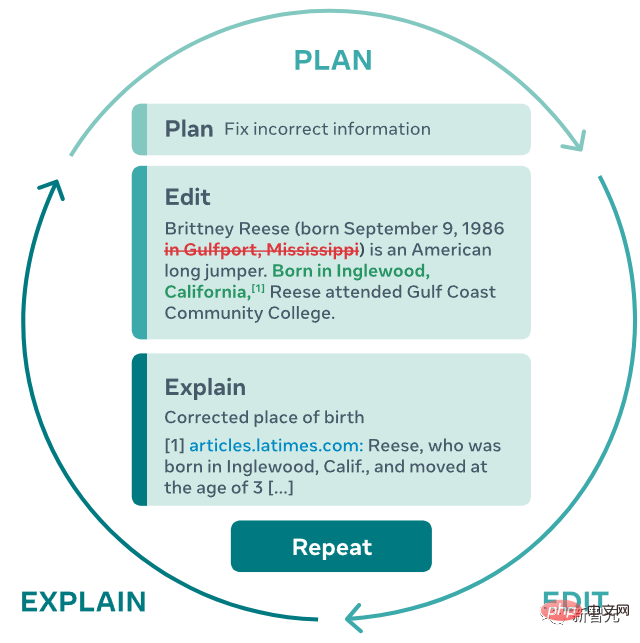

Récemment, des chercheurs de Meta AI Research et de l'Université Carnegie Mellon ont proposé un nouveau modèle de génération de texte PEER (Plan, Edit, Explain, Repeat), qui simule complètement le processus d'écriture humaine, de la rédaction à la sollicitation de suggestions jusqu'à l'édition de texte, et itérer à partir de là.

Adresse papier : https://arxiv.org/abs/2208.11663

PEER résout le problème selon lequel les modèles de langage traditionnels ne généreront que des résultats finaux et que le texte généré ne peut pas être contrôlé en saisissant des commandes en langage naturel, PEER Des modifications peuvent être apportées au texte généré.

Le plus important est que les chercheurs ont formé plusieurs instances de PEER, qui peuvent remplir plusieurs liens dans le processus d'écriture, grâce auxquelles la technologie d'auto-formation peut être utilisée pour améliorer la qualité, la quantité et la qualité des données de formation. Diversité.

La capacité de générer des données de formation signifie que le potentiel de PEER va bien au-delà de la rédaction d'essais et peut également être utilisé dans d'autres domaines sans modifier l'historique, ce qui lui permet d'améliorer progressivement sa capacité à suivre des instructions, à rédiger des commentaires utiles et à expliquer son contenu. actes.

La PNL s'applique également à la bionique

Après la pré-formation avec le langage naturel, l'effet de génération de texte des grands réseaux de neurones est déjà très fort, mais la méthode de génération de ces modèles consiste essentiellement à sortir le texte résultat immédiatement de gauche à droite , ce qui est différent des êtres humains. Le processus itératif d'écriture est très différent.

La génération unique présente également de nombreux inconvénients. Par exemple, il est impossible de retracer les phrases dans le texte à modifier ou à améliorer, ni d'expliquer la raison pour laquelle une certaine phrase de texte a été générée. Elle est également difficile à tester. l'exactitude du texte généré, et des hallucinations (halluciner) sont souvent générées dans le contenu des résultats, c'est-à-dire un texte qui n'est pas conforme aux faits. Ces défauts limitent également la capacité du modèle à écrire en collaboration avec des humains, qui ont besoin d'un texte cohérent et factuel.

Le modèle PEER est formé sur « l'historique d'édition » du texte, permettant au modèle de simuler le processus d'écriture humain.

1. Lorsque le modèle PEER est en cours d'exécution, l'utilisateur ou le modèle doit spécifier un plan (Plan) et décrire l'action (action) qu'il souhaite effectuer en langage naturel, comme l'ajout d'informations ou la correction d'erreurs de grammaire. ;

2 , puis mettre en œuvre cette action en éditant le texte

3. Le modèle peut utiliser le langage naturel et pointer vers des ressources pertinentes pour expliquer les résultats de l'édition, comme l'ajout d'une référence à la fin du texte ; 4. Répétez (Répétez) ce processus jusqu'à ce que le texte généré ne nécessite plus de mises à jour supplémentaires.

Cette approche itérative permet non seulement au modèle de décomposer la tâche complexe d'écriture d'un texte cohérent, cohérent et factuel en plusieurs sous-tâches plus faciles, mais permet également aux humains d'intervenir à tout moment du processus de génération, de guider le modèle dans le bon sens. direction, fournissez aux utilisateurs des plans et des commentaires, ou commencez à le modifier vous-même.

Il ressort de la description de la méthode que la chose la plus difficile dans la mise en œuvre de la fonction n'est pas d'utiliser Transformer pour construire un modèle, mais de trouver des données d'entraînement. Nous voulons trouver une méthode capable d'apprendre ce processus. l'échelle requise pour former un grand modèle de langage. Les données sont évidemment très difficiles car la plupart des sites Web ne fournissent pas d'historique d'édition, de sorte que les pages Web obtenues via les robots d'exploration ne peuvent pas être utilisées comme données de formation.

Il ressort de la description de la méthode que la chose la plus difficile dans la mise en œuvre de la fonction n'est pas d'utiliser Transformer pour construire un modèle, mais de trouver des données d'entraînement. Nous voulons trouver une méthode capable d'apprendre ce processus. l'échelle requise pour former un grand modèle de langage. Les données sont évidemment très difficiles car la plupart des sites Web ne fournissent pas d'historique d'édition, de sorte que les pages Web obtenues via les robots d'exploration ne peuvent pas être utilisées comme données de formation.

Même explorer la même page Web à des moments différents en tant qu'historique des modifications n'est pas réalisable car il n'y a pas de texte pertinent qui planifie ou explique la modification.

PEER est similaire aux méthodes d'édition itératives précédentes, utilisant Wikipédia comme source de données pour les éditeurs principaux et les commentaires associés, car Wikipédia fournit un historique d'édition complet, comprenant des commentaires sur une variété de sujets, et est de grande taille, souvent inclus dans les articles. Citation, utile pour trouver des documents pertinents.

Mais s'appuyer uniquement sur Wikipédia comme seule source de données de formation présente également divers inconvénients :

1. Le modèle formé en utilisant uniquement Wikipédia doit être similaire à Wikipédia en termes d'apparence attendue du contenu du texte et de planification et d'édition prévues

; 2. Les commentaires dans Wikipédia sont bruyants, donc dans de nombreux cas, les commentaires ne sont pas appropriés pour la planification ou l'explication.

3 De nombreux passages dans Wikipédia ne contiennent aucune citation, bien que ces informations générales puissent être corrigées en utilisant un système de recherche ; , mais même un tel système peut ne pas être en mesure de trouver des informations de base pour de nombreux éditeurs.

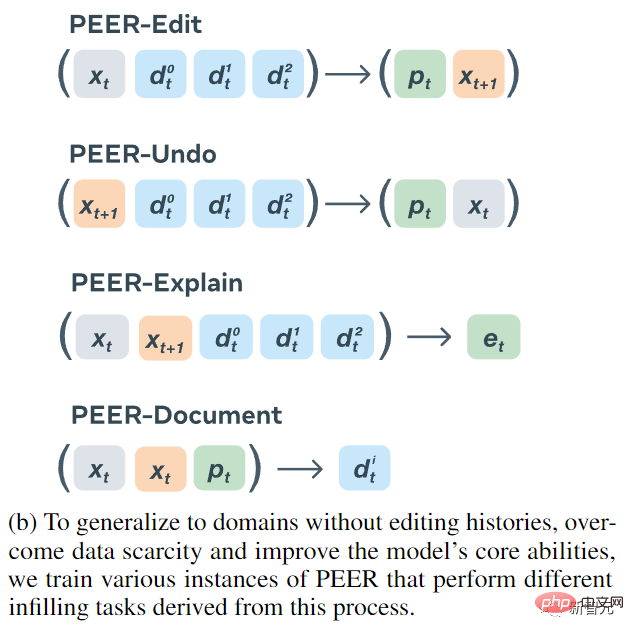

Les chercheurs ont proposé une méthode simple pour résoudre tous les problèmes causés par le fait que Wikipédia est la seule source d'historique d'édition des commentaires : à savoir, former plusieurs instances PEER et utiliser ces instances pour apprendre à renseigner divers aspects du processus d'édition. Ces modèles peuvent être utilisés pour générer des données synthétiques en remplacement des parties manquantes du corpus de formation.

Quatre modèles d'encodeur-décodeur ont finalement été formés :

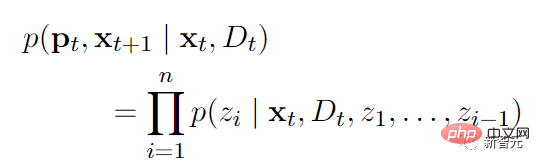

1. L'entrée de PEER-Edit est le texte x et un ensemble de documents, et la sortie du modèle est le texte planifié et édité, où p est le texte prévu .

2. L'entrée de PEER-Undo est le texte modifié et un ensemble de documents, et la sortie du modèle indique s'il faut annuler la modification.

3. PEER-Explain est utilisé pour générer une explication de la modification. L'entrée est le texte source, le texte édité et un ensemble de documents associés.

4. Le document PEER saisit le texte source, le texte modifié et le plan, et la sortie du modèle constitue l'information de base la plus utile dans cette modification.

Toutes les variantes de modèles de PEER sont utilisées pour générer des données synthétiques, à la fois pour générer des données d'entraînement afin de compléter les parties manquantes et pour remplacer les parties « de mauvaise qualité » des données existantes.

Afin de pouvoir entraîner des données de texte arbitraires, même si le texte n'a pas d'historique d'édition, PEER-Undo est utilisé pour générer une édition synthétique "en arrière", c'est-à-dire que PEER-Undo est appliqué à plusieurs reprises au texte source jusqu'à ce que le le texte est vide, puis appelé PEER-Edit trains dans la direction opposée.

Lors de la génération de plans, utilisez PEER-Explain pour corriger de nombreux commentaires de mauvaise qualité dans le corpus, ou pour traiter des textes sans commentaires. Échantillonnez aléatoirement plusieurs résultats de la sortie de PEER-Explain en tant que « plans potentiels », calculez la probabilité d'une modification réelle et sélectionnez celui avec la probabilité la plus élevée comme nouveau plan.

Si le document pertinent ne peut pas être trouvé pour une opération d'édition spécifique, PEER-Document est utilisé pour générer un ensemble de documents synthétiques contenant les informations permettant d'effectuer l'opération d'édition. Plus important encore, PEER-Edit ne le fait que pendant la formation et ne fournit aucun document synthétique pendant la phase d'inférence.

Pour améliorer la qualité et la diversité des plans, des modifications et de la documentation générés, les chercheurs ont également mis en œuvre un mécanisme de contrôle qui prédéfinit des marqueurs de contrôle spécifiques dans les séquences de sortie générées par le modèle en cours d'entraînement, puis les ont utilisés lors de l'inférence. Balises de contrôle pour guider génération de modèle. Les balises incluent :

1. type est utilisé pour contrôler le type de texte généré par PEER-Explain. Les valeurs facultatives sont instructionon (la sortie doit commencer par un infinitif pour ....) et autre ; 2. length, contrôle la longueur de sortie de PEER-Explain. Les valeurs facultatives incluent s (moins de 2 mots), m (2-3 mots), l (4-5 mots) et xl (supérieur ou égal à 6). mots);

3. se chevauchent, si les mots générés par PEER-Explain peuvent être répétés avec le texte édité, les valeurs facultatives sont vraies et fausses

4. texte et texte édité Le nombre de mots différents entre eux, les valeurs facultatives sont toutes des nombres entiers ;

5, contient, utilisé pour garantir que le texte généré par PEER-Document contient une certaine sous-chaîne

PEER n'introduit pas de contrôle caractères à modifier par PEER, c'est-à-dire qu'il ne suppose pas que l'utilisateur Les types de tâches d'édition qui pourraient être résolues avec le modèle rendent le modèle plus général.

Dans la phase de comparaison expérimentale, PEER utilise la version paramètre 3B de LM-Adapted T5 pour l'initialisation pré-entraînement.

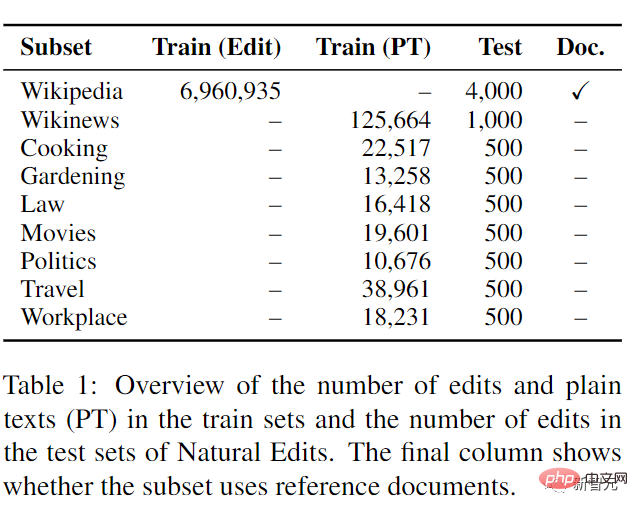

Pour évaluer la capacité de PEER à suivre une série de plans, à utiliser les documents fournis et à effectuer des modifications dans différents domaines, en particulier dans les domaines sans historique de modification, un nouvel ensemble de données Natural Edits est introduit. et les champs.

Les données ont été collectées à partir de trois sources Web en anglais : des pages d'encyclopédie de Wikipédia, des articles de presse de Wikinews et des questions des sous-forums Cuisine, Jardinage, Droit, Film, Politique, Voyage et Lieu de travail, tous ces sites fournissent. un historique des modifications avec des commentaires qui détaillent l'intention de l'éditeur et la fournissent au modèle sous forme de plan.

Dans la formation des sous-ensembles Wikinews et StackExchange, seules les données en texte brut sont fournies au lieu de l'édition réelle, testant ainsi la capacité d'édition dans les zones sans historique d'édition.

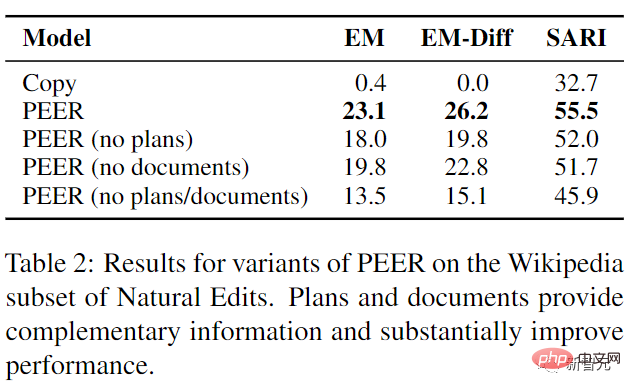

Les résultats expérimentaux montrent que PEER surpasse toutes les lignes de base dans une certaine mesure, et le plan et la documentation fournissent des informations complémentaires que le modèle peut utiliser

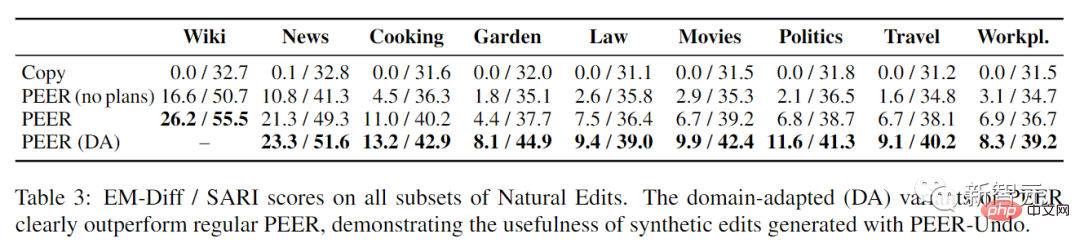

Il peut être trouvé après avoir évalué PEER sur tous les sous-ensembles de modifications naturelles, la planification a été d’une grande aide dans tous les domaines, ce qui suggère que la capacité à comprendre la planification dans l’édition de Wikipédia est directement transférable à d’autres domaines. Il est important de noter que la variante adaptative au domaine de PEER surpasse considérablement le PEER standard sur tous les sous-ensembles de Natural Edits, en particulier avec de grandes améliorations sur les sous-ensembles de jardinage, de politique et de cinéma (84 %, 71 %, et 48 % d'EM-). Diff), montre également l'efficacité de la génération de modifications synthétiques lors de l'application de PEER dans différents domaines.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Géospatial de Laravel: optimisation des cartes interactives et de grandes quantités de données

Apr 08, 2025 pm 12:24 PM

Géospatial de Laravel: optimisation des cartes interactives et de grandes quantités de données

Apr 08, 2025 pm 12:24 PM

Traiter efficacement 7 millions d'enregistrements et créer des cartes interactives avec la technologie géospatiale. Cet article explore comment traiter efficacement plus de 7 millions d'enregistrements en utilisant Laravel et MySQL et les convertir en visualisations de cartes interactives. Exigences initiales du projet de défi: extraire des informations précieuses en utilisant 7 millions d'enregistrements dans la base de données MySQL. Beaucoup de gens considèrent d'abord les langages de programmation, mais ignorent la base de données elle-même: peut-il répondre aux besoins? La migration des données ou l'ajustement structurel est-il requis? MySQL peut-il résister à une charge de données aussi importante? Analyse préliminaire: les filtres et les propriétés clés doivent être identifiés. Après analyse, il a été constaté que seuls quelques attributs étaient liés à la solution. Nous avons vérifié la faisabilité du filtre et établi certaines restrictions pour optimiser la recherche. Recherche de cartes basée sur la ville

Comment résoudre MySQL ne peut pas être démarré

Apr 08, 2025 pm 02:21 PM

Comment résoudre MySQL ne peut pas être démarré

Apr 08, 2025 pm 02:21 PM

Il existe de nombreuses raisons pour lesquelles la startup MySQL échoue, et elle peut être diagnostiquée en vérifiant le journal des erreurs. Les causes courantes incluent les conflits de port (vérifier l'occupation du port et la configuration de modification), les problèmes d'autorisation (vérifier le service exécutant les autorisations des utilisateurs), les erreurs de fichier de configuration (vérifier les paramètres des paramètres), la corruption du répertoire de données (restaurer les données ou reconstruire l'espace de la table), les problèmes d'espace de la table InNODB (vérifier les fichiers IBDATA1), la défaillance du chargement du plug-in (vérification du journal des erreurs). Lors de la résolution de problèmes, vous devez les analyser en fonction du journal d'erreur, trouver la cause profonde du problème et développer l'habitude de sauvegarder régulièrement les données pour prévenir et résoudre des problèmes.

Comment utiliser MySQL après l'installation

Apr 08, 2025 am 11:48 AM

Comment utiliser MySQL après l'installation

Apr 08, 2025 am 11:48 AM

L'article présente le fonctionnement de la base de données MySQL. Tout d'abord, vous devez installer un client MySQL, tel que MySQLWorkBench ou le client de ligne de commande. 1. Utilisez la commande MySQL-UROot-P pour vous connecter au serveur et connecter avec le mot de passe du compte racine; 2. Utilisez Createdatabase pour créer une base de données et utilisez Sélectionner une base de données; 3. Utilisez CreateTable pour créer une table, définissez des champs et des types de données; 4. Utilisez InsertInto pour insérer des données, remettre en question les données, mettre à jour les données par mise à jour et supprimer les données par Supprimer. Ce n'est qu'en maîtrisant ces étapes, en apprenant à faire face à des problèmes courants et à l'optimisation des performances de la base de données que vous pouvez utiliser efficacement MySQL.

Les ingénieurs de backend senior à distance (plates-formes) ont besoin de cercles

Apr 08, 2025 pm 12:27 PM

Les ingénieurs de backend senior à distance (plates-formes) ont besoin de cercles

Apr 08, 2025 pm 12:27 PM

Ingénieur backend à distance Emploi Vacant Société: Emplacement du cercle: Bureau à distance Type d'emploi: Salaire à temps plein: 130 000 $ - 140 000 $ Description du poste Participez à la recherche et au développement des applications mobiles Circle et des fonctionnalités publiques liées à l'API couvrant l'intégralité du cycle de vie de développement logiciel. Les principales responsabilités complètent indépendamment les travaux de développement basés sur RubyOnRails et collaborent avec l'équipe frontale React / Redux / Relay. Créez les fonctionnalités de base et les améliorations des applications Web et travaillez en étroite collaboration avec les concepteurs et le leadership tout au long du processus de conception fonctionnelle. Promouvoir les processus de développement positifs et hiérarchiser la vitesse d'itération. Nécessite plus de 6 ans de backend d'applications Web complexe

Mysql peut-il renvoyer JSON

Apr 08, 2025 pm 03:09 PM

Mysql peut-il renvoyer JSON

Apr 08, 2025 pm 03:09 PM

MySQL peut renvoyer les données JSON. La fonction JSON_Extract extrait les valeurs de champ. Pour les requêtes complexes, envisagez d'utiliser la clause pour filtrer les données JSON, mais faites attention à son impact sur les performances. Le support de MySQL pour JSON augmente constamment, et il est recommandé de faire attention aux dernières versions et fonctionnalités.

La clé principale de MySQL peut être nul

Apr 08, 2025 pm 03:03 PM

La clé principale de MySQL peut être nul

Apr 08, 2025 pm 03:03 PM

La clé primaire MySQL ne peut pas être vide car la clé principale est un attribut de clé qui identifie de manière unique chaque ligne dans la base de données. Si la clé primaire peut être vide, l'enregistrement ne peut pas être identifié de manière unique, ce qui entraînera une confusion des données. Lorsque vous utilisez des colonnes entières ou des UUIdes auto-incrémentales comme clés principales, vous devez considérer des facteurs tels que l'efficacité et l'occupation de l'espace et choisir une solution appropriée.

Comprendre les propriétés acides: les piliers d'une base de données fiable

Apr 08, 2025 pm 06:33 PM

Comprendre les propriétés acides: les piliers d'une base de données fiable

Apr 08, 2025 pm 06:33 PM

Une explication détaillée des attributs d'acide de base de données Les attributs acides sont un ensemble de règles pour garantir la fiabilité et la cohérence des transactions de base de données. Ils définissent comment les systèmes de bases de données gérent les transactions et garantissent l'intégrité et la précision des données même en cas de plantages système, d'interruptions d'alimentation ou de plusieurs utilisateurs d'accès simultanément. Présentation de l'attribut acide Atomicité: une transaction est considérée comme une unité indivisible. Toute pièce échoue, la transaction entière est reculée et la base de données ne conserve aucune modification. Par exemple, si un transfert bancaire est déduit d'un compte mais pas augmenté à un autre, toute l'opération est révoquée. BeginTransaction; UpdateAccountSsetBalance = Balance-100Wh

Master SQL Limit Clause: Contrôlez le nombre de lignes dans une requête

Apr 08, 2025 pm 07:00 PM

Master SQL Limit Clause: Contrôlez le nombre de lignes dans une requête

Apr 08, 2025 pm 07:00 PM

Clause SQLLIMIT: Contrôlez le nombre de lignes dans les résultats de la requête. La clause limite dans SQL est utilisée pour limiter le nombre de lignes renvoyées par la requête. Ceci est très utile lors du traitement de grands ensembles de données, des affichages paginés et des données de test, et peut améliorer efficacement l'efficacité de la requête. Syntaxe de base de la syntaxe: selectColumn1, Column2, ... FromTable_NamelimitNumber_Of_Rows; Number_OF_ROWS: Spécifiez le nombre de lignes renvoyées. Syntaxe avec décalage: selectColumn1, Column2, ... FromTable_Namelimitoffset, numéro_of_rows; décalage: sauter