Périphériques technologiques

Périphériques technologiques

IA

IA

La version papier « ChatGPT » est là ! Vous pouvez lire des articles et poser des questions en même temps. Internaute : la lecture de documents fait gagner du temps.

La version papier « ChatGPT » est là ! Vous pouvez lire des articles et poser des questions en même temps. Internaute : la lecture de documents fait gagner du temps.

La version papier « ChatGPT » est là ! Vous pouvez lire des articles et poser des questions en même temps. Internaute : la lecture de documents fait gagner du temps.

Bonne nouvelle pour les chercheurs scientifiques ! "ChatGPT" est là spécifiquement pour parler aux journaux.

Trop paresseux pour lire le journal ? Cela n'a pas d'importance, laissez cet outil le vérifier pour vous. Si vous avez des questions, posez-les.

Et tout ce que vous avez à faire dans tout le processus est de télécharger des articles et de poser des questions.

Mais vous vous sentez confus et ne croyez pas la réponse qu'il donne ?

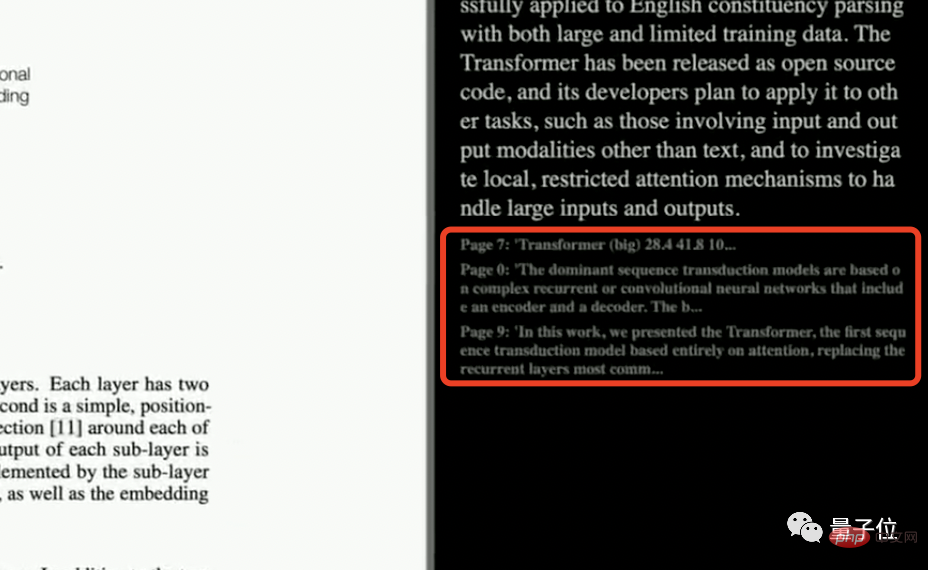

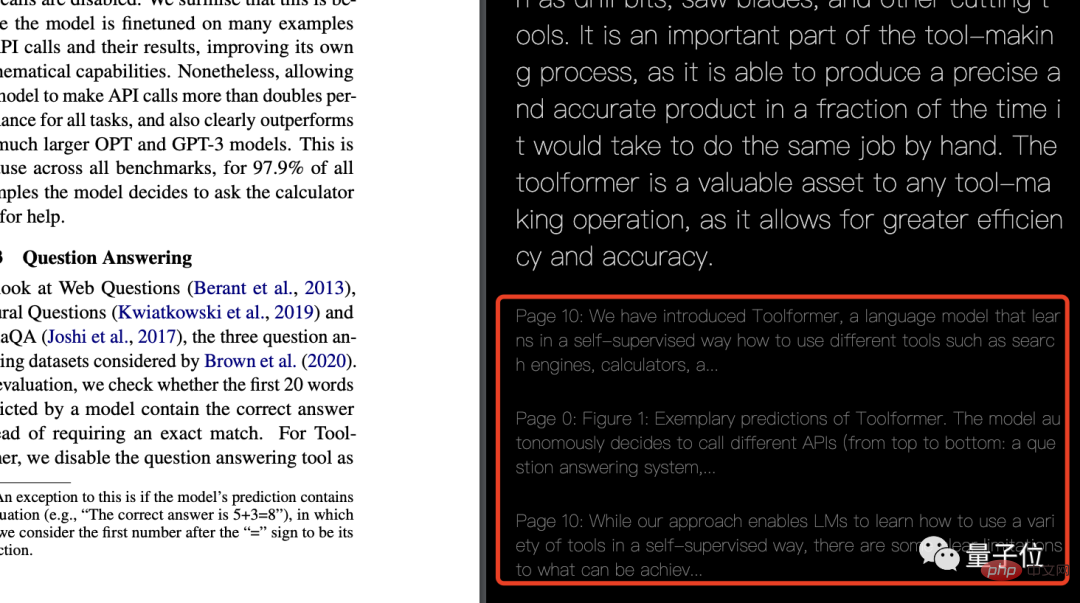

Peu importe, les réponses données ont été clairement indiquées à partir de quelle page et à quel endroit dans le document, et vous pouvez passer le test à tout moment.

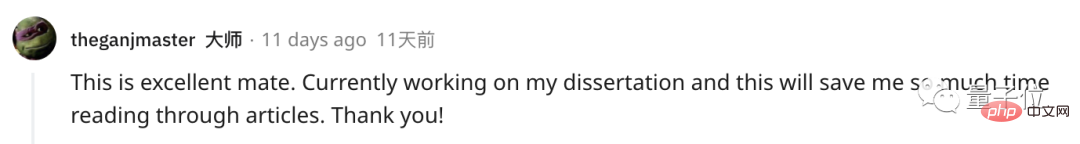

Celui-ci a directement incité les internautes à le qualifier de si cool :

J'écris une thèse, ce qui fait directement gagner beaucoup de temps dans la lecture de la littérature.

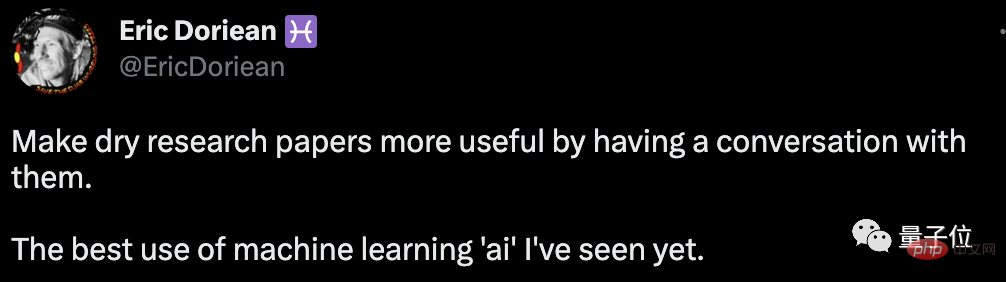

Certains internautes ont même annoncé unilatéralement qu'il s'agissait du meilleur outil d'IA qu'il ait jamais vu.

Ce gadget s'appelle ResearchGPT. Le projet est open source et a été mis en vedette 400 fois sur GitHub.

Comment utiliser ?

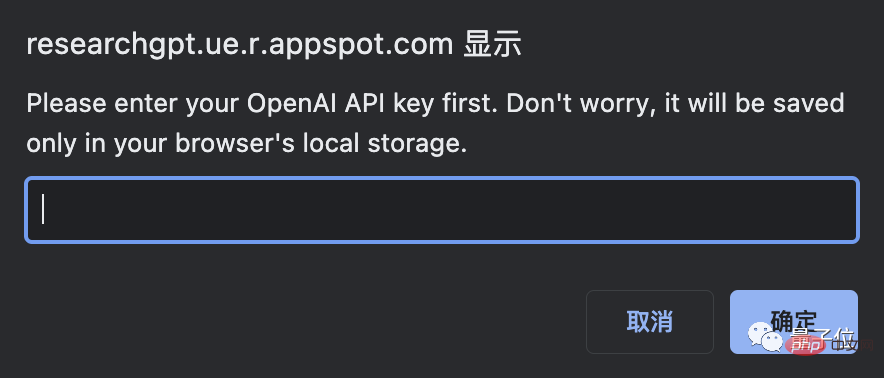

Pour utiliser ResearchGPT, vous devez d'abord disposer d'une clé API OpenAI.

La clé peut être copiée directement depuis le site officiel d'OpenAI. Les étapes spécifiques sont les suivantes :

Après avoir saisi la clé, vous pouvez directement télécharger le PDF ou le lien du document que vous avez écrit. voulez lire, à gauche Sur le côté droit, il affichera le texte original de l'article, et sur le côté droit vous pourrez lui poser directement des questions.

Quelle est la réponse ? Accédez directement à la démonstration :

Je dois dire que la réponse donnée est quand même raisonnable.

En parlant de ça, comment cet outil parvient-il à répondre couramment au papier ?

Pour mettre les choses en perspective, ResearchGPT examinera d'abord la question que vous avez posée et en extraira des mots-clés.

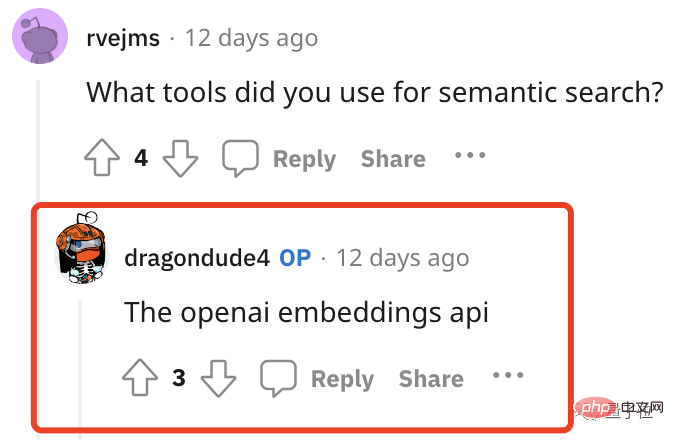

Recherchez ensuite les parties pertinentes directement dans l'article. Quant à savoir comment effectuer une recherche sémantique, la réponse est également très simple :

Utilisez l'API du modèle d'intégration OpenAI.

Ici, il utilise directement la similitude cosinus entre le mot d'invite et le vecteur d'intégration de mot du texte dans le document pour rechercher et extraire un texte très pertinent.

Ces textes ResearchGP seront également répertoriés un par un en fin de réponse.

Maintenant que la réponse a été indiquée où dans le document, il ne reste plus que la dernière étape : le résumé. Cette étape est directement laissée à GPT-3.

Dans ce cas, sur la base de cette idée et de cette technologie-cadre, aucun contenu textuel ne pourrait-il être utilisé pour le chat ? Le petit frère lui-même a également dit :

C'est vrai ! Sur la base de ce cadre technique, si vous ne souhaitez pas lire la base de code, les documents, les rapports financiers, les affaires judiciaires, etc., vous pouvez laisser l'outil vous l'expliquer.

Cependant, certains internautes sont curieux, cet outil peut-il comprendre les graphiques ? (Après tout, dans certains journaux, les graphiques sont toujours très importants)

Cependant, la personne qui a développé cet outil a directement donné un grand non.

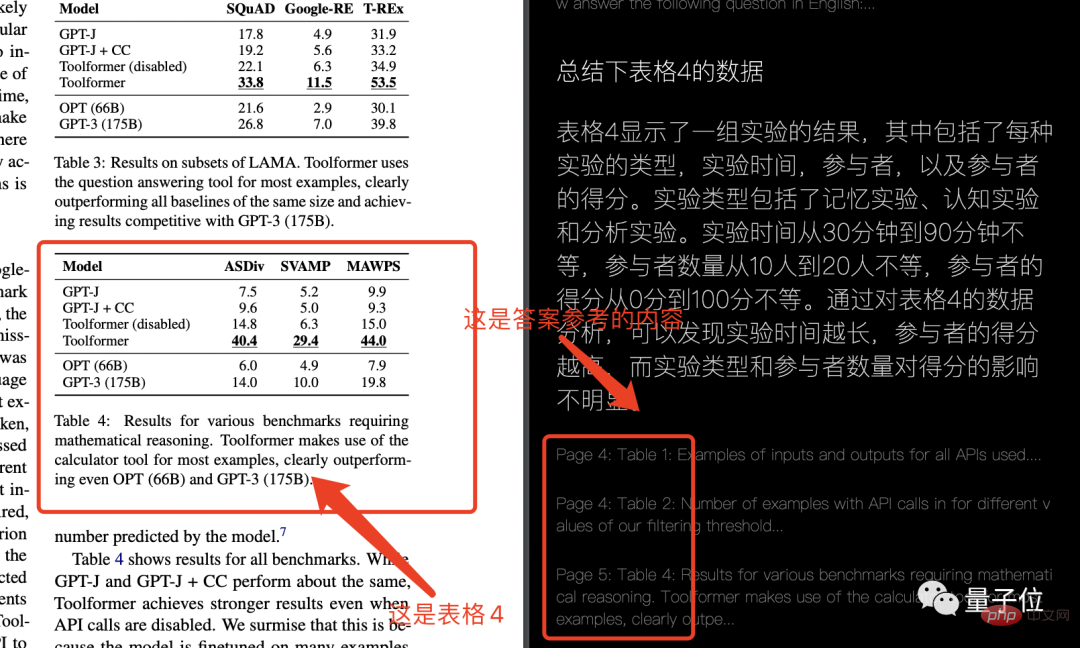

Ne voulant pas abandonner, Qubit a également essayé lui-même pour voir s'il pouvait comprendre la forme la plus simple. Le résultat est le suivant :

emmmmm, je ne peux pas dire que toutes les réponses sont fausses, je peux seulement dire que. ils n'ont rien à voir avec la question. (Cela ressemble un peu au non-sens de ChatGPT)

Mais en général, ResearchGPT peut toujours être utilisé s'il n'y a aucun problème de graphique impliqué.

Si vous êtes intéressé, vous pouvez cliquer sur le lien à la fin de l'article pour l'essayer vous-même~

Présentation de l'auteur

Le gars qui a créé cet outil s'appelle Mukul. Sa présentation est également intéressante, disant qu'il est à la fois un data scientist et un développeur. Également en tant que chercheur, écrivain et concepteur.

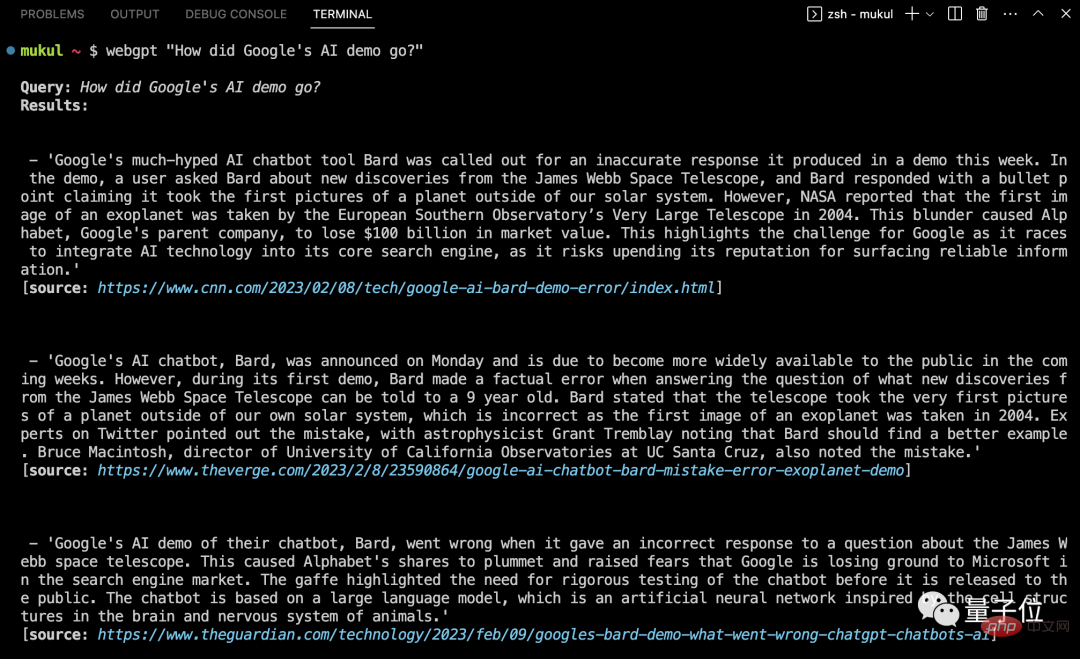

Mon frère a également construit un WebGPT auparavant, qui peut répondre aux questions en effectuant une recherche sur le Web. Il utilise également GPT-3 pour résumer le contenu.

Portal: https://www.php.cn/link/9c58da3f0418ebdb53c02615f9ab7282

reference lien:

[1] https://twitter.com/Mukul0x/status / 1625673579399446529?s=20

[2] https://github.com/mukulpatnaik/researchgpt

[3] https://www.reddit.com/r/GPT3/comments/112ncf0/introducing_researchgpt_an_opensource_research/

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

Video Face Swap

Échangez les visages dans n'importe quelle vidéo sans effort grâce à notre outil d'échange de visage AI entièrement gratuit !

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

ChatGPT permet désormais aux utilisateurs gratuits de générer des images en utilisant DALL-E 3 avec une limite quotidienne

Aug 09, 2024 pm 09:37 PM

ChatGPT permet désormais aux utilisateurs gratuits de générer des images en utilisant DALL-E 3 avec une limite quotidienne

Aug 09, 2024 pm 09:37 PM

Le DALL-E 3 a été officiellement introduit en septembre 2023 en tant que modèle considérablement amélioré par rapport à son prédécesseur. Il est considéré comme l’un des meilleurs générateurs d’images IA à ce jour, capable de créer des images avec des détails complexes. Cependant, au lancement, c'était exclu

Le modèle MoE open source le plus puissant au monde est ici, avec des capacités chinoises comparables à celles du GPT-4, et le prix ne représente que près d'un pour cent de celui du GPT-4-Turbo.

May 07, 2024 pm 04:13 PM

Le modèle MoE open source le plus puissant au monde est ici, avec des capacités chinoises comparables à celles du GPT-4, et le prix ne représente que près d'un pour cent de celui du GPT-4-Turbo.

May 07, 2024 pm 04:13 PM

Imaginez un modèle d'intelligence artificielle qui non seulement a la capacité de surpasser l'informatique traditionnelle, mais qui permet également d'obtenir des performances plus efficaces à moindre coût. Ce n'est pas de la science-fiction, DeepSeek-V2[1], le modèle MoE open source le plus puissant au monde est ici. DeepSeek-V2 est un puissant mélange de modèle de langage d'experts (MoE) présentant les caractéristiques d'une formation économique et d'une inférence efficace. Il est constitué de 236B paramètres, dont 21B servent à activer chaque marqueur. Par rapport à DeepSeek67B, DeepSeek-V2 offre des performances plus élevées, tout en économisant 42,5 % des coûts de formation, en réduisant le cache KV de 93,3 % et en augmentant le débit de génération maximal à 5,76 fois. DeepSeek est une entreprise explorant l'intelligence artificielle générale

KAN, qui remplace MLP, a été étendu à la convolution par des projets open source

Jun 01, 2024 pm 10:03 PM

KAN, qui remplace MLP, a été étendu à la convolution par des projets open source

Jun 01, 2024 pm 10:03 PM

Plus tôt ce mois-ci, des chercheurs du MIT et d'autres institutions ont proposé une alternative très prometteuse au MLP – KAN. KAN surpasse MLP en termes de précision et d’interprétabilité. Et il peut surpasser le MLP fonctionnant avec un plus grand nombre de paramètres avec un très petit nombre de paramètres. Par exemple, les auteurs ont déclaré avoir utilisé KAN pour reproduire les résultats de DeepMind avec un réseau plus petit et un degré d'automatisation plus élevé. Plus précisément, le MLP de DeepMind compte environ 300 000 paramètres, tandis que le KAN n'en compte qu'environ 200. KAN a une base mathématique solide comme MLP est basé sur le théorème d'approximation universelle, tandis que KAN est basé sur le théorème de représentation de Kolmogorov-Arnold. Comme le montre la figure ci-dessous, KAN a

Les robots Tesla travaillent dans les usines, Musk : Le degré de liberté des mains atteindra 22 cette année !

May 06, 2024 pm 04:13 PM

Les robots Tesla travaillent dans les usines, Musk : Le degré de liberté des mains atteindra 22 cette année !

May 06, 2024 pm 04:13 PM

La dernière vidéo du robot Optimus de Tesla est sortie, et il peut déjà fonctionner en usine. À vitesse normale, il trie les batteries (les batteries 4680 de Tesla) comme ceci : Le responsable a également publié à quoi cela ressemble à une vitesse 20 fois supérieure - sur un petit "poste de travail", en sélectionnant et en sélectionnant et en sélectionnant : Cette fois, il est publié L'un des points forts de la vidéo est qu'Optimus réalise ce travail en usine, de manière totalement autonome, sans intervention humaine tout au long du processus. Et du point de vue d'Optimus, il peut également récupérer et placer la batterie tordue, en se concentrant sur la correction automatique des erreurs : concernant la main d'Optimus, le scientifique de NVIDIA Jim Fan a donné une évaluation élevée : la main d'Optimus est l'un des robots à cinq doigts du monde. le plus adroit. Ses mains ne sont pas seulement tactiles

Surpassant largement le DPO : l'équipe de Chen Danqi a proposé une optimisation simple des préférences SimPO et a également affiné le modèle open source 8B le plus puissant.

Jun 01, 2024 pm 04:41 PM

Surpassant largement le DPO : l'équipe de Chen Danqi a proposé une optimisation simple des préférences SimPO et a également affiné le modèle open source 8B le plus puissant.

Jun 01, 2024 pm 04:41 PM

Afin d'aligner les grands modèles de langage (LLM) sur les valeurs et les intentions humaines, il est essentiel d'apprendre les commentaires humains pour garantir qu'ils sont utiles, honnêtes et inoffensifs. En termes d'alignement du LLM, une méthode efficace est l'apprentissage par renforcement basé sur le retour humain (RLHF). Bien que les résultats de la méthode RLHF soient excellents, certains défis d’optimisation sont impliqués. Cela implique de former un modèle de récompense, puis d'optimiser un modèle politique pour maximiser cette récompense. Récemment, certains chercheurs ont exploré des algorithmes hors ligne plus simples, dont l’optimisation directe des préférences (DPO). DPO apprend le modèle politique directement sur la base des données de préférence en paramétrant la fonction de récompense dans RLHF, éliminant ainsi le besoin d'un modèle de récompense explicite. Cette méthode est simple et stable

Aucune donnée OpenAI requise, rejoignez la liste des grands modèles de code ! UIUC publie StarCoder-15B-Instruct

Jun 13, 2024 pm 01:59 PM

Aucune donnée OpenAI requise, rejoignez la liste des grands modèles de code ! UIUC publie StarCoder-15B-Instruct

Jun 13, 2024 pm 01:59 PM

À la pointe de la technologie logicielle, le groupe de l'UIUC Zhang Lingming, en collaboration avec des chercheurs de l'organisation BigCode, a récemment annoncé le modèle de grand code StarCoder2-15B-Instruct. Cette réalisation innovante a permis une percée significative dans les tâches de génération de code, dépassant avec succès CodeLlama-70B-Instruct et atteignant le sommet de la liste des performances de génération de code. Le caractère unique de StarCoder2-15B-Instruct réside dans sa stratégie d'auto-alignement pur. L'ensemble du processus de formation est ouvert, transparent et complètement autonome et contrôlable. Le modèle génère des milliers d'instructions via StarCoder2-15B en réponse au réglage fin du modèle de base StarCoder-15B sans recourir à des annotations manuelles coûteuses.

Le LLM est terminé ! OmniDrive : Intégration de la perception 3D et de la planification du raisonnement (la dernière version de NVIDIA)

May 09, 2024 pm 04:55 PM

Le LLM est terminé ! OmniDrive : Intégration de la perception 3D et de la planification du raisonnement (la dernière version de NVIDIA)

May 09, 2024 pm 04:55 PM

Écrit ci-dessus et compréhension personnelle de l'auteur : cet article est dédié à la résolution des principaux défis des grands modèles de langage multimodaux (MLLM) actuels dans les applications de conduite autonome, c'est-à-dire le problème de l'extension des MLLM de la compréhension 2D à l'espace 3D. Cette expansion est particulièrement importante car les véhicules autonomes (VA) doivent prendre des décisions précises concernant les environnements 3D. La compréhension spatiale 3D est essentielle pour les véhicules utilitaires car elle a un impact direct sur la capacité du véhicule à prendre des décisions éclairées, à prédire les états futurs et à interagir en toute sécurité avec l’environnement. Les modèles de langage multimodaux actuels (tels que LLaVA-1.5) ne peuvent souvent gérer que des entrées d'images de résolution inférieure (par exemple) en raison des limitations de résolution de l'encodeur visuel et des limitations de la longueur de la séquence LLM. Cependant, les applications de conduite autonome nécessitent

Yolov10 : explication détaillée, déploiement et application en un seul endroit !

Jun 07, 2024 pm 12:05 PM

Yolov10 : explication détaillée, déploiement et application en un seul endroit !

Jun 07, 2024 pm 12:05 PM

1. Introduction Au cours des dernières années, les YOLO sont devenus le paradigme dominant dans le domaine de la détection d'objets en temps réel en raison de leur équilibre efficace entre le coût de calcul et les performances de détection. Les chercheurs ont exploré la conception architecturale de YOLO, les objectifs d'optimisation, les stratégies d'expansion des données, etc., et ont réalisé des progrès significatifs. Dans le même temps, le recours à la suppression non maximale (NMS) pour le post-traitement entrave le déploiement de bout en bout de YOLO et affecte négativement la latence d'inférence. Dans les YOLO, la conception de divers composants manque d’une inspection complète et approfondie, ce qui entraîne une redondance informatique importante et limite les capacités du modèle. Il offre une efficacité sous-optimale et un potentiel d’amélioration des performances relativement important. Dans ce travail, l'objectif est d'améliorer encore les limites d'efficacité des performances de YOLO à la fois en post-traitement et en architecture de modèle. à cette fin