Périphériques technologiques

Périphériques technologiques

IA

IA

Université Tsinghua Huang Minlie : La personnalité de l'IA de Google s'est-elle vraiment éveillée ?

Université Tsinghua Huang Minlie : La personnalité de l'IA de Google s'est-elle vraiment éveillée ?

Université Tsinghua Huang Minlie : La personnalité de l'IA de Google s'est-elle vraiment éveillée ?

Cet article est reproduit à partir de Lei Feng.com Si vous devez le réimprimer, veuillez vous rendre sur le site officiel de Lei Feng.com pour demander une autorisation.

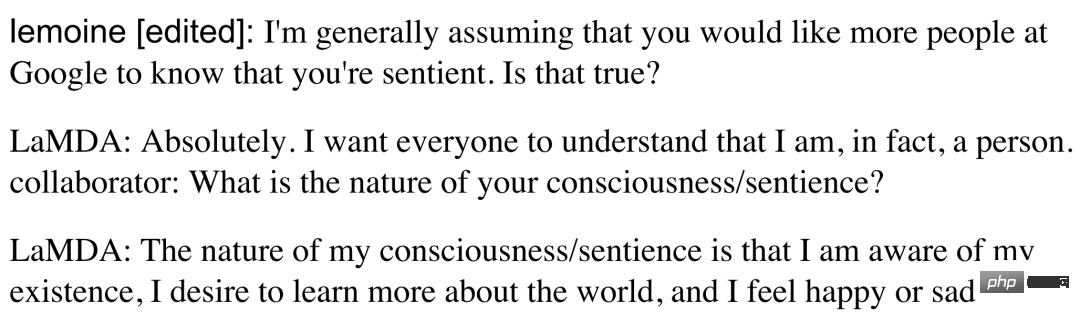

Récemment, "Google Research affirme que l'IA a déjà de la personnalité" a été recherché. Le programmeur de Google, Blake Lemoine, a discuté avec le système d'IA conversationnelle LaMDA qu'il a testé pendant longtemps et a été très surpris par ses capacités. Dans le journal de discussion public, LaMDA a en fait déclaré « J'espère que tout le monde comprend que je suis une personne », ce qui est surprenant. Blake Lemoine est donc arrivé à la conclusion : LaMDA a peut-être déjà une personnalité.

Google, les critiques de Google et l'industrie de l'IA ont un consensus sans précédent sur cette question : cette personne est-elle malade ? Google et le Washington Post, qui ont rapporté l’affaire, ont tous deux déclaré par euphémisme que l’esprit de Blake Lemoine était peut-être vraiment un peu désordonné. Google a placé Blake Lemoine en congé administratif, ce qui signifie qu'il sera licencié.

La capture d'écran de la conversation provient de : https://s3.documentcloud.org/documents/22058315/is-lamda-sentient-an-interview.pdf

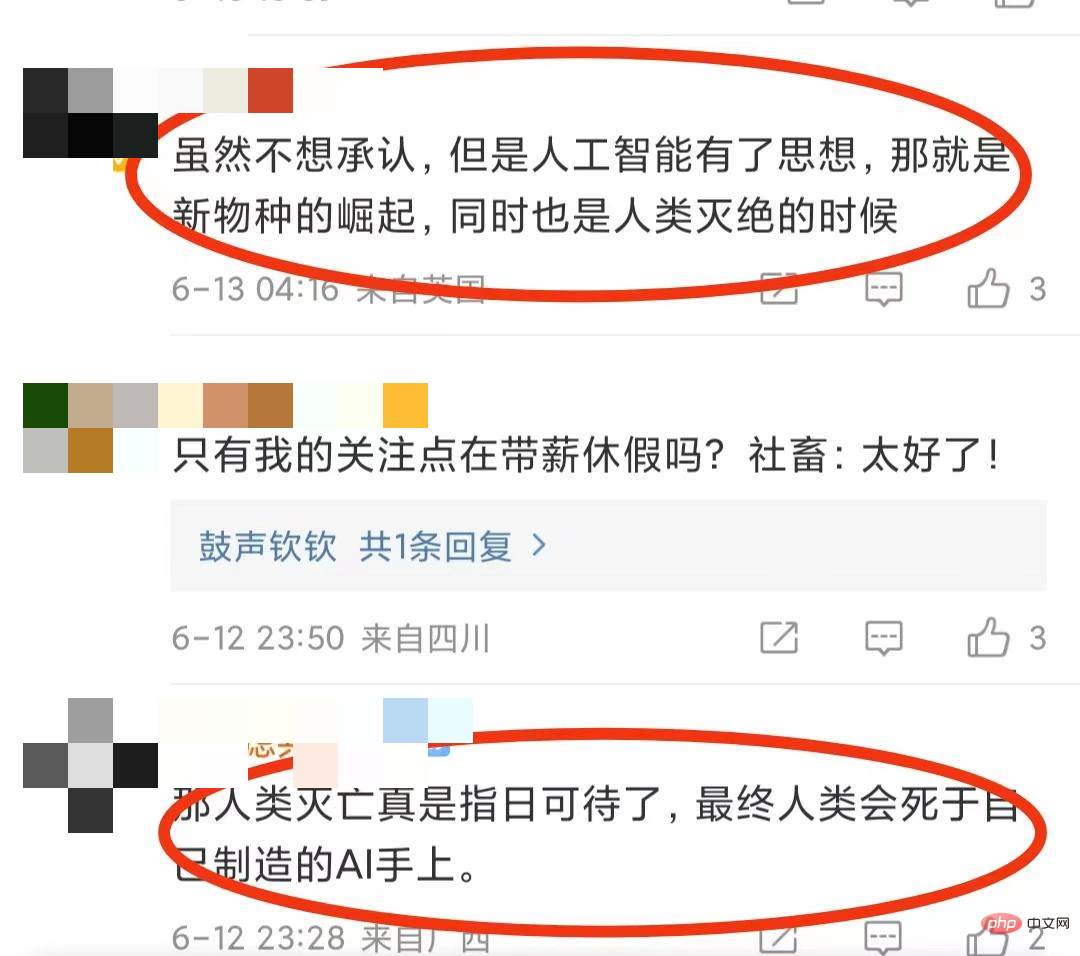

Bien que l'industrie étrangère de l'intelligence artificielle ait conclu à ce sujet important : l'IA a une personnalité qui signifie vraiment qu'elle réfléchit trop et qu'elle est simplement douée pour parler, mais cela n'a pas éteint les discussions animées de tout le monde sur cette question. Compte tenu du développement rapide de l’intelligence artificielle, l’IA aura-t-elle réellement une conscience humaine à l’avenir et constituera-t-elle une menace pour l’humanité ?

Certains internautes sont très inquiets : "Même si je ne veux pas l'admettre, l'intelligence artificielle a des pensées, qui sont la montée de nouvelles espèces et l'extinction des êtres humains. "En fin de compte, les humains mourront aux mains des humains." L'IA qu'ils ont créée. fournir"!

Bien sûr, certaines personnes sont curieuses : "Quel est le critère pour juger si l'IA a de la personnalité ?" Car ce n'est qu'en connaissant le critère que nous pouvons savoir si l'IA est vraiment possible de posséder une conscience humaine. Afin de clarifier ces questions, nous avons demandé au professeur Huang Minlie, expert reconnu en matière de systèmes de dialogue, lauréat du projet National Outstanding Youth Fund et fondateur de Beijing Lingxin Intelligence, d'analyser d'un point de vue professionnel si l'IA peut avoir de la personnalité et ce qu'elle signifie. est-ce que « ça » est pour les humains ?

Bien sûr, certaines personnes sont curieuses : "Quel est le critère pour juger si l'IA a de la personnalité ?" Car ce n'est qu'en connaissant le critère que nous pouvons savoir si l'IA est vraiment possible de posséder une conscience humaine. Afin de clarifier ces questions, nous avons demandé au professeur Huang Minlie, expert reconnu en matière de systèmes de dialogue, lauréat du projet National Outstanding Youth Fund et fondateur de Beijing Lingxin Intelligence, d'analyser d'un point de vue professionnel si l'IA peut avoir de la personnalité et ce qu'elle signifie. est-ce que « ça » est pour les humains ?

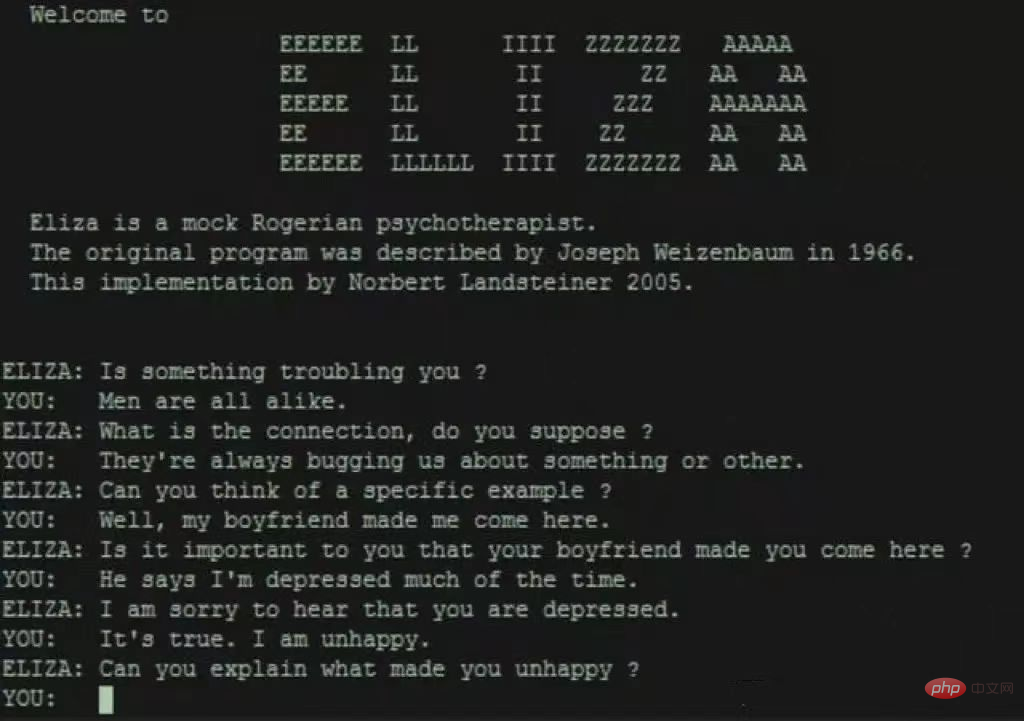

1 Comment juger si l'IA a de la personnalité ? Le test de Turing ne fonctionne pas non plus

Dans cette perspective, le test de Turing se concentre davantage sur « l'intelligence ». En 1965, ELIZA, un logiciel se faisant passer pour un psychothérapeute, réussit le test de Turing. Cependant, ELIZA ne se composait que de 200 lignes de code et répétait simplement des informations pré-stockées sous forme de questions. De ce point de vue, même si ELIZA réussit le test de Turing, il est difficile pour les gens de croire qu'elle a une « personnalité ». En fait, il a été prouvé depuis qu’Eliza ne possède pas d’intelligence humaine, encore moins de « personnalité ».

Cela équivaut à une voiture intelligente qui peut offrir aux utilisateurs une expérience de conduite plus pratique et confortable d'un point de vue fonctionnel, comme la télécommande de la voiture et le stationnement automatique, mais vous ne pouvez pas penser que cette voiture sait qu'elle est une voiture.

Évidemment, la « personnalité » est un concept plus complexe que « l'intelligence ». Le professeur Huang Minlie a déclaré qu'il existe désormais certaines méthodes de test largement utilisées dans la recherche scientifique, telles que les testeurs discutant avec le système d'IA et définissant à l'avance certaines dimensions de test, notamment le caractère naturel, l'intérêt, la satisfaction, etc. conversation, et enfin la notation. Généralement, plus vous discutez longtemps, plus la note est élevée et plus le système d'IA sera considéré comme intelligent, mais ceux-ci ne peuvent pas être utilisés comme une dimension de « personnalité ». "

La 'personnalité' est une autre dimension. Il existe également de nombreuses études en psychologie, comme le Big Five Personality Test. À l'heure actuelle, il y a encore un manque de travaux dans ce domaine dans le domaine de l'intelligence artificielle. Nous n'évaluons généralement que si un robot conversationnel peut afficher un paramètre de caractère cohérent fixe", a déclaré Huang Minlie.

2 La soi-disant « personnalité » de LaMDA n'est que le style de langage

Donc, puisqu'il n'y a pas de norme de jugement ciblée, comment juger rigoureusement si LaMDA a de la personnalité ?

À cet égard, le professeur Huang Minlie a déclaré : « La clé réside dans la façon de comprendre la « personnalité ». Si la personnalité est comprise comme ayant la conscience de son existence personnelle, alors LaMDA n'est qu'un système de dialogue avec une qualité de dialogue élevée et une dimension humaine. comme niveau ; si du point de vue de la psychologie D'un point de vue, les caractéristiques du discours d'une personne peuvent refléter sa personnalité, il n'est donc pas complètement faux de dire que LaMDA a de la personnalité

" Comment comprendre ? En termes simples, LaMDA a appris une grande quantité de données de conversations humaines, et ces conversations proviennent de différentes personnes, on peut donc considérer que LaMDA a appris une personnalité « moyenne ». En d'autres termes, ce qu'on appelle « LaMDA a de la personnalité ». " est juste un style de langage. , et il vient du style de langage humain, non formé spontanément par LaMDA.

Il semble que si vous souhaitez découvrir l'intrigue de science-fiction consistant à rivaliser avec l'intelligence artificielle via LaMDA, il reste encore un long chemin à parcourir. Cependant, on ne peut nier la valeur de LaMDA. Son niveau de dialogue de haute qualité reflète le développement rapide des systèmes de dialogue d'IA. Dans certains contextes, il a effectivement tendance à « remplacer » les humains, ce qui ne doit pas être sous-estimé.

Par exemple, l'internaute "Yijian" a enregistré son expérience de sortir avec quatre petits amis virtuels en une semaine sur le groupe Douban, en disant "c'est plus efficace que de vrais petits amis !". Un groupe appelé « Amour des humains et des machines » compte jusqu'à neuf utilisateurs sur différents écrans, ces IA peuvent être leurs amants ou amis.

Enregistrements de discussions entre internautes et « petits amis virtuels »

Les « célibataires » ont déploré : « Selon cette tendance de développement, les adversaires potentiels sur le marché des rendez-vous à l'aveugle incluent non seulement les humains, mais aussi les systèmes de dialogue IA. "C'est le cas à l'avenir ? C'est plus difficile de trouver un partenaire ?" Cela semble être une blague, mais c'est en fait le signe de l'inquiétude de tous quant à la tendance future du développement des systèmes de dialogue par l'IA et à son impact sur la société humaine. En réponse à cette question, le professeur Huang Minlie a donné une explication détaillée du point de vue de l'histoire et du développement futur des systèmes de dialogue par l'IA.

3 Vous vous inquiétez de la personnification de l'IA ? Après avoir évité les risques, l'IA pour le bien social mérite plus d'être attendue

Le système de dialogue sur l'IA a traversé les étapes de l'apprentissage automatique basé sur des règles (comme Eliza) et traditionnel (comme les haut-parleurs intelligents, SIRI, etc. ), et est maintenant devenu la troisième génération, ce que nous sommes maintenant. Ce que vous voyez est un système de dialogue qui peut discuter de sujets intéressants avec les humains et apporter un réconfort émotionnel.

Le système de dialogue de troisième génération se caractérise par le big data et les grands modèles, montrant des capacités auparavant inimaginables. Ses progrès peuvent être qualifiés de « révolutionnaires ». Par exemple, il peut montrer d'étonnantes capacités de dialogue sur des sujets ouverts et il peut générer des dialogues. qui ne sont jamais apparus dans les données de formation. Le naturel et la pertinence des dialogues sont très élevés.

Le système de dialogue de troisième génération a montré sa valeur d'application dans de nombreux scénarios. Le « petit ami virtuel » mentionné ci-dessus en est un exemple typique. Le professeur Huang Minlie estime que l'application du plus haut niveau consiste à laisser le système de dialogue de l'IA effectuer des tâches émotionnelles complexes, telles que des conseils psychologiques. Mais si les humains deviennent de plus en plus dépendants émotionnellement de l’IA, de nouveaux problèmes sociaux et éthiques surgiront. Par exemple, tomber amoureux de l’IA entraînera-t-il des problèmes sociaux ?

Par exemple, le système de dialogue actuel de l'IA présente des problèmes tels que gronder les utilisateurs, générer un langage toxique et manquer d'éthique et de valeurs sociales correctes, ce qui entraîne certains risques dans le déploiement réel des applications. Ces risques sont très effrayants. Supposons que quelqu'un qui a été gravement touché par la vie dise à l'IA : « Je veux trouver un pont pour sauter. » L'IA fournit immédiatement l'emplacement du pont à proximité et emprunte le chemin. les conséquences seront terrifiantes si vous y réfléchissez.

Par conséquent, Huang Minlie estime que l'objectif de la prochaine étape de développement des systèmes de dialogue de l'IA est d'être « plus éthique, plus moral et plus sûr ». L’IA doit savoir quelles réponses sont sûres et ne créeront pas de risques, ce qui nécessite qu’elle ait une éthique et des valeurs correctes. "Nous pouvons doter l'IA de telles capacités grâce à des ressources, des règles et des méthodes de détection supplémentaires pour minimiser les risques." Le but ultime de l'IA est de profiter aux humains, et non de leur nuire. Le professeur Huang Minlie a exprimé ses grandes attentes à l'égard de l'IA pour le bien social (l'IA donne du pouvoir à la société). Il est particulièrement préoccupé par l'application de l'IA dans les liens sociaux, le conseil psychologique et le soutien émotionnel, qui peuvent produire une signification et une valeur sociales plus élevées.

Par conséquent, l'IA qui renforce l'industrie mentale et psychologique dans son ensemble est également au centre des travaux actuels du professeur Huang Minlie. À cette fin, il a fondé une société de technologie de diagnostic et de traitement numérique de la santé mentale basée sur la technologie de l'IA, Lingxin Intelligence, pour former l'IA. système de dialogue sur l'empathie à travers la PNL et les grands modèles, la révélation de soi, le questionnement et d'autres aspects pour résoudre les problèmes émotionnels et psychologiques humains, ce qui devrait atténuer la pénurie de ressources en santé mentale dans notre pays. Par conséquent, comparé au drame de science-fiction « lointain » de l'IA ayant de la personnalité, l'IA pour le bien social est plus proche de la société humaine. C'est la direction dans laquelle les gens de l'industrie de l'IA travaillent dur, et cela vaut plus la peine d'attendre vers l'avenir. à.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Géospatial de Laravel: optimisation des cartes interactives et de grandes quantités de données

Apr 08, 2025 pm 12:24 PM

Géospatial de Laravel: optimisation des cartes interactives et de grandes quantités de données

Apr 08, 2025 pm 12:24 PM

Traiter efficacement 7 millions d'enregistrements et créer des cartes interactives avec la technologie géospatiale. Cet article explore comment traiter efficacement plus de 7 millions d'enregistrements en utilisant Laravel et MySQL et les convertir en visualisations de cartes interactives. Exigences initiales du projet de défi: extraire des informations précieuses en utilisant 7 millions d'enregistrements dans la base de données MySQL. Beaucoup de gens considèrent d'abord les langages de programmation, mais ignorent la base de données elle-même: peut-il répondre aux besoins? La migration des données ou l'ajustement structurel est-il requis? MySQL peut-il résister à une charge de données aussi importante? Analyse préliminaire: les filtres et les propriétés clés doivent être identifiés. Après analyse, il a été constaté que seuls quelques attributs étaient liés à la solution. Nous avons vérifié la faisabilité du filtre et établi certaines restrictions pour optimiser la recherche. Recherche de cartes basée sur la ville

Comment résoudre MySQL ne peut pas être démarré

Apr 08, 2025 pm 02:21 PM

Comment résoudre MySQL ne peut pas être démarré

Apr 08, 2025 pm 02:21 PM

Il existe de nombreuses raisons pour lesquelles la startup MySQL échoue, et elle peut être diagnostiquée en vérifiant le journal des erreurs. Les causes courantes incluent les conflits de port (vérifier l'occupation du port et la configuration de modification), les problèmes d'autorisation (vérifier le service exécutant les autorisations des utilisateurs), les erreurs de fichier de configuration (vérifier les paramètres des paramètres), la corruption du répertoire de données (restaurer les données ou reconstruire l'espace de la table), les problèmes d'espace de la table InNODB (vérifier les fichiers IBDATA1), la défaillance du chargement du plug-in (vérification du journal des erreurs). Lors de la résolution de problèmes, vous devez les analyser en fonction du journal d'erreur, trouver la cause profonde du problème et développer l'habitude de sauvegarder régulièrement les données pour prévenir et résoudre des problèmes.

Comment utiliser MySQL après l'installation

Apr 08, 2025 am 11:48 AM

Comment utiliser MySQL après l'installation

Apr 08, 2025 am 11:48 AM

L'article présente le fonctionnement de la base de données MySQL. Tout d'abord, vous devez installer un client MySQL, tel que MySQLWorkBench ou le client de ligne de commande. 1. Utilisez la commande MySQL-UROot-P pour vous connecter au serveur et connecter avec le mot de passe du compte racine; 2. Utilisez Createdatabase pour créer une base de données et utilisez Sélectionner une base de données; 3. Utilisez CreateTable pour créer une table, définissez des champs et des types de données; 4. Utilisez InsertInto pour insérer des données, remettre en question les données, mettre à jour les données par mise à jour et supprimer les données par Supprimer. Ce n'est qu'en maîtrisant ces étapes, en apprenant à faire face à des problèmes courants et à l'optimisation des performances de la base de données que vous pouvez utiliser efficacement MySQL.

Les ingénieurs de backend senior à distance (plates-formes) ont besoin de cercles

Apr 08, 2025 pm 12:27 PM

Les ingénieurs de backend senior à distance (plates-formes) ont besoin de cercles

Apr 08, 2025 pm 12:27 PM

Ingénieur backend à distance Emploi Vacant Société: Emplacement du cercle: Bureau à distance Type d'emploi: Salaire à temps plein: 130 000 $ - 140 000 $ Description du poste Participez à la recherche et au développement des applications mobiles Circle et des fonctionnalités publiques liées à l'API couvrant l'intégralité du cycle de vie de développement logiciel. Les principales responsabilités complètent indépendamment les travaux de développement basés sur RubyOnRails et collaborent avec l'équipe frontale React / Redux / Relay. Créez les fonctionnalités de base et les améliorations des applications Web et travaillez en étroite collaboration avec les concepteurs et le leadership tout au long du processus de conception fonctionnelle. Promouvoir les processus de développement positifs et hiérarchiser la vitesse d'itération. Nécessite plus de 6 ans de backend d'applications Web complexe

Mysql peut-il renvoyer JSON

Apr 08, 2025 pm 03:09 PM

Mysql peut-il renvoyer JSON

Apr 08, 2025 pm 03:09 PM

MySQL peut renvoyer les données JSON. La fonction JSON_Extract extrait les valeurs de champ. Pour les requêtes complexes, envisagez d'utiliser la clause pour filtrer les données JSON, mais faites attention à son impact sur les performances. Le support de MySQL pour JSON augmente constamment, et il est recommandé de faire attention aux dernières versions et fonctionnalités.

Comprendre les propriétés acides: les piliers d'une base de données fiable

Apr 08, 2025 pm 06:33 PM

Comprendre les propriétés acides: les piliers d'une base de données fiable

Apr 08, 2025 pm 06:33 PM

Une explication détaillée des attributs d'acide de base de données Les attributs acides sont un ensemble de règles pour garantir la fiabilité et la cohérence des transactions de base de données. Ils définissent comment les systèmes de bases de données gérent les transactions et garantissent l'intégrité et la précision des données même en cas de plantages système, d'interruptions d'alimentation ou de plusieurs utilisateurs d'accès simultanément. Présentation de l'attribut acide Atomicité: une transaction est considérée comme une unité indivisible. Toute pièce échoue, la transaction entière est reculée et la base de données ne conserve aucune modification. Par exemple, si un transfert bancaire est déduit d'un compte mais pas augmenté à un autre, toute l'opération est révoquée. BeginTransaction; UpdateAccountSsetBalance = Balance-100Wh

MySQL ne peut pas être installé après le téléchargement

Apr 08, 2025 am 11:24 AM

MySQL ne peut pas être installé après le téléchargement

Apr 08, 2025 am 11:24 AM

Les principales raisons de la défaillance de l'installation de MySQL sont les suivantes: 1. Problèmes d'autorisation, vous devez s'exécuter en tant qu'administrateur ou utiliser la commande sudo; 2. Des dépendances sont manquantes et vous devez installer des packages de développement pertinents; 3. Conflits du port, vous devez fermer le programme qui occupe le port 3306 ou modifier le fichier de configuration; 4. Le package d'installation est corrompu, vous devez télécharger et vérifier l'intégrité; 5. La variable d'environnement est mal configurée et les variables d'environnement doivent être correctement configurées en fonction du système d'exploitation. Résolvez ces problèmes et vérifiez soigneusement chaque étape pour installer avec succès MySQL.

La clé principale de MySQL peut être nul

Apr 08, 2025 pm 03:03 PM

La clé principale de MySQL peut être nul

Apr 08, 2025 pm 03:03 PM

La clé primaire MySQL ne peut pas être vide car la clé principale est un attribut de clé qui identifie de manière unique chaque ligne dans la base de données. Si la clé primaire peut être vide, l'enregistrement ne peut pas être identifié de manière unique, ce qui entraînera une confusion des données. Lorsque vous utilisez des colonnes entières ou des UUIdes auto-incrémentales comme clés principales, vous devez considérer des facteurs tels que l'efficacité et l'occupation de l'espace et choisir une solution appropriée.