Quel type de modèle BERT peut-on obtenir en s'entraînant sur un GPU grand public en une seule journée ?

Ces derniers temps, les modèles linguistiques ont une fois de plus enflammé le domaine de l'IA. L'attribut de formation non supervisé du modèle de langage pré-entraîné lui permet d'être formé sur la base d'échantillons massifs et d'obtenir une grande quantité de connaissances sémantiques et grammaticales. Qu'il s'agisse de classification ou de questions et réponses, l'IA ne semble poser aucun problème. ne peut pas résoudre.

Cependant, les grands modèles apportent non seulement des avancées technologiques, mais imposent également des exigences infinies en matière de puissance de calcul.

Récemment, Jonas Geiping et Tom Goldstein de l'Université du Maryland ont discuté de toutes les recherches sur l'intensification du calcul et ont approfondi les pistes d'amélioration de la réduction du calcul. Leurs recherches ont attiré l’attention de la communauté de l’apprentissage automatique.

Dans une nouvelle recherche, l'auteur a discuté du type de modèle de langage qui peut être entraîné avec un seul GPU grand public (RTX 2080Ti) et a obtenu des résultats passionnants. Voyons comment cela est mis en œuvre :

Dans le domaine du traitement du langage naturel (NLP), les modèles pré-entraînés basés sur l'architecture Transformer sont devenus courants et ont apporté de nombreuses avancées. La puissance de ces modèles s’explique en grande partie par leur grande taille. À mesure que la quantité de paramètres et de données du modèle augmente, les performances du modèle continueront de s'améliorer. Il y a donc une course dans le domaine de la PNL pour augmenter la taille des modèles.

Cependant, peu de chercheurs ou de praticiens pensent avoir la capacité de former des grands modèles de langage (LLM), et généralement seuls les géants de la technologie du secteur ont les ressources nécessaires pour former des LLM.

Afin d'inverser cette tendance, des chercheurs de l'Université du Maryland ont mené des recherches.

Article "Cramming: Training a Language Model on a Single GPU in One Day" :

Lien article : https://arxiv.org/abs/2212.14034

Cette question s'adresse à la plupart des chercheurs et des praticiens. d'une grande importance car il deviendra une référence pour les coûts de formation modèles et devrait éliminer le goulot d'étranglement des coûts extrêmement élevés de formation LLM. Le document de recherche a rapidement suscité l’attention et les discussions sur Twitter.

Leshem Choshen, expert en recherche en PNL chez IBM, a commenté sur Twitter : "Cet article résume toutes les astuces de formation de grands modèles auxquelles vous pouvez penser."

Les chercheurs de l'Université du Maryland croient : Si vous presse Si la pré-formation sur modèle réduit est une simulation réalisable d'une pré-formation à grande échelle, cela ouvrira la voie à de nouvelles recherches universitaires sur une série de modèles à grande échelle qui sont actuellement difficiles à réaliser.

De plus, cette étude tente de comparer les progrès globaux dans le domaine de la PNL au cours des dernières années, et pas seulement l'impact de la taille du modèle.

L'étude a créé un défi appelé "Cramming" : apprendre l'intégralité du modèle de langage un jour avant le test. Les chercheurs ont d’abord analysé certains aspects du pipeline de formation pour comprendre quelles modifications pourraient réellement améliorer les performances des modèles de simulation à petite échelle. Et l’étude montre que même dans cet environnement contraint, les performances du modèle suivent strictement les lois d’échelle observées dans les grands environnements informatiques.

Alors que les architectures de modèles plus petites accélèrent les calculs de gradient, le taux global d'amélioration du modèle reste presque le même au fil du temps. Cette recherche tente d'utiliser la loi d'expansion pour obtenir des améliorations de performances en améliorant l'efficacité des calculs de gradient sans affecter la taille du modèle. En fin de compte, l'étude a réussi à former un modèle avec des performances respectables (proches ou même supérieures à BERT sur la tâche GLUE) à un faible coût de formation.

Afin de simuler l'environnement de ressources des praticiens et chercheurs ordinaires, cette étude a d'abord construit un environnement de recherche aux ressources limitées :

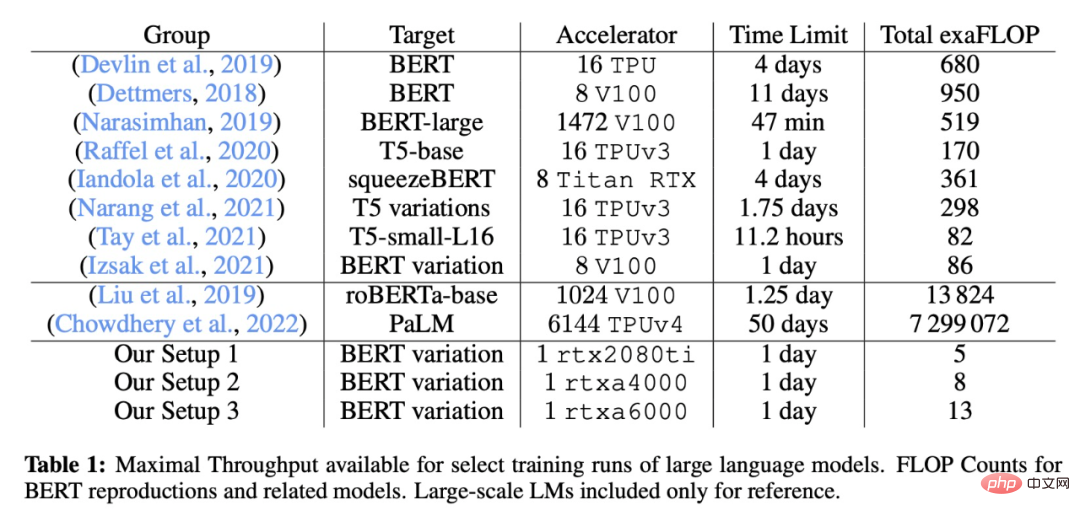

La comparaison des paramètres de formation spécifiques de cette étude avec certains grands modèles classiques est présentée dans le tableau suivant :

Les chercheurs ont mis en œuvre et testé certaines directions de modification proposées par les travaux existants, y compris la mise en œuvre générale et configuration initiale des données et essayé de modifier l'architecture, la formation et la modification de l'ensemble de données.

Les expériences sont menées dans PyTorch, sans utiliser d'implémentations spécialisées pour être le plus juste possible, tout est conservé au niveau d'implémentation du framework PyTorch, seule la fusion automatique d'opérateurs est autorisée et peut être appliquée à tous les composants, et seulement si le final Les noyaux d'attention efficaces ne seront réactivés qu'après la variante architecturale.

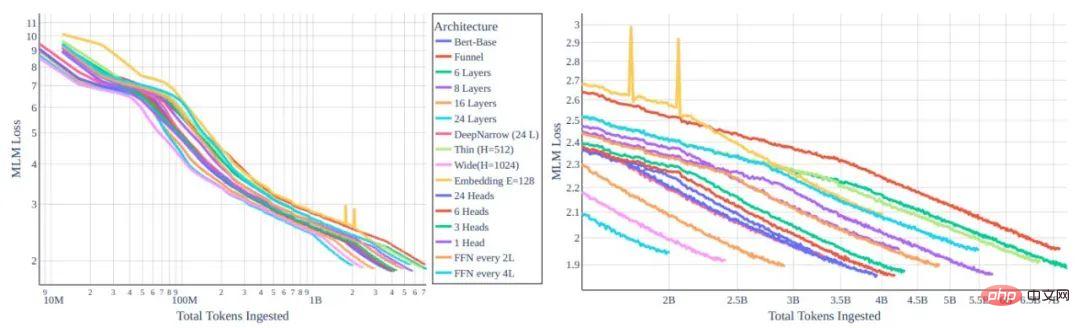

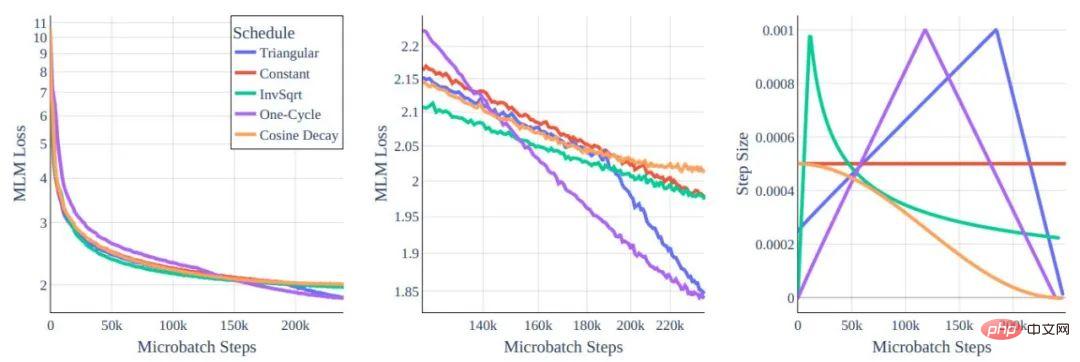

Figure 1 : Comparaison de la fonction de perte MLM et du jeton de différentes variantes d'architecture de transformateur

Gauche : Vue globale. À droite : zoom sur 10e8 et plus de jetons.

Tous les modèles sont entraînés avec le même coût en puissance de calcul. Nous pouvons voir que l'amélioration obtenue grâce au remodelage architectural est minime.

Concernant l'amélioration des performances, la première façon à laquelle nous pensons est définitivement de modifier l'architecture du modèle. Intuitivement, les modèles plus petits/de capacité inférieure semblent être optimaux pour une formation à une carte par jour. Cependant, après avoir étudié la relation entre le type de modèle et l’efficacité de la formation, les chercheurs ont découvert que les lois d’échelle créaient un énorme obstacle à la réduction des effectifs. L'efficacité de la formation de chaque jeton dépend fortement de la taille du modèle plutôt que du type de transformateur.

De plus, les modèles plus petits apprennent moins efficacement, ce qui ralentit dans une large mesure l'augmentation du débit. Heureusement, le fait que l'efficacité de la formation reste presque la même dans des modèles de même taille signifie que nous pouvons rechercher des architectures appropriées avec des nombres de paramètres similaires, en faisant des choix de conception principalement basés sur le temps de calcul affectant une seule étape de gradient.

Figure 2 : Calendrier du taux d'apprentissage

Bien que le comportement soit globalement similaire, vous pouvez voir dans le zoom du milieu que les différences existent.

Dans ce travail, les auteurs ont étudié l'impact des hyperparamètres de formation sur l'architecture de base BERT. Naturellement, les modèles de la méthode de formation BERT originale ne répondaient pas bien aux exigences de formation de type Cramming. Les chercheurs ont donc revisité certains choix standards.

L'auteur a également étudié l'idée d'optimiser l'ensemble des données. La loi de mise à l'échelle empêche des gains significatifs (au-delà de l'efficacité informatique) liés aux modifications architecturales, mais la loi de mise à l'échelle ne nous empêche pas de nous entraîner sur de meilleures données. Si nous voulons entraîner plus de jetons par seconde, nous devrions chercher à nous entraîner sur de meilleurs jetons.

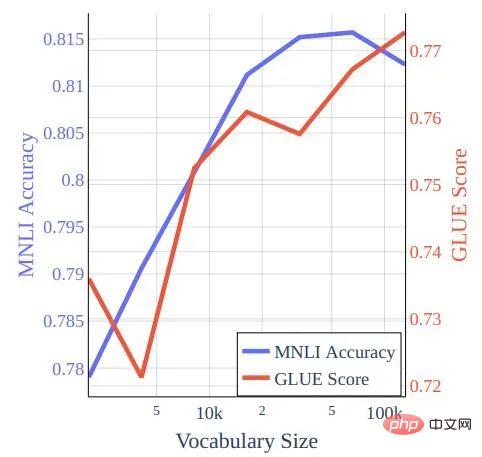

Figure 3 : Taille du vocabulaire par rapport au score GLUE et à la précision MNLI pour un modèle formé à la formation de style Cramming sur les données bookcorpus-wikipedia.

Les chercheurs ont systématiquement évalué les performances du benchmark GLUE et du WNLI, notant que dans la section précédente, seul MNLI (m) a été utilisé et qu'aucun hyperparamètre n'a été ajusté sur la base du score GLUE complet. Dans la nouvelle étude, les auteurs ont affiné tous les ensembles de données pour 5 époques pour la base BERT, avec une taille de lot de 32 et un taux d'apprentissage de 2 × 10-5. Ceci n'est pas optimal pour les modèles entraînés par Cramming, qui peuvent obtenir de petites améliorations à partir d'une taille de lot de 16 et d'un taux d'apprentissage de 4 × 10−5 avec désintégration du cosinus (ce paramètre n'améliore pas le point de contrôle BERT pré-entraîné).

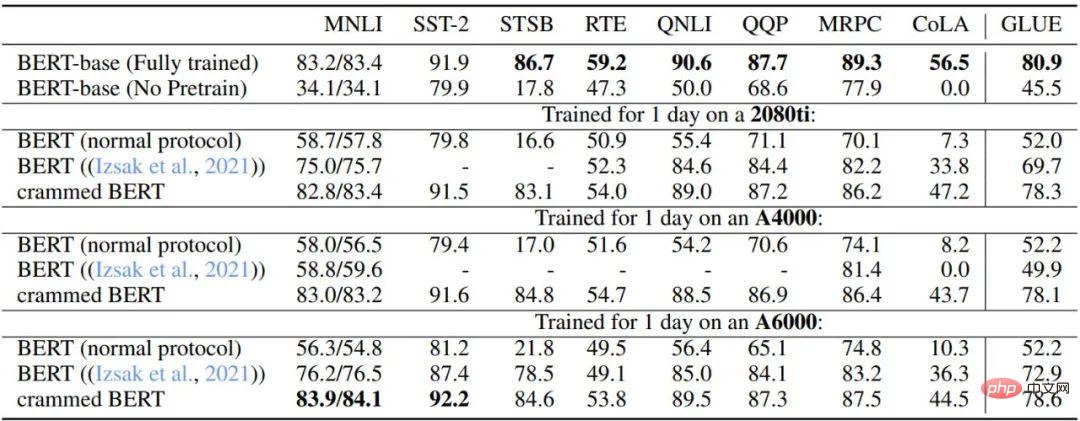

Le Tableau 3 et le Tableau 4 décrivent les performances de cette configuration sur les tâches GLUE en aval. Les auteurs ont comparé le point de contrôle de base BERT d'origine, un paramètre de pré-entraînement BERT qui s'arrête après avoir atteint la limite de puissance de calcul, le paramètre décrit dans l'étude 2021 d'Izsak et al., et un paramètre modifié qui s'entraîne pendant une journée par GPU. paramètre. Dans l'ensemble, les performances sont étonnamment bonnes, en particulier pour les ensembles de données plus volumineux tels que MNLI, QQP, QNLI et SST-2, et un réglage fin en aval peut atténuer les différences restantes entre le modèle BERT complet et la variante de paramètre Cramming.

De plus, les auteurs ont constaté que la nouvelle méthode est considérablement améliorée par rapport à la formation BERT ordinaire avec une puissance de calcul limitée et à la méthode décrite par Izsak et al. Pour l'étude d'Izsak et al., la méthode décrite a été conçue à l'origine pour un serveur lame complet à 8 GPU, et dans le nouveau scénario, la compression du grand modèle BERT sur le GPU plus petit était responsable de la plupart des performances. déclin.

Tableau 3 : Comparaison des performances de GLUE-dev des modèles de base BERT et de la version Cramming

Les hyperparamètres de toutes les tâches sont fixes, la limite d'époque est de 5 et la valeur manquante est NaN. Il a été conçu pour un serveur lame à 8 GPU, et ici, tous les calculs sont regroupés dans un seul GPU.

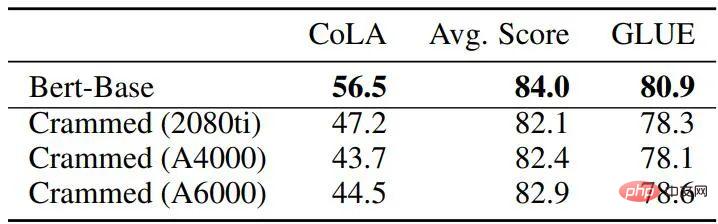

Tableau 4 : Comparaison des performances de GLUE-dev entre le BERT de base et le modèle de remplissage

En général, en utilisant la méthode décrite dans l'article, les résultats de l'entraînement sont très proches du BERT d'origine, mais il est important de savoir que le Le total des FLOPS utilisés par cette dernière est la nouvelle méthode 45 à 136 fois plus rapide (ce qui prend quatre jours sur 16 TPU). Et lorsque le temps de formation est prolongé de 16 fois (deux jours de formation sur 8 GPU), les performances de la nouvelle méthode s'améliorent en réalité beaucoup par rapport au BERT original, atteignant le niveau de RoBERTa.

Dans ce travail, les gens ont discuté des performances que les modèles de langage basés sur des transformateurs peuvent atteindre dans des environnements très limités en termes de calcul. Heureusement, plusieurs directions de modification peuvent nous permettre d'obtenir de bonnes performances en aval sur les performances de GLUE. Les chercheurs espèrent que ces travaux pourront fournir une base pour de nouvelles améliorations et fournir un soutien théorique aux nombreuses améliorations et techniques proposées pour l’architecture des transformateurs ces dernières années.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Installer et configurer VNC sur Ubuntu

Installer et configurer VNC sur Ubuntu

Comment résoudre l'erreur inconnue 11

Comment résoudre l'erreur inconnue 11

Comment obtenir un jeton

Comment obtenir un jeton

Que signifie le HD du téléphone portable ?

Que signifie le HD du téléphone portable ?

Plateforme de trading de devises virtuelles

Plateforme de trading de devises virtuelles

utilisation de l'instruction switch

utilisation de l'instruction switch

Application de plateforme de trading Ouyi

Application de plateforme de trading Ouyi

Comment résoudre le problème de l'impossibilité d'ouvrir la partition du disque dur

Comment résoudre le problème de l'impossibilité d'ouvrir la partition du disque dur