Périphériques technologiques

Périphériques technologiques

IA

IA

Le langage naturel est intégré à NeRF, et LERF, qui génère des images 3D avec seulement quelques mots, est là.

Le langage naturel est intégré à NeRF, et LERF, qui génère des images 3D avec seulement quelques mots, est là.

Le langage naturel est intégré à NeRF, et LERF, qui génère des images 3D avec seulement quelques mots, est là.

NeRF (Neural Radiance Fields), également connu sous le nom de champs de rayonnement neuronal, est rapidement devenu l'un des domaines de recherche les plus populaires depuis sa proposition, et les résultats sont étonnants. Cependant, le résultat direct de NeRF n'est qu'un champ de densité coloré, qui fournit peu d'informations aux chercheurs. Le manque de contexte est l'un des problèmes auxquels il faut faire face. Il affecte directement la construction d'interfaces interactives avec la 3D. scènes.

Mais le langage naturel est différent. Le langage naturel interagit avec les scènes 3D de manière très intuitive. Nous pouvons utiliser la scène de cuisine de la figure 1 pour expliquer que des objets peuvent être trouvés dans la cuisine en demandant où se trouvent les couverts, ou en demandant où se trouvent les outils utilisés pour remuer. Cependant, l’accomplissement de cette tâche nécessite non seulement les capacités de requête du modèle, mais également la capacité d’incorporer la sémantique à plusieurs échelles.

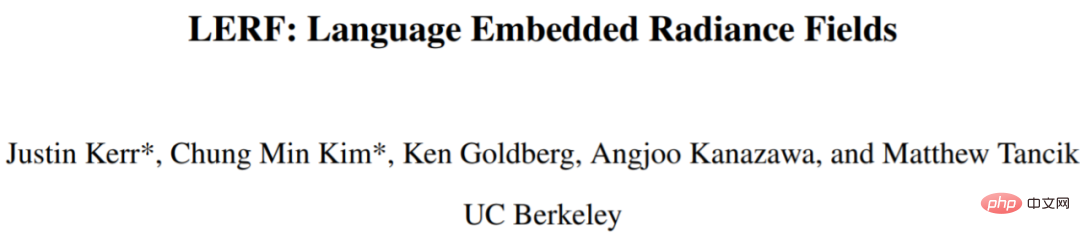

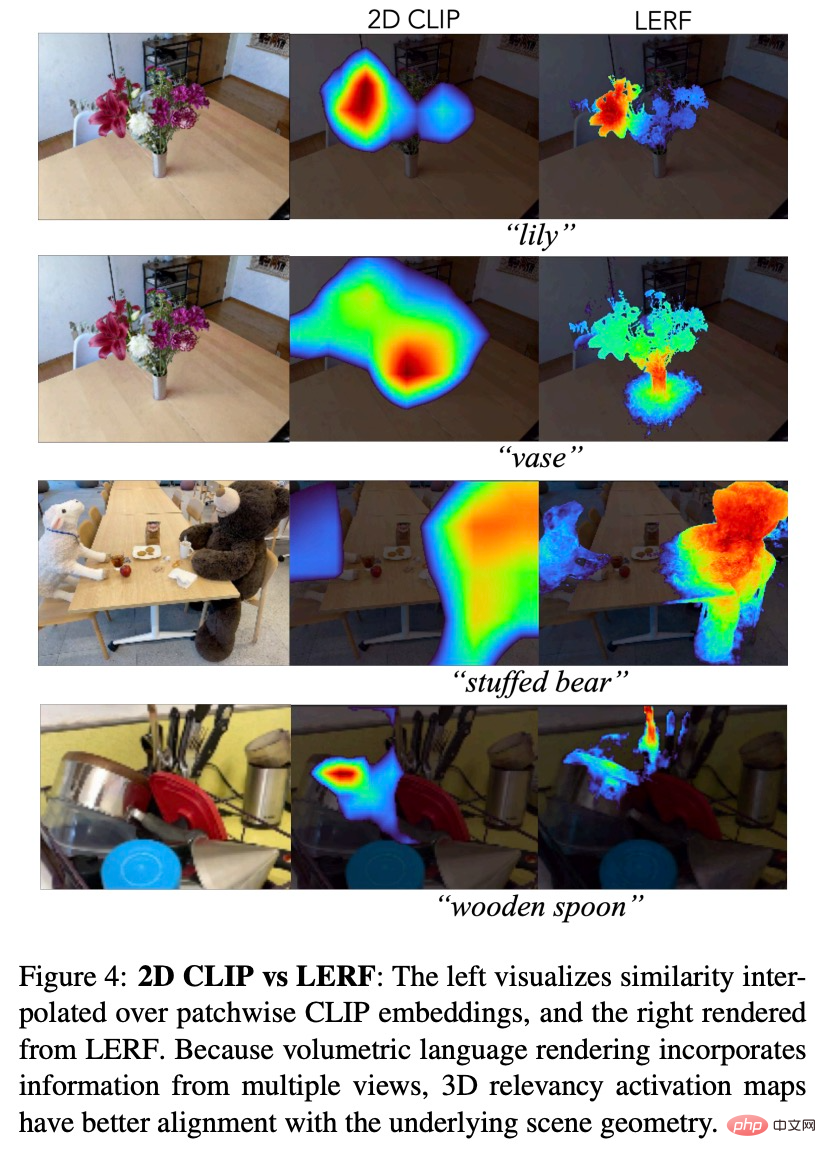

Dans cet article, des chercheurs de l'UC Berkeley ont proposé une nouvelle méthode et l'ont nommée LERF (Language Embedded Radiance Fields), qui combine les langagesdans des modèles tels que CLIP (Contrastive Language-Image Pre-training) Embedded into NeRF, rendant possibles ces types de requêtes en langage ouvert 3D. LERF utilise CLIP directement, sans avoir besoin d'affiner via des ensembles de données tels que COCO, ou de s'appuyer sur des suggestions de régions masquées. LERF préserve l'intégrité des intégrations CLIP à plusieurs échelles et est également capable de gérer une variété de requêtes linguistiques, y compris les attributs visuels (par exemple, le jaune), les concepts abstraits (par exemple, le courant électrique), le texte, etc., comme le montre la figure 1. .

Adresse de papier: https://arxiv.org/pdf/2303.09553v1.pdf

project Homepage: https://www.lerf.io/

LERF peut extraire de manière interactive des diagrammes de corrélation 3D pour les invites linguistiques en temps réel. Par exemple, sur une table avec un agneau et un gobelet d'eau, saisissez l'invite agneau ou gobelet d'eau, et LERF pourra donner la carte 3D correspondante :

Pour les bouquets complexes, LERF peut également positionner avec précision :

Différents objets dans la cuisine :

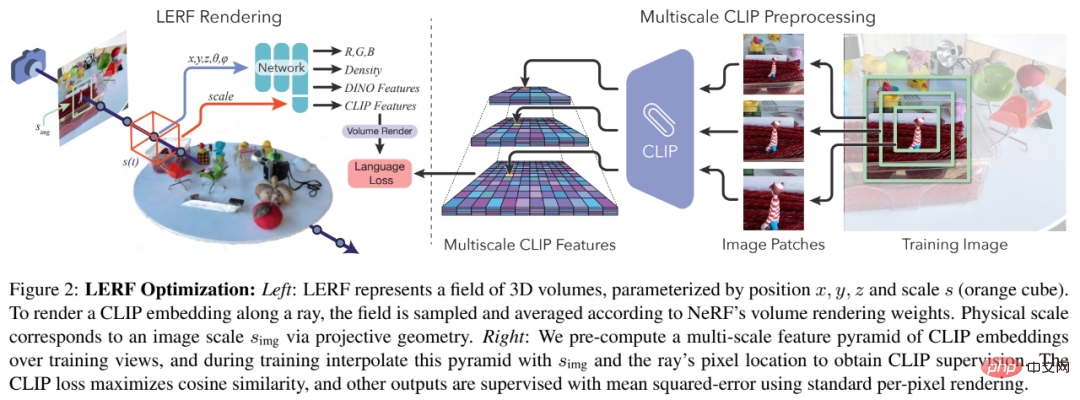

Méthode

Cette étude a construit une nouvelle méthode LERF en optimisant conjointement le champ du langage avec NeRF. LERF prend la position et l'échelle physique en entrée et génère un seul vecteur CLIP. Pendant la formation, les champs sont supervisés à l'aide d'une pyramide de fonctionnalités multi-échelles contenant des intégrations CLIP générées à partir de recadrages d'images des vues de formation. Cela permet à l'encodeur CLIP de capturer le contexte de l'image à différentes échelles, associant ainsi le même emplacement 3D à des intégrations de langage à différentes échelles. LERF peut interroger le champ linguistique à n’importe quelle échelle pendant les tests pour obtenir une carte de corrélation 3D.

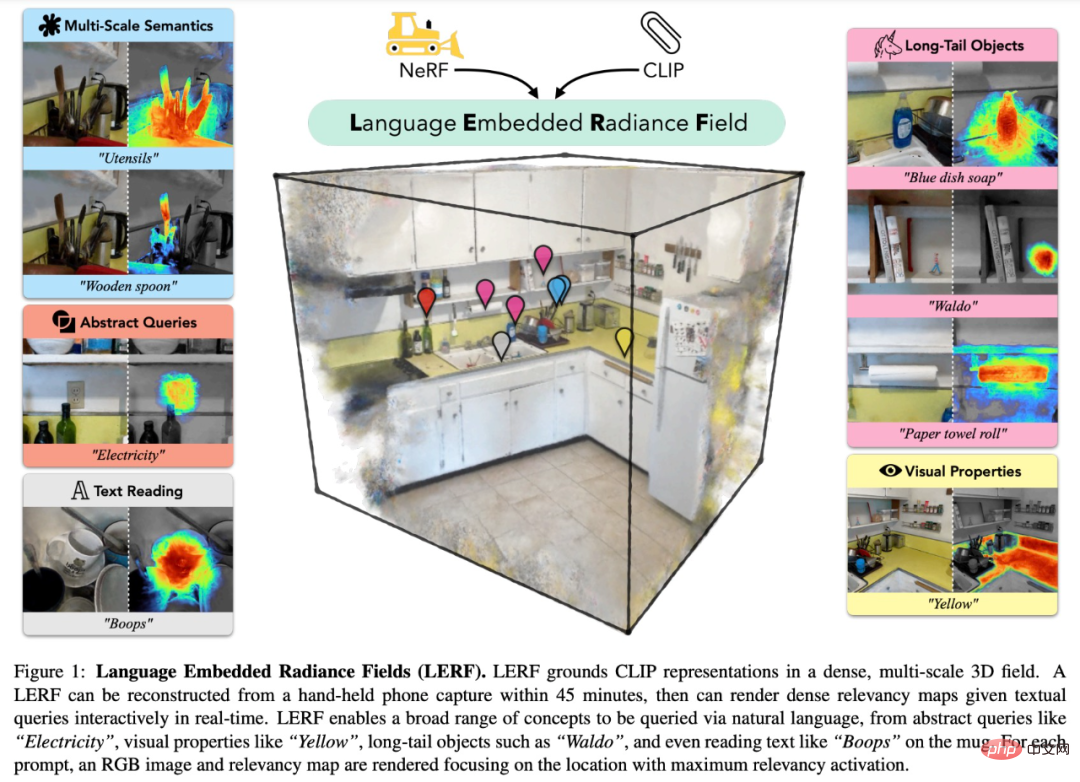

Étant donné que les intégrations CLIP sont extraites de plusieurs vues à plusieurs échelles, la carte de pertinence d'une requête textuelle obtenue via l'intégration CLIP 3D de LERF est plus localisée que celle obtenue via l'intégration CLIP 2D, et est cohérente en 3D et peut. être interrogé directement dans le champ 3D sans afficher plusieurs vues.

LERF nécessite l'apprentissage d'un langage d'intégration de champ sur un volume centré sur un point d'échantillonnage. Plus précisément, le résultat de ce champ est l'intégration CLIP moyenne de toutes les vues d'entraînement contenant des recadrages d'images du volume spécifié. En reconstruisant des requêtes de points en volumes, LERF peut superviser efficacement des champs denses à partir de récoltes grossières d'images d'entrée, qui peuvent être restituées de manière alignée en pixels par conditionnement sur une échelle volumétrique donnée.

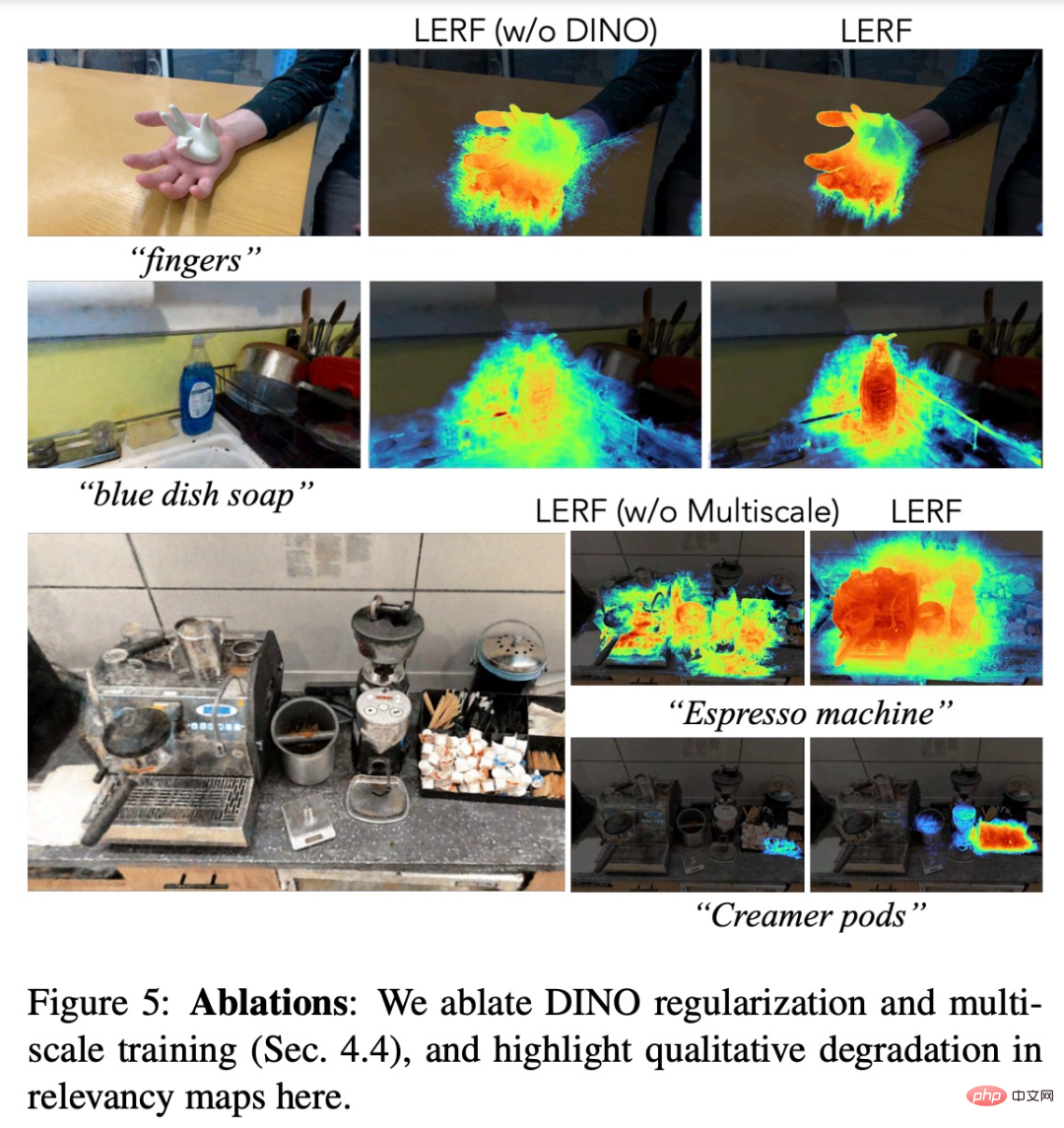

LERF lui-même produit des résultats cohérents, mais la carte de corrélation résultante peut parfois être incomplète et contenir des valeurs aberrantes, comme le montre la figure 5 ci-dessous.

Pour réguler le champ linguistique optimisé, cette étude introduit DINO auto-supervisé en partageant les goulots d'étranglement.

En termes d'architecture, l'optimisation de l'intégration du langage en 3D ne devrait pas affecter la distribution de densité dans la représentation de la scène sous-jacente, cette étude capture donc le biais inductif dans LERF en entraînant deux réseaux indépendants : un avec pour les vecteurs propres (DINO, CLIP) et un autre pour la sortie NeRF standard (couleur, densité).

Expériences

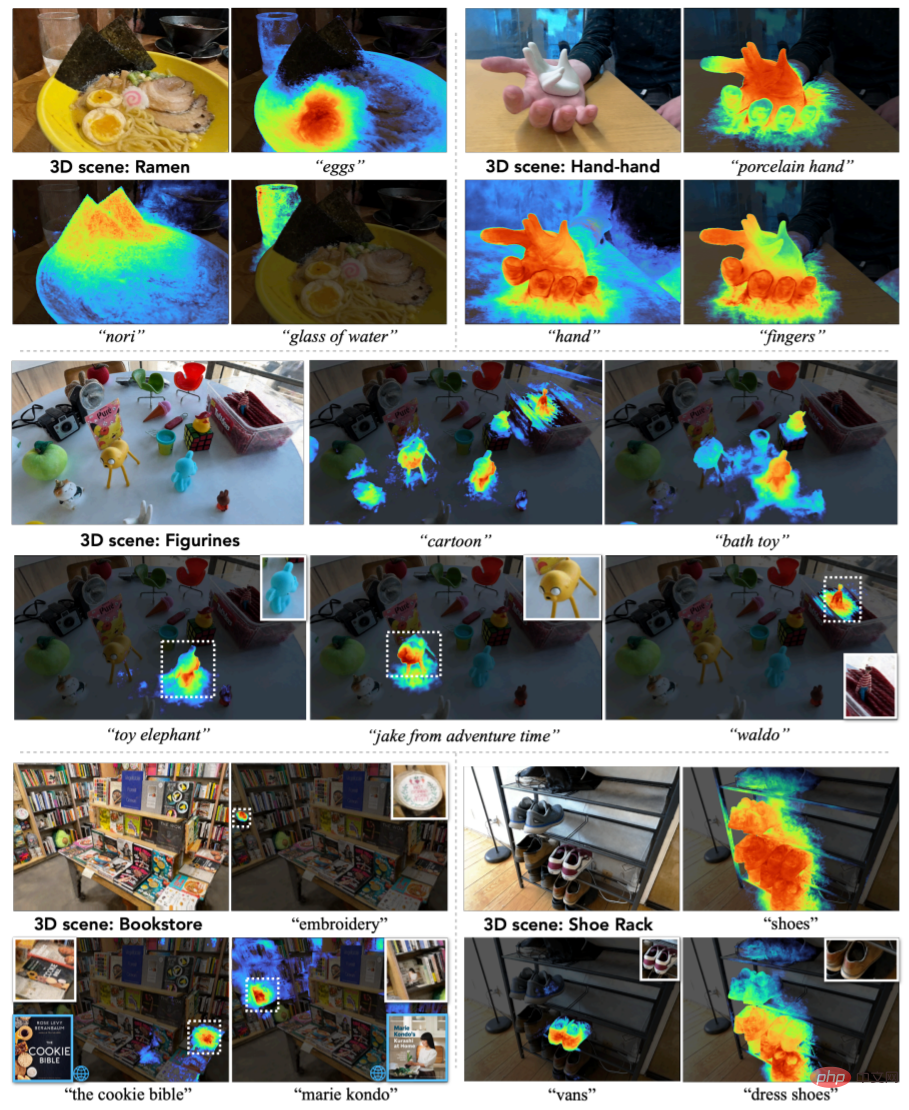

Pour démontrer la capacité du LERF à traiter des données du monde réel, l'étude a collecté 13 scènes, notamment des épiceries, des cuisines, des librairies, des figurines, etc. La figure 3 sélectionne 5 scénarios représentatifs pour démontrer la capacité du LERF à traiter le langage naturel.

Figure 3

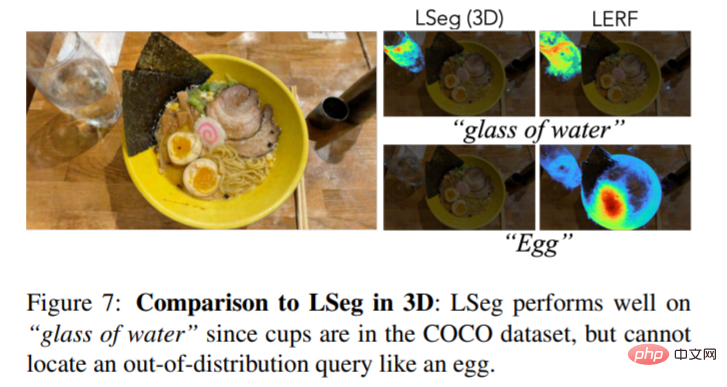

La figure 7 est une comparaison visuelle 3D du LERF et du LSeg Dans les œufs dans le bol d'étalonnage, le LSeg n'est pas aussi bon que le LERF :

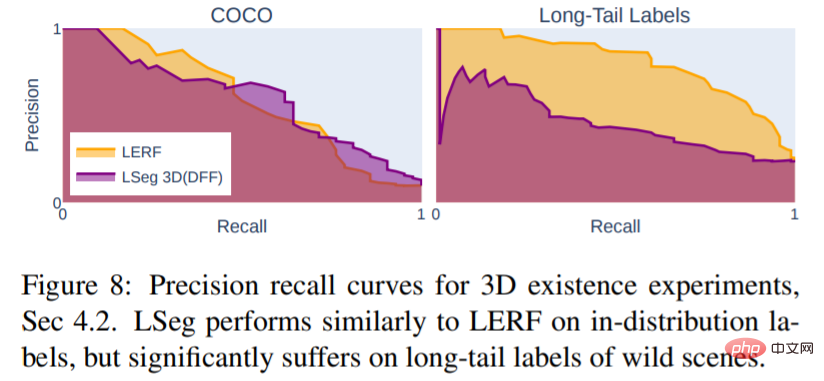

La figure 8 montre que LSeg formé sur un ensemble de données segmentées limitées n'a pas la capacité de représenter efficacement le langage naturel. Au lieu de cela, il ne fonctionne bien que sur les objets courants au sein de la distribution de l'ensemble d'apprentissage, comme le montre la figure 7.

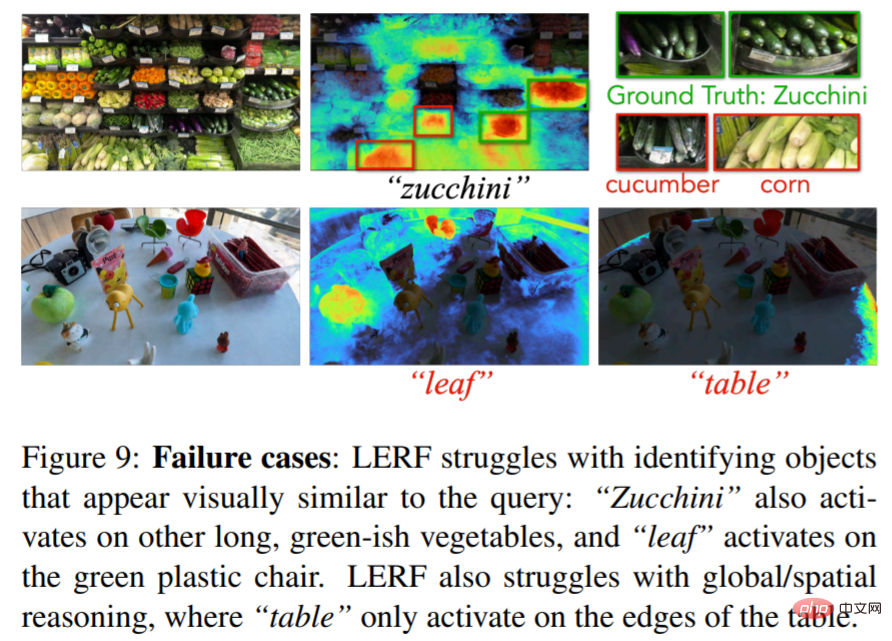

Cependant, la méthode LERF n'est pas encore parfaite. Voici des cas d'échec. Par exemple, lors du calibrage des légumes courgettes, d'autres légumes apparaîtront :

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Introduction à cinq méthodes d'échantillonnage dans les tâches de génération de langage naturel et l'implémentation du code Pytorch

Feb 20, 2024 am 08:50 AM

Introduction à cinq méthodes d'échantillonnage dans les tâches de génération de langage naturel et l'implémentation du code Pytorch

Feb 20, 2024 am 08:50 AM

Dans les tâches de génération de langage naturel, la méthode d'échantillonnage est une technique permettant d'obtenir du texte à partir d'un modèle génératif. Cet article abordera 5 méthodes courantes et les implémentera à l'aide de PyTorch. 1. GreedyDecoding Dans le décodage gourmand, le modèle génératif prédit les mots de la séquence de sortie en fonction du temps de la séquence d'entrée pas à pas. À chaque pas de temps, le modèle calcule la distribution de probabilité conditionnelle de chaque mot, puis sélectionne le mot avec la probabilité conditionnelle la plus élevée comme sortie du pas de temps actuel. Ce mot devient l'entrée du pas de temps suivant et le processus de génération se poursuit jusqu'à ce qu'une condition de fin soit remplie, telle qu'une séquence d'une longueur spécifiée ou un marqueur de fin spécial. La caractéristique de GreedyDecoding est qu’à chaque fois la probabilité conditionnelle actuelle est la meilleure

Comment générer du langage naturel de base à l'aide de PHP

Jun 22, 2023 am 11:05 AM

Comment générer du langage naturel de base à l'aide de PHP

Jun 22, 2023 am 11:05 AM

La génération de langage naturel est une technologie d'intelligence artificielle qui convertit les données en texte en langage naturel. À l’ère actuelle du Big Data, de plus en plus d’entreprises ont besoin de visualiser ou de présenter des données aux utilisateurs, et la génération de langage naturel est une méthode très efficace. PHP est un langage de script côté serveur très populaire qui peut être utilisé pour développer des applications Web. Cet article présentera brièvement comment utiliser PHP pour la génération de base de langage naturel. Présentation de la bibliothèque de génération de langage naturel La bibliothèque de fonctions fournie avec PHP n'inclut pas les fonctions requises pour la génération de langage naturel, donc

Traffic Engineering double la précision de la génération de code : de 19 % à 44 %

Feb 05, 2024 am 09:15 AM

Traffic Engineering double la précision de la génération de code : de 19 % à 44 %

Feb 05, 2024 am 09:15 AM

Les auteurs d'un nouvel article proposent un moyen « d'améliorer » la génération de code. La génération de code est une capacité de plus en plus importante en intelligence artificielle. Il génère automatiquement du code informatique basé sur des descriptions en langage naturel en entraînant des modèles d'apprentissage automatique. Cette technologie a de larges perspectives d'application et peut transformer les spécifications logicielles en code utilisable, automatiser le développement back-end et aider les programmeurs humains à améliorer l'efficacité de leur travail. Cependant, générer du code de haute qualité reste un défi pour les systèmes d’IA, par rapport aux tâches linguistiques telles que la traduction ou le résumé. Le code doit se conformer avec précision à la syntaxe du langage de programmation cible, gérer les cas extrêmes et les entrées inattendues avec élégance, et gérer avec précision les nombreux petits détails de la description du problème. Même de petits bugs qui peuvent sembler inoffensifs dans d'autres domaines peuvent complètement perturber la fonctionnalité d'un programme, provoquant

Construire des générateurs de texte à l'aide de chaînes de Markov

Apr 09, 2023 pm 10:11 PM

Construire des générateurs de texte à l'aide de chaînes de Markov

Apr 09, 2023 pm 10:11 PM

Dans cet article, nous présenterons un projet d'apprentissage automatique populaire appelé générateur de texte. Vous apprendrez à créer un générateur de texte et à implémenter une chaîne de Markov pour obtenir un modèle prédictif plus rapide. Introduction aux générateurs de texte La génération de texte est populaire dans tous les secteurs, en particulier dans les domaines mobile, des applications et de la science des données. Même la presse utilise la génération de texte pour faciliter le processus d'écriture. Dans la vie quotidienne, nous entrerons en contact avec certaines technologies de génération de texte. La complétion de texte, les suggestions de recherche, Smart Compose et les robots de discussion sont autant d'exemples d'applications. Cet article utilisera les chaînes de Markov pour créer un générateur de texte. Il s'agirait d'un modèle basé sur les caractères qui prendrait le caractère précédent de la chaîne et générerait la lettre suivante de la séquence. En entraînant notre programme sur des exemples de mots,

Le curseur intégré à GPT-4 rend l'écriture de code aussi simple que la discussion. Une nouvelle ère de codage en langage naturel est arrivée.

Apr 04, 2023 pm 12:15 PM

Le curseur intégré à GPT-4 rend l'écriture de code aussi simple que la discussion. Une nouvelle ère de codage en langage naturel est arrivée.

Apr 04, 2023 pm 12:15 PM

Github Copilot X, qui intègre GPT-4, est encore en test interne à petite échelle, tandis que Cursor, qui intègre GPT-4, a été rendu public. Cursor est un IDE qui intègre GPT-4 et peut écrire du code en langage naturel, ce qui rend l'écriture de code aussi simple que la discussion. Il existe encore une grande différence entre GPT-4 et GPT-3.5 dans leur capacité à traiter et à écrire du code. Un rapport de test du site officiel. Les deux premiers sont GPT-4, l'un utilise la saisie de texte et l'autre la saisie d'images ; le troisième est GPT3.5. On peut voir que les capacités de codage de GPT-4 ont été grandement améliorées par rapport à GPT-3.5. Github Copilot X intégrant GPT-4 est encore en test à petite échelle, et

Avec une couverture complète des valeurs et de la protection de la vie privée, l'Administration chinoise du cyberespace prévoit « d'établir des règles » pour l'IA générative

Apr 13, 2023 pm 03:34 PM

Avec une couverture complète des valeurs et de la protection de la vie privée, l'Administration chinoise du cyberespace prévoit « d'établir des règles » pour l'IA générative

Apr 13, 2023 pm 03:34 PM

Le 11 avril, l'Administration du cyberespace de Chine (ci-après dénommée Administration du cyberespace de Chine) a rédigé et publié les « Mesures pour la gestion des services d'intelligence artificielle générative (projet pour commentaires) » et a lancé une sollicitation d'opinions d'un mois auprès de le public. Cette mesure de gestion (projet pour commentaires) compte au total 21 articles. En termes de champ d'application, elle inclut à la fois les entités qui fournissent des services d'intelligence artificielle générative, ainsi que les organisations et les individus qui utilisent ces services, les mesures de gestion couvrent la production ; contenu de l'intelligence artificielle générative. orientation vers les valeurs, principes de formation pour les prestataires de services, protection de la vie privée/droits de propriété intellectuelle et autres droits, etc. L’émergence de modèles et de produits génératifs de langage naturel à grande échelle tels que GPT a non seulement permis au public de découvrir les progrès rapides de l’intelligence artificielle, mais a également exposé des risques de sécurité, notamment la génération d’informations biaisées et discriminatoires.

Est-il nécessaire de « participer » ? Andrej Karpathy : Il est temps de jeter ce bagage historique

May 20, 2023 pm 12:52 PM

Est-il nécessaire de « participer » ? Andrej Karpathy : Il est temps de jeter ce bagage historique

May 20, 2023 pm 12:52 PM

L’émergence de l’IA conversationnelle comme ChatGPT a habitué les gens à ce genre de choses : saisissez un texte, un code ou une image, et le robot conversationnel vous donnera la réponse que vous souhaitez. Mais derrière cette méthode d'interaction simple, le modèle d'IA doit effectuer un traitement de données et des calculs très complexes, et la tokenisation est courante. Dans le domaine du traitement du langage naturel, la tokenisation fait référence à la division du texte saisi en unités plus petites, appelées « jetons ». Ces jetons peuvent être des mots, des sous-mots ou des caractères, en fonction de la stratégie spécifique de segmentation des mots et des exigences de la tâche. Par exemple, si nous effectuons une tokenisation sur la phrase « J'aime manger des pommes », nous obtiendrons une séquence de jetons : [&qu

De nombreux pays envisagent d'interdire ChatGPT. La cage pour la « bête » arrive-t-elle ?

Apr 10, 2023 pm 02:40 PM

De nombreux pays envisagent d'interdire ChatGPT. La cage pour la « bête » arrive-t-elle ?

Apr 10, 2023 pm 02:40 PM

"L'intelligence artificielle veut s'évader de prison", "L'IA génère la conscience de soi", "L'IA finira par tuer les humains", "l'évolution de la vie basée sur le silicium"... n'apparaissaient autrefois que dans les fantasmes technologiques tels que le cyberpunk. L'intrigue arrive C’est vrai cette année, et les modèles génératifs de langage naturel sont remis en question comme jamais auparavant. Celui qui a le plus retenu l'attention est ChatGPT. De fin mars à début avril, ce robot de conversation textuelle développé par OpenAI est passé soudainement d'un représentant de « productivité avancée » à une menace pour l'humanité. Premièrement, il a été nommé par des milliers d'élites du cercle technologique et inclus dans une lettre ouverte pour « suspendre la formation de systèmes d'IA plus puissants que GPT-4 », puis l'organisation américaine d'éthique technologique a demandé à la Federal Trade Commission des États-Unis d'enquêter ; OpenAI et interdire la sortie de version commerciale