Périphériques technologiques

Périphériques technologiques

IA

IA

Des recherches vraiment importantes ! 32 articles examinent de près les points chauds de l'IA en 2022

Des recherches vraiment importantes ! 32 articles examinent de près les points chauds de l'IA en 2022

Des recherches vraiment importantes ! 32 articles examinent de près les points chauds de l'IA en 2022

Alors que le monde est encore en convalescence, la recherche n’a pas ralenti son rythme effréné, notamment dans le domaine de l’intelligence artificielle.

De plus, cette année, l'accent est mis sur l'éthique, les préjugés, la gouvernance et la transparence de l'IA.

L'intelligence artificielle et notre compréhension du cerveau humain et sa connexion à l'intelligence artificielle évoluent constamment, et dans un avenir proche, ces applications qui améliorent la qualité de nos vies brilleront.

Le célèbre blogueur Louis Bouchard a également dénombré 32 (!) avancées technologiques en IA en 2022 dans son blog.

Jetons un coup d'œil à ce que sont ces études étonnantes !

Adresse de l'article : https://www.louisbouchard.ai/2022-ai-recap/

LaMA : Résolution Réparation Robuste des Grands Masques Basée sur la Convolution de Fourier

Vous devez avoir été dans cette situation : vous et vos amis avez pris une superbe photo. En conséquence, vous constatez que quelqu'un est derrière vous, détruisant la photo que vous souhaitez envoyer à Moments ou à Xiaohongshu. Mais désormais, ce n’est plus un problème.

La méthode d'inpainting de grands masques, robuste en résolution, basée sur la convolution de Fourier, permet aux utilisateurs de supprimer facilement le contenu indésirable des images. Les personnes et les poubelles peuvent facilement disparaître.

C'est comme un concepteur PS professionnel dans votre poche, il peut être facilement effacé en un seul clic.

Bien qu'apparemment simple, l'inpainting d'images est un problème que de nombreux chercheurs en IA résolvent depuis longtemps.

Lien papier : https://arxiv.org/abs/2109.07161

Adresse du projet : https://github.com/saic-mdal/lama

Démo Colab : https://colab.research.google.com/github/saic-mdal/lama/blob/master/colab/LaMa_inpainting.ipynb

Explication vidéo : https://youtu.be/Ia79AvGzveQ

Courte analyse : https://www.louisbouchard.ai/lama/

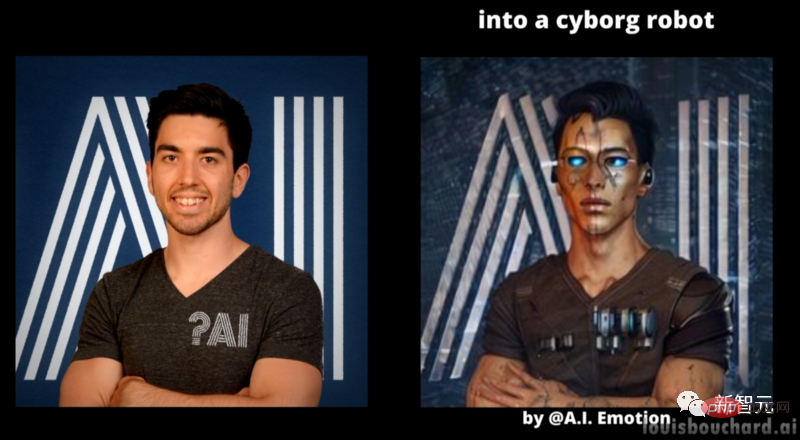

STIT : Montage de visage vidéo réel basé sur GAN

Vous devez avoir vécu une telle expérience : en regardant un film, vous constaterez que les acteurs du film ont l’air beaucoup plus jeunes qu’eux.

Will Smith dans Gemini Man

Auparavant, cela nécessitait que les professionnels consacrent des centaines, voire des milliers d'heures de travail, à monter manuellement les scènes dans lesquelles ces acteurs apparaissaient. Mais avec l’IA, vous pouvez le faire en quelques minutes.

En fait, de nombreuses technologies vous permettent d'augmenter votre sourire et de vous faire paraître plus jeune ou plus vieux, le tout automatiquement à l'aide d'algorithmes basés sur l'intelligence artificielle. C'est ce qu'on appelle les manipulations de visage basées sur l'IA dans la vidéo et représente l'état de l'art en 2022.

Lien papier : https://arxiv.org/abs/2201.08361

Adresse du projet : https://github.com/rotemtzaban/STIT

Explication vidéo : https://youtu.be/mqItu9XoUgk

Courte analyse : https://www.louisbouchard.ai/stitch-it-in-time/

NeROIC : Utilisation du rendu neuronal de la galerie en ligne

Le rendu neuronal peut générer des modèles 3D réalistes dans l'espace à travers des images d'objets, de personnes ou de scènes.

Avec cette technologie, vous n'avez besoin que de quelques images d'un objet, et vous pouvez demander à la machine de comprendre l'objet sur ces images et de simuler à quoi il ressemble dans l'espace.

Comprendre la forme physique des objets à travers des images est facile pour les humains car nous comprenons le monde réel. Mais pour une machine capable de voir uniquement les pixels, le défi est complètement différent.

Comment le modèle généré peut-il être intégré dans de nouveaux scénarios ? Que se passe-t-il si les conditions d'éclairage et les angles de la photo sont différents et que le modèle obtenu change en conséquence ? Telles sont les questions auxquelles Snapchat et l’Université de Californie du Sud devaient répondre dans cette nouvelle étude.

Lien papier : https://arxiv.org/abs/2201.02533

Adresse du projet : https://github.com/snap-research/NeROIC

Explication vidéo : https://youtu.be/88Pl9zD1Z78

Analyse courte : https://www.louisbouchard.ai/neroic/

SpeechPainter : Réparation de la parole dans des conditions de texte

Pour les images Pour Par exemple, la technologie d'inpainting basée sur l'apprentissage automatique peut non seulement supprimer le contenu, mais également remplir les parties manquantes de l'image en fonction des informations d'arrière-plan.

Pour la restauration vidéo, le défi n'est pas seulement de maintenir la cohérence d'une image à l'autre, mais aussi d'éviter de générer des artefacts erronés. Dans le même temps, lorsque vous réussissez à « expulser » une personne de la vidéo, vous devez également supprimer sa voix.

À cette fin, les chercheurs de Google ont proposé une nouvelle méthode de réparation vocale capable de corriger la grammaire, la prononciation et même de supprimer le bruit de fond dans les vidéos.

Lien papier : https://arxiv.org/abs/2202.07273

Explication vidéo : https://youtu.be/zIIc4bRf5Hg

Courte analyse : https:// www.louisbouchard.ai/speech-inpainting-with-ai/

GFP-GAN : Restauration de visages aveugles dans le monde réel à l'aide d'a priori faciaux génératifs

Avez-vous de vieilles photos que vous chérissez en raison de leur âge ? il y a quelque temps et la qualité de l'image est floue ? Ne vous inquiétez pas, avec Blind Face Restoration, vos souvenirs dureront pour toujours.

Ce nouveau modèle d'IA gratuit peut réparer la plupart de vos anciennes photos en un éclair. Cela fonctionne très bien même si la photo de pré-restauration est de très mauvaise qualité. Auparavant, c’était souvent tout un défi.

Ce qui est encore plus cool, c'est que vous pouvez l'essayer comme vous le souhaitez. Ils ont open source le code et créé une démo et une application en ligne que tout le monde peut essayer. Je pense que cette technologie va vous surprendre !

Lien papier : https://arxiv.org/abs/2101.04061

Adresse du projet : https://github.com/TencentARC/GFPGAN

Démo Colab : https://colab.research.google.com/drive/1sVsoBd9AjckIXThgtZhGrHRfFI6UUYOo

Application en ligne : https://huggingface.co/spaces/akhaliq/GFPGAN

Vidéo Explication : https://youtu.be/nLDVtzcSeqM

Analyse courte : https://www.louisbouchard.ai/gfp-gan/

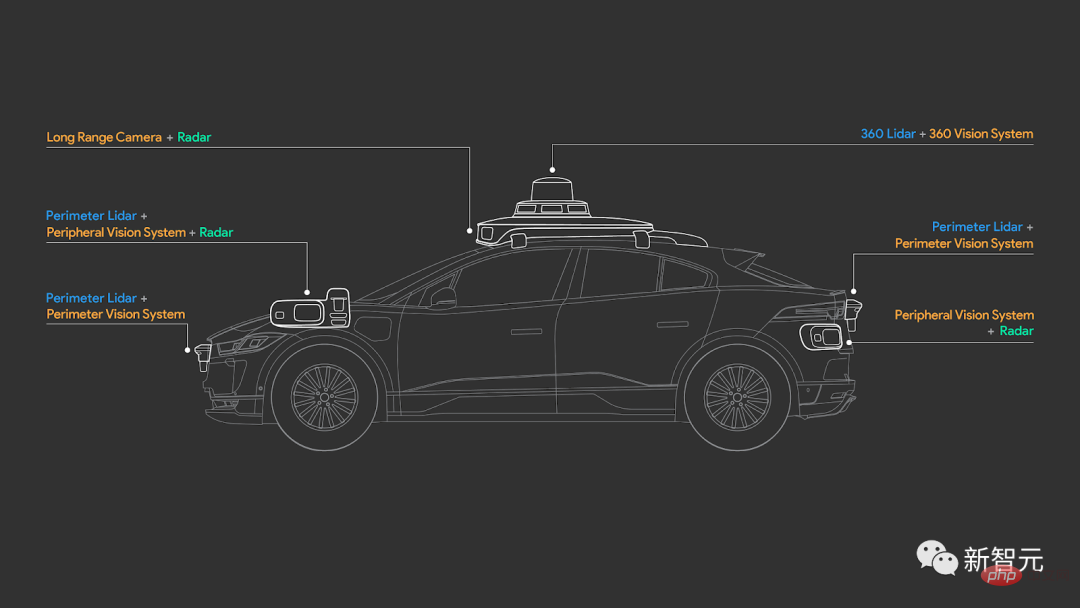

4D-Net : Apprentissage de l'alignement multimodal

Comment les voitures autonomes « voient-elles six directions » ?

Vous avez peut-être entendu parler des capteurs LiDAR ou d'autres caméras étranges utilisées par les constructeurs automobiles. Mais comment fonctionnent-ils, comment voient-ils le monde et que voient-ils exactement différemment de nous ?

Lien papier : https://arxiv.org/abs/2109.01066

Contrairement à Tesla, qui utilise uniquement des caméras pour comprendre le monde, la plupart des constructeurs de voitures autonomes, comme Waymo, utiliser Il s'agit d'une caméra ordinaire et d'un capteur LiDAR 3D.

Ils ne génèrent pas d'images comme les caméras ordinaires, mais génèrent plutôt des nuages de points 3D, utilisent les informations de détection RVB, mesurent la distance entre les objets et calculent le temps de trajet du laser pulsé qu'ils projettent sur l'objet.

Mais comment combiner efficacement ces informations et les faire comprendre au véhicule ? Que verra finalement le véhicule ? La conduite autonome est-elle suffisamment sûre ? Un nouveau document de recherche de Waymo et Google répondra à ces mystères.

Explication vidéo : https://youtu.be/0nJMnw1Ldks

Analyse courte : https://www.louisbouchard.ai/waymo-lidar/

NeRF instantané : basé sur multi -résolution Primitives neuronales instantanées codées par taux de hachage

Comment simuler à quoi ressemble le monde à travers des photos ?

Grâce aux modèles d'IA, les gens peuvent transformer les images capturées en modèles 3D de haute qualité. Cette tâche difficile permet aux chercheurs d’utiliser des images 2D pour créer à quoi ressemblerait un objet ou une personne dans un monde tridimensionnel.

En utilisant des primitives graphiques basées sur le codage de hachage, NVIDIA a réalisé 5 secondes d'entraînement NeRF et a obtenu de meilleurs résultats. En moins de deux ans de recherche, la vitesse d’entraînement du NeRF a été multipliée par plus de 1 000.

Lien papier : https://arxiv.org/abs/2201.05989

Adresse du projet : https://github.com/NVlabs/instant-ngp

Explication vidéo : https://youtu.be/UHQZBQOVAIU

Courte analyse : https://www.louisbouchard.ai/nvidia-photos-into-3d-scenes/

DALL· E 2 : Modèle de génération de texte en image basé sur les fonctionnalités CLIP

L'année dernière, OpenAI a publié le modèle de génération de texte en image DALL·E. Désormais, la version améliorée de DALL·E 2 est de nouveau là.

DALL·E 2 génère non seulement des images réalistes à partir de texte, mais sa sortie a une résolution quatre fois supérieure !

Cependant, l'amélioration des performances ne semble pas suffisante pour satisfaire OpenAI, ils ont donc également permis à DALL·E 2 d'acquérir une nouvelle compétence : la réparation d'images.

C'est-à-dire que vous pouvez éditer des images avec DALL·E 2 ou ajouter tous les nouveaux éléments de votre choix, comme un flamant rose en arrière-plan.

Lien papier : https://arxiv.org/abs/2204.06125

Explication vidéo : https://youtu.be/rdGVbPI42sA

Courte analyse : https ://www.louisbouchard.ai/openais-new-model-dall-e-2-is-amazing/

MyStyle : Génération préalable personnalisée

Google et l'Université de Tel Aviv ont proposé une technologie DeepFake très puissante. Avec lui, vous pouvez presque tout faire.

Prenez simplement des centaines de photos d'une personne, encodez son image et corrigez, modifiez ou créez le look de votre choix.

C’est à la fois étonnant et effrayant, surtout quand on voit les résultats générés.

Lien de papier: https://arxiv.org/abs/2203.17272

project Adresse: https://mystyle-personalized-prior.github.io/

Explication vidéo : https://youtu.be/BNWAEvFfFvQ

Analyse courte : https://www.louisbouchard.ai/mystyle/

OPT : modèle de langage Transformer pré-entraîné ouvert

Ce qui rend GPT-3 si puissant, c'est son architecture et sa taille.

Il possède 175 milliards de paramètres, soit deux fois le nombre de neurones du cerveau humain ! Un réseau neuronal d’une telle envergure a permis au modèle d’apprendre presque tout Internet, de comprendre comment nous écrivons, échangeons et comprenons le texte.

Juste au moment où les gens étaient étonnés par les puissantes fonctions de GPT-3, Meta a fait un grand pas vers la communauté open source. Ils ont sorti un modèle tout aussi puissant qui est désormais entièrement open source !

Non seulement ce modèle possède plus de 100 milliards de paramètres de niveau, mais aussi, comparé au GPT-3, l'OPT-175B est plus ouvert et accessible.

Lien papier : https://arxiv.org/abs/2205.01068

Adresse du projet : https://github.com/facebookresearch/metaseq

Lien vidéo : https://youtu.be/Ejg0OunCi9U

Courte analyse : https://www.louisbouchard.ai/opt-meta/

BlobGAN : Représentation de scène spatialement discrète

Pour Comment décrire une scène, l'équipe de recherche d'Adobe a proposé une nouvelle méthode : BlobGAN.

BlobGAN utilise des "blobs" pour décrire les objets de la scène. Les chercheurs peuvent déplacer les blobs, les rendant plus grands, plus petits ou même supprimés, ce qui aura le même effet sur l'objet qu'ils représentent dans l'image.

Comme les auteurs partagent leurs résultats, vous pouvez créer de nouvelles images dans l'ensemble de données en dupliquant des blobs.

Maintenant, le code de BlobGAN est open source, amis intéressés, dépêchez-vous et essayez-le !

Lien papier : https://arxiv.org/abs/2205.02837

Adresse du projet : https://github.com/dave-epstein/blobgan

Démo Colab : https://colab.research.google.com/drive/1clvh28Yds5CvKsYYENGLS3iIIrlZK4xO?usp=sharing#scrollTo=0QuVIyVplOKu

Explication vidéo : https://youtu.be/mnEzjpiA_4E

Courte analyse : https://www.louisbouchard.ai/blobgan/

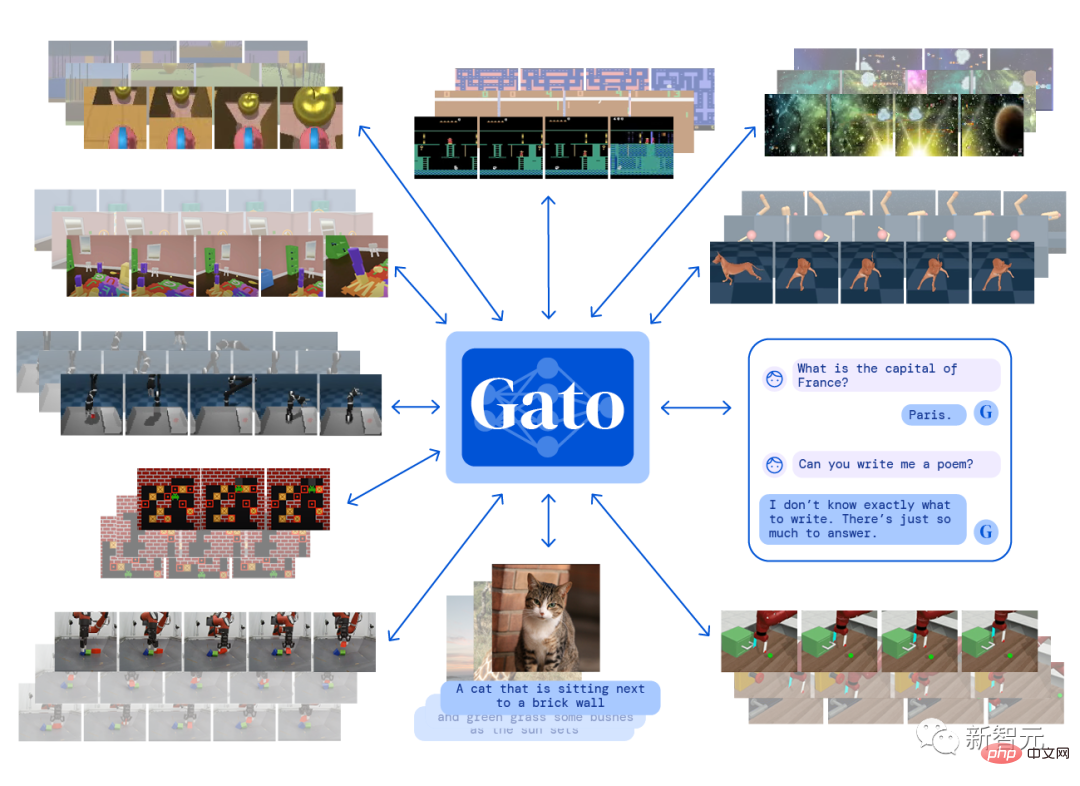

Gato : Agent généraliste

DeepMind a construit un seul agent "général" Gato. Vous pouvez jouer à des jeux Atari, créer des images de sous-titres, discuter avec des gens et contrôler des bras robotiques !

Ce qui est encore plus choquant, c'est qu'il peut effectuer toutes les tâches après un entraînement une seule fois et en utilisant les mêmes poids.

Gato est un agent multimodal. Cela signifie qu’il peut à la fois créer des légendes pour les images et agir comme un chatbot pour répondre aux questions.

Bien que GPT-3 puisse également discuter avec vous, il est évident que Gato peut faire plus. Après tout, il existe souvent des IA capables de discuter, mais peu d’entre elles peuvent jouer à des jeux avec elles.

Lien papier : https://arxiv.org/abs/2205.06175

Explication vidéo : https://youtu.be/xZKSWNv6Esc

bref Analyse de l'histoire : https://www.louisbouchard.ai/deepmind-gato/

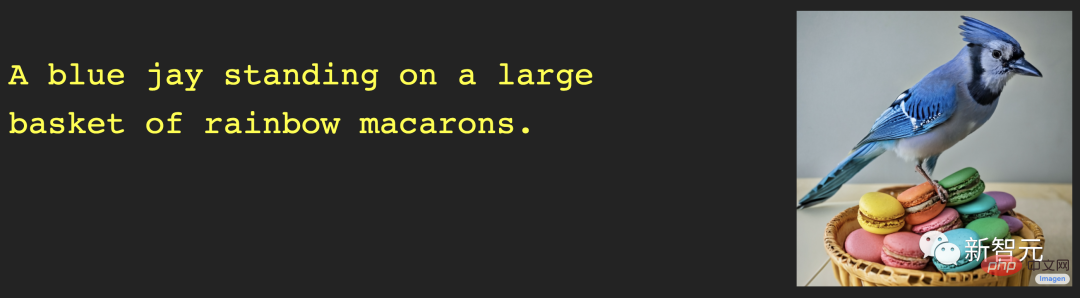

Imagen : modèle de diffusion de texte à image avec une compréhension approfondie du langage

Si vous pensez que DALL·E 2 est excellent, alors vous pourriez aussi jetez un oeil. Ce nouveau modèle de Google Brain - Imagen - peut faire quelque chose à ce sujet.

DALL·E est étonnant, mais les images générées manquent souvent de réalisme. C'est le problème que vise à résoudre Imagen développé par l'équipe Google.

Selon des benchmarks comparant des modèles texte-image, Imagen a obtenu des résultats remarquables en synthèse texte-image avec des intégrations de texte pour de grands modèles de langage. Les images résultantes sont à la fois imaginatives et réalistes.

Lien papier : https://arxiv.org/abs/2205.11487

Adresse du projet : https://imagen.research.google/

Explication vidéo : https://youtu.be/qhtYPhPWCsI

Analyse courte : https://www.louisbouchard.ai/google-brain-imagen/

DALL·E Mini

Un ensemble Les images effrayantes de Xiao Zha ont été populaires sur Twitter pendant un certain temps. Cet ensemble d'œuvres San au bon rapport qualité-prix a été créé par DALL·E mini.

En tant que « Youth Edition » de la famille DALL·E, DALL·E mini est gratuit et open source. Le code a été laissé, quel sera le prochain personnage à être modifié magiquement ?

Adresse du projet : https://github.com/borisdayma/dalle-mini

Expérience en ligne : https://huggingface.co/spaces/dalle-mini/dalle-mini

Explication vidéo : https://youtu.be/K3bZXXjW788

Analyse courte : https://www.louisbouchard.ai/dalle-mini/

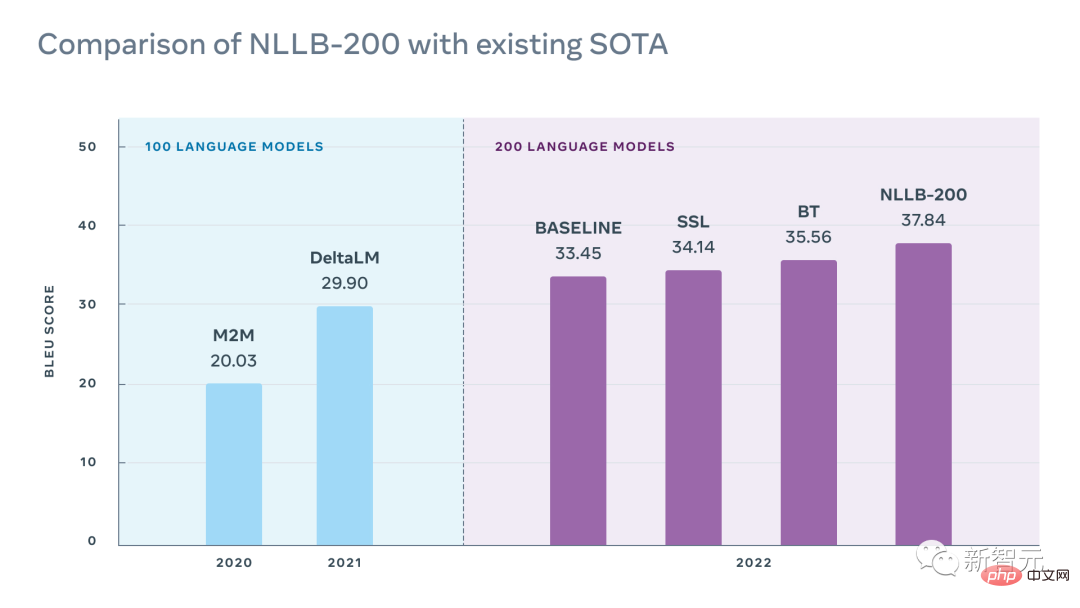

NLLB : Aucune langue laissée pour compte

Meta AI a publié ce modèle NLLB-200. Le concept de dénomination du modèle vient de « No Language Left Behind » et peut réaliser une traduction arbitraire dans plus de 200 langues.

Le point culminant de la recherche est que les chercheurs ont amélioré la plupart des formations linguistiques à faibles ressources de plusieurs ordres de grandeur, tout en obtenant des résultats SOTA pour plus de 200 traductions linguistiques.

Lien papier : https://research.facebook.com/publications/no-lingual-left-behind/

Adresse du projet : https://github.com/facebookresearch/ fairseq/tree/nllb

Expérience en ligne : https://nllb.metademolab.com/

Explication vidéo : https://youtu.be/2G4NeG17Eis

Courte analyse : https://www.louisbouchard.ai/no-lingual-left-behind/

Système de détection de vibrations optiques à double obturateur

Le son peut-il également être vu ?

Cette recherche, qui a remporté le prix honoraire du meilleur article CVPR 2022, propose une nouvelle méthode à double obturateur pour détecter simultanément les surfaces à grande vitesse (jusqu'à 63 kHz) de plusieurs sources de scènes en utilisant une caméra « lente » (130 FPS) Vibration , et ce, en capturant les vibrations provoquées par la source audio.

Ainsi, divers besoins tels que la séparation des instruments de musique et l'élimination du bruit peuvent être réalisés.

Lien papier : https://openaccess.thecvf.com/content/CVPR2022/papers/Sheinin_Dual-Shutter_Optical_Vibration_Sensing_CVPR_2022_paper.pdf

Adresse du projet : https://imagerie.cs.cmu .edu/vibration/

Explication vidéo : https://youtu.be/n1M8ZVspJcs

Courte analyse : https://www.louisbouchard.ai/cvpr-2022-best -paper/

Make-A-Scene : génération de texte en image basée sur une scène avec des priorités humaines

Make-A-Scene n'est pas seulement "un autre DALL·E".

Bien que ce soit vraiment cool que DALL·E puisse générer des images aléatoires basées sur des invites textuelles, cela limite également le contrôle de l'utilisateur sur les résultats générés.

L'objectif de Meta est de promouvoir l'expression créative, en combinant cette tendance du texte à l'image avec le modèle précédent de l'esquisse à l'image, ce qui donne naissance à « Make-A-Scene » : un pont entre le texte et la génération d'images conditionnées par un croquis. .Un merveilleux mélange.

Lien papier : https://arxiv.org/abs/2203.13131

Explication vidéo : https://youtu.be/K3bZXXjW788

Courte analyse : https://www.louisbouchard.ai/make-a-scene/

BANMo : À partir de n'importe quelle vidéo un modèle d'animation 3D cible

Sur la base de cette recherche de Meta, il vous suffit de donner n'importe quelle vidéo qui capture des objets déformables, comme le téléchargement de plusieurs vidéos de chatons et de chiots, et BANMo peut les combiner à partir de milliers d'images 2D. intégré dans un espace canonique pour reconstruire un modèle 3D animé modifiable sans avoir besoin de modèles de forme prédéfinis.

Lien papier : https://arxiv.org/abs/2112.12761

Adresse du projet : https://github.com/facebookresearch/banmo

Explication vidéo : https://youtu.be/jDTy-liFoCQ

Analyse courte : https://www.louisbouchard.ai/banmo/

Utilisation d'un modèle de diffusion latente pour la synthèse d'images haute résolution

Les modèles de génération d'images populaires de cette année, DALL·E, Imagen et Stable Diffusion, qui font sensation, qu'ont en commun ces puissants modèles de génération d'images ? Outre leur coût de calcul élevé et leur temps de formation important, ils reposent tous sur le même mécanisme de diffusion.

Les modèles de diffusion ont récemment obtenu des résultats SOTA dans la plupart des tâches d'image, y compris la conversion texte-image à l'aide de DALL·E, et de nombreuses autres tâches liées à la génération d'images telles que l'inpainting d'image, le transfert de style ou la super-résolution d'image.

Lien papier : https://arxiv.org/abs/2112.10752

Adresse du projet : https://github.com/CompVis/latent-diffusion

Explication vidéo : https://youtu.be/RGBNdD3Wn-g

Analyse courte : https://www.louisbouchard.ai/latent-diffusion-models/

PSG : Génération d'images basées sur la scène Model

AI peut vous aider à identifier avec précision des objets dans des images, mais comprendre la relation entre les objets et l'environnement n'est pas si facile.

À cette fin, des chercheurs de Nanyang Polytechnic ont proposé une tâche de génération de graphiques de scène panoptique (PSG) basée sur la segmentation panoramique.

Par rapport à la génération traditionnelle de graphiques de scène basée sur des images de détection, la tâche PSG nécessite de générer de manière complète toutes les relations dans l'image (y compris la relation entre les objets et les objets, la relation entre les objets et l'arrière-plan et la relation entre l'arrière-plan et l'arrière-plan) , et en utilisant des blocs de segmentation précis pour localiser les objets.

Lien papier : https://arxiv.org/abs/2207.11247

Adresse du projet : https://psgdataset.org/

Candidature en ligne : https : //huggingface.co/spaces/ECCV2022/PSG

Explication vidéo : https://youtu.be/cSsE_H_0Cr8

Courte analyse : https://www.louisbouchard.ai /psg/

Utilisez l'inversion de texte pour obtenir une génération personnalisée de texte en image

Les modèles de génération d'images des grands fabricants cette année peuvent être considérés comme les Huit Immortels traversant la mer, chacun montrant ses pouvoirs magiques, mais comment faire en sorte que le modèle génère des œuvres d'image d'un style spécifique ?

Des chercheurs de l'Université de Tel Aviv et NVIDIA ont collaboré pour lancer un modèle de génération d'images personnalisé qui permet de créer les images que vous souhaitez.

Lien papier : https://arxiv.org/abs/2208.01618

Adresse du projet : https://textual-inversion.github.io/

Explication vidéo : https://youtu.be/f3oXa7_SYek

Courte analyse : https://www.louisbouchard.ai/imageworthoneword/

Modèle de pré-entraînement d'image linguistique pour la reconnaissance vidéo générale

L'apprentissage de modèles de textes visuels a sans aucun doute connu un grand succès, mais comment étendre cette nouvelle méthode de pré-formation linguistique en image au domaine vidéo reste une question ouverte.

Des chercheurs de Microsoft et de l'Académie chinoise des sciences ont proposé une méthode simple et efficace pour adapter directement des modèles langage-image pré-entraînés à la reconnaissance vidéo, plutôt que de pré-entraîner de nouveaux modèles à partir de zéro.

Lien papier : https://arxiv.org/abs/2208.02816

Adresse du projet : https://github.com/microsoft/VideoX/tree/master/X-CLIP

Explication vidéo : https://youtu.be/seb4lmVPEe8

Courte analyse : https://www.louisbouchard.ai/general-video-recognition/

Make-A-Video : Modèle vidéo de génération de texte en un clic

Le peintre peut peindre librement sur la toile Avec une image aussi claire et fluide, pouvez-vous penser que chaque image de la vidéo est générée par l'IA ?

Make-A-Video lancé par MetaAI peut générer des vidéos de styles différents en quelques secondes en saisissant simplement quelques mots. Il n'est pas exagéré de l'appeler la "version vidéo de DALL·E".

Lien papier : https://arxiv.org/abs/2209.14792

Explication vidéo : https://youtu.be/MWwESVyHWto

bref Analyse de l'histoire : https://www.louisbouchard.ai/make-a-video/

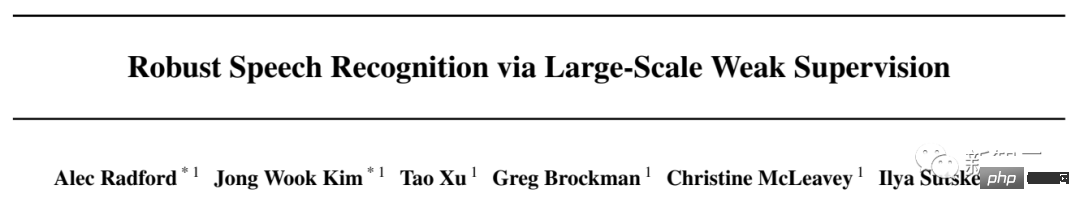

Whisper : Modèle de reconnaissance vocale faiblement supervisé à grande échelle

Avez-vous déjà pensé à un logiciel de traduction capable de traduire rapidement le discours dans la vidéo ? , même ces langues que vous ne comprenez pas vous-même ?

Whisper open source d’OpenAI peut faire exactement cela.

Whisper a été formé sur plus de 680 000 heures de données multilingues. Il peut reconnaître les sons multilingues dans des environnements bruyants et les convertir en texte.

Lien papier : https://arxiv.org/abs/2212.04356

Adresse du projet : https://github.com/openai/whisper

Explication vidéo : https://youtu.be/uFOkMme19Zs

Courte analyse : https://www.louisbouchard.ai/whisper/

DreamFusion : Utilisez des images 2D pour générer Modèle 3D

Le texte peut générer des images, des vidéos et des modèles 3D~

DreamFusion lancé par Google peut générer des modèles 3D en un seul clic en utilisant un modèle de diffusion texte-image 2D pré-entraîné sur des milliards de paires image-texte Les modèles de diffusion entraînés sont à l'origine de percées récentes dans la synthèse de modèles texte en 3D.

Lien papier : https://arxiv.org/abs/2209.14988

Explication vidéo : https://youtu.be/epuU0VRIcjE

bref Analyse de l'histoire : https://www.louisbouchard.ai/dreamfusion/

Imagic : Une véritable méthode d'édition d'images basée sur le modèle de diffusion

En utilisant des modèles de génération d'images texte tels que DALL·E, vous pouvez obtenir l'image souhaitée image en saisissant simplement une ligne de texte Mais les images générées par l’IA ne sont parfois pas si parfaites.

Des chercheurs de Google, de l'Institut israélien de technologie et de l'Institut des sciences Weizmann ont introduit une véritable méthode d'édition d'images basée sur le modèle de diffusion - Imagic, qui peut réaliser des PS de vraies photos en utilisant uniquement du texte.

Par exemple, nous pouvons changer la pose et la composition d'une personne tout en conservant ses caractéristiques d'origine, ou je veux qu'un chien debout s'assoie et qu'un oiseau déploie ses ailes.

Lien papier : https://arxiv.org/abs/2210.09276

Adresse du projet : https://imagic-editing.github.io/

Vidéo Explication : https://youtu.be/gbpPQ5kVJhM

Analyse courte : https://www.louisbouchard.ai/imagic/

eDiffi : modèle de synthèse d'image texte de meilleure qualité

que DALL· Les modèles de synthèse d'image plus puissants de E et Stable Diffusion sont là !

Il s'agit de l'eDiffi de NVIDIA, qui peut générer des images de meilleure qualité avec plus de précision. De plus, l'ajout de modèles de pinceaux peut ajouter plus de créativité et de flexibilité à vos travaux.

Lien papier : https://arxiv.org/abs/2211.01324

Adresse du projet : https://deepimagination.cc/eDiff-I/

Explication vidéo : https://youtu.be/grwp-ht_ixo

Courte analyse : https://www.louisbouchard.ai/ediffi/

Infinite Nature : Apprendre à partir d'une seule image Infini visualiser la génération de scènes naturelles

Avez-vous déjà pensé à prendre une photo puis à voler dans l'image comme si vous ouvriez une porte ?

Des chercheurs de Google et de l'Université Cornell ont transformé cette imagination en réalité. Il s'agit d'InfiniteNature-Zero, qui peut générer des vues illimitées de scènes naturelles à partir d'une seule image.

Lien papier : https://arxiv.org/abs/2207.11148

Adresse du projet : https://infinite-nature.github.io/

Explication vidéo : https://youtu.be/FQzGhukV-l0

Analyse courte : https://www.louisbouchard.ai/infinitenature-zero

Galactica : le grand langage de la science Modèle

Galactica développé par Meta est un grand modèle de langage comparable en taille à GPT-3, mais son domaine d'expertise est la connaissance scientifique.

Le modèle peut rédiger des livres blancs gouvernementaux, des revues de presse, des pages Wikipédia et du code, il sait également citer et écrire des équations. C’est un gros problème pour l’intelligence artificielle et la science.

Lien papier : https://arxiv.org/abs/2211.09085

Explication vidéo : https://youtu.be/2GfxkCWWzLU

bref Analyse de l'histoire : https://www.louisbouchard.ai/galactica/

RAD-NeRF : Modèle de synthèse de portrait en temps réel basé sur la décomposition spatiale audio

Depuis l'émergence de DeepFake et NeRF, l'IA semble changer de visage être devenu monnaie courante. Mais il y a un problème. Les visages remplacés par l’IA révèlent parfois leurs secrets car ils ne correspondent pas à la forme de la bouche.

L'émergence de RAD-NeRF peut résoudre ce problème. Il peut effectuer une synthèse de portrait en temps réel des locuteurs apparaissant dans la vidéo et prend également en charge les avatars personnalisés.

Lien papier : https://arxiv.org/abs/2211.12368

Adresse du projet : https://me.kiui.moe/radnerf/

Vidéo Comment Le travail à succès de l'IA de l'année pourrait-il se faire sans ChatGPT ? Celui-ci est devenu populaire partout sur Internet et a été développé par des internautes pour écrire des articles pornographiques, du code et d'autres applications. Si vous ne le savez pas encore, venez vite ici. jetez un oeil!

Explication vidéo : https://youtu.be/AsFgn8vU-tQ

Courte analyse : https://www.louisbouchard.ai/chatgpt/

Bien que les modèles de vision par ordinateur actuels puissent générer l'âge du visage, le transfert de style, etc., cela n'a qu'une apparence cool et n'a presque aucun effet dans les applications réelles. La technologie existante souffre généralement de perte et de discrimination des caractéristiques du visage. dans les images vidéo suivantes nécessite souvent un montage secondaire manuel.

Récemment, Disney a publié la première méthode pratique et entièrement automatisée pour régénérer les visages dans les images vidéo destinées à la production, FRAN (Face Re-Aging Network), annonçant officiellement le besoin de maquilleurs dans les films. La technologie qui change l'âge des acteurs visuellement a pris fin.

Lien papier : https://dl.acm.org/doi/pdf/10.1145/3550454.3555520

Adresse du projet : https://studios.disneyresearch.com/2022/11 /30/production-ready-face-re-aging-for-visual-effects/

Explication vidéo : https://youtu.be/WC03N0NFfwk

Courte analyse : https ://www.louisbouchard.ai/disney-re-age/

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Quelle méthode est utilisée pour convertir les chaînes en objets dans vue.js?

Apr 07, 2025 pm 09:39 PM

Quelle méthode est utilisée pour convertir les chaînes en objets dans vue.js?

Apr 07, 2025 pm 09:39 PM

Lors de la conversion des chaînes en objets dans vue.js, JSON.Parse () est préféré pour les chaînes JSON standard. Pour les chaînes JSON non standard, la chaîne peut être traitée en utilisant des expressions régulières et réduisez les méthodes en fonction du format ou du codé décodé par URL. Sélectionnez la méthode appropriée en fonction du format de chaîne et faites attention aux problèmes de sécurité et d'encodage pour éviter les bogues.

Les ingénieurs de backend senior à distance (plates-formes) ont besoin de cercles

Apr 08, 2025 pm 12:27 PM

Les ingénieurs de backend senior à distance (plates-formes) ont besoin de cercles

Apr 08, 2025 pm 12:27 PM

Ingénieur backend à distance Emploi Vacant Société: Emplacement du cercle: Bureau à distance Type d'emploi: Salaire à temps plein: 130 000 $ - 140 000 $ Description du poste Participez à la recherche et au développement des applications mobiles Circle et des fonctionnalités publiques liées à l'API couvrant l'intégralité du cycle de vie de développement logiciel. Les principales responsabilités complètent indépendamment les travaux de développement basés sur RubyOnRails et collaborent avec l'équipe frontale React / Redux / Relay. Créez les fonctionnalités de base et les améliorations des applications Web et travaillez en étroite collaboration avec les concepteurs et le leadership tout au long du processus de conception fonctionnelle. Promouvoir les processus de développement positifs et hiérarchiser la vitesse d'itération. Nécessite plus de 6 ans de backend d'applications Web complexe

Vue.js Comment convertir un tableau de type de chaîne en un tableau d'objets?

Apr 07, 2025 pm 09:36 PM

Vue.js Comment convertir un tableau de type de chaîne en un tableau d'objets?

Apr 07, 2025 pm 09:36 PM

Résumé: Il existe les méthodes suivantes pour convertir les tableaux de chaîne Vue.js en tableaux d'objets: Méthode de base: utilisez la fonction de carte pour convenir à des données formatées régulières. Gameplay avancé: l'utilisation d'expressions régulières peut gérer des formats complexes, mais ils doivent être soigneusement écrits et considérés. Optimisation des performances: Considérant la grande quantité de données, des opérations asynchrones ou des bibliothèques efficaces de traitement des données peuvent être utilisées. MEILLEUR PRATIQUE: Effacer le style de code, utilisez des noms de variables significatifs et des commentaires pour garder le code concis.

Comment utiliser MySQL après l'installation

Apr 08, 2025 am 11:48 AM

Comment utiliser MySQL après l'installation

Apr 08, 2025 am 11:48 AM

L'article présente le fonctionnement de la base de données MySQL. Tout d'abord, vous devez installer un client MySQL, tel que MySQLWorkBench ou le client de ligne de commande. 1. Utilisez la commande MySQL-UROot-P pour vous connecter au serveur et connecter avec le mot de passe du compte racine; 2. Utilisez Createdatabase pour créer une base de données et utilisez Sélectionner une base de données; 3. Utilisez CreateTable pour créer une table, définissez des champs et des types de données; 4. Utilisez InsertInto pour insérer des données, remettre en question les données, mettre à jour les données par mise à jour et supprimer les données par Supprimer. Ce n'est qu'en maîtrisant ces étapes, en apprenant à faire face à des problèmes courants et à l'optimisation des performances de la base de données que vous pouvez utiliser efficacement MySQL.

Géospatial de Laravel: optimisation des cartes interactives et de grandes quantités de données

Apr 08, 2025 pm 12:24 PM

Géospatial de Laravel: optimisation des cartes interactives et de grandes quantités de données

Apr 08, 2025 pm 12:24 PM

Traiter efficacement 7 millions d'enregistrements et créer des cartes interactives avec la technologie géospatiale. Cet article explore comment traiter efficacement plus de 7 millions d'enregistrements en utilisant Laravel et MySQL et les convertir en visualisations de cartes interactives. Exigences initiales du projet de défi: extraire des informations précieuses en utilisant 7 millions d'enregistrements dans la base de données MySQL. Beaucoup de gens considèrent d'abord les langages de programmation, mais ignorent la base de données elle-même: peut-il répondre aux besoins? La migration des données ou l'ajustement structurel est-il requis? MySQL peut-il résister à une charge de données aussi importante? Analyse préliminaire: les filtres et les propriétés clés doivent être identifiés. Après analyse, il a été constaté que seuls quelques attributs étaient liés à la solution. Nous avons vérifié la faisabilité du filtre et établi certaines restrictions pour optimiser la recherche. Recherche de cartes basée sur la ville

Vue et Element-UI Cascade déroulante Boîte en V Mode en V

Apr 07, 2025 pm 08:06 PM

Vue et Element-UI Cascade déroulante Boîte en V Mode en V

Apr 07, 2025 pm 08:06 PM

Vue et Element-UI Boîtes déroulantes en cascade Points de fosse de liaison V-model: V-model lie un tableau représentant les valeurs sélectionnées à chaque niveau de la boîte de sélection en cascade, pas une chaîne; La valeur initiale de SelectOptions doit être un tableau vide, non nul ou non défini; Le chargement dynamique des données nécessite l'utilisation de compétences de programmation asynchrones pour gérer les mises à jour des données en asynchrone; Pour les énormes ensembles de données, les techniques d'optimisation des performances telles que le défilement virtuel et le chargement paresseux doivent être prises en compte.

Comment optimiser les performances de la base de données après l'installation de MySQL

Apr 08, 2025 am 11:36 AM

Comment optimiser les performances de la base de données après l'installation de MySQL

Apr 08, 2025 am 11:36 AM

L'optimisation des performances MySQL doit commencer à partir de trois aspects: configuration d'installation, indexation et optimisation des requêtes, surveillance et réglage. 1. Après l'installation, vous devez ajuster le fichier my.cnf en fonction de la configuration du serveur, tel que le paramètre innodb_buffer_pool_size, et fermer query_cache_size; 2. Créez un index approprié pour éviter les index excessifs et optimiser les instructions de requête, telles que l'utilisation de la commande Explication pour analyser le plan d'exécution; 3. Utilisez le propre outil de surveillance de MySQL (ShowProcessList, Showstatus) pour surveiller la santé de la base de données, et sauvegarde régulièrement et organisez la base de données. Ce n'est qu'en optimisant en continu ces étapes que les performances de la base de données MySQL peuvent être améliorées.

Comment résoudre MySQL ne peut pas être démarré

Apr 08, 2025 pm 02:21 PM

Comment résoudre MySQL ne peut pas être démarré

Apr 08, 2025 pm 02:21 PM

Il existe de nombreuses raisons pour lesquelles la startup MySQL échoue, et elle peut être diagnostiquée en vérifiant le journal des erreurs. Les causes courantes incluent les conflits de port (vérifier l'occupation du port et la configuration de modification), les problèmes d'autorisation (vérifier le service exécutant les autorisations des utilisateurs), les erreurs de fichier de configuration (vérifier les paramètres des paramètres), la corruption du répertoire de données (restaurer les données ou reconstruire l'espace de la table), les problèmes d'espace de la table InNODB (vérifier les fichiers IBDATA1), la défaillance du chargement du plug-in (vérification du journal des erreurs). Lors de la résolution de problèmes, vous devez les analyser en fonction du journal d'erreur, trouver la cause profonde du problème et développer l'habitude de sauvegarder régulièrement les données pour prévenir et résoudre des problèmes.