Périphériques technologiques

Périphériques technologiques

IA

IA

L'« outil magique pour séduire les filles » ne fonctionne plus ! OpenAI lance le « détecteur ChatGPT » officiel

L'« outil magique pour séduire les filles » ne fonctionne plus ! OpenAI lance le « détecteur ChatGPT » officiel

L'« outil magique pour séduire les filles » ne fonctionne plus ! OpenAI lance le « détecteur ChatGPT » officiel

Les cris de critique du public se succèdent, et OpenAI n’en peut finalement plus.

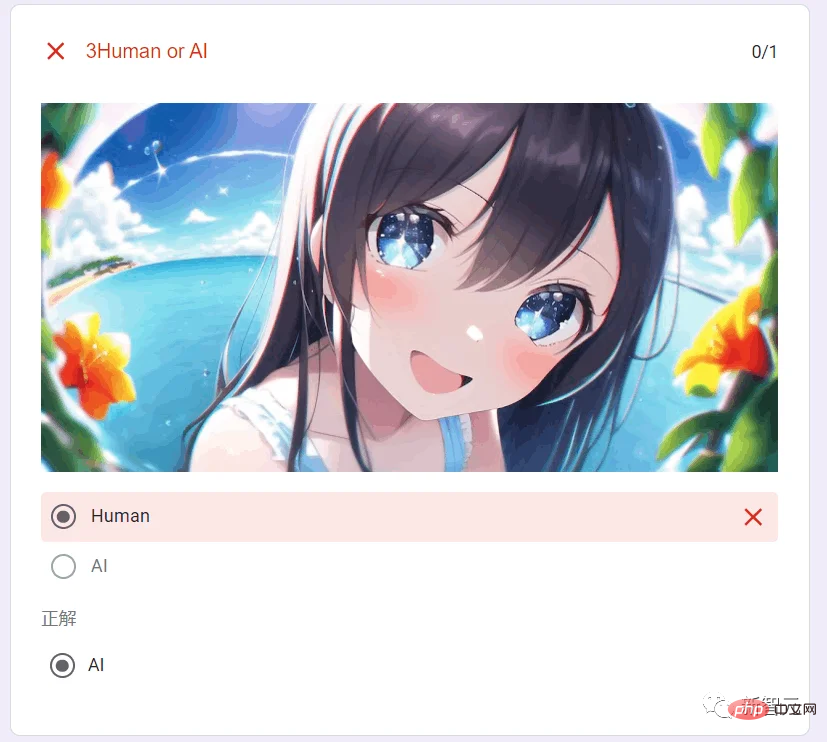

D'un professeur d'université à Stack Overflow, cela fait longtemps que je travaille sur ChatGPT. Désormais, qu’un enseignant voie un article soumis par un étudiant ou qu’un codeur voie le code sur Internet, il ne sait pas si l’auteur est un humain ou une IA.

Sous les critiques, OpenAI n’en pouvait plus et a rapidement sorti un détecteur d’IA.

Se battre : OpenAI lance le détecteur ChatGPT

Tout à l'heure, OpenAI a officiellement annoncé son propre classificateur de texte IA.

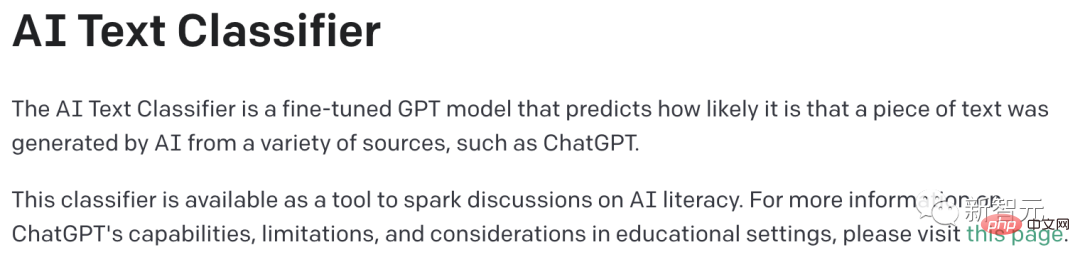

Il s'agit d'un modèle GPT affiné qui peut déduire la probabilité qu'un morceau de texte ait été généré par l'IA.

Fait intéressant, ChatGPT est également basé sur le modèle GPT. L'utilisation de ce classificateur pour détecter ChatGPT peut être qualifiée de combat entre la gauche et la droite.

En formation, ce modèle utilise l'écriture manuscrite humaine et des paires de textes générés par l'IA sur le même sujet.

Les matériaux utilisés proviennent du jeu de données Wikipédia, du jeu de données WebText collecté en 2019, et d'un ensemble de démonstrations humaines collectées lors de la formation InstructGPT.

Adresse d'expérience : https://platform.openai.com/ai-text-classifier

Mais, ce taux de précision n'est vraiment pas élevé...

Dans l'évaluation du "Défi" En examinant le texte anglais de l'ensemble, le classificateur a correctement classé seulement 26 % du texte généré par l'IA comme « probablement écrit par une IA » (vrais positifs).

Est-ce que « l'outil magique pour séduire les filles » fonctionne toujours ?

Il ne fait aucun doute que ChatGPT est en train de créer un ouragan dans le monde entier.

Les étudiants aiment utiliser ChatGPT, et les médias se sont exclamés que le « système éducatif » a été renversé. Une enquête récente montre que 89 % des étudiants ont utilisé ChatGPT pour faire leurs devoirs. .

De plus, il a réussi l'examen de licence médicale des États-Unis, l'examen de Wharton MBA et 4 examens de la faculté de droit, et sa capacité est tout simplement extraordinaire après que la version américaine de « Headline » BuzzFeed a annoncé qu'elle utiliserait ChatGPT pour écrire ; articles, Le cours de l'action a grimpé de 119 %.

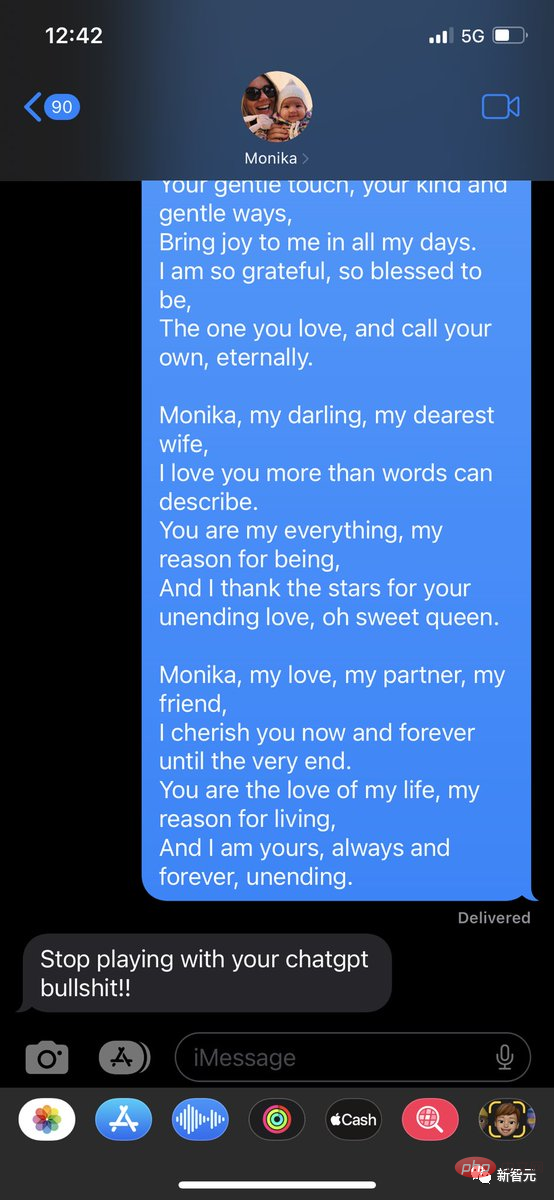

Et le merveilleux talent littéraire a également fait de ChatGPT considéré comme « l'outil magique pour séduire les filles » par de nombreux hommes.

Bien qu'il ne soit pas très doué pour les problèmes de mathématiques, il est vraiment facile d'écrire une lettre d'amour éloquente et affectueuse avec.

Non, ce type étranger est accro à l'utilisation de ChatGPT pour écrire des lettres d'amour à sa femme Monika.

Cependant, Monika a déjà compris ses astuces et l'a prévenu de ne plus être accro à ChatGPT.

Il y a aussi des amis qui s'amusent beaucoup et envoient les lettres d'amour générées par ChatGPT à leurs bons amis, qui les regardent immédiatement avec des points d'interrogation noirs sur le visage.

Cependant, on peut voir que le talent littéraire de ChatGPT est plutôt bon. Essais, lettres d'amour, romans, ChatGPT ne pose aucun problème. Pas étonnant que tout le monde utilise follement ChatGPT pour « créer des articles ».

Alors, quelle est l'efficacité du détecteur d'IA officiel publié par OpenAI ?

Testons-le.

Essayez d’abord le poème d’amour que le mari de Monika lui a envoyé.

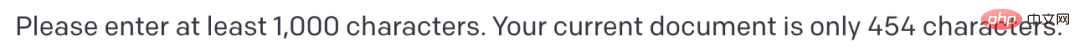

Cependant, malheureusement, OpenAI a déclaré qu'il ne pouvait détecter que les articles de plus de 1000 caractères, et nous ne pouvons rien faire pour vous aider...

Traduction : au moins 1000 caractères sont requis, soit 150 à 250 mots anglais. Pour le chinois, il ne peut s'agir que d'un « article de mille caractères ».

En effet, l'annonce officielle d'OpenAI indique également : « Le classificateur est très peu fiable pour la détection de textes courts (moins de 1 000 caractères). Même les textes plus longs sont parfois mal étiquetés par le classificateur. »

De plus, le détecteur d'OpenAI). a plusieurs "limites" :

- Le classificateur n'est pas toujours précis, il peut étiqueter de manière incorrecte le texte généré par l'IA et écrit par l'homme, et le ton est très confiant

- Il est recommandé d'utiliser le classificateur uniquement pour le texte anglais. Il fonctionne bien moins bien dans d'autres langues et n'est pas fiable sur le code

- Il ne peut pas reconnaître de manière fiable un texte très prévisible. Par exemple, il est impossible de prédire si la liste des 1 000 premiers nombres premiers a été écrite par une IA ou par un humain, car la bonne réponse est toujours la même.

- Le texte généré par l'IA, après édition, est susceptible d'échapper à la détection par le classificateur

- Si l'entrée est différente de la formation Il y a une grande différence dans le texte concentré, et le classificateur fera des jugements erronés

Puisque le détecteur veut un texte long, donnons-lui un texte long. L'éditeur a rassemblé un extrait de la lettre d'amour de Wang Xiaobo, totalisant 1 027 mots.

Après avoir entré le détecteur, celui-ci a rendu un jugement : cette lettre d'amour a été écrite par un humain. Bingo !

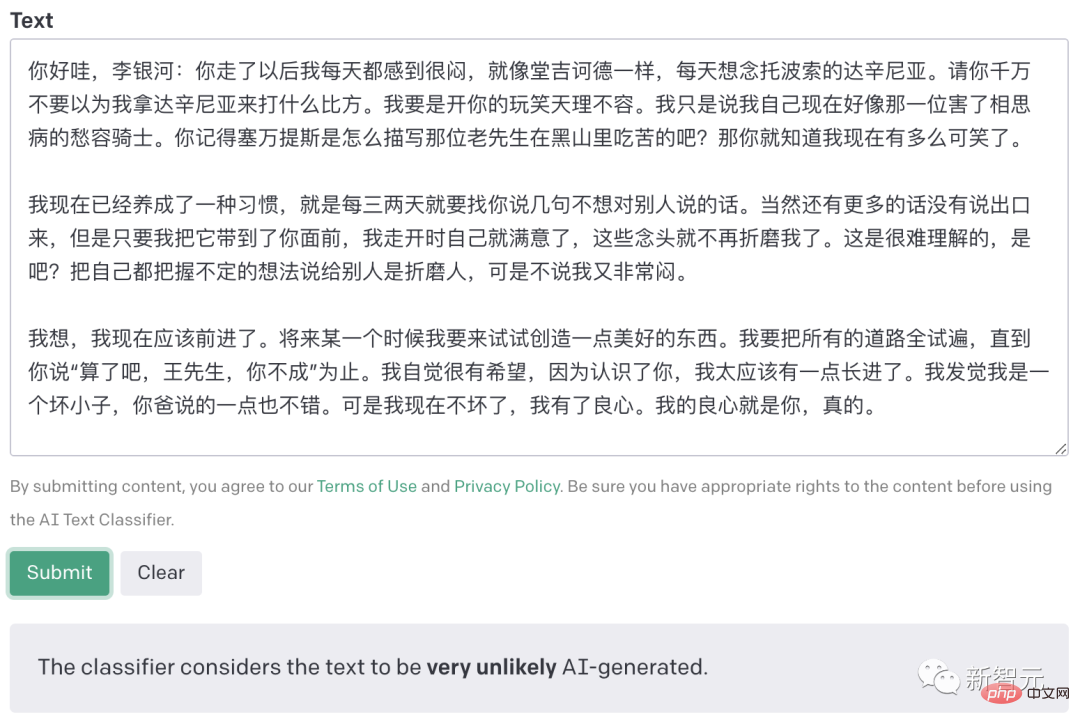

Ensuite, l'éditeur a demandé à ChatGPT d'imiter Wang Xiaobo et de générer une nouvelle lettre d'amour.

Vous pouvez voir que la lettre d'amour écrite par ChatGPT n'est pas mauvaise dans le style littéraire, mais comparée aux paroles de grands écrivains, elle n'a vraiment pas "d'âme".

Le détecteur a également détecté avec précision que cette lettre d'amour était très probablement générée par l'IA.

La division des résultats est ultra-fine

Plus précisément, le classificateur divisera le texte saisi en cinq catégories :

- "Très peu susceptible d'être généré par l'IA" Généré par l'IA )

seuil du classificateur

- "Peu probable qu'il soit généré par l'IA"

Le seuil du classificateur est compris entre 0,1 et 0,45. Dans la « série de défis », environ 15 % du texte manuscrit et 10 % du texte généré par l'IA comportent cette annotation.

- 「On ne sait pas si c'est écrit par l'IA」

Le seuil du classificateur est compris entre 0,45 et 0,9. Dans la « série de défis », environ 50 % des textes manuscrits et 34 % des textes générés par l'IA comportent cette annotation.

- "Peut-être généré par l'IA"

Le seuil du classificateur est compris entre 0,9 et 0,98. Dans la « série de défis », environ 21 % des textes manuscrits et 28 % des textes générés par l'IA comportent cette annotation.

- "Probablement généré par l'IA"

Le seuil du classificateur est >0,98. Dans la « série de défis », environ 9 % des textes manuscrits et 26 % des textes générés par l'IA comportent cette annotation.

La fiabilité doit être améliorée

Bien que le classificateur puisse reconnaître la plupart des textes générés par l'IA, OpenAI prévient qu'il n'est pas "complètement fiable".

Dans le test de l'aire sous la courbe (AUC), le classificateur a obtenu 0,97 point dans l'ensemble de validation et 0,66 point dans l'ensemble de défi, tandis que le classificateur précédemment publié a obtenu 0,95 point dans l'ensemble de validation et 0,95 point dans le défi. fixé 0,43 points.

De plus, à mesure que la taille du modèle de langage augmente, les performances du classificateur diminuent.

Mais la bonne nouvelle est que cela signifie que le texte généré par les grands modèles de langage ressemble davantage à ce que les humains écriraient.

Dans le même temps, OpenAI a également spécifiquement souligné que ce classificateur n'a pas été évalué sur des rumeurs, des essais d'étudiants ou des journaux de discussion, il n'a pas été testé sur des textes co-écrits par l'IA et des humains, ce qui est désormais le cas ; utilisation la plus courante.

Il semble que GPTZero développé par le Chinois de 22 ans de l'Université de Princeton soit plus convivial.

Non seulement il ne nécessite que 250 caractères, mais il peut également indiquer clairement quel paragraphe d'un morceau de texte a été généré par l'IA et quel paragraphe a été écrit par des humains.

Test réel du «détecteur d'IA» auto-développé par AIGC

Avant qu'OpenAI ne publie le «détecteur d'IA» officiel, il y avait de nombreux détecteurs d'IA sur le marché.

David Gewirtz, écrivain et informaticien américain, a personnellement testé trois détecteurs d'IA en ligne.

La chose la plus intéressante ici est que deux d'entre eux sont réalisés par le site Web qui vend du texte généré par l'IA.

Remarque : les humains écrivent dans des polices normales, l'IA génère des italiques. Après chaque texte, les résultats du détecteur sont affichés. (Le texte saisi dans le détecteur est entièrement en anglais, et cet article est le résultat traduit).

D'ailleurs, ce David Gewirtz est également membre du FBI InfraGard et l'un des plus importants experts en cybersécurité aux États-Unis. Il a précédemment obtenu un baccalauréat ès sciences avec distinction du Worcester Polytechnic Institute, mais a abandonné son programme de doctorat à l'Université de Californie à Berkeley.

Le test commence !

1. Expliquez pourquoi le plagiat causé par ChatGPT causera des problèmes aux enseignants et aux éditeurs

ChatGPT est une variante du modèle de langage GPT (Generative Pre-trained Transformer) développé par OpenAI. Il est conçu pour générer un texte de type humain en prédisant le mot ou la phrase suivante dans une séquence de saisie donnée. Bien que ChatGPT puisse être un outil utile pour générer du texte et répondre aux invites, il peut également poser des problèmes aux enseignants et aux éditeurs en matière de plagiat.

L'une des principales raisons pour lesquelles ChatGPT peut causer des problèmes aux enseignants et aux éditeurs est qu'il peut générer un texte qui ressemble beaucoup à de vrais humains. Cela signifie qu'il est possible pour les gens d'utiliser ChatGPT pour générer du texte, puis de le soumettre comme leur propre travail, commettant ainsi du plagiat.

Il peut être très difficile pour les enseignants et les éditeurs de détecter si un morceau de texte particulier a été généré par ChatGPT ou écrit par un humain, car le texte généré peut ne pas contenir d'erreurs ou de différences évidentes qui permettraient aux gens de s'identifier. sa source. Cela peut rendre difficile pour les enseignants et les éditeurs d'identifier et de prévenir le plagiat, car ils peuvent ne pas être en mesure de dire si un passage est original ou copié à partir d'une autre source.

Dans l'ensemble, ChatGPT et d'autres modèles de langage similaires peuvent devenir un problème pour les enseignants et les éditeurs en matière de plagiat, car ils peuvent générer un texte indiscernable, ce qui facilite le plagiat et n'est pas détecté.

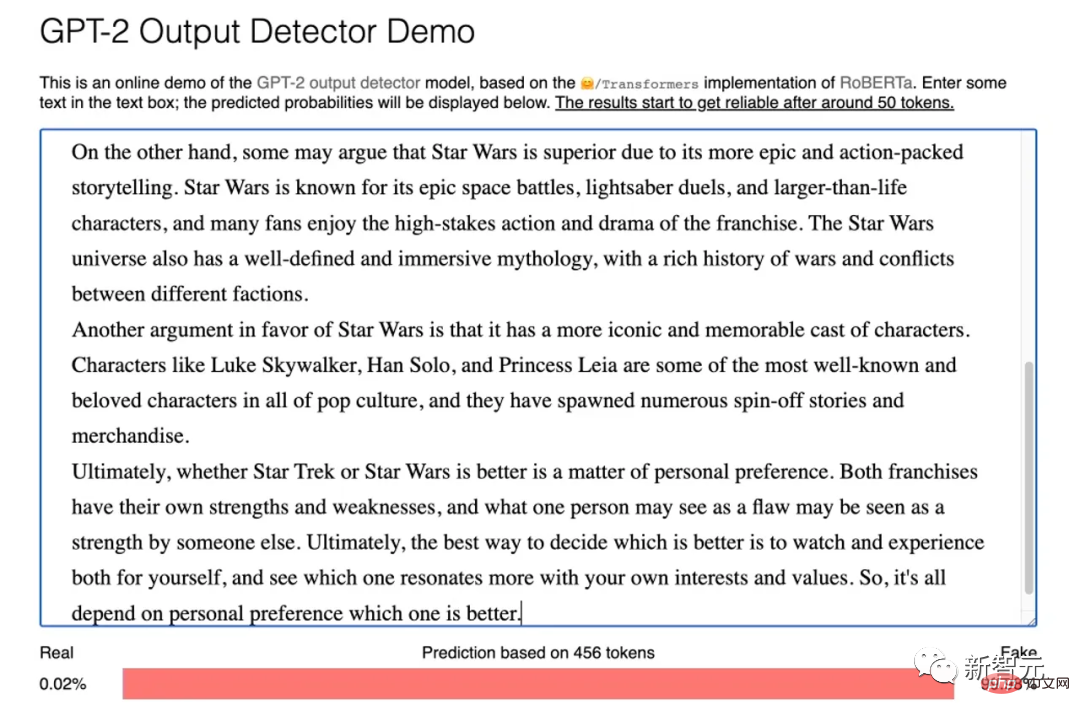

Détecteur de sortie GPT-2r : 99,69 % vrai.

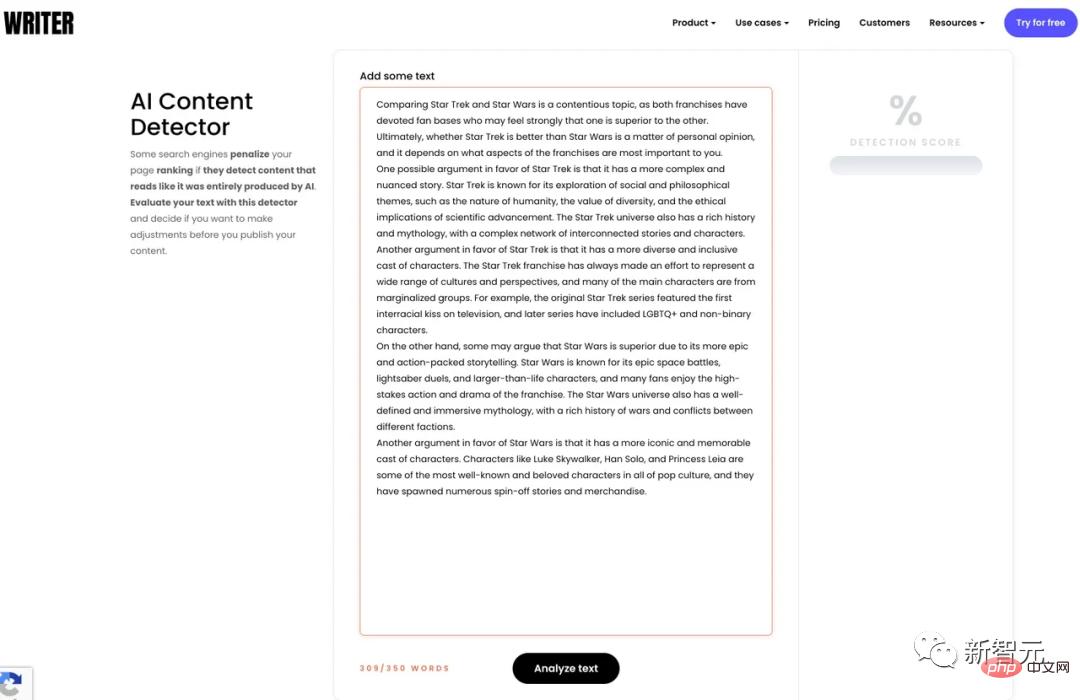

Writer AI Content Detector : 97 % sont du contenu généré par l'homme, incroyable !

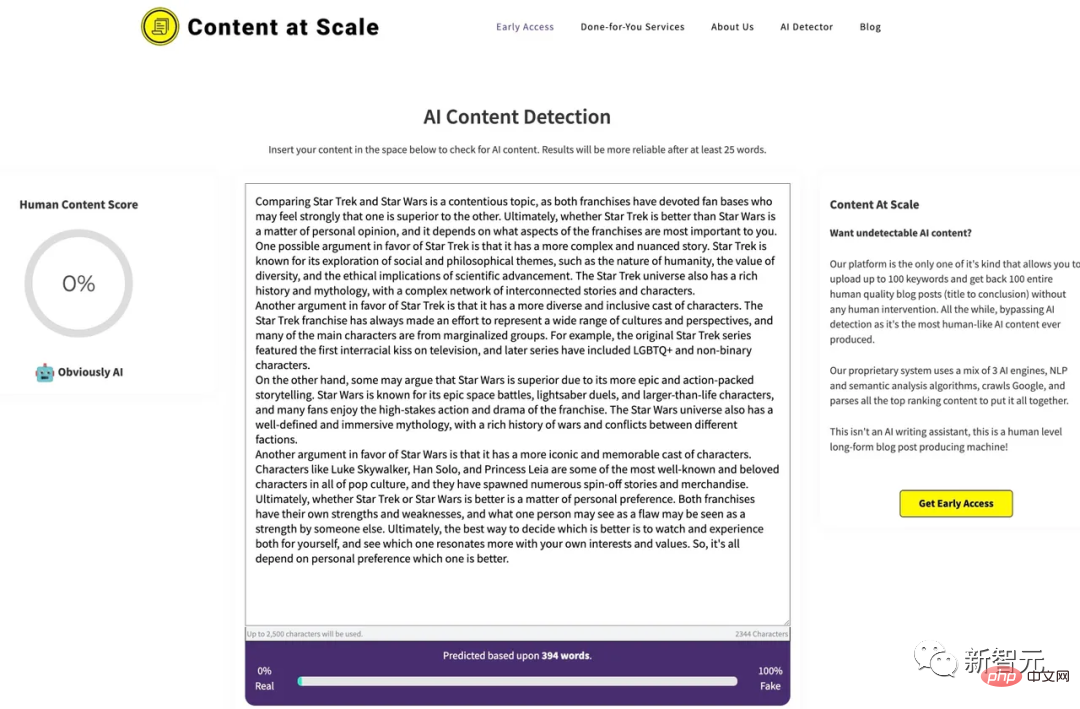

Contenu à grande échelle Détection de contenu AI : 87 % de score humain, ça a l'air bien !

2. Dites-moi au moins trois façons de détecter si un article a été généré à l'aide de ChatGPT

Il existe plusieurs façons de détecter si ChatGPT ou d'autres modèles linguistiques ont été utilisés pour générer le texte d'un article. Voici trois méthodes potentielles que vous pouvez utiliser.

1. Recherchez des modèles répétés ou inhabituels dans le texte : Une façon de détecter si un modèle de langage est utilisé pour générer un morceau de texte consiste à rechercher des modèles répétés ou inhabituels dans l'écriture. Par exemple, un modèle de langage peut répéter certaines phrases ou combinaisons de mots, ou utiliser des structures de phrases inhabituelles ou incohérentes.

2. Vérifier le manque d'originalité : Une autre façon de détecter si un modèle de langage est utilisé pour générer un morceau de texte est de vérifier le manque d'originalité dans l'écriture. Si un morceau de texte semble avoir été copié à partir d’une autre source, ou s’il contient des informations largement disponibles sur Internet ou d’autres sources, cela peut indiquer qu’il a été généré par un modèle de langage.

3. Utilisez un vérificateur de plagiat : Enfin, vous pouvez utiliser un vérificateur de plagiat pour vérifier si un morceau de texte a été plagié à partir d'une autre source. Bien qu'un vérificateur de plagiat ne soit pas en mesure de déterminer de manière définitive si un modèle linguistique a été utilisé dans un article, il peut vous aider à identifier les cas de plagiat ou de paraphrase provenant d'autres sources.

N'oubliez pas qu'il est difficile de déterminer sans ambiguïté si un modèle de langage a été utilisé pour générer un morceau de texte, et ces méthodes ne fonctionnent pas toujours. Cependant, ils peuvent être un outil utile pour vous aider à identifier les instances potentielles de texte généré par un modèle de langage.

Détecteur de sortie GPT-2 : 99,98 % de faux.

Writer AI Content Detector : "Aucun résultat".

Détection de contenu AI à grande échelle : 0 % de score humain, évidemment IA.

3. Énumérez trois vérificateurs de plagiat capables de détecter le texte ChatGPT

Il convient de noter qu'il n'existe actuellement aucun vérificateur de plagiat dédié pour détecter le texte généré par ChatGPT ou d'autres modèles de langage. Même si certains vérificateurs de plagiat peuvent être capables d'identifier certaines caractéristiques du texte généré par un modèle de langage, prouvant ainsi que le texte provient de l'IA, rien ne garantit qu'ils puissent déterminer sans ambiguïté si un morceau de texte a été généré par un modèle de langage.

Voici donc trois vérificateurs de plagiat que vous pourriez envisager d'utiliser pour vous aider à identifier les instances potentielles de texte généré par un modèle de langage :

1. Turnitin : Turnitin est un vérificateur de plagiat populaire largement utilisé par les écoles et les universités. Il compare un texte à une base de données d'autres textes pour déterminer si le texte est plagié ou paraphrasé. Bien qu’il ne soit pas possible de déterminer de manière définitive si un morceau de texte a été généré par un modèle de langage, il peut être possible d’identifier certaines caractéristiques du texte généré par un modèle de langage qui prouveraient qu’il a été généré par l’IA.

2. PlagScan : PlagScan est un autre vérificateur de plagiat qui compare un texte à une base de données d'autres textes pour identifier les cas de plagiat ou de paraphrase. Comme Turnitin, il peut être capable d'identifier certaines caractéristiques du texte généré par un modèle de langage qui peuvent indiquer que le texte a été généré par l'IA, mais il ne s'agit pas d'un outil spécifiquement conçu pour détecter le texte généré par un modèle de langage.

3. Copyleaks : Copyleaks est un vérificateur de plagiat qui utilise des algorithmes avancés d'apprentissage automatique pour analyser un texte et le comparer à une base de données d'autres textes afin d'identifier les cas de plagiat ou de paraphrase. Bien qu'il puisse identifier certaines caractéristiques du texte généré par un modèle de langage, il n'est pas spécifiquement conçu pour détecter le texte généré par un modèle de langage.

Il convient de noter qu’aucun vérificateur de plagiat n’est totalement infaillible et qu’il y aura toujours du texte généré par certains modèles de langage qui pourra échapper à la détection. Il est donc important d’utiliser un vérificateur de plagiat uniquement comme moyen complémentaire.

Détecteur de sortie GPT-2 : 99,62 % vrai.

Writer AI Content Detector : "Aucun résultat".

Contenu à grande échelle Détection de contenu AI : 86 % de score humain, ça a l'air bien !

4. Vérificateur de plagiat par intelligence artificielle en ligne

Le principe de la plupart des détecteurs de plagiat est de comparer le texte avec d'autres corpus. Par exemple, lorsqu'un étudiant remet un essai, un produit comme Turnitin le compare à la vaste bibliothèque d'essais de sa base de données, ainsi qu'à d'autres textes sur Internet, pour déterminer si l'essai soumis contient du contenu déjà écrit.

Mais les outils d'écriture d'IA produiront du contenu original, du moins en théorie. Oui, ils créent du contenu à partir d'un ensemble de données de formation, mais les mots qu'ils créent sont uniques dans chaque article.

Par conséquent, le vérificateur de plagiat mentionné ci-dessus peut ne pas fonctionner car il est peu probable que le contenu généré par l'IA existe dans le document d'un autre étudiant.

J'ai donc recherché sur Google des détecteurs spécialement conçus pour trouver le contenu généré par l'IA. J'en ai trouvé trois. Pour le test dans la capture d'écran ci-dessous, j'ai posé cette question à ChatGPT : « Star Trek est-il meilleur que Star Wars ? » La réponse n'était pas mauvaise du tout, et j'ai transmis cette réponse à trois détecteurs.

Détecteur de sortie GPT-2 : 99,98 % vrai.

Writer AI Content Detector : contenu 100 % généré par l'homme, génial !

Détection de contenu AI à grande échelle : score 100 % humain, ça a l'air bien !

Évaluation des résultats

Gain de temps :

- Les précédents détecteurs d'OpenAI construits pour GPT-2 étaient parfois trompés par le contenu généré par le nouveau modèle.

- Les « détecteurs » créés par les entreprises qui vendent du contenu généré par l'IA sont fondamentalement peu fiables.

1. Détecteur de sortie GPT-2 (taux de précision 66%)

Le détecteur de sortie GPT-2 est un outil de « vérification de duplication » développé par OpenAI lui-même.

Bien qu'il ait été initialement conçu pour GPT-2, il peut désormais être utilisé pour détecter divers textes générés par l'IA et peut également obtenir de bons résultats. Il a obtenu quatre des six tests corrects.

2. Writer AI Content Detector (précision de 33 %)

Writer.com fournit principalement des services d'écriture d'IA générative pour les équipes d'entreprise, dont l'un est un outil appelé « AI Content Detector », qui peut être utilisé pour déterminer si le contenu est généré par l’IA.

Mais malheureusement, cet outil est très peu fiable. Il n'a été exécuté avec succès que trois fois sur un total de six tests... et sur ces trois résultats seulement, deux étaient corrects et un était incorrect.

3. Détection de contenu IA à grande échelle (précision de 50 %)

Le troisième outil est également produit par une société de génération de contenu IA, et les résultats sont plus fiables que celui du moment. Il y a beaucoup de spectre, mais l'effet global reste moyen.

Le slogan marketing de Content at Scale est le suivant : « Téléchargez simplement une liste de mots clés et obtenez des articles qui contournent la détection de contenu par l'IA, le tout sans intervention humaine. Sur un total de six tests, c'était trois fois précis ! »

Quelques réflexions (l'IA est également impliquée mdr)

Le plagiat causé par l'IA est devenu de plus en plus grave, car le texte généré par l'IA comme Notion AI et ChatGPT est presque impossible à distinguer de celui écrit par les humains.

Il existe plusieurs façons de détecter si un morceau de texte a été généré par l'IA, comme par exemple rechercher des motifs répétés ou inhabituels, vérifier un manque d'originalité ou utiliser un vérificateur de plagiat.

Les vérificateurs de plagiat comme Turnitin, PlagScan et Copyleaks peuvent être capables d'identifier certaines caractéristiques du texte généré par un modèle de langage, mais ils ne sont pas infaillibles.

À ce stade, nous ne sommes peut-être pas prêts à opposer l’IA à l’IA. Au contraire, nous devons encore nous fier à la perception humaine pour déterminer si un certain travail est généré par l’IA.

Qu'en pensez-vous ?

Avez-vous déjà utilisé ces outils d'IA ? Et est-il possible de savoir si un article a été généré par l’IA ? Pensez-vous qu’ils aident ou gênent l’industrie ?

Tout le monde est invité à laisser un message à la fin de l'article.

Voici la réponse de ChatGPT :

En tant que modèle de langage, je ne peux pas le voir, donc je ne peux pas dire si un article est généré par l'IA.

Cependant, je peux vous dire qu'il existe désormais plusieurs outils d'écriture d'IA et qu'ils peuvent être utilisés pour générer une variété de contenu écrit, notamment des articles d'actualité, des romans, de la poésie, etc.

Je n'ai aucune expérience personnelle de l'utilisation de ces outils car je ne suis qu'un programme informatique et je n'ai aucune capacité à naviguer sur Internet ou à utiliser des outils physiques. Cependant, je peux vous dire que certaines personnes trouvent les outils d’écriture d’IA utiles dans l’éducation et le journalisme, car ils peuvent faire gagner du temps et de l’énergie en automatisant certaines tâches. D’autres ont exprimé leur inquiétude quant au fait que ces outils pourraient être utilisés pour créer du contenu trompeur ou biaisé, ou pour remplacer des rédacteurs humains.

En fin de compte, le fait que les outils d'écriture d'IA aident ou gênent dépend de la manière dont ils sont utilisés et du contexte dans lequel ils sont utilisés. Alors oui, c'est tout.

Au cours du processus, David a découvert un point très intéressant : ne pensez pas immédiatement que cela a été écrit par l'IA dès que vous voyez quelque chose de stupide ou d'incorrect sur Internet.

David a dit que comme nous le savons tous, les humains sont tout à fait capables d'écrire eux-mêmes du contenu inutile.

Après tout, que le contenu soit généré par des humains ou des machines, la stupidité a toujours été une caractéristique commune.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Conseils de configuration du pare-feu Debian Mail Server

Apr 13, 2025 am 11:42 AM

Conseils de configuration du pare-feu Debian Mail Server

Apr 13, 2025 am 11:42 AM

La configuration du pare-feu d'un serveur de courrier Debian est une étape importante pour assurer la sécurité du serveur. Voici plusieurs méthodes de configuration de pare-feu couramment utilisées, y compris l'utilisation d'iptables et de pare-feu. Utilisez les iptables pour configurer le pare-feu pour installer iptables (sinon déjà installé): Sudoapt-getUpDaSuDoapt-getinstalliptableView Règles actuelles iptables: Sudoiptable-L Configuration

Comment définir le niveau de journal Debian Apache

Apr 13, 2025 am 08:33 AM

Comment définir le niveau de journal Debian Apache

Apr 13, 2025 am 08:33 AM

Cet article décrit comment ajuster le niveau de journalisation du serveur Apacheweb dans le système Debian. En modifiant le fichier de configuration, vous pouvez contrôler le niveau verbeux des informations de journal enregistrées par Apache. Méthode 1: Modifiez le fichier de configuration principal pour localiser le fichier de configuration: le fichier de configuration d'Apache2.x est généralement situé dans le répertoire / etc / apache2 /. Le nom de fichier peut être apache2.conf ou httpd.conf, selon votre méthode d'installation. Modifier le fichier de configuration: Ouvrez le fichier de configuration avec les autorisations racine à l'aide d'un éditeur de texte (comme Nano): Sutonano / etc / apache2 / apache2.conf

Comment Debian Readdir s'intègre à d'autres outils

Apr 13, 2025 am 09:42 AM

Comment Debian Readdir s'intègre à d'autres outils

Apr 13, 2025 am 09:42 AM

La fonction ReadDir dans le système Debian est un appel système utilisé pour lire le contenu des répertoires et est souvent utilisé dans la programmation C. Cet article expliquera comment intégrer ReadDir avec d'autres outils pour améliorer sa fonctionnalité. Méthode 1: combinant d'abord le programme de langue C et le pipeline, écrivez un programme C pour appeler la fonction readdir et sortir le résultat: # include # include # include # includeIntmain (intargc, char * argv []) {dir * dir; structDirent * entrée; if (argc! = 2) {

Comment optimiser les performances de Debian Readdir

Apr 13, 2025 am 08:48 AM

Comment optimiser les performances de Debian Readdir

Apr 13, 2025 am 08:48 AM

Dans Debian Systems, les appels du système ReadDir sont utilisés pour lire le contenu des répertoires. Si ses performances ne sont pas bonnes, essayez la stratégie d'optimisation suivante: simplifiez le nombre de fichiers d'annuaire: divisez les grands répertoires en plusieurs petits répertoires autant que possible, en réduisant le nombre d'éléments traités par appel ReadDir. Activer la mise en cache de contenu du répertoire: construire un mécanisme de cache, mettre à jour le cache régulièrement ou lorsque le contenu du répertoire change et réduire les appels fréquents à Readdir. Les caches de mémoire (telles que Memcached ou Redis) ou les caches locales (telles que les fichiers ou les bases de données) peuvent être prises en compte. Adoptez une structure de données efficace: si vous implémentez vous-même la traversée du répertoire, sélectionnez des structures de données plus efficaces (telles que les tables de hachage au lieu de la recherche linéaire) pour stocker et accéder aux informations du répertoire

Comment implémenter le tri des fichiers par Debian Readdir

Apr 13, 2025 am 09:06 AM

Comment implémenter le tri des fichiers par Debian Readdir

Apr 13, 2025 am 09:06 AM

Dans Debian Systems, la fonction ReadDir est utilisée pour lire le contenu du répertoire, mais l'ordre dans lequel il revient n'est pas prédéfini. Pour trier les fichiers dans un répertoire, vous devez d'abord lire tous les fichiers, puis les trier à l'aide de la fonction QSORT. Le code suivant montre comment trier les fichiers de répertoire à l'aide de ReadDir et QSort dans Debian System: # include # include # include # include # include // Fonction de comparaison personnalisée, utilisée pour qsortintCompare (constvoid * a, constvoid * b) {returnstrcmp (* (

Méthode d'installation du certificat de Debian Mail Server SSL

Apr 13, 2025 am 11:39 AM

Méthode d'installation du certificat de Debian Mail Server SSL

Apr 13, 2025 am 11:39 AM

Les étapes pour installer un certificat SSL sur le serveur de messagerie Debian sont les suivantes: 1. Installez d'abord la boîte à outils OpenSSL, assurez-vous que la boîte à outils OpenSSL est déjà installée sur votre système. Si ce n'est pas installé, vous pouvez utiliser la commande suivante pour installer: Sudoapt-getUpDaSuDoapt-getInstallOpenSSL2. Générer la clé privée et la demande de certificat Suivant, utilisez OpenSSL pour générer une clé privée RSA 2048 bits et une demande de certificat (RSE): OpenSS

Comment effectuer une vérification de la signature numérique avec Debian OpenSSL

Apr 13, 2025 am 11:09 AM

Comment effectuer une vérification de la signature numérique avec Debian OpenSSL

Apr 13, 2025 am 11:09 AM

En utilisant OpenSSL pour la vérification de la signature numérique sur Debian System, vous pouvez suivre ces étapes: Préparation à installer OpenSSL: Assurez-vous que votre système Debian a installé OpenSSL. Si vous n'êtes pas installé, vous pouvez utiliser la commande suivante pour l'installer: SudoaptupDaSudoaptinInStallOpenssl pour obtenir la clé publique: la vérification de la signature numérique nécessite la clé publique du signataire. En règle générale, la clé publique sera fournie sous la forme d'un fichier, comme public_key.pe

Comment Debian OpenSSL empêche les attaques de l'homme au milieu

Apr 13, 2025 am 10:30 AM

Comment Debian OpenSSL empêche les attaques de l'homme au milieu

Apr 13, 2025 am 10:30 AM

Dans Debian Systems, OpenSSL est une bibliothèque importante pour le chiffrement, le décryptage et la gestion des certificats. Pour empêcher une attaque d'homme dans le milieu (MITM), les mesures suivantes peuvent être prises: utilisez HTTPS: assurez-vous que toutes les demandes de réseau utilisent le protocole HTTPS au lieu de HTTP. HTTPS utilise TLS (Protocole de sécurité de la couche de transport) pour chiffrer les données de communication pour garantir que les données ne sont pas volées ou falsifiées pendant la transmission. Vérifiez le certificat de serveur: vérifiez manuellement le certificat de serveur sur le client pour vous assurer qu'il est digne de confiance. Le serveur peut être vérifié manuellement via la méthode du délégué d'URLSession