Périphériques technologiques

Périphériques technologiques

IA

IA

Dix éléments de l'architecture du système d'apprentissage automatique

Dix éléments de l'architecture du système d'apprentissage automatique

Dix éléments de l'architecture du système d'apprentissage automatique

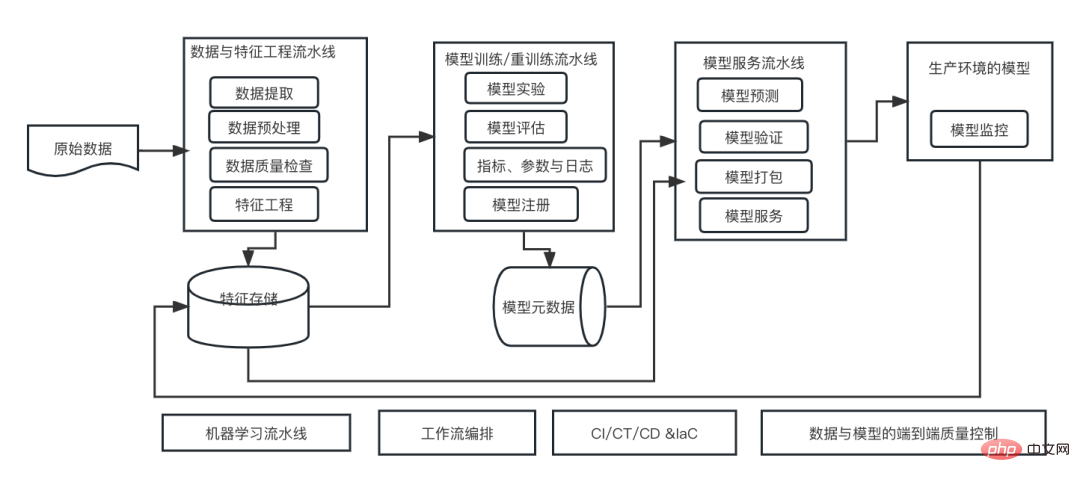

C’est une ère d’autonomisation de l’IA, et l’apprentissage automatique est un moyen technique important pour réaliser l’IA. Alors, existe-t-il une architecture universelle de système d’apprentissage automatique ?

Dans le champ cognitif des programmeurs expérimentés, tout n'est rien, notamment pour l'architecture système. Cependant, il est possible de créer une architecture de système d'apprentissage automatique évolutive et fiable si elle est applicable à la plupart des systèmes ou cas d'utilisation basés sur l'apprentissage automatique. Du point de vue du cycle de vie du machine learning, cette architecture dite universelle couvre les étapes clés du machine learning, depuis le développement de modèles de machine learning jusqu'au déploiement de systèmes de formation et de systèmes de services dans les environnements de production. Nous pouvons essayer de décrire une telle architecture de système d'apprentissage automatique à partir des dimensions de 10 éléments.

1. Pipeline d'ingénierie de données et de fonctionnalités

Fournissez des données de haute qualité dans un temps donné et générez des fonctionnalités d'apprentissage automatique utiles de manière évolutive et flexible. En général, le pipeline de données peut être séparé du pipeline d’ingénierie des fonctionnalités. Le pipeline de données fait référence au pipeline d'extraction, de transformation et de chargement (ETL), dans lequel les ingénieurs de données sont responsables du transfert des données vers des emplacements de stockage, tels que les lacs de données construits sur le stockage d'objets, et les pipelines d'ingénierie de fonctionnalités se concentrent sur la conversion des données brutes en données qui peut aider les fonctionnalités d'apprentissage automatique que les algorithmes d'apprentissage automatique apprennent plus rapidement et avec plus de précision.

L'ingénierie des fonctionnalités est généralement divisée en deux étapes. Dans la première étape, la logique d'ingénierie des fonctionnalités est généralement créée par les data scientists pendant la phase de développement à travers diverses expériences afin de trouver le meilleur ensemble de fonctionnalités, tandis que les ingénieurs de données ou les ingénieurs en apprentissage automatique sont responsables de la production de pipelines d'ingénierie de fonctionnalités pour la formation des modèles. et les services de production dans l'environnement fournissent des données de fonctionnalités de haute qualité.

2. Stockage des fonctionnalités

Stocke les données des fonctionnalités d'apprentissage automatique, effectue la gestion des versions, pour la découverte, le partage et la réutilisation, et fournit des données cohérentes et des fonctionnalités d'apprentissage automatique pour la formation de modèles et les services, améliorant ainsi la fiabilité du système d'apprentissage automatique.

Face aux données de fonctionnalités d'apprentissage automatique, le stockage de fonctionnalités est une solution de stockage persistante créée par le pipeline d'ingénierie de fonctionnalités. Le stockage des fonctionnalités prend en charge la formation et la diffusion des modèles. Il s’agit donc d’un élément très important et d’un composant important de l’architecture du système d’apprentissage automatique de bout en bout.

3. Pipeline de formation et de recyclage des modèles d'apprentissage automatique

Exécutez différents paramètres et hyperparamètres pour la formation en apprentissage automatique, menez des expériences de manière simple et configurable et enregistrez les différents paramètres et modèles sur lesquels ces formations sont exécutées sur des indicateurs de performance. Évaluez, validez, sélectionnez et enregistrez automatiquement les modèles les plus performants dans une bibliothèque de modèles d'apprentissage automatique.

4. Métastockage de la formation et des modèles

Stocke et enregistre les exécutions d'apprentissage automatique, y compris les paramètres, les indicateurs, les codes, les résultats de configuration et les modèles entraînés, et fournit la gestion du cycle de vie des modèles, l'annotation des modèles, la découverte et la réutilisation des modèles et d'autres fonctions.

Pour un système d'apprentissage automatique complet, caractérisé par l'ingénierie, la formation de modèles et le service de modèles, une grande quantité de métadonnées peut être générée à partir des données. Toutes ces métadonnées sont très utiles pour comprendre le fonctionnement du système, assurer la traçabilité depuis Données->Fonctionnalités->Modèle->Serveur et fournir des informations utiles pour le débogage lorsque le modèle cesse de fonctionner.

5. Pipeline de services de modèles d'apprentissage automatique

Fournir une infrastructure appropriée pour l'utilisation de modèles d'apprentissage automatique dans les environnements de production, en tenant compte à la fois du service complet et de la latence.

De manière générale, il existe trois modes de service : le service par lots, le service de streaming et le service en ligne. Chaque type de service nécessite une infrastructure complètement différente. De plus, l'infrastructure doit être tolérante aux pannes et évoluer automatiquement en réponse aux fluctuations des demandes et du débit, en particulier pour les systèmes d'apprentissage automatique critiques pour l'entreprise.

6. Surveiller les modèles ML en production

Dans l'environnement de production, lorsque des dérives et des anomalies de données et de modèles sont détectées, fournir des fonctions de collecte de données, de surveillance, d'analyse, de visualisation et de notification, et fournir les informations nécessaires pour aider au débogage du système.

7. Pipeline d'apprentissage automatique

Par rapport aux flux de travail d'apprentissage automatique spécifiques, les pipelines d'apprentissage automatique fournissent un cadre réutilisable qui permet aux data scientists de développer et d'itérer plus rapidement tout en maintenant un code de haute qualité et en réduisant le temps de production. Certains frameworks de pipeline d'apprentissage automatique fournissent également des capacités d'orchestration et d'abstraction architecturale.

8. Workflow Orchestration

L'orchestration du workflow est l'élément clé de l'intégration d'un système d'apprentissage automatique de bout en bout, coordonnant et gérant les dépendances de tous ces composants clés. Les outils d'orchestration de workflow fournissent également des fonctionnalités telles que la journalisation, la mise en cache, le débogage et les nouvelles tentatives.

9. Intégration continue/Formation continue/Livraison continue (CI/CT/CD)

Les tests continus et l'intégration continue font référence à la formation continue de nouveaux modèles avec de nouvelles données, à la mise à niveau des performances du modèle si nécessaire et au maintien de la sécurité, de l'agilité et de l'automatisation. pour servir en permanence l’environnement de production et déployer des modèles.

10. Contrôle qualité de bout en bout pour les données et les modèles

À chaque étape du flux de travail d'apprentissage automatique de bout en bout, des contrôles fiables de la qualité des données, des contrôles de la qualité des modèles, ainsi que la détection des dérives des données et des concepts doivent être intégrés pour garantir que le système d'apprentissage automatique lui-même est fiable et digne de confiance. Ces contrôles de qualité incluent, entre autres, des statistiques descriptives, la forme globale des données, les données manquantes, les données en double, les caractéristiques presque constantes, les tests statistiques, les mesures de distance et la qualité des prédictions du modèle.

Ce qui précède peut être appelé les 10 éléments de l'architecture du système d'apprentissage automatique. Dans notre pratique, le flux de travail global devrait rester à peu près le même, mais certains éléments devront peut-être être modifiés et personnalisés.

Comment ajuster l'architecture système du machine learning ?

Comment rationaliser les éléments architecturaux dès le début de la conception d'un produit ?

Comment maintenir la continuité de l'architecture système d'origine lors de l'introduction d'un système d'apprentissage automatique ?

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Le système de conduite intelligent Qiankun ADS3.0 de Huawei sera lancé en août et sera lancé pour la première fois sur Xiangjie S9

Jul 30, 2024 pm 02:17 PM

Le système de conduite intelligent Qiankun ADS3.0 de Huawei sera lancé en août et sera lancé pour la première fois sur Xiangjie S9

Jul 30, 2024 pm 02:17 PM

Le 29 juillet, lors de la cérémonie de lancement de la 400 000e nouvelle voiture d'AITO Wenjie, Yu Chengdong, directeur général de Huawei, président de Terminal BG et président de la BU Smart Car Solutions, a assisté et prononcé un discours et a annoncé que les modèles de la série Wenjie seraient sera lancé cette année En août, la version Huawei Qiankun ADS 3.0 a été lancée et il est prévu de pousser successivement les mises à niveau d'août à septembre. Le Xiangjie S9, qui sortira le 6 août, lancera le système de conduite intelligent ADS3.0 de Huawei. Avec l'aide du lidar, la version Huawei Qiankun ADS3.0 améliorera considérablement ses capacités de conduite intelligente, disposera de capacités intégrées de bout en bout et adoptera une nouvelle architecture de bout en bout de GOD (identification générale des obstacles)/PDP (prédictive prise de décision et contrôle), fournissant la fonction NCA de conduite intelligente d'une place de stationnement à l'autre et mettant à niveau CAS3.0

Cet article vous amènera à comprendre SHAP : explication du modèle pour l'apprentissage automatique

Jun 01, 2024 am 10:58 AM

Cet article vous amènera à comprendre SHAP : explication du modèle pour l'apprentissage automatique

Jun 01, 2024 am 10:58 AM

Dans les domaines de l’apprentissage automatique et de la science des données, l’interprétabilité des modèles a toujours été au centre des préoccupations des chercheurs et des praticiens. Avec l'application généralisée de modèles complexes tels que l'apprentissage profond et les méthodes d'ensemble, la compréhension du processus décisionnel du modèle est devenue particulièrement importante. Explainable AI|XAI contribue à renforcer la confiance dans les modèles d'apprentissage automatique en augmentant la transparence du modèle. L'amélioration de la transparence des modèles peut être obtenue grâce à des méthodes telles que l'utilisation généralisée de plusieurs modèles complexes, ainsi que les processus décisionnels utilisés pour expliquer les modèles. Ces méthodes incluent l'analyse de l'importance des caractéristiques, l'estimation de l'intervalle de prédiction du modèle, les algorithmes d'interprétabilité locale, etc. L'analyse de l'importance des fonctionnalités peut expliquer le processus de prise de décision du modèle en évaluant le degré d'influence du modèle sur les fonctionnalités d'entrée. Estimation de l’intervalle de prédiction du modèle

Identifier le surapprentissage et le sous-apprentissage grâce à des courbes d'apprentissage

Apr 29, 2024 pm 06:50 PM

Identifier le surapprentissage et le sous-apprentissage grâce à des courbes d'apprentissage

Apr 29, 2024 pm 06:50 PM

Cet article présentera comment identifier efficacement le surajustement et le sous-apprentissage dans les modèles d'apprentissage automatique grâce à des courbes d'apprentissage. Sous-ajustement et surajustement 1. Surajustement Si un modèle est surentraîné sur les données de sorte qu'il en tire du bruit, alors on dit que le modèle est en surajustement. Un modèle surajusté apprend chaque exemple si parfaitement qu'il classera mal un exemple inédit/inédit. Pour un modèle surajusté, nous obtiendrons un score d'ensemble d'entraînement parfait/presque parfait et un score d'ensemble/test de validation épouvantable. Légèrement modifié : "Cause du surajustement : utilisez un modèle complexe pour résoudre un problème simple et extraire le bruit des données. Parce qu'un petit ensemble de données en tant qu'ensemble d'entraînement peut ne pas représenter la représentation correcte de toutes les données."

L'évolution de l'intelligence artificielle dans l'exploration spatiale et l'ingénierie des établissements humains

Apr 29, 2024 pm 03:25 PM

L'évolution de l'intelligence artificielle dans l'exploration spatiale et l'ingénierie des établissements humains

Apr 29, 2024 pm 03:25 PM

Dans les années 1950, l’intelligence artificielle (IA) est née. C’est à ce moment-là que les chercheurs ont découvert que les machines pouvaient effectuer des tâches similaires à celles des humains, comme penser. Plus tard, dans les années 1960, le Département américain de la Défense a financé l’intelligence artificielle et créé des laboratoires pour poursuivre son développement. Les chercheurs trouvent des applications à l’intelligence artificielle dans de nombreux domaines, comme l’exploration spatiale et la survie dans des environnements extrêmes. L'exploration spatiale est l'étude de l'univers, qui couvre l'ensemble de l'univers au-delà de la terre. L’espace est classé comme environnement extrême car ses conditions sont différentes de celles de la Terre. Pour survivre dans l’espace, de nombreux facteurs doivent être pris en compte et des précautions doivent être prises. Les scientifiques et les chercheurs pensent qu'explorer l'espace et comprendre l'état actuel de tout peut aider à comprendre le fonctionnement de l'univers et à se préparer à d'éventuelles crises environnementales.

Implémentation d'algorithmes d'apprentissage automatique en C++ : défis et solutions courants

Jun 03, 2024 pm 01:25 PM

Implémentation d'algorithmes d'apprentissage automatique en C++ : défis et solutions courants

Jun 03, 2024 pm 01:25 PM

Les défis courants rencontrés par les algorithmes d'apprentissage automatique en C++ incluent la gestion de la mémoire, le multithread, l'optimisation des performances et la maintenabilité. Les solutions incluent l'utilisation de pointeurs intelligents, de bibliothèques de threads modernes, d'instructions SIMD et de bibliothèques tierces, ainsi que le respect des directives de style de codage et l'utilisation d'outils d'automatisation. Des cas pratiques montrent comment utiliser la bibliothèque Eigen pour implémenter des algorithmes de régression linéaire, gérer efficacement la mémoire et utiliser des opérations matricielles hautes performances.

Toujours nouveau ! Mises à niveau de la série Huawei Mate60 vers HarmonyOS 4.2 : amélioration du cloud AI, le dialecte Xiaoyi est si facile à utiliser

Jun 02, 2024 pm 02:58 PM

Toujours nouveau ! Mises à niveau de la série Huawei Mate60 vers HarmonyOS 4.2 : amélioration du cloud AI, le dialecte Xiaoyi est si facile à utiliser

Jun 02, 2024 pm 02:58 PM

Le 11 avril, Huawei a officiellement annoncé pour la première fois le plan de mise à niveau de 100 machines HarmonyOS 4.2. Cette fois, plus de 180 appareils participeront à la mise à niveau, couvrant les téléphones mobiles, les tablettes, les montres, les écouteurs, les écrans intelligents et d'autres appareils. Au cours du mois dernier, avec la progression constante du plan de mise à niveau de 100 machines HarmonyOS4.2, de nombreux modèles populaires, notamment Huawei Pocket2, la série Huawei MateX5, la série nova12, la série Huawei Pura, etc., ont également commencé à être mis à niveau et à s'adapter, ce qui signifie qu'il y aura davantage d'utilisateurs de modèles Huawei pourront profiter de l'expérience commune et souvent nouvelle apportée par HarmonyOS. À en juger par les commentaires des utilisateurs, l'expérience des modèles de la série Huawei Mate60 s'est améliorée à tous égards après la mise à niveau d'HarmonyOS4.2. Surtout Huawei M

IA explicable : Expliquer les modèles IA/ML complexes

Jun 03, 2024 pm 10:08 PM

IA explicable : Expliquer les modèles IA/ML complexes

Jun 03, 2024 pm 10:08 PM

Traducteur | Revu par Li Rui | Chonglou Les modèles d'intelligence artificielle (IA) et d'apprentissage automatique (ML) deviennent aujourd'hui de plus en plus complexes, et le résultat produit par ces modèles est une boîte noire – impossible à expliquer aux parties prenantes. L'IA explicable (XAI) vise à résoudre ce problème en permettant aux parties prenantes de comprendre comment fonctionnent ces modèles, en s'assurant qu'elles comprennent comment ces modèles prennent réellement des décisions et en garantissant la transparence des systèmes d'IA, la confiance et la responsabilité pour résoudre ce problème. Cet article explore diverses techniques d'intelligence artificielle explicable (XAI) pour illustrer leurs principes sous-jacents. Plusieurs raisons pour lesquelles l’IA explicable est cruciale Confiance et transparence : pour que les systèmes d’IA soient largement acceptés et fiables, les utilisateurs doivent comprendre comment les décisions sont prises

Quelle est la courbe d'apprentissage de l'architecture du framework Golang ?

Jun 05, 2024 pm 06:59 PM

Quelle est la courbe d'apprentissage de l'architecture du framework Golang ?

Jun 05, 2024 pm 06:59 PM

La courbe d'apprentissage de l'architecture du framework Go dépend de la familiarité avec le langage Go et le développement back-end ainsi que de la complexité du framework choisi : une bonne compréhension des bases du langage Go. Il est utile d’avoir une expérience en développement back-end. Les cadres qui diffèrent en complexité entraînent des différences dans les courbes d'apprentissage.