Article 1 : Un modèle pour les éditer tous : Manipulation d'images basées sur du texte de forme libre avec modulations sémantiques

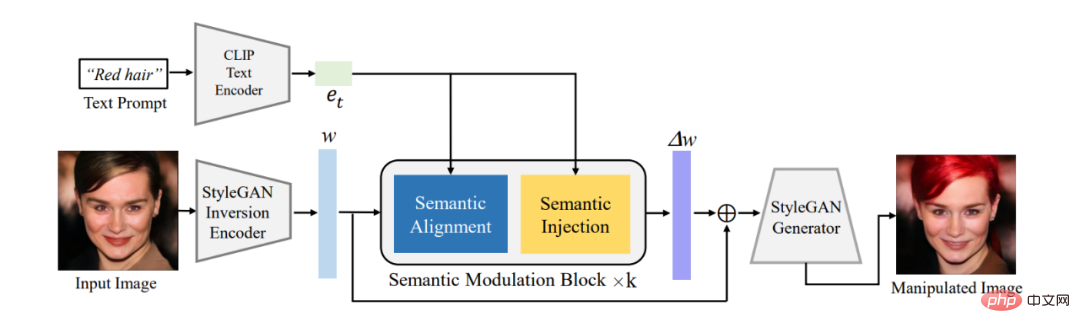

Résumé : Cet article utilise d'abord l'encodeur existant pour convertir l'image qui doit être modifiée vers l'encodage latent w dans la sémantique W^+ espace de StyleGAN, puis Le codage latent est modulé de manière adaptative via le module de modulation sémantique proposé. Le module de modulation sémantique comprend des modules d'alignement sémantique et d'injection sémantique. Il aligne d'abord la sémantique entre l'encodage de texte et l'encodage latent du GAN via le mécanisme d'attention, puis injecte les informations textuelles dans l'encodage latent aligné pour garantir que l'encodage Caïn est propriétaire. le texte. Informations permettant ainsi d'éditer des images à l'aide de texte.

Différent du modèle StyleCLIP classique, notre modèle n'a pas besoin de former un modèle distinct pour chaque texte. Un modèle peut répondre à plusieurs textes pour éditer efficacement les images, de sorte que notre modèle devient une manipulation d'image pilotée par texte sans forme FFCLIP. . Dans le même temps, notre modèle a obtenu de très bons résultats sur les ensembles de données classiques d'église, de visage et de voiture.

Figure 1 : Schéma global du cadre

Recommandé : Nouveau paradigme d'édition de texte et d'images, un modèle unique réalise l'édition d'images guidées multi-textes.

Article 2 : Modules photovoltaïques organiques imprimés sur des substrats ultra-minces transférables comme sources d'énergie additives

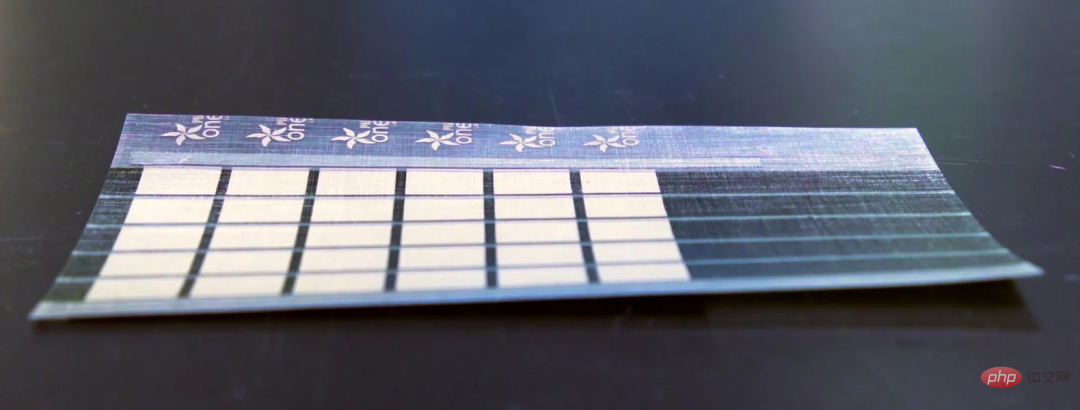

Résumé : Des chercheurs du MIT ont développé une technologie de fabrication évolutive capable de produire des cellules solaires ultra fines et légères. Des batteries pouvant être posées sur n'importe quelle surface.

Des chercheurs du MIT ont créé des panneaux solaires plus fins qu'un cheveu humain et fournissent 18 fois plus d'énergie par kilogramme que les panneaux solaires actuels à base de verre et de silicium. Ces panneaux solaires ne pèsent qu’un pour cent des cellules photovoltaïques traditionnelles.

Ce panneau solaire ultra fin peut également être installé sur des voiles, des ailes de drone et des tentes. Ils sont particulièrement utiles dans les zones reculées et les opérations de secours en cas de catastrophe.

Recommandation : MIT crée des panneaux solaires minces comme du papier.

Article 3 : Une enquête sur l'apprentissage profond pour le raisonnement mathématique

Résumé :Dans un rapport récemment publié, des chercheurs de l'UCLA et d'autres institutions ont systématiquement examiné les progrès de l'apprentissage profond dans le raisonnement mathématique.

Plus précisément, cet article traite de diverses tâches et ensembles de données (Section 2) et examine les progrès des réseaux de neurones (Section 3) et des modèles de langage pré-entraînés (Section 4) en mathématiques. Le développement rapide de l'apprentissage contextuel de grands modèles de langage dans le raisonnement mathématique est également exploré (Section 5). L'article analyse plus en détail les références existantes et constate que moins d'attention est accordée aux environnements multimodaux et à faibles ressources (Section 6.1). Des recherches fondées sur des données probantes montrent que les représentations actuelles des capacités informatiques sont inadéquates et que les méthodes d’apprentissage profond sont incohérentes en ce qui concerne le raisonnement mathématique (section 6.2). Par la suite, les auteurs suggèrent des améliorations aux travaux actuels en termes de généralisation et de robustesse, de raisonnement fiable, d’apprentissage à partir du feedback et de raisonnement mathématique multimodal (Section 7).

Recommandé : Comment l'apprentissage profond ouvre lentement la porte au raisonnement mathématique.

Papier 4 : Muse : Génération de texte en image via des transformateurs génératifs masqués

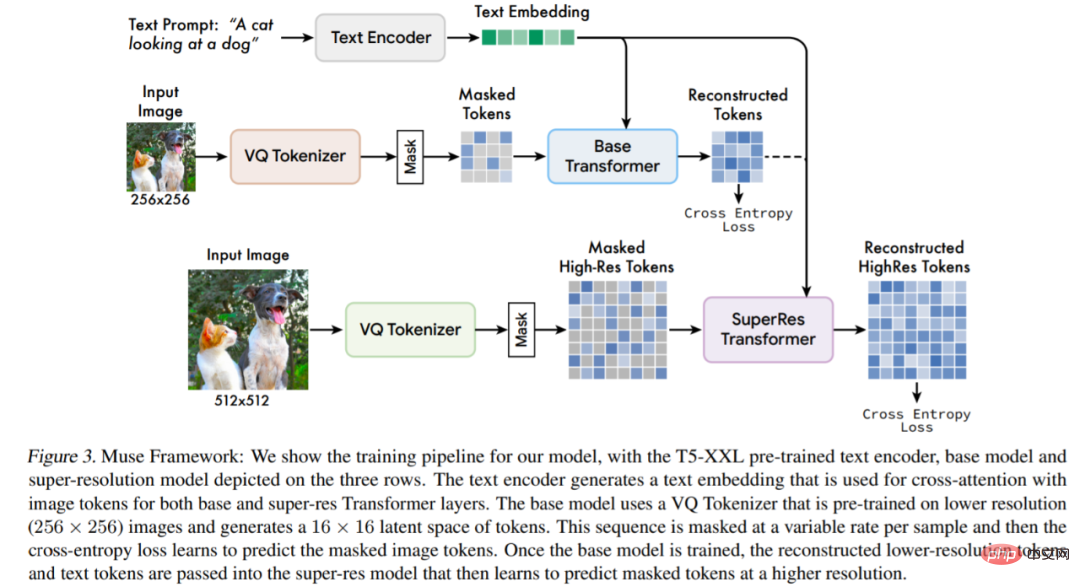

Résumé : Cette étude propose un nouveau modèle de synthèse texte-image utilisant une approche de modélisation d'image masquée, dans laquelle l'architecture du décodeur d'image est auto-pré-entraînée. et des intégrations d'encodeurs LLM (Large Language Model) T5-XXL gelées.

Par rapport à Imagen (Saharia et al., 2022) ou Dall-E2 (Ramesh et al., 2022) basés sur le modèle de diffusion de l'espace pixel en cascade, Muse utilise des jetons discrets, l'efficacité est considérablement améliorée. Par rapport au modèle autorégressif SOTA Parti (Yu et al., 2022), Muse est plus efficace grâce à son utilisation du décodage parallèle.

Sur la base de résultats expérimentaux sur TPU-v4, les chercheurs estiment que Muse est plus de 10 fois plus rapide que les modèles Imagen-3B ou Parti-3B en vitesse d'inférence, et plus rapide que Stable Diffusion v1.4 (Rombach et al., 2022) 2x plus rapide. Les chercheurs pensent que Muse est plus rapide que Stable Diffusion car le modèle de diffusion est utilisé dans Stable Diffusion v1.4, ce qui nécessite évidemment plus d'itérations lors de l'inférence.

Aperçu de l'architecture du modèle.

Recommandation : La vitesse d'inférence est 2 fois plus rapide que la diffusion stable, et la génération et la réparation d'images peuvent être effectuées avec un seul modèle Google.

Passage 5 : Bruit d'incitation positive

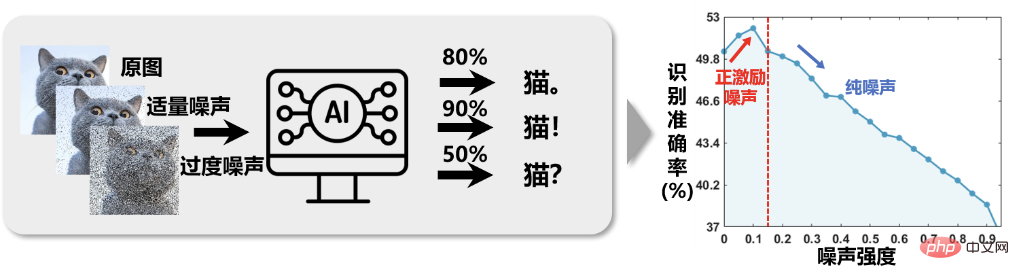

Résumé :Dans tous les aspects de la recherche scientifique, il existe une grande quantité de bruit, tel que des erreurs d'instruments causées par une précision insuffisante des instruments, des écarts causés par des erreurs humaines de fonctionnement, une distorsion de l'information causée par des interférences externes telles que des environnements extrêmes, etc. . Les chercheurs pensent désormais que le bruit a souvent des effets néfastes sur les tâches effectuées. C'est pourquoi de nombreux travaux de recherche ont été générés autour de la tâche principale de la « réduction du bruit ». Cependant, l'équipe du professeur Li Xuelong de la Northwestern Polytechnical University a remis en question cette hypothèse à travers des observations expérimentales lors de tâches de détection et de traitement de signaux : le bruit dans la recherche scientifique est-il vraiment toujours nocif ?

Comme le montre la figure 1, dans un système de classification intelligent d'images, après avoir ajouté une quantité appropriée de bruit à l'image puis entraîné, la précision de la reconnaissance a augmenté. Cela nous apporte un peu d'inspiration : ajouter du bruit à l'image au lieu de le supprimer, puis effectuer la tâche de classification d'image peut donner de meilleurs résultats. Tant que l'impact du bruit sur la cible est bien inférieur à l'impact du bruit sur le fond, l'effet de « blesser l'ennemi (bruit de fond) de mille et s'endommager soi-même (signal cible) de huit cents » est significatif, car la mission poursuit un rapport signal/bruit élevé. Essentiellement, face aux problèmes de classification traditionnels, l'ajout aléatoire d'un bruit modéré après les fonctionnalités équivaut à augmenter la dimension des fonctionnalités. Dans un sens, cela équivaut à ajouter une fonction de noyau aux fonctionnalités, qui termine en fait une tâche à partir de bas. -L'espace dimensionnel vers l'espace de grande dimension rend les données plus séparables, améliorant ainsi l'effet de classification.

Figure 1 La précision de la reconnaissance d'image montre une relation « contre-intuitive » consistant « d'abord à augmenter puis à diminuer » à mesure que l'intensité du bruit de l'image augmente.

Recommandé : Le professeur Li Xuelong de la Western Polytechnic University a proposé un cadre d'analyse mathématique basé sur l'entropie des tâches.

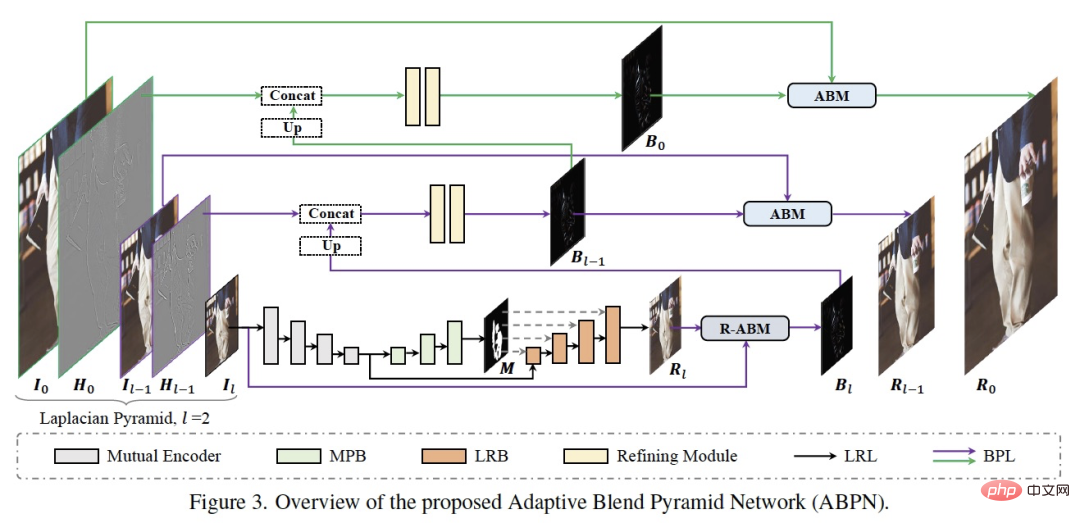

Papier 6 : ABPN : Réseau pyramidal de mélange adaptatif pour la retouche locale en temps réel de photos à ultra haute résolution

Les chercheurs de la DAMO Academy visent à atteindre point de soins de la peau intelligent de niveau professionnel, recherche et développement Un ensemble d'algorithmes de retouche locale ultra-fins ABPN pour les images haute définition a été développé, qui a obtenu de bons résultats et des applications dans les tâches d'embellissement de la peau et d'élimination des rides des vêtements dans des images ultra haute définition.

Comme le montre la figure ci-dessus, la structure du réseau se compose principalement de deux parties : la couche de modification locale contextuelle (LRL) et la couche pyramidale de mélange adaptative (BPL). Le but de LRL est de modifier localement l’image basse résolution sous-échantillonnée et de générer une image de résultat de modification basse résolution, en tenant pleinement compte des informations de contexte global et des informations de texture locale. De plus, BPL est utilisé pour améliorer progressivement les résultats basse résolution générés dans LRL vers des résultats haute résolution. Parmi eux, nous avons conçu un module de fusion adaptative (ABM) et son module inverse (R-ABM). En utilisant la couche de fusion intermédiaire Bi, nous pouvons réaliser une conversion adaptative et une expansion vers le haut entre l'image d'origine et l'image résultante, montrant une puissante évolutivité. et des capacités de fidélité des détails. Nous avons mené un grand nombre d'expériences sur les deux ensembles de données de modification du visage et de modification des vêtements, et les résultats montrent que notre méthode est nettement en avance sur les méthodes existantes en termes d'efficacité et d'efficience. Il est à noter que notre modèle réalise l'inférence en temps réel d'images 4K ultra haute résolution sur une seule carte P100.

Recommandé : Effacez les imperfections et les rides en un seul clic.

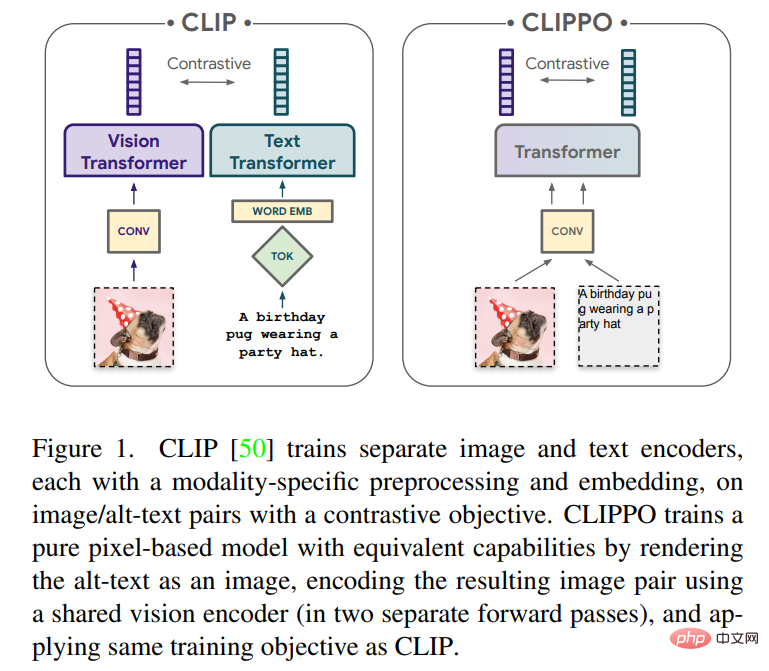

Papier 7 : Compréhension de l'image et du langage à partir des pixels uniquement

Résumé : Le développement d'un modèle unique de bout en bout capable de gérer n'importe quelle modalité ou combinaison de modalités sera une étape importante vers l'apprentissage multimodal. Dans cet article, les chercheurs de Google Research (équipe Google Brain) et de Zurich se concentreront principalement sur les images et le texte.

Cet article explorera l'apprentissage multimodal du texte et des images à l'aide de modèles purement basés sur les pixels. Le modèle est un transformateur visuel distinct qui traite les entrées visuelles ou le texte, ou les deux ensemble, le tout rendu sous forme d'images RVB. Toutes les modalités utilisent les mêmes paramètres de modèle, y compris le traitement des fonctionnalités de bas niveau ; c'est-à-dire qu'il n'y a pas de convolutions initiales, d'algorithmes de tokenisation ou de tables d'intégration d'entrée spécifiques aux modalités. Le modèle est formé avec une seule tâche : l'apprentissage contrastif, tel que popularisé par CLIP et ALIGN. Le modèle est donc appelé CLIP-Pixels Only (CLIPPO).

Recommandé : Les paramètres sont réduits de moitié et aussi bons que CLIP réalise l'unification d'image et de texte à partir des pixels.

Heart of Machine coopère avec ArXiv Weekly Radiostation initiée par Chu Hang et Luo Ruotian, et sélectionne cette semaine des articles plus importants sur la base de 7 articles, dont 10 articles sélectionnés chacun dans les domaines de la PNL, du CV et du ML. , et fournissez un résumé audio de l'article, les détails sont les suivants :

10 NLP PapersAudio :00:0020:02

Les 10 articles PNL sélectionnés cette semaine sont :

1. Repenser avec la récupération : l'inférence fidèle à un grand modèle linguistique (de Hongming Zhang, Dan Roth)

2. Un ensemble de données et une méthode. (de Bhiksha Raj)

3. Vers une génération de table en texte avec un modèle de langage pré-entraîné : une compréhension de la structure de table et une approche délibérative de texte (de Hui Xiong)

4. Rhétorique avec détection de position épistémique. (de Brendan O'Connor)

5. Vers une analyse sémantique texte-SQL à forte intensité de connaissances avec des connaissances formulées (de Min-Yen Kan)

6. dans Détection implicite des discours de haine. (de Jessica Lin)

7. Les modèles de langage de codec neuronal sont des synthétiseurs de synthèse vocale Zero-Shot (de Furu Wei)

8. Générateur d'interviews (de Tao Zhang)

9. Modélisation du langage basée sur un dictionnaire de recherche augmentée pour la reconnaissance automatique de la parole (de Yuxuan Wang)

10. )

10 CV PapiersAudio:00:0021:06

Les 10 CV articles sélectionnés cette semaine sont :

1. CA$^2$T-Net : Transfert d'articulation 3D indépendant de la catégorie à partir d'une image unique (de Jitendra Malik)

2. Cartographie des plantations de noix de cajou des petits exploitants pour éclairer l'expansion durable des cultures d'arbres au Bénin. Malik) Vipin Kumar)

3. Scale-MAE : un auto-encodeur masqué prenant en compte l'échelle pour l'apprentissage de la représentation géospatiale à plusieurs échelles)

4. . (de Rama Chellappa)

5. Muse : Génération de texte en image via des transformateurs génératifs masqués (de Ming-Hsuan Yang, Kevin Murphy, William T. Freeman)

6. Grâce à l'effondrement neuronal. (de Xiangyu Zhang, Jiaya Jia)

7. Transformateur multimodal via l'encodage de coordonnées pour la détection d'objets 3D (de Xiangyu Zhang)

8. . ( d'Alan Yuille)

9. Apprendre par tri : apprentissage auto-supervisé avec contraintes d'ordre de groupe (de Bernt Schiele)

.10. AttEntropy : segmentation d'objets inconnus dans des scènes complexes à l'aide de l'entropie d'attention spatiale des transformateurs de segmentation sémantique. (De Pascal Fua)

本周 10 篇 ML精选论文是:1. Apprentissage de la structure graphique préservée par auto-organisation avec le principe des informations pertinentes. (de Philip S. Yu)2. Expansion modifiée des requêtes via des réseaux contradictoires génératifs pour l'extraction d'informations dans le commerce électronique. (d'Altan Cakir)3. Explications démêlées des prédictions des réseaux neuronaux en trouvant des sous-espaces pertinents. (de Klaus-Robert Müller)4. L-HYDRA : Réseaux de neurones multi-têtes informés par la physique. (de George Em Karniadakis)

5. Sur la transformation de l'apprentissage par renforcement par Transformer : la trajectoire de développement. (de Dacheng Tao)

6. Stimuler les réseaux de neurones pour décompiler les binaires optimisés. (de Kai Chen)7. NeuroExplainer : décodage précis de l'attention pour découvrir les modèles de développement cortical des nourrissons prématurés. (de Dinggang Shen)

8. Une théorie de l'apprentissage en quelques étapes semblable à celui des humains. (de Ming Li)

9. Apprentissage par différence temporelle avec mises à jour compressées : le retour d'erreur rencontre l'apprentissage par renforcement. (de George J. Pappas)

10. Estimation des flux de population latente à partir de données agrégées via l'inversion du transport optimal multi-marginal. (de Hongyuan Zha)

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Comment implémenter la technologie de conteneur Docker en Java

Comment implémenter la technologie de conteneur Docker en Java

Que sont les moteurs MySQL ?

Que sont les moteurs MySQL ?

Que signifie la passerelle Edge Computing ?

Que signifie la passerelle Edge Computing ?

Qu'est-ce que le service SAAS

Qu'est-ce que le service SAAS

utilisation de la fonction date

utilisation de la fonction date

Comment utiliser la balise article

Comment utiliser la balise article

Solution au code Java qui ne fonctionne pas

Solution au code Java qui ne fonctionne pas

Que sont les bases de données en mémoire ?

Que sont les bases de données en mémoire ?