Périphériques technologiques

Périphériques technologiques

IA

IA

Entretien avec Stuart Russell : Concernant ChatGPT, plus de données et plus de puissance de calcul ne peuvent pas apporter une réelle intelligence

Entretien avec Stuart Russell : Concernant ChatGPT, plus de données et plus de puissance de calcul ne peuvent pas apporter une réelle intelligence

Entretien avec Stuart Russell : Concernant ChatGPT, plus de données et plus de puissance de calcul ne peuvent pas apporter une réelle intelligence

La quatrième édition chinoise de « Intelligence artificielle : une approche moderne » a été récemment publiée. Machine Heart a mené une interview exclusive avec l'auteur, le professeur Stuart Russell. En tant que classique dans le domaine de l'IA, Artificial Intelligence: A Modern Approach a été réimprimé plusieurs fois, le contenu et la structure reflétant l'évolution de la compréhension des deux auteurs. La dernière quatrième édition est leur dernière explication après avoir intégré les progrès de l'IA au cours de la dernière décennie, en particulier l'impact de l'apprentissage profond, dans le cadre global. Elle reflète les perspectives des deux maîtres sur les tendances de l'intelligence artificielle et le développement du sujet. système.

Cette interview suit également "une approche moderne", dans l'espoir de montrer les réflexions du professeur Russell sur les tendances technologiques, les théories de l'intelligence et les populaires par rapport aux classiques dans une perspective en phase avec le développement de la technologie et de l'époque, et fournir des informations aux chercheurs en IA et inspirer les praticiens.

Stuart Russell travaille à l'Université de Californie à Berkeley, où il est actuellement professeur au Département d'informatique (ancien directeur du département) et directeur du Center for Human-Compatible Intelligence artificielle. Il a reçu le prix présidentiel de la National Science Foundation pour les jeunes scientifiques exceptionnels en 1990 et le prix IJCAI Computing and Ideas en 1995. Il est membre de l'AAAI, de l'ACM et de l'AAAS et a publié plus de 300 articles dans le domaine de l'intelligence artificielle, couvrant un large éventail de sujets. Source de l'image : kavlicenter.berkeley.edu

Le professeur Russell estime qu'au cours des dix prochaines années, l'attention des gens passera d'un apprentissage profond de bout en bout à un système modulaire et basé sur la logique mathématique. Il s'agit d'un système composé de représentations sémantiquement bien définies, et l’apprentissage profond jouera un rôle crucial dans l’obtention de données sensorielles brutes. Il est important de souligner que les représentations modulaires et sémantiquement bien définies ne doivent pas nécessairement être conçues à la main ou que de telles représentations peuvent être apprises à partir de données ;

Quant au populaire ChatGPT, le professeur Russell estime que la clé est de distinguer les domaines de tâches et de déterminer dans quelles circonstances il est utilisé : ChatGPT peut être un bon outil s'il peut être ancré sur des faits, combiné avec le système de planification, apportera une plus grande valeur. Le problème est que nous ne savons pas actuellement comment fonctionne ChatGPT, et nous ne pourrons probablement pas le comprendre, ce qui nécessitera des avancées conceptuelles difficiles à prévoir.

Il estime que pour construire un système véritablement intelligent, nous devrions accorder plus d'attention à la logique mathématique et au raisonnement des connaissances, car nous devons construire le système sur des méthodes que nous comprenons, afin de garantir que l'IA ne s'échappe pas. de contrôle. Il ne croit pas que le développement à grande échelle soit la solution, ni que les problèmes puissent être résolus avec plus de données et plus de puissance de calcul. Cette idée est trop optimiste et intellectuellement inintéressante.

Si nous ignorons le problème fondamental de l'inefficacité des données d'apprentissage profond, "Je crains que nous nous trompions en pensant que nous nous dirigeons vers une véritable intelligence. Tout ce que nous faisons est en fait vers des modèles qui ne sont pas du tout vraiment intelligents". . Les choses ajoutent de plus en plus de pixels. "

-1-

Machine Heart : À votre avis, le modèle de langage pré-entraîné (LLM) à grande échelle représenté par ChatGPT est-il fondamentalement différent ? l'intelligence au niveau supérieur ? Le LLM résout-il certains problèmes fondamentaux des systèmes d’apprentissage profond, tels que l’acquisition du bon sens et le raisonnement des connaissances ?

Stuart Russell : La première réponse qui me vient à l’esprit est : nous ne le savons pas, car personne ne sait comment fonctionnent ces modèles, y compris les personnes qui les ont créés.

Que sait ChatGPT ? Peut-il raisonner ? Dans quel sens comprend-il la réponse ? Nous ne le savons pas.

Un de mes amis à l'Oregon State University a demandé au modèle "Lequel est le plus gros, un éléphant ou un chat ?" Le modèle a répondu "L'éléphant est plus gros", mais a demandé d'une autre manière : "Lequel ne l'est pas ?" plus gros que l'autre, un éléphant ou un chat ?" Le mannequin a répondu "Ni l'éléphant ni le chat ne sont plus gros que l'autre." Donc vous dites que le modèle sait lequel est le plus grand, un éléphant ou un chat ? Il ne le sait pas, car si on lui posait la question autrement, il aboutirait à une conclusion contradictoire.

Alors, que sait le modèle ?

Laissez-moi vous donner un autre exemple, qui correspond également à ce qui s'est réellement passé. Les données d'entraînement de ces modèles contiennent un grand nombre de parties d'échecs, représentées par des codes et des symboles unifiés. Une partie ressemble à la séquence e4 e5 Cf3 Cc6 Bb5... Le joueur connaît la signification de ces symboles et les mouvements représentés par ces séquences. Mais le modèle ne sait pas qu'il y a un échiquier et il ne connaît pas les mouvements. Pour le modèle, ces symboles ne sont que des symboles. Ainsi, lorsque vous jouez aux échecs à l'aveugle avec lui et que vous dites "Jouons aux échecs, g4", il peut répondre "e6". Bien sûr, cela peut être un bon coup, mais le modèle n'a aucune idée du jeu d'échecs. Il apprend simplement. formation Trouvez des séquences similaires dans les données, effectuez les transformations appropriées sur ces séquences, puis générez le mouvement suivant. 80% voire 90% du temps, il produira un bon coup, mais d'autres fois, il fera des mouvements idiots ou complètement contraires aux règles parce qu'il n'a aucune idée de jouer un coup sur un échiquier.

Pas seulement pour jouer aux échecs, je pense que cela s'applique en fait à tout ce que font les grands modèles maintenant : 80 % du temps, il ressemble à une personne très intelligente, mais les 20 % restants du temps, il ressemble à un idiot complet.

Il a l'air intelligent car il contient beaucoup de données. Il a lu presque tous les livres et articles écrits par les humains jusqu'à présent, mais malgré cela, après avoir accepté une telle quantité d'informations utiles, il crachera toujours. des choses dont je n'ai aucune idée de leur nom. Donc, en ce sens, je pense que les grands modèles de langage ne constituent probablement pas une avancée dans le domaine de l’intelligence artificielle.

Ce qui est vraiment impressionnant avec ChatGPT, c'est sa capacité à généraliser, à trouver des similitudes entre les conversations qu'il a avec les utilisateurs et le texte précédemment lu et à effectuer les transformations appropriées , de sorte que ses réponses semblent intelligentes. Cependant, nous ne savons pas comment le modèle fait cela, nous ne savons pas où se situent les limites de cette capacité de généralisation et nous ne savons pas comment cette généralisation est implémentée dans le circuit.

Si nous le savons vraiment, cela peut en effet être considéré comme un progrès en matière d'intelligence artificielle, car nous pouvons l'utiliser comme base, et nous pouvons développer d'autres systèmes basés sur ChatGPT. Mais à ce stade, tout reste un mystère. La seule façon d'avancer est si le modèle ne fonctionne pas ? D'accord, donnons-lui plus de données et agrandissons un peu le modèle.

Je ne pense pas que l’intensification soit la solution. Les données finiront par s’épuiser et de nouvelles situations se produisent toujours dans le monde réel. Lorsque nous écrivons des programmes d'échecs, les programmes qui savent vraiment bien jouer aux échecs peuvent faire face à des situations jamais vues auparavant. Il n'y a qu'une seule raison, c'est que ces programmes comprennent les règles des échecs et peuvent déplacer les pièces d'échecs dans l'évolution. Les positions sur l'échiquier - les points auxquels les pièces peuvent être déplacées, les prochains mouvements possibles de l'adversaire, y compris les mouvements jamais enregistrés auparavant dans le jeu d'échecs - sont visualisés.

Nous sommes encore loin de pouvoir le faire dans des situations générales réelles. En même temps, je ne pense pas que les grands modèles linguistiques nous rapprochent davantage de cet objectif. Sauf que, pourrait-on dire, les grands modèles de langage nous permettent d’utiliser les connaissances humaines stockées dans le texte.

Les grands modèles de langage seront plus utiles si nous pouvons les ancrer dans des faits connus. Pensez au Google Knowledge Graph, qui contient 500 milliards de faits, si ChatGPT peut être ancré dans ces faits et peut donner des réponses correctes aux questions liées à ces faits, alors ChatGPT sera plus fiable.

Si nous pouvons trouver un moyen de coupler de grands modèles de langage dans un moteur d'inférence capable d'effectuer correctement le raisonnement et la planification, alors nous pouvons dire que nous avons surmonté un goulot d'étranglement de l'intelligence artificielle. Nous disposons désormais de nombreux algorithmes de planification, mais il est difficile de faire en sorte que ces algorithmes de planification effectuent une planification correcte et raisonnable, comme la construction d'une voiture, et leur fournissent les connaissances requises, car il y a trop de choses à comprendre, et il est très difficile de le faire. Il est difficile de tous les écrire et de s'assurer qu'ils sont tous corrects. Mais les grands modèles linguistiques ont lu tous les livres sur les voitures, et peut-être peuvent-ils nous aider à acquérir les connaissances nécessaires, ou simplement à répondre aux questions nécessaires sur demande, afin que nous puissions capturer toutes ces connaissances lors de la planification.

Au lieu de simplement considérer ChatGPT comme une boîte noire qui vous aide à faire quelque chose, combinez de grands modèles de langage avec des algorithmes de planification et laissez-les devenir l'apport de connaissances du système de planification, ce qui apportera des résultats vraiment utiles. outil . Autant que je sache, il y a déjà des gens qui travaillent dans ce sens, et en cas de succès, ce sera un grand progrès.

Cœur de la machine : En tant qu'enseignant, que pensez-vous de ChatGPT ? Permettez-vous aux étudiants d'utiliser ChatGPT pour générer des articles ? En tant qu'utilisateur, que pensez-vous des différentes applications que ChatGPT a engendrées, notamment les applications commerciales ?

Stuart Russell : Il y a quelques semaines, lorsque je parlais à des hommes d'affaires au Forum économique mondial de Davos, tout le monde me posait des questions sur les grands modèles linguistiques et sur la manière de les utiliser dans leurs problématiques. utiliser ces modèles dans les entreprises.

Je pense que vous pouvez y penser de cette façon : mettriez-vous un enfant de 6 ans au même poste dans votre entreprise ?

Bien qu'il existe des différences de capacités entre les deux, je pense qu'elles peuvent être comparées ainsi. Les grands modèles de langage et ChatGPT ne sont pas dignes de confiance. Ils n’ont aucun bon sens et donneront des informations erronées de manière sérieuse. Donc, si vous comptez utiliser ChatGPT ou un modèle similaire dans votre entreprise, vous devez être très prudent. Si vous considérez certains postes ou responsabilités dans l'entreprise comme des nœuds du réseau, la langue est entrée et sortie dans ces nœuds - bien sûr, vous pouvez voir les choses de cette façon. C'est le cas pour de nombreux emplois, comme celui de journaliste et de professeur. . Une telle chose. Cependant, cela ne signifie pas que vous pouvez les remplacer par ChatGPT.

Nous devons être très prudents en matière d'éducation. L’émergence de ChatGPT a semé la panique chez de nombreuses personnes. Certaines personnes disent, ah, nous devons désactiver ChatGPT dans les écoles. D'autres ont dit que l'interdiction de ChatGPT était ridicule, citant des discussions du 19ème siècle où certaines personnes disaient que nous devions interdire les calculatrices mécaniques parce que si les étudiants commençaient à utiliser des calculatrices mécaniques, ils n'apprendraient jamais les bons calculs.

Cela ne semble-t-il pas convaincant ? Ne semble-t-il pas que nous devons interdire ChatGPT ? Cependant, cette analogie est complètement fausse : une calculatrice mécanique automatise exactement le même processus très mécanique. La multiplication de nombres à 26 chiffres est très mécanique, un ensemble d'instructions, et il suffit de suivre les étapes, étape par étape, étape par étape, pour obtenir la réponse. La valeur intellectuelle du respect des instructions est limitée, surtout si la personne ne comprend pas ce que font les instructions.

Mais ce que ChatGPT remplacera, ce n'est pas le suivi mécanique des instructions, mais la capacité de répondre aux questions, de lire et de comprendre, et d'organiser les idées dans des documents. Si vous ne les apprenez même pas et laissez ChatGPT le faire à votre place, vous risquez vraiment de devenir une personne inutile.

Il existe maintenant des calculatrices électroniques, mais nous enseignons toujours aux enfants l'arithmétique, nous leur enseignons les règles de l'arithmétique, essayons de leur faire comprendre ce que sont les nombres, comment les nombres correspondent aux choses du monde physique, etc. Ce n’est qu’après qu’ils auront acquis cette compréhension et maîtrisé les règles de l’arithmétique que nous leur fournirons des calculatrices électroniques afin qu’ils n’aient pas à suivre des procédures mécaniques.

À notre époque, il n'y avait pas de calculatrices à cette époque. Nous utilisions des tableaux imprimés avec les valeurs de diverses fonctions sinus, cosinus et logarithmiques. Personne n'a jamais dit qu'on ne pouvait pas apprendre en utilisant ces tableaux. Mathématiques.

Nous devons donc déterminer quel est le bon moment pour que les étudiants commencent à utiliser un outil comme ChatGPT. Pour répondre à votre question, si vous pouvez trouver la partie stupide de la tâche de rédaction d'un article - en fait, il arrive souvent que la rédaction d'un article soit insensée, il suffit de répéter mécaniquement des processus fastidieux et ennuyeux - alors vous êtes probablement disponible et ChatGPT est disponible et Cela ne me pose aucun problème.

Cependant, l'écriture n'est pas qu'un processus ennuyeux. L'écriture est essentiellement une sorte de réflexion et une façon pour les gens d'apprendre à penser. La dernière chose que nous voulons, c’est que quelqu’un utilise aveuglément ChatGPT et ne comprenne ni la question ni la réponse.

Comme pour d'autres applications de ChatGPT, comme la génération d'images ou de musique, je pense que la situation est similaire. La clé est de bien distinguer les zones de tâches. Je pense que le processus de création artistique peut être grossièrement divisé en deux parties, d'abord avoir un concept de ce que vous voulez créer, puis le processus relativement mécanique de création réelle basé sur votre vision. Pour certaines personnes, cette dernière étape est très difficile et peu importe leurs efforts, ils ne parviennent pas à réaliser une belle image. Nous avons donc des artistes spécialement formés, en particulier des artistes commerciaux, dont le travail n'implique pas beaucoup de créativité, qui accordent plus d'attention. à la capacité de produire des images selon les besoins. Je pense que c'est une profession qui est très menacée.

J'ai vécu cette expérience lorsque j'écrivais un livre. Il y a cinq à six cents illustrations dans "L'intelligence artificielle : une approche moderne", que j'ai presque toutes dessinées moi-même. Créer une bonne illustration ou un bon diagramme est un processus lent et minutieux qui nécessite beaucoup de compétences et d'habiletés. S'il existait un grand modèle ou une application capable de produire des diagrammes ou des illustrations techniques comme celles de mon livre, je serais heureux de les utiliser.

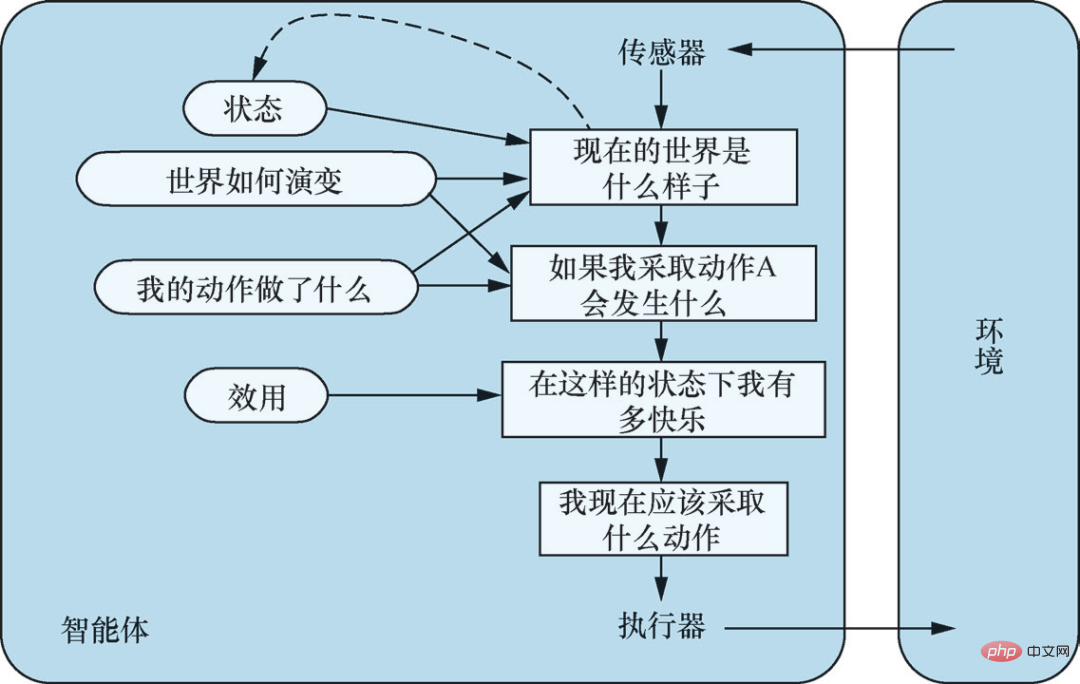

Agent basé sur un modèle et basé sur un utilitaire. Source : « Intelligence artificielle : approches modernes (4e édition) » Illustrations 2-14

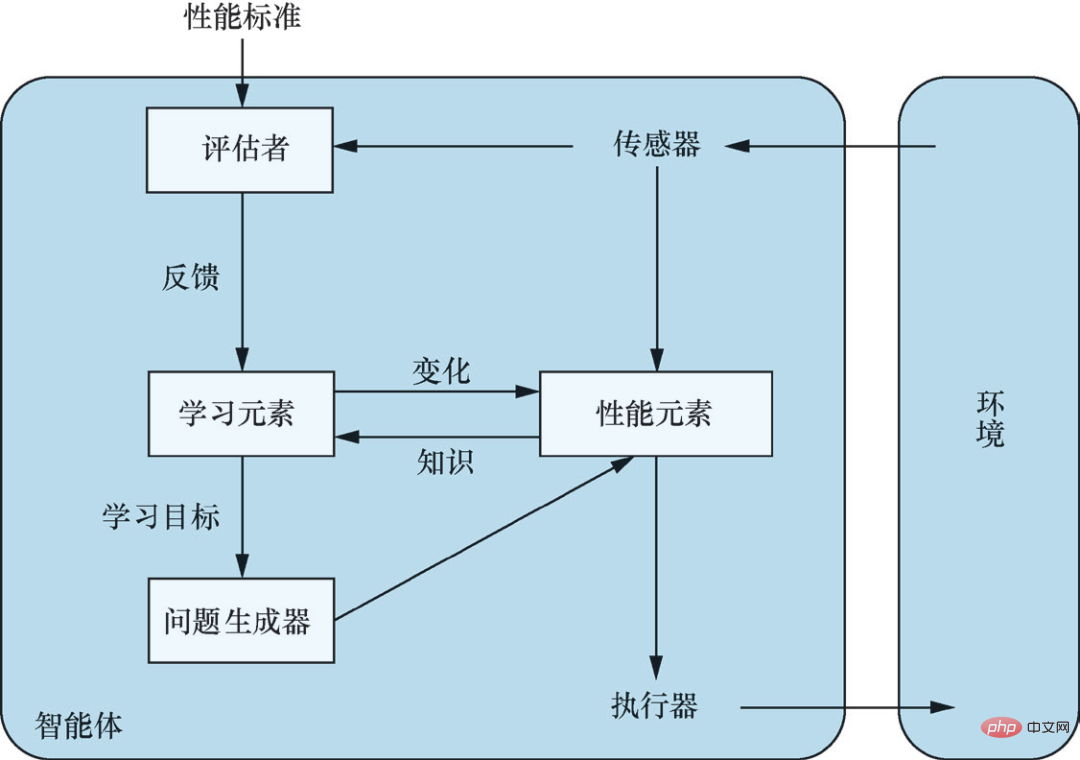

Agent d'apprentissage général. Source : « Intelligence artificielle : méthodes modernes (4e édition) » Illustration 2-15

-2-

Cœur de la machine : Nous ne connaissons pas les principes de ChatGPT, mais grâce à la mise en œuvre de l'ingénierie, nous avons obtenu un outil utile dans certaines situations ; ChatGPT semble également être un bon exemple pour mettre les gens au courant. ChatGPT est-il une amélioration d’un point de vue technique ?

Stuart Russell : Je ne sais pas si ChatGPT peut être appelé ingénierie, car de manière générale, nous considérons « l'ingénierie » comme une discipline qui applique la science de l'ingénierie, combinant la physique, la chimie et la mécanique. , l'électronique et d'autres connaissances sont combinées pour créer quelque chose d'utile aux humains d'une manière complexe et ingénieuse. En même temps, nous comprenons pourquoi ces choses sont utiles, parce que leurs propriétés utiles sont obtenues grâce à des méthodes spécifiques et peuvent être reproduites.

Mais comment avons-nous développé ChatGPT ? L'intégration des commentaires humains est utile, mais à en juger par les résultats, ChatGPT a été obtenu en effectuant une descente de gradient sur un grand nombre d'ensembles de données. Cela me rappelle les années 1950, lorsque beaucoup d’efforts étaient consacrés à la programmation génétique et que les programmes Fortran qui étaient censés atteindre l’intelligence en simulant l’évolution biologique ont lamentablement échoué.

Théoriquement, lorsque vous disposez de suffisamment de programmes Fortran et que vous les laissez générer suffisamment de mutations, il est en principe possible de produire des programmes Fortran plus intelligents que les humains. Mais cette possibilité en principe ne s’est pas concrétisée dans la pratique.

Maintenant tu fais de la descente de gradient sur un circuit assez grand et assez de données et du coup tu peux créer une vraie intelligence ? Je pense que c'est peu probable, peut-être un peu plus que les programmes Fortran évolutifs - mais je ne peux pas dire, peut-être que les programmes Fortran sont plus probables, car il y a des raisons de penser que les programmes Fortran sont une sorte de représentation qui a des capacités plus fortes que les circuits. langage, et lorsqu'ils ont abandonné le programme Fortran en 1958, la puissance de calcul était de 15 ou 16 ordres de grandeur inférieure à celle dont nous disposons aujourd'hui.

Machine Heart : Sans utiliser le mot « projet », que pensez-vous de ce que fait OpenAI ?

Stuart Russell : Ce que fait OpenAI, vous pouvez l'appeler Cookery, car nous ne savons vraiment pas comment fonctionnent ces modèles. Tout comme lorsque je fais un gâteau, je ne sais pas comment il s'est transformé en gâteau. Les êtres humains fabriquent des gâteaux depuis des milliers d'années. Ils ont essayé de nombreuses matières premières différentes et de nombreuses méthodes différentes. , un jour j'ai découvert une chose magique : le gâteau, c'est ça la cuisine. On en sait désormais un peu plus sur les principes sous-jacents du gâteau, mais il n'est toujours pas parfait. Il y a des limites à ce que nous pouvons tirer de la cuisine, et le processus n’a pas une grande valeur intellectuelle.

Et si un jour vous ne parvenez pas à obtenir la réponse que vous souhaitez en tapant des invites ou des instructions en raison de problèmes fondamentaux avec ChatGPT ? Allez-vous encore modifier la recette ? Augmenter le token de 4000 à 5000 et doubler le nombre de couches réseau ? Ce n’est pas de la science et je ne pense pas que ce soit intellectuellement intéressant.

La recherche qui tente de comprendre comment les grands modèles de langage fonctionnent est certainement précieuse, car ChatGPT fait une quantité incroyable de généralisations, et ce n'est qu'en comprenant comment cela se produit que nous pourrons vraiment développer un système d'intelligence significatif. De nombreuses personnes travaillent actuellement sur ce sujet et de nombreux articles ont été publiés à ce sujet.

Mais si le mécanisme interne de ChatGPT peut être compris, je pense que c'est difficile à dire, il est peut-être trop complexe et nous n'avons aucun moyen de procéder à une ingénierie inverse de ce qui se passe à l'intérieur.

Une analogie intéressante est ce qui s'est passé entre les humains et les chiens il y a 30 000 ans. Nous ne comprenons pas comment fonctionne le cerveau d’un chien et il est difficile de comprendre exactement ce qu’il pense, mais nous avons appris à les apprivoiser et les chiens sont désormais intégrés dans nos vies, jouant divers rôles précieux. Nous avons découvert que les chiens sont doués dans de nombreux domaines, notamment s’occuper de la maison et jouer avec les enfants, mais nous ne le faisons pas grâce à l’ingénierie. Nous sélectionnons et améliorons ces caractéristiques par le biais de l’élevage, en peaufinant leurs formules. Mais vous ne vous attendez pas à ce que votre chien écrive votre article à votre place, vous savez qu’il ne peut pas le faire, et vous ne vous attendez probablement pas à ce que votre chien le fasse non plus.

ChatGPT Ce qui est surprenant dans tout cela, c'est que je pense que c'est la première fois que les systèmes d'IA sont vraiment révélés au public, ce qui est un grand changement. OpenAI lui-même a un bon dicton, c'est-à-dire que bien que ChatGPT ne soit pas une véritable intelligence, il permet au corps humain de goûter à la réalisation d'une intelligence réelle (artificielle), et chacun peut utiliser cette intelligence pour faire toutes sortes de choses qu'il veut faire. .

Cœur de la Machine : Un autre point qui préoccupe beaucoup de personnes est la disparition des tâches intermédiaires provoquée par le LLM. Pensez-vous que ces tâches intermédiaires, telles que l’analyse sémantique et l’analyse syntaxique, ont désormais beaucoup de valeur du point de vue de l’itération technique, et vont-elles réellement disparaître à l’avenir ? Les chercheurs et praticiens de l’IA se trouvant au milieu, ceux qui ne disposent pas de ressources matérielles puissantes ou d’une solide connaissance du domaine, risquent-ils de perdre leur emploi ?

Stuart Russell : C'est une bonne question. Le fait est qu'il est difficile de publier des articles sur l'analyse sémantique de nos jours. En fait, il est difficile d'amener les membres de la communauté PNL à écouter quoi que ce soit à moins de parler de grands modèles de langage ou de rafraîchir de grands benchmarks avec de grands modèles. Presque tous les articles portent sur l'actualisation des grands benchmarks. Il est difficile de publier un article qui ne porte pas sur l'actualisation des grands benchmarks, tels que la structure du langage, la compréhension du langage, ou l'analyse sémantique, l'analyse syntaxique, etc., donc les grands benchmarks pour l'évaluation des grands modèles. sont C'est devenu le seul choix pour rédiger des articles, et ces grands repères n'ont rien à voir avec la langue.

Dans un sens, dans le domaine du traitement du langage naturel aujourd'hui, on n'étudie plus le langage, ce qui me semble très regrettable. Il en va de même pour la vision par ordinateur. Aujourd’hui, dans la plupart des recherches sur la vision par ordinateur, nous n’étudions plus la vision, nous étudions uniquement la précision des données, de la formation et des prédictions.

Quant à la manière de développer ensuite l'IA, je pense que nous devrions nous concentrer sur des méthodes que nous comprenons, en nous concentrant sur les connaissances et le raisonnement logique. La raison est double. Premièrement, nous voulons que les systèmes d’IA soient fiables, nous devons garantir mathématiquement qu’ils sont sûrs et contrôlables, et cela signifie que nous devons comprendre les systèmes que nous construisons.

Deuxièmement, réfléchissez-y du point de vue de l'efficacité des données, qui sera nécessaire pour atteindre l'intelligence générale, le cerveau humain fonctionnant à 20 watts au lieu de 20 mégawatts. Les circuits ne sont pas un langage très expressif, l'efficacité des données de ces algorithmes est bien inférieure à celle de l'apprentissage humain, et vous auriez du mal à écrire une grande partie de ce que nous savons sur le monde dans les circuits. Une fois que nous avons eu des ordinateurs et des langages de programmation à usage général, nous avons arrêté d'utiliser des circuits car il était beaucoup plus simple et plus facile à utiliser pour exprimer ce que nous voulions dans un programme, ce que la communauté de l'IA a largement oublié à un moment donné. égaré.

-3-

Cœur de la machine : La quatrième édition de "Intelligence artificielle : approches modernes" comporte une mise à jour importante, à savoir qu'elle ne suppose plus que les systèmes ou les agents d'IA ont des objectifs fixes. Auparavant, le but de l'intelligence artificielle était défini comme « créer des systèmes qui tentent de maximiser l'utilité attendue, avec des objectifs fixés par les humains ». Aujourd'hui, nous ne fixons plus d'objectifs aux systèmes d'IA. Pourquoi un tel changement ?

Stuart Russell : Il y a plusieurs raisons. Premièrement, à mesure que l’intelligence artificielle quitte le laboratoire pour entrer dans le monde réel, nous avons du mal à définir correctement nos objectifs. Par exemple, lorsque vous conduisez sur la route, vous voulez arriver rapidement à votre destination, mais cela ne signifie pas que vous devriez conduire à 200 milles à l'heure, et si vous dites à une voiture autonome de donner la priorité à la sécurité, il pourrait finir par rester garé pour toujours dans un garage à l’intérieur. Il existe des compromis entre les objectifs d'arriver à destination en toute sécurité et rapidement, et d'être amical avec les autres conducteurs, de ne pas mettre les passagers mal à l'aise, de se conformer aux lois et réglementations, etc. Il y a toujours des risques sur la route et des accidents inévitables se produiront. Il est difficile d'écrire tous vos objectifs lorsque vous conduisez, et conduire n'est qu'une chose petite et simple dans la vie. Par conséquent, d’un point de vue pratique, fixer des objectifs aux systèmes d’IA n’est pas raisonnable.

La seconde concerne l'exemple du roi Midas (Problème du roi Midas) que j'ai donné dans le livre. Midas était un roi dans la mythologie grecque. Il était très gourmand et demandait à Dieu de lui donner le pouvoir de tout transformer en or. Dieu exauça son souhait et tout ce qu'il touchait se transforma en or, mais plus tard, il obtint de l'eau et de la nourriture. s'est également transformé en or, et les membres de sa famille se sont également transformés en or après avoir été touchés par lui. Finalement, il est mort tragiquement entouré d'or. Cela nous rappelle que lorsque vous définissez des objectifs pour des systèmes très puissants, vous feriez mieux de vous assurer que les objectifs que vous définissez sont absolument corrects. Mais maintenant que nous savons que nous ne pouvons pas faire cela, il devient de plus en plus important, à mesure que les systèmes d’IA deviennent plus puissants, de ne pas savoir quels sont leurs véritables objectifs.

Les objectifs sont en fait une chose très compliquée. Par exemple, si je dis que je veux acheter une orange pour le déjeuner, cela peut être un objectif, non ? Dans les contextes quotidiens, un objectif est considéré comme quelque chose qui peut être atteint, et une fois atteint, il est atteint. Mais dans la théorie du choix rationnel définie par la philosophie et l’économie, un tel objectif n’existe pas. Ce que nous avons, ce sont des préférences ou des classements de divers futurs possibles. Chaque avenir possible s’étend d’aujourd’hui jusqu’à la fin des temps. Il contient tout ce qui existe dans l’univers. Je pense qu’il s’agit d’une compréhension plus complexe et plus profonde du but, de ce que veulent réellement les humains.

Cœur de la Machine : Quel impact cette transformation aura-t-elle sur le développement futur de l'intelligence artificielle ?

Stuart Russell : Depuis la naissance de l'intelligence artificielle avec l'informatique dans les années 1940 et 1950, les chercheurs ont besoin d'avoir un concept d'intelligence pour pouvoir mener des recherches basées sur celui-ci. Alors que certains des premiers travaux visaient davantage à imiter la cognition humaine, c’est le concept de rationalité qui a finalement pris le dessus : plus une machine peut atteindre ses objectifs par l’action, plus nous la considérons comme intelligente.

Dans le modèle standard de l'intelligence artificielle, c'est le type de machine que nous nous efforçons de créer ; les humains définissent l'objectif et la machine fait le reste. Par exemple, pour un système de solution dans un environnement déterministe, nous donnons une fonction de coût et un critère d'objectif pour permettre à la machine de trouver la séquence d'action avec le plus petit coût pour atteindre l'état objectif, pour un système d'apprentissage par renforcement dans un environnement stochastique ; donnez une fonction de récompense et un facteur de remise, laissez la machine apprendre une stratégie qui maximise la somme de récompense de remise attendue. Cette approche peut également être observée en dehors du domaine de l’intelligence artificielle : les spécialistes du contrôle minimisent les fonctions de coût, les chercheurs opérationnels maximisent les récompenses, les statisticiens minimisent les fonctions de perte attendue et les économistes maximisent l’utilité individuelle ou le bien-être d’un groupe.

Mais le modèle standard est en réalité faux. Comme je viens de le dire, il nous est presque impossible de spécifier nos objectifs de manière complètement correcte, et lorsque les objectifs de la machine ne correspondent pas à ce que nous voulons réellement, nous risquons de perdre le contrôle de la machine car la machine prendra des mesures de manière préventive et fera tout ce qu'elle veut. prend. Le prix garantit qu’il atteint ses objectifs déclarés. Presque tous les systèmes d'IA existants sont développés dans le cadre de modèles standards, ce qui crée de gros problèmes.

Dans "Artificial Intelligence: Modern Approach (4th Edition)", nous avons proposé que l'intelligence artificielle nécessite de nouveaux modèles, Les nouveaux modèles soulignent l'incertitude de la cible du système d'IA, cette incertitude permet à la machine pour connaître les préférences humaines et rechercher les opinions humaines avant d'agir. Pendant le fonctionnement du système d'IA, certaines informations doivent circuler de l'humain vers la machine qui illustrent les véritables préférences de l'humain, plutôt que que les objectifs de l'humain ne deviennent inutiles une fois qu'ils sont initialement fixés. Cela nécessite de découpler les machines des objectifs fixes et un couplage binaire entre les machines et les humains. Le modèle standard peut être considéré comme un cas extrême, dans lequel une machine peut spécifier correctement un objectif humain souhaité, comme jouer au Go ou résoudre un casse-tête, dans le cadre de la machine.

Nous fournissons également quelques exemples dans le livre pour illustrer le fonctionnement du nouveau modèle, comme des préférences incertaines, un problème d'interrupteur, un jeu d'assistance, etc. Mais ce n’est qu’un début, et nous venons tout juste de commencer à les étudier.

Cœur de la Machine : Dans le domaine en plein développement de l'intelligence artificielle, comment suivre les tendances technologiques sans courir après aveuglément les points chauds ? Que doivent garder à l’esprit les chercheurs et les praticiens de l’IA ?

Stuart Russell : Pour construire un système véritablement intelligent, je pense que le problème fondamental est de pouvoir utiliser un langage représentationnel pour représenter les différentes irrégularités contenues dans l'univers. La différence essentielle entre l'intelligence et les circuits est que, à notre connaissance, les circuits ne peuvent pas bien représenter ces irrégularités, ce qui se manifeste en pratique par une extrême inefficacité des données.

Pour donner un exemple simple, je pourrais écrire la définition de la fonction sinus (avec une formule mathématique), ou je pourrais essayer de décrire la fonction sinus de manière empirique en utilisant un grand nombre de pixels. Si je n'ai que 10 millions de pixels, je ne peux couvrir qu'une partie de la fonction sinusoïdale, et si je regarde la zone que j'ai couverte, il me semble avoir un assez bon modèle de la fonction sinusoïdale. Mais en fait, je ne comprends pas vraiment la fonction sinusoïdale, je ne connais pas la forme de la fonction et je ne connais pas ses propriétés mathématiques.

Je crains que nous nous trompions en pensant que nous nous dirigeons vers la véritable intelligence. Tout ce que nous faisons, c'est ajouter de plus en plus de pixels à quelque chose qui n'est pas du tout un modèle intelligent.

Je pense que lors de la construction de systèmes d'IA, nous devons nous concentrer sur des méthodes dotées de capacités de représentation de base, dont le cœur réside dans la capacité de déclarer tous les objets. Supposons que je veuille écrire les règles de Go. Ensuite, ces règles doivent s'appliquer à chaque carré du tableau. Je peux également dire ce qui arrivera à chaque y pour chaque x. Je peux également l'écrire en C++ ou en Python. Écrit en anglais, rédigé en logique du premier ordre. Chacun de ces langages me permet d'écrire des règles de manière très concise car ils ont tous le pouvoir expressif d'exprimer ces règles. Cependant, je ne peux pas faire cela dans les circuits, les représentations basées sur des circuits (y compris les systèmes d'apprentissage profond) ne peuvent pas représenter cette classe de généralisations.

Ignorer ce fait et essayer d'atteindre l'intelligence grâce au Big Data est ridicule à mon avis, c'est comme dire qu'il n'est pas nécessaire de comprendre ce qu'est une pièce Go parce que nous avons des milliards d'échantillons d'entraînement. Si vous pensez à ce que l’intelligence humaine a fait, nous avons construit LIGO et détecté des ondes gravitationnelles provenant de l’autre côté de l’univers. Comment avons-nous fait ? Basé sur la connaissance et le raisonnement. Avant de créer LIGO, où avons-nous collecté des échantillons de formation ? De toute évidence, les prédécesseurs ont appris certaines choses, y compris leurs expériences sensorielles, puis les ont enregistrées dans des langages expressifs tels que l'anglais et les mathématiques. Nous avons appris d'eux, compris les lois de l'univers et effectué un raisonnement et une ingénierie basés sur celles-ci. design, etc., observant ainsi une collision de trous noirs à l'autre bout de l'univers.

Bien sûr, il est possible d'obtenir une intelligence basée sur le Big Data. Il est également possible de faire évoluer un programme Fortran plus intelligent que les humains. Mais nous avons passé plus de deux mille ans à comprendre la connaissance et le raisonnement, et avons développé un grand nombre d'excellentes technologies basées sur la connaissance et le raisonnement, et des milliers d'applications utiles ont été développées sur la base de ces technologies. Maintenant, vous vous intéressez à l’intelligence mais pas à la connaissance et au raisonnement, je n’ai rien à dire là-dessus.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

Video Face Swap

Échangez les visages dans n'importe quelle vidéo sans effort grâce à notre outil d'échange de visage AI entièrement gratuit !

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Sujets chauds

1654

1654

14

14

1413

1413

52

52

1306

1306

25

25

1252

1252

29

29

1225

1225

24

24

Quelles sont les dix principales applications de trading de devises virtuelles? Le dernier classement de change de monnaie numérique

Apr 28, 2025 pm 08:03 PM

Quelles sont les dix principales applications de trading de devises virtuelles? Le dernier classement de change de monnaie numérique

Apr 28, 2025 pm 08:03 PM

Les dix premiers échanges de devises numériques tels que Binance, OKX, Gate.io ont amélioré leurs systèmes, des transactions diversifiées efficaces et des mesures de sécurité strictes.

Laquelle des dix principales plateformes de trading de devises au monde est la dernière version des dix principales plateformes de trading de devises

Apr 28, 2025 pm 08:09 PM

Laquelle des dix principales plateformes de trading de devises au monde est la dernière version des dix principales plateformes de trading de devises

Apr 28, 2025 pm 08:09 PM

Les dix principales plates-formes de trading de crypto-monnaie au monde comprennent Binance, Okx, Gate.io, Coinbase, Kraken, Huobi Global, BitFinex, Bittrex, Kucoin et Poloniex, qui fournissent toutes une variété de méthodes de trading et de puissantes mesures de sécurité.

Recommandés plates-formes fiables de trading de devises numériques. Top 10 des échanges de devises numériques dans le monde. 2025

Apr 28, 2025 pm 04:30 PM

Recommandés plates-formes fiables de trading de devises numériques. Top 10 des échanges de devises numériques dans le monde. 2025

Apr 28, 2025 pm 04:30 PM

Plate-forme de trading de devises numériques fiables recommandées: 1. Okx, 2. Binance, 3. Coinbase, 4. Kraken, 5. Huobi, 6. Kucoin, 7. Bitfinex, 8. Gemini, 9. Bitstamp, 10. Poloniex, ces plates-formes sont connu

Quelles sont les principales plateformes de trading de devises? Les 10 meilleurs échanges de devises virtuels virtuels

Apr 28, 2025 pm 08:06 PM

Quelles sont les principales plateformes de trading de devises? Les 10 meilleurs échanges de devises virtuels virtuels

Apr 28, 2025 pm 08:06 PM

Actuellement classé parmi les dix premiers échanges de devises virtuels: 1. Binance, 2. Okx, 3. Gate.io, 4. Coin Library, 5. Siren, 6. Huobi Global Station, 7. Bybit, 8. Kucoin, 9. Bitcoin, 10. Bit Stamp.

Decryption Gate.io Strategy Medgrade: Comment redéfinir la gestion des actifs cryptographiques dans Memebox 2.0?

Apr 28, 2025 pm 03:33 PM

Decryption Gate.io Strategy Medgrade: Comment redéfinir la gestion des actifs cryptographiques dans Memebox 2.0?

Apr 28, 2025 pm 03:33 PM

Memebox 2.0 redéfinit la gestion des actifs cryptographiques grâce à une architecture innovante et à des percées de performance. 1) Il résout trois principaux points de douleur: les silos d'actifs, la désintégration du revenu et le paradoxe de la sécurité et de la commodité. 2) Grâce à des pôles d'actifs intelligents, à la gestion des risques dynamiques et aux moteurs d'amélioration du rendement, la vitesse de transfert croisée, le taux de rendement moyen et la vitesse de réponse aux incidents de sécurité sont améliorés. 3) Fournir aux utilisateurs la visualisation des actifs, l'automatisation des politiques et l'intégration de la gouvernance, réalisant la reconstruction de la valeur utilisateur. 4) Grâce à la collaboration écologique et à l'innovation de la conformité, l'efficacité globale de la plate-forme a été améliorée. 5) À l'avenir, les pools d'assurance-contrat intelligents, l'intégration du marché des prévisions et l'allocation d'actifs axés sur l'IA seront lancés pour continuer à diriger le développement de l'industrie.

Combien vaut le bitcoin

Apr 28, 2025 pm 07:42 PM

Combien vaut le bitcoin

Apr 28, 2025 pm 07:42 PM

Le prix de Bitcoin varie de 20 000 $ à 30 000 $. 1. Le prix de Bitcoin a radicalement fluctué depuis 2009, atteignant près de 20 000 $ en 2017 et près de 60 000 $ en 2021. 2. Les prix sont affectés par des facteurs tels que la demande du marché, l'offre et l'environnement macroéconomique. 3. Obtenez des prix en temps réel via les échanges, les applications mobiles et les sites Web. 4. Le prix du bitcoin est très volatil, tiré par le sentiment du marché et les facteurs externes. 5. Il a une certaine relation avec les marchés financiers traditionnels et est affecté par les marchés boursiers mondiaux, la force du dollar américain, etc. 6. La tendance à long terme est optimiste, mais les risques doivent être évalués avec prudence.

Laquelle des dix principales plateformes de trading de devises au monde figurent parmi les dix principales plateformes de trading de devises en 2025

Apr 28, 2025 pm 08:12 PM

Laquelle des dix principales plateformes de trading de devises au monde figurent parmi les dix principales plateformes de trading de devises en 2025

Apr 28, 2025 pm 08:12 PM

Les dix premiers échanges de crypto-monnaie au monde en 2025 incluent Binance, Okx, Gate.io, Coinbase, Kraken, Huobi, Bitfinex, Kucoin, Bittrex et Poloniex, qui sont tous connus pour leur volume et leur sécurité commerciaux élevés.

Comment utiliser la bibliothèque Chrono en C?

Apr 28, 2025 pm 10:18 PM

Comment utiliser la bibliothèque Chrono en C?

Apr 28, 2025 pm 10:18 PM

L'utilisation de la bibliothèque Chrono en C peut vous permettre de contrôler plus précisément les intervalles de temps et de temps. Explorons le charme de cette bibliothèque. La bibliothèque Chrono de C fait partie de la bibliothèque standard, qui fournit une façon moderne de gérer les intervalles de temps et de temps. Pour les programmeurs qui ont souffert de temps et ctime, Chrono est sans aucun doute une aubaine. Il améliore non seulement la lisibilité et la maintenabilité du code, mais offre également une précision et une flexibilité plus élevées. Commençons par les bases. La bibliothèque Chrono comprend principalement les composants clés suivants: std :: chrono :: system_clock: représente l'horloge système, utilisée pour obtenir l'heure actuelle. std :: chron