Périphériques technologiques

Périphériques technologiques

IA

IA

Un guide en dix étapes pour choisir un excellent modèle d'apprentissage automatique

Un guide en dix étapes pour choisir un excellent modèle d'apprentissage automatique

Un guide en dix étapes pour choisir un excellent modèle d'apprentissage automatique

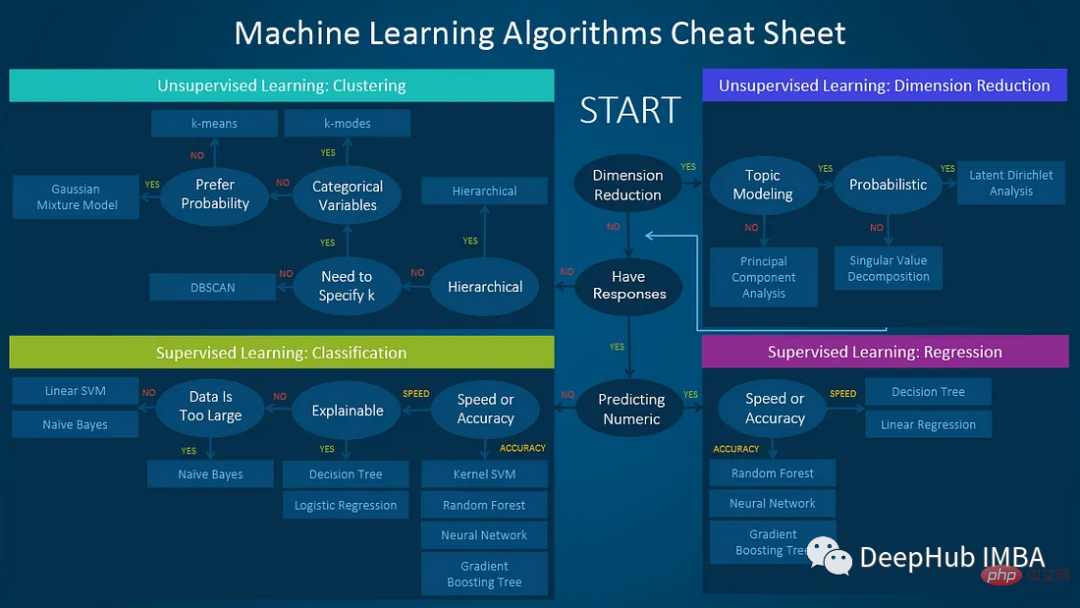

L'apprentissage automatique peut être utilisé pour résoudre un large éventail de problèmes. Mais il y a tellement de modèles différents parmi lesquels choisir qu’il peut être difficile de savoir lequel convient le mieux. Le résumé de cet article vous aidera à choisir le modèle de machine learning le plus adapté à vos besoins.

1. Déterminez le problème que vous souhaitez résoudre

La première étape consiste à déterminer le problème que vous souhaitez résoudre : s'agit-il d'un problème de régression, de classification ou de clustering que vous souhaitez résoudre ? et décidez lequel choisir comme type de modèle.

Quel type de problème souhaitez-vous résoudre ?

Problème de classification : régression logistique, classificateur d'arbre de décision, classificateur de forêt aléatoire, machine à vecteurs de support (SVM), classificateur naïf de Bayes ou réseau de neurones.

Problème de clustering : clustering k-means, clustering hiérarchique ou DBSCAN.

2. Tenez compte de la taille et de la nature de l'ensemble de données

a) Taille de l'ensemble de données

Si vous disposez d'un petit ensemble de données, choisissez un modèle moins complexe, tel que la régression linéaire. Pour des ensembles de données plus volumineux, des modèles plus complexes tels que la forêt aléatoire ou l’apprentissage profond peuvent convenir.

Comment juger de la taille de l'ensemble de données :

- Grands ensembles de données (des milliers à des millions de lignes) : boosting de gradient, réseau neuronal ou modèle d'apprentissage profond.

- Petits ensembles de données (moins de 1000 lignes) : régression logistique, arbre de décision ou Bayes naïf.

b) Les données étiquetées

data ont des résultats prédéterminés, contrairement aux données non étiquetées. Si les données sont étiquetées, des algorithmes d’apprentissage supervisé tels que la régression logistique ou les arbres de décision sont généralement utilisés. Les données non étiquetées nécessitent des algorithmes d'apprentissage non supervisés tels que les k-moyennes ou l'analyse en composantes principales (ACP).

c) Nature des fonctionnalités

Si vos fonctionnalités sont de type catégoriel, vous devrez peut-être utiliser des arbres de décision ou des Bayes naïfs. Pour les caractéristiques numériques, la régression linéaire ou les machines à vecteurs de support (SVM) peuvent être plus adaptées.

- Caractéristiques de classification : arbre de décision, forêt aléatoire, Bayes naïf.

- Caractéristiques numériques : régression linéaire, régression logistique, machine à vecteurs de support, réseau neuronal, clustering k-means.

- Fonctionnalités mixtes : arbres de décision, forêts aléatoires, machines à vecteurs de support, réseaux de neurones.

d) Données séquentielles

Si vous traitez des données séquentielles, telles que des séries temporelles ou un langage naturel, vous devrez peut-être utiliser des réseaux de neurones récurrents (rnn) ou de la mémoire à long terme (LSTM), des transformateurs, etc.

e) Valeurs manquantes

Il existe de nombreuses valeurs manquantes qui peuvent être utilisées : arbres de décision, forêts aléatoires, clustering k-means. Si les valeurs manquantes ne sont pas correctes, vous pouvez envisager la régression linéaire, la régression logistique, la machine à vecteurs de support et le réseau neuronal.

3. Qu'est-ce qui est le plus important : l'interprétabilité ou la précision ?

Certains modèles d'apprentissage automatique sont plus faciles à expliquer que d'autres. Si vous avez besoin d'expliquer les résultats du modèle, vous pouvez choisir des modèles tels que des arbres de décision ou une régression logistique. Si la précision est plus critique, des modèles plus complexes tels que la forêt aléatoire ou l’apprentissage profond peuvent être plus adaptés.

4. Classes déséquilibrées

Si vous avez affaire à des classes déséquilibrées, vous souhaiterez peut-être utiliser des modèles tels que des forêts aléatoires, des machines vectorielles de support ou des réseaux de neurones pour résoudre ce problème.

Gestion des valeurs manquantes dans vos données

Si vous avez des valeurs manquantes dans votre ensemble de données, vous souhaiterez peut-être envisager des techniques d'imputation ou des modèles capables de gérer les valeurs manquantes, tels que les K-voisins les plus proches (KNN) ou les arbres de décision. .

5. Complexité des données

S'il peut exister des relations non linéaires entre les variables, des modèles plus complexes tels que des réseaux de neurones ou des machines à vecteurs de support doivent être utilisés.

- Faible complexité : régression linéaire, régression logistique.

- Complexité moyenne : arbre de décision, forêt aléatoire, Bayes naïf.

- Haute complexité : réseau neuronal, support machine à vecteurs.

6. Équilibrer vitesse et précision

Si vous souhaitez considérer le compromis entre vitesse et précision, les modèles plus complexes peuvent être plus lents, mais ils peuvent également offrir une plus grande précision.

- La vitesse est plus importante : arbres de décision, Bayes naïfs, régression logistique, clustering k-means.

- La précision est plus importante : réseau de neurones, forêt aléatoire, machine à vecteurs de support.

7. Données et bruit de grande dimension

Si vous souhaitez traiter des données de grande dimension ou des données bruyantes, vous devrez peut-être utiliser des techniques de réduction de dimensionnalité (telles que PCA) ou des modèles capables de gérer le bruit (tels que KNN ou arbres de décision).

- Faible bruit : régression linéaire, régression logistique.

- Bruit modéré : arbres de décision, forêts aléatoires, clustering k-means.

- Bruit élevé : réseau neuronal, support machine vectorielle.

8. Prédiction en temps réel

Si vous avez besoin de prédiction en temps réel, vous devez choisir un modèle tel qu'un arbre de décision ou une machine à vecteurs de support.

9. Gérer les valeurs aberrantes

Si les données contiennent de nombreuses valeurs aberrantes, vous pouvez choisir un modèle robuste comme svm ou random forest.

- Modèles sensibles aux valeurs aberrantes : régression linéaire, régression logistique.

- Modèles très robustes : arbres de décision, forêts aléatoires, machines à vecteurs de support.

10. Difficulté de déploiement

Le but ultime du modèle est de déployer en ligne, la difficulté de déploiement est donc la considération finale :

Certains modèles simples, tels que la régression linéaire, la régression logistique, l'arbre de décision, etc., peuvent être relativement facilement déployés Déployés dans des environnements de production car ils ont une petite taille de modèle, une faible complexité et une faible surcharge de calcul. Sur des ensembles de données à grande échelle, de grande dimension, non linéaires et autres ensembles de données complexes, les performances de ces modèles peuvent être limitées, nécessitant des modèles plus avancés, tels que des réseaux neuronaux, des machines à vecteurs de support, etc. Par exemple, dans des domaines tels que la reconnaissance d'images et de parole, les ensembles de données peuvent nécessiter un traitement et un prétraitement approfondis, ce qui peut rendre le déploiement du modèle plus difficile.

Résumé

Choisir le bon modèle d'apprentissage automatique peut être une tâche difficile qui nécessite de faire des compromis en fonction du problème spécifique, des données, de la vitesse, de l'interprétabilité, du déploiement, etc. et de choisir l'algorithme le plus approprié en fonction des besoins. En suivant ces directives, vous pouvez vous assurer que votre modèle d'apprentissage automatique est bien adapté à votre cas d'utilisation spécifique et peut vous fournir les informations et les prédictions dont vous avez besoin.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

Video Face Swap

Échangez les visages dans n'importe quelle vidéo sans effort grâce à notre outil d'échange de visage AI entièrement gratuit !

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Sujets chauds

Cet article vous amènera à comprendre SHAP : explication du modèle pour l'apprentissage automatique

Jun 01, 2024 am 10:58 AM

Cet article vous amènera à comprendre SHAP : explication du modèle pour l'apprentissage automatique

Jun 01, 2024 am 10:58 AM

Dans les domaines de l’apprentissage automatique et de la science des données, l’interprétabilité des modèles a toujours été au centre des préoccupations des chercheurs et des praticiens. Avec l'application généralisée de modèles complexes tels que l'apprentissage profond et les méthodes d'ensemble, la compréhension du processus décisionnel du modèle est devenue particulièrement importante. Explainable AI|XAI contribue à renforcer la confiance dans les modèles d'apprentissage automatique en augmentant la transparence du modèle. L'amélioration de la transparence des modèles peut être obtenue grâce à des méthodes telles que l'utilisation généralisée de plusieurs modèles complexes, ainsi que les processus décisionnels utilisés pour expliquer les modèles. Ces méthodes incluent l'analyse de l'importance des caractéristiques, l'estimation de l'intervalle de prédiction du modèle, les algorithmes d'interprétabilité locale, etc. L'analyse de l'importance des fonctionnalités peut expliquer le processus de prise de décision du modèle en évaluant le degré d'influence du modèle sur les fonctionnalités d'entrée. Estimation de l’intervalle de prédiction du modèle

Identifier le surapprentissage et le sous-apprentissage grâce à des courbes d'apprentissage

Apr 29, 2024 pm 06:50 PM

Identifier le surapprentissage et le sous-apprentissage grâce à des courbes d'apprentissage

Apr 29, 2024 pm 06:50 PM

Cet article présentera comment identifier efficacement le surajustement et le sous-apprentissage dans les modèles d'apprentissage automatique grâce à des courbes d'apprentissage. Sous-ajustement et surajustement 1. Surajustement Si un modèle est surentraîné sur les données de sorte qu'il en tire du bruit, alors on dit que le modèle est en surajustement. Un modèle surajusté apprend chaque exemple si parfaitement qu'il classera mal un exemple inédit/inédit. Pour un modèle surajusté, nous obtiendrons un score d'ensemble d'entraînement parfait/presque parfait et un score d'ensemble/test de validation épouvantable. Légèrement modifié : "Cause du surajustement : utilisez un modèle complexe pour résoudre un problème simple et extraire le bruit des données. Parce qu'un petit ensemble de données en tant qu'ensemble d'entraînement peut ne pas représenter la représentation correcte de toutes les données."

Transparent! Une analyse approfondie des principes des principaux modèles de machine learning !

Apr 12, 2024 pm 05:55 PM

Transparent! Une analyse approfondie des principes des principaux modèles de machine learning !

Apr 12, 2024 pm 05:55 PM

En termes simples, un modèle d’apprentissage automatique est une fonction mathématique qui mappe les données d’entrée à une sortie prédite. Plus précisément, un modèle d'apprentissage automatique est une fonction mathématique qui ajuste les paramètres du modèle en apprenant à partir des données d'entraînement afin de minimiser l'erreur entre la sortie prédite et la véritable étiquette. Il existe de nombreux modèles dans l'apprentissage automatique, tels que les modèles de régression logistique, les modèles d'arbre de décision, les modèles de machines à vecteurs de support, etc. Chaque modèle a ses types de données et ses types de problèmes applicables. Dans le même temps, il existe de nombreux points communs entre les différents modèles, ou il existe une voie cachée pour l’évolution du modèle. En prenant comme exemple le perceptron connexionniste, en augmentant le nombre de couches cachées du perceptron, nous pouvons le transformer en un réseau neuronal profond. Si une fonction noyau est ajoutée au perceptron, elle peut être convertie en SVM. celui-ci

L'évolution de l'intelligence artificielle dans l'exploration spatiale et l'ingénierie des établissements humains

Apr 29, 2024 pm 03:25 PM

L'évolution de l'intelligence artificielle dans l'exploration spatiale et l'ingénierie des établissements humains

Apr 29, 2024 pm 03:25 PM

Dans les années 1950, l’intelligence artificielle (IA) est née. C’est à ce moment-là que les chercheurs ont découvert que les machines pouvaient effectuer des tâches similaires à celles des humains, comme penser. Plus tard, dans les années 1960, le Département américain de la Défense a financé l’intelligence artificielle et créé des laboratoires pour poursuivre son développement. Les chercheurs trouvent des applications à l’intelligence artificielle dans de nombreux domaines, comme l’exploration spatiale et la survie dans des environnements extrêmes. L'exploration spatiale est l'étude de l'univers, qui couvre l'ensemble de l'univers au-delà de la terre. L’espace est classé comme environnement extrême car ses conditions sont différentes de celles de la Terre. Pour survivre dans l’espace, de nombreux facteurs doivent être pris en compte et des précautions doivent être prises. Les scientifiques et les chercheurs pensent qu'explorer l'espace et comprendre l'état actuel de tout peut aider à comprendre le fonctionnement de l'univers et à se préparer à d'éventuelles crises environnementales.

Implémentation d'algorithmes d'apprentissage automatique en C++ : défis et solutions courants

Jun 03, 2024 pm 01:25 PM

Implémentation d'algorithmes d'apprentissage automatique en C++ : défis et solutions courants

Jun 03, 2024 pm 01:25 PM

Les défis courants rencontrés par les algorithmes d'apprentissage automatique en C++ incluent la gestion de la mémoire, le multithread, l'optimisation des performances et la maintenabilité. Les solutions incluent l'utilisation de pointeurs intelligents, de bibliothèques de threads modernes, d'instructions SIMD et de bibliothèques tierces, ainsi que le respect des directives de style de codage et l'utilisation d'outils d'automatisation. Des cas pratiques montrent comment utiliser la bibliothèque Eigen pour implémenter des algorithmes de régression linéaire, gérer efficacement la mémoire et utiliser des opérations matricielles hautes performances.

Cinq écoles d'apprentissage automatique que vous ne connaissez pas

Jun 05, 2024 pm 08:51 PM

Cinq écoles d'apprentissage automatique que vous ne connaissez pas

Jun 05, 2024 pm 08:51 PM

L'apprentissage automatique est une branche importante de l'intelligence artificielle qui donne aux ordinateurs la possibilité d'apprendre à partir de données et d'améliorer leurs capacités sans être explicitement programmés. L'apprentissage automatique a un large éventail d'applications dans divers domaines, de la reconnaissance d'images et du traitement du langage naturel aux systèmes de recommandation et à la détection des fraudes, et il change notre façon de vivre. Il existe de nombreuses méthodes et théories différentes dans le domaine de l'apprentissage automatique, parmi lesquelles les cinq méthodes les plus influentes sont appelées les « Cinq écoles d'apprentissage automatique ». Les cinq grandes écoles sont l’école symbolique, l’école connexionniste, l’école évolutionniste, l’école bayésienne et l’école analogique. 1. Le symbolisme, également connu sous le nom de symbolisme, met l'accent sur l'utilisation de symboles pour le raisonnement logique et l'expression des connaissances. Cette école de pensée estime que l'apprentissage est un processus de déduction inversée, à travers les connaissances existantes.

Flash Attention est-il stable ? Meta et Harvard ont constaté que les écarts de poids de leur modèle fluctuaient de plusieurs ordres de grandeur.

May 30, 2024 pm 01:24 PM

Flash Attention est-il stable ? Meta et Harvard ont constaté que les écarts de poids de leur modèle fluctuaient de plusieurs ordres de grandeur.

May 30, 2024 pm 01:24 PM

MetaFAIR s'est associé à Harvard pour fournir un nouveau cadre de recherche permettant d'optimiser le biais de données généré lors de l'apprentissage automatique à grande échelle. On sait que la formation de grands modèles de langage prend souvent des mois et utilise des centaines, voire des milliers de GPU. En prenant comme exemple le modèle LLaMA270B, sa formation nécessite un total de 1 720 320 heures GPU. La formation de grands modèles présente des défis systémiques uniques en raison de l’ampleur et de la complexité de ces charges de travail. Récemment, de nombreuses institutions ont signalé une instabilité dans le processus de formation lors de la formation des modèles d'IA générative SOTA. Elles apparaissent généralement sous la forme de pics de pertes. Par exemple, le modèle PaLM de Google a connu jusqu'à 20 pics de pertes au cours du processus de formation. Le biais numérique est à l'origine de cette imprécision de la formation,

Afin de fournir un nouveau système de référence et d'évaluation de questions-réponses scientifiques et complexes pour les grands modèles, l'UNSW, Argonne, l'Université de Chicago et d'autres institutions ont lancé conjointement le cadre SciQAG.

Jul 25, 2024 am 06:42 AM

Afin de fournir un nouveau système de référence et d'évaluation de questions-réponses scientifiques et complexes pour les grands modèles, l'UNSW, Argonne, l'Université de Chicago et d'autres institutions ont lancé conjointement le cadre SciQAG.

Jul 25, 2024 am 06:42 AM

L'ensemble de données ScienceAI Question Answering (QA) joue un rôle essentiel dans la promotion de la recherche sur le traitement du langage naturel (NLP). Des ensembles de données d'assurance qualité de haute qualité peuvent non seulement être utilisés pour affiner les modèles, mais également évaluer efficacement les capacités des grands modèles linguistiques (LLM), en particulier la capacité à comprendre et à raisonner sur les connaissances scientifiques. Bien qu’il existe actuellement de nombreux ensembles de données scientifiques d’assurance qualité couvrant la médecine, la chimie, la biologie et d’autres domaines, ces ensembles de données présentent encore certaines lacunes. Premièrement, le formulaire de données est relativement simple, et la plupart sont des questions à choix multiples. Elles sont faciles à évaluer, mais limitent la plage de sélection des réponses du modèle et ne peuvent pas tester pleinement la capacité du modèle à répondre aux questions scientifiques. En revanche, les questions et réponses ouvertes