Périphériques technologiques

Périphériques technologiques

IA

IA

Résumé de fin d'année Google AI n°6 : Comment se passe le développement des robots Google sans Boston Dynamics ?

Résumé de fin d'année Google AI n°6 : Comment se passe le développement des robots Google sans Boston Dynamics ?

Résumé de fin d'année Google AI n°6 : Comment se passe le développement des robots Google sans Boston Dynamics ?

Un backflip de Boston Dynamics nous montre les possibilités infinies apportées par les robots fabriqués par l'homme.

Bien que Google ait vendu Boston Dynamics en 2017, Google poursuit toujours son développement de robots, pas seulement en s'approchant « physiquement » des humains, En termes de " intelligence", nous recherchons également une meilleure compréhension des instructions humaines.

La série de résumés de fin d'année de Google Research "Google Research, 2022 et au-delà" dirigée par Jeff Dean a été mise à jour dans le sixième numéro. Le thème de ce numéro est ". Robot" , rédigé par Kendra Byrne, chef de produit senior, et Jie Tan, chercheur scientifique chez Google Robotics

Au cours de notre vie, nous verrons certainement la technologie robotique impliquée dans la vie quotidienne humaine, contribuant à améliorer la productivité humaine. et Qualité de vie.

Avant que les technologies robotiques puissent être largement utilisées pour le travail pratique quotidien dans des espaces centrés sur l'humain (c'est-à-dire des espaces conçus pour les personnes et non pour les machines), il faut s'assurer qu'elles peuvent aider les personnes en toute sécurité.

En 2022, Google se concentre sur le défi consistant à rendre les robots plus utiles aux humains :

- permettre aux robots et aux humains de communiquer plus efficacement et plus naturellement

- permettre aux robots de comprendre et d'appliquer les connaissances de bon sens dans le monde réel ;

- Augmenter le nombre de compétences de bas niveau requises pour que les robots effectuent efficacement des tâches dans des environnements non structurés.

Quand le LLM rencontre les robots

Une caractéristique des grands modèles de langage (LLM) est la capacité d'encoder des descriptions et du contexte dans un format « compréhensible par les humains et les machines ».

Lorsque LLM est appliqué à la robotique, il permet aux utilisateurs d'attribuer des tâches aux robots uniquement via des instructions en langage naturel ; lorsqu'il est combiné avec des modèles visuels et des méthodes d'apprentissage des robots, LLM fournit aux robots un moyen de comprendre les méthodes contextuelles et la capacité de comprendre les demandes des utilisateurs. planifier les actions à entreprendre pour compléter la demande.

L'une des méthodes de base consiste à utiliser LLM pour inciter d'autres modèles pré-entraînés à obtenir des informations afin de créer le contexte de ce qui se passe dans la scène et de faire des prédictions pour des tâches multimodales. L'ensemble du processus est similaire à la méthode d'enseignement socratique. L'enseignant pose des questions aux élèves et les guide pour y répondre à travers un processus de réflexion rationnelle.

Dans le « Modèle Socrates », les chercheurs ont démontré que cette méthode peut atteindre des performances de pointe dans les tâches de description d'images sans prise de vue et de récupération de texte vidéo, et peut également prendre en charge de nouvelles fonctions, telles que répondre gratuitement à des questions sur les vidéos. -former des questions et prédire les activités futures, le dialogue assisté multimodal, ainsi que la perception et la planification des robots.

Lien papier : https://arxiv.org/abs/2204.00598

Dans l'article "Vers des robots utiles : un langage de base pour l'utilisabilité des robots", les chercheurs ont collaboré avec Everyday Robots pour construire un modèle d'utilisabilité des robots Plan long tâches à terme basées sur le modèle de langage PaLM.

Lien du blog : https://ai.googleblog.com/2022/08/towards-helpful-robots-grounding.html

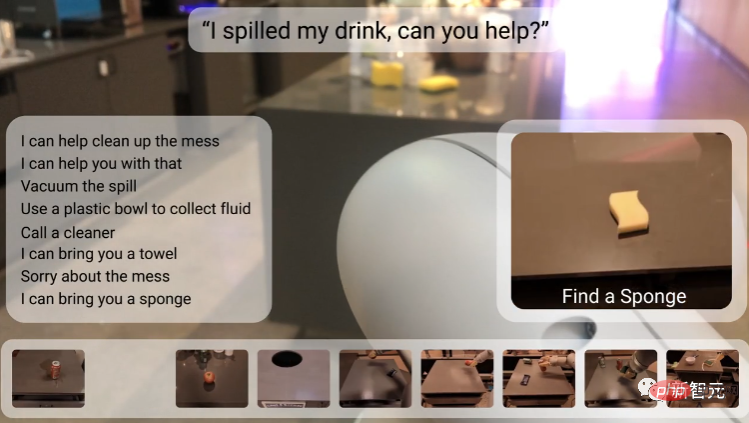

Dans les méthodes d'apprentissage automatique précédentes, les robots ne pouvaient accepter que des tâches telles que "ramasser le éponge" " et d'autres commandes courtes codées en dur, et il est difficile de raisonner sur les étapes requises pour terminer la tâche, et il est encore plus difficile à gérer si la tâche est un objectif abstrait, tel que " Pouvez-vous aider à nettoyer ces des déversements ?

Les chercheurs ont choisi d'utiliser un LLM pour prédire la séquence d'étapes permettant d'accomplir une tâche à long terme, ainsi qu'un modèle d'affordance qui représente les compétences que le robot peut réellement accomplir dans une situation donnée.

La fonction de valeur du modèle d'apprentissage par renforcement peut être utilisée pour construire un modèle d'affordance, qui est une représentation abstraite des actions qu'un robot peut effectuer dans différents états, intégrant ainsi des tâches à long terme dans le monde réel, telles que « ranger » la chambre" avec le temps nécessaire pour accomplir la tâche. Les compétences à court terme telles que choisir, placer et disposer correctement les objets sont liées.

Lien papier : https://arxiv.org/abs/2111.03189

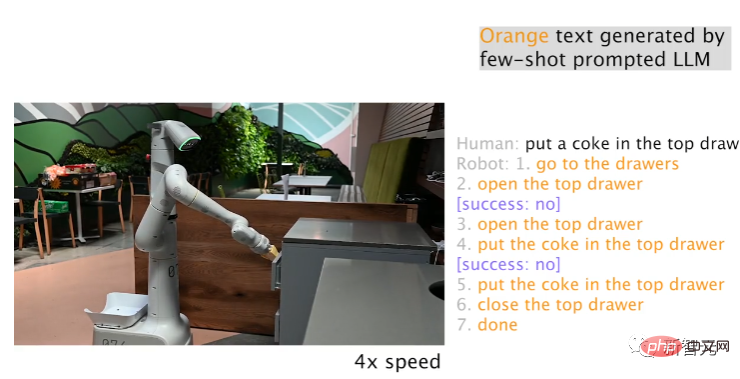

Avoir à la fois des modèles LLM et d'affordance ne signifie pas que le robot peut accomplir avec succès la tâche grâce au monologue intérieur (Inner Monologue), il peut se terminer. basé sur les boucles LLM dans la planification de mission ; l'exploitation d'autres sources d'informations, telles que les commentaires humains ou la compréhension de la scène, peut détecter quand un robot ne peut pas accomplir une tâche correctement.

Lien papier : https://arxiv.org/abs/2207.05608

À l'aide d'un robot d'Everyday Robots, les chercheurs ont découvert que LLM peut replanifier efficacement les étapes du plan ayant échoué en cours ou précédentes, et que le robot peut récupérer après un échec Récupérez et accomplissez des tâches complexes comme « Mettre un Coca-Cola dans le tiroir du haut ».

Dans la planification de mission basée sur LLM, l'une des capacités exceptionnelles est que le robot peut réagir aux changements d'objectifs de haut niveau et de tâches intermédiaires : par exemple, l'utilisateur peut indiquer au robot ce qui se passe, en fournissant rapidement corrections ou rediriger le robot vers une autre tâche, modifiant ainsi les actions déjà planifiées, et est particulièrement utile pour permettre aux utilisateurs de contrôler et de personnaliser de manière interactive les tâches robotiques.

Bien que le langage naturel facilite la spécification et la modification des tâches des robots, il existe également le défi de réagir aux descriptions humaines en temps réel.

Les chercheurs proposent un cadre d'apprentissage par imitation à grande échelle pour produire des robots en temps réel, à vocabulaire ouvert et conditionnés par le langage, capables de traiter plus de 87 000 instructions uniques avec un taux de réussite moyen estimé à 93,5 % dans le cadre du projet ; , Google a également publié Language-Table, le plus grand ensemble de données de robot d'annotation de langage à l'heure actuelle

Lien papier : https://arxiv.org/pdf/2210.06407.pdf

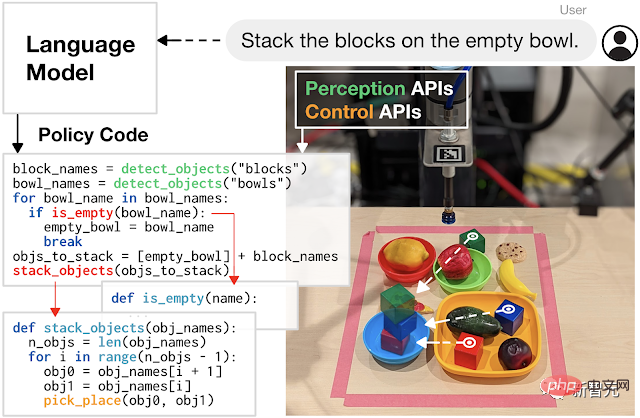

Et utilisez LLM pour écrire du code Robot de contrôle les mouvements constituent également une direction de recherche prometteuse.

La méthode de codage développée par les chercheurs démontre le potentiel d'augmenter la complexité des tâches, permettant aux robots de générer de manière autonome un nouveau code pour recombiner les appels d'API, synthétiser de nouvelles fonctions et exprimer des boucles de rétroaction pour synthétiser de nouveaux comportements au moment de l'exécution.

Lien papier : https://arxiv.org/abs/2209.07753

Transformer l'apprentissage des robots en un problème de données évolutif

Un grand langage et des modèles multimodaux peuvent aider les robots à comprendre l'environnement dans lequel ils opèrent, comme quoi ce qui se passe dans la scène et ce que le robot doit faire ; mais les robots ont également besoin de compétences physiques de bas niveau pour accomplir des tâches dans le monde physique, comme ramasser et placer des objets avec précision.

Bien que les humains tiennent souvent ces compétences physiques pour acquises et sont capables d'effectuer diverses actions sans réfléchir, elles constituent un problème pour les robots.

Par exemple, lorsqu'un robot ramasse un objet, il doit détecter et comprendre l'environnement, déduire la relation spatiale et la dynamique de contact entre la griffe et l'objet, piloter avec précision le bras à haut degré de liberté et appliquer Force appropriée pour saisir l'objet de manière stable sans détruire l'objet.

Le casse-tête de l’apprentissage de ces compétences de bas niveau est connu sous le nom de paradoxe de Moravec : le raisonnement nécessite très peu de calculs, mais les compétences sensorimotrices et perceptuelles nécessitent d’énormes ressources informatiques.

Inspirés par le succès du LLM, les chercheurs adoptent une approche basée sur les données pour transformer le problème de l'apprentissage des compétences physiques de bas niveau en un problème de données évolutif : le LLM montre que la généralisabilité et les performances des grands modèles Transformer évoluent avec la quantité de données. augmente avec l'augmentation.

Lien papier : https://robotics-transformer.github.io/assets/rt1.pdf

Les chercheurs ont proposé le modèle Robot Transformer-1 (RT-1) et formé une stratégie de fonctionnement du robot. Les données de formation utilisées étaient un ensemble de données de robots réels à grande échelle de 130 000 épisodes, utilisant 13 robots d'Everyday Robots Robotics, couvrant. plus de 700 tâches, et montre la même tendance en robotique, à savoir que l'augmentation de la taille et de la diversité des données améliore la généralisation du modèle à de nouvelles tâches, environnements et objets.

Derrière le modèle de langage et les méthodes d'apprentissage des robots (telles que RT-1), le modèle Transformer est formé sur la base de données à l'échelle Internet, mais contrairement au LLM, la robotique est confrontée à des environnements changeants et aux défis de la représentation multimodale avec des calculs limités.

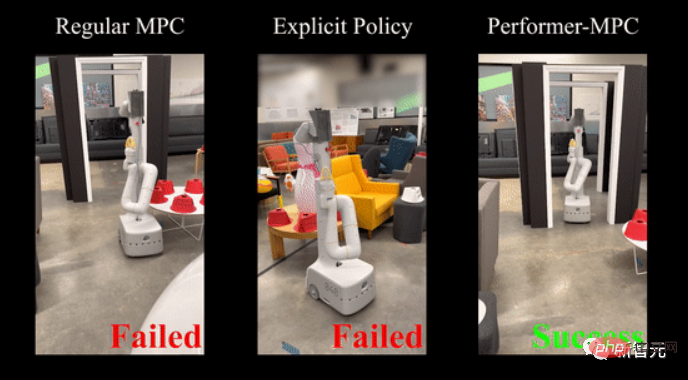

En 2020, Google a proposé Performers, une méthode qui peut améliorer l'efficacité informatique de Transformer, affectant plusieurs scénarios d'application, y compris la robotique.

Récemment, les chercheurs ont étendu cette méthode et introduit une nouvelle classe de stratégies de contrôle implicite qui combinent les avantages de l'apprentissage par simulation et une gestion robuste des contraintes du système (contraintes de contrôle pré-estimées du modèle).

Lien papier : https://performermpc.github.io/

Par rapport à la stratégie MPC standard, les résultats expérimentaux montrent que le robot a une amélioration de plus de 40 % dans la réalisation de l'objectif lors de la navigation autour des humains, des réseaux sociaux Il y a une amélioration de plus de 65 % des indicateurs ; Performance-MPC est de 8,3 M. Le retard du modèle de paramètres n'est que de 8 millisecondes, ce qui permet de déployer Transformer sur des robots.

L'équipe de recherche de Google a également démontré que les méthodes basées sur les données sont souvent applicables à différentes plates-formes robotiques dans différents environnements pour apprendre un large éventail de tâches, notamment la manipulation mobile, la navigation, la locomotion et le tennis de table, etc., ainsi que pour l'apprentissage de compétences en robotique de bas niveau, il existe une voie claire : la collecte de données évolutive.

Contrairement aux riches données vidéo et textuelles sur Internet, les données robotiques sont extrêmement rares et difficiles à obtenir, et les méthodes permettant de collecter et d'utiliser efficacement des ensembles de données riches qui représentent les interactions du monde réel sont essentielles à une approche basée sur les données.

La simulation est une option rapide, sûre et facile à paralléliser, mais il est difficile de reproduire l'environnement complet en simulation, en particulier l'environnement physique et l'environnement d'interaction homme-machine.

Lien papier : https://arxiv.org/abs/2207.06572

Dans i-Sim2Real, les chercheurs démontrent une méthode en s'appuyant sur un modèle de comportement humain simple et en s'entraînant à des simulations. Alternant entre les déploiements du monde réel pour résoudre inadéquations entre simulation et réalité, et apprentissage du tennis de table contre des adversaires humains, les modèles de comportement humain et les politiques sont affinés à chaque itération.

Bien que les simulations puissent aider à collecter des données, la collecte de données dans le monde réel est essentielle pour affiner les stratégies de simulation ou adapter les stratégies existantes dans de nouveaux environnements.

Au cours du processus d'apprentissage, un robot peut facilement échouer et potentiellement causer des dommages à lui-même et à son environnement. Surtout dans les premières étapes d'apprentissage de l'exploration de la manière d'interagir avec le monde, les données d'entraînement doivent être collectées en toute sécurité afin que le robot ne puisse pas le faire. n'apprend que des compétences, il peut également se remettre de manière autonome des échecs.

Lien papier : https://arxiv.org/abs/2110.05457

Les chercheurs ont proposé un cadre RL sécurisé qui bascule entre la « stratégie de l'apprenant » et la « stratégie de récupération sûre », la première étant optimisée afin de réaliser les tâches requises, cette dernière évite au robot de se trouver dans des états dangereux ; elle entraîne une stratégie de réinitialisation afin que le robot puisse se remettre des pannes, comme apprendre à se relever tout seul après une chute.

Bien qu'il existe très peu de données sur les robots, il existe de nombreuses vidéos d'humains effectuant différentes tâches. Bien sûr, les structures des robots et des humains sont différentes, donc l'idée de laisser les robots apprendre des humains a déclenché un "transfert". problème d'apprentissage à travers différentes entités.

Lien papier : https://arxiv.org/pdf/2106.03911.pdf

Les chercheurs ont développé l'apprentissage par renforcement inverse par incarnation croisée pour apprendre de nouvelles tâches en observant les humains, plutôt que d'essayer de reproduire une tâche aussi précisément qu'un humain. L'apprentissage par démonstration permet aux robots d'acquérir des compétences en regardant des vidéos facilement disponibles sur Internet.

Une autre direction consiste à améliorer l'efficacité des données des algorithmes d'apprentissage afin qu'ils ne reposent plus uniquement sur une collecte de données étendue : l'efficacité des méthodes RL est améliorée en incorporant des informations préalables, notamment des informations prédictives, des priorités d'action contradictoire et des stratégies d'orientation.

Lien papier : https://arxiv.org/abs/2210.10865

En utilisant une nouvelle architecture de système dynamique structurée pour combiner RL avec optimisation de trajectoire, avec le support d'un nouveau solveur, nous obtenons Pour d'autres améliorations, avant les informations aident à atténuer les défis d’exploration, à mieux normaliser les données et à réduire considérablement la quantité de données requises.

De plus, l'équipe de robotique a également investi beaucoup d'argent dans un apprentissage plus efficace par simulation de données. Des expériences ont prouvé qu'une simple méthode d'apprentissage par imitation BC-Z peut effectuer une généralisation sans tir sur de nouvelles tâches non vues en formation.

Lien papier : https://arxiv.org/pdf/2210.02343.pdf

Et a également introduit un algorithme d'apprentissage par imitation itératif GoalsEye, qui combine l'apprentissage à partir de jeux et le clonage de comportement conditionnel cible pour des performances rapides et élevées. Jeu de tennis de table de précision de vitesse.

Lien papier : https://sites.google.com/view/goals-eye

Du côté théorique, les chercheurs ont étudié la stabilité dynamique du système qui caractérise la complexité des échantillons d'apprentissage simulés et ont capturé des données de démonstration. Échec et récupération pour mieux réguler le rôle de l'apprentissage hors ligne avec de petits ensembles de données.

Lien papier : https://proceedings.mlr.press/v168/tu22a.html

Résumé

Les progrès des modèles à grande échelle dans le domaine de l'intelligence artificielle ont favorisé un bond en avant dans les capacités d'apprentissage des robots.

Au cours de la dernière année, nous avons constaté que le sens contextuel et la séquence des événements capturés dans LLM aident à aborder la planification à long terme en robotique et permettent aux robots d'interagir plus facilement avec les personnes et d'accomplir des tâches. Vous pouvez également découvrir des voies évolutives pour apprendre la robustesse et généraliser le comportement des robots en appliquant l’architecture du modèle Transformer à l’apprentissage des robots.

Google promet de continuer à ouvrir des ensembles de données open source pour continuer à développer des robots utiles au cours de la nouvelle année.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Comment commenter Deepseek

Feb 19, 2025 pm 05:42 PM

Comment commenter Deepseek

Feb 19, 2025 pm 05:42 PM

Deepseek est un puissant outil de récupération d'informations. .

Comment rechercher Deepseek

Feb 19, 2025 pm 05:39 PM

Comment rechercher Deepseek

Feb 19, 2025 pm 05:39 PM

Deepseek est un moteur de recherche propriétaire qui ne recherche que dans une base de données ou un système spécifique, plus rapide et plus précis. Lorsque vous l'utilisez, il est conseillé aux utilisateurs de lire le document, d'essayer différentes stratégies de recherche, de demander de l'aide et des commentaires sur l'expérience utilisateur afin de tirer le meilleur parti de leurs avantages.

Sesame Open Door Exchange Page d'enregistrement de page Enregistrement Gate Trading App The Registration Site Web

Feb 28, 2025 am 11:06 AM

Sesame Open Door Exchange Page d'enregistrement de page Enregistrement Gate Trading App The Registration Site Web

Feb 28, 2025 am 11:06 AM

Cet article présente le processus d'enregistrement de la version Web de Sesame Open Exchange (GATE.IO) et l'application Gate Trading en détail. Qu'il s'agisse de l'enregistrement Web ou de l'enregistrement de l'application, vous devez visiter le site Web officiel ou l'App Store pour télécharger l'application authentique, puis remplir le nom d'utilisateur, le mot de passe, l'e-mail, le numéro de téléphone mobile et d'autres informations et terminer la vérification des e-mails ou du téléphone mobile.

Pourquoi le lien d'échange de Bybit ne peut-il pas être téléchargé directement et installé?

Feb 21, 2025 pm 10:57 PM

Pourquoi le lien d'échange de Bybit ne peut-il pas être téléchargé directement et installé?

Feb 21, 2025 pm 10:57 PM

Pourquoi le lien d'échange de Bybit ne peut-il pas être téléchargé directement et installé? Bybit est un échange de crypto-monnaie qui fournit des services de trading aux utilisateurs. Les applications mobiles de l'échange ne peuvent pas être téléchargées directement via AppStore ou GooglePlay pour les raisons suivantes: 1. La politique de l'App Store empêche Apple et Google d'avoir des exigences strictes sur les types d'applications autorisées dans l'App Store. Les demandes d'échange de crypto-monnaie ne répondent souvent pas à ces exigences car elles impliquent des services financiers et nécessitent des réglementations et des normes de sécurité spécifiques. 2. Conformité des lois et réglementations Dans de nombreux pays, les activités liées aux transactions de crypto-monnaie sont réglementées ou restreintes. Pour se conformer à ces réglementations, l'application ByBit ne peut être utilisée que via des sites Web officiels ou d'autres canaux autorisés

Sesame Open Door Trading Platform Download Version mobile Gateio Trading Plateforme de téléchargement Adresse de téléchargement

Feb 28, 2025 am 10:51 AM

Sesame Open Door Trading Platform Download Version mobile Gateio Trading Plateforme de téléchargement Adresse de téléchargement

Feb 28, 2025 am 10:51 AM

Il est crucial de choisir un canal formel pour télécharger l'application et d'assurer la sécurité de votre compte.

Top 10 recommandé pour l'application de trading d'actifs numériques crypto (2025 Global Ranking)

Mar 18, 2025 pm 12:15 PM

Top 10 recommandé pour l'application de trading d'actifs numériques crypto (2025 Global Ranking)

Mar 18, 2025 pm 12:15 PM

Cet article recommande les dix principales plates-formes de trading de crypto-monnaie qui méritent d'être prêtées, notamment Binance, Okx, Gate.io, Bitflyer, Kucoin, Bybit, Coinbase Pro, Kraken, Bydfi et Xbit décentralisées. Ces plateformes ont leurs propres avantages en termes de quantité de devises de transaction, de type de transaction, de sécurité, de conformité et de fonctionnalités spéciales. Le choix d'une plate-forme appropriée nécessite une considération complète en fonction de votre propre expérience de trading, de votre tolérance au risque et de vos préférences d'investissement. J'espère que cet article vous aide à trouver le meilleur costume pour vous-même

Binance Binance Site officiel Dernière version Portail de connexion

Feb 21, 2025 pm 05:42 PM

Binance Binance Site officiel Dernière version Portail de connexion

Feb 21, 2025 pm 05:42 PM

Pour accéder à la dernière version du portail de connexion du site Web de Binance, suivez simplement ces étapes simples. Accédez au site officiel et cliquez sur le bouton "Connectez-vous" dans le coin supérieur droit. Sélectionnez votre méthode de connexion existante. Entrez votre numéro de mobile ou votre mot de passe enregistré et votre mot de passe et complétez l'authentification (telles que le code de vérification mobile ou Google Authenticator). Après une vérification réussie, vous pouvez accéder à la dernière version du portail de connexion du site Web officiel de Binance.

Sesame Open Door Exchange Page Web Login Dernière version GATEIO Entrée du site officiel

Mar 04, 2025 pm 11:48 PM

Sesame Open Door Exchange Page Web Login Dernière version GATEIO Entrée du site officiel

Mar 04, 2025 pm 11:48 PM

Une introduction détaillée à l'opération de connexion de la version Web Sesame Open Exchange, y compris les étapes de connexion et le processus de récupération de mot de passe.