Le rêve de tout le monde d'avoir un ChatGPT est sur le point de devenir réalité ?

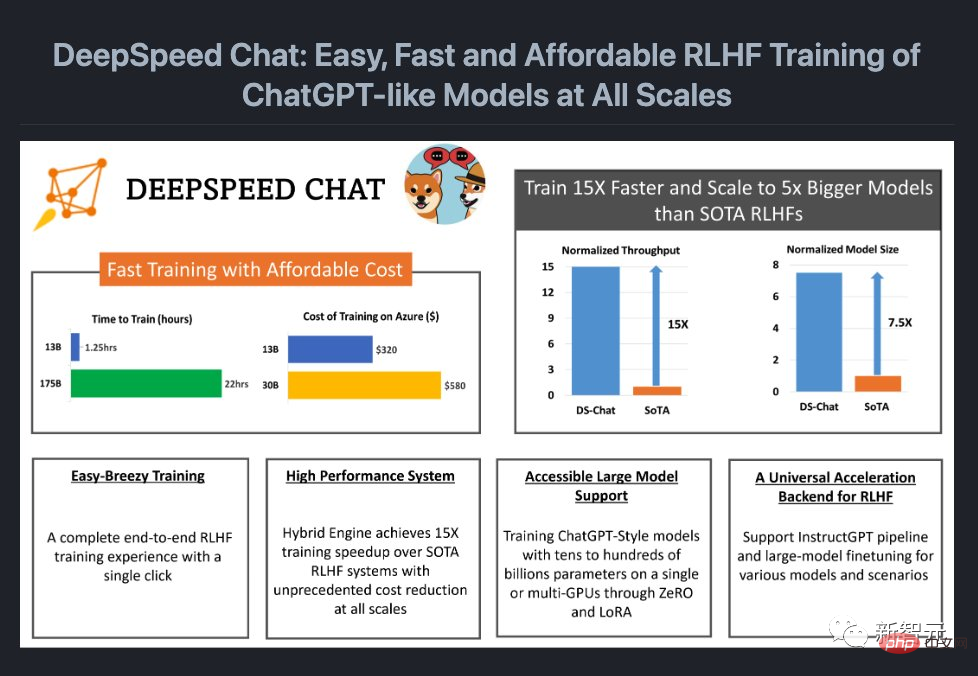

Tout à l'heure, Microsoft a open source un framework système qui peut ajouter un processus RLHF complet pour modéliser la formation - DeepSpeed Chat.

En d’autres termes, des modèles ChatGPT de haute qualité de toutes tailles sont désormais à votre portée !

Adresse du projet : https://github.com/microsoft/DeepSpeed

Comme nous le savons tous, car OpenAI est trop ouvert, Afin de permettre à davantage de personnes d'utiliser des modèles de type ChatGPT, la communauté open source a successivement lancé des modèles tels que LLaMa, Alpaca, Vicuna et Databricks-Dolly.

Cependant, en raison de l'absence d'un système à grande échelle prenant en charge le RLHF de bout en bout, la formation actuelle de modèles de type ChatGPT est encore très difficile. L'émergence de DeepSpeed Chat compense tout juste ce "bug".

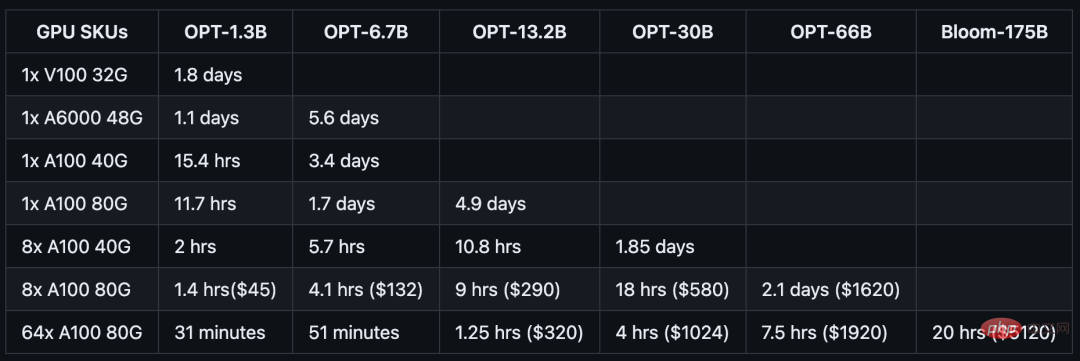

Ce qui est encore plus brillant, c'est que DeepSpeed Chat a considérablement réduit les coûts.

Auparavant, les configurations multi-GPU coûteuses dépassaient les capacités de nombreux chercheurs, et même avec l'accès aux clusters multi-GPU, les méthodes existantes n'étaient pas en mesure de permettre la formation de centaines de milliards de modèles ChatGPT de paramètres.

Maintenant, pour seulement 1 620 $, vous pouvez entraîner un modèle OPT-66B en 2,1 jours grâce au moteur hybride DeepSpeed-HE.

Et si vous utilisez un système multi-nœuds et multi-GPU, DeepSpeed-HE peut dépenser 320 dollars américains pour former un modèle OPT-13B en 1,25 heure, et dépenser 5 120 dollars américains pour former un modèle OPT-13B en moins d'une journée modèle 175B.

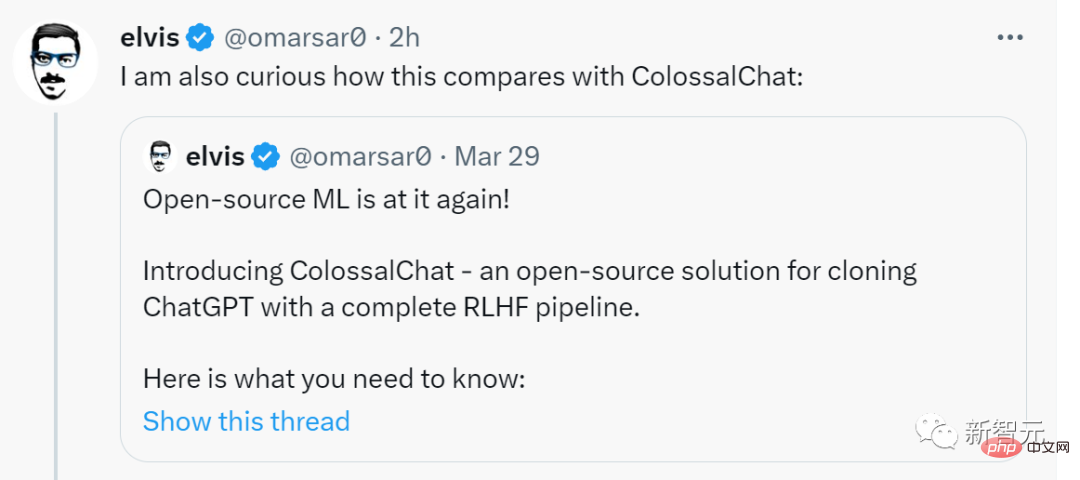

Elvis, ancien expert en méta-IA, a retweeté avec enthousiasme, affirmant que c'était un gros problème et a exprimé sa curiosité quant à la façon dont DeepSpeed Chat se compare à ColossalChat.

Maintenant, voyons comment cela fonctionne.

Après une formation par DeepSpeed-Chat, la version à 1,3 milliard de paramètres "ChatGPT" a très bien fonctionné lors de la session de questions et réponses. Non seulement vous pouvez comprendre le contexte de la question, mais les réponses données sont également pertinentes.

Dans plusieurs séries de conversations, les performances démontrées par cette version à 1,3 milliard de paramètres de « ChatGPT » ont complètement dépassé l'impression inhérente à cette échelle.

Bien sûr, avant d'en faire l'expérience, vous devez configurer l'environnement :

git clone https://github.com/microsoft/DeepSpeed.git cd DeepSpeed pip install . git clone https://github.com/microsoft/DeepSpeedExamples.git cd DeepSpeedExamples/applications/DeepSpeed-Chat/ pip install -r requirements.txt

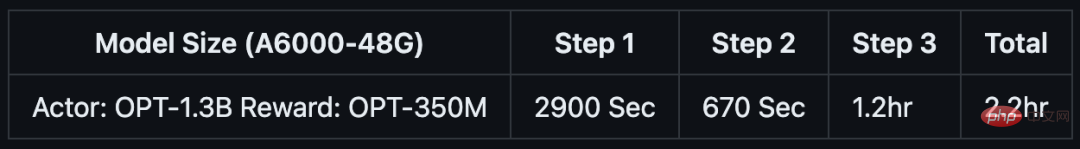

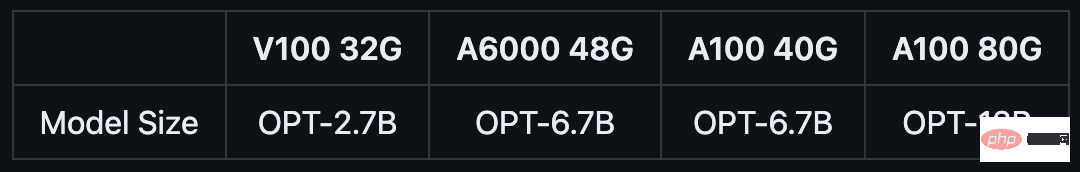

Si vous ne disposez que d'environ 1 à 2 heures de café ou de pause déjeuner, vous pouvez également essayer d'utiliser DeepSpeed-Chat pour entraîner un "petit jouet".

L'équipe a spécialement préparé un exemple de formation pour le modèle 1.3B, qui peut être testé sur des GPU grand public. Le meilleur, c'est que lorsque vous revenez de votre pause déjeuner, tout est prêt.

python train.py --actor-model facebook/opt-1.3b --reward-model facebook/opt-350m --num-gpus 1

GPU NVIDIA A6000 grand public avec 48 Go de mémoire vidéo :

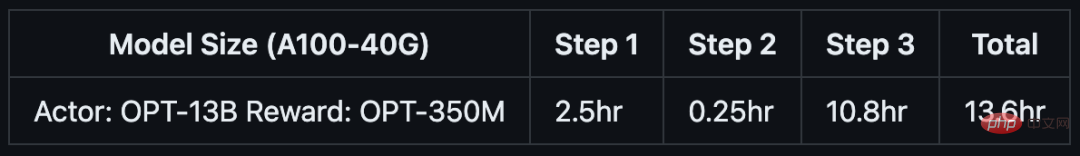

如果你只有半天的时间,以及一台服务器节点,则可以通过预训练的OPT-13B作为actor模型,OPT-350M作为reward模型,来生成一个130亿参数的类ChatGPT模型:

python train.py --actor-model facebook/opt-13b --reward-model facebook/opt-350m --num-gpus 8

单DGX节点,搭载了8个NVIDIA A100-40G GPU:

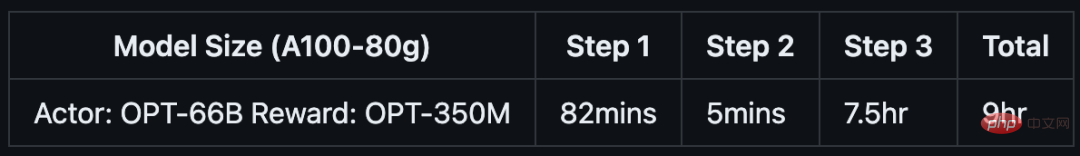

如果你可以使用多节点集群或云资源,并希望训练一个更大、更高质量的模型。那么只需基于下面这行代码,输入你想要的模型大小(如66B)和GPU数量(如64):

python train.py --actor-model facebook/opt-66b --reward-model facebook/opt-350m --num-gpus 64

8个DGX节点,每个节点配备8个NVIDIA A100-80G GPU:

具体来说,针对不同规模的模型和硬件配置,DeepSpeed-RLHF系统所需的时间和成本如下:

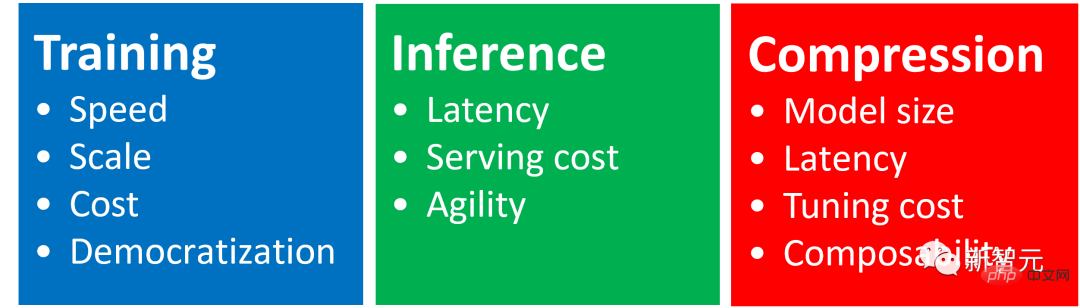

DeepSpeed Chat是一种通用系统框架,能够实现类似ChatGPT模型的端到端RLHF训练,从而帮助我们生成自己的高质量类ChatGPT模型。

DeepSpeed Chat具有以下三大核心功能:

1. 简化ChatGPT类型模型的训练和强化推理体验

开发者只需一个脚本,就能实现多个训练步骤,并且在完成后还可以利用推理API进行对话式交互测试。

2. DeepSpeed-RLHF模块

DeepSpeed-RLHF复刻了InstructGPT论文中的训练模式,并提供了数据抽象和混合功能,支持开发者使用多个不同来源的数据源进行训练。

3. DeepSpeed-RLHF系统

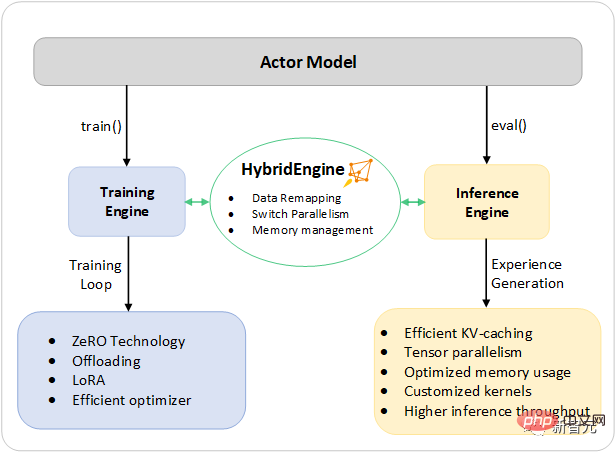

团队将DeepSpeed的训练(training engine)和推理能力(inference engine) 整合成了一个统一的混合引擎(DeepSpeed Hybrid Engine or DeepSpeed-HE)中,用于RLHF训练。由于,DeepSpeed-HE能够无缝地在推理和训练模式之间切换,因此可以利用来自DeepSpeed-Inference的各种优化。

DeepSpeed-RLHF系统在大规模训练中具有无与伦比的效率,使复杂的RLHF训练变得快速、经济并且易于大规模推广:

DeepSpeed-HE比现有系统快15倍以上,使RLHF训练快速且经济实惠。

例如,DeepSpeed-HE在Azure云上只需9小时即可训练一个OPT-13B模型,只需18小时即可训练一个OPT-30B模型。这两种训练分别花费不到300美元和600美元。

DeepSpeed-HE peut prendre en charge des modèles d'entraînement avec des centaines de milliards de paramètres et fait preuve d'une excellente évolutivité sur les systèmes multi-nœuds multi-GPU.

Ainsi, même un modèle avec 13 milliards de paramètres peut être entraîné en seulement 1,25 heure. Pour un modèle comportant 175 milliards de paramètres, l’entraînement à l’aide de DeepSpeed-HE ne prend que moins d’une journée.

Avec un seul GPU, DeepSpeed-HE peut prendre en charge des modèles de formation avec plus de 13 milliards de paramètres. Cela permet aux data scientists et aux chercheurs qui n'ont pas accès aux systèmes multi-GPU de créer facilement non seulement des modèles RLHF légers, mais également des modèles volumineux et puissants pour faire face à différents scénarios d'utilisation.

Afin de fournir une expérience de formation transparente, les chercheurs ont suivi InstructGPT et ont inclus un processus de formation complet de bout en bout dans DeepSpeed-Chat.

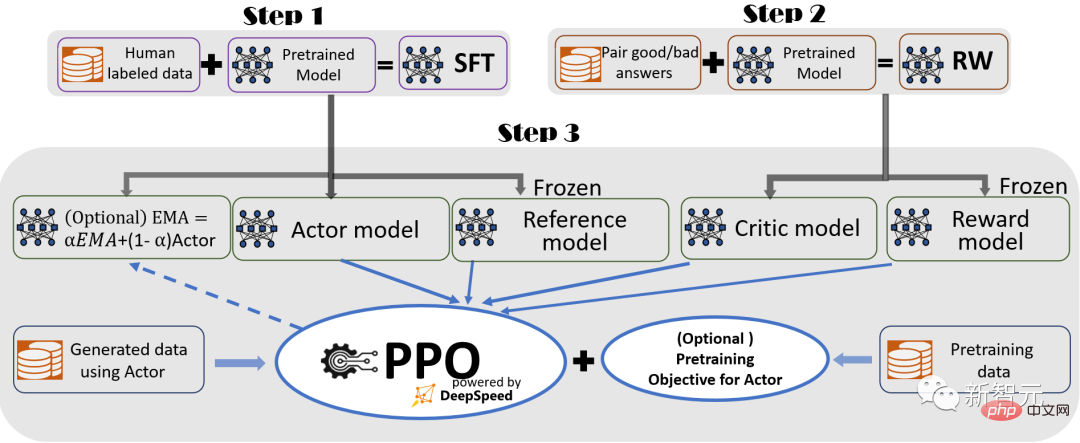

Diagramme du processus de formation RLHF de DeepSpeed-Chat, comprenant certaines fonctions facultatives

Le processus comprend trois étapes principales :

Supervision Fine- réglage (SFT) , utilise des réponses humaines organisées pour affiner les modèles de langage pré-entraînés à diverses requêtes.

Affinement du modèle de récompense, à l'aide d'un ensemble de données contenant des évaluations humaines de plusieurs réponses à la même requête, pour former un modèle de récompense (RW) indépendant (généralement plus petit que SFT).

Formation RLHF Dans cette étape, le modèle SFT est affiné davantage en utilisant l'algorithme d'optimisation de politique approximative (PPO) avec le retour de récompense du modèle RW.

À l'étape 3, le chercheur fournit également deux fonctions supplémentaires pour aider à améliorer la qualité du modèle :

- Collection de moyenne mobile exponentielle (EMA), vous pouvez choisir un point de contrôle basé sur l'EMA pour l'évaluation finale.

- Entraînement hybride, mélangeant l'objectif de pré-entraînement (c'est-à-dire la prédiction du mot suivant) avec l'objectif PPO pour éviter la régression des performances sur les benchmarks publics (tels que SQuAD2.0).

La formation EMA et hybride sont deux fonctionnalités de formation qui sont souvent ignorées par les autres frameworks open source car elles n'entravent pas la formation.

Cependant, selon InstructGPT, les points de contrôle EMA ont tendance à fournir une meilleure qualité de réponse que les modèles finaux formés traditionnels, et la formation hybride peut aider le modèle à maintenir ses capacités de résolution de base avant la formation.

Par conséquent, les chercheurs proposent ces fonctions aux utilisateurs afin qu'ils puissent obtenir pleinement l'expérience de formation décrite dans InstructGPT.

En plus d'être très cohérent avec l'article InstructGPT, le chercheur fournit également des fonctions qui permettent aux développeurs d'utiliser une variété de ressources de données pour former leurs propres modèles RLHF :

DeepSpeed -Chat est équipé de (1) une couche d'ensemble de données abstraite pour unifier le format des différents ensembles de données ; et (2) une fonctionnalité de fractionnement/fusion de données afin que plusieurs ensembles de données soient correctement mélangés, puis divisés en 3 étapes de formation.

Indique les étapes 1 et 2 du pipeline RLHF guidé, similaires au réglage fin conventionnel des grands modèles, qui sont obtenues par une combinaison d'optimisation basée sur ZeRO et de stratégies parallèles flexibles dans la formation DeepSpeed pour atteindre l'échelle et la vitesse.

Et l'étape 3 du pipeline est la partie la plus complexe en termes d'impact sur les performances.

Chaque itération doit gérer efficacement deux étapes : a) l'étape d'inférence, qui est utilisée pour la génération de jetons/expériences afin de générer des informations de formation b) l'étape de formation, qui met à jour les poids de l'acteur et les modèles de récompense, et l'interaction et la planification.

Cela introduit deux difficultés majeures : (1) le coût de la mémoire, puisque plusieurs modèles SFT et RW doivent être exécutés tout au long de la troisième étape ; (2) une génération plus lente de l'étape de réponse, si elle n'est pas correctement accélérée, ralentira considérablement le toute la troisième phase.

De plus, les deux fonctions importantes ajoutées par les chercheurs dans la troisième étape : la collecte de moyenne mobile exponentielle (EMA) et la formation hybride entraîneront des coûts de mémoire et de formation supplémentaires.

Pour relever ces défis, les chercheurs ont combiné toutes les capacités du système de formation et d'inférence DeepSpeed dans une infrastructure unifiée, le moteur hybride.

Il utilise le moteur DeepSpeed d'origine pour le mode d'entraînement rapide, tout en appliquant sans effort le moteur d'inférence DeepSpeed pour le mode génération/évaluation, fournissant ainsi un système d'entraînement plus rapide pour la troisième étape de l'entraînement RLHF.

Comme le montre la figure ci-dessous, la transition entre l'entraînement DeepSpeed et les moteurs d'inférence est transparente : en activant les modes d'évaluation et d'entraînement typiques pour le modèle d'acteur, DeepSpeed sélectionne différentes optimisations lors de l'exécution des processus d'inférence et d'entraînement. , pour exécuter les modèles plus rapidement et améliorer le débit global du système.

Conception du moteur hybride DeepSpeed pour accélérer la partie la plus chronophage du processus RLHF

Pendant l'exécution d'inférence de la phase de génération d'expérience de la formation RLHF, le moteur hybride DeepSpeed utilise un système de gestion de mémoire léger pour traiter le cache KV et les résultats intermédiaires, tout en utilisant des cœurs CUDA d'inférence hautement optimisés et un calcul parallèle tensoriel, obtenant une augmentation significative du débit (nombre de jetons par seconde) par rapport aux solutions existantes.

Pendant la formation, le moteur hybride active des technologies d'optimisation de la mémoire telles que la série de technologies ZeRO de DeepSpeed et l'adaptation d'ordre faible (LoRA).

La façon dont les chercheurs conçoivent et mettent en œuvre l'optimisation de ces systèmes est de les rendre compatibles les uns avec les autres et peuvent être combinés pour fournir la plus grande efficacité de formation sous un moteur hybride unifié.

Le moteur hybride peut modifier de manière transparente le partitionnement du modèle pendant la formation et l'inférence pour prendre en charge l'inférence tensorielle basée sur le parallèle et le mécanisme de partitionnement de formation basé sur ZeRO.

Il peut également reconfigurer le système de mémoire pour maximiser la disponibilité de la mémoire dans tous les modes.

Cela évite le goulot d'étranglement de l'allocation de mémoire et peut prendre en charge de grandes tailles de lots, améliorant considérablement les performances.

En résumé, le moteur hybride repousse les limites de la formation RLHF moderne, offrant une évolutivité et une efficacité système inégalées pour les charges de travail RLHF.

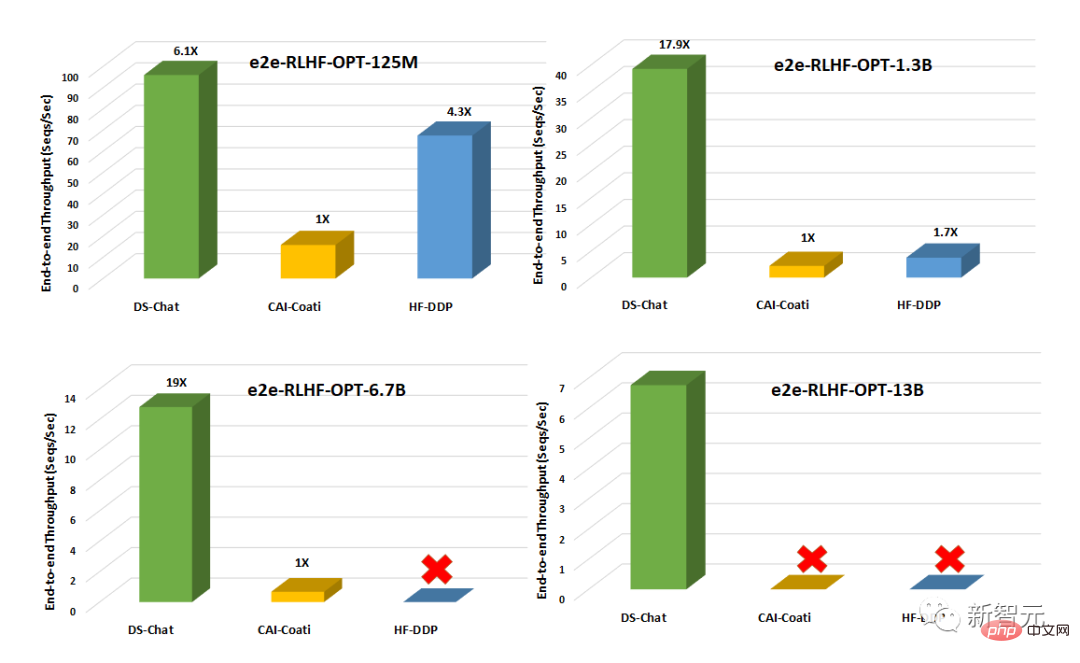

Par rapport aux systèmes existants tels que Colossal-AI ou HuggingFace-DDP, DeepSpeed-Chat a un débit de plus d'un ordre de grandeur et est capable de former des réseaux plus vastes avec le même budget de latence. Acteur de modèles ou entraînez des modèles de taille similaire à moindre coût.

Par exemple, DeepSpeed améliore le débit de la formation RLHF de plus de 10 fois sur un seul GPU. Alors que CAI-Coati et HF-DDP peuvent exécuter des modèles 1,3B, DeepSpeed peut exécuter des modèles 6,5B sur le même matériel, ce qui est directement 5 fois plus élevé.

Sur plusieurs GPU sur un seul nœud, DeepSpeed-Chat est 6 à 19 fois plus rapide que CAI-Coati en termes de débit système, et HF-DDP est 1,4 à 10,5 fois plus rapide.

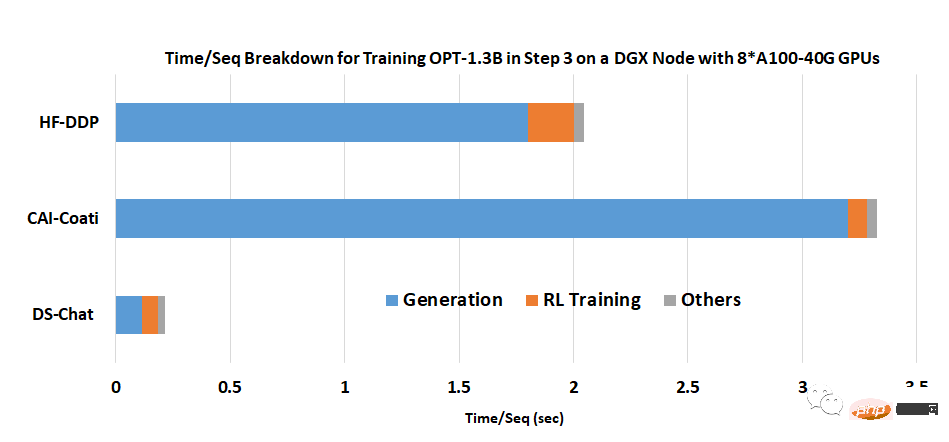

L'équipe a déclaré que l'une des principales raisons pour lesquelles DeepSpeed-Chat peut obtenir d'aussi excellents résultats est l'accélération fournie par le moteur hybride pendant la phase de génération.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Solution à l'échec de la connexion entre wsus et le serveur Microsoft

Solution à l'échec de la connexion entre wsus et le serveur Microsoft

Quelles sont les plateformes de vidéos courtes ?

Quelles sont les plateformes de vidéos courtes ?

Méthodes de chiffrement courantes pour le stockage de données chiffrées

Méthodes de chiffrement courantes pour le stockage de données chiffrées

Logiciel de trading au comptant

Logiciel de trading au comptant

Qu'est-ce qu'une procédure stockée MYSQL ?

Qu'est-ce qu'une procédure stockée MYSQL ?

Quels sont les avantages et les inconvénients de la décentralisation

Quels sont les avantages et les inconvénients de la décentralisation

Qu'est-ce qu'Avalanche

Qu'est-ce qu'Avalanche

Quels sont les attributs du javabean ?

Quels sont les attributs du javabean ?