Périphériques technologiques

Périphériques technologiques

IA

IA

IBM développe le supercalculateur d'IA cloud natif Vela pour déployer et former de manière flexible des dizaines de milliards de modèles de paramètres

IBM développe le supercalculateur d'IA cloud natif Vela pour déployer et former de manière flexible des dizaines de milliards de modèles de paramètres

IBM développe le supercalculateur d'IA cloud natif Vela pour déployer et former de manière flexible des dizaines de milliards de modèles de paramètres

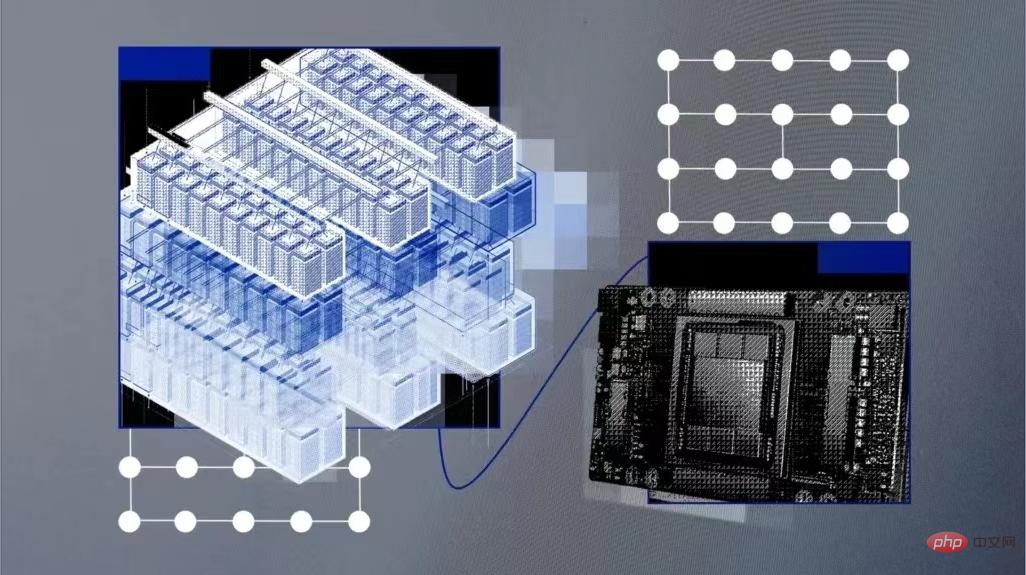

ChatGPT est populaire sur Internet et la formation sur le modèle d'IA qui la sous-tend a également attiré une large attention. IBM Research a récemment annoncé que le supercalculateur cloud natif Vela qu'il a développé pouvait être rapidement déployé et utilisé pour former des modèles d'IA de base. Depuis mai 2022, des dizaines de chercheurs de l’entreprise utilisent ce supercalculateur pour entraîner des modèles d’IA comportant des dizaines de milliards de paramètres.

Les modèles de base sont des modèles d'IA entraînés sur de grandes quantités de données non étiquetées, et leur polyvalence signifie qu'ils peuvent être utilisés pour une gamme de tâches différentes avec juste un réglage fin. Leur ampleur est énorme et nécessite une puissance de calcul massive et coûteuse. Par conséquent, comme le disent les experts, la puissance de calcul deviendra le plus gros goulot d'étranglement dans le développement de la prochaine génération de modèles de base à grande échelle, et leur formation nécessitera beaucoup de puissance de calcul et de temps.

Les modèles de formation capables d'exécuter des dizaines ou des centaines de milliards de paramètres nécessitent l'utilisation de matériel informatique haute performance, notamment des réseaux, des systèmes de fichiers parallèles et des nœuds nus. Ce matériel est difficile à déployer et coûteux à exploiter. Microsoft a construit un supercalculateur IA pour OpenAI en mai 2020 et l'a hébergé sur la plateforme cloud Azure. Mais IBM affirme qu'ils sont pilotés par le matériel, ce qui augmente les coûts et limite la flexibilité.

Cloud AI Supercomputer

IBM a donc créé un système appelé Vela qui est « spécifiquement axé sur l'IA à grande échelle ».

Vela peut être déployée dans n'importe quel centre de données cloud d'IBM selon les besoins, et il s'agit en soi d'un « cloud virtuel ». Même si cette approche réduit la puissance de calcul par rapport à la construction de supercalculateurs basés sur la physique, elle crée une solution plus flexible. Les solutions de cloud computing fournissent aux ingénieurs des ressources via des interfaces API, un accès plus facile au vaste écosystème cloud IBM pour une intégration plus approfondie et la possibilité d'adapter les performances selon les besoins.

Les ingénieurs IBM ont expliqué que Vela est capable d'accéder aux ensembles de données sur IBM Cloud Object Storage au lieu de créer un backend de stockage personnalisé. Auparavant, cette infrastructure devait être intégrée séparément aux supercalculateurs.

Le composant clé de tout supercalculateur IA est un grand nombre de GPU et les nœuds qui les connectent. Vela configure en fait chaque nœud comme une machine virtuelle (plutôt que comme du bare metal). Il s'agit de la méthode la plus courante et est largement considérée comme la méthode la plus idéale pour la formation en IA.

Comment Vela est-elle construite ?

L'un des inconvénients des ordinateurs virtuels cloud est que les performances ne peuvent être garanties. Pour remédier à la dégradation des performances et offrir des performances sans système d'exploitation au sein des machines virtuelles, les ingénieurs IBM ont trouvé un moyen de libérer les performances de l'ensemble des nœuds (y compris le GPU, le CPU, le réseau et le stockage) et de réduire les pertes de charge à moins de 5 %.

Cela implique la configuration d'un hôte nu pour la virtualisation, la prise en charge de la mise à l'échelle des VM, la virtualisation de grandes pages et d'E/S à racine unique, ainsi qu'une représentation réaliste de tous les périphériques et connexions au sein de la VM, qui comprend également la correspondance des cartes réseau avec les CPU et les GPU, ainsi que leur mode d'emploi ; se pontent. Après avoir terminé ce travail, ils ont constaté que les performances des nœuds VM étaient « proches du bare metal ».

De plus, ils s'engagent également à concevoir des nœuds d'IA dotés d'une grande mémoire GPU et de grandes quantités de stockage local pour la mise en cache des données, des modèles et des produits finis d'entraînement de l'IA. Lors de tests utilisant PyTorch, ils ont constaté qu'en optimisant les modèles de communication de la charge de travail, ils étaient également capables de combler le goulot d'étranglement des réseaux Ethernet relativement lents par rapport aux réseaux plus rapides comme Infiniband utilisé dans le calcul intensif.

En termes de configuration, chaque Vela utilise huit GPU A100 de 80 Go, deux processeurs évolutifs Intel Xeon de deuxième génération, 1,5 To de mémoire et quatre disques durs NVMe de 3,2 To, et peut être déployé sur IBM à n'importe quelle échelle. à travers le monde.

Les ingénieurs d'IBM ont déclaré : « Disposer des outils et de l'infrastructure appropriés est un facteur clé pour améliorer l'efficacité de la R&D. De nombreuses équipes choisissent de suivre la voie éprouvée de la construction de superordinateurs traditionnels pour l'IA... Nous travaillons toujours à une meilleure solution, pour offrir le double avantage du calcul haute performance et de la productivité utilisateur haut de gamme »

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Comment ajouter une nouvelle colonne dans SQL

Apr 09, 2025 pm 02:09 PM

Comment ajouter une nouvelle colonne dans SQL

Apr 09, 2025 pm 02:09 PM

Ajoutez de nouvelles colonnes à une table existante dans SQL en utilisant l'instruction ALTER TABLE. Les étapes spécifiques comprennent: la détermination des informations du nom de la table et de la colonne, rédaction des instructions de la table ALTER et exécution des instructions. Par exemple, ajoutez une colonne de messagerie à la table des clients (VARCHAR (50)): Alter Table Clients Ajouter un e-mail VARCHAR (50);

Quelle est la syntaxe pour ajouter des colonnes dans SQL

Apr 09, 2025 pm 02:51 PM

Quelle est la syntaxe pour ajouter des colonnes dans SQL

Apr 09, 2025 pm 02:51 PM

La syntaxe pour ajouter des colonnes dans SQL est alter table table_name Ajouter Column_name data_type [pas null] [default default_value]; Lorsque Table_Name est le nom de la table, Column_name est le nouveau nom de colonne, DATA_TYPE est le type de données, et non Null Spécifie si les valeurs NULL sont autorisées, et default default_value spécifie la valeur par défaut.

Tableau Clear SQL: Conseils d'optimisation des performances

Apr 09, 2025 pm 02:54 PM

Tableau Clear SQL: Conseils d'optimisation des performances

Apr 09, 2025 pm 02:54 PM

Conseils pour améliorer les performances de compensation de la table SQL: utilisez une table tronquée au lieu de supprimer, libre d'espace et réinitialiser la colonne d'identité. Désactivez les contraintes de clés étrangères pour éviter la suppression en cascade. Utilisez les opérations d'encapsulation des transactions pour assurer la cohérence des données. Supprimer les mégadonnées et limiter le nombre de lignes via Limit. Reconstruisez l'indice après la compensation pour améliorer l'efficacité de la requête.

Comment définir des valeurs par défaut lors de l'ajout de colonnes dans SQL

Apr 09, 2025 pm 02:45 PM

Comment définir des valeurs par défaut lors de l'ajout de colonnes dans SQL

Apr 09, 2025 pm 02:45 PM

Définissez la valeur par défaut des colonnes nouvellement ajoutées, utilisez l'instruction ALTER TABLE: Spécifiez des colonnes Ajouter et définissez la valeur par défaut: alter table table_name Ajouter Column_name data_type default_value; Utilisez la clause CONSTRAINT pour spécifier la valeur par défaut: ALTER TABLE TABLE_NAME ADD COLUMN COLUMN_NAME DATA_TYPE CONSTRAINT DEFAULT_CONSTRAINT DEFAULT_VALUE;

Utilisez la déclaration de suppression pour effacer les tables SQL

Apr 09, 2025 pm 03:00 PM

Utilisez la déclaration de suppression pour effacer les tables SQL

Apr 09, 2025 pm 03:00 PM

Oui, l'instruction Delete peut être utilisée pour effacer une table SQL, les étapes sont les suivantes: Utilisez l'instruction Delete: Delete de Table_Name; Remplacez Table_Name par le nom de la table à effacer.

Comment gérer la fragmentation de la mémoire redis?

Apr 10, 2025 pm 02:24 PM

Comment gérer la fragmentation de la mémoire redis?

Apr 10, 2025 pm 02:24 PM

La fragmentation de la mémoire redis fait référence à l'existence de petites zones libres dans la mémoire allouée qui ne peut pas être réaffectée. Les stratégies d'adaptation comprennent: Redémarrer Redis: effacer complètement la mémoire, mais le service d'interruption. Optimiser les structures de données: utilisez une structure plus adaptée à Redis pour réduire le nombre d'allocations et de versions de mémoire. Ajustez les paramètres de configuration: utilisez la stratégie pour éliminer les paires de valeurs clés les moins récemment utilisées. Utilisez le mécanisme de persistance: sauvegardez régulièrement les données et redémarrez Redis pour nettoyer les fragments. Surveillez l'utilisation de la mémoire: découvrez les problèmes en temps opportun et prenez des mesures.

phpmyadmin crée un tableau de données

Apr 10, 2025 pm 11:00 PM

phpmyadmin crée un tableau de données

Apr 10, 2025 pm 11:00 PM

Pour créer un tableau de données à l'aide de PhpMyAdmin, les étapes suivantes sont essentielles: connectez-vous à la base de données et cliquez sur le nouvel onglet. Nommez le tableau et sélectionnez le moteur de stockage (InnODB recommandé). Ajouter les détails de la colonne en cliquant sur le bouton Ajouter une colonne, y compris le nom de la colonne, le type de données, s'il faut autoriser les valeurs nuls et d'autres propriétés. Sélectionnez une ou plusieurs colonnes comme clés principales. Cliquez sur le bouton Enregistrer pour créer des tables et des colonnes.

Moniteur Disd Droplet avec service d'exportateur Redis

Apr 10, 2025 pm 01:36 PM

Moniteur Disd Droplet avec service d'exportateur Redis

Apr 10, 2025 pm 01:36 PM

La surveillance efficace des bases de données Redis est essentielle pour maintenir des performances optimales, identifier les goulots d'étranglement potentiels et assurer la fiabilité globale du système. Le service Redis Exporter est un utilitaire puissant conçu pour surveiller les bases de données Redis à l'aide de Prometheus. Ce didacticiel vous guidera à travers la configuration et la configuration complètes du service Redis Exportateur, en vous garantissant de créer des solutions de surveillance de manière transparente. En étudiant ce tutoriel, vous réaliserez les paramètres de surveillance entièrement opérationnels