Périphériques technologiques

Périphériques technologiques

IA

IA

Utilisez l'IA pour vous plonger dans l'animation, qui a reçu plus de 1,5 million de vues en 3 jours. Animateur professionnel : j'avais peur.

Utilisez l'IA pour vous plonger dans l'animation, qui a reçu plus de 1,5 million de vues en 3 jours. Animateur professionnel : j'avais peur.

Utilisez l'IA pour vous plonger dans l'animation, qui a reçu plus de 1,5 million de vues en 3 jours. Animateur professionnel : j'avais peur.

Enregistrez simplement une vidéo et l'IA vous plongera parfaitement dans l'animation !

Qu'il s'agisse de lignes, de couleurs ou de présentation de lumière et d'ombre, c'est exactement le même que le style réaliste des bandes dessinées américaines. L'animation est également délicate et fluide, et la fréquence d'images n'est évidemment pas faible :

.La production d'un tel film contient 120 plans VFX (combien d'efforts faut-il pour investir dans l'animation des effets visuels) ?

Seulement 3 personnes suffisent, et aucune équipe de costumes ou d'accessoires n'est nécessaire.

En revanche, de nombreux effets spéciaux animés à succès précédemment filmés nécessitaient souvent beaucoup d'efforts, et des équipes bien constituées comptaient même des centaines de personnes.

Après la mise en ligne de cet anime sur YouTube, il a reçu plus de 1,5 million de vues et plus de 110 000 likes en trois jours.

Il y a déjà des peintres qui ont peur après l'avoir lu :

J'ai consacré ma vie à la peinture... Cependant, ceux-ci seront remplacés dans quelques années.

Certains internautes ont estimé que leur « rêve d'enfant était devenu réalité » :

Quand j'étais jeune, j'ai toujours pensé que les animations étaient basées sur de vraies vidéos. Maintenant que je vois ça, je pense que c'est super cool.

Alors, comment est produit un tel anime ?

Comment utiliser l'IA pour réaliser une animation ?

Le processus est divisé en trois parties.

La première partie consiste à utiliser l'IA pour créer et générer des personnages d'anime et établir la relation entre celle-ci et les acteurs ; la deuxième partie consiste à créer des scènes d'animation ; la troisième partie consiste à synthétiser et à ajuster l'effet d'animation final.

Jetons un coup d'œil à la première partie de l'utilisation de l'IA pour redessiner l'animation des personnages. Cette partie a été réalisée à l'aide de Stable Diffusion, et le modèle de diffusion DreamBooth lancé par Google a été utilisé pour la mise au point.

Prenons ce personnage de l'anime comme exemple. Le coin supérieur gauche est le prototype de l'acteur, et le coin inférieur droit est le personnage de l'anime créé par l'IA :

Cela ne peut pas être fait en mettant directement l'image vidéo par cadre en diffusion stable. L'effet apparaît.

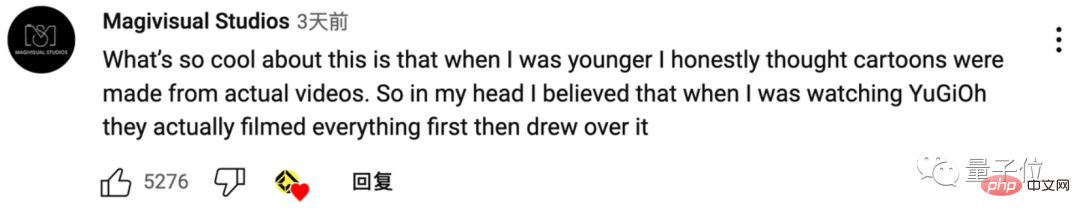

Afin de garantir que le style d'animation du personnage produise l'effet souhaité, les auteurs ont collecté un grand nombre de captures d'écran de personnages de l'anime classique "Vampire Hunter D" sous différents angles et les ont transmises à l'IA :

Dans le même temps, l’IA doit apprendre et mémoriser diverses caractéristiques détaillées de personnes réelles, du visage au corps.

Il est donc nécessaire de prendre à l'avance un grand nombre de photos des acteurs sous différents éclairages, sous plusieurs angles et diverses actions :

De cette façon, lorsque l'IA voit les acteurs dans la vidéo , il peut rapidement utiliser "Vampire Hunter" D" qui est la base du style de peinture et dessine des personnages de style anime qui ressemblent à des acteurs.

Comme pour certaines prises de vue agrandies du visage difficiles à contrôler, ControlNet est également utilisé pour contrôler davantage les effets générés.

Cependant, il existe toujours un problème avec les animations générées directement par l'IA.

Même si la différence entre les images n'est pas grande, la connexion n'est pas complètement cohérente. Certaines pointes de cheveux "sautant à plusieurs reprises" et des détails d'ombre et de lumière feront scintiller follement l'image :

Les auteurs ont pensé à utiliser DEFlicker. pour éliminer le scintillement. Le plug-in résout ce problème et réduit légèrement la fréquence d'images pour garantir une image fluide.

La deuxième partie consiste à générer la scène. Dans cette partie, les auteurs ont directement utilisé Unreal Engine et certains des modèles 3D qui l'accompagnent pour créer l'arrière-plan de l'animation.

Par exemple, cet arrière-plan rotatif a l'air très cool :

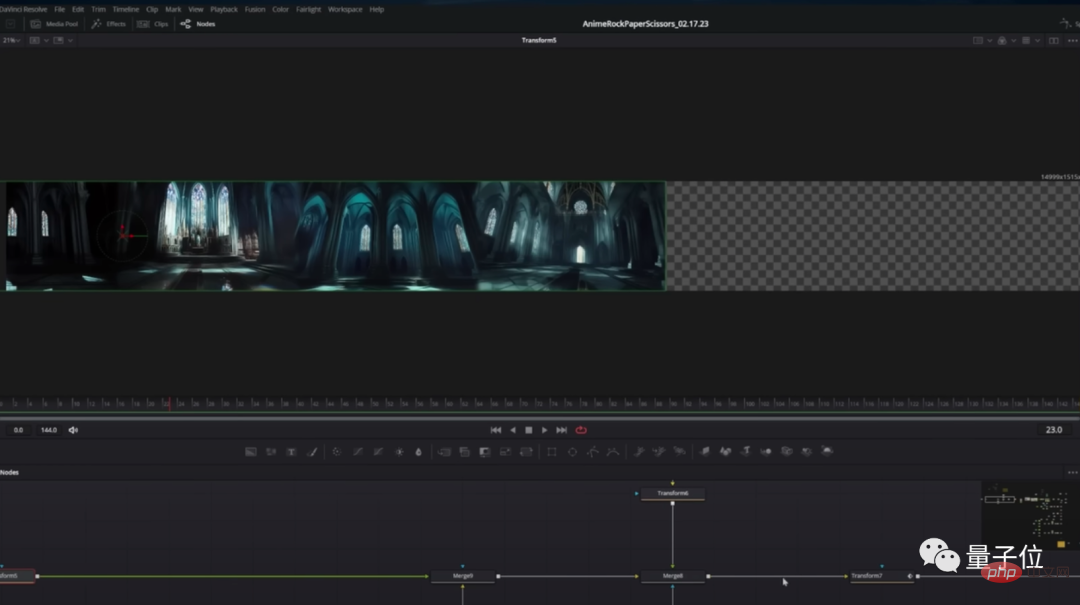

Le fond est réalisé en combinant un grand nombre de photos de scène et en défilant rapidement :

La dernière partie est le polissage après synthèse.

Cette partie a été réalisée par l'équipe elle-même. D'une part, ils ont ajouté quelques modèles 3D (comme des bougies vacillantes) à la vidéo pour augmenter l'immersion des personnages :

D'autre part, ils ont ajouté. beaucoup de visuels rétro Les effets spéciaux rendent l'animation beaucoup plus sophistiquée :

Enfin, il y a cette animation créée avec l'aide de l'IA.

Création de la vidéo d'effets spéciaux parodie de Boston Dynamics

L'équipe derrière cette création d'animation, Corridor Crew, vient d'un studio de production américain appelé Corridor Digital.

Corridor Digital a été créée en 2009. Au fil des années, elle a créé de nombreuses courtes vidéos populaires axées sur les effets spéciaux.

La plus connue est la « Contre-attaque d’Atlas » de 2019 (un nouveau robot peut maintenant riposter !) qui a usurpé le robot de Boston Dynamics.

Dans la vidéo, Atlas a été victime d'intimidation et de maltraitance à plusieurs reprises par des gens, et n'en a finalement plus pu et a lancé une attaque contre les humains :

△Source : "Bosstown Dynamics" (Dog Head)

Cette vidéo était autrefois considéré comme une véritable fuite des images de Boston Dynamics jusqu'à ce que Corridor Digital vienne le nier.

Par la suite, Boston Dynamics a également officiellement réfuté les rumeurs, affirmant qu'il ne s'agissait que d'un CGI produit par Corridor Digital.

L'équipe Corridor Crew de Corridor Digital Studio est chargée de réaliser des « programmes révélateurs » qui expliquent spécifiquement les effets spéciaux et les processus techniques de production derrière divers blockbusters. Les membres de l'équipe projetteront certaines séries télévisées et films, discuteront et décomposeront le visuel. coups d'effets.

Ils ont également invité de nombreux artistes et acteurs d'effets spéciaux à être invités dans l'émission pour observer leurs réactions aux divers effets spéciaux.

Concernant l'animation IA produite par l'équipe, certains internautes ont ridiculisé :

Pourquoi ne pas inviter des animateurs la prochaine fois ? Découvrez leurs réactions à cet anime IA.

Alors, que pensez-vous de l'effet d'animation réalisé par l'IA ?

Lien de référence :

[1]https://www.php.cn/link/f3957fa3bea9138b3f54f0e18975a30c

[2]https://www.php.cn/link/ 532435c44bec236b471a47a88d63513d

[3]https://twitter.com/bilawalsidhu/status/1631043203515449344

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Comment vérifier la configuration de CentOS HDFS

Apr 14, 2025 pm 07:21 PM

Comment vérifier la configuration de CentOS HDFS

Apr 14, 2025 pm 07:21 PM

Guide complet pour vérifier la configuration HDFS dans les systèmes CentOS Cet article vous guidera comment vérifier efficacement la configuration et l'état de l'exécution des HDF sur les systèmes CentOS. Les étapes suivantes vous aideront à bien comprendre la configuration et le fonctionnement des HDF. Vérifiez la variable d'environnement Hadoop: Tout d'abord, assurez-vous que la variable d'environnement Hadoop est correctement définie. Dans le terminal, exécutez la commande suivante pour vérifier que Hadoop est installé et configuré correctement: HadoopVersion Check HDFS Fichier de configuration: Le fichier de configuration de base de HDFS est situé dans le répertoire / etc / hadoop / conf / le répertoire, où Core-site.xml et hdfs-site.xml sont cruciaux. utiliser

Ligne de commande de l'arrêt CentOS

Apr 14, 2025 pm 09:12 PM

Ligne de commande de l'arrêt CentOS

Apr 14, 2025 pm 09:12 PM

La commande de fermeture CENTOS est arrêtée et la syntaxe est la fermeture de [options] le temps [informations]. Les options incluent: -H Arrêtez immédiatement le système; -P éteignez l'alimentation après l'arrêt; -r redémarrer; -t temps d'attente. Les temps peuvent être spécifiés comme immédiats (maintenant), minutes (minutes) ou une heure spécifique (HH: mm). Des informations supplémentaires peuvent être affichées dans les messages système.

Quelles sont les méthodes de sauvegarde pour Gitlab sur Centos

Apr 14, 2025 pm 05:33 PM

Quelles sont les méthodes de sauvegarde pour Gitlab sur Centos

Apr 14, 2025 pm 05:33 PM

La politique de sauvegarde et de récupération de GitLab dans le système CentOS afin d'assurer la sécurité et la récupérabilité des données, Gitlab on CentOS fournit une variété de méthodes de sauvegarde. Cet article introduira plusieurs méthodes de sauvegarde courantes, paramètres de configuration et processus de récupération en détail pour vous aider à établir une stratégie complète de sauvegarde et de récupération de GitLab. 1. MANUEL BACKUP Utilisez le Gitlab-RakegitLab: Backup: Créer la commande pour exécuter la sauvegarde manuelle. Cette commande sauvegarde des informations clés telles que le référentiel Gitlab, la base de données, les utilisateurs, les groupes d'utilisateurs, les clés et les autorisations. Le fichier de sauvegarde par défaut est stocké dans le répertoire / var / opt / gitlab / backups. Vous pouvez modifier / etc / gitlab

CentOS installe MySQL

Apr 14, 2025 pm 08:09 PM

CentOS installe MySQL

Apr 14, 2025 pm 08:09 PM

L'installation de MySQL sur CENTOS implique les étapes suivantes: Ajout de la source MySQL YUM appropriée. Exécutez la commande YUM Install MySQL-Server pour installer le serveur MySQL. Utilisez la commande mysql_secure_installation pour créer des paramètres de sécurité, tels que la définition du mot de passe de l'utilisateur racine. Personnalisez le fichier de configuration MySQL selon les besoins. Écoutez les paramètres MySQL et optimisez les bases de données pour les performances.

Comment faire fonctionner la formation distribuée de Pytorch sur CentOS

Apr 14, 2025 pm 06:36 PM

Comment faire fonctionner la formation distribuée de Pytorch sur CentOS

Apr 14, 2025 pm 06:36 PM

La formation distribuée par Pytorch sur le système CentOS nécessite les étapes suivantes: Installation de Pytorch: La prémisse est que Python et PIP sont installés dans le système CentOS. Selon votre version CUDA, obtenez la commande d'installation appropriée sur le site officiel de Pytorch. Pour la formation du processeur uniquement, vous pouvez utiliser la commande suivante: pipinstalltorchtorchVisionTorChaudio Si vous avez besoin d'une prise en charge du GPU, assurez-vous que la version correspondante de CUDA et CUDNN est installée et utilise la version Pytorch correspondante pour l'installation. Configuration de l'environnement distribué: la formation distribuée nécessite généralement plusieurs machines ou des GPU multiples uniques. Lieu

Explication détaillée du principe docker

Apr 14, 2025 pm 11:57 PM

Explication détaillée du principe docker

Apr 14, 2025 pm 11:57 PM

Docker utilise les fonctionnalités du noyau Linux pour fournir un environnement de fonctionnement d'application efficace et isolé. Son principe de travail est le suivant: 1. Le miroir est utilisé comme modèle en lecture seule, qui contient tout ce dont vous avez besoin pour exécuter l'application; 2. Le Système de fichiers Union (UnionFS) empile plusieurs systèmes de fichiers, ne stockant que les différences, l'économie d'espace et l'accélération; 3. Le démon gère les miroirs et les conteneurs, et le client les utilise pour l'interaction; 4. Les espaces de noms et les CGROUP implémentent l'isolement des conteneurs et les limitations de ressources; 5. Modes de réseau multiples prennent en charge l'interconnexion du conteneur. Ce n'est qu'en comprenant ces concepts principaux que vous pouvez mieux utiliser Docker.

Comment afficher les journaux Gitlab sous Centos

Apr 14, 2025 pm 06:18 PM

Comment afficher les journaux Gitlab sous Centos

Apr 14, 2025 pm 06:18 PM

Un guide complet pour consulter les journaux GitLab sous Centos System Cet article vous guidera comment afficher divers journaux GitLab dans le système CentOS, y compris les journaux principaux, les journaux d'exception et d'autres journaux connexes. Veuillez noter que le chemin du fichier journal peut varier en fonction de la version Gitlab et de la méthode d'installation. Si le chemin suivant n'existe pas, veuillez vérifier le répertoire d'installation et les fichiers de configuration de GitLab. 1. Afficher le journal GitLab principal Utilisez la commande suivante pour afficher le fichier journal principal de l'application GitLabRails: Commande: sudocat / var / log / gitlab / gitlab-rails / production.log Cette commande affichera le produit

Comment est la prise en charge du GPU pour Pytorch sur Centos

Apr 14, 2025 pm 06:48 PM

Comment est la prise en charge du GPU pour Pytorch sur Centos

Apr 14, 2025 pm 06:48 PM

Activer l'accélération du GPU Pytorch sur le système CentOS nécessite l'installation de versions CUDA, CUDNN et GPU de Pytorch. Les étapes suivantes vous guideront tout au long du processus: CUDA et CUDNN Installation détermineront la compatibilité de la version CUDA: utilisez la commande NVIDIA-SMI pour afficher la version CUDA prise en charge par votre carte graphique NVIDIA. Par exemple, votre carte graphique MX450 peut prendre en charge CUDA11.1 ou plus. Téléchargez et installez Cudatoolkit: visitez le site officiel de Nvidiacudatoolkit et téléchargez et installez la version correspondante selon la version CUDA la plus élevée prise en charge par votre carte graphique. Installez la bibliothèque CUDNN: