Périphériques technologiques

Périphériques technologiques

IA

IA

La multimodalité à nouveau unifiée ! Meta lance l'algorithme auto-supervisé data2vec 2.0 : l'efficacité de l'entraînement est multipliée par 16 !

La multimodalité à nouveau unifiée ! Meta lance l'algorithme auto-supervisé data2vec 2.0 : l'efficacité de l'entraînement est multipliée par 16 !

La multimodalité à nouveau unifiée ! Meta lance l'algorithme auto-supervisé data2vec 2.0 : l'efficacité de l'entraînement est multipliée par 16 !

La plupart des avancées dans le domaine de l'intelligence artificielle ces dernières années ont été motivées par l'apprentissage auto-supervisé. Par exemple, le MLM (Masked Language Model) proposé dans BERT, en masquant certains mots dans le texte puis en les réutilisant. -prédire, des données textuelles massives non étiquetées peuvent être utilisées pour entraîner des modèles, ce qui a depuis ouvert une nouvelle ère de modèles pré-entraînés à grande échelle. Cependant, les algorithmes d’apprentissage auto-supervisés présentent également des limites évidentes. Ils ne conviennent généralement qu’aux données dans une seule modalité (telles que les images, le texte, la parole, etc.) et nécessitent une grande puissance de calcul pour apprendre à partir de données massives. En revanche, les humains apprennent beaucoup plus efficacement que les modèles d’IA actuels et peuvent apprendre à partir de différents types de données.

En janvier 2022, Meta AI a publié le cadre d'apprentissage auto-supervisé data2vec, qui intègre trois modalités de données (voix, vision et texte) dans un seul cadre. tendance à unifier la multimodalité. Récemment Meta AI a publié data2cec version 2.0 , qui a principalement amélioré la génération précédente en termes de performances : avec la même précision, la vitesse d'entraînement est comparée à celle des autres l'algorithme a été amélioré jusqu'à 16 fois !

Lien papier : https://ai.facebook.com/research/publications/e efficace -apprentissage-auto-supervisé-avec-représentations-cibles-contextualisées-pour-la-vision-parole-et-langage

Lien de code :https://github.com /facebookresearch/fairseq/tree/main/examples/data2vec

data2vec 1.0

Actuellement, la plupart des modèles d'apprentissage automatique sont toujours basés sur des modèles d'apprentissage supervisé, qui nécessitent des annotateurs pour étiqueter les données cibles, mais pour certaines tâches (comme les milliers de langues humaines sur la planète), la collecte de données étiquetées n'est pas réalisable.

En revanche, l'apprentissage auto-supervisé n'a pas besoin d'indiquer au modèle ce qui est correct et faux, mais permet à la machine d'apprendre la structure des images, de la parole et du texte en observant le monde. Les résultats de recherches connexes ont favorisé le développement de la parole (par exemple, wave2vec 2.0), de la vision par ordinateur (par exemple, l'encodeur automatique masqué) et du traitement du langage naturel (par exemple, BERT).

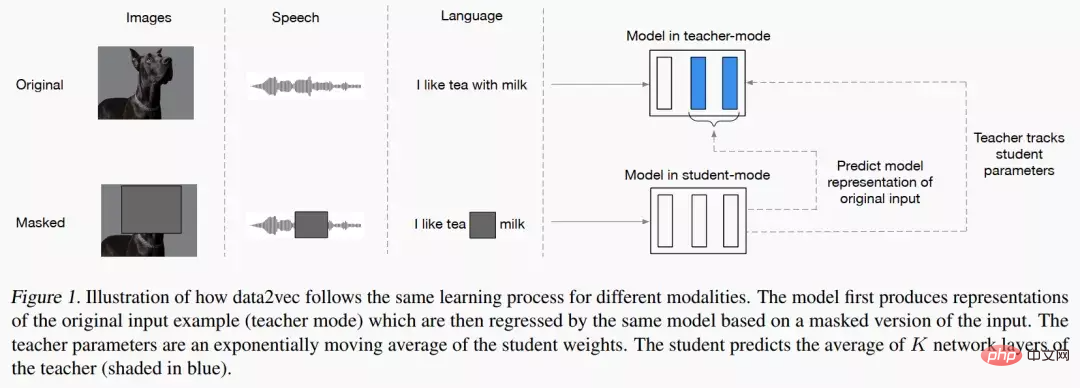

L'idée principale de data2vec est d'abord de construire un réseau d'enseignants et de calculer d'abord la représentation cible à partir d'images, de texte ou de discours. Les données sont ensuite masquées pour masquer certaines parties de l'entrée, et le processus est répété avec un réseau d'étudiants pour prédire les représentations obtenues par le modèle d'enseignant.

En d'autres termes, le modèle étudiant ne peut prédire que la représentation de « données d'entrée complètes » tout en acceptant des « informations d'entrée incomplètes ». Afin d'assurer la cohérence des deux modèles, les paramètres des deux modèles sont partagés, mais les paramètres du modèle Enseignant seront mis à jour plus rapidement dans les premières étapes de la formation. En termes de résultats expérimentaux, data2vec a considérablement amélioré les performances par rapport au modèle de base en matière de parole, de vision, de texte et d'autres tâches.

data2vec 2.0

data2vec propose un cadre général d'apprentissage auto-supervisé qui unifie l'apprentissage de trois données modales de la parole, de la vision et du langage, et data2vec2.0 résout principalement les problèmes Autrement dit, la création d'un modèle auto-supervisé nécessite une grande quantité de puissance de calcul GPU pour terminer la formation. Semblable à l'algorithme data2vec original, data2vec 2.0 prédit les représentations contextualisées de données ou les couches de réseaux neuronaux, plutôt que de prédire les pixels des images, les mots des segments de texte ou la parole.

Contrairement à d'autres algorithmes courants, ces soi-disant représentations cibles sont contextuelles, ce qui signifie que l'algorithme doit prendre en compte l'ensemble de l'exemple de formation.

Par exemple, le modèle apprend la représentation du mot banque sur la base de la phrase entière contenant banque, ce qui facilite la déduction du sens correct du mot, par exemple en distinguant s'il fait spécifiquement référence à « financier » institution » ou « terrain au bord de la rivière » ». Les chercheurs pensent que les objectifs contextualisés faciliteront des tâches d’apprentissage plus riches et permettront à data2vec 2.0 d’apprendre plus rapidement que les autres algorithmes.

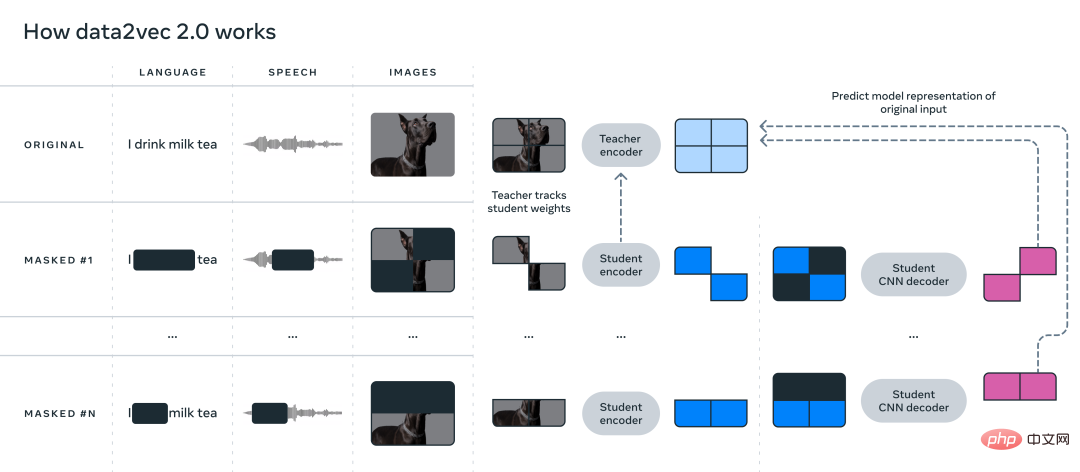

data2vec 2.0 améliore l'efficacité de l'algorithme data2vec d'origine des trois manières suivantes :

1. Construisez une représentation cible pour un exemple d'entraînement spécifique et réutilisez cette représentation dans le masque version. Dans la version masquée, différentes parties des exemples de formation sont masquées de manière aléatoire. Les représentations apprises par les deux versions sont ensuite introduites dans le modèle d'étudiant, qui prédit la même représentation cible contextualisée pour différentes versions de masque, amortissant ainsi l'effort de calcul requis pour créer la représentation cible.

2. Semblable à l'auto-encodeur masqué (MAE), le réseau d'encodeurs dans le modèle étudiant n'exploite pas la partie masquée des exemples de formation. Dans les expériences d’images, environ 80 % des sections étaient vierges, ce qui a permis d’importantes économies de cycles de calcul.

3. Un modèle de décodeur plus efficace est utilisé, qui ne repose plus sur le réseau Transformer, mais s'appuie sur un réseau convolutif multicouche.

Section expérimentale

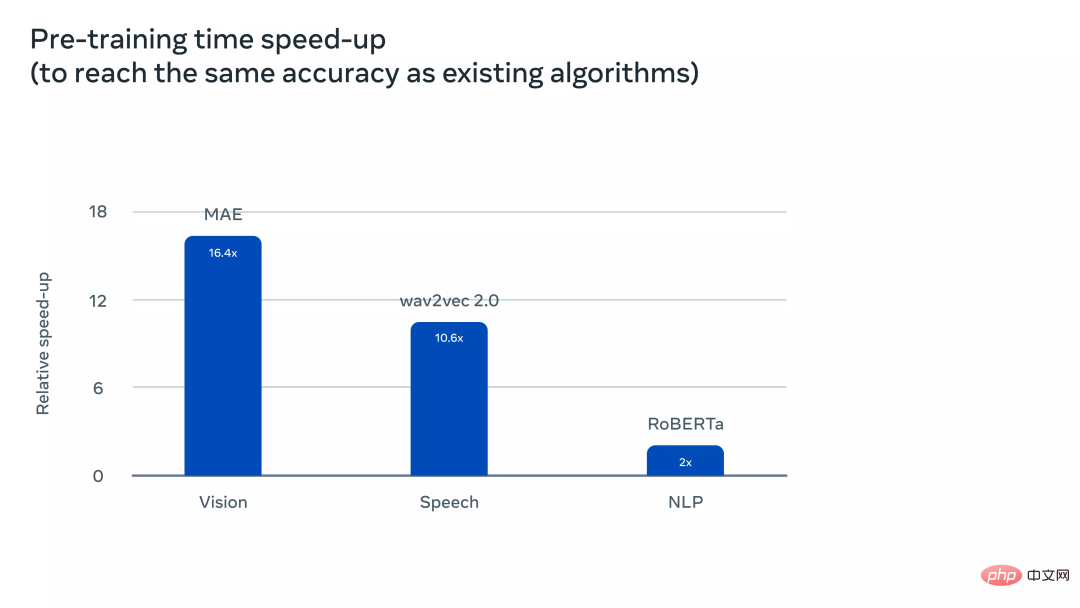

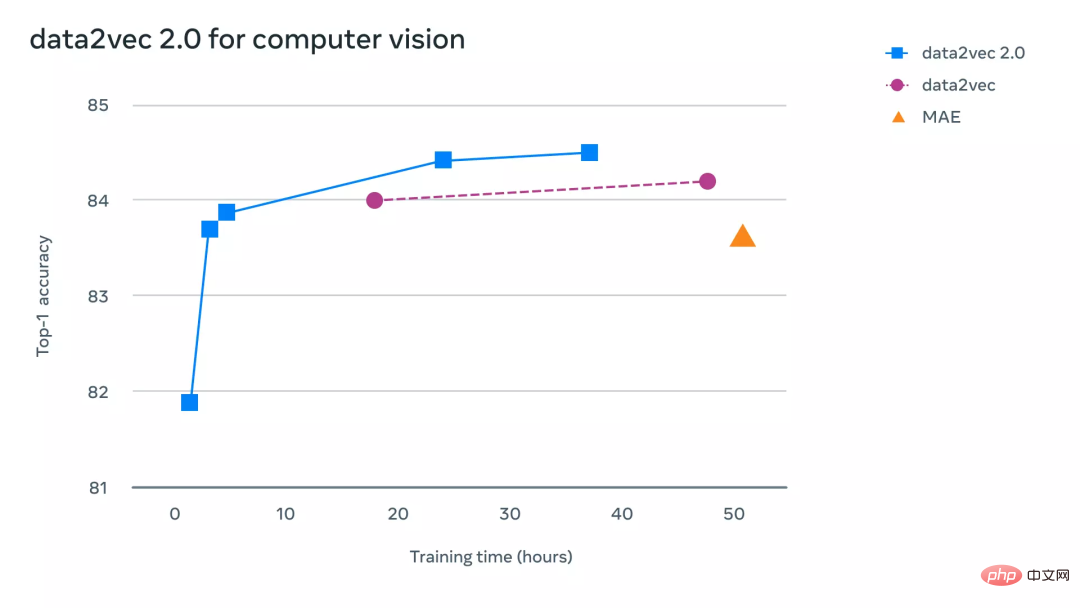

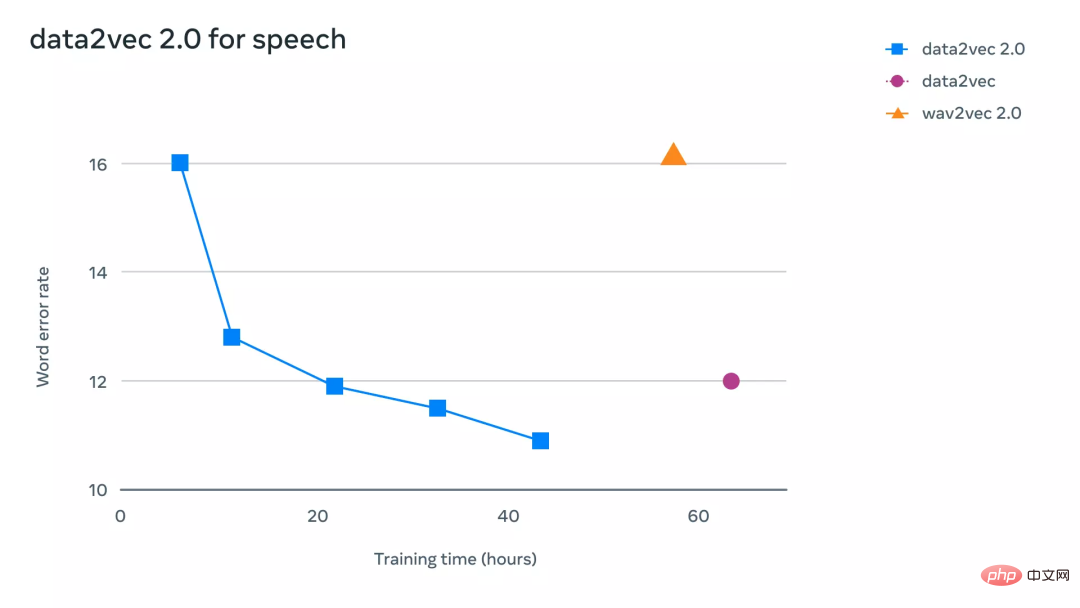

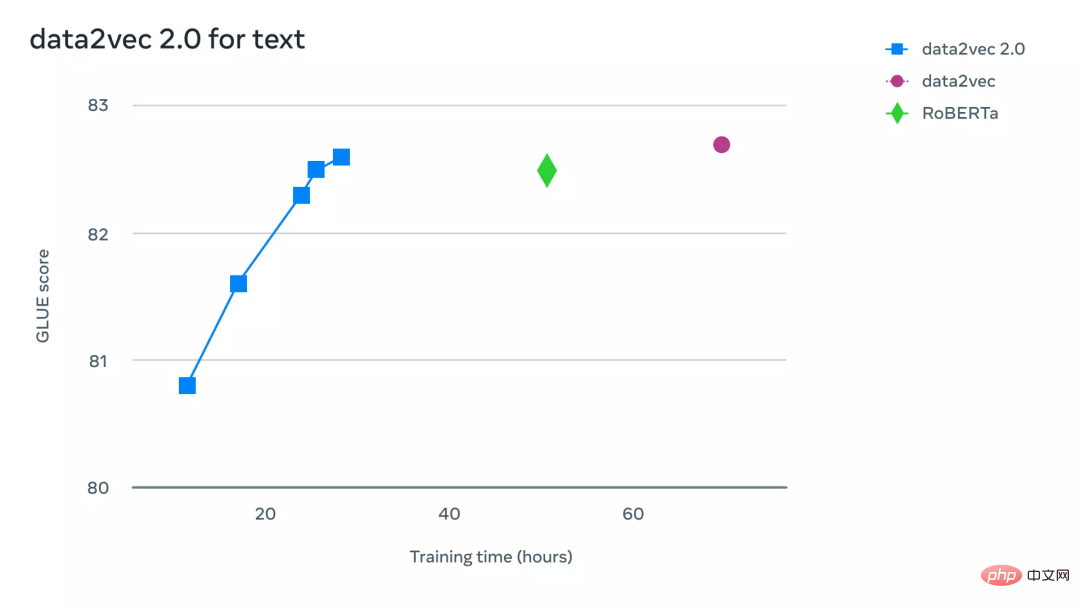

Pour comprendre plus intuitivement à quel point data2vec 2.0 est plus efficace que data2vec et d'autres algorithmes similaires, les chercheurs ont mené des expériences approfondies sur des benchmarks liés aux tâches de vision par ordinateur, de parole et de texte. Dans l'expérience, la précision finale et le temps nécessaire au pré-entraînement du modèle ont été principalement pris en compte. L'environnement expérimental était sur le même matériel (modèle GPU, quantité, etc.) pour mesurer la vitesse d'exécution de l'algorithme.

Sur les tâches de vision par ordinateur, les chercheurs ont évalué data2vec 2.0 sur le benchmark standard de classification d'images ImageNet-1K, un ensemble de données à partir duquel le modèle apprend les représentations d'images. Les résultats expérimentaux montrent que data2vec 2.0 peut égaler la précision de l'auto-encodeur masqué (MAE), mais est 16 fois plus rapide.

Si vous continuez à donner plus de temps d'exécution à l'algorithme data2vec 2.0, il peut atteindre une plus grande précision tout en étant plus rapide que MAE.

Sur la tâche vocale, les chercheurs l'ont testé sur le benchmark de reconnaissance vocale LibriLanguage, et il était plus de 11 fois plus précis que wave2vec 2.0.

Pour les tâches de traitement du langage naturel, les chercheurs ont évalué data2vec 2.0 sur le benchmark General Language Understanding Evaluation (GLUE), obtenant la même précision que RoBERTa, une réimplémentation de BERT, en seulement la moitié du temps de formation.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Conseils de configuration du pare-feu Debian Mail Server

Apr 13, 2025 am 11:42 AM

Conseils de configuration du pare-feu Debian Mail Server

Apr 13, 2025 am 11:42 AM

La configuration du pare-feu d'un serveur de courrier Debian est une étape importante pour assurer la sécurité du serveur. Voici plusieurs méthodes de configuration de pare-feu couramment utilisées, y compris l'utilisation d'iptables et de pare-feu. Utilisez les iptables pour configurer le pare-feu pour installer iptables (sinon déjà installé): Sudoapt-getUpDaSuDoapt-getinstalliptableView Règles actuelles iptables: Sudoiptable-L Configuration

Comment Debian Readdir s'intègre à d'autres outils

Apr 13, 2025 am 09:42 AM

Comment Debian Readdir s'intègre à d'autres outils

Apr 13, 2025 am 09:42 AM

La fonction ReadDir dans le système Debian est un appel système utilisé pour lire le contenu des répertoires et est souvent utilisé dans la programmation C. Cet article expliquera comment intégrer ReadDir avec d'autres outils pour améliorer sa fonctionnalité. Méthode 1: combinant d'abord le programme de langue C et le pipeline, écrivez un programme C pour appeler la fonction readdir et sortir le résultat: # include # include # include # includeIntmain (intargc, char * argv []) {dir * dir; structDirent * entrée; if (argc! = 2) {

Comment implémenter le tri des fichiers par Debian Readdir

Apr 13, 2025 am 09:06 AM

Comment implémenter le tri des fichiers par Debian Readdir

Apr 13, 2025 am 09:06 AM

Dans Debian Systems, la fonction ReadDir est utilisée pour lire le contenu du répertoire, mais l'ordre dans lequel il revient n'est pas prédéfini. Pour trier les fichiers dans un répertoire, vous devez d'abord lire tous les fichiers, puis les trier à l'aide de la fonction QSORT. Le code suivant montre comment trier les fichiers de répertoire à l'aide de ReadDir et QSort dans Debian System: # include # include # include # include # include // Fonction de comparaison personnalisée, utilisée pour qsortintCompare (constvoid * a, constvoid * b) {returnstrcmp (* (

Méthode d'installation du certificat de Debian Mail Server SSL

Apr 13, 2025 am 11:39 AM

Méthode d'installation du certificat de Debian Mail Server SSL

Apr 13, 2025 am 11:39 AM

Les étapes pour installer un certificat SSL sur le serveur de messagerie Debian sont les suivantes: 1. Installez d'abord la boîte à outils OpenSSL, assurez-vous que la boîte à outils OpenSSL est déjà installée sur votre système. Si ce n'est pas installé, vous pouvez utiliser la commande suivante pour installer: Sudoapt-getUpDaSuDoapt-getInstallOpenSSL2. Générer la clé privée et la demande de certificat Suivant, utilisez OpenSSL pour générer une clé privée RSA 2048 bits et une demande de certificat (RSE): OpenSS

Comment effectuer une vérification de la signature numérique avec Debian OpenSSL

Apr 13, 2025 am 11:09 AM

Comment effectuer une vérification de la signature numérique avec Debian OpenSSL

Apr 13, 2025 am 11:09 AM

En utilisant OpenSSL pour la vérification de la signature numérique sur Debian System, vous pouvez suivre ces étapes: Préparation à installer OpenSSL: Assurez-vous que votre système Debian a installé OpenSSL. Si vous n'êtes pas installé, vous pouvez utiliser la commande suivante pour l'installer: SudoaptupDaSudoaptinInStallOpenssl pour obtenir la clé publique: la vérification de la signature numérique nécessite la clé publique du signataire. En règle générale, la clé publique sera fournie sous la forme d'un fichier, comme public_key.pe

Comment Debian OpenSSL empêche les attaques de l'homme au milieu

Apr 13, 2025 am 10:30 AM

Comment Debian OpenSSL empêche les attaques de l'homme au milieu

Apr 13, 2025 am 10:30 AM

Dans Debian Systems, OpenSSL est une bibliothèque importante pour le chiffrement, le décryptage et la gestion des certificats. Pour empêcher une attaque d'homme dans le milieu (MITM), les mesures suivantes peuvent être prises: utilisez HTTPS: assurez-vous que toutes les demandes de réseau utilisent le protocole HTTPS au lieu de HTTP. HTTPS utilise TLS (Protocole de sécurité de la couche de transport) pour chiffrer les données de communication pour garantir que les données ne sont pas volées ou falsifiées pendant la transmission. Vérifiez le certificat de serveur: vérifiez manuellement le certificat de serveur sur le client pour vous assurer qu'il est digne de confiance. Le serveur peut être vérifié manuellement via la méthode du délégué d'URLSession

Comment faire Debian Hadoop Log Management

Apr 13, 2025 am 10:45 AM

Comment faire Debian Hadoop Log Management

Apr 13, 2025 am 10:45 AM

Gérer les journaux Hadoop sur Debian, vous pouvez suivre les étapes et les meilleures pratiques suivantes: l'agrégation de journal Activer l'agrégation de journaux: définir yarn.log-aggregation-inable à true dans le fichier yarn-site.xml pour activer l'agrégation de journaux. Configurer la stratégie de rétention du journal: Définissez Yarn.log-agregation.retain-secondes pour définir le temps de rétention du journal, tel que 172800 secondes (2 jours). Spécifiez le chemin de stockage des journaux: via yarn.n

Ligne de commande de l'arrêt CentOS

Apr 14, 2025 pm 09:12 PM

Ligne de commande de l'arrêt CentOS

Apr 14, 2025 pm 09:12 PM

La commande de fermeture CENTOS est arrêtée et la syntaxe est la fermeture de [options] le temps [informations]. Les options incluent: -H Arrêtez immédiatement le système; -P éteignez l'alimentation après l'arrêt; -r redémarrer; -t temps d'attente. Les temps peuvent être spécifiés comme immédiats (maintenant), minutes (minutes) ou une heure spécifique (HH: mm). Des informations supplémentaires peuvent être affichées dans les messages système.