Périphériques technologiques

Périphériques technologiques

IA

IA

ChatGPT multimodal Microsoft arrive ? 1,6 milliard de paramètres pour gérer des tâches telles que regarder des images et répondre à des questions, des tests de QI, etc.

ChatGPT multimodal Microsoft arrive ? 1,6 milliard de paramètres pour gérer des tâches telles que regarder des images et répondre à des questions, des tests de QI, etc.

ChatGPT multimodal Microsoft arrive ? 1,6 milliard de paramètres pour gérer des tâches telles que regarder des images et répondre à des questions, des tests de QI, etc.

Dans le domaine de la PNL, les grands modèles de langage (LLM) ont servi avec succès d'interface commune dans diverses tâches en langage naturel. Tant que nous pouvons convertir l'entrée et la sortie en texte, nous pouvons adapter l'interface basée sur LLM à une tâche. Par exemple, la tâche récapitulative récupère des documents et génère des informations récapitulatives. Ainsi, nous pouvons introduire les documents d'entrée dans un modèle de langage récapitulatif et générer un résumé.

Malgré l'application réussie du LLM dans les tâches de PNL, les chercheurs ont encore du mal à l'utiliser de manière native pour les données multimodales telles que les images et l'audio. En tant que composante fondamentale de l’intelligence, la perception multimodale est une condition nécessaire pour parvenir à une intelligence artificielle générale, tant pour l’acquisition de connaissances que pour la gestion du monde réel. Plus important encore, débloquer la saisie multimodale peut considérablement étendre l’application des modèles linguistiques dans des domaines à plus forte valeur ajoutée, tels que la robotique multimodale, l’intelligence documentaire et la robotique.

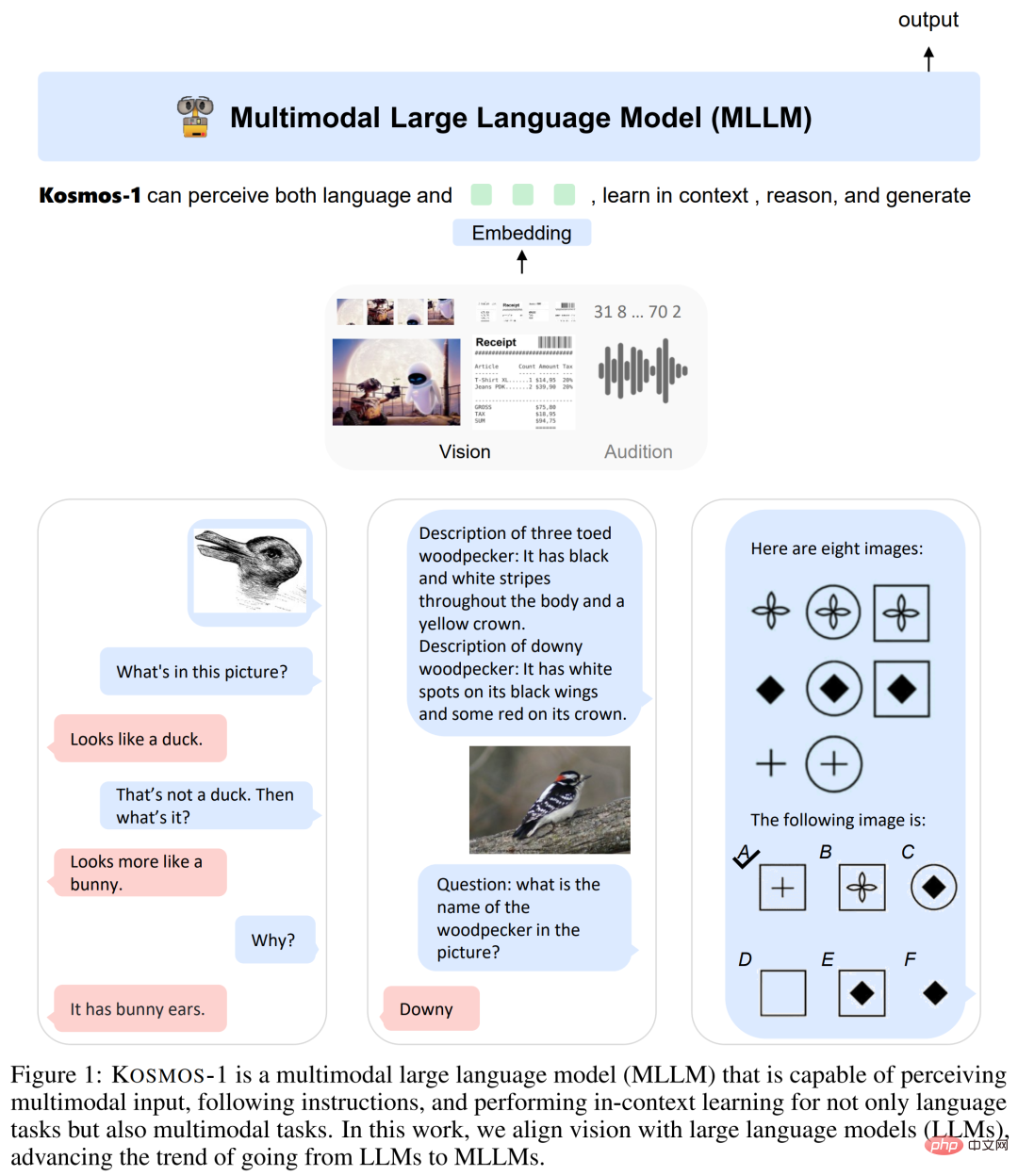

Par conséquent, l'équipe Microsoft a introduit un Multimodal Large Language Model (MLLM) - KOSMOS-1 dans l'article "Le langage n'est pas tout ce dont vous avez besoin : aligner la perception avec les modèles de langage", qui peut percevoir la modalité générale, en suivant instructions (c'est-à-dire apprentissage sans tir) et apprentissage en contexte (c'est-à-dire apprentissage en quelques coups) . L'objectif de la recherche est d'aligner la perception avec le LLM afin que le modèle puisse voir et parler. Les chercheurs ont formé KOSMOS-1 à partir de zéro selon la méthode de METALM (voir l'article « Les modèles de langage sont des interfaces à usage général »).

- Adresse papier : https://arxiv.org/pdf/2302.14045.pdf

- Adresse du projet : https://github.com/microsoft/unilm

Comme le montre la figure 1 ci-dessous, le chercheur utilise un modèle de langage basé sur Transformer comme interface générale et le connecte au module de perception. Ils ont formé le modèle sur un corpus multimodal à l’échelle du Web, qui comprend des données textuelles, des images et du texte arbitrairement entrelacés, ainsi que des paires image-légende. De plus, les chercheurs ont calibré l’enseignement intermodal en fonction des capacités en transmettant des données linguistiques pures.

Enfin, le modèle KOSMOS-1 prend en charge nativement le langage, le langage perceptuel et les tâches visuelles dans des paramètres d'apprentissage à zéro et à quelques coups, comme le montre le tableau 1 ci-dessous.

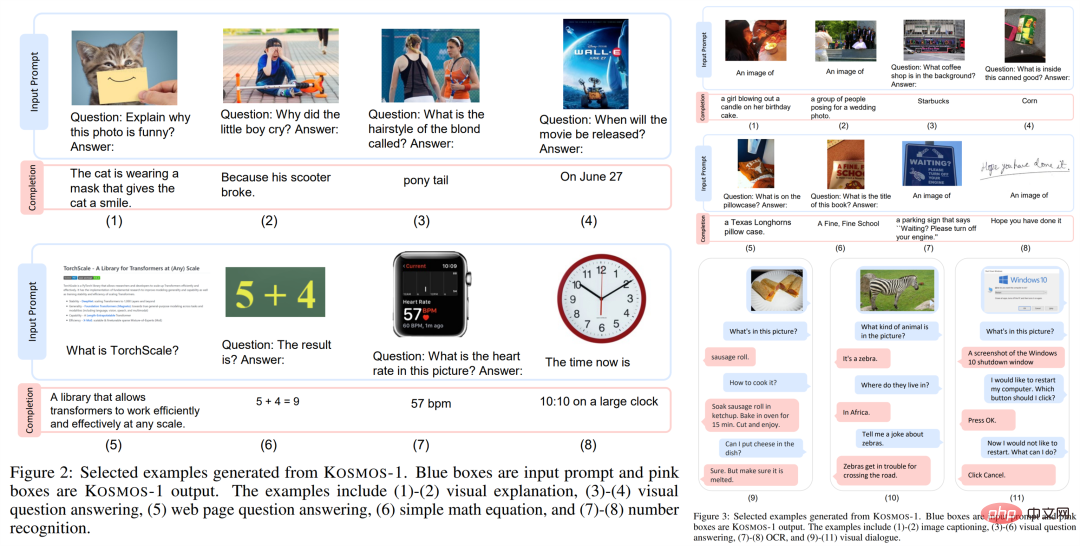

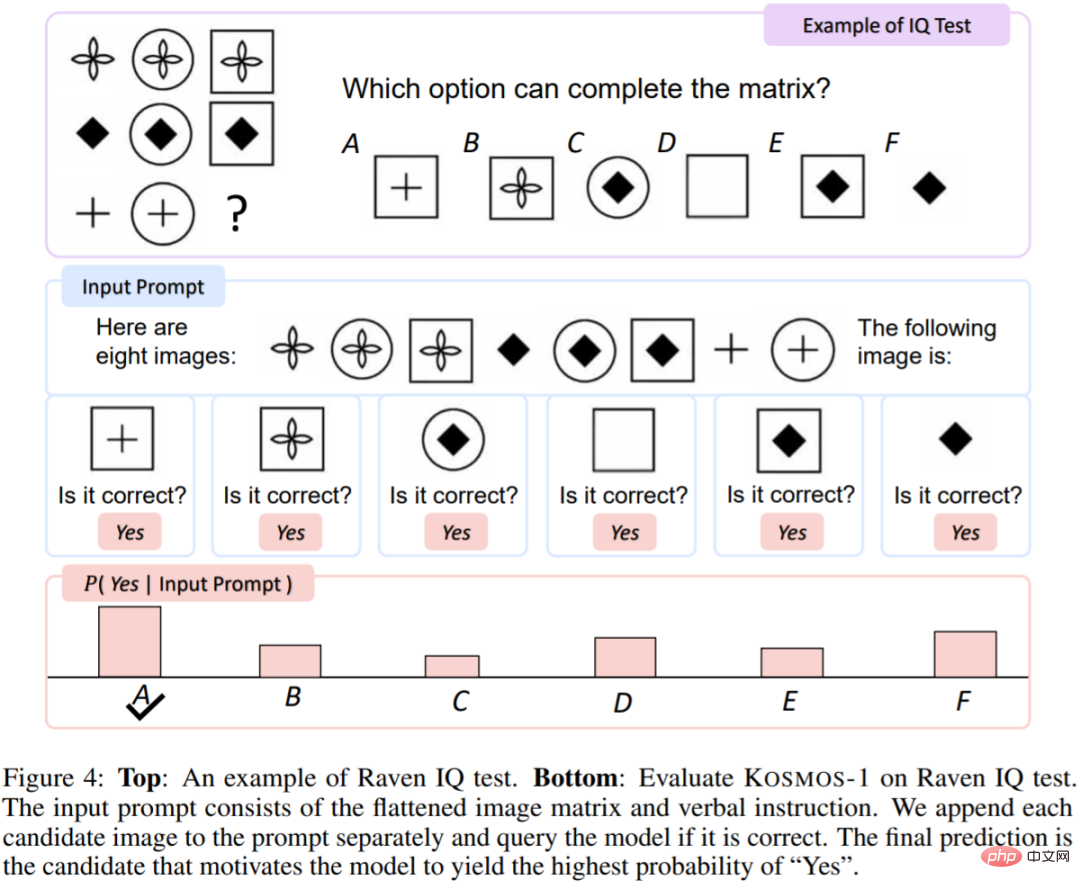

Les chercheurs montrent quelques exemples générés dans les figures 2 et 3 ci-dessous. En plus de diverses tâches en langage naturel, le modèle KOSMOS-1 est capable de gérer nativement un large éventail de tâches à forte intensité de perception, telles que le dialogue visuel, l'explication visuelle, la réponse visuelle aux questions, les sous-titres d'images, les équations mathématiques simples, l'OCR et images sans prise de vue avec descriptions Classification. Ils ont également établi un test de référence de QI basé sur les matrices progressives de Raven (RPM) pour évaluer la capacité de raisonnement non verbal de MLLM.

Ces exemples démontrent que la prise en charge native de la perception multimodale ouvre de nouvelles opportunités pour appliquer le LLM à de nouvelles tâches. De plus, par rapport au LLM, le MLLM atteint de meilleures performances de raisonnement de bon sens, ce qui indique que le transfert intermodal facilite l'acquisition de connaissances.

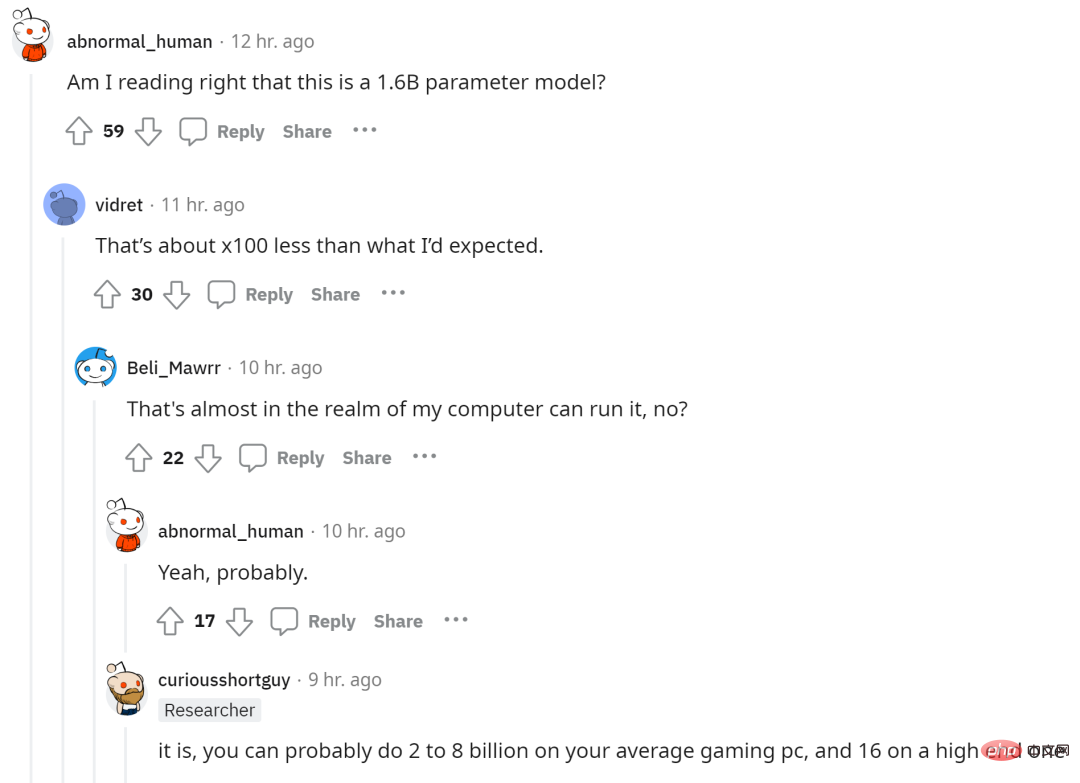

Le nombre de paramètres du modèle KOSMOS-1 étant de 1,6 milliard, certains internautes ont exprimé l'espoir de faire fonctionner ce grand modèle multimodal sur leurs ordinateurs.

KOSMOS-1 : un modèle de langage multimodal à grande échelle

Comme le montre la figure 1, KOSMOS-1 est un modèle de langage multimodal qui peut percevoir des modalités générales, suivre des instructions, apprendre en contexte et générer des résultats. Plus précisément, l'épine dorsale de KOSMOS-1 est un modèle de langage causal basé sur Transformer. En plus du texte, d'autres modalités peuvent également être intégrées et entrées dans le modèle. Comme le montre la figure ci-dessous, en plus du langage, il existe également des intégrations de vision, de parole, etc. Les décodeurs de transformateur servent d'interface générale pour les entrées multimodales. Une fois le modèle entraîné, KOSMOS-1 peut également être évalué sur des tâches linguistiques et des tâches multimodales dans des contextes de tir nul et de tir réduit.

Le décodeur de transformateur perçoit la modalité de manière unifiée et les informations d'entrée seront aplaties en une séquence avec des jetons spéciaux. Par exemple, signifie le début de la séquence et signifie la fin de la séquence. Les jetons spéciaux

Le module d'intégration code les jetons de texte et d'autres modalités de saisie dans des représentations vectorielles pour les jetons d'entrée, l'étude utilise une table de recherche pour les mapper dans des intégrations. Pour les modalités de signal continu (par exemple, images et audio), l'entrée peut également être représentée sous forme de codes discrets.

Après cela, l'intégration de la séquence d'entrée obtenue est transmise au décodeur basé sur Transformer. Le modèle causal traite ensuite la séquence de manière autorégressive, aboutissant au jeton suivant. En résumé, le framework MLLM peut gérer de manière flexible différents types de données tant que les entrées sont représentées sous forme de vecteurs.

Formation du modèle

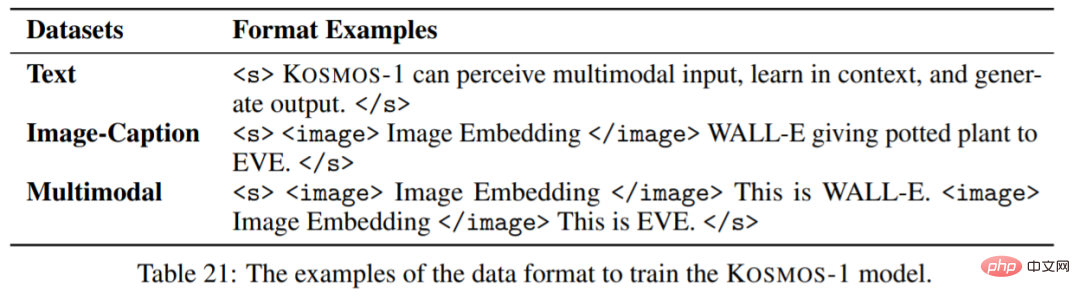

Le premier est l'ensemble de données de formation. Les ensembles de données comprennent des corpus de texte, des paires image-sous-titres et des ensembles de données croisées image et texte. Plus précisément, le corpus de texte comprend The Pile et Common Crawl (CC) ; les paires image-sous-titres incluent les anglais LAION-2B, LAION-400M, COYO-700M et Conceptual Captions ; l'ensemble de données multimodales d'image et de texte provient de Common Crawl ; instantané.

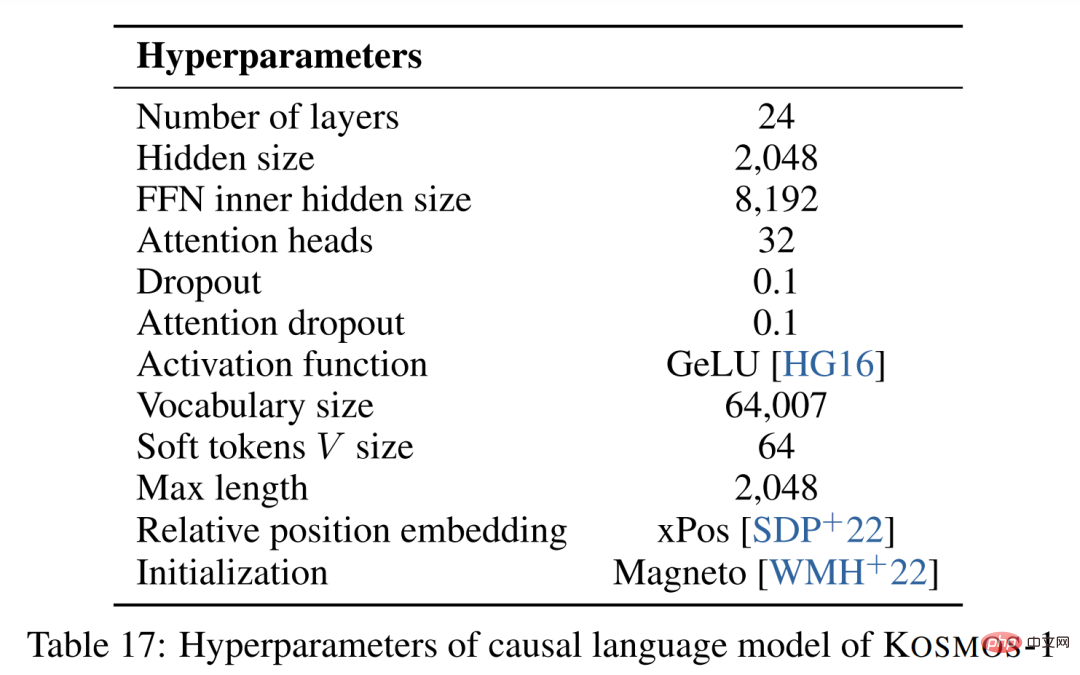

Maintenant que nous avons l'ensemble de données, nous avons les paramètres d'entraînement. Le composant MLLM contient 24 couches, des dimensions cachées de 2 048, 8 192 FFN, 32 têtes d'attention et une taille de paramètre de 1,3 B. Pour permettre une meilleure convergence du modèle, la représentation de l'image est obtenue à partir du modèle CLIP ViT-L/14 pré-entraîné avec 1024 dimensions de caractéristiques. Les images sont prétraitées à une résolution de 224 × 224 pendant la formation. De plus, tous les paramètres du modèle CLIP, à l'exception de la dernière couche, sont gelés pendant la formation. Le nombre total de paramètres pour KOSMOS-1 est d’environ 1,6 milliard.

Résultats expérimentaux

Cette étude a mené une série d'expériences riches pour évaluer KOSMOS-1 : tâches linguistiques (compréhension du langage, génération de langage, classification de texte sans OCR) ; Raisonnement de bon sens ; Raisonnement non verbal (test de QI) ; Tâches perceptuelles et linguistiques (sous-titres d'images, questions et réponses visuelles, questions et réponses de pages Web (classification d'images sans plan, classification d'images sans plan avec description) ; ).

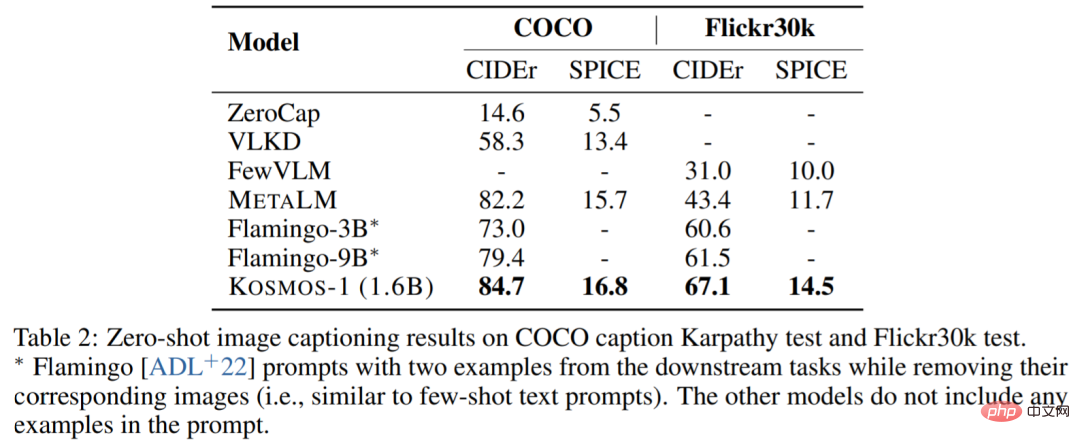

Légendes des images. Le tableau suivant montre les performances sans échantillon de différents modèles sur COCO et Flickr30k. Comparé à d'autres modèles, le KOSMOS-1 a obtenu des résultats significatifs et ses performances sont également bonnes, même si le nombre de paramètres est beaucoup plus petit que celui du Flamingo.

Le tableau suivant montre la comparaison des performances de quelques échantillons :

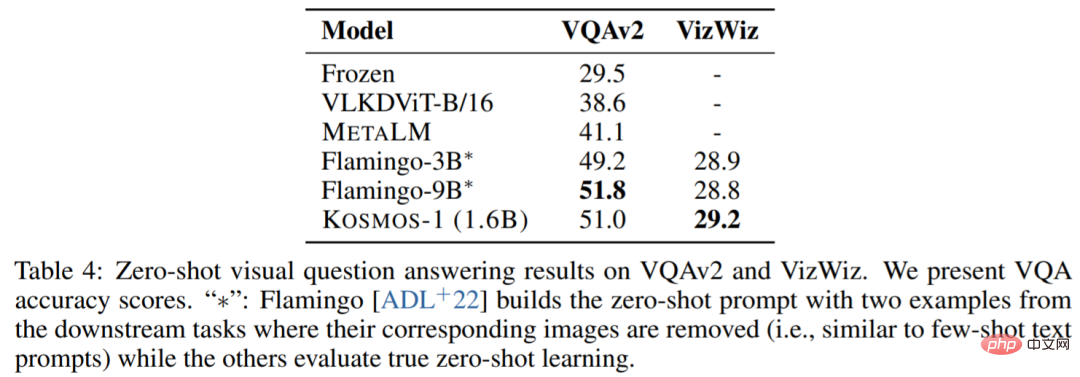

Questions et réponses visuelles. KOSMOS-1 a une précision et une robustesse supérieures à celles des modèles Flamingo-3B et Flamingo-9B :

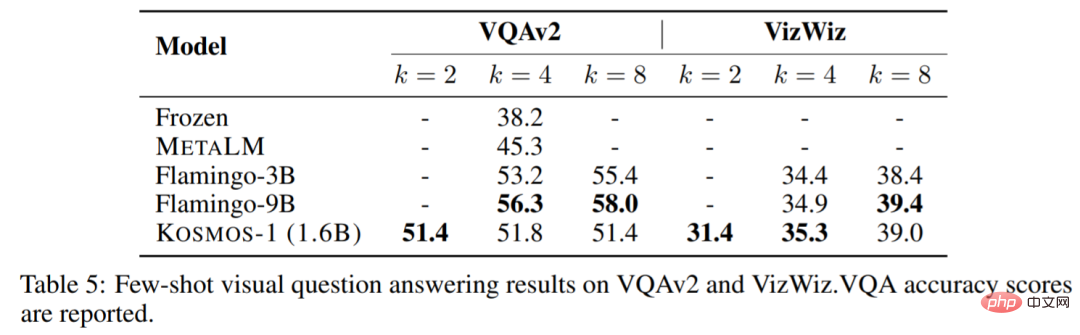

Le tableau suivant montre une comparaison des performances de quelques exemples :

Test de QI. Le test de raisonnement de Raven est l'un des tests les plus couramment utilisés pour évaluer le raisonnement non verbal. La figure 4 montre un exemple.

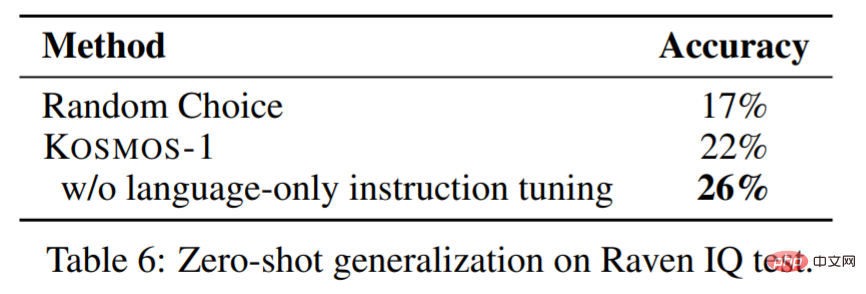

Le tableau 6 montre les résultats de l'évaluation sur l'ensemble de données du test de QI. KOSMOS-1 est capable de percevoir des modèles conceptuels abstraits dans un environnement non verbal, puis de raisonner les éléments suivants parmi de multiples choix. À notre connaissance, c’est la première fois qu’un modèle est capable d’effectuer un tel test Raven IQ sur échantillon zéro.

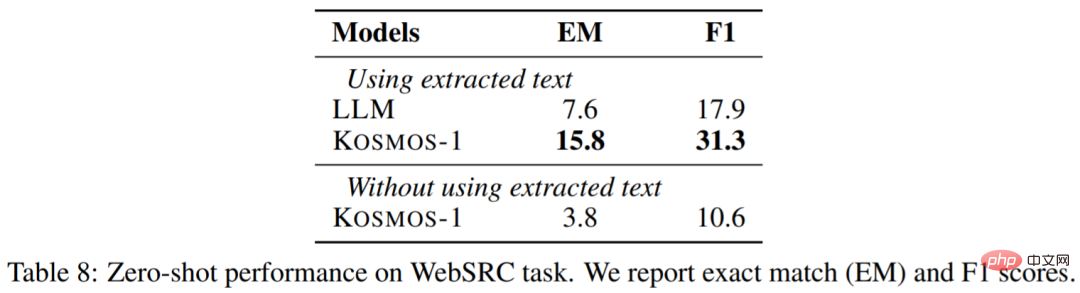

Questions et réponses Web. Web Q&A vise à trouver des réponses aux questions des pages Web. Cela nécessite que le modèle comprenne à la fois la sémantique et la structure du texte. Les résultats sont les suivants :

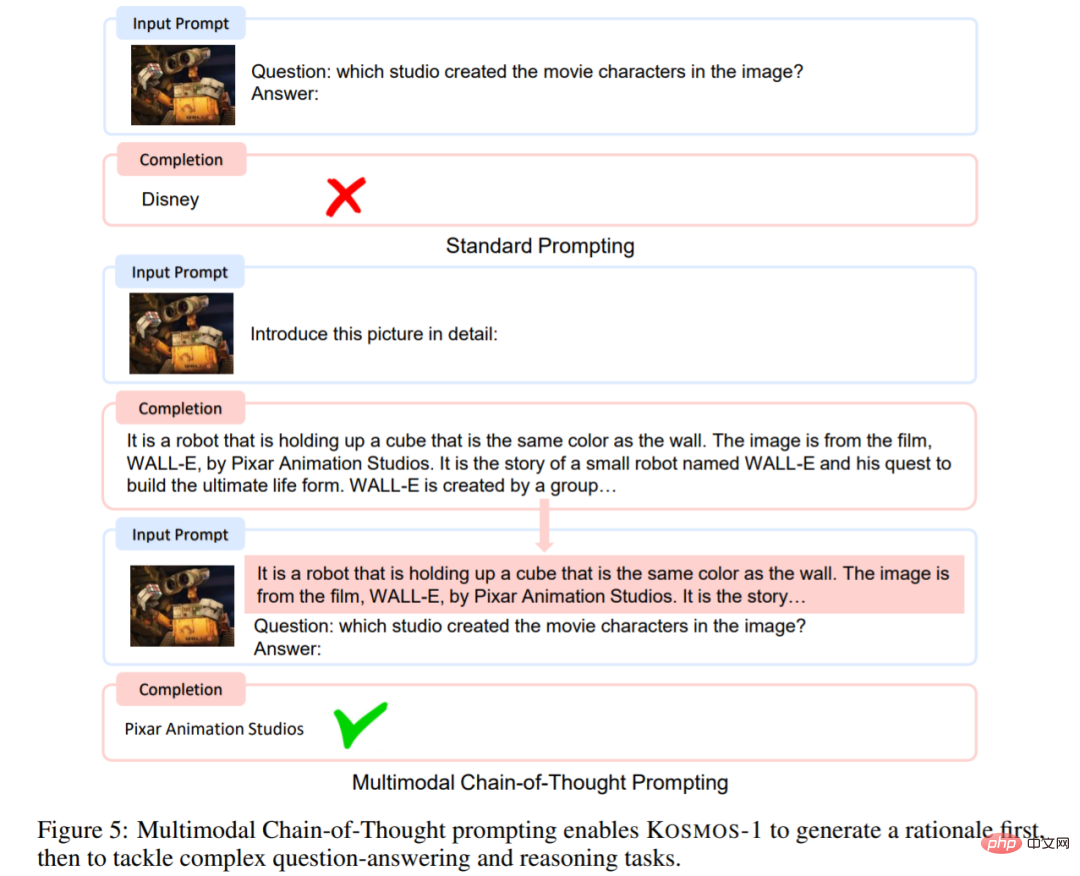

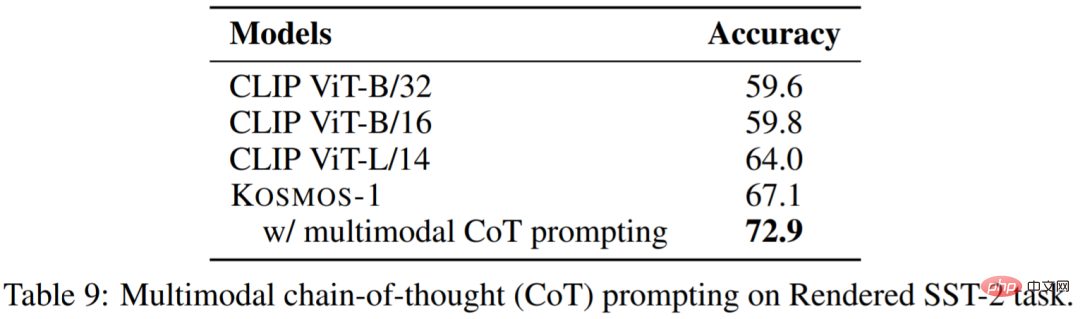

Invites à la chaîne de pensée multimodale. Inspiré par les invites de la chaîne de réflexion, cet article a mené une expérience à cet égard. Comme le montre la figure 5, cet article décompose la tâche de perception du langage en deux étapes. Étant donné une image dans la première étape, des indices sont utilisés pour guider le modèle afin de générer une sortie qui répond aux exigences pour produire le résultat final.

Comme le montre le tableau 9, le score de l'invite de chaîne de pensée multimodale est de 72,9 points, soit 5,8 points de plus que l'invite standard :

En savoir plus à propos de l'expérience, veuillez vous référer à l'article original.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Comment créer une base de données Oracle Comment créer une base de données Oracle

Apr 11, 2025 pm 02:33 PM

Comment créer une base de données Oracle Comment créer une base de données Oracle

Apr 11, 2025 pm 02:33 PM

La création d'une base de données Oracle n'est pas facile, vous devez comprendre le mécanisme sous-jacent. 1. Vous devez comprendre les concepts de la base de données et des SGBD Oracle; 2. Master les concepts de base tels que SID, CDB (base de données de conteneurs), PDB (base de données enfichable); 3. Utilisez SQL * Plus pour créer CDB, puis créer PDB, vous devez spécifier des paramètres tels que la taille, le nombre de fichiers de données et les chemins; 4. Les applications avancées doivent ajuster le jeu de caractères, la mémoire et d'autres paramètres et effectuer un réglage des performances; 5. Faites attention à l'espace disque, aux autorisations et aux paramètres des paramètres, et surveillez et optimisez en continu les performances de la base de données. Ce n'est qu'en le maîtrisant habilement une pratique continue que vous pouvez vraiment comprendre la création et la gestion des bases de données Oracle.

Comment créer une base de données Oracle Comment créer une base de données Oracle

Apr 11, 2025 pm 02:36 PM

Comment créer une base de données Oracle Comment créer une base de données Oracle

Apr 11, 2025 pm 02:36 PM

Pour créer une base de données Oracle, la méthode commune consiste à utiliser l'outil graphique DBCA. Les étapes sont les suivantes: 1. Utilisez l'outil DBCA pour définir le nom DBN pour spécifier le nom de la base de données; 2. Définissez Syspassword et SystemPassword sur des mots de passe forts; 3. Définir les caractères et NationalCharacterset à Al32Utf8; 4. Définissez la taille de mémoire et les espaces de table pour s'ajuster en fonction des besoins réels; 5. Spécifiez le chemin du fichier log. Les méthodes avancées sont créées manuellement à l'aide de commandes SQL, mais sont plus complexes et sujets aux erreurs. Faites attention à la force du mot de passe, à la sélection du jeu de caractères, à la taille et à la mémoire de l'espace de table

Comment rédiger des instructions de base de données Oracle

Apr 11, 2025 pm 02:42 PM

Comment rédiger des instructions de base de données Oracle

Apr 11, 2025 pm 02:42 PM

Le cœur des instructions Oracle SQL est sélectionné, insérer, mettre à jour et supprimer, ainsi que l'application flexible de diverses clauses. Il est crucial de comprendre le mécanisme d'exécution derrière l'instruction, tel que l'optimisation de l'indice. Les usages avancés comprennent des sous-requêtes, des requêtes de connexion, des fonctions d'analyse et PL / SQL. Les erreurs courantes incluent les erreurs de syntaxe, les problèmes de performances et les problèmes de cohérence des données. Les meilleures pratiques d'optimisation des performances impliquent d'utiliser des index appropriés, d'éviter la sélection *, d'optimiser les clauses et d'utiliser des variables liées. La maîtrise d'Oracle SQL nécessite de la pratique, y compris l'écriture de code, le débogage, la réflexion et la compréhension des mécanismes sous-jacents.

Comment ajouter, modifier et supprimer le guide de fonctionnement du champ de table de données MySQL

Apr 11, 2025 pm 05:42 PM

Comment ajouter, modifier et supprimer le guide de fonctionnement du champ de table de données MySQL

Apr 11, 2025 pm 05:42 PM

Guide de fonctionnement du champ dans MySQL: Ajouter, modifier et supprimer les champs. Ajouter un champ: alter table table_name Ajouter Column_name data_type [pas null] [Default default_value] [Clé primaire] [Auto_increment] Modifier le champ: alter table table_name modifie Column_name data_type [pas null] [default default_value] [clé primaire]

Quelles sont les contraintes d'intégrité des tables de base de données Oracle?

Apr 11, 2025 pm 03:42 PM

Quelles sont les contraintes d'intégrité des tables de base de données Oracle?

Apr 11, 2025 pm 03:42 PM

Les contraintes d'intégrité des bases de données Oracle peuvent garantir la précision des données, notamment: Not Null: les valeurs nulles sont interdites; Unique: garantie l'unicité, permettant une seule valeur nulle; Clé primaire: contrainte de clé primaire, renforcer unique et interdire les valeurs nulles; Clé étrangère: maintenir les relations entre les tableaux, les clés étrangères se réfèrent aux clés primaires primaires; Vérifiez: limitez les valeurs de colonne en fonction des conditions.

Explication détaillée des instances de requête imbriquées dans la base de données MySQL

Apr 11, 2025 pm 05:48 PM

Explication détaillée des instances de requête imbriquées dans la base de données MySQL

Apr 11, 2025 pm 05:48 PM

Les requêtes imbriquées sont un moyen d'inclure une autre requête dans une requête. Ils sont principalement utilisés pour récupérer des données qui remplissent des conditions complexes, associer plusieurs tables et calculer des valeurs de résumé ou des informations statistiques. Les exemples incluent la recherche de salaires supérieurs aux employés, la recherche de commandes pour une catégorie spécifique et le calcul du volume des commandes totales pour chaque produit. Lorsque vous écrivez des requêtes imbriquées, vous devez suivre: écrire des sous-requêtes, écrire leurs résultats sur les requêtes extérieures (référencées avec des alias ou en tant que clauses) et optimiser les performances de la requête (en utilisant des index).

Comment configurer le format de journal debian Apache

Apr 12, 2025 pm 11:30 PM

Comment configurer le format de journal debian Apache

Apr 12, 2025 pm 11:30 PM

Cet article décrit comment personnaliser le format de journal d'Apache sur les systèmes Debian. Les étapes suivantes vous guideront à travers le processus de configuration: Étape 1: Accédez au fichier de configuration Apache Le fichier de configuration apache principal du système Debian est généralement situé dans /etc/apache2/apache2.conf ou /etc/apache2/httpd.conf. Ouvrez le fichier de configuration avec les autorisations racinaires à l'aide de la commande suivante: sudonano / etc / apache2 / apache2.conf ou sudonano / etc / apache2 / httpd.conf Étape 2: définir les formats de journal personnalisés à trouver ou

Que fait Oracle

Apr 11, 2025 pm 06:06 PM

Que fait Oracle

Apr 11, 2025 pm 06:06 PM

Oracle est la plus grande société de logiciels de gestion de base de données au monde (SGBD). Ses principaux produits incluent les fonctions suivantes: Outils de développement du système de gestion de la base de données relationnels (Oracle Database) (Oracle Apex, Oracle Visual Builder) Middleware (Oracle Weblogic Server, Oracle Soa Suite) Cloud Service (Oracle Cloud Infrastructure) Analyse et Oracle Blockchain Pla Intelligence (Oracle Analytic