Périphériques technologiques

Périphériques technologiques

IA

IA

Google et le MIT proposent un cadre unifié MAGE : l'apprentissage des représentations dépasse le MAE et la génération d'images non supervisée surpasse la diffusion latente

Google et le MIT proposent un cadre unifié MAGE : l'apprentissage des représentations dépasse le MAE et la génération d'images non supervisée surpasse la diffusion latente

Google et le MIT proposent un cadre unifié MAGE : l'apprentissage des représentations dépasse le MAE et la génération d'images non supervisée surpasse la diffusion latente

La reconnaissance et la génération sont les deux tâches essentielles dans le domaine de l'intelligence artificielle. Si elles peuvent être fusionnées en un système unifié, ces deux tâches devraient être complémentaires. En fait, dans le traitement du langage naturel, des modèles comme BERT [1] sont non seulement capables de générer un texte de haute qualité, mais également d'en extraire des fonctionnalités.

Cependant, dans le domaine de la vision par ordinateur, la plupart des modèles de génération d'images et de reconnaissance actuels sont formés séparément, sans utiliser pleinement la synergie de ces deux tâches. Cela est principalement dû au fait que les modèles de génération d'images et de reconnaissance d'images présentent généralement des différences structurelles essentielles : l'entrée de la génération d'images est constituée de caractéristiques ou de bruit de faible dimension, et la sortie est une image originale de haute dimension, en revanche ; l'entrée de la reconnaissance d'image est une image originale de haute dimension, tandis que la sortie est constituée de caractéristiques de basse dimension.

Récemment, des chercheurs du MIT et de Google Research ont proposé une méthode d'apprentissage des représentations basée sur le masquage sémantique des images, qui a permis pour la première fois de générer des images et d'apprendre des représentations dans un cadre unifié, et a bien fonctionné sur plusieurs ensembles de données. A atteint des performances SOTA. Le document de recherche a été accepté par le CVPR 2023, et le code et le modèle pré-entraînés pertinents sont open source.

- Adresse papier : https://arxiv.org/abs/2211.09117

- Adresse code : https://github.com/LTH14/mage

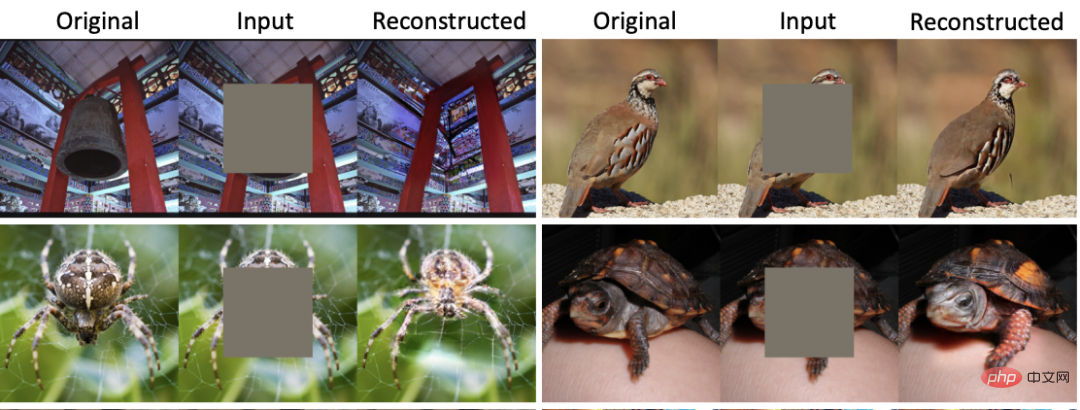

Au CVPR 2022, MAE [2] a proposé une méthode d'apprentissage des représentations basée sur des masques d'image (MIM) et a obtenu de très bons résultats sur plusieurs sous-tâches. Avec un taux de masquage allant jusqu'à 75 %, MAE peut reconstruire une image qui correspond étroitement à la sémantique de l'image originale, permettant ainsi au réseau d'apprendre de manière auto-supervisée les caractéristiques de l'image. Cependant, comme le montre la figure 1, bien que l'image reconstruite par MAE ait des informations sémantiques similaires à celles de l'image originale, de sérieux problèmes de flou et de distorsion surviennent. Des problèmes similaires se posent dans toutes les méthodes d’apprentissage des représentations basées sur MIM. Dans le même temps, les modèles génératifs actuels, qu’il s’agisse de modèles de diffusion ou de GAN, n’ont pas la capacité d’extraire des caractéristiques d’image de haute qualité.

Figure 1 : Comparaison des reconstructions MAE et MAGE

Aperçu des méthodes

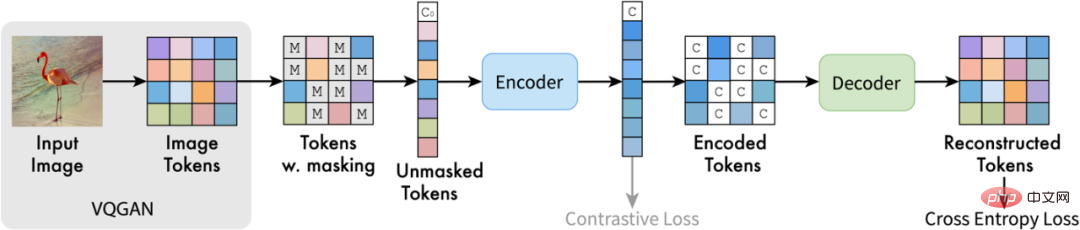

En réponse aux problèmes ci-dessus, l'auteur de cet article a proposé MAGE (Masked Generative Encoder) , qui a permis d'obtenir des modèles unifiés de génération d'images et d'extraction de fonctionnalités. Différent de la méthode de masquage où MIM agit directement sur l'image, MAGE propose une méthode de modélisation de jetons d'image masquée basée sur des symboles sémantiques d'image. Comme le montre la figure, MAGE utilise d'abord l'encodeur VQGAN [3] pour convertir l'image originale en symboles sémantiques discrets. Après cela, MAGE le masque de manière aléatoire et utilise la structure codeur-décodeur basée sur un transformateur pour reconstruire le masque. Les symboles sémantiques reconstruits peuvent être utilisés pour générer l'image originale via le décodeur VQGAN. En utilisant différents taux de masquage lors de la formation, MAGE peut former à la fois des modèles génératifs (taux de masquage de près de 100 %) et l'apprentissage des représentations (taux de masquage de 50 % à 80 %). Comme le montre la figure 1, l'image reconstruite par MAGE possède non seulement des informations sémantiques cohérentes avec l'image originale, mais peut également garantir la diversité et l'authenticité de l'image générée.

Figure 2 : Diagramme de structure MAGE

Résultats expérimentaux

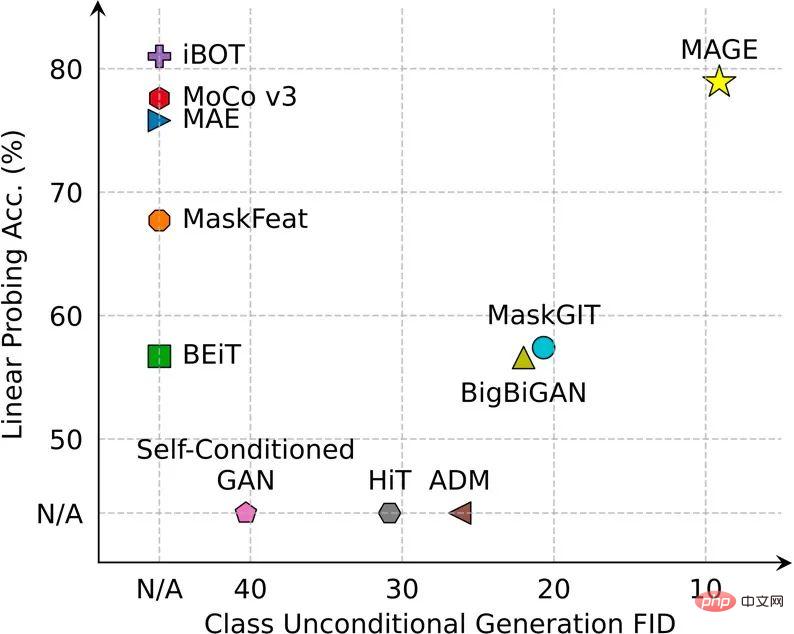

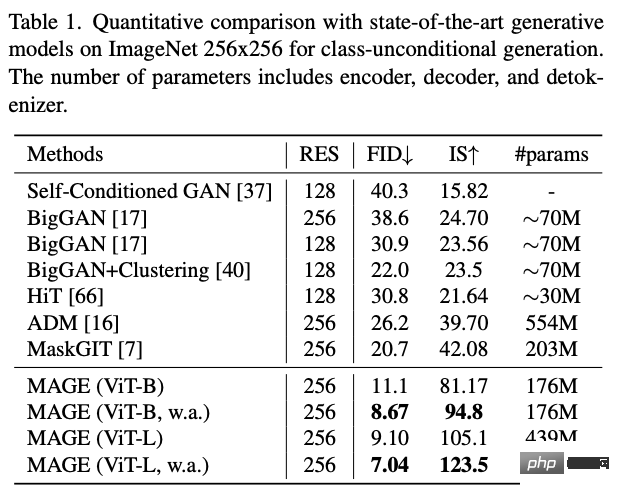

MAGE a atteint ou dépassé SOTA sur plusieurs tâches de génération et de reconnaissance d'images.

Dans la tâche de génération d'images non supervisée d'ImageNet, le FID de MAGE est passé du précédent > 20 à 7,04, atteignant même le niveau de génération d'images supervisée (le FID de diffusion latente supervisée sur ImageNet est de 3,60) :

Figure 3 : Exemple de génération d'images non supervisée MAGE

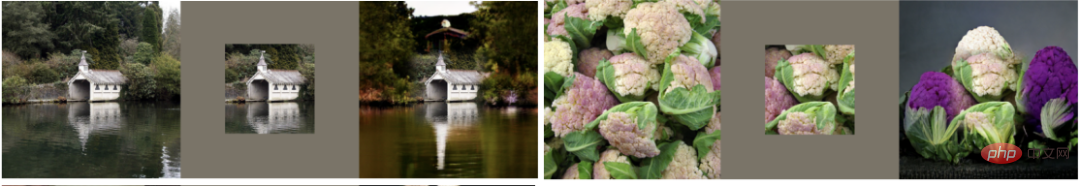

MAGE peut également effectuer diverses tâches d'édition d'images, notamment l'inpainting, l'outpainting et le dérognage :

Figure 4 : Exemple d'édition d'images MAGE

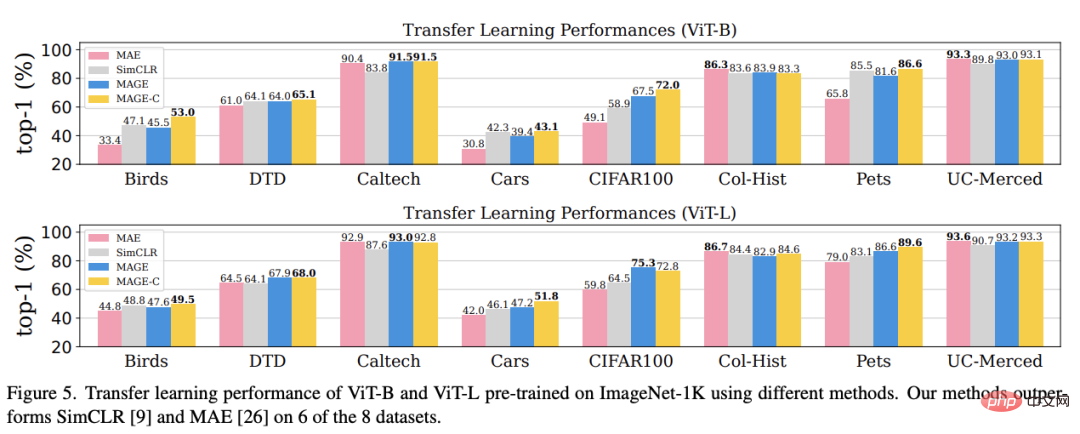

En termes d'apprentissage des représentations, MAGE excelle dans Sondage linéaire ImageNet et tâches In à quelques échantillons Comme l'apprentissage et l'apprentissage par transfert, il a été grandement amélioré par rapport à la méthode MIM actuelle et peut atteindre ou dépasser le niveau de la méthode d'apprentissage auto-supervisée optimale actuelle.

Conclusion

Cet article vise à unifier la génération d'images et l'apprentissage de la représentation. A cette fin, l'auteur de cet article propose MAGE, un cadre d'apprentissage auto-supervisé basé sur le masquage sémantique d'images. Ce cadre est simple et efficace et, pour la première fois, atteint ou dépasse les performances SOTA en matière de génération d'images et d'apprentissage de représentation. Les lecteurs intéressés peuvent consulter le texte original de l’article pour en savoir plus sur la recherche.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Comment commenter Deepseek

Feb 19, 2025 pm 05:42 PM

Comment commenter Deepseek

Feb 19, 2025 pm 05:42 PM

Deepseek est un puissant outil de récupération d'informations. .

Comment rechercher Deepseek

Feb 19, 2025 pm 05:39 PM

Comment rechercher Deepseek

Feb 19, 2025 pm 05:39 PM

Deepseek est un moteur de recherche propriétaire qui ne recherche que dans une base de données ou un système spécifique, plus rapide et plus précis. Lorsque vous l'utilisez, il est conseillé aux utilisateurs de lire le document, d'essayer différentes stratégies de recherche, de demander de l'aide et des commentaires sur l'expérience utilisateur afin de tirer le meilleur parti de leurs avantages.

Sesame Open Door Exchange Page d'enregistrement de page Enregistrement Gate Trading App The Registration Site Web

Feb 28, 2025 am 11:06 AM

Sesame Open Door Exchange Page d'enregistrement de page Enregistrement Gate Trading App The Registration Site Web

Feb 28, 2025 am 11:06 AM

Cet article présente le processus d'enregistrement de la version Web de Sesame Open Exchange (GATE.IO) et l'application Gate Trading en détail. Qu'il s'agisse de l'enregistrement Web ou de l'enregistrement de l'application, vous devez visiter le site Web officiel ou l'App Store pour télécharger l'application authentique, puis remplir le nom d'utilisateur, le mot de passe, l'e-mail, le numéro de téléphone mobile et d'autres informations et terminer la vérification des e-mails ou du téléphone mobile.

Pourquoi le lien d'échange de Bybit ne peut-il pas être téléchargé directement et installé?

Feb 21, 2025 pm 10:57 PM

Pourquoi le lien d'échange de Bybit ne peut-il pas être téléchargé directement et installé?

Feb 21, 2025 pm 10:57 PM

Pourquoi le lien d'échange de Bybit ne peut-il pas être téléchargé directement et installé? Bybit est un échange de crypto-monnaie qui fournit des services de trading aux utilisateurs. Les applications mobiles de l'échange ne peuvent pas être téléchargées directement via AppStore ou GooglePlay pour les raisons suivantes: 1. La politique de l'App Store empêche Apple et Google d'avoir des exigences strictes sur les types d'applications autorisées dans l'App Store. Les demandes d'échange de crypto-monnaie ne répondent souvent pas à ces exigences car elles impliquent des services financiers et nécessitent des réglementations et des normes de sécurité spécifiques. 2. Conformité des lois et réglementations Dans de nombreux pays, les activités liées aux transactions de crypto-monnaie sont réglementées ou restreintes. Pour se conformer à ces réglementations, l'application ByBit ne peut être utilisée que via des sites Web officiels ou d'autres canaux autorisés

Sesame Open Door Trading Platform Download Version mobile Gateio Trading Plateforme de téléchargement Adresse de téléchargement

Feb 28, 2025 am 10:51 AM

Sesame Open Door Trading Platform Download Version mobile Gateio Trading Plateforme de téléchargement Adresse de téléchargement

Feb 28, 2025 am 10:51 AM

Il est crucial de choisir un canal formel pour télécharger l'application et d'assurer la sécurité de votre compte.

portail d'enregistrement officiel de Gate.io Exchange

Feb 20, 2025 pm 04:27 PM

portail d'enregistrement officiel de Gate.io Exchange

Feb 20, 2025 pm 04:27 PM

Gate.io est un échange de crypto-monnaie de premier plan qui offre une large gamme d'actifs cryptographiques et de paires de trading. Enregistrer Gate.io est très simple. Complétez l'inscription. Avec Gate.io, les utilisateurs peuvent profiter d'une expérience de trading de crypto-monnaie sûre et pratique.

Top 10 recommandé pour l'application de trading d'actifs numériques crypto (2025 Global Ranking)

Mar 18, 2025 pm 12:15 PM

Top 10 recommandé pour l'application de trading d'actifs numériques crypto (2025 Global Ranking)

Mar 18, 2025 pm 12:15 PM

Cet article recommande les dix principales plates-formes de trading de crypto-monnaie qui méritent d'être prêtées, notamment Binance, Okx, Gate.io, Bitflyer, Kucoin, Bybit, Coinbase Pro, Kraken, Bydfi et Xbit décentralisées. Ces plateformes ont leurs propres avantages en termes de quantité de devises de transaction, de type de transaction, de sécurité, de conformité et de fonctionnalités spéciales. Le choix d'une plate-forme appropriée nécessite une considération complète en fonction de votre propre expérience de trading, de votre tolérance au risque et de vos préférences d'investissement. J'espère que cet article vous aide à trouver le meilleur costume pour vous-même

Binance Binance Site officiel Dernière version Portail de connexion

Feb 21, 2025 pm 05:42 PM

Binance Binance Site officiel Dernière version Portail de connexion

Feb 21, 2025 pm 05:42 PM

Pour accéder à la dernière version du portail de connexion du site Web de Binance, suivez simplement ces étapes simples. Accédez au site officiel et cliquez sur le bouton "Connectez-vous" dans le coin supérieur droit. Sélectionnez votre méthode de connexion existante. Entrez votre numéro de mobile ou votre mot de passe enregistré et votre mot de passe et complétez l'authentification (telles que le code de vérification mobile ou Google Authenticator). Après une vérification réussie, vous pouvez accéder à la dernière version du portail de connexion du site Web officiel de Binance.