Périphériques technologiques

Périphériques technologiques

IA

IA

Un GPU exécute le modèle de volume ChatGPT et ControlNet est un autre artefact pour le dessin AI.

Un GPU exécute le modèle de volume ChatGPT et ControlNet est un autre artefact pour le dessin AI.

Un GPU exécute le modèle de volume ChatGPT et ControlNet est un autre artefact pour le dessin AI.

Un catalogue

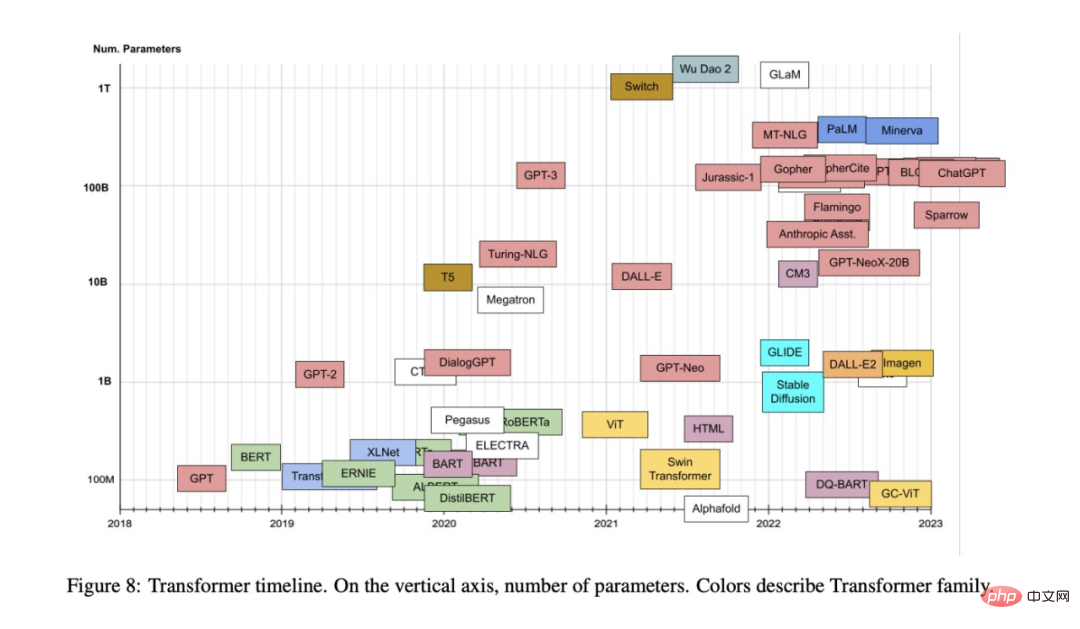

Modèles TransFormer : Une INTRODUACTION et un CATALOGUE

- Génération sophistiquée de grands modèles de langage avec un seul GPUMPORAL DMAIN avec des réseaux de neurones dynamiques sensibles à la dérive

- Modélisation physiquement précise à grande échelle de véritable pile à combustible à membrane échangeuse de protons avec apprentissage profond

- Une enquête complète sur les modèles de base pré-entraînés : une histoire de BERT à ChatGPT

- Ajout d'un contrôle conditionnel aux modèles de diffusion texte-image

- EVA3D : 3D compositionnelle Génération humaine à partir de collections d'images 2D

- Radiostation hebdomadaire ArXiv : PNL, CV, ML Plus d'articles sélectionnés (avec audio)

- Article 1 : Modèles de transformateur : une introduction et un catalogue

Author: Xavier Amatriin

- Paper Adresse: https://arxiv.org/pdf/2302.07730.pdf

- abstract: Since 2017 Depuis son introduction en 2016, le modèle de transformateur a démontré une force sans précédent dans d'autres domaines tels que le traitement du langage naturel et la vision par ordinateur, et a déclenché des percées technologiques telles que ChatGPT. Les gens ont également proposé diverses variantes basées sur le modèle original.

Alors que le monde universitaire et l'industrie continuent de proposer de nouveaux modèles basés sur le mécanisme d'attention Transformer, il nous est parfois difficile de résumer cette direction. Récemment, un article de synthèse de Xavier Amatriain, responsable de la stratégie produit IA chez LinkedIn, pourrait nous aider à résoudre ce problème.

Recommandation :

L'objectif de cet article est de fournir un catalogue et une classification relativement complets mais simples des modèles Transformer les plus populaires. Il présente également les aspects et innovations les plus importants des modèles Transformer.

Article 2 : Inférence générative à haut niveau de modèles de langage volumineux avec un seul GPU

Auteur : Ying Sheng et al

- Adresse de l'article : https://github.com / FMInference/FlexGen/blob/main/docs/paper.pdf

- Résumé : Traditionnellement, les exigences élevées en matière de calcul et de mémoire de l'inférence de grands modèles de langage (LLM) ont nécessité l'utilisation de plusieurs IA haut de gamme. accélérateurs pour la formation . Cette étude explore comment réduire les exigences de l'inférence LLM à un GPU grand public et obtenir des performances pratiques. ,

Récemment, de nouvelles recherches de l'Université de Stanford, de l'UC Berkeley, de l'ETH Zurich, de Yandex, de l'École supérieure d'économie de Moscou, de Meta, de l'Université Carnegie Mellon et d'autres institutions ont proposé FlexGen, une méthode pour exécuter une génération limitée à haut débit. moteur pour LLM sur la mémoire GPU. La figure ci-dessous montre l'idée de conception de FlexGen, qui utilise la planification par blocs pour réutiliser les poids et chevaucher les E/S avec les calculs, comme le montre la figure (b) ci-dessous, tandis que d'autres systèmes de base utilisent une planification ligne par ligne inefficace, comme illustré dans la figure (a) ci-dessous.

Recommandation :Exécutez le modèle de volume ChatGPT, et n'avez désormais besoin que d'un seul GPU : voici la méthode pour accélérer cent fois.

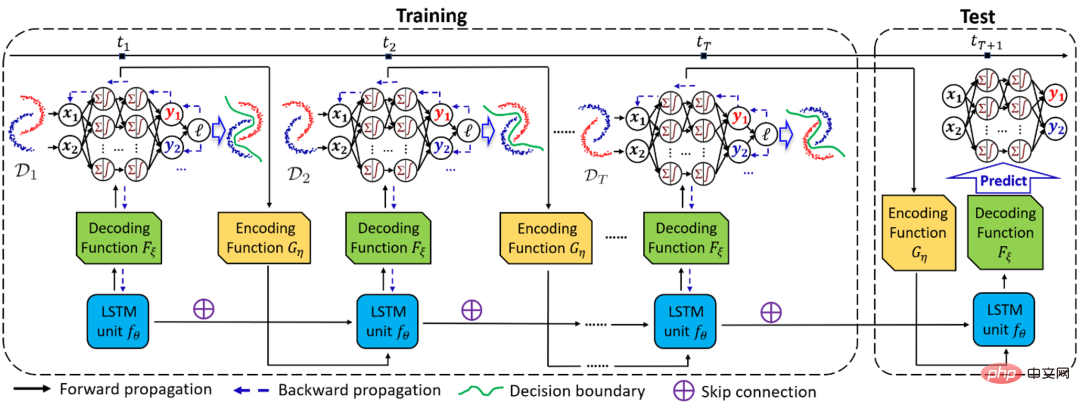

Article 3 : Généralisation du domaine temporel avec des réseaux de neurones dynamiques sensibles à la dérive

Auteur : Guangji Bai et al

- Adresse de l'article : https://arxiv.org/pdf/ 2205.106 64 .pdf

- Résumé : Dans la tâche de généralisation de domaine (DG), lorsque la distribution du domaine change continuellement avec l'environnement, il est très important de capturer avec précision le changement et son impact sur le modèle . Mais c’est aussi un problème très difficile.

- Auteur : Ying Da Wang et al

- Adresse de l'article : https:/ / www.nature.com/articles/s41467-023-35973-8

- Auteur : Ce Zhou et al

- Adresse du papier : https://arxiv. org /pdf/2302.09419.pdf

- Auteur : Lvmin Zhang et al

- Adresse de l'article : https://arxiv.org/pdf / 2302.05543.pdf

- Auteur : Fangzhou Hong et al

- Adresse de l'article : https://arxiv.org/abs/ 2210.0 4888

À cette fin, l'équipe du professeur Zhao Liang de l'Université Emory a proposé un cadre de généralisation du domaine temporel DRAIN basé sur la théorie bayésienne, qui utilise des réseaux récursifs pour apprendre la dérive de la distribution du domaine dimensionnel temporel, et utilise des réseaux neuronaux dynamiques et une technologie de génération de graphes. La combinaison maximise la capacité d'expression du modèle et permet la généralisation et la prédiction du modèle dans des domaines inconnus à l'avenir.

Ce travail a été sélectionné dans l'ICLR 2023 Oral (Top 5% parmi les articles acceptés). Ce qui suit est un diagramme schématique du cadre global de DRAIN.

Recommandé : Bénédiction du réseau neuronal dynamique sensible à la dérive, le nouveau cadre de généralisation du domaine temporel dépasse de loin les méthodes de généralisation et d'adaptation du domaine.

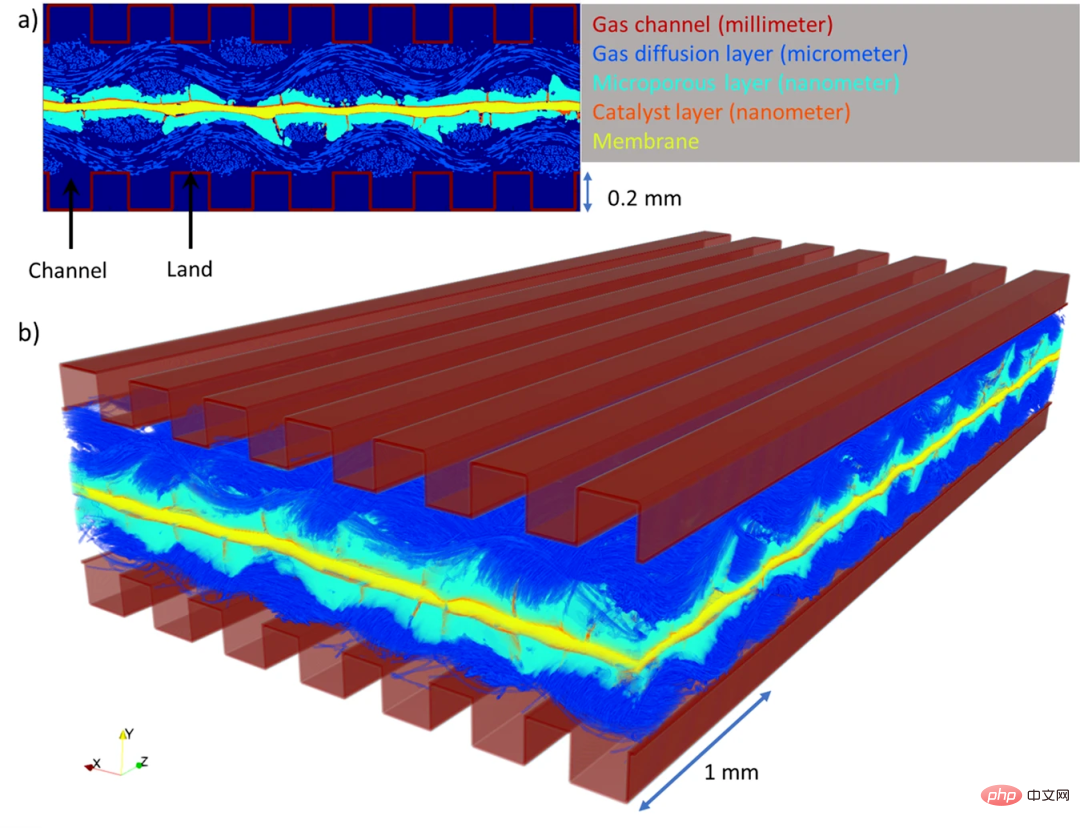

Article 4 : Modélisation physiquement précise à grande échelle d'une véritable pile à combustible à membrane échangeuse de protons avec apprentissage en profondeur

Résumé : Afin de garantir l'approvisionnement en énergie et de lutter contre le changement climatique, l'attention des gens s'est déplacée des combustibles fossiles vers les énergies propres et renouvelables, et l'hydrogène a une densité énergétique élevée et des attributs énergétiques propres et à faibles émissions de carbone qui peuvent jouer un rôle important dans la transition énergétique. Les piles à combustible à hydrogène, en particulier les piles à combustible à membrane échangeuse de protons (PEMFC), sont la clé de cette révolution verte en raison de leur rendement de conversion énergétique élevé et de leur fonctionnement sans émission.

PEMFC convertit l'hydrogène en électricité par un processus électrochimique, et le seul sous-produit de la réaction est l'eau pure. Cependant, les PEMFC peuvent devenir inefficaces si l’eau ne peut pas s’écouler correctement de la cellule et « inonde » ensuite le système. Jusqu’à présent, il était difficile pour les ingénieurs de comprendre la manière précise dont l’eau s’écoule ou s’accumule à l’intérieur des piles à combustible en raison de leur petite taille et de leur complexité.

Récemment, une équipe de recherche de l'Université de Nouvelle-Galles du Sud à Sydney a développé un algorithme d'apprentissage profond (DualEDSR) pour améliorer la compréhension des conditions internes du PEMFC et peut générer des images haute résolution à partir de rayons X de basse résolution. Numérisations de tomodensitométrie. Images de modélisation de résolution. Le processus a été testé sur une seule pile à combustible à hydrogène, permettant de modéliser avec précision son intérieur et d’améliorer potentiellement son efficacité. La figure ci-dessous montre les domaines PEMFC générés dans cette étude.

Recommandation : Le Deep Learning effectue une modélisation physique et précise à grande échelle de l'intérieur des piles à combustible pour aider à améliorer les performances de la batterie.

Papier 5 : Une enquête complète sur les modèles de base pré-entraînés : Une histoire de BERT à ChatGPT

Résumé : Cette revue de près de 100 pages passe en revue l'historique de l'évolution du modèle de base pré-entraîné, nous permettant de voir comment ChatGPT a réussi étape par étape.

Recommandation : De BERT à ChatGPT, une revue d'une centaine de pages passant au peigne fin l'historique de l'évolution des grands modèles pré-entraînés.

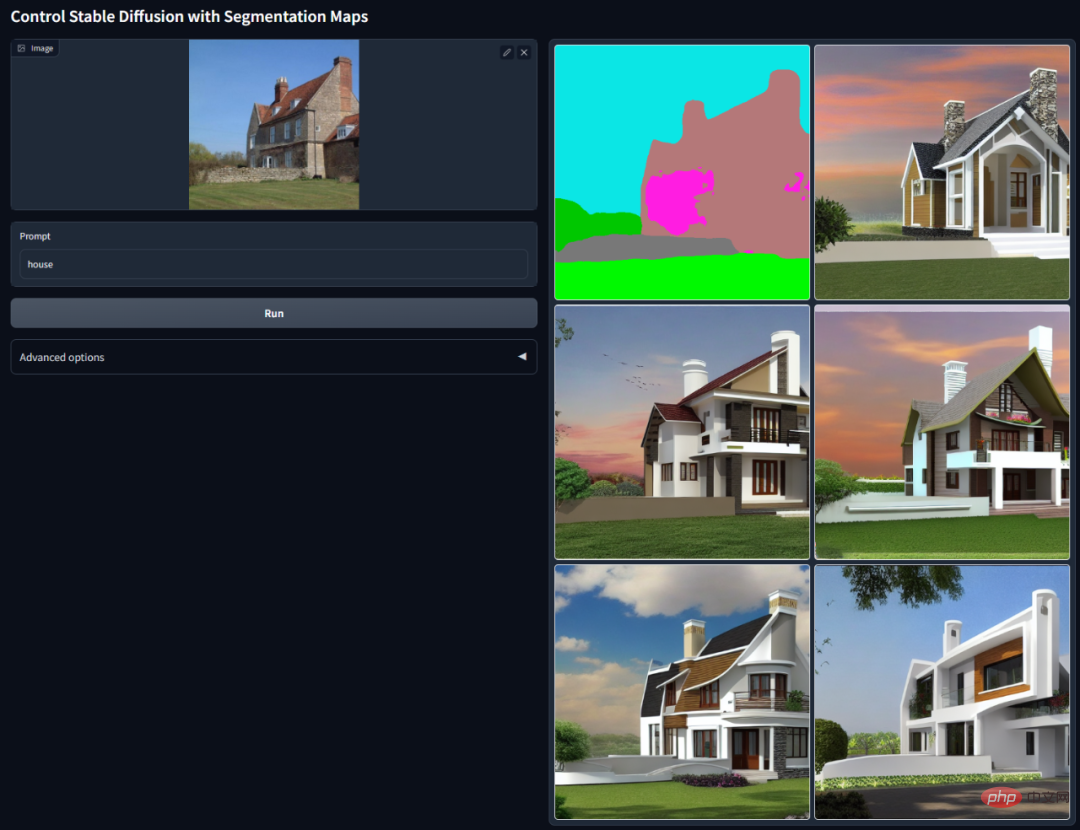

Article 6 : Ajout d'un contrôle conditionnel aux modèles de diffusion texte-image

Résumé : Cet article propose une architecture de réseau neuronal de bout en bout ControlNet, qui peut contrôler le modèle de diffusion (tel que Stable Diffusion) en ajoutant des conditions supplémentaires pour améliorer la génération de graphiques effet. Il peut générer des images en couleur à partir de dessins au trait, générer des images avec la même structure de profondeur et optimiser la génération manuelle à travers les points clés de la main.

Recommandation : L'IA réduit la dimensionnalité pour vaincre les peintres humains, introduit ControlNet dans les graphiques vincentiens et réutilise entièrement les informations de profondeur et de bord.

Article 7 : EVA3D : Génération humaine compositionnelle en 3D à partir de collections d'images 2D

Résumé : Lors de l'ICLR 2023, l'équipe S-Lab du Centre de recherche commun SenseTime de l'Université technologique de Nanyang a proposé EVA3D, la première méthode d'apprentissage de la génération de corps humain tridimensionnel haute résolution à partir d'une collection de images en deux dimensions. Grâce au rendu différenciable fourni par NeRF, les modèles génératifs 3D récents ont obtenu des résultats époustouflants sur des objets stationnaires. Cependant, dans une catégorie plus complexe et déformable comme le corps humain, la génération 3D pose encore de grands défis.

Cet article propose une représentation NeRF combinée efficace du corps humain, permettant d'obtenir une génération de corps humain 3D haute résolution (512x256) sans utiliser de modèle de super-résolution. EVA3D a largement surpassé les solutions existantes sur quatre ensembles de données du corps humain à grande échelle, et le code est open source.

Recommandé : ICLR 2023 Spotlight | Image 2D brainstorming du corps humain 3D, vous pouvez mettre les vêtements avec désinvolture et vous pouvez également modifier les mouvements.

ArXiv Weekly Radiostation

Heart of Machine coopère avec ArXiv Weekly Radiostation initiée par Chu Hang, Luo Ruotian et Mei Hongyuan, et sélectionne des articles plus importants cette semaine sur la base de 7 articles, dont NLP, CV, ML 10 articles sélectionnés dans chaque domaine, et des introductions abstraites des articles sous forme audio sont fournies. Les détails sont les suivants :

7 Articles PNL

Les 10 articles PNL sélectionnés cette semaine sont :

1 . Invite active avec chaîne de pensée pour les grands modèles linguistiques (de Tong Zhang)

2. Les fonctionnalités prosodiques améliorent la segmentation et l'analyse des phrases auto-supervisées (d'Emmanuel Dupoux)

4. Exploration des médias sociaux pour la détection précoce de la dépression chez les patients COVID-19 (de Jie Yang)

5. Traduction automatique du voisin le plus proche fédéré (d'Enhong Chen)

6. Termes avec attention graphique. (de Michael Moortgat)

7. Un modèle de reconnaissance d'entités nommées continue basé sur l'étendue neuronale (de Qingcai Chen)

10 articles de CV

Cette semaine. Les 10 articles sélectionnés par CV sont :

1. MERF : Memory-Efficient Radiance Fields for Real-time View Synthesis in Unbounded Scenes (de Richard Szeliski, Andreas Geiger)

2. Modèles texte-image. (de Daniel Cohen-Or)

3. Enseigner CLIP à compter jusqu'à dix (de Michal Irani)

4. Simulation des pores du visage. (de Weisi Lin)

5. Détection des dommages en temps réel dans les cordes de levage de fibres à l'aide de réseaux neuronaux convolutifs (de Moncef Gabbouj)

6. Amélioration de l'image lumineuse (de Chen Change Loy)

7. Diffusion adaptée à la région pour une édition d'images basée sur le texte sans prise de vue. (de Changsheng Xu)

8. Réseau d'adaptateurs latéraux pour la segmentation sémantique à vocabulaire ouvert. (de Xiang Bai)

9. VoxFormer : transformateur de voxel clairsemé pour la réalisation de scènes sémantiques 3D basées sur une caméra. (de Sanja Fidler)

10. Prédiction vidéo centrée sur les objets via le découplage de la dynamique et des interactions des objets. (de Sven Behnke)

10 ML Papers

本周 10 篇 ML 精选论文是:

1. normflows : un package PyTorch pour normaliser les flux. (de Bernhard Schölkopf)

2. Apprentissage conceptuel pour un apprentissage par renforcement multi-agent interprétable. (de Katia Sycara)

3. Les enseignants aléatoires sont de bons enseignants. (de Thomas Hofmann)

4. Alignement des modèles texte-image à l'aide de la rétroaction humaine. (de Craig Boutilier, Pieter Abbeel)

5. Le changement est difficile : un examen plus approfondi du changement de sous-population. (de Dina Katabi)

6. AlpaServe : multiplexage statistique avec parallélisme de modèles pour le service d'apprentissage profond. (de Zhifeng Chen)

7. Optimisation de politiques diverses pour un espace d'action structuré. (de Hongyuan Zha)

8. La géométrie de la mixabilité. (de Robert C. Williamson)

9. Le Deep Learning apprend-il à faire abstraction ? Un cadre de sondage systématique. (de Nanning Zheng)

10. Minimisation séquentielle des risques contrefactuels. (de Julien Mairal)

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Quelle méthode est utilisée pour convertir les chaînes en objets dans vue.js?

Apr 07, 2025 pm 09:39 PM

Quelle méthode est utilisée pour convertir les chaînes en objets dans vue.js?

Apr 07, 2025 pm 09:39 PM

Lors de la conversion des chaînes en objets dans vue.js, JSON.Parse () est préféré pour les chaînes JSON standard. Pour les chaînes JSON non standard, la chaîne peut être traitée en utilisant des expressions régulières et réduisez les méthodes en fonction du format ou du codé décodé par URL. Sélectionnez la méthode appropriée en fonction du format de chaîne et faites attention aux problèmes de sécurité et d'encodage pour éviter les bogues.

Comment utiliser MySQL après l'installation

Apr 08, 2025 am 11:48 AM

Comment utiliser MySQL après l'installation

Apr 08, 2025 am 11:48 AM

L'article présente le fonctionnement de la base de données MySQL. Tout d'abord, vous devez installer un client MySQL, tel que MySQLWorkBench ou le client de ligne de commande. 1. Utilisez la commande MySQL-UROot-P pour vous connecter au serveur et connecter avec le mot de passe du compte racine; 2. Utilisez Createdatabase pour créer une base de données et utilisez Sélectionner une base de données; 3. Utilisez CreateTable pour créer une table, définissez des champs et des types de données; 4. Utilisez InsertInto pour insérer des données, remettre en question les données, mettre à jour les données par mise à jour et supprimer les données par Supprimer. Ce n'est qu'en maîtrisant ces étapes, en apprenant à faire face à des problèmes courants et à l'optimisation des performances de la base de données que vous pouvez utiliser efficacement MySQL.

Géospatial de Laravel: optimisation des cartes interactives et de grandes quantités de données

Apr 08, 2025 pm 12:24 PM

Géospatial de Laravel: optimisation des cartes interactives et de grandes quantités de données

Apr 08, 2025 pm 12:24 PM

Traiter efficacement 7 millions d'enregistrements et créer des cartes interactives avec la technologie géospatiale. Cet article explore comment traiter efficacement plus de 7 millions d'enregistrements en utilisant Laravel et MySQL et les convertir en visualisations de cartes interactives. Exigences initiales du projet de défi: extraire des informations précieuses en utilisant 7 millions d'enregistrements dans la base de données MySQL. Beaucoup de gens considèrent d'abord les langages de programmation, mais ignorent la base de données elle-même: peut-il répondre aux besoins? La migration des données ou l'ajustement structurel est-il requis? MySQL peut-il résister à une charge de données aussi importante? Analyse préliminaire: les filtres et les propriétés clés doivent être identifiés. Après analyse, il a été constaté que seuls quelques attributs étaient liés à la solution. Nous avons vérifié la faisabilité du filtre et établi certaines restrictions pour optimiser la recherche. Recherche de cartes basée sur la ville

Comment résoudre MySQL ne peut pas être démarré

Apr 08, 2025 pm 02:21 PM

Comment résoudre MySQL ne peut pas être démarré

Apr 08, 2025 pm 02:21 PM

Il existe de nombreuses raisons pour lesquelles la startup MySQL échoue, et elle peut être diagnostiquée en vérifiant le journal des erreurs. Les causes courantes incluent les conflits de port (vérifier l'occupation du port et la configuration de modification), les problèmes d'autorisation (vérifier le service exécutant les autorisations des utilisateurs), les erreurs de fichier de configuration (vérifier les paramètres des paramètres), la corruption du répertoire de données (restaurer les données ou reconstruire l'espace de la table), les problèmes d'espace de la table InNODB (vérifier les fichiers IBDATA1), la défaillance du chargement du plug-in (vérification du journal des erreurs). Lors de la résolution de problèmes, vous devez les analyser en fonction du journal d'erreur, trouver la cause profonde du problème et développer l'habitude de sauvegarder régulièrement les données pour prévenir et résoudre des problèmes.

Vue.js Comment convertir un tableau de type de chaîne en un tableau d'objets?

Apr 07, 2025 pm 09:36 PM

Vue.js Comment convertir un tableau de type de chaîne en un tableau d'objets?

Apr 07, 2025 pm 09:36 PM

Résumé: Il existe les méthodes suivantes pour convertir les tableaux de chaîne Vue.js en tableaux d'objets: Méthode de base: utilisez la fonction de carte pour convenir à des données formatées régulières. Gameplay avancé: l'utilisation d'expressions régulières peut gérer des formats complexes, mais ils doivent être soigneusement écrits et considérés. Optimisation des performances: Considérant la grande quantité de données, des opérations asynchrones ou des bibliothèques efficaces de traitement des données peuvent être utilisées. MEILLEUR PRATIQUE: Effacer le style de code, utilisez des noms de variables significatifs et des commentaires pour garder le code concis.

Comment définir le délai de Vue Axios

Apr 07, 2025 pm 10:03 PM

Comment définir le délai de Vue Axios

Apr 07, 2025 pm 10:03 PM

Afin de définir le délai d'expiration de Vue Axios, nous pouvons créer une instance AxiOS et spécifier l'option Timeout: dans les paramètres globaux: vue.prototype. $ Axios = axios.create ({timeout: 5000}); Dans une seule demande: ce. $ axios.get ('/ api / utilisateurs', {timeout: 10000}).

Comment optimiser les performances de la base de données après l'installation de MySQL

Apr 08, 2025 am 11:36 AM

Comment optimiser les performances de la base de données après l'installation de MySQL

Apr 08, 2025 am 11:36 AM

L'optimisation des performances MySQL doit commencer à partir de trois aspects: configuration d'installation, indexation et optimisation des requêtes, surveillance et réglage. 1. Après l'installation, vous devez ajuster le fichier my.cnf en fonction de la configuration du serveur, tel que le paramètre innodb_buffer_pool_size, et fermer query_cache_size; 2. Créez un index approprié pour éviter les index excessifs et optimiser les instructions de requête, telles que l'utilisation de la commande Explication pour analyser le plan d'exécution; 3. Utilisez le propre outil de surveillance de MySQL (ShowProcessList, Showstatus) pour surveiller la santé de la base de données, et sauvegarde régulièrement et organisez la base de données. Ce n'est qu'en optimisant en continu ces étapes que les performances de la base de données MySQL peuvent être améliorées.

Les ingénieurs de backend senior à distance (plates-formes) ont besoin de cercles

Apr 08, 2025 pm 12:27 PM

Les ingénieurs de backend senior à distance (plates-formes) ont besoin de cercles

Apr 08, 2025 pm 12:27 PM

Ingénieur backend à distance Emploi Vacant Société: Emplacement du cercle: Bureau à distance Type d'emploi: Salaire à temps plein: 130 000 $ - 140 000 $ Description du poste Participez à la recherche et au développement des applications mobiles Circle et des fonctionnalités publiques liées à l'API couvrant l'intégralité du cycle de vie de développement logiciel. Les principales responsabilités complètent indépendamment les travaux de développement basés sur RubyOnRails et collaborent avec l'équipe frontale React / Redux / Relay. Créez les fonctionnalités de base et les améliorations des applications Web et travaillez en étroite collaboration avec les concepteurs et le leadership tout au long du processus de conception fonctionnelle. Promouvoir les processus de développement positifs et hiérarchiser la vitesse d'itération. Nécessite plus de 6 ans de backend d'applications Web complexe