Périphériques technologiques

Périphériques technologiques

IA

IA

Amazon entre dans la guerre ChatGPT avec une grande visibilité et publie gratuitement le grand modèle Titan et l'assistant de programmation IA : Changez toutes les expériences.

Amazon entre dans la guerre ChatGPT avec une grande visibilité et publie gratuitement le grand modèle Titan et l'assistant de programmation IA : Changez toutes les expériences.

Amazon entre dans la guerre ChatGPT avec une grande visibilité et publie gratuitement le grand modèle Titan et l'assistant de programmation IA : Changez toutes les expériences.

Du jour au lendemain, Amazon est venu "dépasser dans un virage".

Alors que les principaux géants mondiaux de la technologie adoptent le grand modèle le plus populaire d’aujourd’hui, l’AIGC, Amazon ne donne aux gens qu’une seule impression : la furtivité.

Bien qu'AWS ait fourni une puissance de calcul d'apprentissage automatique à de grandes entreprises vedettes telles que Hugging Face et Stability AI, Amazon divulgue rarement les détails de la coopération. Certains internautes ont estimé qu'au cours des dernières réunions de reporting financier, Amazon n'avait mentionné l'IA presque aucune fois.

Mais maintenant, l’attitude d’Amazon a radicalement changé.

Le 13 avril, le PDG d'Amazon, Andy Jassy, a publié la lettre annuelle aux actionnaires de 2022, déclarant qu'il est convaincu qu'Amazon peut contrôler les coûts et continuer à investir dans de nouveaux domaines de croissance. Dans sa lettre, il a déclaré qu'Amazon investirait massivement à l'avenir dans les domaines actuellement populaires des modèles linguistiques à grande échelle (LLM) et de l'intelligence artificielle générative (IA).

Jassy a déclaré qu'au cours des dernières décennies, Amazon a utilisé l'apprentissage automatique dans diverses applications. L'entreprise développe actuellement son propre modèle linguistique à grande échelle, qui a le potentiel d'améliorer « presque toutes les expériences client ».

Avant qu’il ait fini de parler, le grand modèle et les services d’Amazon ont été dévoilés.

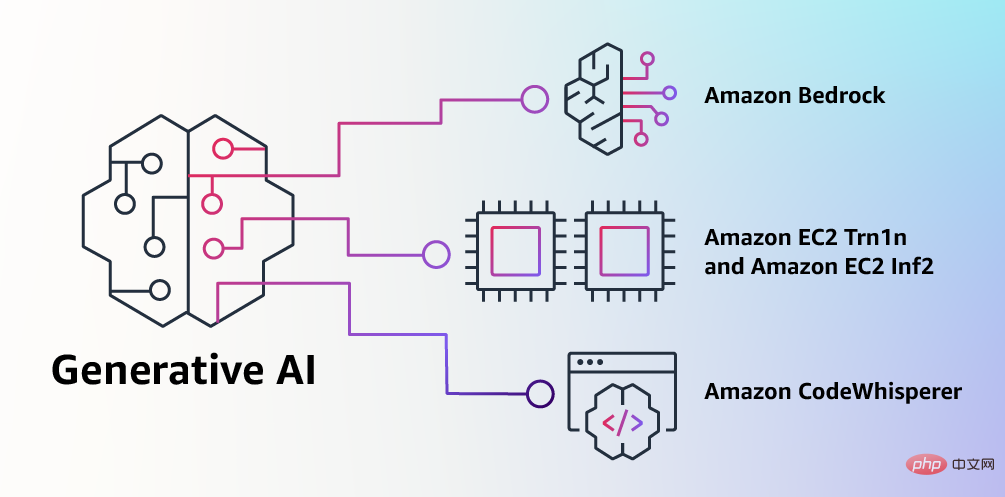

"La plupart des entreprises souhaitent utiliser de grands modèles de langage, mais les modèles de langage vraiment utiles nécessitent des milliards de dollars et des années pour se former, et les gens ne veulent pas passer par là", a déclaré Andy Jassy. "Ils cherchent donc à améliorer un modèle de base déjà énorme, puis à pouvoir le personnaliser à leurs propres fins. C'est Bedrock."

Version Amazon de ChatGPT : une partie de son service cloud.

Grands modèles

Dans sa dernière annonce, AWS a présenté un nouvel ensemble de modèles – collectivement appelés « Amazon Titan ».

Les modèles de la série Titan sont divisés en deux types, l'un est un modèle de texte pour la génération de contenu et l'autre est un modèle d'intégration qui peut créer des intégrations vectorielles pour créer des fonctions de recherche efficaces, etc.

Le modèle de génération de texte est similaire au GPT-4 d'OpenAI (mais pas nécessairement identique en termes de performances) et peut effectuer des tâches telles que la rédaction d'articles de blog et d'e-mails, la synthèse de documents et l'extraction d'informations à partir de bases de données. Les modèles d'intégration traduisent les entrées textuelles (telles que des mots et des phrases) en représentations numériques, appelées intégrations, qui contiennent la sémantique du texte.

Les chatbots ChatGPT et Microsoft Bing basés sur le modèle de langage OpenAI produisent parfois des informations inexactes. Cela est dû à un comportement appelé "hallucination", où le résultat semble convaincant, mais en fait cela n'a rien à voir avec les données d'entraînement.

Le vice-président d'AWS, Bratin Saha, a déclaré à CNBC qu'Amazon « se soucie beaucoup » de l'exactitude et veille à ce que son modèle Titan produise des réponses de haute qualité.

Les clients pourront personnaliser les modèles Titan avec leurs propres données. Mais un autre vice-président a déclaré que les données ne seraient jamais utilisées pour entraîner les modèles Titan afin de garantir que d'autres clients, y compris des concurrents, ne bénéficieraient pas de ces données.

Sivasubramanian et Saha ont refusé de parler de la taille des modèles Titan ou d'identifier les données utilisées par Amazon pour les former, et Saha n'a pas décrit le processus suivi par Amazon pour supprimer les parties problématiques des données de formation du modèle.

Service Cloud

La sortie du modèle Titan fait en fait partie du plan « Bedrock » d'Amazon. Amazon, le plus grand fournisseur d'infrastructures cloud au monde, ne laissera évidemment pas un domaine en croissance aussi rapide à des concurrents tels que Google et Microsoft.

Le projet Bedrock a été lancé un mois après la sortie de GPT-4 par OpenAI. À cette époque, Microsoft avait investi des milliards de dollars dans OpenAI et fournissait de la puissance de calcul à OpenAI via son service cloud Azure. Il s'agit de la concurrence la plus forte à laquelle l'activité AWS d'Amazon ait jamais été confrontée.

Le service cloud Bedrock est similaire au moteur derrière le chatbot ChatGPT alimenté par la startup OpenAI soutenue par Microsoft. Amazon Web Services donnera accès à des modèles comme Titan via son service d'IA générative Bedrock.

L'ensemble de modèles de base initial pris en charge par ce service comprend également des modèles d'AI21, Anthropic et Stability AI, ainsi que les nouveaux modèles de la série Titan développés par Amazon. Les débuts de Bedrock sont un précurseur des partenariats qu’AWS a noués avec des startups d’IA générative au cours des derniers mois.

Le principal avantage de Bedrock est que les utilisateurs peuvent l'intégrer au reste de la plateforme cloud AWS. Cela signifie que les organisations pourront accéder plus facilement aux données stockées dans le service de stockage d'objets Amazon S3 et bénéficier des politiques de contrôle d'accès et de gouvernance d'AWS.

Amazon ne révèle pas actuellement combien coûtera le service Bedrock car il est encore en avant-première limitée. Un porte-parole a déclaré que les clients peuvent s'inscrire sur une liste d'attente. Auparavant, Microsoft et OpenAI avaient annoncé les prix d'utilisation de GPT-4, à partir de quelques centimes pour 1 000 jetons, avec un jeton équivalent à environ quatre caractères anglais, tandis que Google n'a pas encore annoncé les prix de son modèle de langage PaLM.

Assistant de programmation IA, gratuit et ouvert aux particuliers

Nous savons que la programmation sera l'un des domaines où la technologie de l'IA générative sera rapidement appliquée. Aujourd’hui, les développeurs de logiciels passent beaucoup de temps à écrire du code assez simple et indifférencié, et beaucoup de temps à apprendre de nouveaux outils et techniques complexes en constante évolution. En conséquence, les développeurs disposent de très peu de temps pour développer des fonctionnalités et des services innovants.

Pour résoudre ce problème, les développeurs tenteront de copier des extraits de code depuis Internet, puis de les modifier, mais ils risquent de copier par inadvertance du code invalide et du code présentant des risques de sécurité. Cette méthode de recherche et de copie fait également perdre du temps aux développeurs dans la construction d’une entreprise.

L'IA générative peut réduire considérablement ce travail ardu en « écrivant » du code principalement indifférencié, permettant aux développeurs d'écrire du code plus rapidement et d'avoir plus de temps pour se concentrer sur un travail de programmation plus créatif.

En 2022, Amazon a annoncé le lancement de l'aperçu Amazon CodeWhisperer . Cet assistant de programmation IA utilise un modèle de base intégré pour générer des suggestions de code en temps réel sur la base des commentaires des développeurs décrits en langage naturel et du code existant dans l'EDI, améliorant ainsi l'efficacité du travail. La version préliminaire a reçu une réponse enthousiaste de la part des développeurs, les utilisateurs accomplissant les tâches en moyenne 57 % plus rapidement et avec un taux de réussite 27 % plus élevé que ceux qui n'ont pas utilisé l'assistant de programmation.

Maintenant, Amazon annonce que CodeWhisperer est officiellement disponible, gratuit et ouvert à tous les utilisateurs individuels sans aucune qualification ni limite de durée d'utilisation. Comprend également le suivi des citations et 50 analyses de sécurité par mois. Les utilisateurs doivent uniquement s'inscrire par e-mail et n'ont pas besoin d'un compte de service cloud Amazon. Les clients Entreprise peuvent choisir la version Professionnelle qui inclut des fonctionnalités de gestion plus avancées.

En plus de Python, Java, JavaScript, TypeScript et C#, CodeWhisperer a ajouté la prise en charge de 10 nouveaux langages de développement tels que Go, Kotlin, Rust, PHP et SQL. Les développeurs peuvent accéder à CodeWhisperer via le plug-in Amazon Toolkit dans des environnements de développement intégrés tels que VS Code, IntelliJ IDEA, Amazon Cloud9, et peuvent également être utilisés dans la console Amazon Lambda.

Amazon affirme qu'en plus d'apprendre à partir de milliards de lignes de code public, CodeWhisperer est également formé sur le code d'Amazon. Il s'agit donc actuellement du moyen le plus précis, le plus rapide et le plus sécurisé de générer du code pour les services cloud Amazon, notamment Amazon EC2 et plus encore.

Le code généré par les assistants de programmation IA peut contenir des vulnérabilités de sécurité cachées, c'est pourquoi CodeWhisperer fournit des capacités d'analyse de sécurité intégrées (activées par inférence automatisée), le seul à le faire. Cette fonctionnalité détecte les vulnérabilités difficiles à détecter et formule des recommandations de correction, telles que celles du Top 10 Open Web Application Security Project (OWASP) et celles qui ne sont pas conformes aux meilleures pratiques des bibliothèques cryptographiques.

De plus, pour aider les développeurs à développer du code de manière responsable, CodeWhisperer filtre les suggestions de code qui peuvent être considérées comme biaisées ou injustes. Dans le même temps, étant donné que les clients peuvent avoir besoin de se référer à des sources de code open source ou d'obtenir l'autorisation de les utiliser, CodeWhisperer est également le seul assistant de programmation capable de filtrer et de marquer les suggestions de code open source suspectées.

Résumé

Amazon est dans le domaine de l'IA depuis plus de 20 ans et AWS compte déjà plus de 100 000 clients IA. Amazon utilise une version modifiée de Titan pour diffuser les résultats de recherche via sa page d'accueil, a déclaré Sivasubramanian.

Cependant, Amazon n'est que l'une des grandes entreprises à lancer des capacités d'IA générative après l'émergence et la popularité de ChatGPT. Expedia, HubSpot, Paylocity et Spotify se sont tous engagés à intégrer la technologie OpenAI, contrairement à Amazon. "Nous agissons toujours lorsque tout est prêt et que toute la technologie est déjà là", a déclaré Sivasubramanian. Amazon veut garantir que Bedrock soit facile à utiliser et rentable grâce à son utilisation d'un processeur d'IA personnalisé.

Actuellement, des entreprises telles que C3.ai, Pegasystems et Salesforce se préparent à introduire Amazon Bedrock.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Comment résoudre la complexité de l'installation de WordPress et de la mise à jour à l'aide du compositeur

Apr 17, 2025 pm 10:54 PM

Comment résoudre la complexité de l'installation de WordPress et de la mise à jour à l'aide du compositeur

Apr 17, 2025 pm 10:54 PM

Lors de la gestion des sites Web WordPress, vous rencontrez souvent des opérations complexes telles que l'installation, la mise à jour et la conversion multi-sites. Ces opérations ne prennent pas seulement du temps, mais aussi sujettes aux erreurs, ce qui a entraîné la paralysée du site Web. La combinaison de la commande WP-CLI Core avec Composer peut simplifier considérablement ces tâches, améliorer l'efficacité et la fiabilité. Cet article présentera comment utiliser le compositeur pour résoudre ces problèmes et améliorer la commodité de la gestion WordPress.

Accélérer l'inspection du code PHP: Expérience et pratique en utilisant une bibliothèque sur-true / phplint

Apr 17, 2025 pm 11:06 PM

Accélérer l'inspection du code PHP: Expérience et pratique en utilisant une bibliothèque sur-true / phplint

Apr 17, 2025 pm 11:06 PM

Au cours du processus de développement, nous devons souvent effectuer des vérifications de syntaxe sur le code PHP pour assurer l'exactitude et la maintenabilité du code. Cependant, lorsque le projet est grand, le processus de vérification de la syntaxe à thread unique peut devenir très lent. Récemment, j'ai rencontré ce problème dans mon projet. Après avoir essayé plusieurs méthodes, j'ai finalement trouvé la bibliothèque Overrue / Phplint, qui améliore considérablement la vitesse de l'inspection du code par le traitement parallèle.

Comment résoudre un problème de relation d'appartenance complexe à Laravel? Utilisez le compositeur!

Apr 17, 2025 pm 09:54 PM

Comment résoudre un problème de relation d'appartenance complexe à Laravel? Utilisez le compositeur!

Apr 17, 2025 pm 09:54 PM

Dans le développement de Laravel, le traitement des relations de modèle complexes a toujours été un défi, en particulier en ce qui concerne les relations d'appartenance à plusieurs niveaux. Récemment, j'ai rencontré ce problème dans un projet traitant d'une relation de modèle à plusieurs niveaux, où les relations traditionnelles ont de la part des relations avec les besoins, ce qui fait que les requêtes de données deviennent complexes et inefficaces. Après une certaine exploration, j'ai trouvé la bibliothèque StaudenMeir / appartient à l'encontre, qui a facilement installé et résolu mes problèmes via le compositeur.

Comment optimiser les performances du site Web: expériences et leçons tirées de l'utilisation de la bibliothèque minifée

Apr 17, 2025 pm 11:18 PM

Comment optimiser les performances du site Web: expériences et leçons tirées de l'utilisation de la bibliothèque minifée

Apr 17, 2025 pm 11:18 PM

En train de développer un site Web, l'amélioration du chargement des pages a toujours été l'une de mes principales priorités. Une fois, j'ai essayé d'utiliser la bibliothèque Miniify pour compresser et fusionner les fichiers CSS et JavaScript afin d'améliorer les performances du site Web. Cependant, j'ai rencontré de nombreux problèmes et défis pendant l'utilisation, ce qui m'a finalement fait réaliser que Miniify pourrait ne plus être le meilleur choix. Ci-dessous, je partagerai mon expérience et comment installer et utiliser MINIFY via Composer.

Résoudre le problème du préfixe CSS à l'aide du compositeur: Pratique de la bibliothèque Padaliyajay / PHP-Autoprefixer

Apr 17, 2025 pm 11:27 PM

Résoudre le problème du préfixe CSS à l'aide du compositeur: Pratique de la bibliothèque Padaliyajay / PHP-Autoprefixer

Apr 17, 2025 pm 11:27 PM

J'ai un problème délicat lors du développement d'un projet frontal: j'ai besoin d'ajouter manuellement un préfixe de navigateur aux propriétés CSS pour assurer la compatibilité. Cela prend non seulement du temps, mais aussi des erreurs. Après une certaine exploration, j'ai découvert la bibliothèque Padaliyajay / Php-Autoprefixer, qui a facilement résolu mes problèmes avec compositeur.

Comment résoudre le problème des colonnes virtuelles dans le modèle Laravel? Utilisez Stancl / VirtualColumn!

Apr 17, 2025 pm 09:48 PM

Comment résoudre le problème des colonnes virtuelles dans le modèle Laravel? Utilisez Stancl / VirtualColumn!

Apr 17, 2025 pm 09:48 PM

Pendant le développement de Laravel, il est souvent nécessaire d'ajouter des colonnes virtuelles au modèle pour gérer la logique des données complexes. Cependant, l'ajout de colonnes virtuelles directement dans le modèle peut conduire à la complexité de la migration et de la maintenance de la base de données. Après avoir rencontré ce problème dans mon projet, j'ai réussi à résoudre ce problème en utilisant la bibliothèque Stancl / VirtualColumn. Cette bibliothèque simplifie non seulement la gestion des colonnes virtuelles, mais améliore également la maintenabilité et l'efficacité du code.

Comment assurer la qualité du code Magento2: Utilisez Magento / Magento-coding-standard

Apr 17, 2025 pm 11:12 PM

Comment assurer la qualité du code Magento2: Utilisez Magento / Magento-coding-standard

Apr 17, 2025 pm 11:12 PM

Lors du développement d'extensions de magento2, j'ai rencontré un problème commun: comment m'assurer que la qualité du code répond aux normes de Magento. Cela affecte non seulement la maintenabilité du code, mais affecte également la stabilité globale et les performances du projet. Après une certaine exploration, j'ai trouvé la bibliothèque standard de codage magento / magento, qui fournit spécifiquement des règles PHPCodesniffer pour les projets Magento2 pour aider les développeurs à vérifier et à optimiser rapidement le code.

Comment résoudre les problèmes d'installation et de configuration des Typo3cms? Cela peut être fait facilement avec le compositeur!

Apr 17, 2025 pm 10:51 PM

Comment résoudre les problèmes d'installation et de configuration des Typo3cms? Cela peut être fait facilement avec le compositeur!

Apr 17, 2025 pm 10:51 PM

Lorsque vous utilisez des typo3cms pour le développement de sites Web, vous rencontrez souvent des problèmes avec les extensions d'installation et de configuration. Surtout pour les débutants, comment installer et configurer correctement Typo3 et ses extensions peuvent être un mal de tête. J'ai eu des difficultés similaires dans mon projet réel et j'ai fini par résoudre ces problèmes en utilisant le compositeur et le typo3cmscomposeRinstallers.