Périphériques technologiques

Périphériques technologiques

IA

IA

Stanford, Meta AI Research : Sur la route de l'AGI, l'élagage des données est plus important que nous le pensons

Stanford, Meta AI Research : Sur la route de l'AGI, l'élagage des données est plus important que nous le pensons

Stanford, Meta AI Research : Sur la route de l'AGI, l'élagage des données est plus important que nous le pensons

Dans de nombreux domaines de l'apprentissage automatique, notamment la vision, le langage et la parole, la loi de mise à l'échelle neuronale stipule que l'erreur de test diminue généralement avec les données d'entraînement, la taille du modèle ou le nombre de calculs. Cette amélioration proportionnelle a permis au deep learning d’obtenir des gains de performances substantiels. Cependant, ces améliorations obtenues grâce à la seule mise à l’échelle ont un coût considérable en termes de calcul et d’énergie.

Cette échelle proportionnelle n’est pas tenable. Par exemple, la quantité de données, de calculs ou d'énergie nécessaire pour réduire l'erreur de 3 % à 2 % augmente de façon exponentielle. Certaines recherches antérieures ont montré que la réduction de la perte d'entropie croisée de 3,4 à 2,8 dans la modélisation du langage avec de grands Transformers nécessite 10 fois plus de données de formation. De plus, pour les grands transformateurs visuels, 2 milliards de points de données pré-entraînés supplémentaires (à partir de 1 milliard) n'ont entraîné qu'un gain de précision de quelques points de pourcentage sur ImageNet.

Tous ces résultats mettent en lumière la nature des données dans le deep learning, tout en montrant que la pratique consistant à collecter d’énormes ensembles de données peut s’avérer inefficace. La discussion ici est de savoir si nous pouvons faire mieux. Par exemple, pouvons-nous parvenir à une mise à l’échelle exponentielle avec une bonne stratégie de sélection des échantillons d’apprentissage ?

Dans un article récent, des chercheurs ont découvert que l'ajout de seulement quelques échantillons d'entraînement soigneusement sélectionnés peut réduire l'erreur de 3 % à 2 % sans avoir à collecter 10 fois plus d'échantillons aléatoires. En bref, « La vente n’est pas tout ce dont vous avez besoin ».

Lien papier : https://arxiv.org/pdf/2206.14486.pdf

En général, les contributions de cette recherche sont :

1 En utilisant la mécanique statistique, une nouvelle méthode d'élagage des données a été développée selon. Selon la théorie de l'analyse de branche, dans l'environnement d'apprentissage du perceptron enseignant-élève, les échantillons sont élagués en fonction de leurs marges d'enseignant, et les grandes (petites) marges correspondent chacune à des échantillons simples (difficiles). La théorie est quantitativement en accord avec les expériences numériques et révèle deux prédictions surprenantes :

a La stratégie d'élagage optimale change avec la quantité de données initiales ; si les données initiales sont abondantes (rares), seules les plus difficiles doivent être retenues (faciles).

b. Si un score d'élagage Pareto-optimal croissant est choisi en fonction de la taille initiale de l'ensemble de données, alors une mise à l'échelle exponentielle est possible pour la taille de l'ensemble de données élagué.

2. La recherche montre que ces deux prédictions se vérifient dans la pratique dans des contextes plus généraux. Ils valident les caractéristiques de mise à l'échelle exponentielle des erreurs par rapport à la taille de l'ensemble de données élagué pour les ResNets formés à partir de zéro sur SVHN, CIFAR-10 et ImageNet, et pour un transformateur visuel affiné sur CIFAR-10.

3. Nous avons mené une étude de référence à grande échelle sur 10 métriques d'élagage de données différentes sur ImageNet et avons constaté que la plupart des métriques fonctionnaient mal, à l'exception des plus gourmandes en calcul.

4. Une nouvelle métrique d'élagage non supervisée à faible coût est développée à l'aide d'un apprentissage auto-supervisé qui, contrairement aux métriques précédentes, ne nécessite pas d'étiquettes. Nous démontrons que cette mesure non supervisée est comparable aux meilleures mesures d’élagage supervisé, qui nécessitent des étiquettes et davantage de calculs. Ce résultat révèle la possibilité d'utiliser un modèle de base pré-entraîné pour élaguer de nouveaux ensembles de données.

Est-ce que l'échelle est tout ce dont vous avez besoin ?

La théorie de l'élagage des données par perceptron du chercheur propose trois prédictions surprenantes, qui peuvent être testées dans un environnement plus général, comme les réseaux de neurones profonds entraînés sur des benchmarks :

(1) Par rapport à l'élagage aléatoire des données, lorsque l'ensemble de données initial est relativement grand, il est avantageux de ne conserver que les échantillons les plus difficiles, mais lorsque l'ensemble de données initial est relativement petit, cela est nuisible

(2) À mesure que la taille de l'ensemble de données initial augmente, en conservant les échantillons les plus difficiles. Élagage des données avec un la fraction fixe f des échantillons devrait produire une mise à l'échelle en loi de puissance avec une exponentielle égale à un élagage aléatoire ;

(3) L'erreur de test optimisée sur la taille de l'ensemble de données initial et la fraction de données conservées peuvent être améliorées en mettant à l'échelle une valeur initiale plus grande. Plus un élagage agressif est effectué sur l'ensemble de données pour suivre une enveloppe inférieure Pareto-optimale, brisant la relation de fonction de mise à l'échelle de la loi de puissance entre l'erreur de test et la taille de l'ensemble de données élagué.

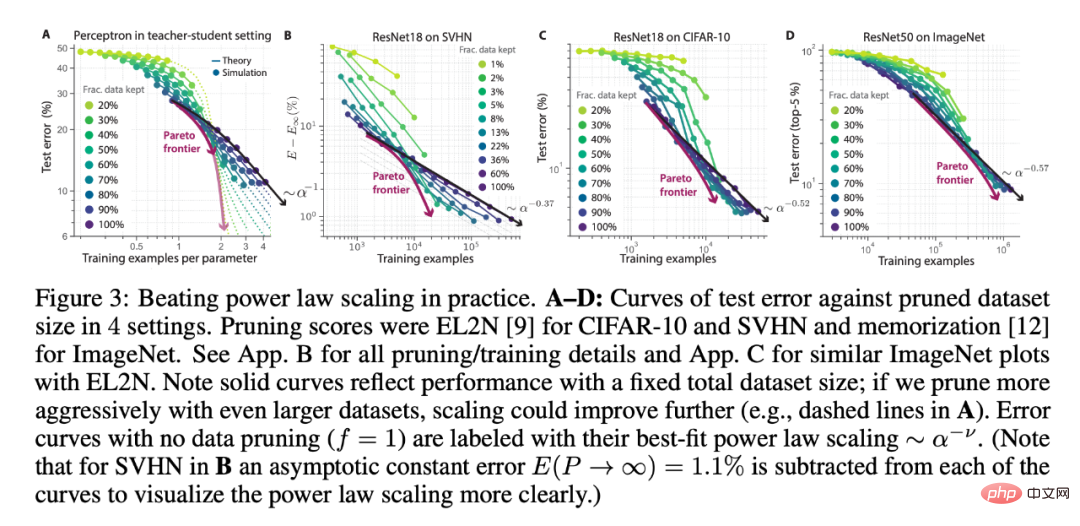

Les chercheurs ont utilisé différents nombres de tailles d'ensembles de données initiales et de fractions de données enregistrées lors de l'élagage des données (théorie de la figure 3A par rapport à l'expérience d'apprentissage en profondeur de la figure 3BCD), la formation sur SVHN, CIFAR-10 et ImageNet ResNets a vérifié la au-dessus de trois prédictions. Dans chaque contexte expérimental, on peut constater qu’un ensemble de données initial plus grand et un élagage plus agressif fonctionnent mieux que la mise à l’échelle de la loi de puissance. De plus, un ensemble de données initial plus important peut bénéficier d’une meilleure mise à l’échelle (Figure 3A).

De plus, les chercheurs ont découvert que l'élagage des données peut améliorer les performances de l'apprentissage par transfert. Ils ont d’abord analysé ViT pré-entraîné sur ImageNet21K, puis affiné sur différents sous-ensembles élagués de CIFAR-10. Il est intéressant de noter que le modèle pré-entraîné a permis un élagage plus agressif des données ; seulement 10 % des réglages fins du CIFAR-10 correspondaient ou dépassaient les performances obtenues par tous les réglages fins du CIFAR-10 (Figure 4A). De plus, la figure 4A fournit un exemple de rupture de mise à l’échelle de la loi de puissance dans un réglage précis.

Nous avons examiné l'efficacité de l'élagage des données pré-entraînées en pré-entraînant ResNet50 sur différents sous-ensembles élagués d'ImageNet1K (illustré dans la figure 3D), puis les avons peaufinées sur CIFAR-10. Comme le montre la figure 4B, le pré-entraînement sur un minimum de 50 % d'ImageNet est capable d'égaler ou de dépasser les performances CIFAR-10 obtenues par le pré-entraînement sur tous les ImageNet.

Par conséquent, l'élagage des données de pré-entraînement des tâches en amont peut toujours maintenir des performances élevées sur différentes tâches en aval. Dans l’ensemble, ces résultats montrent la promesse d’un élagage de l’apprentissage par transfert pendant les phases de pré-formation et de mise au point.

Analyse comparative des métriques d'élagage supervisé sur ImageNet

Les chercheurs ont remarqué que la plupart des expériences d'élagage des données ont été menées sur des ensembles de données à petite échelle (c'est-à-dire des variantes du MNIST et du CIFAR). Par conséquent, les quelques mesures d’élagage proposées pour ImageNet sont rarement comparées aux lignes de base conçues sur des ensembles de données plus petits.

Ainsi, on ne sait pas comment la plupart des méthodes d'élagage s'adaptent à ImageNet et quelle méthode est la meilleure. Pour étudier l'impact théorique de la qualité des mesures d'élagage sur les performances, nous avons décidé de combler ce manque de connaissances en effectuant une évaluation systématique de 8 mesures d'élagage supervisées différentes sur ImageNet.

Ils ont observé des différences de performances significatives entre les métriques : la figure 5BC montre les performances du test lorsqu'une partie des échantillons les plus difficiles sous chaque métrique a été conservée dans l'ensemble d'entraînement. De nombreuses métriques réussissent sur des ensembles de données plus petits, mais lorsque l'on choisit un sous-ensemble de formation nettement plus petit (comme 80 % d'Imagenet), seules quelques-unes obtiennent encore des performances comparables lorsqu'elles sont entraînées sur l'ensemble de données complet.

Néanmoins, la plupart des mesures surpassent encore l’élagage aléatoire (Figure 5C). Les chercheurs ont découvert que toutes les mesures d’élagage amplifient le déséquilibre des classes, entraînant une dégradation des performances. Pour résoudre ce problème, les auteurs ont utilisé un simple taux d’équilibre des classes de 50 % dans toutes les expériences ImageNet.

Élagage de données auto-supervisé via des métriques prototypes

Comme le montre la figure 5, de nombreuses métriques d'élagage de données ne s'adaptent pas bien à ImageNet, et certaines d'entre elles nécessitent en effet beaucoup de calculs. De plus, toutes ces métriques nécessitent des annotations, ce qui limite leurs capacités d'élagage des données pour former des modèles de base à grande échelle sur des ensembles de données massifs non étiquetés. Par conséquent, nous avons clairement besoin de mesures d’élagage simples, évolutives et auto-supervisées.

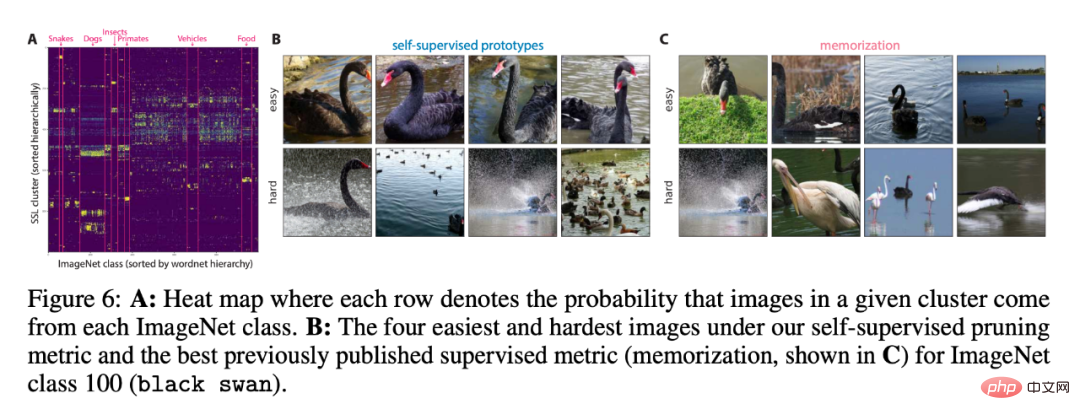

Pour évaluer si les clusters découverts par la métrique sont cohérents avec les classes ImageNet, nous avons comparé leur chevauchement dans la figure 6A. Les performances des mesures auto-supervisées et supervisées sont similaires lorsque l’on conserve plus de 70 % des données, ce qui montre la promesse d’un élagage auto-supervisé.

Pour plus de détails sur la recherche, veuillez vous référer à l'article original.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

Video Face Swap

Échangez les visages dans n'importe quelle vidéo sans effort grâce à notre outil d'échange de visage AI entièrement gratuit !

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Sujets chauds

1393

1393

52

52

1207

1207

24

24

WEB3 Trading Platform Ranking_Web3 Global Exchanges Top Ten Résumé

Apr 21, 2025 am 10:45 AM

WEB3 Trading Platform Ranking_Web3 Global Exchanges Top Ten Résumé

Apr 21, 2025 am 10:45 AM

Binance est le suzerain de l'écosystème mondial de trading d'actifs numériques, et ses caractéristiques comprennent: 1. Le volume de négociation quotidien moyen dépasse 150 milliards de dollars, prend en charge 500 paires de négociation, couvrant 98% des monnaies grand public; 2. La matrice d'innovation couvre le marché des dérivés, la mise en page Web3 et le système éducatif; 3. Les avantages techniques sont des moteurs de correspondance d'une milliseconde, avec des volumes de traitement de pointe de 1,4 million de transactions par seconde; 4. Conformité Progress détient des licences de 15 pays et établit des entités conformes en Europe et aux États-Unis.

Prévisions des prix WorldCoin (WLD) 2025-2031: WLD atteindra-t-il 4 $ d'ici 2031?

Apr 21, 2025 pm 02:42 PM

Prévisions des prix WorldCoin (WLD) 2025-2031: WLD atteindra-t-il 4 $ d'ici 2031?

Apr 21, 2025 pm 02:42 PM

WorldCoin (WLD) se démarque sur le marché des crypto-monnaies avec ses mécanismes uniques de vérification biométrique et de protection de la vie privée, attirant l'attention de nombreux investisseurs. WLD a permis de se produire avec remarquablement parmi les Altcoins avec ses technologies innovantes, en particulier en combinaison avec la technologie d'Intelligence artificielle OpenAI. Mais comment les actifs numériques se comporteront-ils au cours des prochaines années? Prédons ensemble le prix futur de WLD. Les prévisions de prix de 2025 WLD devraient atteindre une croissance significative de la WLD en 2025. L'analyse du marché montre que le prix moyen du WLD peut atteindre 1,31 $, avec un maximum de 1,36 $. Cependant, sur un marché baissier, le prix peut tomber à environ 0,55 $. Cette attente de croissance est principalement due à WorldCoin2.

Top 10 plates-formes d'échange de crypto-monnaie La plus grande liste de changes numériques au monde

Apr 21, 2025 pm 07:15 PM

Top 10 plates-formes d'échange de crypto-monnaie La plus grande liste de changes numériques au monde

Apr 21, 2025 pm 07:15 PM

Les échanges jouent un rôle essentiel sur le marché des crypto-monnaies d'aujourd'hui. Ce ne sont pas seulement des plateformes pour les investisseurs pour négocier, mais aussi des sources importantes de liquidité du marché et la découverte des prix. Les plus grands échanges de devises virtuels au monde se classent parmi les dix premiers, et ces échanges sont non seulement bien en avance dans le volume des échanges, mais présentent également leurs propres avantages dans l'expérience utilisateur, la sécurité et les services innovants. Les échanges qui dépassent la liste ont généralement une grande base d'utilisateurs et une influence approfondie du marché, et leur volume de trading et leurs types d'actifs sont souvent difficiles à atteindre par d'autres échanges.

Que signifie la transaction transversale? Quelles sont les transactions transversales?

Apr 21, 2025 pm 11:39 PM

Que signifie la transaction transversale? Quelles sont les transactions transversales?

Apr 21, 2025 pm 11:39 PM

Échanges qui prennent en charge les transactions transversales: 1. Binance, 2. UniSwap, 3. Sushiswap, 4. Curve Finance, 5. Thorchain, 6. 1inch Exchange, 7. DLN Trade, ces plateformes prennent en charge les transactions d'actifs multi-chaînes via diverses technologies.

Pourquoi la hausse ou la baisse des prix de monnaie virtuelle? Pourquoi la hausse ou la baisse des prix de monnaie virtuelle?

Apr 21, 2025 am 08:57 AM

Pourquoi la hausse ou la baisse des prix de monnaie virtuelle? Pourquoi la hausse ou la baisse des prix de monnaie virtuelle?

Apr 21, 2025 am 08:57 AM

Les facteurs de la hausse des prix des devises virtuels comprennent: 1. Une augmentation de la demande du marché, 2. Daisser l'offre, 3. Stimulé de nouvelles positives, 4. Sentiment du marché optimiste, 5. Environnement macroéconomique; Les facteurs de déclin comprennent: 1. Daissement de la demande du marché, 2. AUGMENT DE L'OFFICATION, 3. Strike of Negative News, 4. Pespimiste Market Sentiment, 5. Environnement macroéconomique.

Classement des échanges à effet de levier dans le cercle des devises Les dernières recommandations des dix premiers échanges à effet de levier dans le cercle des devises

Apr 21, 2025 pm 11:24 PM

Classement des échanges à effet de levier dans le cercle des devises Les dernières recommandations des dix premiers échanges à effet de levier dans le cercle des devises

Apr 21, 2025 pm 11:24 PM

Les plates-formes qui ont des performances exceptionnelles dans le commerce, la sécurité et l'expérience utilisateur en effet de levier en 2025 sont: 1. OKX, adaptés aux traders à haute fréquence, fournissant jusqu'à 100 fois l'effet de levier; 2. Binance, adaptée aux commerçants multi-monnaies du monde entier, offrant un effet de levier 125 fois élevé; 3. Gate.io, adapté aux joueurs de dérivés professionnels, fournissant 100 fois l'effet de levier; 4. Bitget, adapté aux novices et aux commerçants sociaux, fournissant jusqu'à 100 fois l'effet de levier; 5. Kraken, adapté aux investisseurs stables, fournissant 5 fois l'effet de levier; 6. BUTBIT, adapté aux explorateurs Altcoin, fournissant 20 fois l'effet de levier; 7. Kucoin, adapté aux commerçants à faible coût, fournissant 10 fois l'effet de levier; 8. Bitfinex, adapté au jeu senior

Comment gagner des récompenses de plateaux aériens du noyau sur la stratégie de processus complète de la binance

Apr 21, 2025 pm 01:03 PM

Comment gagner des récompenses de plateaux aériens du noyau sur la stratégie de processus complète de la binance

Apr 21, 2025 pm 01:03 PM

Dans le monde animé des crypto-monnaies, de nouvelles opportunités émergent toujours. À l'heure actuelle, l'activité aérienne de Kerneldao (noyau) attire beaucoup l'attention et attire l'attention de nombreux investisseurs. Alors, quelle est l'origine de ce projet? Quels avantages le support BNB peut-il en tirer? Ne vous inquiétez pas, ce qui suit le révélera un par un pour vous.

'Black Monday Sell' est une journée difficile pour l'industrie de la crypto-monnaie

Apr 21, 2025 pm 02:48 PM

'Black Monday Sell' est une journée difficile pour l'industrie de la crypto-monnaie

Apr 21, 2025 pm 02:48 PM

Le plongeon sur le marché des crypto-monnaies a provoqué la panique parmi les investisseurs, et Dogecoin (Doge) est devenu l'une des zones les plus difficiles. Son prix a fortement chuté et le verrouillage de la valeur totale de la finance décentralisée (DEFI) (TVL) a également connu une baisse significative. La vague de vente de "Black Monday" a balayé le marché des crypto-monnaies, et Dogecoin a été le premier à être touché. Son Defitvl a chuté aux niveaux de 2023 et le prix de la devise a chuté de 23,78% au cours du dernier mois. Le Defitvl de Dogecoin est tombé à un minimum de 2,72 millions de dollars, principalement en raison d'une baisse de 26,37% de l'indice de valeur SOSO. D'autres plates-formes de Defi majeures, telles que le Dao et Thorchain ennuyeux, TVL ont également chuté de 24,04% et 20, respectivement.