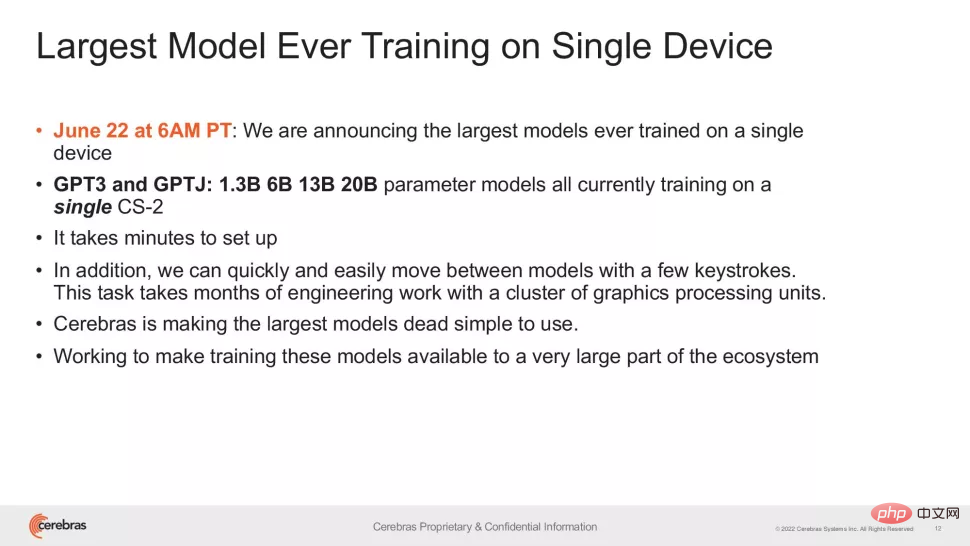

Cette semaine, la startup de puces Cerebras a annoncé une nouvelle étape : former un modèle d'intelligence artificielle NLP (traitement du langage naturel) avec plus de 10 milliards de paramètres dans un seul appareil informatique.

Le volume de modèles d'IA entraînés par Cerebras atteint un nombre sans précédent de 20 milliards de paramètres, le tout sans faire évoluer les charges de travail sur plusieurs accélérateurs. Ce travail est suffisant pour satisfaire le modèle de génération d'IA texte-image le plus populaire sur Internet : le grand modèle DALL-E de 12 milliards de paramètres d'OpenAI.

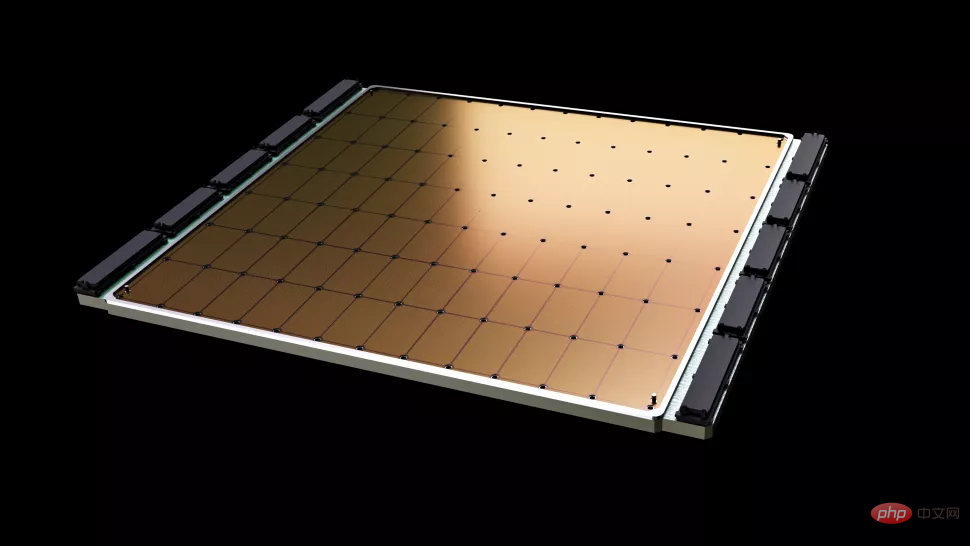

Cerebras La chose la plus importante à propos de ce nouvel emploi est la réduction des exigences en matière d'infrastructure et de complexité logicielle. La puce fournie par cette société, Wafer Scale Engine-2 (WSE2), est, comme son nom l'indique, gravée sur une seule plaquette entière selon le processus 7 nm de TSMC, une zone généralement suffisamment grande pour accueillir des centaines de puces grand public - avec une vitesse stupéfiante. 2,6 billions de transistors, 850 000 cœurs de calcul IA et 40 Go de cache intégré, et la consommation électrique après emballage atteint 15 kW.

Le Wafer Scale Engine-2 est proche de la taille d'une plaquette et est plus grand qu'un iPad.

Bien que la machine unique de Cerebras soit déjà similaire à un superordinateur en termes de taille, conserver jusqu'à 20 milliards de paramètres du modèle NLP dans une seule puce réduit encore considérablement le coût de formation de milliers de GPU, ainsi que du matériel et des technologies associés. exigences d'extension, tout en éliminant les difficultés techniques liées à la division des modèles entre eux. Ce dernier est « l’un des aspects les plus pénibles des charges de travail en PNL » et « prend parfois des mois », a déclaré Cerebras.

Il s'agit d'un problème personnalisé qui est propre non seulement à chaque réseau neuronal traité, mais également aux spécifications de chaque GPU et au réseau qui les relie - ces éléments doivent être formés la première fois. Configurez-le à l'avance avant de commencer, et il n'est pas portable entre les systèmes.

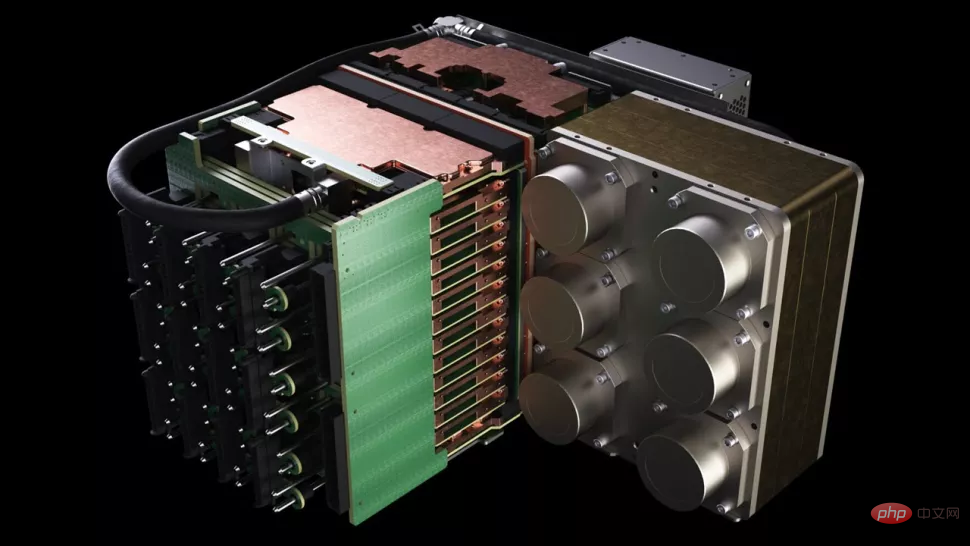

Le CS-2 de Cerebras est un cluster de supercalcul autonome qui comprend la puce Wafer Scale Engine-2, avec tous les sous-systèmes d'alimentation, de mémoire et de stockage associés.

Quel est le niveau approximatif de 20 milliards de paramètres ? Dans le domaine de l'intelligence artificielle, les modèles de pré-formation à grande échelle sont la direction que diverses entreprises et institutions technologiques ont travaillé dur pour développer récemment. Le GPT-3 d'OpenAI est un modèle NLP capable d'écrire des articles entiers et de faire des choses suffisantes. tromper les lecteurs humains. Opérations mathématiques et traductions avec un nombre stupéfiant de 175 milliards de paramètres. Gopher de DeepMind, lancé à la fin de l’année dernière, a porté le nombre record de paramètres à 280 milliards.

Récemment, Google Brain a même annoncé avoir entraîné un modèle avec plus d'un billion de paramètres, Switch Transformer.

"Dans le domaine de la PNL, il a été prouvé que les modèles plus grands sont plus performants. Mais traditionnellement, seules quelques entreprises disposent des ressources et de l'expertise nécessaires pour achever la décomposition de ces grands modèles, en les répartissant sur des centaines de personnes. Ou le travail acharné de milliers d'unités de traitement graphique", a déclaré Andrew Feldman, PDG et co-fondateur de Cerebras. "Il y a donc très peu d'entreprises capables de former de grands modèles PNL - c'est trop coûteux, chronophage et inutilisable pour le reste de l'industrie.

Maintenant, la méthode de Cerebras peut réduire le GPT-3XL 1.3B." la disponibilité des modèles GPT-J 6B, GPT-3 13B et GPT-NeoX 20B permet à l'ensemble de l'écosystème d'IA de créer de grands modèles en quelques minutes et de les entraîner sur un seul système CS-2.

Cependant, tout comme la vitesse d'horloge d'un processeur phare, le nombre de paramètres n'est qu'un indicateur des performances d'un grand modèle. Récemment, certaines recherches ont obtenu de meilleurs résultats en partant du principe de réduction des paramètres, comme Chinchilla proposé par DeepMind en avril de cette année, qui a surpassé GPT-3 et Gopher dans les cas conventionnels avec seulement 70 milliards de paramètres.

Le but de ce type de recherche est bien sûr de travailler plus intelligemment, et non de travailler plus dur. Les réalisations de Cerebras sont donc plus importantes que ce que les gens voient au premier abord - cette recherche nous donne la certitude que le niveau actuel de fabrication de puces peut s'adapter à des modèles de plus en plus complexes, et la société a déclaré que les systèmes avec des puces spéciales comme noyau ont le support " La capacité de modèles avec des centaines de milliards, voire des milliards de paramètres.

La croissance explosive du nombre de paramètres pouvant être entraînés sur une seule puce repose sur la technologie Weight Streaming de Cerebras. Cette technologie dissocie le calcul et l'empreinte mémoire, permettant à la mémoire d'évoluer à n'importe quelle échelle en fonction du nombre rapidement croissant de paramètres dans les charges de travail d'IA. Cela réduit le temps de configuration de plusieurs mois à quelques minutes et permet de basculer entre des modèles tels que GPT-J et GPT-Neo. Comme l'ont dit les chercheurs : "Cela ne prend que quelques frappes."

"Cerebras offre aux gens la possibilité d'exécuter de grands modèles de langage de manière pratique et peu coûteuse, ouvrant ainsi la voie à une nouvelle ère passionnante de l'intelligence artificielle. offre un moyen simple et peu coûteux aux organisations qui ne peuvent pas dépenser des dizaines de millions de dollars pour rivaliser sur de grands modèles », a déclaré Dan Olds, directeur de la recherche chez Intersect360 Research. "Nous attendons avec impatience les nouvelles applications et découvertes des clients CS-2 alors qu'ils entraînent des modèles de niveau GPT-3 et GPT-J sur des ensembles de données massifs

."Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Application de l'intelligence artificielle dans la vie

Application de l'intelligence artificielle dans la vie

Quel est le concept de base de l'intelligence artificielle

Quel est le concept de base de l'intelligence artificielle

Comment démarrer le service SVN

Comment démarrer le service SVN

Une liste complète des DNS publics couramment utilisés

Une liste complète des DNS publics couramment utilisés

Que signifie le jeton ?

Que signifie le jeton ?

Comment obtenir Douyin Xiaohuoren

Comment obtenir Douyin Xiaohuoren

Caractéristiques de l'arithmétique du complément à deux

Caractéristiques de l'arithmétique du complément à deux

Racine du téléphone portable

Racine du téléphone portable