Périphériques technologiques

Périphériques technologiques

IA

IA

'Yi Tay : un scientifique qui a quitté Google et s'est lancé dans la voie de l'entrepreneuriat, publiant 16 articles de haute qualité en trois ans'

'Yi Tay : un scientifique qui a quitté Google et s'est lancé dans la voie de l'entrepreneuriat, publiant 16 articles de haute qualité en trois ans'

'Yi Tay : un scientifique qui a quitté Google et s'est lancé dans la voie de l'entrepreneuriat, publiant 16 articles de haute qualité en trois ans'

Le lendemain de la sortie de GPT-4, Geoffrey Hinton, lauréat du prix Turing, a contribué à une merveilleuse métaphore : "Une chenille extrait les nutriments de la nourriture, puis se transforme en papillon. Les gens ont extrait des milliards d'indices de compréhension, GPT- 4 est le papillon humain"

En seulement deux semaines, ce papillon semble avoir déclenché un ouragan dans divers domaines. En conséquence, l’industrie de l’IA a marqué le début d’une nouvelle vague d’entrepreneuriat. Parmi eux se trouvent de nombreux entrepreneurs issus de grandes entreprises comme Google.

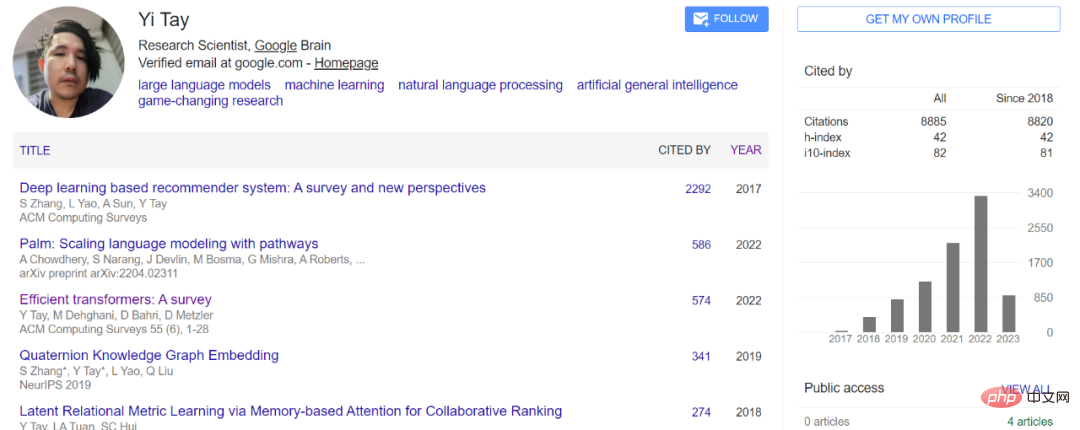

Si vous lisez souvent des articles sur les grands modèles d'IA, Yi Tay doit être un nom familier. En tant que chercheur scientifique principal chez Google Brain, Yi Tay a contribué à de nombreux modèles linguistiques à grande échelle et modèles multimodaux bien connus, notamment PaLM, UL2, Flan-U-PaLM, LaMDA/Bard, ViT-22B, PaLI, MAMAN et autres.

Selon les statistiques personnelles de Yi Tay, au cours de ses 3,3 années chez Google Brain, il a participé à la rédaction d'un total d'environ 45 articles et a été co-auteur de 16 d'entre eux. Les articles rédigés incluent UL2, U-PaLM, DSI, Synthesizer, Charformer et Long Range Arena, etc.

Comme la plupart des auteurs de Transformer qui ont quitté Google pour créer leur propre entreprise, Yi Tay a également trouvé le moment approprié pour partir et se lancer dans un nouveau voyage de vie.

Dans un article de blog, Yi Tay a officiellement annoncé la nouvelle de sa démission et a révélé sa prochaine étape dans son profil mis à jour : participer à la fondation d'une société appelée Reka et occuper le poste de PDG de l'entreprise. Scientifique en chef, en se concentrant sur modèles de langage à grande échelle.

Yi Tay a également révélé que Reka est basée dans la région de la baie de San Francisco et a été cofondée par une solide équipe d'anciens chercheurs et ingénieurs de DeepMind, FAIR et Google Brain.

En plus de Yi Tay, Liu Qi, professeur adjoint du Département d'informatique de l'Université de Hong Kong, a également mentionné sur sa page d'accueil personnelle qu'il participe à la création d'une société appelée "Reka" dédiée à le développement de modèles de base multimodaux. Au cours de ses études de doctorat, Liu Qi a effectué un stage chez Google pendant un certain temps et a co-écrit des articles tels que « Quaternion Knowledge Graph Embedding » avec Yi Tay.

Le site officiel de "Reka" ne pouvant pas encore être ouvert, nous ne sommes temporairement pas en mesure d'obtenir plus d'informations sur l'entreprise.

À l'occasion de ses adieux à Google, Yi Tay a écrit un blog avec gratitude, affirmant que quitter Google ressemblait à une remise de diplôme car il avait beaucoup appris de Google et de ses collègues, mentors et managers exceptionnels.

Google sera toujours spécial pour moi car c'est là que j'ai appris à faire de très bonnes recherches. Je repense à ma première adhésion, lorsque j'ai vu les auteurs de tant d'articles célèbres et influents si proches les uns des autres, j'étais comme un fan rencontrant sa star préférée. C’est pour moi une formidable stimulation sensorielle, très motivante et inspirante. À ce jour, je suis toujours reconnaissant d’avoir pu travailler et étudier avec beaucoup d’entre eux, du moins avant que la plupart d’entre eux ne partent.

J'ai beaucoup appris.

Dans une perspective plus large, j'ai appris l'importance de mener des recherches critiques et comment diriger la recherche vers l'objectif d'avoir un impact concret. Au collège, on nous dit seulement que nous devons soumettre un nombre N d'articles de conférence (afin d'obtenir notre diplôme ou de faire autre chose). Chez Google, les choses doivent être lancées et avoir un réel impact.

Pour moi, la plus grande inspiration ici est de savoir comment s'approprier le processus d'innovation en recherche de bout en bout, c'est-à-dire de l'idée au papier/brevet, en passant par la production et enfin au service des utilisateurs. Dans une large mesure, je pense que ce processus a fait de moi un meilleur chercheur.

Si je dois décrire ma croissance, je pense que l'ensemble de mon processus de recherche peut être considéré comme « fluide » plutôt que « soudain ». Je pense que mes propres capacités de recherche se sont améliorées de manière linéaire au fil du temps, à mesure que je m'améliorais et que je m'immergeais davantage dans la culture de Google. C'est comme un processus de diffusion. À ce jour, je crois toujours que l’environnement de recherche est très important.

Tout le monde dit que les « personnes » constituent le plus grand avantage de Google. Je suis tout à fait d'accord. Je suis éternellement reconnaissant à tous mes proches collaborateurs et mentors qui ont joué un rôle énorme dans mon évolution en tant que chercheur et en tant que personne.

Du fond du cœur, je tiens à remercier mon manager actuel (Quoc Le) et mon ancien manager (Don Metzler) de m'avoir donné l'opportunité de travailler ensemble et de toujours m'aider et prendre soin de moi - pas tout comme un subordonné A, mais aussi en tant que personne. Je voudrais également remercier des vétérans tels que Ed Chi, Denny Zhou et Slav Petrov pour m'avoir soutenu tout au long de ce voyage. Enfin, je tiens à remercier Andrew Tomkins, qui m'a repéré et m'a embauché pour rejoindre Google.

Je voudrais également remercier mes amis/collaborateurs les plus proches (Mostafa Dehghani, Vinh Tran, Jason Wei, Hyung Won, Steven Zheng, Siamak Shakeri) pour tous les moments amusants passés avec moi : Partager des sujets chauds, apprendre les uns des autres , rédigez des articles ensemble et discutez de la recherche.

Il convient de mentionner que si la vague d'entrepreneuriat modèle d'IA à grande échelle a été lancée à l'étranger, les startups nationales ont également lancé une bataille acharnée pour les talents. Par exemple, certains médias ont révélé que Wang Huiwen, qui vise à construire l'OpenAI chinoise, recrute également des troupes et envisage d'acquérir deux sociétés Tsinghua NLP : Shenyan Technology et Wall-Facing Intelligence. La rubrique Heart of the Machine Talent AI a également appris que les meilleurs laboratoires nationaux d'IA, plusieurs startups et un certain nombre d'institutions d'investissement quantitatif recherchent également activement de grands talents modèles.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Comment vérifier la configuration de CentOS HDFS

Apr 14, 2025 pm 07:21 PM

Comment vérifier la configuration de CentOS HDFS

Apr 14, 2025 pm 07:21 PM

Guide complet pour vérifier la configuration HDFS dans les systèmes CentOS Cet article vous guidera comment vérifier efficacement la configuration et l'état de l'exécution des HDF sur les systèmes CentOS. Les étapes suivantes vous aideront à bien comprendre la configuration et le fonctionnement des HDF. Vérifiez la variable d'environnement Hadoop: Tout d'abord, assurez-vous que la variable d'environnement Hadoop est correctement définie. Dans le terminal, exécutez la commande suivante pour vérifier que Hadoop est installé et configuré correctement: HadoopVersion Check HDFS Fichier de configuration: Le fichier de configuration de base de HDFS est situé dans le répertoire / etc / hadoop / conf / le répertoire, où Core-site.xml et hdfs-site.xml sont cruciaux. utiliser

Ligne de commande de l'arrêt CentOS

Apr 14, 2025 pm 09:12 PM

Ligne de commande de l'arrêt CentOS

Apr 14, 2025 pm 09:12 PM

La commande de fermeture CENTOS est arrêtée et la syntaxe est la fermeture de [options] le temps [informations]. Les options incluent: -H Arrêtez immédiatement le système; -P éteignez l'alimentation après l'arrêt; -r redémarrer; -t temps d'attente. Les temps peuvent être spécifiés comme immédiats (maintenant), minutes (minutes) ou une heure spécifique (HH: mm). Des informations supplémentaires peuvent être affichées dans les messages système.

Quelles sont les méthodes de sauvegarde pour Gitlab sur Centos

Apr 14, 2025 pm 05:33 PM

Quelles sont les méthodes de sauvegarde pour Gitlab sur Centos

Apr 14, 2025 pm 05:33 PM

La politique de sauvegarde et de récupération de GitLab dans le système CentOS afin d'assurer la sécurité et la récupérabilité des données, Gitlab on CentOS fournit une variété de méthodes de sauvegarde. Cet article introduira plusieurs méthodes de sauvegarde courantes, paramètres de configuration et processus de récupération en détail pour vous aider à établir une stratégie complète de sauvegarde et de récupération de GitLab. 1. MANUEL BACKUP Utilisez le Gitlab-RakegitLab: Backup: Créer la commande pour exécuter la sauvegarde manuelle. Cette commande sauvegarde des informations clés telles que le référentiel Gitlab, la base de données, les utilisateurs, les groupes d'utilisateurs, les clés et les autorisations. Le fichier de sauvegarde par défaut est stocké dans le répertoire / var / opt / gitlab / backups. Vous pouvez modifier / etc / gitlab

CentOS installe MySQL

Apr 14, 2025 pm 08:09 PM

CentOS installe MySQL

Apr 14, 2025 pm 08:09 PM

L'installation de MySQL sur CENTOS implique les étapes suivantes: Ajout de la source MySQL YUM appropriée. Exécutez la commande YUM Install MySQL-Server pour installer le serveur MySQL. Utilisez la commande mysql_secure_installation pour créer des paramètres de sécurité, tels que la définition du mot de passe de l'utilisateur racine. Personnalisez le fichier de configuration MySQL selon les besoins. Écoutez les paramètres MySQL et optimisez les bases de données pour les performances.

Comment afficher les journaux Gitlab sous Centos

Apr 14, 2025 pm 06:18 PM

Comment afficher les journaux Gitlab sous Centos

Apr 14, 2025 pm 06:18 PM

Un guide complet pour consulter les journaux GitLab sous Centos System Cet article vous guidera comment afficher divers journaux GitLab dans le système CentOS, y compris les journaux principaux, les journaux d'exception et d'autres journaux connexes. Veuillez noter que le chemin du fichier journal peut varier en fonction de la version Gitlab et de la méthode d'installation. Si le chemin suivant n'existe pas, veuillez vérifier le répertoire d'installation et les fichiers de configuration de GitLab. 1. Afficher le journal GitLab principal Utilisez la commande suivante pour afficher le fichier journal principal de l'application GitLabRails: Commande: sudocat / var / log / gitlab / gitlab-rails / production.log Cette commande affichera le produit

Comment faire fonctionner la formation distribuée de Pytorch sur CentOS

Apr 14, 2025 pm 06:36 PM

Comment faire fonctionner la formation distribuée de Pytorch sur CentOS

Apr 14, 2025 pm 06:36 PM

La formation distribuée par Pytorch sur le système CentOS nécessite les étapes suivantes: Installation de Pytorch: La prémisse est que Python et PIP sont installés dans le système CentOS. Selon votre version CUDA, obtenez la commande d'installation appropriée sur le site officiel de Pytorch. Pour la formation du processeur uniquement, vous pouvez utiliser la commande suivante: pipinstalltorchtorchVisionTorChaudio Si vous avez besoin d'une prise en charge du GPU, assurez-vous que la version correspondante de CUDA et CUDNN est installée et utilise la version Pytorch correspondante pour l'installation. Configuration de l'environnement distribué: la formation distribuée nécessite généralement plusieurs machines ou des GPU multiples uniques. Lieu

Explication détaillée du principe docker

Apr 14, 2025 pm 11:57 PM

Explication détaillée du principe docker

Apr 14, 2025 pm 11:57 PM

Docker utilise les fonctionnalités du noyau Linux pour fournir un environnement de fonctionnement d'application efficace et isolé. Son principe de travail est le suivant: 1. Le miroir est utilisé comme modèle en lecture seule, qui contient tout ce dont vous avez besoin pour exécuter l'application; 2. Le Système de fichiers Union (UnionFS) empile plusieurs systèmes de fichiers, ne stockant que les différences, l'économie d'espace et l'accélération; 3. Le démon gère les miroirs et les conteneurs, et le client les utilise pour l'interaction; 4. Les espaces de noms et les CGROUP implémentent l'isolement des conteneurs et les limitations de ressources; 5. Modes de réseau multiples prennent en charge l'interconnexion du conteneur. Ce n'est qu'en comprenant ces concepts principaux que vous pouvez mieux utiliser Docker.

Comment est la prise en charge du GPU pour Pytorch sur Centos

Apr 14, 2025 pm 06:48 PM

Comment est la prise en charge du GPU pour Pytorch sur Centos

Apr 14, 2025 pm 06:48 PM

Activer l'accélération du GPU Pytorch sur le système CentOS nécessite l'installation de versions CUDA, CUDNN et GPU de Pytorch. Les étapes suivantes vous guideront tout au long du processus: CUDA et CUDNN Installation détermineront la compatibilité de la version CUDA: utilisez la commande NVIDIA-SMI pour afficher la version CUDA prise en charge par votre carte graphique NVIDIA. Par exemple, votre carte graphique MX450 peut prendre en charge CUDA11.1 ou plus. Téléchargez et installez Cudatoolkit: visitez le site officiel de Nvidiacudatoolkit et téléchargez et installez la version correspondante selon la version CUDA la plus élevée prise en charge par votre carte graphique. Installez la bibliothèque CUDNN: