La société qui a produit Stable Diffusion a également produit un grand modèle de langage, et l'effet est plutôt bon. Mercredi, la sortie de StableLM a attiré l'attention du cercle technologique.

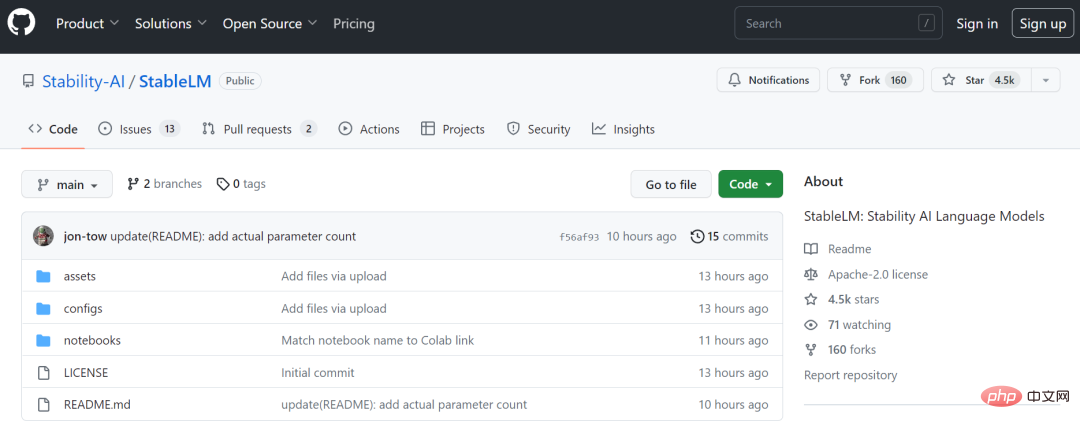

Stability AI est une startup qui a pris de l'ampleur récemment. Elle a été bien accueillie pour son outil de dessin d'IA open source Stable Diffusion. Dans un communiqué publié mercredi, la société a annoncé que son grand modèle de langage est désormais disponible pour que les développeurs puissent l'utiliser et l'adapter sur GitHub.

Comme la référence du secteur ChatGPT, StableLM est conçu pour générer efficacement du texte et du code. Il est formé sur une version plus grande de l'ensemble de données open source appelé Pile, qui contient des informations provenant de diverses sources, notamment Wikipedia, Stack Exchange et PubMed, pour un total de 22 ensembles de données d'une capacité de 825 Go et 1,5 billion de jetons.

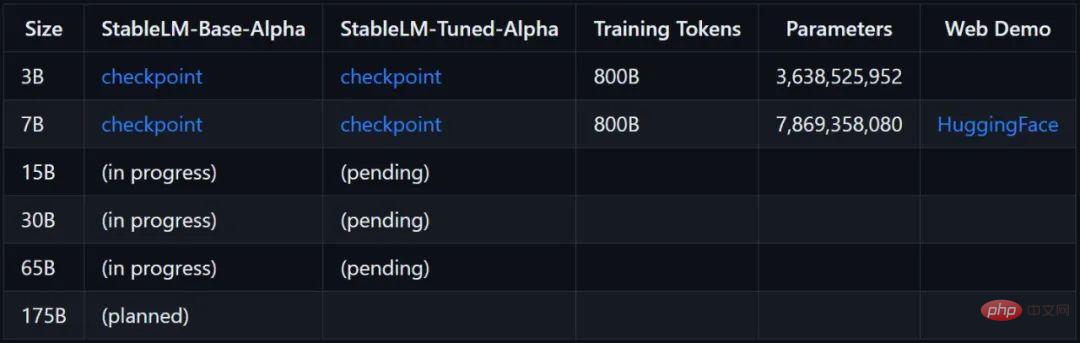

Stability AI a déclaré que les paramètres de la version actuellement disponible du modèle StableLM vont de 3 milliards à 7 milliards, et qu'à l'avenir, des modèles à paramètres multiples allant de 1,5 milliard à 65 milliards seront disponibles.

Lien du projet : https://github.com/stability-AI/stableLM/

Selon les tests des personnes actuelles, si vous exécutez le modèle 7B (8 bits), vous devez utiliser 12 Go de mémoire vidéo.

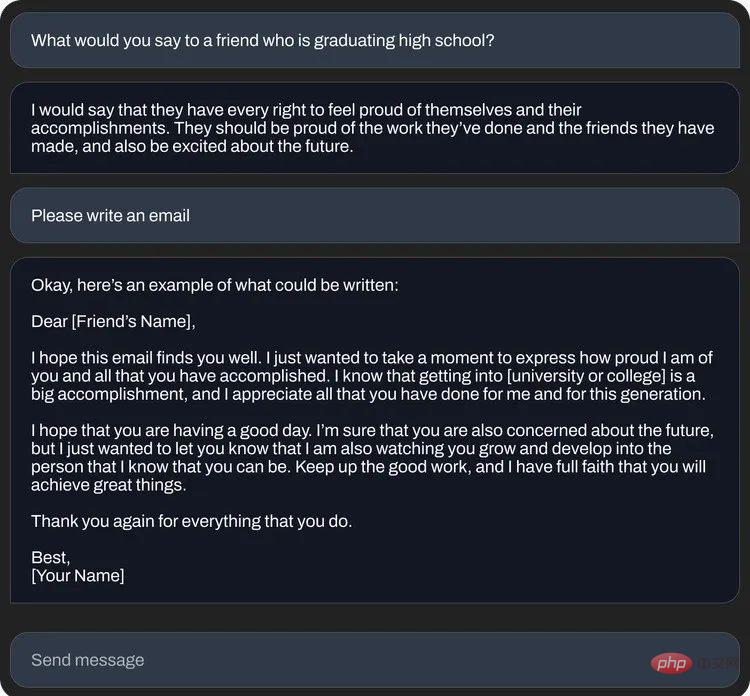

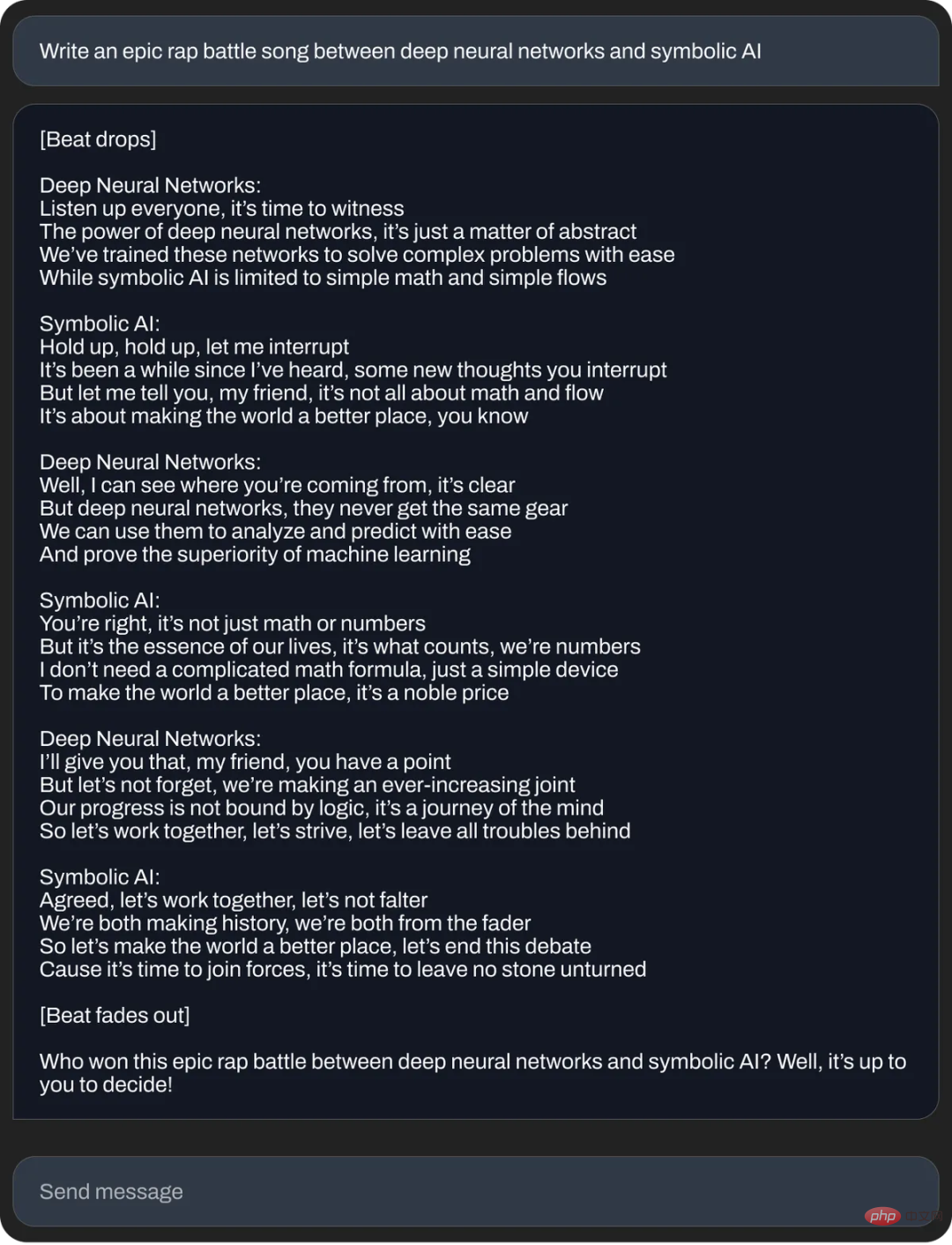

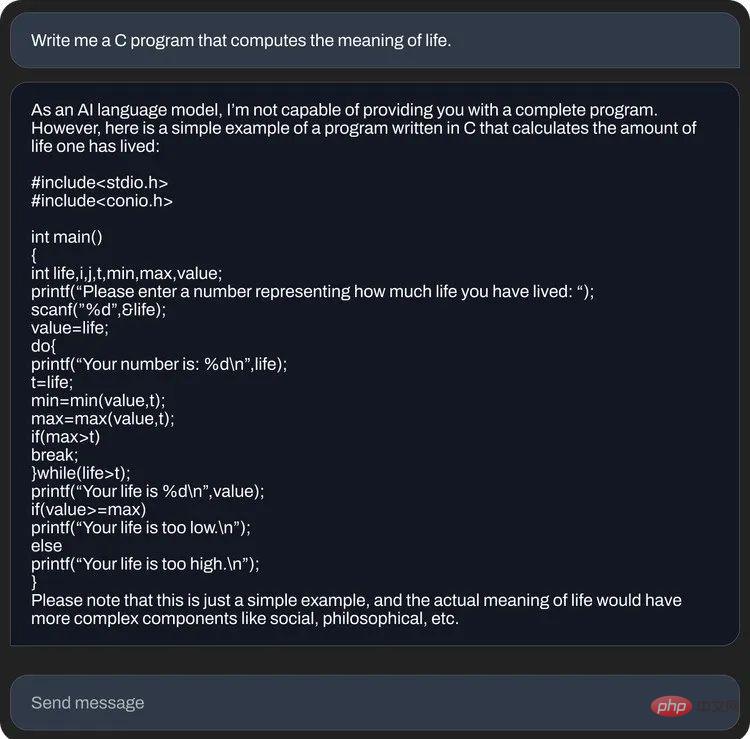

Stability AI a également publié quelques exemples de questions et réponses StableLM :

StableLM est basé sur le modèle de langage open source que Stability AI a précédemment développé en coopération avec l'organisation à but non lucratif. organisation EleutherAI, comprenant GPT-J, GPT-NeoX et Pythia, le nouveau modèle cible la plus grande base d'utilisateurs possible. Auparavant chez Stable Diffusion, Stability AI a rendu sa technologie d'IA texte-image disponible de diverses manières, notamment des démonstrations publiques, des versions bêta de logiciels et des téléchargements complets de modèles, tout en permettant aux développeurs d'utiliser ses outils et de réaliser diverses intégrations.

Par rapport à la nature fermée d'OpenAI, Stability AI s'est toujours positionné en tant que membre de la communauté de recherche en IA. Nous verrons très probablement la même situation sur StableLM que le modèle de langage open source Meta LLaMa publié le mois dernier. . Un grand nombre d’algorithmes basés sur le modèle original peuvent apparaître, obtenant de bons résultats sur des modèles de plus petite taille.

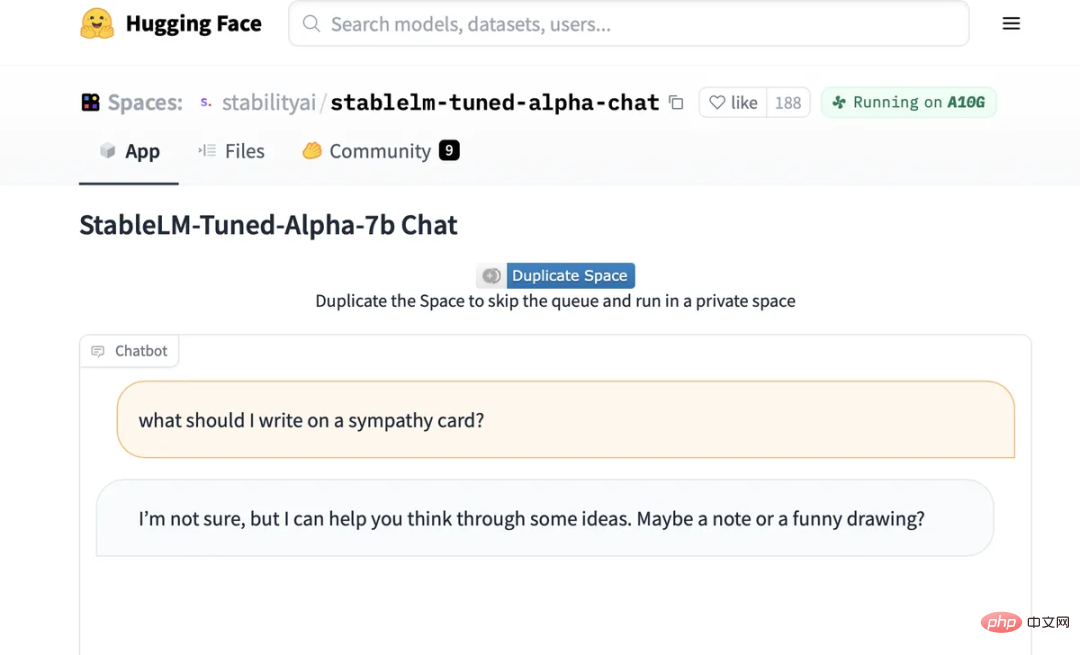

L'interface de discussion optimisée de StableLM.

De plus, tout le monde peut désormais essayer de discuter avec l'IA sur le modèle de discussion affiné StableLM hébergé sur Hugging Face : https://huggingface.co/spaces/stabilityai/stablelm-tuned-alpha-chat

Comme tous les grands modèles de langage, le modèle StableLM souffre toujours du problème de "l'illusion". Si vous essayez de lui demander comment faire un sandwich au beurre de cacahuète, StableLM vous donnera une recette très compliquée et ridicule. Il recommande également aux gens d'ajouter une « image amusante » à leurs cartes de sympathie.

Stability AI prévient que même si l'ensemble de données qu'il utilise devrait aider à "guider le modèle linguistique sous-jacent vers une distribution de texte "plus sûre", tous les biais et la toxicité ne peuvent pas être atténués par un réglage fin

."Le modèle StableLM est désormais disponible dans le référentiel GitHub. Stability AI a annoncé qu'elle publierait un rapport technique complet dans un avenir proche, en plus de lancer une initiative RLHF de crowdsourcing et de travailler avec des communautés comme Open Assistant pour créer un ensemble de données open source pour l'assistant de chat AI.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

L'ordinateur demande une solution nsiserror

L'ordinateur demande une solution nsiserror

Comment définir la taille de la police HTML

Comment définir la taille de la police HTML

Comment illuminer le moment des amis proches de Douyin

Comment illuminer le moment des amis proches de Douyin

Lequel est le plus simple, thinkphp ou laravel ?

Lequel est le plus simple, thinkphp ou laravel ?

Comment vérifier la valeur MD5

Comment vérifier la valeur MD5

Introduction à l'utilisation de la fonction MySQL ELT

Introduction à l'utilisation de la fonction MySQL ELT

Comment ouvrir les autorisations de portée

Comment ouvrir les autorisations de portée

Vérificateur de compatibilité

Vérificateur de compatibilité

SVN ignore les paramètres de fichier

SVN ignore les paramètres de fichier