Périphériques technologiques

Périphériques technologiques

IA

IA

Présentation d'ImageMol, le premier cadre de génération d'images moléculaires au monde basé sur l'apprentissage auto-supervisé

Présentation d'ImageMol, le premier cadre de génération d'images moléculaires au monde basé sur l'apprentissage auto-supervisé

Présentation d'ImageMol, le premier cadre de génération d'images moléculaires au monde basé sur l'apprentissage auto-supervisé

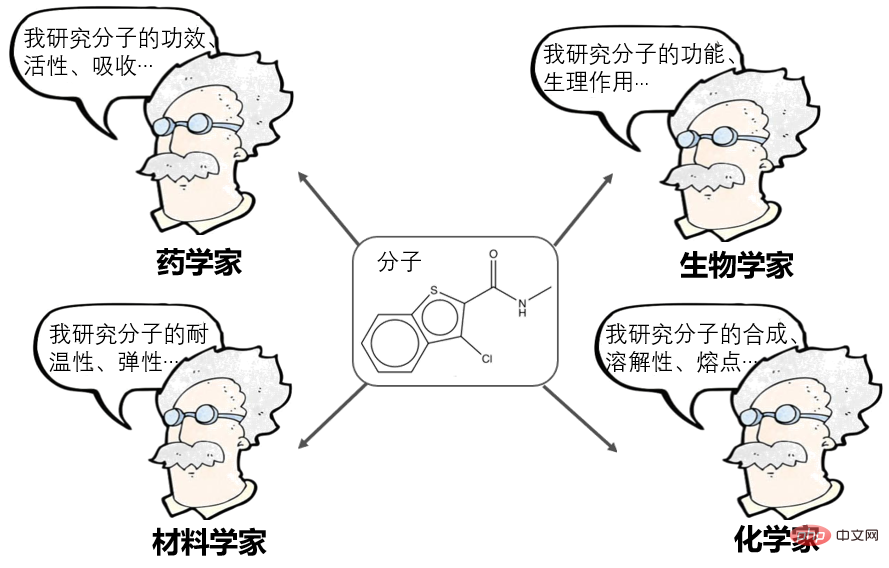

Moléculaire est la plus petite unité qui maintient la stabilité chimique des substances. L’étude des molécules est un enjeu fondamental dans de nombreux domaines scientifiques comme la pharmacie, la science des matériaux, la biologie ou encore la chimie.

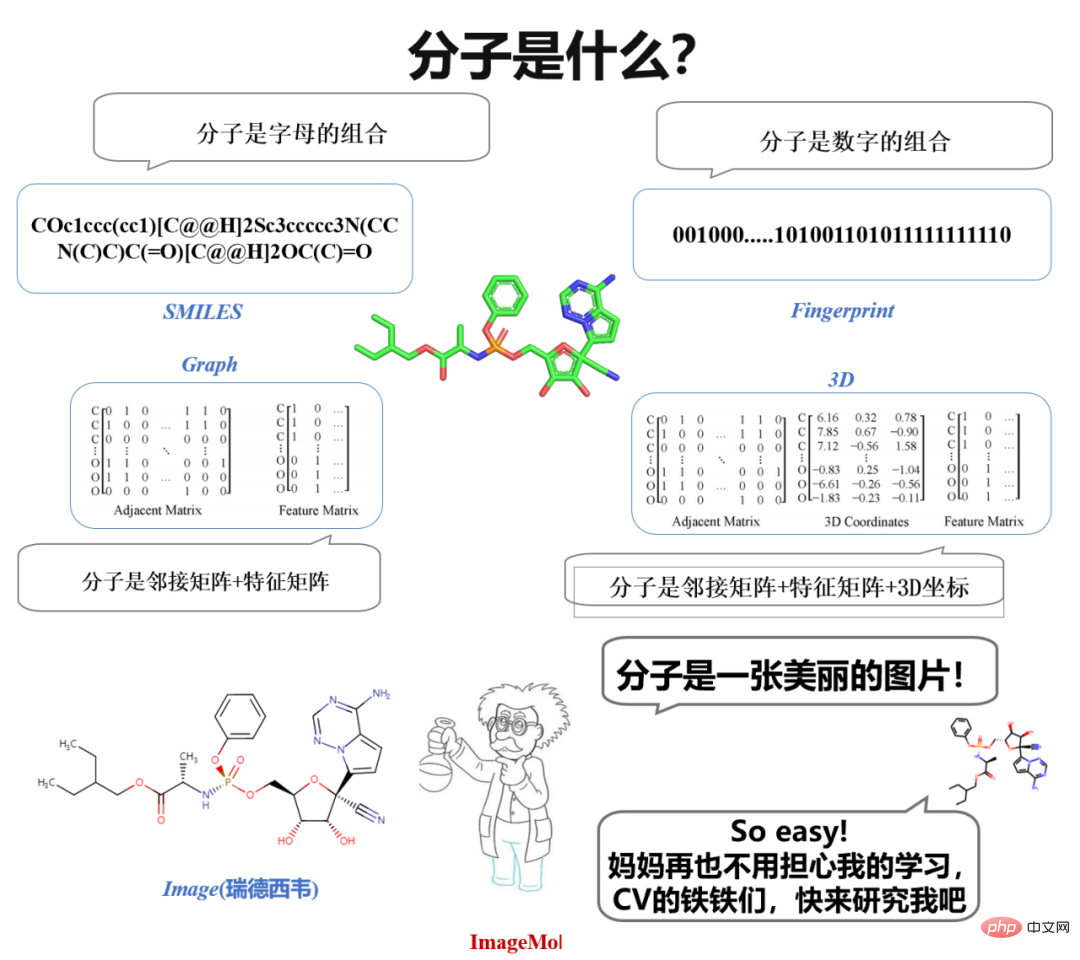

L'apprentissage de la représentation moléculaire a été une direction très populaire ces dernières années et peut actuellement être divisé en de nombreuses écoles :

- Les pharmaciens informatiques disent : les molécules peuvent être représentées comme une chaîne d'empreintes digitales, ou de descripteurs, comme AttentiveFP proposé par Shanghai Drug, sont des représentants remarquables à cet égard.

- NLPer a déclaré : Les molécules peuvent être exprimées sous forme de SMILES (séquences) puis traitées comme un langage naturel, comme le X-Mol de Baidu, qui est un représentant exceptionnel à cet égard.

- Les chercheurs en réseaux neuronaux graphiques disent : les molécules peuvent être représentées sous forme de graphique (Graph), qui est une matrice de contiguïté, puis traitées à l'aide de réseaux neuronaux graphiques, tels que GROVER de Tencent, DMPNN du MIT, MOLCLR de CMU et d'autres méthodes. représentant exceptionnel à cet égard.

Cependant, les méthodes de caractérisation actuelles présentent encore certaines limites. Par exemple, la représentation des séquences manque d'informations structurelles explicites sur les molécules, et la capacité d'expression des réseaux neuronaux graphiques existants présente encore de nombreuses limites (le professeur Shen Huawei de l'Institut de technologie informatique de l'Académie chinoise des sciences en a discuté, voir le rapport de M. Shen « The Capacité d'expression des réseaux de neurones graphiques").

Ce qui est intéressant, c'est que lorsque nous étudions les molécules en chimie au lycée, nous voyons des images de molécules. Lorsque les chimistes conçoivent des molécules, ils observent et réfléchissent également sur la base d'images moléculaires. Une idée naturelle surgit spontanément : "Pourquoi ne pas utiliser directement des images moléculaires pour représenter des molécules ?" Si vous pouvez utiliser directement des images pour représenter des molécules, alors tous les dix-huit arts martiaux en CV (vision par ordinateur) ne peuvent pas être utilisés. utilisé pour étudier des molécules ?

Faites-le, il y a tellement de modèles dans les CV, que diriez-vous de les utiliser pour apprendre des molécules ? Arrêtez, il y a un autre problème important : les données ! Des données particulièrement étiquetées ! Dans le domaine du CV, l’annotation des données ne semble pas difficile. Pour des problèmes classiques de CV et de PNL comme la reconnaissance d’images ou la classification d’émotions, une personne peut annoter en moyenne 800 données. Cependant, dans le domaine moléculaire, les propriétés moléculaires ne peuvent être évaluées que par des expériences humides et des expériences cliniques, de sorte que les données étiquetées sont très rares.

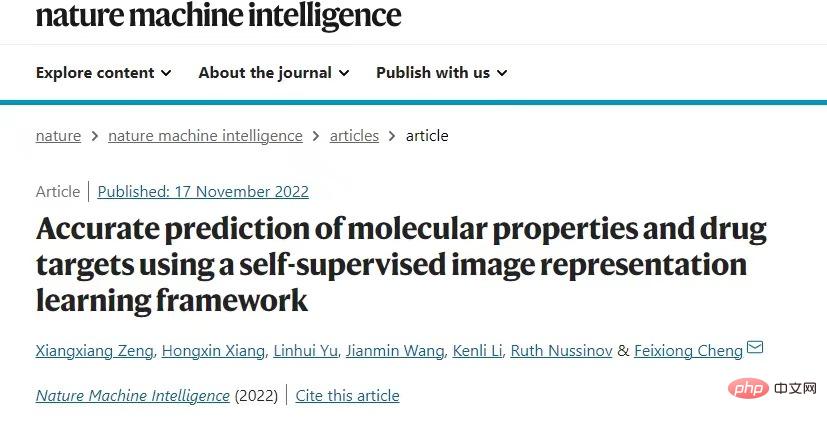

Sur cette base, des chercheurs de l'Université du Hunan ont proposé le premier cadre d'apprentissage non supervisé au monde pour les images moléculaires, ImageMol, qui utilise des données d'images moléculaires non étiquetées à grande échelle pour un pré-entraînement non supervisé afin de fournir des informations sur les propriétés moléculaires et les cibles des médicaments. fournit un nouveau paradigme et prouve que les images moléculaires ont un grand potentiel dans le domaine du développement de médicaments intelligents. Le résultat a été publié dans la revue internationale de premier plan « Nature Machine Intelligence » sous le titre « Prédiction précise des propriétés moléculaires et des cibles médicamenteuses à l'aide d'un cadre d'apprentissage de représentation d'image auto-supervisé ». Le succès obtenu à l'intersection de la vision par ordinateur et des domaines moléculaires démontre le grand potentiel de l'utilisation de la technologie de vision par ordinateur pour comprendre les propriétés moléculaires et les mécanismes cibles des médicaments, et offre de nouvelles opportunités de recherche dans le domaine moléculaire. L'architecture globale d'ImageMol est présentée dans la figure ci-dessous, divisée en trois parties au total :

(1) Concevoir un encodeur moléculaire ResNet18 (bleu clair), qui peut extraire des caractéristiques latentes d'environ 10 millions d'images moléculaires (a).

(2) Prenant en compte les connaissances chimiques et les informations structurelles dans les images moléculaires, cinq stratégies de pré-entraînement (MG3C, MRD, JPP, MCL, MIR) sont utilisées pour optimiser la représentation latente de l'encodeur moléculaire (b). Plus précisément :

① MG3C (Classification des clusters chimiques multi-granularité) : Le classificateur de structure (bleu foncé) est utilisé pour prédire les informations sur la structure chimique dans les images moléculaires

② MRD (Discrimination de rationalité moléculaire) : Classificateur de rationalité ( vert), qui est utilisé pour distinguer les molécules raisonnables et déraisonnables ;

③ JPP (Prédiction du puzzle) : Le classificateur Jigsaw (gris clair) est utilisé pour prédire l'arrangement raisonnable des molécules ;

④ MCL (MASK) ; -based contrastive learning basé sur MASK contrastive learning) : Le classificateur contrastif Classificateur contrastif (gris foncé) Utilisé pour maximiser la similarité entre l'image originale et l'image masque

⑤ MIR (Reconstruction d'image moléculaire) : Le générateur (jaune) ) est utilisé pour restaurer les caractéristiques latentes de l'image moléculaire, et le discriminateur est (violet) utilisé pour distinguer les images réelles des fausses images de molécules générées par le générateur.

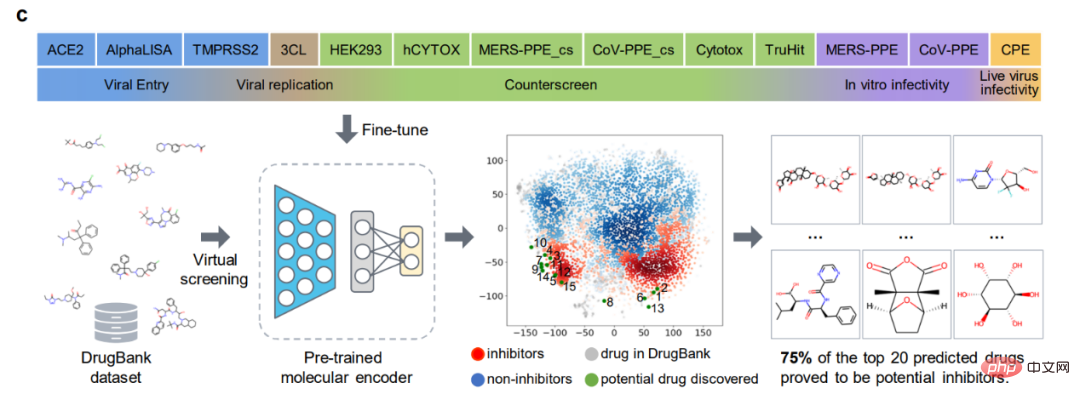

(3) Affinez l'encodeur moléculaire prétraité dans les tâches en aval pour améliorer encore les performances du modèle (c).

Évaluation de référence

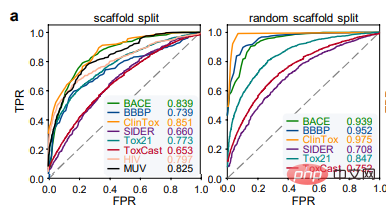

Les auteurs ont d'abord utilisé 8 ensembles de données de référence sur la découverte de médicaments pour évaluer les performances d'ImageMol, et ont utilisé les deux stratégies de fractionnement les plus populaires (répartition de l'échafaudage et répartition aléatoire de l'échafaudage) pour évaluer les performances d'ImageMol. Performances sur tous les ensembles de données de référence. Dans la tâche de classification, la courbe des caractéristiques de fonctionnement du récepteur (ROC) et la zone sous la courbe (AUC) sont utilisées pour évaluer. À partir des résultats expérimentaux, on peut voir qu'ImageMol peut obtenir des valeurs d'AUC plus élevées (Figure a).

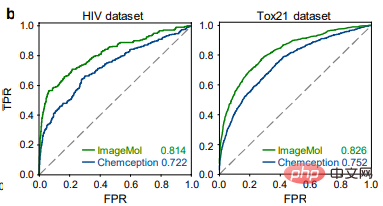

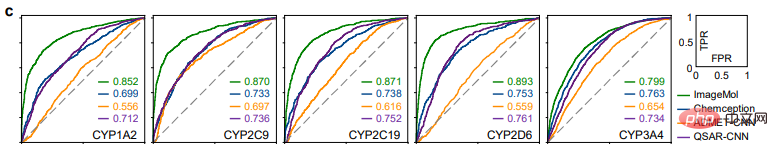

En comparant les résultats de détection du VIH et de Tox21 entre ImageMol et Chemception, un cadre de réseau neuronal convolutionnel classique pour prédire les images moléculaires (Figure b), ImageMol a une valeur d'ASC plus élevée. Cet article évalue en outre les performances d'ImageMol dans la prédiction du métabolisme des médicaments par cinq enzymes métabolisantes majeures : CYP1A2, CYP2C9, CYP2C19, CYP2D6 et CYP3A4. La figure c montre qu'ImageMol obtient de meilleurs résultats par rapport à trois modèles de représentation basés sur des images moléculaires de pointe (Chemception46, ADMET-CNN12 et QSAR-CNN47) dans la prédiction des inhibiteurs par rapport aux non-inhibiteurs de cinq enzymes majeures du métabolisme des médicaments. . a atteint des valeurs d'AUC plus élevées (allant de 0,799 à 0,893).

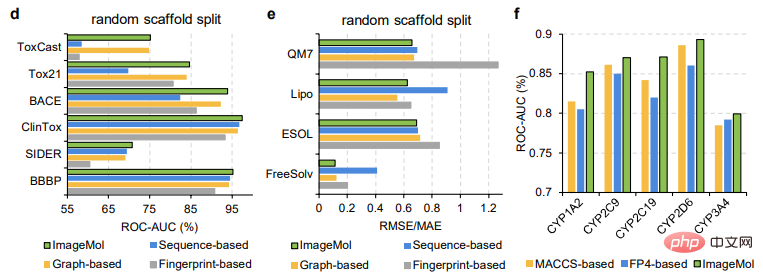

Cet article compare en outre les performances d'ImageMol avec trois modèles de représentation moléculaire de pointe, comme le montrent les figures d, e. ImageMol a de meilleures performances par rapport aux modèles basés sur les empreintes digitales (tels que AttentiveFP), aux modèles basés sur des séquences (tels que TF_Robust) et aux modèles basés sur des graphiques (tels que N-GRAM, GROVER et MPG) qui utilisent un partitionnement squelette aléatoire. De plus, ImageMol a atteint des valeurs d'ASC plus élevées sur les CYP1A2, CYP2C9, CYP2C19, CYP2D6 et CYP3A4 par rapport aux méthodes traditionnelles basées sur MACCS et aux méthodes basées sur FP4 (Figure f).

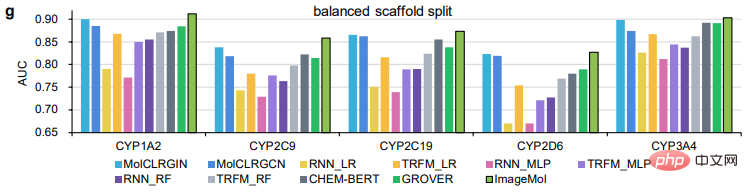

ImageMol Comparé aux modèles basés sur des séquences (y compris RNN_LR, TRFM_LR, RNN_MLP, TRFM_MLP, RNN_RF, TRFM_RF et CHEM-BERT) et aux modèles basés sur des graphiques (y compris MolCLRGIN, MolCLRGCN et GROVER), comme le montre la figure g, ImageMol De meilleures performances de l'ASC ont été obtenues pour les CYP1A2, CYP2C9, CYP2C19, CYP2D6 et CYP3A4.

Dans la comparaison ci-dessus entre ImageMol et d'autres modèles avancés, nous pouvons voir la supériorité d'ImageMol.

Depuis l’apparition du COVID-19, nous devons élaborer de toute urgence des stratégies de traitement efficaces contre le COVID-19. Par conséquent, les auteurs ont évalué ImageMol en conséquence sous cet aspect.

Prédiction de 13 cibles du SRAS-CoV-2

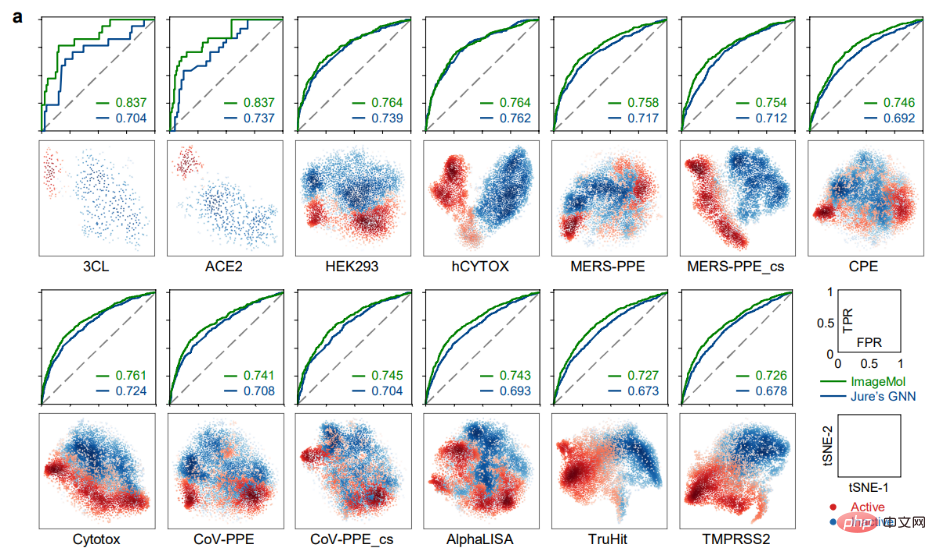

ImageMol a mené des expériences de prédiction sur le SRAS-CoV-2 qui est actuellement préoccupant dans 13 ensembles de données de tests biologiques sur le SRAS-CoV-2, ImageMol a atteint des valeurs d'ASC élevées. de 72,6% à 83,7%. Le panneau a révèle la signature potentielle identifiée par ImageMol, qui se regroupe bien sur 13 cibles ou points finaux anti-SARS-CoV-2 actifs et inactifs, avec des valeurs d'ASC supérieures aux autres. Le GNN du modèle Jure est plus de 12 % plus élevé, reflétant la grande précision et la forte généralisation du modèle.

Identification des inhibiteurs anti-SARS-CoV-2

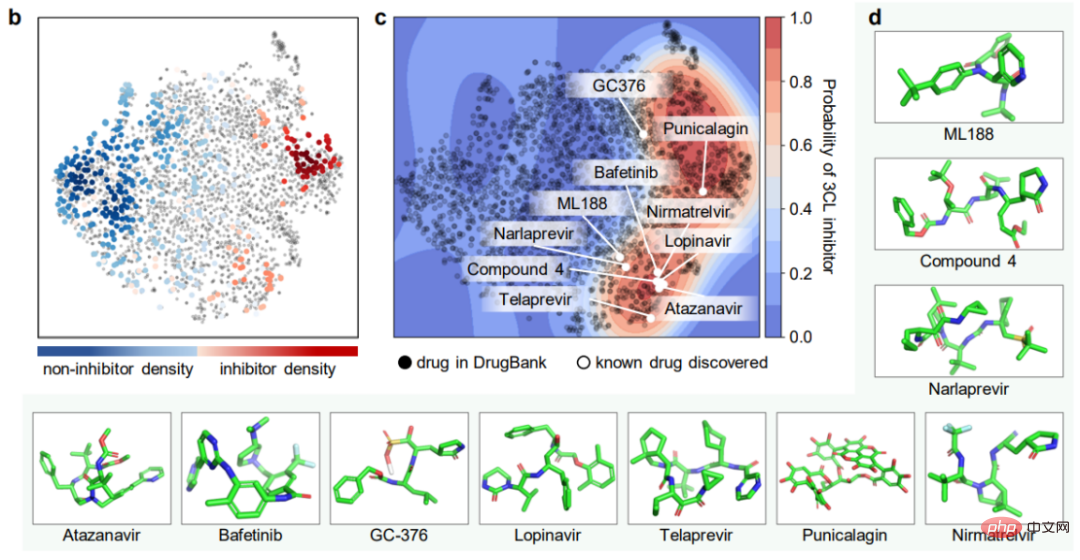

L'expérience la plus directe liée à la recherche de molécules médicamenteuses est ici, utilisez ImageMol pour identifier directement les molécules inhibitrices ! Grâce à la représentation par image moléculaire des inhibiteurs et des non-inhibiteurs de la protéase 3CL (qui s'est avérée être une cible de développement thérapeutique prometteuse pour le traitement du COVID-19) dans le cadre d'ImageMol, cette étude a révélé que les inhibiteurs et les non-inhibiteurs de la 3CL ont différences significatives dans les puits t séparés dans le tracé SNE, comme le montre la figure b ci-dessous.

De plus, ImageMol a identifié 10 des 16 inhibiteurs de protéase 3CL connus et a visualisé ces 10 médicaments dans l'espace d'intégration de la figure (taux de réussite de 62,5 %), indiquant qu'ils sont efficaces contre le SRAS-CoV-2. Forte généralisation capacité dans la découverte de médicaments. Lors de l’utilisation du test HEY293 pour prédire les médicaments réutilisés anti-SARS-CoV-2, ImageMol a prédit avec succès 42 médicaments sur 70 (taux de réussite de 60 %), ce qui indique qu’ImageMol est également efficace pour déduire des médicaments candidats potentiels dans le test HEY293. fort potentiel de promotion. La figure c ci-dessous montre la découverte par ImageMol de médicaments qui sont des inhibiteurs potentiels de la 3CL sur l'ensemble de données DrugBank. Le panneau d montre la structure moléculaire de l’inhibiteur 3CL découvert par ImageMol.

Attention Visualisation

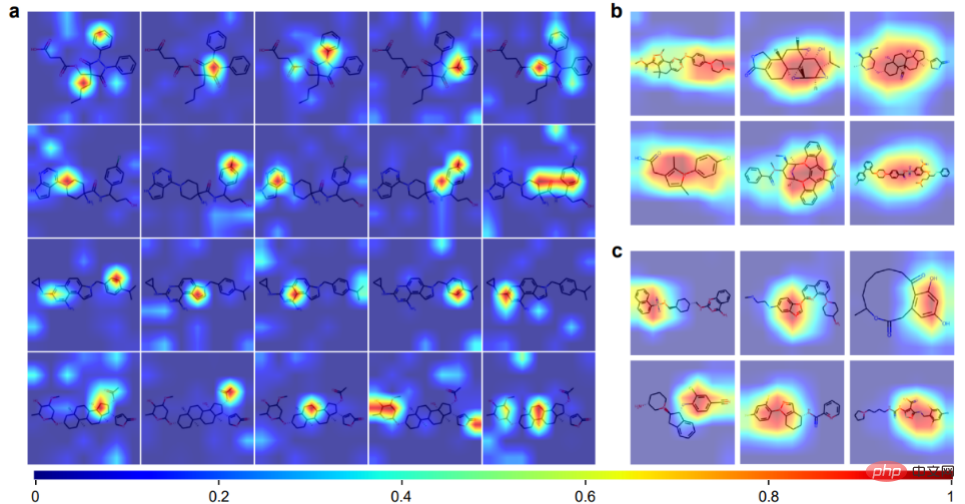

ImageMol peut obtenir une connaissance préalable des informations chimiques à partir de représentations d'images moléculaires, notamment les liaisons = O, les liaisons -OH, les liaisons -NH3 et les cycles benzéniques. Les panneaux b et c montrent 12 exemples de molécules visualisées par Grad-CAM d'ImageMol. Cela signifie qu'ImageMol capte simultanément avec précision l'attention sur les informations structurelles globales (b) et locales (c). Ces résultats permettent aux chercheurs de comprendre visuellement comment la structure moléculaire affecte les propriétés et les cibles.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Le modèle MoE open source le plus puissant au monde est ici, avec des capacités chinoises comparables à celles du GPT-4, et le prix ne représente que près d'un pour cent de celui du GPT-4-Turbo.

May 07, 2024 pm 04:13 PM

Le modèle MoE open source le plus puissant au monde est ici, avec des capacités chinoises comparables à celles du GPT-4, et le prix ne représente que près d'un pour cent de celui du GPT-4-Turbo.

May 07, 2024 pm 04:13 PM

Imaginez un modèle d'intelligence artificielle qui non seulement a la capacité de surpasser l'informatique traditionnelle, mais qui permet également d'obtenir des performances plus efficaces à moindre coût. Ce n'est pas de la science-fiction, DeepSeek-V2[1], le modèle MoE open source le plus puissant au monde est ici. DeepSeek-V2 est un puissant mélange de modèle de langage d'experts (MoE) présentant les caractéristiques d'une formation économique et d'une inférence efficace. Il est constitué de 236B paramètres, dont 21B servent à activer chaque marqueur. Par rapport à DeepSeek67B, DeepSeek-V2 offre des performances plus élevées, tout en économisant 42,5 % des coûts de formation, en réduisant le cache KV de 93,3 % et en augmentant le débit de génération maximal à 5,76 fois. DeepSeek est une entreprise explorant l'intelligence artificielle générale

L'IA bouleverse la recherche mathématique ! Le lauréat de la médaille Fields et mathématicien sino-américain a dirigé 11 articles les mieux classés | Aimé par Terence Tao

Apr 09, 2024 am 11:52 AM

L'IA bouleverse la recherche mathématique ! Le lauréat de la médaille Fields et mathématicien sino-américain a dirigé 11 articles les mieux classés | Aimé par Terence Tao

Apr 09, 2024 am 11:52 AM

L’IA change effectivement les mathématiques. Récemment, Tao Zhexuan, qui a prêté une attention particulière à cette question, a transmis le dernier numéro du « Bulletin de l'American Mathematical Society » (Bulletin de l'American Mathematical Society). En se concentrant sur le thème « Les machines changeront-elles les mathématiques ? », de nombreux mathématiciens ont exprimé leurs opinions. L'ensemble du processus a été plein d'étincelles, intense et passionnant. L'auteur dispose d'une équipe solide, comprenant Akshay Venkatesh, lauréat de la médaille Fields, le mathématicien chinois Zheng Lejun, l'informaticien de l'Université de New York Ernest Davis et de nombreux autres universitaires bien connus du secteur. Le monde de l’IA a radicalement changé. Vous savez, bon nombre de ces articles ont été soumis il y a un an.

Google est ravi : les performances de JAX surpassent Pytorch et TensorFlow ! Cela pourrait devenir le choix le plus rapide pour la formation à l'inférence GPU

Apr 01, 2024 pm 07:46 PM

Google est ravi : les performances de JAX surpassent Pytorch et TensorFlow ! Cela pourrait devenir le choix le plus rapide pour la formation à l'inférence GPU

Apr 01, 2024 pm 07:46 PM

Les performances de JAX, promu par Google, ont dépassé celles de Pytorch et TensorFlow lors de récents tests de référence, se classant au premier rang sur 7 indicateurs. Et le test n’a pas été fait sur le TPU présentant les meilleures performances JAX. Bien que parmi les développeurs, Pytorch soit toujours plus populaire que Tensorflow. Mais à l’avenir, des modèles plus volumineux seront peut-être formés et exécutés sur la base de la plate-forme JAX. Modèles Récemment, l'équipe Keras a comparé trois backends (TensorFlow, JAX, PyTorch) avec l'implémentation native de PyTorch et Keras2 avec TensorFlow. Premièrement, ils sélectionnent un ensemble de

Bonjour, Atlas électrique ! Le robot Boston Dynamics revient à la vie, des mouvements étranges à 180 degrés effraient Musk

Apr 18, 2024 pm 07:58 PM

Bonjour, Atlas électrique ! Le robot Boston Dynamics revient à la vie, des mouvements étranges à 180 degrés effraient Musk

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas entre officiellement dans l’ère des robots électriques ! Hier, l'Atlas hydraulique s'est retiré "en larmes" de la scène de l'histoire. Aujourd'hui, Boston Dynamics a annoncé que l'Atlas électrique était au travail. Il semble que dans le domaine des robots humanoïdes commerciaux, Boston Dynamics soit déterminé à concurrencer Tesla. Après la sortie de la nouvelle vidéo, elle a déjà été visionnée par plus d’un million de personnes en seulement dix heures. Les personnes âgées partent et de nouveaux rôles apparaissent. C'est une nécessité historique. Il ne fait aucun doute que cette année est l’année explosive des robots humanoïdes. Les internautes ont commenté : Les progrès des robots ont fait ressembler la cérémonie d'ouverture de cette année à des êtres humains, et le degré de liberté est bien plus grand que celui des humains. Mais n'est-ce vraiment pas un film d'horreur ? Au début de la vidéo, Atlas est allongé calmement sur le sol, apparemment sur le dos. Ce qui suit est à couper le souffle

KAN, qui remplace MLP, a été étendu à la convolution par des projets open source

Jun 01, 2024 pm 10:03 PM

KAN, qui remplace MLP, a été étendu à la convolution par des projets open source

Jun 01, 2024 pm 10:03 PM

Plus tôt ce mois-ci, des chercheurs du MIT et d'autres institutions ont proposé une alternative très prometteuse au MLP – KAN. KAN surpasse MLP en termes de précision et d’interprétabilité. Et il peut surpasser le MLP fonctionnant avec un plus grand nombre de paramètres avec un très petit nombre de paramètres. Par exemple, les auteurs ont déclaré avoir utilisé KAN pour reproduire les résultats de DeepMind avec un réseau plus petit et un degré d'automatisation plus élevé. Plus précisément, le MLP de DeepMind compte environ 300 000 paramètres, tandis que le KAN n'en compte qu'environ 200. KAN a une base mathématique solide comme MLP est basé sur le théorème d'approximation universelle, tandis que KAN est basé sur le théorème de représentation de Kolmogorov-Arnold. Comme le montre la figure ci-dessous, KAN a

Les robots Tesla travaillent dans les usines, Musk : Le degré de liberté des mains atteindra 22 cette année !

May 06, 2024 pm 04:13 PM

Les robots Tesla travaillent dans les usines, Musk : Le degré de liberté des mains atteindra 22 cette année !

May 06, 2024 pm 04:13 PM

La dernière vidéo du robot Optimus de Tesla est sortie, et il peut déjà fonctionner en usine. À vitesse normale, il trie les batteries (les batteries 4680 de Tesla) comme ceci : Le responsable a également publié à quoi cela ressemble à une vitesse 20 fois supérieure - sur un petit "poste de travail", en sélectionnant et en sélectionnant et en sélectionnant : Cette fois, il est publié L'un des points forts de la vidéo est qu'Optimus réalise ce travail en usine, de manière totalement autonome, sans intervention humaine tout au long du processus. Et du point de vue d'Optimus, il peut également récupérer et placer la batterie tordue, en se concentrant sur la correction automatique des erreurs : concernant la main d'Optimus, le scientifique de NVIDIA Jim Fan a donné une évaluation élevée : la main d'Optimus est l'un des robots à cinq doigts du monde. le plus adroit. Ses mains ne sont pas seulement tactiles

FisheyeDetNet : le premier algorithme de détection de cible basé sur une caméra fisheye

Apr 26, 2024 am 11:37 AM

FisheyeDetNet : le premier algorithme de détection de cible basé sur une caméra fisheye

Apr 26, 2024 am 11:37 AM

La détection de cibles est un problème relativement mature dans les systèmes de conduite autonome, parmi lesquels la détection des piétons est l'un des premiers algorithmes à être déployés. Des recherches très complètes ont été menées dans la plupart des articles. Cependant, la perception de la distance à l’aide de caméras fisheye pour une vue panoramique est relativement moins étudiée. En raison de la distorsion radiale importante, la représentation standard du cadre de délimitation est difficile à mettre en œuvre dans les caméras fisheye. Pour alléger la description ci-dessus, nous explorons les conceptions étendues de boîtes englobantes, d'ellipses et de polygones généraux dans des représentations polaires/angulaires et définissons une métrique de segmentation d'instance mIOU pour analyser ces représentations. Le modèle fisheyeDetNet proposé avec une forme polygonale surpasse les autres modèles et atteint simultanément 49,5 % de mAP sur l'ensemble de données de la caméra fisheye Valeo pour la conduite autonome.

DualBEV : dépassant largement BEVFormer et BEVDet4D, ouvrez le livre !

Mar 21, 2024 pm 05:21 PM

DualBEV : dépassant largement BEVFormer et BEVDet4D, ouvrez le livre !

Mar 21, 2024 pm 05:21 PM

Cet article explore le problème de la détection précise d'objets sous différents angles de vue (tels que la perspective et la vue à vol d'oiseau) dans la conduite autonome, en particulier comment transformer efficacement les caractéristiques de l'espace en perspective (PV) en vue à vol d'oiseau (BEV). implémenté via le module Visual Transformation (VT). Les méthodes existantes sont globalement divisées en deux stratégies : la conversion 2D en 3D et la conversion 3D en 2D. Les méthodes 2D vers 3D améliorent les caractéristiques 2D denses en prédisant les probabilités de profondeur, mais l'incertitude inhérente aux prévisions de profondeur, en particulier dans les régions éloignées, peut introduire des inexactitudes. Alors que les méthodes 3D vers 2D utilisent généralement des requêtes 3D pour échantillonner des fonctionnalités 2D et apprendre les poids d'attention de la correspondance entre les fonctionnalités 3D et 2D via un transformateur, ce qui augmente le temps de calcul et de déploiement.