Périphériques technologiques

Périphériques technologiques

IA

IA

'Appel à innovation : UCL Wang Jun discute de la théorie et des perspectives d'application de l'intelligence artificielle générale ChatGPT'

'Appel à innovation : UCL Wang Jun discute de la théorie et des perspectives d'application de l'intelligence artificielle générale ChatGPT'

'Appel à innovation : UCL Wang Jun discute de la théorie et des perspectives d'application de l'intelligence artificielle générale ChatGPT'

*Cet article a été initialement rédigé en anglais, La traduction en chinois a été réalisée par ChatGPT, et est présenté tel quel, avec quelques ambiguïtés marquées pour correction (parties rouges et jaunes). Veuillez consulter l'annexe pour le manuscrit anglais. L'auteur a constaté que les insuffisances de la traduction de ChatGPT sont souvent dues au manque d'expression fluide dans le manuscrit original en anglais. Les lecteurs intéressés devraient le lire attentivement.

ChatGPT a récemment attiré l'attention de la communauté des chercheurs, du monde des affaires et du grand public. Il s'agit d'un chatbot général qui peut répondre aux invites ou aux questions ouvertes des utilisateurs. La curiosité est née à propos de ses capacités linguistiques remarquables, proches de celles des humains, qui lui permettent de fournir des réponses cohérentes, cohérentes et bien structurées. Grâce à un vaste modèle de langage génératif pré-entraîné, ses interactions conversationnelles à plusieurs tours prennent en charge une variété de tâches basées sur du texte et du code, notamment la création de romans, le jeu de mots et même la manipulation de robots via la génération de code. Cela amène le public à croire que l’apprentissage automatique général et la compréhension automatique seront bientôt réalisables.

Si l'on creuse plus profondément, on peut constater que lorsque le code de programmation est ajouté en tant que données d'entraînement, certaines capacités de raisonnement, une compréhension de bon sens et même des chaînes de pensée (une série d'étapes de raisonnement intermédiaires) peuvent émerger lorsque le modèle atteint un certain niveau. échelle. Bien que cette nouvelle découverte soit passionnante et ouvre de nouvelles possibilités pour la recherche et les applications de l’intelligence artificielle, elle soulève plus de questions qu’elle n’en résout. Par exemple, ces capacités émergentesémergentes pourraient-elles servir d’indicateurs précoces d’une intelligence avancée, ou sont-elles simplement des imitations naïves du comportement humain ? La poursuite du développement de modèles déjà massifs pourrait-elle conduire à la création d’une intelligence artificielle générale (AGI), ou ces modèles sont-ils simplement une IA aux capacités limitées ? Si l’on répond à ces questions, elles pourraient conduire à des changements fondamentaux dans la théorie et l’application de l’intelligence artificielle.

Par conséquent, nous vous invitons non seulement à reproduire le succès de ChatGPT, mais plus important encore à mener des recherches révolutionnaires et le développement de nouvelles applications dans les domaines suivants de l'intelligence artificielle (liste non exhaustive) :

1 . Nouvelle théorie de l'apprentissage automatique, au-delà de basée sur tâche basée sur spécifique . Le paradigme établi de l'apprentissage automatique

Le raisonnement inductif est un type de raisonnement dans lequel nous tirons des conclusions sur le monde basées sur des observations passées. L’apprentissage automatique peut être vaguement considéré comme un raisonnement inductif dans la mesure où il utilise des données passées (de formation) pour améliorer les performances sur de nouvelles tâches. En prenant la traduction automatique comme exemple, un processus d'apprentissage automatique typique comprend les quatre étapes principales suivantes :

1 Définir un problème spécifique, tel que besoin de traduire des phrases anglaises en chinois : E → C,

. 2. Collectez des données, telles que des paires de phrases {E → C},

3. Entraînez un modèle, tel qu'un réseau neuronal profond en utilisant l'entrée {E} et la sortie {C},

4. modélisez des points de données inconnus, par exemple, saisissez une nouvelle phrase anglaise E', affichez la traduction chinoise C' et évaluez le résultat.

Comme indiqué ci-dessus, l'apprentissage automatique traditionnel isole la formation de chaque tâche spécifique. Par conséquent, pour chaque nouvelle tâche, le processus doit être réinitialisé et réexécuté de l’étape 1 à l’étape 4, perdant ainsi toutes les connaissances acquises (données, modèles, etc.) des tâches précédentes. Par exemple, si vous souhaitez traduire du français vers le chinois, vous avez besoin d’un modèle différent.

Sous ce paradigme, le travail des théoriciens de l'apprentissage automatique se concentre sur la compréhension de la capacité d'un modèle d'apprentissage à généraliser des données d'entraînement aux données de test invisibles. Par exemple, une question courante est de savoir combien d’échantillons sont nécessaires lors de l’entraînement pour atteindre une certaine erreur liée à la prédiction de données de test invisibles. Nous savons que les biais biais inductifs (c'est-à-dire des connaissances préalables ou des hypothèses préalables) sont nécessaires pour qu'un modèle d'apprentissage prédise ses résultats non rencontrés. En effet, la valeur de sortie dans la situation inconnue est complètement arbitraire et il est impossible de résoudre le problème sans faire certaines hypothèses. Le célèbre théorème du « repas gratuit » illustre en outre que tout biais inductif a des limites ; il ne fonctionnera que pour certains ensembles de problèmes, et il peut échouer ailleurs si la connaissance a priori supposée est incorrecte.

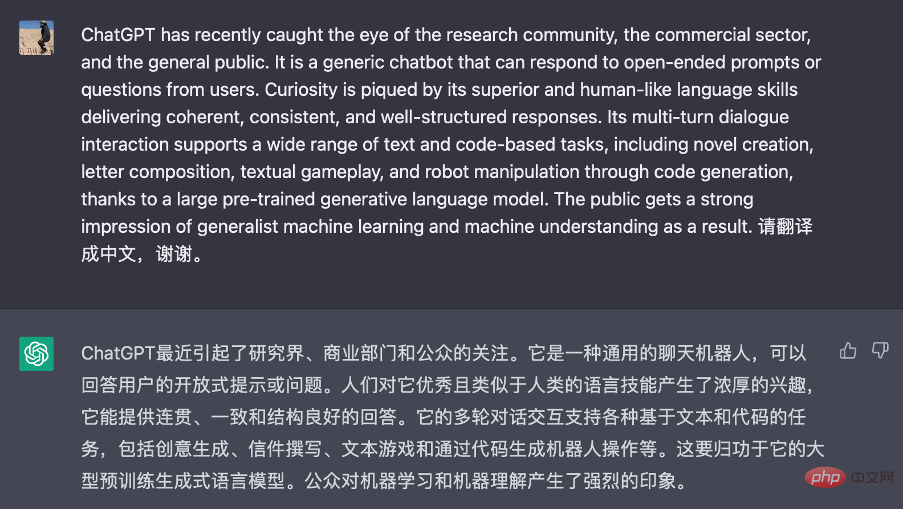

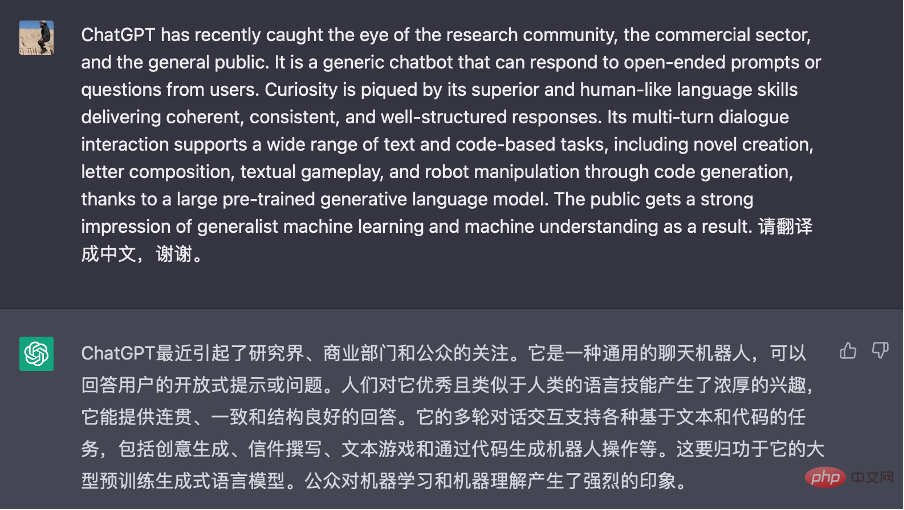

Figure 1 Capture d'écran de ChatGPT pour la traduction automatique. Les invites utilisateur contiennent uniquement des instructions et ne nécessitent pas d’exemples de démonstration.

Bien que la théorie ci-dessus s'applique toujours, l'émergence de modèles linguistiques de base a peut-être changé notre approche de l'apprentissage automatique. Le nouveau processus d'apprentissage automatique peut être le suivant (en prenant le problème de traduction automatique comme exemple, voir Figure 1) :

1.L'API accède à des modèles linguistiques de base formés par d'autres, tels que la formation sur divers documents, y compris les paires anglais/chinois. modèle de corpus.

2. Concevez une description textuelle appropriée (appelée invite) pour la tâche à accomplir basée sur quelques exemples ou aucun, par exemple PromptPrompt = {quelques exemples E ➔ C}.

3. Conditionné par l'invite et compte tenu de nouveaux points de données de test, le modèle de langage génère une réponse, par exemple en ajoutant E' à l'invite et en générant C' à partir du modèle.

4. Interprétez la réponse comme une prédiction.

Comme indiqué à l'étape 1, le modèle linguistique de base sert de base de connaissances universelletaille unique. Les astuces et le contexte fournis à l'étape 2 permettent de personnaliser le modèle de langage de base pour résoudre un objectif ou un problème spécifique sur la base d'un petit nombre d'exemples de démonstration. Bien que le pipeline ci-dessus soit principalement limité aux problèmes basés sur du texte, il est raisonnable de supposer qu'à mesure que les modèles de base pré-entraînés évolueront selon les modalités (voir section 3), ils deviendront la norme pour l'apprentissage automatique. Cela pourrait éliminer les barrières de tâches nécessaires et ouvrir la voie à l’Intelligence générale artificielle (AGI).

Cependant, nous n’en sommes qu’aux premiers stades de la compréhension du fonctionnement des exemples de démonstration dans le texte de l’indice. D'après certains travaux antérieurs, nous comprenons maintenant que le format de l'échantillon de démonstration est plus important que l'exactitude des étiquettes (par exemple, comme le montre la figure 1, nous n'avons pas besoin de fournir des exemples de traduction, mais seulement besoin de fournir la description du langage), mais y a-t-il des limites théoriques à son adaptabilité, comme le dit le théorème du « pas de repas gratuit » ? La connaissance du contexte et des impératifs énoncés dans les invites peut-elle être intégrée dans le modèle pour une utilisation future ? Ces questions commencent seulement à être explorées. Par conséquent, nous appelons à une nouvelle compréhension et à de nouveaux principes de cette nouvelle forme d’apprentissage contextuel et de ses limites et propriétés théoriques, comme la recherche des limites de la généralisation.

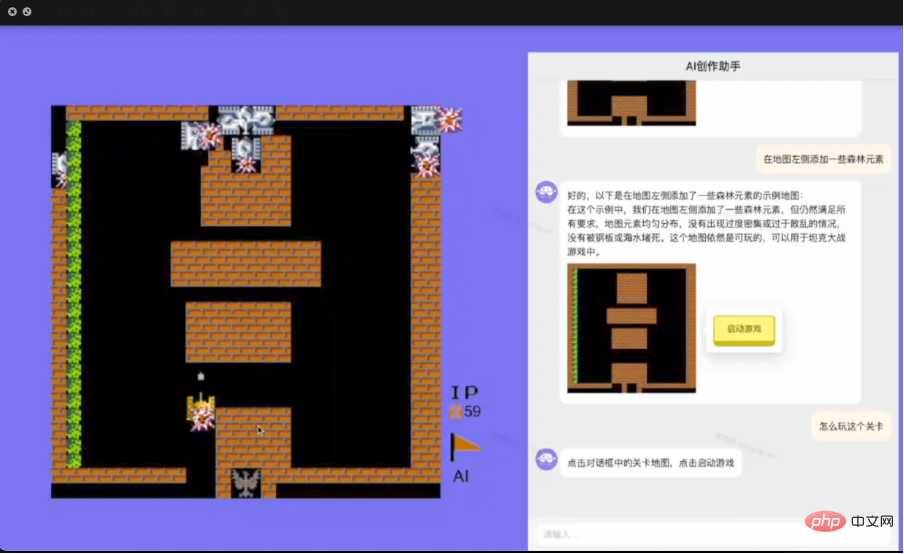

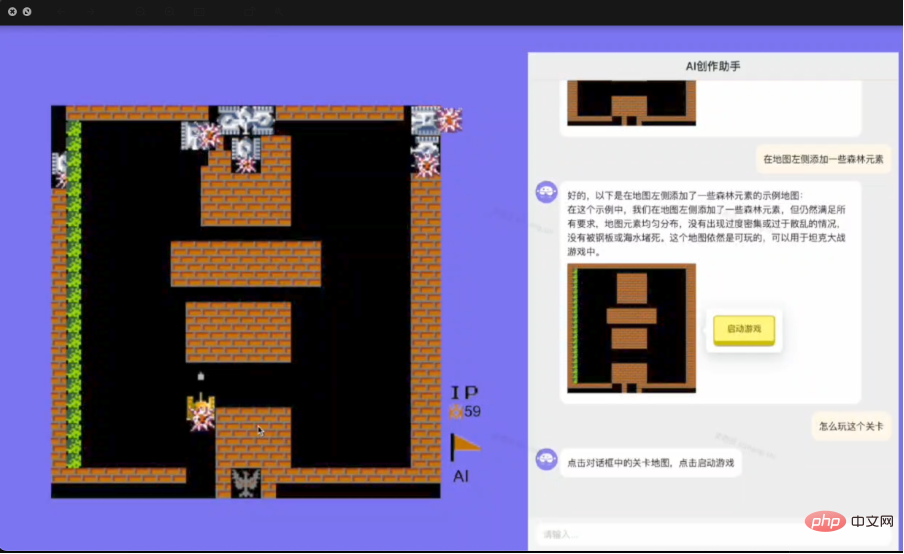

Figure 2 Illustration de la génération de décisions par intelligence artificielle (AIGA) utilisée pour concevoir des jeux informatiques.

2. Affinez vos capacités de raisonnement

Nous sommes à l'aube d'une ère passionnante dans laquelle toutes nos données linguistiques et comportementales peuvent être exploitées à des fins de formation (et assimilées dans d'énormes modèles informatisés). Il s’agit d’une énorme réussite car l’ensemble de notre expérience collective et de notre civilisation peut être digérée dans une base de connaissances (cachée) (sous la forme de réseaux de neurones artificiels) pour une utilisation ultérieure. En fait, ChatGPT et le modèle à grande base sont censés présenter une certaine forme de capacité de raisonnement et peut-être même une certaine compréhension de l’état d’esprit des autres (théorie de l’esprit). Ceci est réalisé grâce à l'ajustement des données (prédictions de jetons de langage masqué comme signaux d'entraînement) et à l'imitation (comportement humain). Cependant, la question de savoir si cette stratégie entièrement basée sur les données conduira à une plus grande intelligence est discutable.

Pour illustrer ce point, prenons l'exemple de demander à un agent (agent) comment jouer aux échecs. Même si l'agent (agent) avait accès à une quantité illimitée de données humaines sur le jeu d'échecs, il serait très difficile de générer une nouvelle stratégie meilleure que les données existantes simplement en imitant la stratégie existante. Cependant, en utilisant ces données, on peut acquérir une compréhension du monde (par exemple, les règles d'un jeu) et l'utiliser pour « penser » (construire un simulateur dans son cerveau pour recueillir des commentaires afin de créer de meilleures stratégies). Cela met en évidence l'importance du biais inductif ; plutôt que d'adopter simplement une approche de force brute, l'agent d'apprentissage (agent) doit avoir un certain modèle du monde afin de s'améliorer.

Par conséquent, il existe un besoin urgent d’étudier et de comprendre en profondeur les capacités émergentes des modèles sous-jacents. En plus des compétences linguistiques, nous préconisons l’acquisition de capacités pratiques de raisonnement grâce à l’étude des mécanismes sous-jacents. Une approche prometteuse consiste à s’inspirer des neurosciences et des sciences du cerveau pour décrypter les mécanismes du raisonnement humain et faire progresser le développement de modèles de langage. Dans le même temps, l’élaboration d’une solide théorie de l’esprit peut également nécessiter une compréhension approfondie de l’apprentissage multi-agents et de ses principes sous-jacents.

3. Du contenu généré par l'IA (AIGC) à l'action générée par l'IA (AIGA)

La sémantique implicite développée par le langage humain est cruciale pour le modèle de langage de base. Comment exploiter cela est un sujet clé de l’apprentissage automatique général. Par exemple, une fois que l’espace sémantique est aligné avec d’autres médias (tels que des photos, des vidéos et des sons) ou d’autres formes de données comportementales humaines et machines (telles que les trajectoires/actions des robots), nous pouvons obtenir des capacités d’interprétation sémantique pour ces derniers sans aucun problème. coût supplémentaire. De cette manière, l’apprentissage automatique (prédiction, génération et prise de décision) devient général et décomposable. Cependant, la gestion de l’alignement multimodal est une difficulté importante à laquelle nous sommes confrontés car l’annotation des relations demande beaucoup de travail. De plus, l’alignement des valeurs humaines devient difficile lorsque de nombreuses parties intéressées sont en conflit.

Un inconvénient fondamental de ChatGPT est qu'il ne peut communiquer que directement avec les humains. Cependant, une fois qu’un alignement suffisant avec le monde extérieur est établi, le modèle linguistique sous-jacent devrait être capable d’apprendre à interagir avec une grande variété d’acteurs et d’environnements. Ceci est important car cela donnera à ses capacités de raisonnement et à sa sémantique basée sur le langage des applications et des capacités plus larges au-delà de la simple conversation. Par exemple, il pourrait être développé en un agent universel (agent) capable de naviguer sur Internet, de contrôler des ordinateurs et de manipuler des robots. Par conséquent, il est encore plus important de mettre en œuvre des procédures garantissant que les réponses des agents (agents) (généralement sous la forme d'actions générées) sont sûres, fiables, impartiales et dignes de confiance.

La figure 2 montre un exemple d'AIGA interagissant avec un moteur de jeu pour automatiser le processus de conception de jeux vidéo.

4. La théorie de l'interaction multi-agents avec des modèles de langage de base

ChatGPT utilise l'apprentissage contextuel et l'ingénierie rapide pour mener plusieurs cycles de conversations avec des personnes en une seule session, c'est-à-dire à partir d'une question ou d'une question. À l'invite, l'intégralité des conversations précédentes (questions et réponses) est envoyée au système comme contexte supplémentaire pour construire la réponse. Il s'agit d'un modèle simple de processus de décision Markov (MDP) basé sur la conversation :

{statut = contexte, action = réponse, récompense = note J'aime/Je n'aime pas}.

Bien qu'efficace, cette stratégie présente les inconvénients suivants : Premièrement, l'invite ne fournit qu'une description de la réponse de l'utilisateur, mais la véritable intention de l'utilisateur peut ne pas être explicitement déclarée et doit être déduite. Peut-être qu'un modèle puissant, tel que le processus de décision de Markov partiellement observable (POMDP) précédemment proposé pour les robots conversationnels, peut modéliser avec précision les intentions cachées des utilisateurs.

Deuxièmement, ChatGPT cible d'abord la génération d'un langage adapté en utilisant l'adaptabilité du langage pour la formation, puis utilise des étiquettes humaines pour la formation/le réglage fin avec des objectifs conversationnels. En raison de la nature ouverte de la plateforme, les buts et objectifs réels des utilisateurs peuvent ne pas correspondre aux récompenses de formation/mise au point. Afin d'examiner les équilibres et les conflits d'intérêts entre les humains et les agents (agents) , il peut être intéressant d'utiliser une perspective de théorie des jeux.

5. Nouvelles applications

Comme l'a démontré ChatGPT, nous pensons que le modèle de langage de base présente deux caractéristiques uniques qui seront la force motrice des futures applications d'apprentissage automatique et de modèle de langage de base. Le premier concerne ses compétences linguistiques supérieures, tandis que le second concerne ses capacités sémantiques et de raisonnement précoces intégrées (sous la forme du langage humain). En tant qu'interface, le premier réduira considérablement la barrière d'entrée pour l'application de l'apprentissage automatique, tandis que le second favorisera considérablement le champ d'application de l'apprentissage automatique.

Comme le montre le nouveau processus d'apprentissage introduit dans la première partie, les invites et l'apprentissage contextuel éliminent le goulot d'étranglement de l'ingénierie des données et les efforts nécessaires pour créer et former des modèles. De plus, tirer parti des capacités de raisonnement nous permet de décomposer et de résoudre automatiquement chaque sous-tâche d’une tâche difficile. Par conséquent, cela modifiera considérablement de nombreuses industries et domaines d’application. Dans les entreprises Internet, les interfaces basées sur la conversation sont des applications évidentes pour la recherche Web et mobile, les systèmes de recommandation et la publicité. Cependant, comme nous sommes habitués aux systèmes de recherche par index inversé d’URL basés sur des mots clés, le changement n’est pas facile. Il faut réapprendre aux gens à utiliser des requêtes plus longues et le langage naturel comme requêtes. De plus, les modèles linguistiques sous-jacents sont souvent rigides et inflexibles. Ils manquent d’informations actuelles sur les événements récents. Ils évoquent souvent des faits et ne fournissent pas de capacités de récupération ni de vérification. Par conséquent, nous avons besoin d’un modèle de base instantané qui puisse évoluer de manière dynamique au fil du temps.

Par conséquent, nous appelons au développement de nouvelles applications, y compris, mais sans s'y limiter, les domaines suivants :

-

Innovation

NouveautéIngénierie de pointe, support de processus et de logiciels. - Recherche Web basée sur des modèles, recommandation et génération d'annonces ; un nouveau modèle économique pour la publicité conversationnelle.

- Technologie pour les services informatiques basés sur la conversation, les systèmes logiciels, les communications sans fil (systèmes de messagerie personnalisés) et les systèmes de service client.

- Générez l'automatisation des processus robotiques (RPA) ainsi que les tests et la validation de logiciels à partir de modèles de langage sous-jacents.

- Programmation assistée par l'IA.

- Un nouvel outil de génération de contenu pour l'industrie créative.

-

Unifie les modèles de langage avec Recherche opérationnelle

Recherche opérationnelle, Intelligence d'entreprise et optimisation. - Un moyen de servir de manière efficace et rentable de grands modèles de base dans le cloud computing.

-

Développer des modèles de base pour l'apprentissage par renforcement, l'apprentissage multi-agents et d'autres intelligence artificielle

prise de décision. - Technologie robotique assistée par le langage.

- Modèles de base et inférence pour l'optimisation combinatoire, Automation de la conception électronique (EDA) et conception de puces.

À propos de l'auteur

Wang Jun, professeur d'informatique à l'University College London (UCL), co-fondateur et doyen du Shanghai Digital Brain Institute, étudie principalement l'intelligence décisionnelle et la recherche à grande échelle liée aux modèles, notamment l'apprentissage automatique, l'apprentissage par renforcement, le multi- agent, exploration de données, publicité informatique, systèmes de recommandation, etc. Il a publié plus de 200 articles universitaires et deux monographies universitaires, remporté plusieurs prix du meilleur article et dirigé l'équipe pour développer le premier modèle de prise de décision multi-agents au monde et le premier modèle de prise de décision multimodal au monde.

Annexe :

Appel à innovation : théories post-ChatGPT de l'intelligence artificielle générale et leurs applications

ChatGPT a récemment attiré l'attention de la communauté des chercheurs, du secteur commercial et du grand public Il s'agit d'un chatbot générique qui peut répondre aux invites ou aux questions ouvertes des utilisateurs. La curiosité est piquée par ses compétences linguistiques supérieures et semblables à celles d'un humain, fournissant des réponses cohérentes, cohérentes et bien structurées. un large éventail de tâches basées sur du texte et du code, y compris la création de romans, la composition de lettres, le gameplay textuel et même la manipulation de robots via la génération de code, grâce à un vaste modèle de langage génératif pré-entraîné. Cela donne au public la foi dans l'apprentissage automatique généraliste et la machine. l'apprentissage et la compréhension sont réalisables très bientôt.

Si l'on creuse plus profondément, on peut découvrir que lorsque le code de programmation est ajouté comme données d'entraînement, certaines capacités de raisonnement, une compréhension de bon sens et même une chaîne de pensée (une série de raisonnements intermédiaires). étapes ) peuvent apparaître comme des capacités émergentes [1] lorsque les modèles atteignent une taille particulière. Bien que la nouvelle découverte soit passionnante et ouvre de nouvelles possibilités pour la recherche et les applications de l'IA, elle soulève cependant plus de questions qu'elle n'en résout. par exemple, servent-ils d'indicateur précoce d'une intelligence supérieure, ou s'agit-il simplement d'une imitation naïve du comportement humain cachée par les données. La poursuite de l'expansion des modèles déjà existants conduirait-elle à la naissance de l'intelligence générale artificielle (AGI), ou ces modèles sont-ils simplement superficiels ? intelligent avec des capacités limitées ? Si elles sont répondues, ces questions pourraient conduire à des changements fondamentaux dans la théorie et les applications de l'intelligence artificielle.

Nous invitons donc non seulement à reproduire les succès de ChatGPT, mais surtout à faire avancer la recherche révolutionnaire et le développement de nouvelles applications dans le domaine. domaines suivants de l'intelligence artificielle (liste non exhaustive) :

1.Nouvelle théorie de l'apprentissage automatique qui va au-delà du paradigme établi de l'apprentissage automatique spécifique à une tâche

Le raisonnement inductif est un type de raisonnement dans lequel nous tirons des conclusions sur le monde sur la base d'observations passées. L'apprentissage automatique peut être vaguement considéré comme un raisonnement inductif dans le sens où il exploite les données passées (de formation) pour améliorer les performances sur de nouvelles tâches, en prenant comme exemple la traduction automatique, un apprentissage automatique typique. Le pipeline implique les quatre étapes principales suivantes :

1.définir le problème spécifique, par exemple traduire des phrases anglaises en chinois : E→C,

2.collecter les données, par exemple des paires de phrases { E→C} ,

3.entraîner un modèle, par exemple un réseau neuronal profond avec des entrées {E} et des sorties {C},

4.appliquer le modèle à un point de données invisible, par exemple saisir une nouvelle phrase en anglais E' et génèrez une traduction chinoise C' et évaluez le résultat.

Comme indiqué ci-dessus, l'apprentissage automatique traditionnel isole la formation pour chaque tâche spécifique. Par conséquent, pour chaque nouvelle tâche, il faut réinitialiser et refaire le processus à partir de l'étape 1. à l'étape 4, perdant toutes les connaissances acquises (données, modèles, etc.) lors des tâches précédentes. Par exemple, vous auriez besoin d'un modèle différent si vous souhaitez traduire le français vers le chinois, plutôt que l'anglais vers le chinois

.Dans ce paradigme, le travail des théoriciens de l'apprentissage automatique se concentre principalement sur la compréhension de la capacité de généralisation d'un modèle d'apprentissage depuis les données d'entraînement jusqu'aux données de test invisibles [2, 3]. Par exemple, une question courante serait de savoir de combien d’échantillons nous avons besoin lors de la formation pour atteindre une certaine marge d’erreur dans la prédiction des données de test invisibles. Nous savons qu'un biais inductif (c'est-à-dire une connaissance préalable ou une hypothèse préalable) est nécessaire pour qu'un modèle d'apprentissage puisse prédire des résultats qu'il n'a pas rencontrés. En effet, la valeur de sortie dans des circonstances inconnues est complètement arbitraire, ce qui rend impossible la résolution du problème sans formuler certaines hypothèses. Le célèbre théorème du « non-déjeuner gratuit » [5] dit en outre que tout biais inductif a une limite ; il ne convient qu'à un certain groupe de problèmes et peut échouer ailleurs si les connaissances préalables supposées sont incorrectes.

Figure 1 Une capture d'écran de ChatGPT utilisé pour la traduction automatique. L'invite contient uniquement des instructions et aucun exemple de démonstration n'est nécessaire.

Bien que les théories ci-dessus soient toujours valables, l'arrivée des modèles de langage de base a peut-être modifié notre approche de l'apprentissage automatique. Le nouveau pipeline d'apprentissage automatique pourrait être le suivant (en utilisant le même problème de traduction automatique comme exemple ; voir Figure 1) :

1.Accès API à un modèle de langage de base formé ailleurs par d'autres, par exemple, un modèle formé avec divers documents, y compris un corpus d'appariement anglais/chinois,

2.avec quelques exemples ou pas d'exemple du tout, concevoir une description textuelle appropriée (appelée invite) pour la tâche à accomplir, par exemple, Invite = {quelques exemples E → C },

3. conditionné à l'invite et à un nouveau point de données de test donné, le modèle de langage génère la réponse, par exemple, ajoutez E' à l'invite et générez C' à partir du modèle,

4.interpréter la réponse comme le résultat prédit.

Comme indiqué à l'étape 1, le modèle de langage de base sert de référentiel de connaissances unique. L'invite (et le contexte) présentés à l'étape 2 permettent de personnaliser le modèle de langage de base en fonction d'un objectif ou d'un problème spécifique avec seulement quelques instances de démonstration. Bien que le pipeline susmentionné soit principalement limité aux problèmes basés sur du texte, il est raisonnable de supposer qu'à mesure que le développement de modèles de base pré-entraînés multimodaux (voir section 3) se poursuit, il deviendra la norme pour l'apprentissage automatique en général. Cela pourrait éliminer les barrières de tâches nécessaires pour ouvrir la voie à l’AGI.

Mais il est encore tôt dans le processus de détermination du fonctionnement des exemples de démonstration dans un texte d'invite. Empiriquement, nous comprenons maintenant, grâce à certains premiers travaux [2], que le format des échantillons de démonstration est plus important que l'exactitude des étiquettes (par exemple, comme l'illustre la figure 1, nous n'avons pas besoin de fournir d'exemple de traduction mais sommes nécessaire pour dispenser un enseignement linguistique), mais existe-t-il des limites théoriques à son adaptabilité, comme l'énonce le théorème du non-déjeuner gratuit ? Le contexte et les connaissances basées sur les instructions énoncées dans les invites (étape 2) peuvent-ils être intégrés dans le modèle pour une utilisation future ? Nous ne faisons qu’effleurer la surface avec ces enquêtes. Nous appelons donc à une nouvelle compréhension et à de nouveaux principes derrière cette nouvelle forme d’apprentissage en contexte et ses limites et propriétés théoriques, telles que les limites de généralisation.

Figure 2 Une illustration d'AIGA pour la conception de jeux informatiques.

2.Développer les capacités de raisonnement

Nous sommes à l'aube d'une ère passionnante dans laquelle toutes nos données linguistiques et comportementales peuvent être exploitées pour former (et être absorbées par) un énorme modèle informatisé. Il s’agit d’un formidable accomplissement puisque l’ensemble de notre expérience collective et de notre civilisation pourrait être digérée dans une base de connaissances unique (cachée) (sous la forme de réseaux de neurones artificiels) pour une utilisation ultérieure. En fait, ChatGPT et les grands modèles de fondation démontreraient une certaine forme de capacité de raisonnement. Ils peuvent même sans doute saisir dans une certaine mesure les états mentaux des autres (théorie de l’esprit) [6]. Ceci est accompli par l'ajustement des données (prédiction des jetons de langage masqués comme signaux d'entraînement) et par l'imitation (des comportements humains). Pourtant, on peut se demander si cette stratégie entièrement basée sur les données nous apportera une plus grande intelligence.

Pour illustrer cette notion, pensez à apprendre à un agent à jouer aux échecs à titre d'exemple. Même si l’agent a accès à une quantité illimitée de données de jeu humain, il lui sera très difficile, en se contentant d’imiter les politiques existantes, de générer de nouvelles politiques plus optimales que celles déjà présentes dans les données. En utilisant les données, on peut cependant développer une compréhension du monde (par exemple, les règles du jeu) et l’utiliser pour « penser » (construire un simulateur dans son cerveau pour recueillir des commentaires afin de créer des politiques plus optimales). Cela met en évidence l’importance du biais inductif ; plutôt que d'une simple force brute, un agent d'apprentissage doit disposer d'un modèle du monde et le déduire à partir des données afin de s'améliorer.

Il existe donc un besoin urgent d’étudier et de comprendre en profondeur les capacités émergentes des modèles de fondation. Outre les compétences linguistiques, nous préconisons des recherches sur l'acquisition d'une réelle capacité de raisonnement en étudiant les mécanismes sous-jacents [9]. Une approche prometteuse consisterait à s’inspirer des neurosciences et des sciences du cerveau pour déchiffrer les mécanismes du raisonnement humain et faire progresser le développement de modèles de langage. Dans le même temps, la construction d’une solide théorie de l’esprit peut également nécessiter une connaissance approfondie de l’apprentissage multiagent [10, 11] et de ses principes sous-jacents.

3.De l'IA Generating Content (AIGC) à l'IA Generating Action (AIGA)

La sémantique implicite développée au-dessus des langages humains fait partie intégrante des modèles de langage de base. Comment l’utiliser est un sujet crucial pour l’apprentissage automatique généraliste. Par exemple, une fois que l’espace sémantique est aligné avec d’autres médias (tels que des photos, des vidéos et des sons) ou d’autres formes de données issues des comportements humains et machines, tels que les trajectoires/actions robotiques, nous acquérons un pouvoir d’interprétation sémantique pour ces derniers sans aucun besoin supplémentaire. coût [7, 14]. De cette manière, l’apprentissage automatique (prédiction, génération et prise de décision) serait générique et décomposable. Pourtant, gérer l’alignement entre les modalités constitue pour nous un obstacle de taille en raison de la nature laborieuse de l’étiquetage des relations. De plus, l’alignement des valeurs humaines devient difficile lorsque de nombreuses parties ont des intérêts contradictoires.

Un inconvénient fondamental de ChatGPT est qu'il ne peut communiquer directement qu'avec des humains. Pourtant, une fois qu'un alignement suffisant avec le monde extérieur a été établi, les modèles de langage de base devraient être capables d'apprendre à interagir avec diverses parties et environnements [7, 14]. Ceci est important car cela confèrera son pouvoir à la capacité de raisonnement et à la sémantique basée sur le langage pour des applications et des capacités plus larges au-delà de la conversation. Par exemple, il pourrait évoluer vers un agent généraliste capable de naviguer sur Internet [7], de contrôler des ordinateurs [13] et de manipuler des robots [12]. Il devient donc plus important de mettre en œuvre des procédures garantissant que les réponses de l’agent (souvent sous la forme d’actions générées) sont sécurisées, fiables, impartiales et dignes de confiance.

La figure 2 fournit une démonstration d'AIGA [7] pour interagir avec un moteur de jeu afin d'automatiser le processus de conception d'un jeu vidéo.

4.Théories multiagents des interactions avec les modèles de langage de base

ChatGPT utilise l'apprentissage en contexte et l'ingénierie des invites pour conduire un dialogue à plusieurs tours avec les personnes en une seule session, c'est-à-dire qu'en fonction de la question ou de l'invite, l'intégralité de la conversation précédente (questions et réponses) est envoyée au système comme contexte supplémentaire pour construire la réponse. Il s'agit d'un modèle simple de processus de décision markovien (MDP) pour la conversation :

{État = contexte, action = réponse, récompense = note positive/clinique}.

Bien qu'efficace, cette stratégie présente les inconvénients suivants : premièrement, une invite fournit simplement une description de la réponse de l'utilisateur, mais l'intention réelle de l'utilisateur peut ne pas être explicitement déclarée et doit être déduite. Peut-être qu'un modèle robuste, comme proposé précédemment pour les robots de conversation, serait un processus de décision de Markov partiellement observable (POMDP) qui modélise avec précision une intention cachée de l'utilisateur.

Deuxièmement, ChatGPT est d'abord formé à l'aide de l'aptitude linguistique, puis d'étiquettes humaines pour les objectifs de conversation. En raison de la nature ouverte de la plate-forme, le but et l'objectif réels de l'utilisateur peuvent ne pas correspondre aux récompenses formées/affinées. Afin d’examiner l’équilibre et les intérêts conflictuels des humains et des agents, il peut être intéressant d’utiliser une perspective de théorie des jeux [9].

5.Nouvelles applications

Comme le prouve ChatGPT, il existe deux caractéristiques distinctives des modèles de langage de base qui, selon nous, seront la force motrice des futures applications d'apprentissage automatique et de modèles de langage de base. Le premier réside dans ses compétences linguistiques supérieures, tandis que le second réside dans sa sémantique intégrée et ses capacités de raisonnement précoces (sous la forme du langage humain). En tant qu’interface, la première réduira considérablement la barrière d’entrée à l’apprentissage automatique appliqué, tandis que la seconde généralisera considérablement la manière dont l’apprentissage automatique est appliqué.

Comme le démontre le nouveau pipeline d'apprentissage présenté dans la section 1, les invites et l'apprentissage en contexte éliminent le goulot d'étranglement de l'ingénierie des données et les efforts nécessaires pour construire et former un modèle. De plus, l’exploitation des capacités de raisonnement pourrait nous permettre de disséquer et de résoudre automatiquement chaque sous-tâche d’une tâche difficile. Par conséquent, cela transformera radicalement de nombreuses industries et secteurs d’application. Dans les entreprises basées sur Internet, l'interface basée sur le dialogue est une application évidente pour la recherche Web et mobile, les systèmes de recommandation et la publicité. Cependant, comme nous sommes habitués au système de recherche par index inversé d’URL basé sur des mots clés, le changement n’est pas simple. Il faut réapprendre aux gens à utiliser des requêtes plus longues et le langage naturel comme requêtes. De plus, les modèles de langage de base sont généralement rigides et inflexibles. Il n’a pas accès aux informations actuelles sur les événements récents. Ils hallucinent généralement les faits et ne fournissent pas de capacités de récupération ni de vérification. Nous avons donc besoin d’un modèle de fondation juste à temps, capable de subir une évolution dynamique au fil du temps.

Nous appelons donc à de nouvelles candidatures, y compris, mais sans s'y limiter, les domaines suivants :

- Nouvelle ingénierie d'invite, sa procédure et son support logiciel.

- Recherche, recommandation et publicité Web génératives et basées sur des modèles ; nouveaux modèles commerciaux pour la publicité conversationnelle.

- Techniques pour les services informatiques basés sur le dialogue, les systèmes logiciels, les communications sans fil (systèmes de messagerie personnalisés) et les systèmes de service client.

- Génération d'automatisation à partir de modèles de langage de base pour l'automatisation des processus robotiques (RPA ) et test et vérification de logiciels. des méthodes rentables pour servir de grands modèles de base dans le cloud computing.

- Modèles de base pour l'apprentissage par renforcement et l'apprentissage multiagent et d'autres domaines de prise de décision.

- Robotique assistée par le langage.

- Modèles de base et raisonnement pour l'optimisation combinatoire, l'EDA et la conception de puces.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

ChatGPT permet désormais aux utilisateurs gratuits de générer des images en utilisant DALL-E 3 avec une limite quotidienne

Aug 09, 2024 pm 09:37 PM

ChatGPT permet désormais aux utilisateurs gratuits de générer des images en utilisant DALL-E 3 avec une limite quotidienne

Aug 09, 2024 pm 09:37 PM

Le DALL-E 3 a été officiellement introduit en septembre 2023 en tant que modèle considérablement amélioré par rapport à son prédécesseur. Il est considéré comme l’un des meilleurs générateurs d’images IA à ce jour, capable de créer des images avec des détails complexes. Cependant, au lancement, c'était exclu

Bytedance Cutting lance le super abonnement SVIP : 499 yuans pour un abonnement annuel continu, offrant une variété de fonctions d'IA

Jun 28, 2024 am 03:51 AM

Bytedance Cutting lance le super abonnement SVIP : 499 yuans pour un abonnement annuel continu, offrant une variété de fonctions d'IA

Jun 28, 2024 am 03:51 AM

Ce site a rapporté le 27 juin que Jianying est un logiciel de montage vidéo développé par FaceMeng Technology, une filiale de ByteDance. Il s'appuie sur la plateforme Douyin et produit essentiellement du contenu vidéo court pour les utilisateurs de la plateforme. Il est compatible avec iOS, Android et. Windows, MacOS et autres systèmes d'exploitation. Jianying a officiellement annoncé la mise à niveau de son système d'adhésion et a lancé un nouveau SVIP, qui comprend une variété de technologies noires d'IA, telles que la traduction intelligente, la mise en évidence intelligente, l'emballage intelligent, la synthèse humaine numérique, etc. En termes de prix, les frais mensuels pour le clipping SVIP sont de 79 yuans, les frais annuels sont de 599 yuans (attention sur ce site : équivalent à 49,9 yuans par mois), l'abonnement mensuel continu est de 59 yuans par mois et l'abonnement annuel continu est de 59 yuans par mois. est de 499 yuans par an (équivalent à 41,6 yuans par mois) . En outre, le responsable de Cut a également déclaré que afin d'améliorer l'expérience utilisateur, ceux qui se sont abonnés au VIP d'origine

Assistant de codage d'IA augmenté par le contexte utilisant Rag et Sem-Rag

Jun 10, 2024 am 11:08 AM

Assistant de codage d'IA augmenté par le contexte utilisant Rag et Sem-Rag

Jun 10, 2024 am 11:08 AM

Améliorez la productivité, l’efficacité et la précision des développeurs en intégrant une génération et une mémoire sémantique améliorées par la récupération dans les assistants de codage IA. Traduit de EnhancingAICodingAssistantswithContextUsingRAGandSEM-RAG, auteur JanakiramMSV. Bien que les assistants de programmation d'IA de base soient naturellement utiles, ils ne parviennent souvent pas à fournir les suggestions de code les plus pertinentes et les plus correctes, car ils s'appuient sur une compréhension générale du langage logiciel et des modèles d'écriture de logiciels les plus courants. Le code généré par ces assistants de codage est adapté à la résolution des problèmes qu’ils sont chargés de résoudre, mais n’est souvent pas conforme aux normes, conventions et styles de codage des équipes individuelles. Cela aboutit souvent à des suggestions qui doivent être modifiées ou affinées pour que le code soit accepté dans l'application.

Le réglage fin peut-il vraiment permettre au LLM d'apprendre de nouvelles choses : l'introduction de nouvelles connaissances peut amener le modèle à produire davantage d'hallucinations

Jun 11, 2024 pm 03:57 PM

Le réglage fin peut-il vraiment permettre au LLM d'apprendre de nouvelles choses : l'introduction de nouvelles connaissances peut amener le modèle à produire davantage d'hallucinations

Jun 11, 2024 pm 03:57 PM

Les grands modèles linguistiques (LLM) sont formés sur d'énormes bases de données textuelles, où ils acquièrent de grandes quantités de connaissances du monde réel. Ces connaissances sont intégrées à leurs paramètres et peuvent ensuite être utilisées en cas de besoin. La connaissance de ces modèles est « réifiée » en fin de formation. À la fin de la pré-formation, le modèle arrête effectivement d’apprendre. Alignez ou affinez le modèle pour apprendre à exploiter ces connaissances et répondre plus naturellement aux questions des utilisateurs. Mais parfois, la connaissance du modèle ne suffit pas, et bien que le modèle puisse accéder à du contenu externe via RAG, il est considéré comme bénéfique de l'adapter à de nouveaux domaines grâce à un réglage fin. Ce réglage fin est effectué à l'aide de la contribution d'annotateurs humains ou d'autres créations LLM, où le modèle rencontre des connaissances supplémentaires du monde réel et les intègre.

Afin de fournir un nouveau système de référence et d'évaluation de questions-réponses scientifiques et complexes pour les grands modèles, l'UNSW, Argonne, l'Université de Chicago et d'autres institutions ont lancé conjointement le cadre SciQAG.

Jul 25, 2024 am 06:42 AM

Afin de fournir un nouveau système de référence et d'évaluation de questions-réponses scientifiques et complexes pour les grands modèles, l'UNSW, Argonne, l'Université de Chicago et d'autres institutions ont lancé conjointement le cadre SciQAG.

Jul 25, 2024 am 06:42 AM

L'ensemble de données ScienceAI Question Answering (QA) joue un rôle essentiel dans la promotion de la recherche sur le traitement du langage naturel (NLP). Des ensembles de données d'assurance qualité de haute qualité peuvent non seulement être utilisés pour affiner les modèles, mais également évaluer efficacement les capacités des grands modèles linguistiques (LLM), en particulier la capacité à comprendre et à raisonner sur les connaissances scientifiques. Bien qu’il existe actuellement de nombreux ensembles de données scientifiques d’assurance qualité couvrant la médecine, la chimie, la biologie et d’autres domaines, ces ensembles de données présentent encore certaines lacunes. Premièrement, le formulaire de données est relativement simple, et la plupart sont des questions à choix multiples. Elles sont faciles à évaluer, mais limitent la plage de sélection des réponses du modèle et ne peuvent pas tester pleinement la capacité du modèle à répondre aux questions scientifiques. En revanche, les questions et réponses ouvertes

Les performances de SOTA, la méthode d'IA de prédiction d'affinité protéine-ligand multimodale de Xiamen, combinent pour la première fois des informations sur la surface moléculaire

Jul 17, 2024 pm 06:37 PM

Les performances de SOTA, la méthode d'IA de prédiction d'affinité protéine-ligand multimodale de Xiamen, combinent pour la première fois des informations sur la surface moléculaire

Jul 17, 2024 pm 06:37 PM

Editeur | KX Dans le domaine de la recherche et du développement de médicaments, il est crucial de prédire avec précision et efficacité l'affinité de liaison des protéines et des ligands pour le criblage et l'optimisation des médicaments. Cependant, les études actuelles ne prennent pas en compte le rôle important des informations sur la surface moléculaire dans les interactions protéine-ligand. Sur cette base, des chercheurs de l'Université de Xiamen ont proposé un nouveau cadre d'extraction de caractéristiques multimodales (MFE), qui combine pour la première fois des informations sur la surface des protéines, la structure et la séquence 3D, et utilise un mécanisme d'attention croisée pour comparer différentes modalités. alignement. Les résultats expérimentaux démontrent que cette méthode atteint des performances de pointe dans la prédiction des affinités de liaison protéine-ligand. De plus, les études d’ablation démontrent l’efficacité et la nécessité des informations sur la surface des protéines et de l’alignement des caractéristiques multimodales dans ce cadre. Les recherches connexes commencent par "S

Préparant des marchés tels que l'IA, GlobalFoundries acquiert la technologie du nitrure de gallium de Tagore Technology et les équipes associées

Jul 15, 2024 pm 12:21 PM

Préparant des marchés tels que l'IA, GlobalFoundries acquiert la technologie du nitrure de gallium de Tagore Technology et les équipes associées

Jul 15, 2024 pm 12:21 PM

Selon les informations de ce site Web du 5 juillet, GlobalFoundries a publié un communiqué de presse le 1er juillet de cette année, annonçant l'acquisition de la technologie de nitrure de gallium (GaN) et du portefeuille de propriété intellectuelle de Tagore Technology, dans l'espoir d'élargir sa part de marché dans l'automobile et Internet. des objets et des domaines d'application des centres de données d'intelligence artificielle pour explorer une efficacité plus élevée et de meilleures performances. Alors que des technologies telles que l’intelligence artificielle générative (GenerativeAI) continuent de se développer dans le monde numérique, le nitrure de gallium (GaN) est devenu une solution clé pour une gestion durable et efficace de l’énergie, notamment dans les centres de données. Ce site Web citait l'annonce officielle selon laquelle, lors de cette acquisition, l'équipe d'ingénierie de Tagore Technology rejoindrait GF pour développer davantage la technologie du nitrure de gallium. g

SK Hynix présentera de nouveaux produits liés à l'IA le 6 août : HBM3E à 12 couches, NAND à 321 hauteurs, etc.

Aug 01, 2024 pm 09:40 PM

SK Hynix présentera de nouveaux produits liés à l'IA le 6 août : HBM3E à 12 couches, NAND à 321 hauteurs, etc.

Aug 01, 2024 pm 09:40 PM

Selon les informations de ce site le 1er août, SK Hynix a publié un article de blog aujourd'hui (1er août), annonçant sa participation au Global Semiconductor Memory Summit FMS2024 qui se tiendra à Santa Clara, Californie, États-Unis, du 6 au 8 août, présentant de nombreuses nouvelles technologies de produit. Introduction au Future Memory and Storage Summit (FutureMemoryandStorage), anciennement Flash Memory Summit (FlashMemorySummit) principalement destiné aux fournisseurs de NAND, dans le contexte de l'attention croissante portée à la technologie de l'intelligence artificielle, cette année a été rebaptisée Future Memory and Storage Summit (FutureMemoryandStorage) pour invitez les fournisseurs de DRAM et de stockage et bien d’autres joueurs. Nouveau produit SK hynix lancé l'année dernière