Périphériques technologiques

Périphériques technologiques

IA

IA

La plus grande puce IA au monde bat le record de formation de grands modèles sur un seul appareil, Cerebras veut « tuer » les GPU

La plus grande puce IA au monde bat le record de formation de grands modèles sur un seul appareil, Cerebras veut « tuer » les GPU

La plus grande puce IA au monde bat le record de formation de grands modèles sur un seul appareil, Cerebras veut « tuer » les GPU

Cet article est reproduit à partir de Lei Feng.com Si vous avez besoin de réimprimer, veuillez vous rendre sur le site officiel de Lei Feng.com pour demander une autorisation.

Cerebras, une société célèbre pour avoir créé le plus grand moteur à puce accélératrice CS-2 Wafer Scale Engine au monde, a annoncé hier avoir franchi une étape importante dans l'utilisation de « cœurs géants » pour la formation à l'intelligence artificielle. La société a formé le plus grand modèle d’IA PNL (traitement du langage naturel) au monde sur une seule puce.

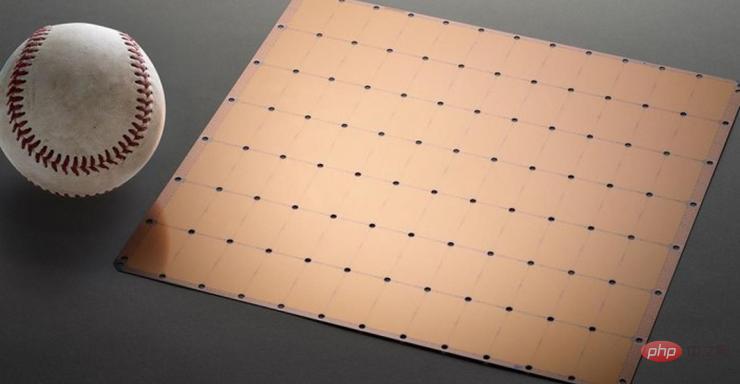

Le modèle possède 2 milliards de paramètres et est entraîné sur la puce CS-2. La plus grande puce accélératrice au monde utilise un processus de 7 nm et est gravée à partir d'une plaquette carrée. Il est des centaines de fois plus gros que les puces traditionnelles et a une puissance de 15 kW. Il intègre 2,6 billions de transistors 7 nm, contient 850 000 cœurs et 40 Go de mémoire.

Figure 1 Puce CS-2 Wafer Scale Engine

Nouveau record pour la formation sur puce unique de grands modèles d'IA

Le développement de modèles NLP est un domaine important de l'intelligence artificielle. Grâce aux modèles NLP, l’intelligence artificielle peut « comprendre » le sens du texte et prendre les mesures correspondantes. Le modèle DALL.E d'OpenAI est un modèle PNL typique. Ce modèle peut convertir les informations textuelles saisies par les utilisateurs en sortie d'image.

Par exemple, lorsque l'utilisateur saisit « fauteuil en forme d'avocat », l'IA générera automatiquement plusieurs images correspondant à cette phrase.

Image : L'image du "fauteuil en forme d'avocat" générée par l'IA après avoir reçu des informations

De plus, ce modèle peut également permettre à l'IA de comprendre des connaissances complexes telles que les espèces, la géométrie, les époques historiques, etc.

Mais il n'est pas facile de réaliser tout cela. Le développement traditionnel de modèles NLP présente des coûts de puissance de calcul et des seuils techniques extrêmement élevés.

En fait, si l'on ne parle que de chiffres, les 2 milliards de paramètres du modèle développé par Cerebras semblent un peu médiocres par rapport à ses pairs.

Le modèle DALL.E mentionné précédemment comporte 12 milliards de paramètres, et le plus grand modèle actuellement est Gopher, lancé par DeepMind à la fin de l'année dernière, avec 280 milliards de paramètres.

Mais au-delà des chiffres ahurissants, la PNL développée par Cerebras présente une énorme avancée : elle réduit la difficulté de développer des modèles de PNL.

Comment « Giant Core » bat-il le GPU ?

Selon le processus traditionnel, le développement de modèles NLP nécessite que les développeurs divisent d'énormes modèles NLP en plusieurs parties fonctionnelles et répartissent leur charge de travail sur des centaines ou des milliers d'unités de traitement graphique.

Des milliers d'unités de traitement graphique représentent des coûts énormes pour les fabricants.

Les difficultés techniques rendent également les constructeurs malheureux.

Le découpage des modèles est un problème personnalisé, les spécifications de chaque réseau neuronal, de chaque GPU et du réseau qui les connecte (ou les interconnecte) ensemble sont uniques et ne sont pas portables entre les systèmes.

Les fabricants doivent clairement prendre en compte tous ces facteurs avant la première formation.

Ce travail est extrêmement complexe et prend parfois plusieurs mois.

Cerebras a déclaré qu'il s'agissait de « l'un des aspects les plus douloureux » de la formation des modèles PNL. Seule une poignée d’entreprises disposent des ressources et de l’expertise nécessaires pour développer la PNL. Pour les autres entreprises du secteur de l'IA, la formation PNL est trop coûteuse, prend beaucoup de temps et n'est pas disponible.

Mais si une seule puce peut prendre en charge un modèle avec 2 milliards de paramètres, cela signifie qu'il n'est pas nécessaire d'utiliser des GPU massifs pour répartir la charge de travail de formation du modèle. Cela peut permettre aux fabricants d'économiser des milliers de coûts de formation GPU et d'exigences matérielles et de mise à l'échelle associées. Cela évite également aux fournisseurs d’avoir à découper les modèles et à répartir leurs charges de travail sur des milliers de GPU.

Cerebras n'est pas seulement obsédé par les chiffres. Pour évaluer la qualité d'un modèle, le nombre de paramètres n'est pas le seul critère.

Plutôt que d'espérer "l'effort" du modèle né sur le "noyau géant", Cerebras espère que le modèle sera "intelligent".

La raison pour laquelle Cerebras peut atteindre une croissance explosive du nombre de paramètres est qu'il utilise la technologie du flux pondéré. Cette technologie dissocie les empreintes informatiques et mémoire et permet d'étendre la mémoire pour qu'elle soit suffisamment grande pour stocker un nombre quelconque de paramètres qui augmentent les charges de travail de l'IA.

Grâce à cette avancée, le temps de mise en place d'un modèle a été réduit de quelques mois à quelques minutes. Et les développeurs peuvent basculer entre des modèles tels que GPT-J et GPT-Neo en « quelques touches seulement ». Cela facilite le développement du PNL.

Cela a entraîné de nouveaux changements dans le domaine de la PNL.

Comme Dan Olds, directeur de recherche d'Intersect360 Research, a commenté les réalisations de Cerebras : « La capacité de Cerebras à proposer de grands modèles de langage au grand public de manière rentable et accessible ouvre une nouvelle ère passionnante de l'intelligence artificielle. »

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Quelle méthode est utilisée pour convertir les chaînes en objets dans vue.js?

Apr 07, 2025 pm 09:39 PM

Quelle méthode est utilisée pour convertir les chaînes en objets dans vue.js?

Apr 07, 2025 pm 09:39 PM

Lors de la conversion des chaînes en objets dans vue.js, JSON.Parse () est préféré pour les chaînes JSON standard. Pour les chaînes JSON non standard, la chaîne peut être traitée en utilisant des expressions régulières et réduisez les méthodes en fonction du format ou du codé décodé par URL. Sélectionnez la méthode appropriée en fonction du format de chaîne et faites attention aux problèmes de sécurité et d'encodage pour éviter les bogues.

Les ingénieurs de backend senior à distance (plates-formes) ont besoin de cercles

Apr 08, 2025 pm 12:27 PM

Les ingénieurs de backend senior à distance (plates-formes) ont besoin de cercles

Apr 08, 2025 pm 12:27 PM

Ingénieur backend à distance Emploi Vacant Société: Emplacement du cercle: Bureau à distance Type d'emploi: Salaire à temps plein: 130 000 $ - 140 000 $ Description du poste Participez à la recherche et au développement des applications mobiles Circle et des fonctionnalités publiques liées à l'API couvrant l'intégralité du cycle de vie de développement logiciel. Les principales responsabilités complètent indépendamment les travaux de développement basés sur RubyOnRails et collaborent avec l'équipe frontale React / Redux / Relay. Créez les fonctionnalités de base et les améliorations des applications Web et travaillez en étroite collaboration avec les concepteurs et le leadership tout au long du processus de conception fonctionnelle. Promouvoir les processus de développement positifs et hiérarchiser la vitesse d'itération. Nécessite plus de 6 ans de backend d'applications Web complexe

Vue.js Comment convertir un tableau de type de chaîne en un tableau d'objets?

Apr 07, 2025 pm 09:36 PM

Vue.js Comment convertir un tableau de type de chaîne en un tableau d'objets?

Apr 07, 2025 pm 09:36 PM

Résumé: Il existe les méthodes suivantes pour convertir les tableaux de chaîne Vue.js en tableaux d'objets: Méthode de base: utilisez la fonction de carte pour convenir à des données formatées régulières. Gameplay avancé: l'utilisation d'expressions régulières peut gérer des formats complexes, mais ils doivent être soigneusement écrits et considérés. Optimisation des performances: Considérant la grande quantité de données, des opérations asynchrones ou des bibliothèques efficaces de traitement des données peuvent être utilisées. MEILLEUR PRATIQUE: Effacer le style de code, utilisez des noms de variables significatifs et des commentaires pour garder le code concis.

Comment utiliser MySQL après l'installation

Apr 08, 2025 am 11:48 AM

Comment utiliser MySQL après l'installation

Apr 08, 2025 am 11:48 AM

L'article présente le fonctionnement de la base de données MySQL. Tout d'abord, vous devez installer un client MySQL, tel que MySQLWorkBench ou le client de ligne de commande. 1. Utilisez la commande MySQL-UROot-P pour vous connecter au serveur et connecter avec le mot de passe du compte racine; 2. Utilisez Createdatabase pour créer une base de données et utilisez Sélectionner une base de données; 3. Utilisez CreateTable pour créer une table, définissez des champs et des types de données; 4. Utilisez InsertInto pour insérer des données, remettre en question les données, mettre à jour les données par mise à jour et supprimer les données par Supprimer. Ce n'est qu'en maîtrisant ces étapes, en apprenant à faire face à des problèmes courants et à l'optimisation des performances de la base de données que vous pouvez utiliser efficacement MySQL.

Géospatial de Laravel: optimisation des cartes interactives et de grandes quantités de données

Apr 08, 2025 pm 12:24 PM

Géospatial de Laravel: optimisation des cartes interactives et de grandes quantités de données

Apr 08, 2025 pm 12:24 PM

Traiter efficacement 7 millions d'enregistrements et créer des cartes interactives avec la technologie géospatiale. Cet article explore comment traiter efficacement plus de 7 millions d'enregistrements en utilisant Laravel et MySQL et les convertir en visualisations de cartes interactives. Exigences initiales du projet de défi: extraire des informations précieuses en utilisant 7 millions d'enregistrements dans la base de données MySQL. Beaucoup de gens considèrent d'abord les langages de programmation, mais ignorent la base de données elle-même: peut-il répondre aux besoins? La migration des données ou l'ajustement structurel est-il requis? MySQL peut-il résister à une charge de données aussi importante? Analyse préliminaire: les filtres et les propriétés clés doivent être identifiés. Après analyse, il a été constaté que seuls quelques attributs étaient liés à la solution. Nous avons vérifié la faisabilité du filtre et établi certaines restrictions pour optimiser la recherche. Recherche de cartes basée sur la ville

Comment résoudre MySQL ne peut pas être démarré

Apr 08, 2025 pm 02:21 PM

Comment résoudre MySQL ne peut pas être démarré

Apr 08, 2025 pm 02:21 PM

Il existe de nombreuses raisons pour lesquelles la startup MySQL échoue, et elle peut être diagnostiquée en vérifiant le journal des erreurs. Les causes courantes incluent les conflits de port (vérifier l'occupation du port et la configuration de modification), les problèmes d'autorisation (vérifier le service exécutant les autorisations des utilisateurs), les erreurs de fichier de configuration (vérifier les paramètres des paramètres), la corruption du répertoire de données (restaurer les données ou reconstruire l'espace de la table), les problèmes d'espace de la table InNODB (vérifier les fichiers IBDATA1), la défaillance du chargement du plug-in (vérification du journal des erreurs). Lors de la résolution de problèmes, vous devez les analyser en fonction du journal d'erreur, trouver la cause profonde du problème et développer l'habitude de sauvegarder régulièrement les données pour prévenir et résoudre des problèmes.

Comment optimiser les performances de la base de données après l'installation de MySQL

Apr 08, 2025 am 11:36 AM

Comment optimiser les performances de la base de données après l'installation de MySQL

Apr 08, 2025 am 11:36 AM

L'optimisation des performances MySQL doit commencer à partir de trois aspects: configuration d'installation, indexation et optimisation des requêtes, surveillance et réglage. 1. Après l'installation, vous devez ajuster le fichier my.cnf en fonction de la configuration du serveur, tel que le paramètre innodb_buffer_pool_size, et fermer query_cache_size; 2. Créez un index approprié pour éviter les index excessifs et optimiser les instructions de requête, telles que l'utilisation de la commande Explication pour analyser le plan d'exécution; 3. Utilisez le propre outil de surveillance de MySQL (ShowProcessList, Showstatus) pour surveiller la santé de la base de données, et sauvegarde régulièrement et organisez la base de données. Ce n'est qu'en optimisant en continu ces étapes que les performances de la base de données MySQL peuvent être améliorées.

Vue et Element-UI Cascade déroulante Boîte en V Mode en V

Apr 07, 2025 pm 08:06 PM

Vue et Element-UI Cascade déroulante Boîte en V Mode en V

Apr 07, 2025 pm 08:06 PM

Vue et Element-UI Boîtes déroulantes en cascade Points de fosse de liaison V-model: V-model lie un tableau représentant les valeurs sélectionnées à chaque niveau de la boîte de sélection en cascade, pas une chaîne; La valeur initiale de SelectOptions doit être un tableau vide, non nul ou non défini; Le chargement dynamique des données nécessite l'utilisation de compétences de programmation asynchrones pour gérer les mises à jour des données en asynchrone; Pour les énormes ensembles de données, les techniques d'optimisation des performances telles que le défilement virtuel et le chargement paresseux doivent être prises en compte.