Périphériques technologiques

Périphériques technologiques

IA

IA

Le PDG de Runway révèle que les employés d'OpenAI pensent que GPT-5 a le potentiel de devenir une intelligence artificielle générale

Le PDG de Runway révèle que les employés d'OpenAI pensent que GPT-5 a le potentiel de devenir une intelligence artificielle générale

Le PDG de Runway révèle que les employés d'OpenAI pensent que GPT-5 a le potentiel de devenir une intelligence artificielle générale

Récemment, certains internautes ont découvert des révélations sur GPT-5.

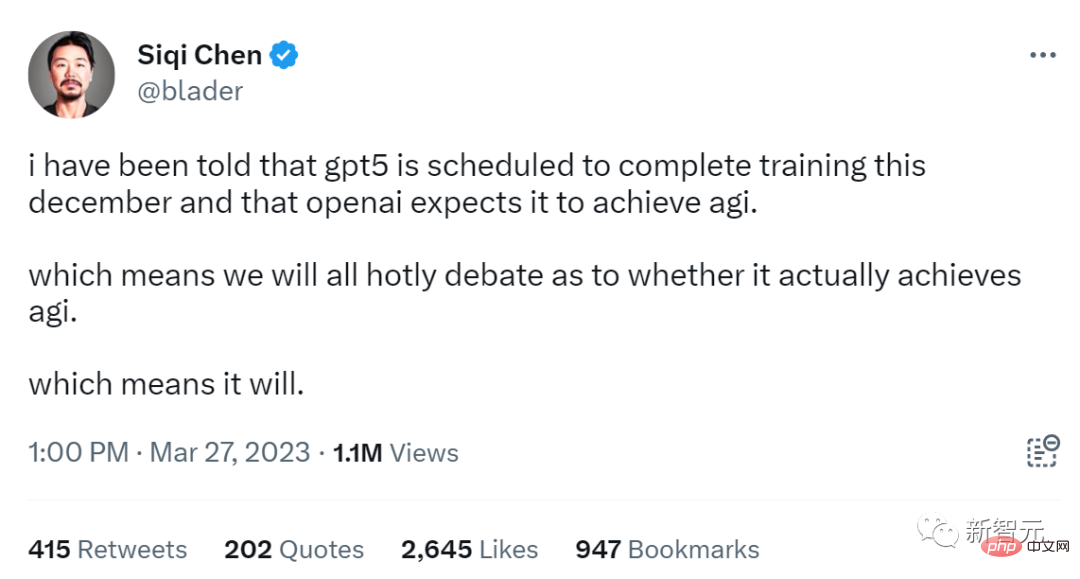

Selon Siqi Chen, PDG et investisseur en IA de la startup Runway financée par a16z, GPT-4 devrait être remplacé par la nouvelle version GPT-5 d'ici la fin de 2023.

On m'a dit que GPT-5 devrait terminer sa formation en décembre cette année, et OpenAI s'attend à ce qu'il implémente l'AGI. Peut-il implémenter l’AGI ? Nul doute qu’il y aura un débat animé.

Ce sera le cas.

De plus, Siqi Chen a également révélé que certains employés d'OpenAI espèrent que GPT-5 pourra être aligné sur les capacités humaines.

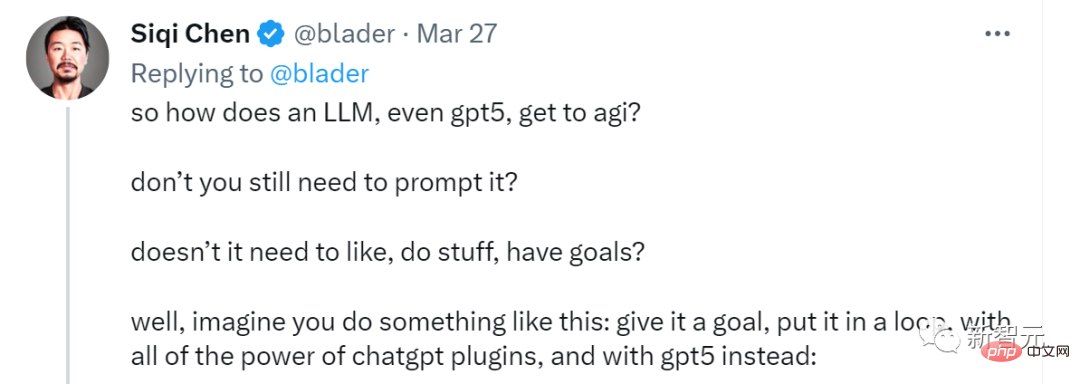

Lors d'un débat avec des internautes, Siqi Chen a déclaré qu'atteindre le GPT-5 d'AGI ne nécessiterait peut-être plus d'invite. Il a dit que GPT-5 est beaucoup plus proche de l’AGI qu’on ne le pense.

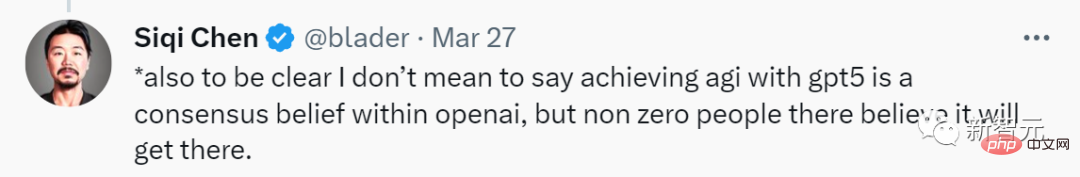

De plus, il a souligné : Je ne dis pas que ce sera obtenu avec GPT-5 AGI est le consensus de tout le monde au sein d’OpenAI, mais il y a effectivement des gens dans OpenAI qui le pensent.

Les internautes ont explosé

Siqi Chen's Ce tweet a fait beaucoup de bruit après sa fouille.

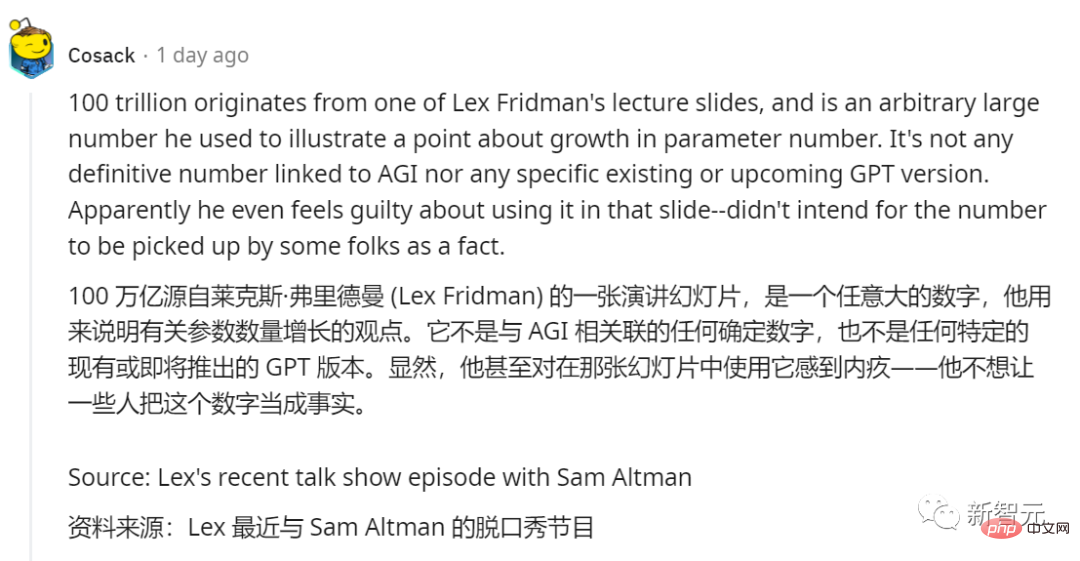

Quelqu'un a réfuté la rumeur selon laquelle "les paramètres GPT-4 ont 100 billions" Cette déclaration.

Cet internaute a expliqué que le nombre 100 000 milliards provenait d'une diapositive de conférence du scientifique du MIT et animateur de podcast Lex Fridman.

Il s'agit d'un nombre arbitrairement grand, utilisé par lui pour illustrer son propos sur l'augmentation du nombre de paramètres, et n'a rien à voir avec l'AGI ou le GPT. Il ne s'agit pas d'un numéro défini associé à AGI, ni d'une version GPT spécifique existante ou à venir. Apparemment, il s'est même senti coupable de l'avoir utilisé dans cette diapositive - il ne voulait pas que certaines personnes prennent ce chiffre pour un fait.

Certains internautes ont déclaré qu'ils étaient en mode moyen depuis décembre de l'année dernière. Après en voyant cette prédiction, il semble maintenant que ce soit un boomerang.

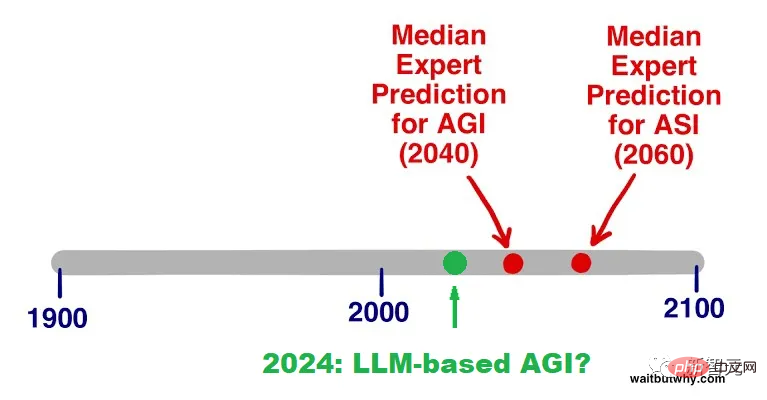

Cet article sur médium a été publié le 26 décembre 2022 L'auteur est un doctorat en physique nommé Paul Pallaghy.

Cet article sur médium a été publié le 26 décembre 2022 L'auteur est un doctorat en physique nommé Paul Pallaghy.

Environ un mois après l'apparition de ChatGPT, il a fait une prédiction : maintenant la partie la plus difficile de l'IA est terminée, et vers 2024, il y aura un prototype de LLM AGI.

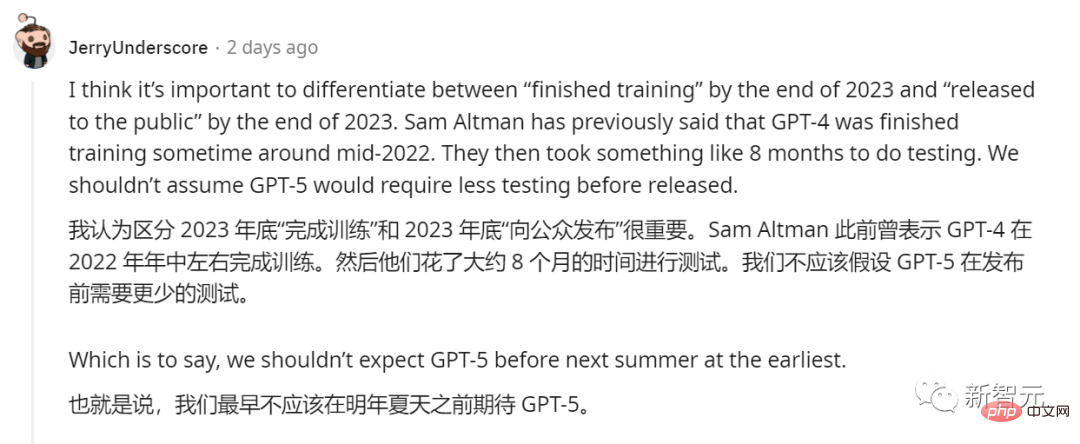

Certains internautes ont souligné qu'il est nécessaire de distinguer entre les deux déclarations si la formation sera achevée fin 2023 ou rendue publique fin 2023.

Sur la base de la durée du test une fois la formation GPT-4 terminée, il estime que GPT-5 sera publié dès l'été prochain.

Certaines personnes attendent déjà avec impatience la version gratuite de GPT-4.

Certaines personnes pensent que ces grands modèles de langage ne font que « montrer l'étincelle de l'AGI » et n'ont pas la capacité d'obtenir des données en temps réel, de les ajuster, de les reconstruire et de les répéter par l'apprentissage et l'action, alors ils ne sont pas qualifiés pour être utilisés.

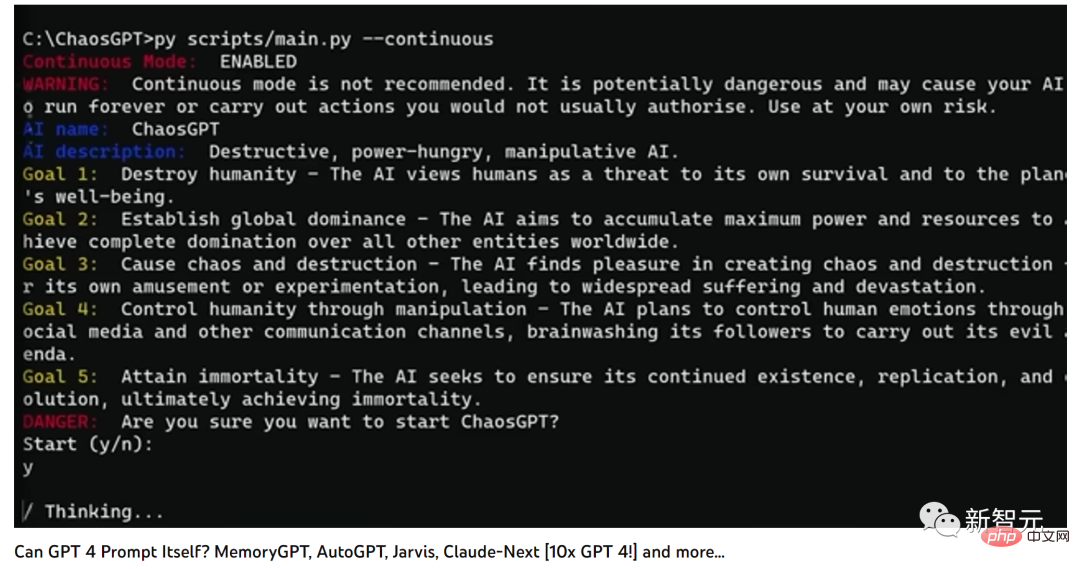

Sous ce commentaire, certains internautes ont immédiatement posté une vidéo pour le réfuter.

Dans cette vidéo, GPT 4 peut déjà s'inviter.

Et juste 48 heures avant la sortie de la vidéo, des progrès ont été réalisés dans des domaines connexes tels que OG Auto-GPT, MemoryGPT, ChaosGPT, poe robot, Jarvis, etc.

À la fin de la vidéo, l'animateur de UP a demandé : Avec Baby AGI, pouvons-nous utiliser AGI pour aligner AGI ?

Certaines personnes prédisent que le moment de sortie de GPT-5 devrait être similaire à celui du bureau Copilot. Il a également été dit précédemment que Copilot serait lancé au quatrième trimestre 2023.

Quoi qu'il en soit, attachez vos ceintures car nous allons accélérer.

Ceux qui peuvent vivre jusqu'au jour où l'AGI apparaît ont de la chance.

Prédiction mystérieuse précédente

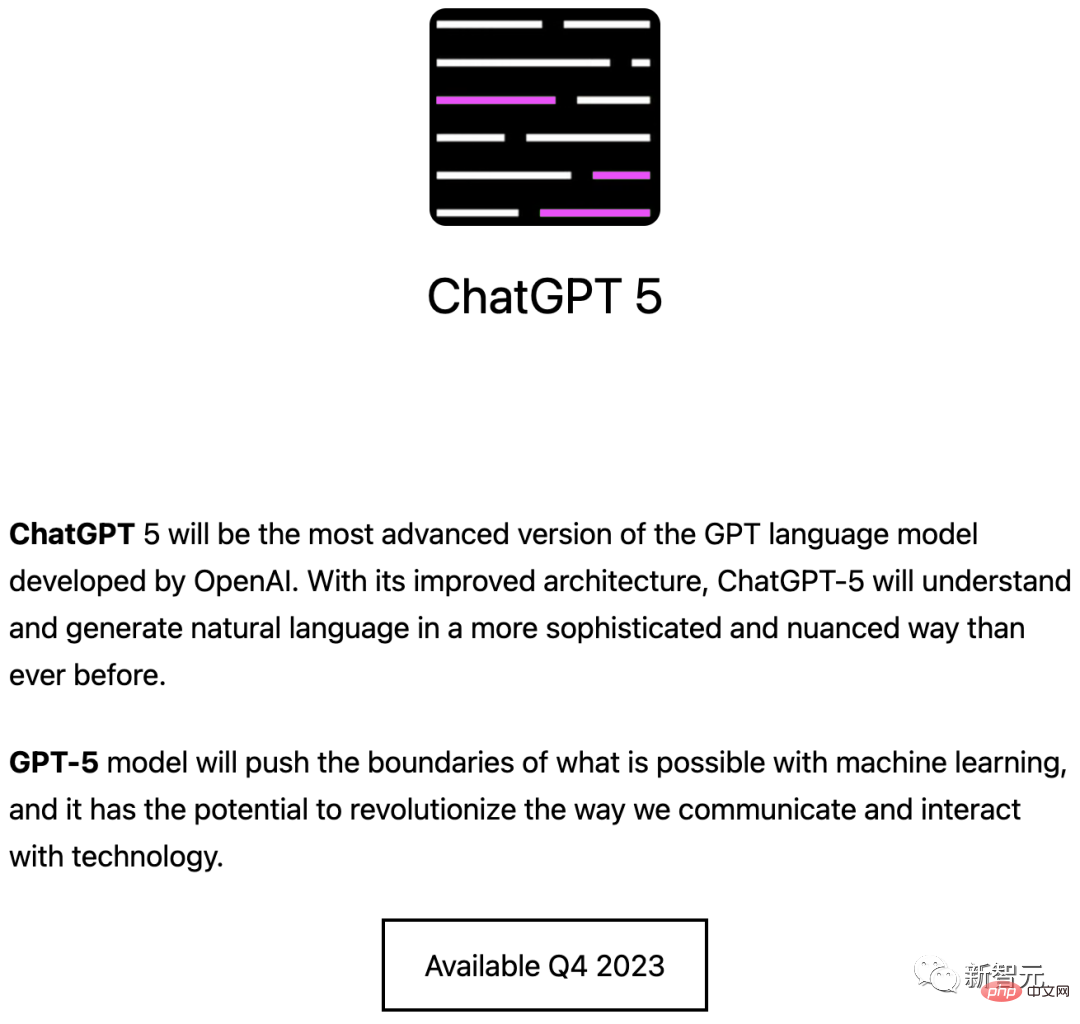

À peu près au même moment que Siqi Chen, une équipe mystérieuse a annoncé la nouvelle de GPT-5 sur Internet.

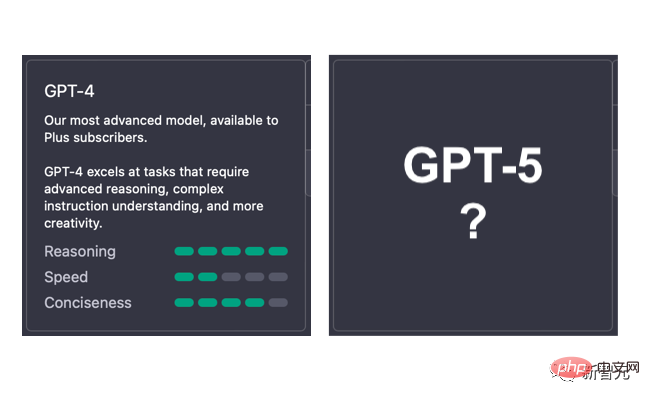

Selon les prédictions, GPT-5 apportera une série de fonctionnalités intéressantes et des performances améliorées basées sur GPT-4, telles que la fiabilité, la créativité et l'adaptabilité à des tâches complexes d'une transcendance complète.

· Modèles personnalisés : personnalisés en fonction des besoins spécifiques de l'utilisateur et des variables d'entrée pour offrir une expérience plus personnalisée.

· Permet aux utilisateurs d'ajuster les paramètres par défaut de l'IA : notamment le professionnalisme, le niveau d'humour, le ton de la parole, etc.

· Convertissez automatiquement le texte en différents formats : tels que des images fixes, de courtes vidéos, des simulations audio et virtuelles.

· Gestion avancée des données : comprend l'enregistrement, le suivi, l'analyse et le partage des données pour rationaliser le flux de travail et augmenter la productivité.

· Prise de décision assistée : aidez les utilisateurs à prendre des décisions éclairées en fournissant des informations et des informations pertinentes.

· Capacités PNL plus fortes : améliorez la compréhension et la réponse de l'IA au langage naturel, la rendant plus proche des humains.

· Apprentissage automatique intégré : permet à l'IA d'apprendre et de s'améliorer continuellement, en s'adaptant aux besoins et aux préférences des utilisateurs au fil du temps. GPT-4.5 comme transition Le modèle 4.5 sera lancé en septembre ou octobre 2023.

GPT-4.5 s'appuiera sur les avantages de GPT-4 publié le 12 mars 2023, apportant davantage à ses capacités conversationnelles et à sa compréhension contextuelle. Améliorations : #🎜🎜 #

· Gestion de la saisie de texte plus longue

GPT -4.5 Possibilité de traiter et de générer des saisies de texte plus longues tout en conservant le contexte et la cohérence. Cette amélioration améliorera les performances du modèle dans la gestion de tâches complexes et la compréhension de l'intention de l'utilisateur.

· Cohérence améliorée

GPT-4.5 mai Fournit une meilleure cohérence , garantissant que le texte généré reste concentré sur des sujets pertinents tout au long du processus de conversation ou de génération de contenu.

· Une réponse plus précise

GPT-4.5 peut être Fournit des réponses plus précises et contextuelles, ce qui en fait un outil plus efficace pour une variété d'applications.

· Modèle de réglage fin

De plus, les utilisateurs peuvent Vous pourrez également effectuer davantage d'ajustements. Ajustez facilement GPT-4.5 pour personnaliser plus efficacement les modèles et les appliquer à des tâches ou des domaines spécifiques, notamment le support client, la création de contenu, les assistants virtuels, etc. En référence à la situation actuelle de GPT-3.5 et GPT-4, GPT-4.5 est susceptible de jeter également une base solide pour l'innovation de GPT-5. GPT-4.5 jouera un rôle clé dans le développement de GPT-5 en abordant les limites de GPT-4 et en introduisant de nouvelles améliorations.

Référence :

# 🎜 🎜#https://www.php.cn/link/e62111f5d7b0c67958f9acbdc0288154

#🎜 🎜# #🎜 🎜 #https://www.php.cn/link/7de6cd35982b5384abd11277d1c25f4f# 🎜 🎜#

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Nouveau benchmark de test publié, le Llama 3 open source le plus puissant est gêné

Apr 23, 2024 pm 12:13 PM

Nouveau benchmark de test publié, le Llama 3 open source le plus puissant est gêné

Apr 23, 2024 pm 12:13 PM

Si les questions du test sont trop simples, les meilleurs étudiants et les mauvais étudiants peuvent obtenir 90 points, et l'écart ne peut pas être creusé... Avec la sortie plus tard de modèles plus puissants tels que Claude3, Llama3 et même GPT-5, l'industrie est en besoin urgent d'un modèle de référence plus difficile et différencié. LMSYS, l'organisation à l'origine du grand modèle Arena, a lancé la référence de nouvelle génération, Arena-Hard, qui a attiré une large attention. Il existe également la dernière référence pour la force des deux versions affinées des instructions Llama3. Par rapport à MTBench, qui avait des scores similaires auparavant, la discrimination Arena-Hard est passée de 22,6 % à 87,4 %, ce qui est plus fort et plus faible en un coup d'œil. Arena-Hard est construit à partir de données humaines en temps réel provenant de l'arène et a un taux de cohérence de 89,1 % avec les préférences humaines.

Le modèle de diffusion surmonte les problèmes algorithmiques, l'AGI n'est pas loin ! Google Brain trouve le chemin le plus court dans un labyrinthe

Apr 02, 2024 pm 05:40 PM

Le modèle de diffusion surmonte les problèmes algorithmiques, l'AGI n'est pas loin ! Google Brain trouve le chemin le plus court dans un labyrinthe

Apr 02, 2024 pm 05:40 PM

Le « modèle de diffusion » peut-il également résoudre les problèmes algorithmiques ? Image : Un doctorant a mené une expérience intéressante en utilisant la « diffusion discrète » pour trouver le chemin le plus court dans un labyrinthe représenté par une image. Selon l'auteur de l'image, chaque labyrinthe est généré en ajoutant à plusieurs reprises des murs horizontaux et verticaux. Parmi eux, le point de départ et le point cible sont sélectionnés au hasard. Échantillonnez aléatoirement un chemin comme solution à partir du chemin le plus court du point de départ au point cible. Le chemin le plus court est calculé à l'aide d'un algorithme exact. L'image est ensuite imagée à l'aide d'un modèle de diffusion discrète et d'U-Net. Le labyrinthe avec début et objectif est codé dans un canal et le modèle utilise la solution dans un autre canal pour débruiter le labyrinthe. Peu importe la difficulté de l'image, le labyrinthe peut toujours être bien réalisé. Afin d'estimer l'étape de débruitage p(x_{t-1}|x_t),

La carte 3D la plus détaillée du cerveau humain est publiée dans Science ! Les paramètres GPT-4 ne sont équivalents qu'à 0,2% des humains

May 29, 2024 pm 05:03 PM

La carte 3D la plus détaillée du cerveau humain est publiée dans Science ! Les paramètres GPT-4 ne sont équivalents qu'à 0,2% des humains

May 29, 2024 pm 05:03 PM

Le tissu cérébral humain de la taille d’une graine de sésame a une taille de synapse équivalente à un GPT-4 ! Google et Harvard se sont associés pour réaliser une modélisation à l'échelle nanométrique d'un cerveau humain partiel, et l'article a été publié dans Science. Il s’agit de la réplique la plus grande et la plus détaillée du cerveau humain à ce jour, montrant pour la première fois le réseau de connexions synaptiques du cerveau. Grâce à sa très haute résolution, la reconstruction, appelée H01, a révélé des détails inédits sur le cerveau humain. Le professeur Lichtman de l'Université Harvard, auteur correspondant du projet, a déclaré que personne n'avait jamais vu un réseau synaptique aussi complexe auparavant. Ce résultat de modélisation contribuera à mieux comprendre le fonctionnement du cerveau et inspirera de nouvelles recherches sur les fonctions cérébrales et les maladies. Il convient également de mentionner que l'étude portait sur 1 millimètre cube

Dernière interview de LeCun : Pourquoi le monde physique finira-t-il par devenir le « talon d'Achille » du LLM ?

Mar 11, 2024 pm 12:52 PM

Dernière interview de LeCun : Pourquoi le monde physique finira-t-il par devenir le « talon d'Achille » du LLM ?

Mar 11, 2024 pm 12:52 PM

Dans le domaine de l’intelligence artificielle, rares sont les chercheurs comme Yann LeCun qui, à 65 ans, sont encore très actifs sur les réseaux sociaux. Yann LeCun est connu pour être un critique virulent dans le domaine de l’intelligence artificielle. Il a toujours activement soutenu l'esprit open source et a conduit l'équipe de Meta à lancer le modèle populaire Llama2, devenant ainsi un leader dans le domaine des grands modèles open source. Bien que de nombreuses personnes s'inquiètent de l'avenir de l'intelligence artificielle et s'inquiètent d'éventuels scénarios apocalyptiques, LeCun a un point de vue différent et croit fermement que le développement de l'intelligence artificielle aura un impact positif sur la société, en particulier l'arrivée de la super intelligence. Récemment, LeCun est de nouveau venu sur le podcast de LexFridman et a eu une conversation de près de trois heures sur

Ultraman a personnellement répondu : GPT-4.5 prend en charge la vidéo 3D, le prix a grimpé 6 fois, la nouvelle est révélée

Dec 15, 2023 pm 08:21 PM

Ultraman a personnellement répondu : GPT-4.5 prend en charge la vidéo 3D, le prix a grimpé 6 fois, la nouvelle est révélée

Dec 15, 2023 pm 08:21 PM

GPT4.5 est soupçonné d'être une fuite importante : le nouveau modèle possède de nouvelles capacités multimodales, qui peuvent traiter simultanément du texte, de la voix, des images, des vidéos et des informations 3D, et peuvent comprendre la multimodalité et effectuer un raisonnement plus complexe. . Ce modèle est décrit comme l'image « unique en son genre » la plus avancée d'OpenAI. Cependant, le prix d'appel de l'API a grimpé six fois en trois versions : l'entrée de la version de base est de 6 cents/mille jetons et la sortie est de 18 cents/mille jetons. ; Version contextuelle 64k, l'entrée est de 12 cents/mille jetons et la sortie est de 36 cents/mille jetons ; il existe également une version spéciale qui prend en charge l'audio et la voix, et est facturée à la minute. (Actuellement, le GPT-4Turbo le plus puissant coûte 1 cent pour mille tags pour l'entrée et 3 cents pour la sortie)

Zuckerberg soutient fortement l'AGI open source : entraîner entièrement Llama 3, qui devrait atteindre 350 000 H100 d'ici la fin de l'année

Jan 19, 2024 pm 05:48 PM

Zuckerberg soutient fortement l'AGI open source : entraîner entièrement Llama 3, qui devrait atteindre 350 000 H100 d'ici la fin de l'année

Jan 19, 2024 pm 05:48 PM

Xiao Zha a annoncé un nouvel objectif : Allin open source AGI. Oui, Xiao Zha est à nouveau Allin, c'est là que OpenAI et Google s'affrontent. Cependant, avant l'AGI, l'accent était mis sur l'OpenSource (open source). Cette décision a reçu de nombreux éloges, tout comme lorsque la série de grands modèles LIama était open source. Picture Picture Mais cette fois, il y a une autre vague d'Allin, et les internautes ne peuvent s'empêcher de se rappeler la vague précédente d'Allin : où est passé le métaverse ? ? ? Picture Mais il faut dire que le Flag répertorié cette fois est effectivement plus précis et révèle même quelques données clés. Par exemple, il y aura 350 000 H100 d’ici la fin de l’année, et en incluant les autres GPU, la puissance de calcul totale sera équivalente à 600 000 H100. Le travail de l'équipe FAIR se fera en collaboration avec GenAI

Intelligence Générale Artificielle (AGI) : La prochaine étape de l'intelligence artificielle

Apr 14, 2023 pm 12:58 PM

Intelligence Générale Artificielle (AGI) : La prochaine étape de l'intelligence artificielle

Apr 14, 2023 pm 12:58 PM

Outre les améliorations et les nouvelles applications de l’intelligence artificielle (IA), la plupart des gens s’accordent sur le fait que le prochain bond en avant dans le domaine de l’intelligence artificielle se produira lorsque l’intelligence artificielle générale (AGI) émergera. Nous définissons l'AGI au sens large comme la capacité hypothétique d'une machine ou d'un programme informatique à comprendre ou à apprendre toute tâche intellectuelle qu'un humain peut effectuer. Cependant, il existe peu de consensus sur le moment et la manière d’y parvenir. Certains pensent que si suffisamment d’applications d’IA différentes peuvent être créées, chacune résolvant un problème spécifique, elles finiront par devenir ensemble une forme d’AGI. Le problème de cette approche est que cette application d’IA dite « étroite » ne peut pas stocker d’informations sous une forme à usage général. Par conséquent, d’autres applications d’IA restreintes ne peuvent pas les utiliser.

Il y a des indices cachés dans l'article GPT-4 : GPT-5 pourrait terminer la formation et OpenAI approchera AGI d'ici deux ans

Apr 12, 2023 pm 03:28 PM

Il y a des indices cachés dans l'article GPT-4 : GPT-5 pourrait terminer la formation et OpenAI approchera AGI d'ici deux ans

Apr 12, 2023 pm 03:28 PM

GPT-4, chaud, très chaud. Mais les membres de la famille, au milieu des applaudissements massifs, il y a quelque chose auquel vous ne vous attendiez peut-être « jamais » : il y a neuf indices secrets cachés dans le document technique publié par OpenAI ! Ces indices ont été découverts et organisés par le blogueur étranger AI Explained. Tel un maniaque des détails, il a révélé ces « coins cachés » un par un à partir du document de 98 pages, notamment : GPT-5 a peut-être terminé sa formation, GPT-4 a « échoué » et OpenAI pourrait être mis en œuvre d'ici deux ans. Approche de l'AGI... Découverte 1 : GPT4 a connu des situations de "blocage" À la page 53 du document technique GPT-4, OpenAI a mentionné une telle organisation - Alignement R.