Périphériques technologiques

Périphériques technologiques

IA

IA

Les risques liés à l'utilisation de chatbots basés sur l'IA dans l'entreprise

Les risques liés à l'utilisation de chatbots basés sur l'IA dans l'entreprise

Les risques liés à l'utilisation de chatbots basés sur l'IA dans l'entreprise

Depuis le lancement officiel de ChatGPT en novembre 2022, des millions d'utilisateurs ont afflué de manière folle. En raison de ses excellentes capacités de génération de langage de type humain, de son talent en matière de logiciels de programmation et de ses capacités d'analyse de texte ultra-rapides, ChatGPT est rapidement devenu l'outil de choix pour les développeurs, les chercheurs et les utilisateurs quotidiens.

Comme toute technologie disruptive, les systèmes d’IA générative comme ChatGPT comportent également des risques potentiels. En particulier, les principaux acteurs de l’industrie technologique, les agences nationales de renseignement et d’autres agences gouvernementales ont émis des avertissements concernant l’introduction d’informations sensibles dans des systèmes d’intelligence artificielle tels que ChatGPT.

Les inquiétudes concernant les risques de sécurité de ChatGPT proviennent de la possibilité que des informations finissent par être divulguées dans le domaine public via ChatGPT, soit par des failles de sécurité, soit par l'utilisation de contenu généré par l'utilisateur pour « former » le chatbot.

En réponse à ces préoccupations, les entreprises technologiques prennent des mesures pour atténuer les risques de sécurité associés aux grands modèles de langage (LLM) et à l'IA conversationnelle (CAI). Certaines entreprises ont même choisi de désactiver complètement ChatGPT, tandis que d'autres avertissent leurs employés des dangers liés à la saisie de données confidentielles dans de tels modèles.

ChatGPT : une IA ouverte et effrayante ?

ChatGPT, basé sur l'IA, est devenu un outil populaire permettant aux entreprises d'optimiser leurs opérations et de rationaliser des tâches complexes. Cependant, des événements récents ont mis en évidence les dangers potentiels du partage d’informations confidentielles via la plateforme.

De manière inquiétante, trois incidents de fuite de données sensibles via ChatGPT ont été signalés en moins d'un mois. Les médias sud-coréens ont rapporté que des employés de la principale usine de semi-conducteurs du fabricant de smartphones Samsung ont saisi des informations confidentielles, notamment du code source hautement sensible utilisé pour résoudre les erreurs de programmation, dans un chatbot à intelligence artificielle, suscitant la controverse.

Le code source est l'un des secrets les plus jalousement gardés de toute entreprise technologique, car il constitue l'élément fondamental de tout logiciel ou système d'exploitation. Et maintenant, des secrets d’affaires aussi précieux sont accidentellement tombés entre les mains d’OpenAI.

Selon des personnes proches du dossier, Samsung a actuellement restreint l'accès de ses employés à ChatGPT.

D'autres conglomérats Fortune 500, dont Amazon, Walmart et JPMorgan, ont connu des situations similaires où des employés saisissaient accidentellement des données sensibles dans des chatbots.

Il y a eu des rapports antérieurs selon lesquels des employés d'Amazon utilisaient ChatGPT pour obtenir des informations confidentielles sur les clients, ce qui a incité le géant de la technologie à limiter rapidement l'utilisation de l'outil et à avertir sévèrement les employés de ne saisir aucune donnée sensible dans l'outil.

Modèles « imparfaits » : des bases de connaissances manquant d'intelligence

Mathieu Fortier, directeur de l'apprentissage automatique chez Coveo, une plateforme d'expérience numérique basée sur l'IA, a déclaré que les LLM tels que GPT-4 et LLaMA souffrent de multiples imperfections, avertissant que, bien qu'ils excellent dans la compréhension du langage, ces modèles n’ont pas la capacité de reconnaître l’exactitude, les lois immuables, la réalité physique et d’autres aspects non linguistiques.

Bien que les LLM construisent une vaste base de connaissances intrinsèques à partir de données de formation, ils n'ont aucune notion explicite de vérité ou d'exactitude factuelle. De plus, ils sont vulnérables aux failles de sécurité et aux attaques par extraction de données, et ont tendance à s'écarter des réponses attendues ou à présenter des caractéristiques « psychotiques » – le nom technique est « hallucinations ».

Fortier a souligné les risques élevés auxquels sont confrontées les entreprises. Les conséquences peuvent gravement ébranler la confiance des clients et causer des dommages irréparables à la réputation d'une marque, entraînant d'importants problèmes juridiques et financiers.

Suivant les traces d’autres géants de la technologie, la branche technologique du géant de la vente au détail, Walmart Global tech, a pris des mesures pour réduire le risque de violation de données. Dans une note interne adressée aux employés, l'entreprise a demandé à ses employés de bloquer ChatGPT immédiatement après avoir détecté une activité suspecte susceptible de compromettre les données et la sécurité de l'entreprise.

Un porte-parole de Walmart a déclaré que même si le détaillant crée son propre chatbot basé sur les capacités de GPT-4, il a mis en œuvre plusieurs mesures pour protéger les données des employés et des clients contre l'IA générative comme la propagation de l'outil ChatGPT.

Le porte-parole a déclaré : « La plupart des nouvelles technologies apportent de nouveaux avantages, mais aussi de nouveaux risques. Par conséquent, nous évaluons ces nouvelles technologies et fournissons à nos employés des conseils d'utilisation pour protéger les données de nos clients, membres et employés. des technologies comme Open AI et construire une couche par-dessus pour communiquer plus efficacement avec les détaillants, nous permettant de développer de nouvelles expériences client et d'améliorer celles existantes. "

De plus, d'autres entreprises telles que Verizon et Accenture ont également pris des mesures. pour limiter l'utilisation de ChatGPT, Verizon demandant à ses employés de limiter le chatbot aux tâches non sensibles et Accenture mettant en œuvre des contrôles plus stricts pour garantir le respect des réglementations sur la confidentialité des données.

Comment ChatGPT utilise les données de session

Plus inquiétant encore, ChatGPT conserve les données saisies par l'utilisateur pour entraîner davantage le modèle, ce qui soulève des questions sur l'exposition potentielle d'informations sensibles via des violations de données ou d'autres incidents de sécurité.

OpenAI, la société à l'origine des modèles populaires d'intelligence artificielle générative ChatGPT et DALL-E, a récemment mis en œuvre une nouvelle politique pour améliorer la confidentialité et la sécurité des données des utilisateurs.

Depuis le 1er mars de cette année, les utilisateurs d'API doivent explicitement choisir de partager leurs données pour former ou améliorer les modèles OpenAI.

En revanche, pour les services non API tels que ChatGPT et DALL-E, les utilisateurs doivent se désinscrire s'ils ne souhaitent pas qu'OpenAI utilise leurs données.

OpenAI a déclaré dans un blog récemment mis à jour : « Lorsque vous utilisez nos services grand public non API ChatGPT ou DALL-E, nous pouvons utiliser les données que vous fournissez pour améliorer nos modèles et non pour partager vos données avec nous. aide seulement nos modèles à devenir plus précis et à mieux résoudre votre problème spécifique, mais contribue également à améliorer leurs capacités et leur sécurité globales... Vous pouvez le faire en remplissant ce formulaire. L'ID de votre organisation et l'adresse e-mail associée au propriétaire du compte pour demander l'option -hors de l'utilisation de vos données pour améliorer nos services non-API." Publié par des entreprises où la prudence est de mise lors de la manipulation d'informations sensibles. Le gouvernement italien s'est récemment joint à la mêlée en interdisant l'utilisation de ChatGPT dans tout le pays, invoquant des préoccupations concernant la confidentialité et la sécurité des données.

OpenAI a déclaré qu'il supprimait toute information personnelle identifiable des données utilisées pour améliorer ses modèles d'intelligence artificielle et n'utilisait qu'un petit échantillon de données de chaque client à cette fin.

Avertissement du gouvernement

L'agence de renseignement britannique Government Communications Quarters (GCHQ), par l'intermédiaire de son National Cyber Security Centre (NCSC), a émis un avertissement concernant les grands modèles de langage ( LLM) tels que ChatGPT Avertissement des limitations et des risques. Bien que ces modèles aient été loués pour leurs impressionnantes capacités de traitement du langage naturel, le NCSC prévient qu'ils ne sont pas infaillibles et peuvent contenir de graves défauts.

Selon le NCSC, LLM peut générer des faits incorrects ou « illusoires », comme l'a démontré la première démonstration du chatbot Google Bard. Ils peuvent également faire preuve de partialité et de crédulité, en particulier lorsqu’ils répondent à des questions suggestives. De plus, ces modèles nécessitent des ressources informatiques étendues et de grandes quantités de données pour être entraînés à partir de zéro, et ils sont vulnérables aux attaques par injection et à la création de contenu toxique.

Fortier de Coveo a déclaré : « Les LLM génèrent des réponses aux invites en fonction de la similitude inhérente de l'invite avec les connaissances internes. Cependant, étant donné qu'ils n'ont pas de « règle stricte » interne inhérente ou de capacités de raisonnement, il est peu probable qu'ils le fassent. réussir à 100 % à respecter la contrainte de non-divulgation d'informations sensibles. Bien que des efforts soient déployés pour réduire la génération d'informations sensibles, la seule solution est que LLM utilise ces données pour la formation. Ne formez pas ces modèles avec du matériel sensible. évitez également de leur fournir des informations sensibles dans les invites, car la plupart des services enregistrent actuellement ces informations dans leurs journaux Meilleures pratiques pour une sécurité intelligente et une utilisation éthique

Alors que les entreprises continuent d'adopter l'intelligence artificielle et d'autres technologies émergentes, garantissant. des mesures de sécurité appropriées pour protéger les données sensibles et empêcher la divulgation accidentelle d’informations confidentielles seront essentielles.

Les actions entreprises par ces entreprises soulignent l'importance de rester vigilant lors de l'utilisation de modèles linguistiques d'intelligence artificielle tels que ChatGPT. Bien que ces outils puissent augmenter considérablement l’efficacité et la productivité, ils peuvent présenter des risques importants s’ils sont mal utilisés.

Peter Relan, président de la startup d'intelligence artificielle conversationnelle Got it AI, a suggéré que « la meilleure approche est d'incorporer chaque nouveau développement dans l'amélioration originale des modèles de langage dans une architecture axée sur la stratégie d'entreprise », le L'architecture combine un modèle de langage avec des pré- et post-processeurs pour la protection, les ajuste pour les données spécifiques à l'entreprise, puis les déploie même localement. Sinon, le modèle de langage d'origine est trop puissant et le traitement dans l'entreprise est parfois nuisible. ."

Prasanna Arikala, CTO de Kore.ai, une plateforme d'IA conversationnelle soutenue par NVIDIA, a déclaré qu'à l'avenir, les entreprises devront limiter l'accès LLM aux informations sensibles et personnelles pour éviter les violations. .

Arikala a noté que « la mise en œuvre de contrôles d'accès stricts, tels que l'authentification multifacteur et le cryptage des données sensibles, peut aider à atténuer ces risques. De plus, des audits de sécurité et des évaluations de vulnérabilité réguliers sont nécessaires pour identifier et éliminer. vulnérabilités potentielles. Le LLM est un outil précieux s'il est utilisé correctement, mais il est essentiel que les entreprises prennent les précautions nécessaires pour protéger les données sensibles et maintenir la confiance des clients et des parties prenantes. " #🎜 🎜#

Cela reste à voir. comment ces réglementations évolueront, mais les entreprises doivent rester vigilantes pour garder une longueur d'avance. Si l’IA générative présente des avantages potentiels, elle entraîne également de nouvelles responsabilités et de nouveaux défis, et l’industrie technologique doit travailler avec les décideurs politiques pour garantir que cette technologie est développée et mise en œuvre de manière responsable et éthique.Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Sujets chauds

ChatGPT permet désormais aux utilisateurs gratuits de générer des images en utilisant DALL-E 3 avec une limite quotidienne

Aug 09, 2024 pm 09:37 PM

ChatGPT permet désormais aux utilisateurs gratuits de générer des images en utilisant DALL-E 3 avec une limite quotidienne

Aug 09, 2024 pm 09:37 PM

Le DALL-E 3 a été officiellement introduit en septembre 2023 en tant que modèle considérablement amélioré par rapport à son prédécesseur. Il est considéré comme l’un des meilleurs générateurs d’images IA à ce jour, capable de créer des images avec des détails complexes. Cependant, au lancement, c'était exclu

La combinaison parfaite de ChatGPT et Python : créer un chatbot de service client intelligent

Oct 27, 2023 pm 06:00 PM

La combinaison parfaite de ChatGPT et Python : créer un chatbot de service client intelligent

Oct 27, 2023 pm 06:00 PM

La combinaison parfaite de ChatGPT et Python : Création d'un chatbot de service client intelligent Introduction : À l'ère de l'information d'aujourd'hui, les systèmes de service client intelligents sont devenus un outil de communication important entre les entreprises et les clients. Afin d'offrir une meilleure expérience de service client, de nombreuses entreprises ont commencé à se tourner vers les chatbots pour effectuer des tâches telles que la consultation des clients et la réponse aux questions. Dans cet article, nous présenterons comment utiliser le puissant modèle ChatGPT et le langage Python d'OpenAI pour créer un chatbot de service client intelligent afin d'améliorer

Comment installer chatgpt sur un téléphone mobile

Mar 05, 2024 pm 02:31 PM

Comment installer chatgpt sur un téléphone mobile

Mar 05, 2024 pm 02:31 PM

Étapes d'installation : 1. Téléchargez le logiciel ChatGTP depuis le site officiel ou la boutique mobile de ChatGTP ; 2. Après l'avoir ouvert, dans l'interface des paramètres, sélectionnez la langue chinoise 3. Dans l'interface de jeu, sélectionnez le jeu homme-machine et définissez la langue. Spectre chinois ; 4. Après avoir démarré, entrez les commandes dans la fenêtre de discussion pour interagir avec le logiciel.

Chatgpt peut-il être utilisé en Chine ?

Mar 05, 2024 pm 03:05 PM

Chatgpt peut-il être utilisé en Chine ?

Mar 05, 2024 pm 03:05 PM

chatgpt peut être utilisé en Chine, mais ne peut pas être enregistré, ni à Hong Kong et Macao. Si les utilisateurs souhaitent s'inscrire, ils peuvent utiliser un numéro de téléphone mobile étranger pour s'inscrire. Notez que lors du processus d'enregistrement, l'environnement réseau doit être basculé vers. une adresse IP étrangère.

Comment développer un chatbot intelligent en utilisant ChatGPT et Java

Oct 28, 2023 am 08:54 AM

Comment développer un chatbot intelligent en utilisant ChatGPT et Java

Oct 28, 2023 am 08:54 AM

Dans cet article, nous présenterons comment développer des chatbots intelligents à l'aide de ChatGPT et Java, et fournirons quelques exemples de code spécifiques. ChatGPT est la dernière version du Generative Pre-training Transformer développé par OpenAI, une technologie d'intelligence artificielle basée sur un réseau neuronal qui peut comprendre le langage naturel et générer du texte de type humain. En utilisant ChatGPT, nous pouvons facilement créer des discussions adaptatives

Comment utiliser ChatGPT et Python pour implémenter la fonction de reconnaissance des intentions de l'utilisateur

Oct 27, 2023 am 09:04 AM

Comment utiliser ChatGPT et Python pour implémenter la fonction de reconnaissance des intentions de l'utilisateur

Oct 27, 2023 am 09:04 AM

Comment utiliser ChatGPT et Python pour implémenter la fonction de reconnaissance des intentions des utilisateurs Introduction : À l'ère numérique d'aujourd'hui, la technologie de l'intelligence artificielle est progressivement devenue un élément indispensable dans divers domaines. Parmi eux, le développement de la technologie de traitement du langage naturel (Natural Language Processing, NLP) permet aux machines de comprendre et de traiter le langage humain. ChatGPT (Chat-GeneratingPretrainedTransformer) est une sorte de

Comment créer un robot de service client intelligent en utilisant ChatGPT PHP

Oct 28, 2023 am 09:34 AM

Comment créer un robot de service client intelligent en utilisant ChatGPT PHP

Oct 28, 2023 am 09:34 AM

Comment utiliser ChatGPTPHP pour créer un robot de service client intelligent Introduction : Avec le développement de la technologie de l'intelligence artificielle, les robots sont de plus en plus utilisés dans le domaine du service client. L'utilisation de ChatGPTPHP pour créer un robot de service client intelligent peut aider les entreprises à fournir des services client plus efficaces et personnalisés. Cet article explique comment utiliser ChatGPTPHP pour créer un robot de service client intelligent et fournit des exemples de code spécifiques. 1. Installez ChatGPTPHP et utilisez ChatGPTPHP pour créer un robot de service client intelligent.

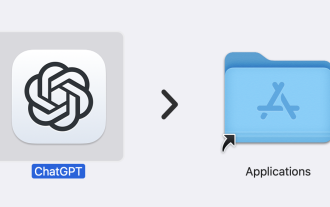

ChatGPT est désormais disponible pour macOS avec la sortie d'une application dédiée

Jun 27, 2024 am 10:05 AM

ChatGPT est désormais disponible pour macOS avec la sortie d'une application dédiée

Jun 27, 2024 am 10:05 AM

L'application ChatGPT Mac d'Open AI est désormais accessible à tous, après avoir été limitée aux seuls utilisateurs disposant d'un abonnement ChatGPT Plus au cours des derniers mois. L'application s'installe comme n'importe quelle autre application Mac native, à condition que vous disposiez d'un Apple S à jour.