L’IA est comme une boîte noire, elle peut prendre des décisions toute seule, mais les gens ne savent pas pourquoi. Créez un modèle d'IA, saisissez des données, puis affichez les résultats, mais un problème est que nous ne pouvons pas expliquer pourquoi l'IA arrive à une telle conclusion. Il est nécessaire de comprendre le raisonnement qui sous-tend la manière dont une IA parvient à une certaine conclusion, plutôt que de simplement accepter un résultat produit sans contexte ni explication.

L'interprétabilité est conçue pour aider les gens à comprendre :

Dans cet article, je présenterai 6 frameworks Python pour l'interprétabilité.

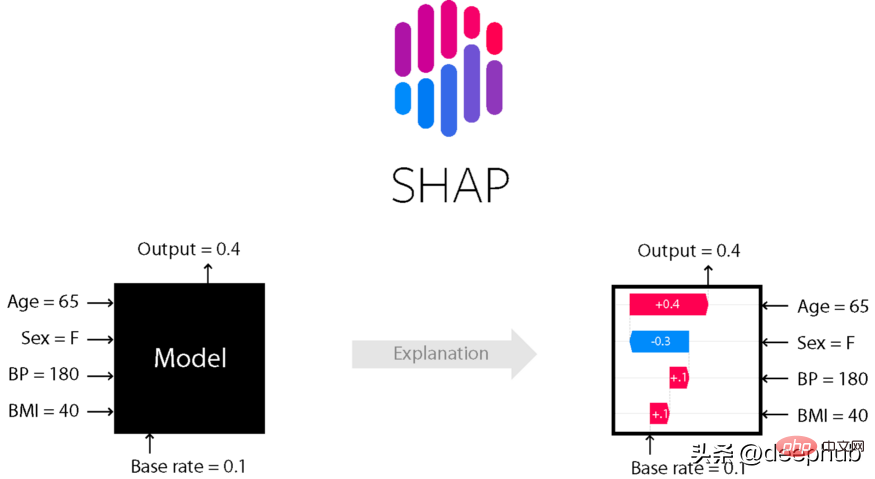

SHapley Additive Explication (SHapley Additive Explication) est une méthode de théorie des jeux pour expliquer la sortie de tout modèle d'apprentissage automatique. Il utilise la valeur Shapley classique de la théorie des jeux et ses extensions associées pour relier l'allocation optimale de crédits aux interprétations locales (voir l'article pour plus de détails et les citations).

La contribution de chaque entité de l'ensemble de données à la prédiction du modèle est expliquée par la valeur de Shapley. L'algorithme SHAP de Lundberg et Lee a été initialement publié en 2017 et a été largement adopté par la communauté dans de nombreux domaines différents.

Utilisez pip ou conda pour installer la bibliothèque shap.

# install with pippip install shap# install with condaconda install -c conda-forge shap

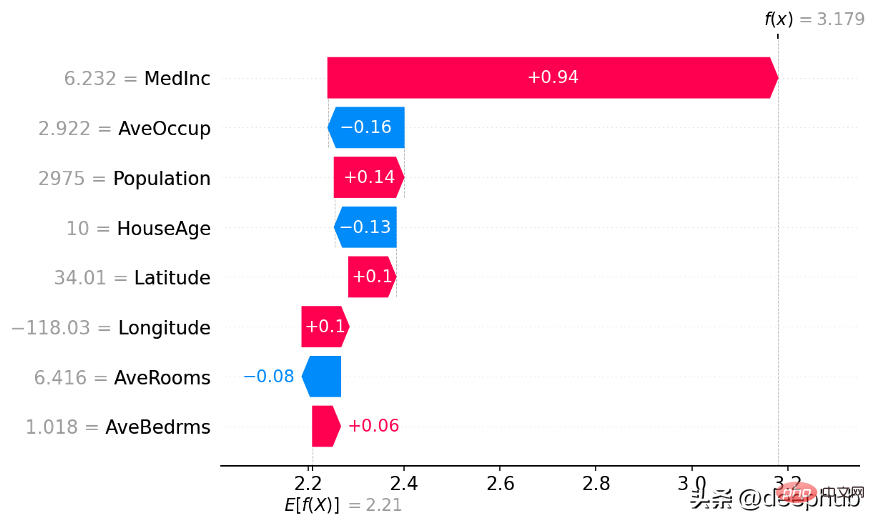

Utilisez la bibliothèque Shap pour créer un graphique en cascade

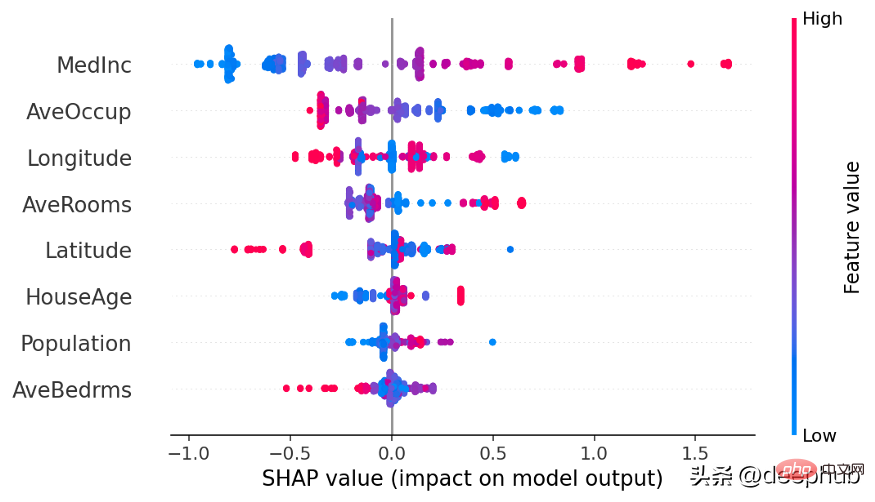

Utilisez la bibliothèque Shap pour créer un graphique Beeswarm

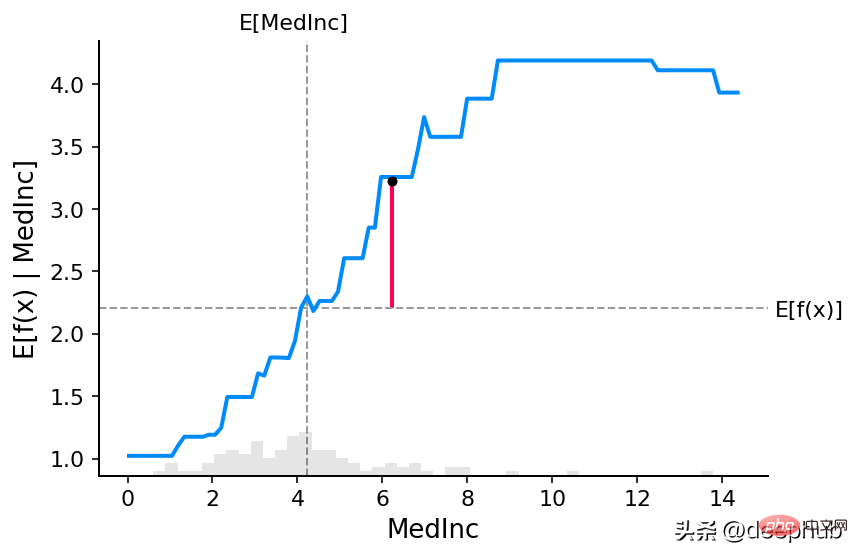

Utilisez la bibliothèque Shap pour créer un graphique de dépendances partielles

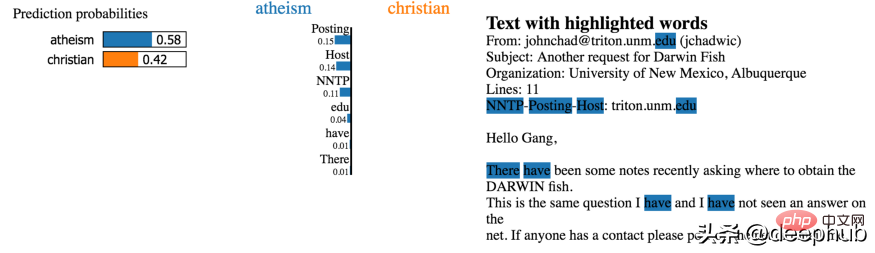

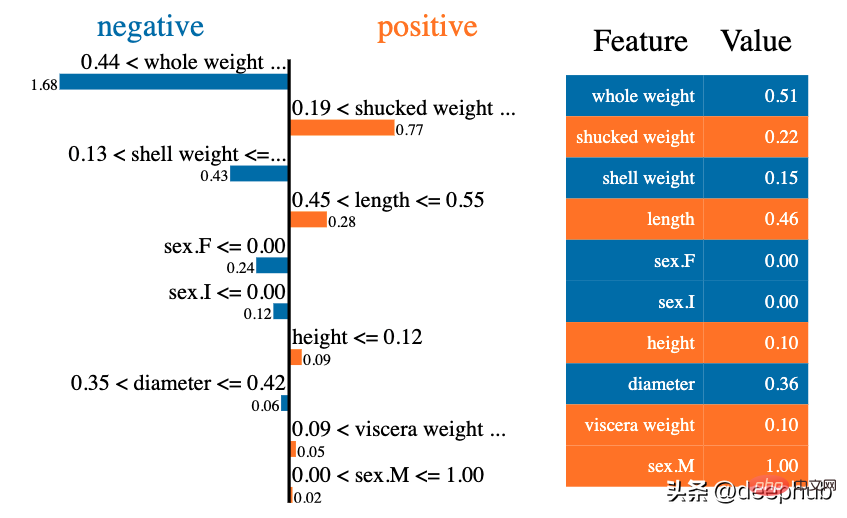

Dans le domaine de l'interprétabilité, le la première méthode célèbre est LIME. Cela peut aider à expliquer quels modèles d’apprentissage automatique apprennent et pourquoi ils prédisent d’une certaine manière. Lime prend actuellement en charge l'interprétation des données tabulaires, des classificateurs de texte et des classificateurs d'images.

Savoir pourquoi le modèle prédit comme il le fait est crucial pour régler l'algorithme. Avec l'explication de LIME, vous pouvez comprendre pourquoi le modèle se comporte de cette façon. Si le modèle ne fonctionne pas comme prévu, il est probable qu'une erreur ait été commise lors de la phase de préparation des données.

Utilisation de l'installation de pip

pip install lime

Graphique d'explication partielle construit par LIME

Graphique Beeswarm construit par LIME

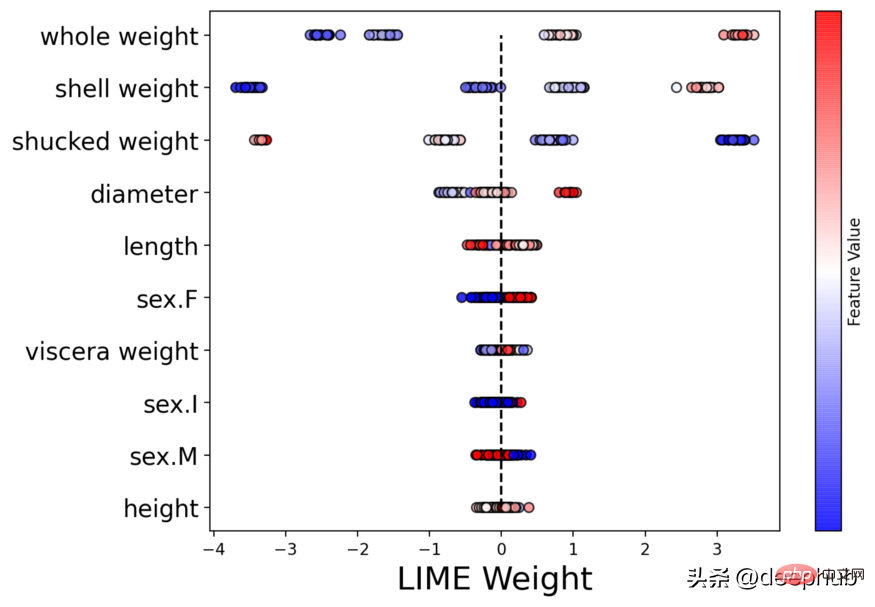

" Shapash est un outil qui rend l'apprentissage automatique interprétable et accessible à tous Comprendre la bibliothèque Python. Shapash propose plusieurs types de visualisations qui affichent des étiquettes claires que tout le monde peut comprendre. Les data scientists peuvent plus facilement comprendre leurs modèles et partager les résultats en utilisant les résumés les plus standards «

Pour exprimer des résultats qui contiennent des histoires. , des informations et des modèles dans vos données, l'interactivité et de beaux graphiques sont essentiels. La meilleure façon pour les entreprises et les data scientists/analystes de présenter et d’interagir avec les résultats de l’IA/ML est de les visualiser et de les mettre sur le Web. La bibliothèque Shapash peut générer des tableaux de bord interactifs et possède une collection de nombreux graphiques de visualisation. Lié à l’interprétabilité forme/chaux. Il peut utiliser SHAP/Lime comme backend, ce qui signifie qu'il ne fournit que des graphiques plus beaux. "Utilisation de Shapash pour créer un graphique de contribution aux fonctionnalités" chercheurs avec des algorithmes d’interprétabilité d’apprentissage automatique. InterpretML prend en charge la formation de modèles interprétables (glassbox), ainsi que l'interprétation des pipelines ML existants (blackbox).

InterpretML démontre deux types d'interprétabilité : les modèles glassbox – modèles d'apprentissage automatique conçus pour l'interprétabilité (par exemple, modèles linéaires, listes de règles, modèles additifs généralisés) et techniques d'interprétabilité boîte noire – pour l'interprétabilité des systèmes existants (par exemple, dépendances partielles, LIME). Utilisant une API unifiée et encapsulant plusieurs méthodes, avec une plate-forme de visualisation intégrée et extensible, ce package permet aux chercheurs de comparer facilement les algorithmes d'interprétabilité. InterpretML inclut également la première implémentation de l'explication Boosting Machine, un modèle de boîte de verre puissant et interprétable qui peut être aussi précis que de nombreux modèles de boîte noire.

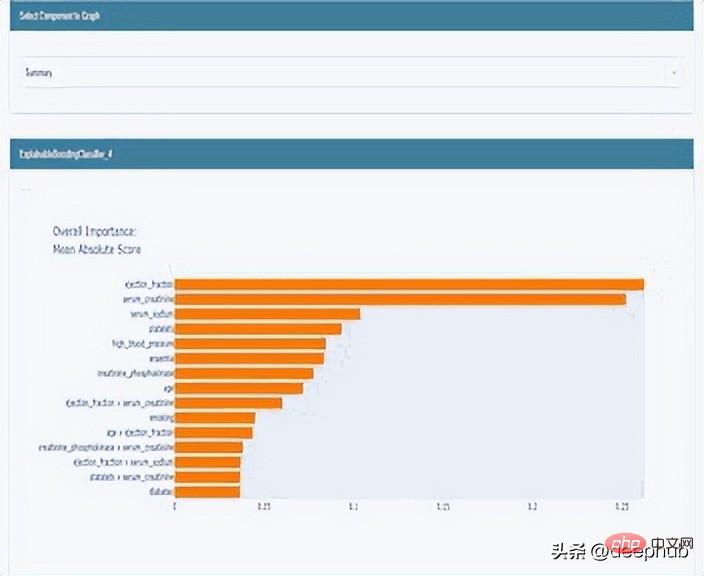

Tracé interactif d'explication locale construit à l'aide d'InterpretML

Tracé d'explication global construit à l'aide d'InterpretML

ELI5 est une bibliothèque Python qui peut aider à déboguer les classificateurs d'apprentissage automatique et à interpréter leurs prédictions. Les frameworks d'apprentissage automatique suivants sont actuellement pris en charge :

ELI5 propose deux manières principales d'interpréter un modèle de classification ou de régression :

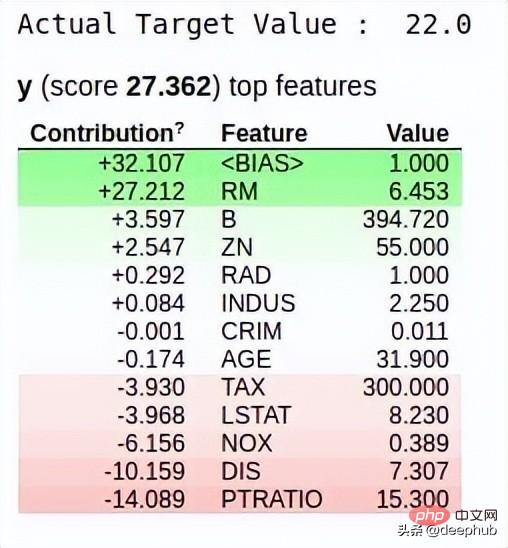

Utilisez la bibliothèque ELI5 pour générer des poids globaux

Utilisez la bibliothèque ELI5 pour générer des poids locaux

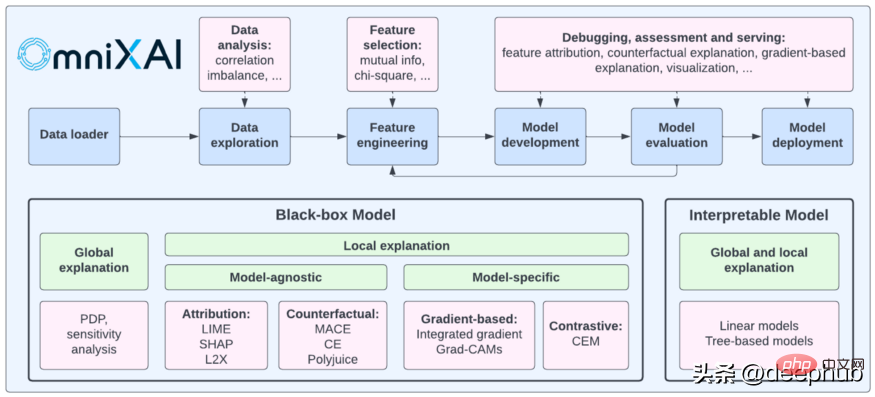

OmniXAI (abréviation de Omni expliqué AI) est une bibliothèque Python récemment développée et open source par Force de vente. Il fournit une gamme complète d'intelligence artificielle explicable et de capacités d'apprentissage automatique explicables pour résoudre plusieurs problèmes qui nécessitent du jugement lors de la génération de modèles d'apprentissage automatique dans la pratique. Pour les data scientists et les chercheurs en ML qui ont besoin d'interpréter différents types de données, de modèles et de techniques d'explication à différentes étapes du processus de ML, OmniXAI espère fournir une bibliothèque complète unique qui simplifie l'IA explicable.

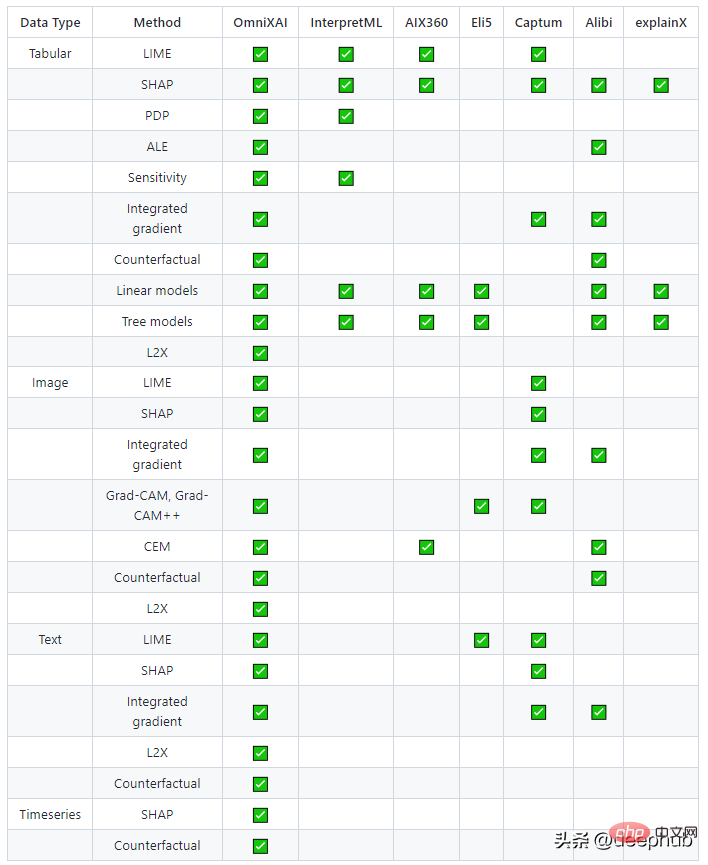

Ce qui suit est une comparaison entre ce que fournit OmniXAI et d'autres bibliothèques similaires

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!