Périphériques technologiques

Périphériques technologiques

IA

IA

Explorez la technologie des grands modèles dans l'ère post-GPT 3.0 et avancez vers la réalisation de l'avenir de l'AGI.

Explorez la technologie des grands modèles dans l'ère post-GPT 3.0 et avancez vers la réalisation de l'avenir de l'AGI.

Explorez la technologie des grands modèles dans l'ère post-GPT 3.0 et avancez vers la réalisation de l'avenir de l'AGI.

ChatGPT a surpris ou réveillé de nombreuses personnes après son apparition. La surprise vient du fait que je ne m'attendais pas à ce que le grand modèle de langage (LLM) puisse être aussi efficace ; le réveil a été la prise de conscience soudaine que notre compréhension et nos concepts de développement du LLM sont loin des idées les plus avancées au monde. J'appartiens au groupe qui a été à la fois surpris et éveillé, et je suis aussi un Chinois typique. Les Chinois sont doués pour l'auto-réflexion, alors ils ont commencé à réfléchir, et cet article est le résultat de cette réflexion.

Pour être honnête, en termes de technologie liée aux modèles LLM en Chine, à l'heure actuelle, l'écart entre celle-ci et la technologie la plus avancée s'est encore creusé. Je pense que la question du leadership technologique ou du fossé technologique doit être considérée de manière dynamique dans une perspective de développement. En fait, un à deux ans après l'émergence de Bert, le rattrapage technologique national dans ce domaine était encore très rapide, et de bons modèles d'amélioration ont également été proposés. Le tournant décisif pour creuser l'écart devrait se situer après la sortie de GPT 3.0. , c'est-à-dire en 2020 Vers le milieu de l'année. À l’époque, seules quelques personnes savaient que GPT 3.0 n’était pas seulement une technologie spécifique, mais incarnait en réalité un concept de développement indiquant la direction que devait prendre le LLM. Depuis lors, l’écart s’est de plus en plus creusé, et ChatGPT n’est qu’une conséquence naturelle de cette différence de philosophies de développement. Par conséquent, je pense personnellement que mettons de côté la question de savoir si vous avez les ressources financières nécessaires pour construire un très grand LLM. D'un seul point de vue technique, l'écart vient principalement de la compréhension différente du LLM et des différents concepts de développement quant à l'endroit où aller. allez dans le futur .

La Chine prend de plus en plus de retard sur la technologie étrangère. C’est un fait, et il est normal de ne pas l’admettre. Il y a quelque temps, de nombreux internautes s'inquiétaient du fait que l'IA nationale se trouve désormais dans une « phase critique de survie ». Je ne pense pas que ce soit si grave. Ne voyez-vous pas, OpenAI est-elle la seule entreprise au monde avec une vision aussi avant-gardiste ? En fait, y compris Google, leur compréhension des concepts de développement LLM est évidemment derrière OpenAI. La réalité est qu’OpenAI a trop bien performé et a laissé tout le monde derrière, pas seulement au niveau national.

Je pense qu'OpenAI est en avance d'environ six mois à un an sur Google et DeepMind à l'étranger en termes de concepts et de technologies associées pour le LLM, et d'environ deux ans sur la Chine. En ce qui concerne le LLM, je pense que l'échelon est très clair. Ceux qui reflètent le mieux la vision technique de Google sont PaLM et Pathways. Ils ont été lancés entre février et avril 2022. Au cours de la même période, OpenAI. a été lancé. Il s'agit d'InstructGPT. De là, vous pouvez voir l'écart entre Google et OpenAI. Quant à la raison pour laquelle je dis cela, vous pouvez probablement le comprendre après avoir lu le texte derrière moi. L'objectif précédent de DeepMind était de renforcer l'apprentissage de la conquête des jeux et de l'IA pour la science. Il est en fait entré très tard dans le LLM. Il n'aurait dû commencer à s'intéresser à cette direction que dans 21 ans, et il rattrape actuellement son retard. Sans parler de Meta, l'accent n'a pas été mis sur le LLM, et maintenant on a l'impression qu'il essaie de rattraper son retard. Il s’agit toujours d’un groupe d’institutions qui s’en sortent le mieux à l’heure actuelle. Si tel est le cas, sans parler des institutions nationales ? Je me sens excusable. Quant à la philosophie d’OpenAI sur le LLM, je parlerai de ma compréhension dans la dernière partie de cet article.

Cet article résume la technologie LLM dominante depuis l'émergence de GPT 3.0 Pour les technologies grand public avant cela, vous pouvez vous référer à "PTM chevauchant le vent et les vagues, interprétation approfondie des progrès de. modèles de pré-formation".

Je pense qu'après avoir lu ces deux articles, vous aurez une compréhension plus claire du contexte technique du domaine LLM, des différents concepts de développement qui ont émergé dans le développement de la technologie LLM, et même des possibles tendances de développement futures. Bien entendu, le contenu mentionné à de nombreux endroits est mon opinion personnelle et est hautement subjectif. Les erreurs et omissions sont inévitables, veuillez donc vous y référer avec prudence.

Cet article tente de répondre à certaines des questions suivantes : ChatGPT a-t-il provoqué un changement de paradigme de recherche dans le domaine de la PNL et même de l'IA ? Si oui, quel impact cela aura-t-il ? Qu’apprend LLM à partir d’énormes quantités de données ? Comment LLM accède-t-il à ces connaissances ? À mesure que l’échelle du LLM augmente progressivement, quel sera l’impact ? Qu’est-ce que l’apprentissage en contexte ? Pourquoi est-ce une technologie mystérieuse ? Quelle est sa relation avec Instruct ? LLM a-t-il des capacités de raisonnement ? Comment fonctionne le CoT de la Chaîne de Pensée ? Attendez, je pense que vous aurez une réponse à ces questions après l'avoir lu.

Tout d'abord, avant de parler de l'état actuel de la technologie LLM, permettez-moi de parler du changement de paradigme de recherche dans mon esprit à un niveau macro. De cette façon, nous pouvons « voir la forêt avant les arbres » et mieux comprendre pourquoi certaines technologies ont tant évolué.

Top de la tendance : La transformation du paradigme de recherche en PNL

Si nous étendons la chronologie plus longtemps, revenons à l'ère de l'apprentissage profond dans le domaine de la PNL et observons les changements technologiques et leur impact sur une fenêtre de temps plus longue, cela peut-être qu'il est plus facile de voir certains des nœuds clés. Je crois personnellement qu’au cours du développement technologique dans le domaine de la PNL au cours des 10 dernières années, deux changements majeurs de paradigme de recherche ont pu se produire.

Paradigm Shift 1.0 : De l'apprentissage profond au modèle de pré-formation en deux étapes

La période couverte par ce changement de paradigme va approximativement de l'introduction de l'apprentissage profond dans le domaine de la PNL (vers 2013 ) vers GPT 3.0 Avant sa sortie (vers mai 2020) .

Avant l'émergence des modèles Bert et GPT, la technologie populaire dans le domaine de la PNL était le modèle d'apprentissage profond, et l'apprentissage profond dans le domaine de la PNL reposait principalement sur les technologies clés suivantes : un grand nombre de modèles LSTM améliorés et un petite quantité de modèles CNN améliorés En tant qu'extracteur de fonctionnalités typique ; utilisez Séquence à Séquence (ou encodeur-décodeur) + Attention comme cadre technique global typique pour diverses tâches spécifiques.

Avec le soutien de ces technologies de base, le principal objectif de recherche de l'apprentissage profond dans le domaine de la PNL, s'il est résumé, est de savoir comment augmenter efficacement la profondeur de la couche de modèle ou la capacité des paramètres du modèle. C'est-à-dire, comment pouvons-nous ajouter continuellement des couches LSTM ou CNN plus profondes à l'encodeur et au décodeur pour atteindre l'objectif d'augmenter la profondeur des couches et la capacité du modèle. Bien que ce type d'effort ait effectivement augmenté continuellement la profondeur du modèle, il n'est globalement pas très efficace du point de vue de l'effet de la résolution de tâches spécifiques. En d'autres termes, par rapport aux méthodes d'apprentissage non approfondies, les avantages qu'il apporte ne sont pas nombreux. super.

La raison pour laquelle l'apprentissage profond n'est pas assez efficace, je pense, est principalement due à deux aspects : d'une part, la quantité totale de données d'entraînement pour une tâche spécifique est limitée. À mesure que la capacité du modèle augmente, il doit être pris en charge par une plus grande quantité de données d'entraînement. Sinon, même si vous pouvez augmenter la profondeur, l'effet de la tâche ne sera pas obtenu. Avant l'émergence des modèles de pré-formation, il était évident qu'il s'agissait d'un problème sérieux dans le domaine de la recherche en PNL ; un autre aspect était que l'extracteur de fonctionnalités LSTM/CNN n'avait pas de fortes capacités d'expression ; Cela signifie que quelle que soit la quantité de données qui vous sont fournies, elles sont inutiles car vous ne pouvez pas absorber efficacement les connaissances contenues dans les données. Ce sont principalement ces deux raisons qui entravent la percée réussie du deep learning dans le domaine de la PNL.

L'émergence de ces deux modèles de pré-formation, Bert/GPT, représente un saut technologique dans le domaine de la PNL, tant du point de vue de la recherche académique que de l'application industrielle, et a entraîné une transformation du paradigme de recherche en tout le champ. L'impact de ce changement de paradigme se reflète sous deux aspects : premièrement, le déclin, voire la disparition progressive de certains sous-domaines de recherche en PNL, deuxièmement, les méthodes techniques et les cadres techniques des différents sous-domaines de la PNL sont de plus en plus unifiés un an après l'émergence de la PNL. Bert À cette époque, la pile technologique a essentiellement convergé vers deux modèles technologiques. Parlons de ces deux points séparément.

Impact 1 : La disparition des tâches intermédiaires

La PNL est un nom collectif pour un domaine de recherche macro, qui comporte une variété de sous-domaines et de sous-directions spécifiques s'il est analysé attentivement, du point de vue. Selon la nature de la tâche, celles-ci peuvent être divisées en deux catégories : l'une peut être appelée « tâches intermédiaires » et l'autre peut être appelée « tâches finales ».

Les tâches intermédiaires typiques incluent : la segmentation des mots chinois, le marquage d'une partie du discours, le NER, l'analyse syntaxique, la résolution de référence, l'analyseur sémantique, etc. Ces types de tâches ne résolvent généralement pas les besoins réels de l'application, et la plupart d'entre eux sont utilisés pour résoudre les besoins réels. Il y a une étape intermédiaire ou une étape auxiliaire de la tâche, par exemple, il n'est presque pas nécessaire de dire : je veux qu'un analyseur syntaxique montre à l'utilisateur l'arbre d'analyse syntaxique de cette phrase. L'utilisateur n'a pas besoin de voir les résultats du traitement de ces étapes intermédiaires de la PNL. Il s'en soucie seulement. Avez-vous bien accompli une tâche spécifique ? Les « tâches finales » incluent la classification de texte, le calcul de similarité de texte, la traduction automatique, le résumé de texte, etc., il y en a beaucoup. La caractéristique de ce type de tâche est que chaque sous-domaine répond à un certain besoin réel et que les résultats de la tâche peuvent être présentés directement à l'utilisateur. Par exemple, l'utilisateur a vraiment besoin de vous donner une phrase en anglais et de lui dire quoi. Le chinois l'est.

Logiquement parlant, les « tâches intermédiaires » ne devraient pas apparaître, et la raison pour laquelle elles existent est le reflet du niveau de développement insuffisant de la technologie PNL. Au début du développement technologique, la technologie étant relativement arriérée, il était difficile d’accomplir des tâches finales difficiles en une seule étape. Prenons l'exemple de la traduction automatique. Aux débuts de la technologie, il était très difficile de faire du bon travail en traduction automatique. C'est pourquoi les chercheurs ont divisé et résolu les problèmes difficiles et les ont décomposés en diverses étapes intermédiaires telles que la segmentation des mots, en partie. -le marquage vocal et l'analyse syntaxique. Ils ont d'abord bien complété chaque étape intermédiaire, puis nous ne pouvons rien faire pour travailler ensemble pour mener à bien la mission finale.

Mais depuis l'émergence de Bert/GPT, il n'est en fait plus nécessaire d'effectuer ces tâches intermédiaires, car grâce à un pré-entraînement avec une grande quantité de données, Bert/GPT a absorbé ces tâches intermédiaires en tant que caractéristiques linguistiques dans les paramètres de Transformer. À ce stade, nous pouvons résoudre directement ces tâches finales de bout en bout sans avoir à modéliser spécifiquement ce processus intermédiaire. La chose la plus controversée ici est peut-être la segmentation des mots chinois. En fait, le principe est le même. Vous n'avez pas à vous soucier des mots qui doivent former un mot. Laissez simplement LLM l'apprendre en tant que fonctionnalité. pour résoudre la tâche, il l'apprendra naturellement.La méthode raisonnable de segmentation des mots de cette étude n'est pas nécessairement la même que les règles de segmentation des mots que nous, les humains, comprenons.

Sur la base de la compréhension ci-dessus, en fait, dès l'apparition de Bert/GPT, vous devriez conclure que ce type de tâches de la phase intermédiaire de la PNL se retirera progressivement de la scène de l'histoire.

Impact 2 : Unification des voies techniques dans différentes directions de recherche

Avant d'expliquer l'impact spécifique, nous discutons d'abord d'une autre façon de diviser les tâches de la PNL, qui est utile pour comprendre le contenu suivant. Si la « tâche finale » est classée plus en détail, elle peut être grossièrement divisée en deux types de tâches différents : les tâches de compréhension du langage naturel et les tâches de génération du langage naturel. Si les « tâches intermédiaires » sont exclues, les tâches typiques de compréhension du langage naturel comprennent la classification de texte, le jugement de relation de phrase, le jugement de tendance émotionnelle, etc. Ces tâches sont essentiellement des tâches de classification, c'est-à-dire saisir une phrase (article) ou deux Une phrase, le modèle fait référence à tout le contenu d'entrée et donne enfin un jugement sur la catégorie à laquelle il appartient. La génération de langage naturel comprend également de nombreuses sous-directions de recherche en PNL, telles que les robots de discussion, la traduction automatique, la synthèse de texte, les systèmes de questions et réponses, etc. La caractéristique de la tâche de génération est qu'étant donné le texte d'entrée, le modèle doit générer une chaîne de texte de sortie en conséquence. La différence entre les deux se reflète principalement dans les formulaires d'entrée et de sortie

Depuis la naissance du modèle Bert/GPT, il y a eu une tendance évidente à l'unification technique. Tout d'abord, les extracteurs de fonctionnalités des différents sous-champs du NLP sont progressivement unifiés de LSTM/CNN à Transformer. En fait, peu de temps après que Bert ait été rendu public, nous aurions dû réaliser que cela deviendrait inévitablement une tendance technologique. Quant à la raison, elle a été expliquée et analysée dans cet article que j'ai écrit il y a quelques années "Zhang Junlin : Abandonnez les illusions et adoptez pleinement Transformer : Comparaison de trois extracteurs de fonctionnalités majeurs (CNN/RNN/TF) pour le traitement du langage naturel". Les étudiants intéressés peuvent s'y référer.

Lien de l'article : https://zhuanlan.zhihu.com/p/54743941

De plus, Transformer unifie non seulement de nombreux domaines de la PNL, mais remplace également progressivement les tâches de traitement d'image largement utilisées dans divers De même, dans le processus d'utilisation de CNN et d'autres modèles, les modèles multimodaux utilisent actuellement essentiellement le modèle Transformer. Ce type de Transformer part de la PNL et unifie progressivement la tendance de plus en plus de domaines de l'IA. Cela a commencé avec le Vision Transformer (ViT) apparu fin 2020. Il a prospéré depuis et a connu un grand succès jusqu'à présent. , et il continue de s'étendre dans davantage de domaines. La dynamique d'expansion deviendra de plus en plus rapide.

Deuxièmement, le modèle de recherche et développement dans la plupart des sous-domaines de la PNL est passé à un modèle en deux étapes : étape de pré-formation du modèle + réglage fin de l'application (Fine-tuning) ou mode d'invite Zero/Few Shot de l'application. Pour être plus précis, diverses tâches de PNL ont en fait convergé vers deux cadres de modèles de pré-formation différents : pour les tâches de compréhension du langage naturel, le système technique a été unifié dans le "modèle de langage bidirectionnel pré-formation + réglage fin de l'application" représenté par Bert. » ; pour les tâches de génération de langage naturel, le système technique est unifié selon le mode « modèle de langage autorégressif (c'est-à-dire, modèle de langage unidirectionnel de gauche à droite) + Zero /Few Shot Prompt » représenté par GPT 2.0. Quant à savoir pourquoi il est divisé en deux itinéraires techniques, c'est inévitable. Nous l'expliquerons plus tard.

Ces deux modèles peuvent sembler similaires, mais ils contiennent des idées de développement très différentes et mèneront à des orientations de développement futures différentes. Malheureusement, la plupart d’entre nous ont sous-estimé le potentiel du GPT en tant que voie de développement à cette époque et ont concentré notre vision sur des modèles comme Bert.

Paradigm Shift 2.0 : Des modèles pré-entraînés à l'intelligence générale artificielle (AGI, Artificial General Intelligence)

La plage de temps couverte par ce changement de paradigme se situe à peu près après l'émergence de GPT3.0 ( 20 ans environ juin), jusqu'à présent, nous devrions être en plein milieu de ce changement de paradigme .

ChatGPT est le nœud clé qui déclenche ce changement de paradigme, mais avant l'émergence d'InstructGPT, LLM était en fait dans une période de transition avant ce changement de paradigme.

Période de transition : Le modèle « modèle de langage autorégressif + Prompting » représenté par GPT 3.0 occupe une position dominante

Comme mentionné précédemment, dans les premiers jours du développement des modèles de pré-formation, le cadre technique a convergé vers le modèle Bert et le modèle GPT Ces deux paradigmes techniques différents, et les gens sont généralement plus optimistes quant au modèle Bert. De nombreuses améliorations techniques ultérieures se trouvent sur le chemin de Bert. Cependant, à mesure que la technologie continue de se développer, vous constaterez que les modèles LLM actuellement les plus importants sont presque tous basés sur le modèle « langage autorégressif + invite » similaire à GPT 3.0, comme GPT 3, PaLM, GLaM, Gopher, Chinchilla, MT. -NLG, LaMDA, etc., aucune exception. Pourquoi cela se produit-il ? Il doit y avoir une certaine fatalité derrière cela, et je pense que cela peut être principalement dû à deux raisons.

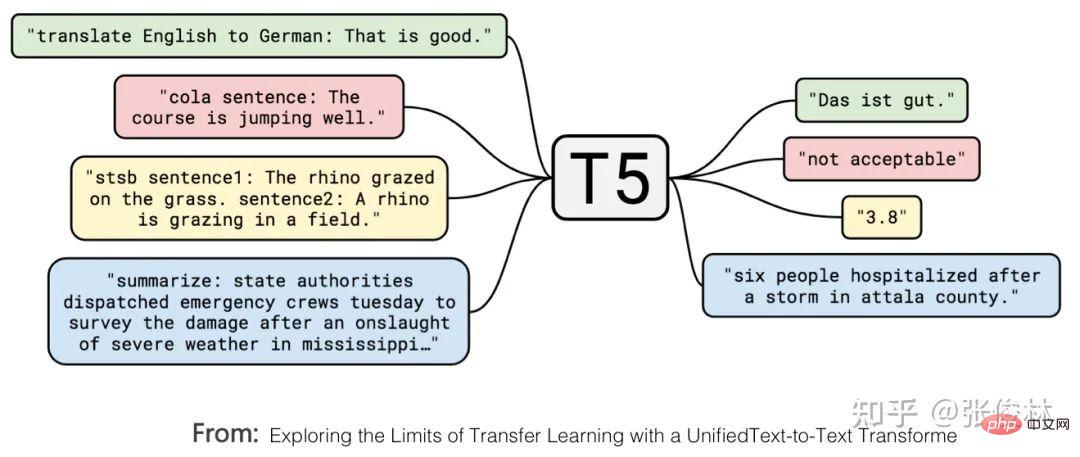

Tout d'abord, Le modèle T5 de Google unifie formellement les expressions externes des tâches de compréhension du langage naturel et de génération du langage naturel. Comme le montre la figure ci-dessus, ce qui est marqué en rouge est un problème de classification de texte, et ce qui est marqué en jaune est un problème de régression ou de classification qui détermine la similitude des phrases. Ce sont deux problèmes typiques de compréhension du langage naturel. Dans le modèle T5, ces problèmes de compréhension du langage naturel sont cohérents avec les problèmes de génération sous forme d'entrée et de sortie. En d'autres termes, le problème de classification peut être converti en modèle LLM pour générer des chaînes de catégories correspondantes, de sorte que la compréhension et la sortie soient cohérentes. les tâches de génération sont exprimées sous la forme L'unité complète est atteinte.

Cela montre que la tâche de génération du langage naturel peut être compatible avec la tâche de compréhension du langage naturel en termes d'expression. Si c'est l'inverse, il sera difficile d'y parvenir. L’avantage est que le même modèle de génération LLM peut résoudre presque tous les problèmes de PNL. Si le mode Bert est toujours adopté, ce modèle LLM ne peut pas bien gérer la tâche de génération. Cela étant, il y a une raison pour laquelle nous avons certainement tendance à utiliser des modèles génératifs.

La deuxième raison, Si vous voulez faire du bon travail avec une invite de tir zéro ou quelques invites de tir, vous devez adopter le mode GPT. Il y a eu des études (Référence : Sur le rôle de la bidirectionnalité dans la pré-formation du modèle de langage) qui ont prouvé que si les tâches en aval sont résolues avec un réglage fin, le mode Bert est meilleur que le mode GPT si l'invite zéro tir/quelques tirs est utilisée ; , ceci Si ce mode résout les tâches en aval, l'effet du mode GPT est meilleur que le mode Bert. Cela montre qu'il est plus facile pour le modèle généré d'effectuer des tâches en mode d'invite zéro tir/quelques tirs, et le mode Bert présente des inconvénients naturels pour effectuer des tâches de cette manière. C'est la deuxième raison.

Mais voici la question : pourquoi cherchons-nous à inciter à zéro tir/quelques tirs pour effectuer des tâches ? Pour expliquer clairement ce problème, nous devons d’abord clarifier une autre question : quel type de modèle LLM est le plus idéal pour nous ?

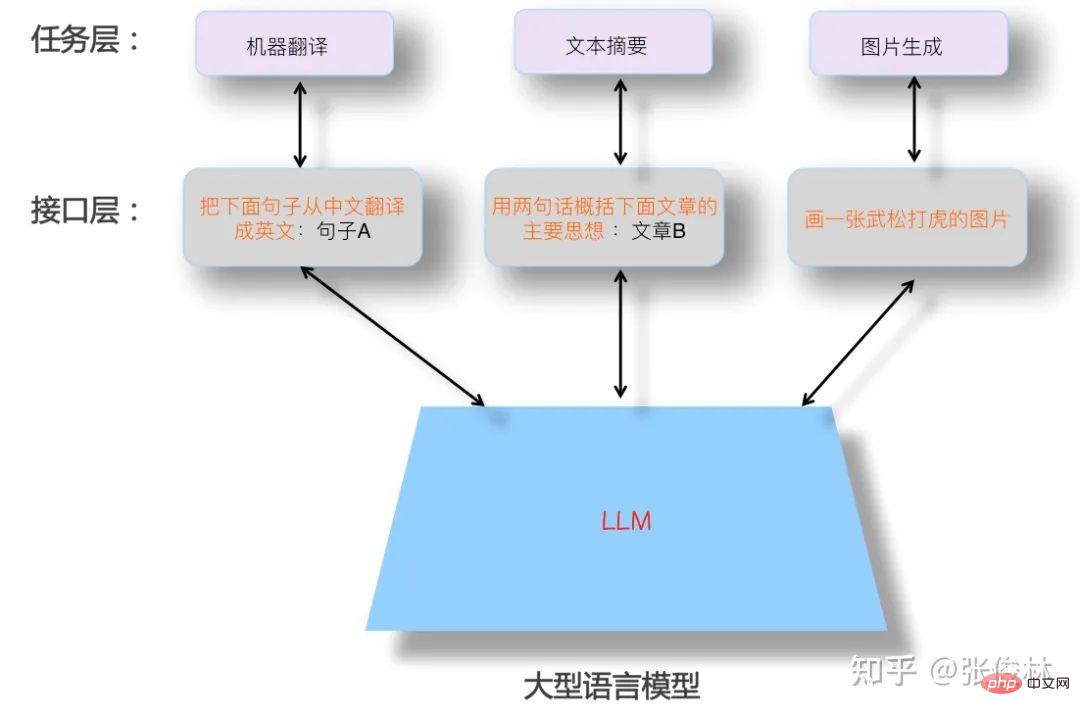

L'image ci-dessus montre à quoi devrait ressembler un LLM idéal. Premièrement, le LLM doit avoir de fortes capacités d’apprentissage autonome. Supposons que nous lui fournissions tous les différents types de données, comme du texte ou des images, disponibles dans le monde, il devrait être capable d'apprendre automatiquement tous les points de connaissance qu'il contient. Le processus d'apprentissage ne nécessite pas d'intervention humaine, et il devrait pouvoir le faire. appliquer avec flexibilité les connaissances acquises pour résoudre des problèmes pratiques. Parce que les données sont massives, pour absorber toutes les connaissances, de nombreux paramètres de modèle sont nécessaires pour stocker les connaissances, ce modèle sera donc inévitablement un modèle géant.

Deuxièmement, LLM devrait être capable de résoudre des problèmes dans n'importe quel sous-domaine de la PNL, et pas seulement de prendre en charge des domaines limités. Il devrait même répondre aux problèmes dans d'autres domaines en dehors de la PNL. Il est préférable que les problèmes dans n'importe quel domaine puissent être résolus. eh bien. Répondez .

De plus, lorsque nous utilisons LLM pour résoudre des problèmes dans un domaine spécifique, nous devons utiliser les expressions auxquelles nous sommes habitués en tant qu'humains, c'est-à-dire que LLM doit comprendre les commandes humaines. Cela reflète le fait de laisser les LLM s'adapter aux gens, plutôt que l'inverse, de laisser les gens s'adapter au modèle LLM. Des exemples typiques de personnes qui s'adaptent au LLM se creusent la tête pour essayer diverses invites dans le but de trouver les bonnes invites qui peuvent mieux résoudre le problème en question. Concernant ce point, la figure ci-dessus donne quelques exemples au niveau de la couche d'interface où les humains interagissent avec LLM pour illustrer ce qu'est une bonne forme d'interface permettant aux utilisateurs d'utiliser le modèle LLM.

Après avoir lu ce LLM idéal, revenons en arrière et expliquons les questions restantes ci-dessus : Pourquoi devrions-nous poursuivre l'incitation à zéro tir/quelques tirs pour accomplir des tâches ? Il y a deux raisons.

Premièrement, l'échelle de ce modèle LLM doit être très énorme, et il doit y avoir très peu d'institutions capables de réaliser ce modèle ou de modifier les paramètres de ce modèle. Les demandeurs de tâches sont des milliers de petites et moyennes organisations ou même des particuliers. Même si vous ouvrez le modèle en open source, ils ne pourront pas déployer le modèle, et encore moins utiliser le mode de réglage fin pour modifier les paramètres du modèle. Par conséquent, nous devrions rechercher un moyen de permettre au demandeur de tâche de terminer la tâche sans modifier les paramètres du modèle, c'est-à-dire que le mode invite devrait être utilisé pour terminer la tâche au lieu du mode de réglage fin (on peut voir que la direction technique du soft inciter va à l’encontre de cette tendance de développement). Le modéliste transforme LLM en service public et l'exécute en mode LLM as Service. En tant que partisan du service, compte tenu des besoins en constante évolution des utilisateurs, les producteurs de modèles LLM doivent poursuivre l'objectif de permettre à LLM d'effectuer autant de types de tâches que possible. C'est un effet secondaire, et c'est aussi un facteur réaliste pour lequel c'est super. les grands modèles poursuivront certainement l'AGI.

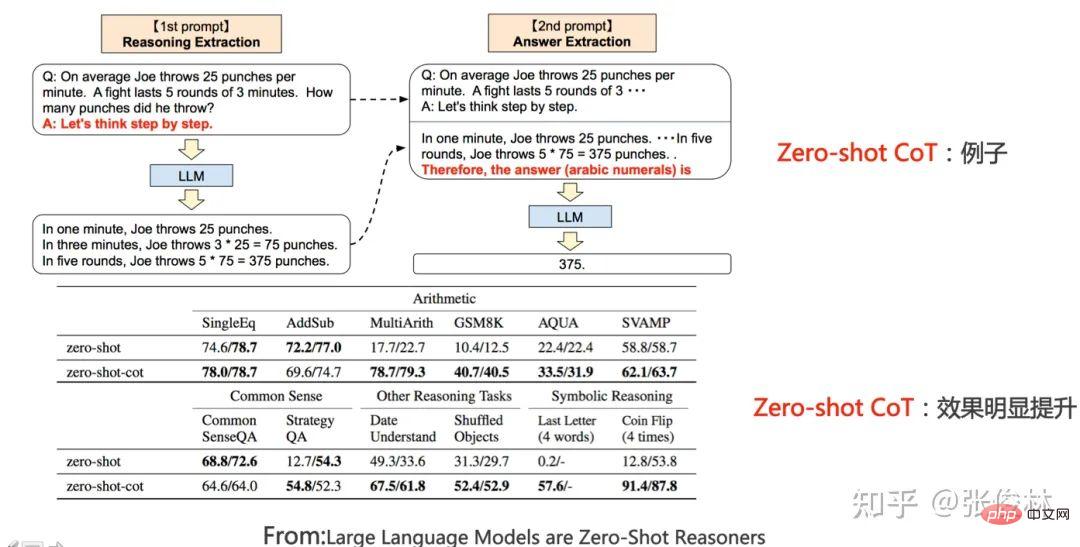

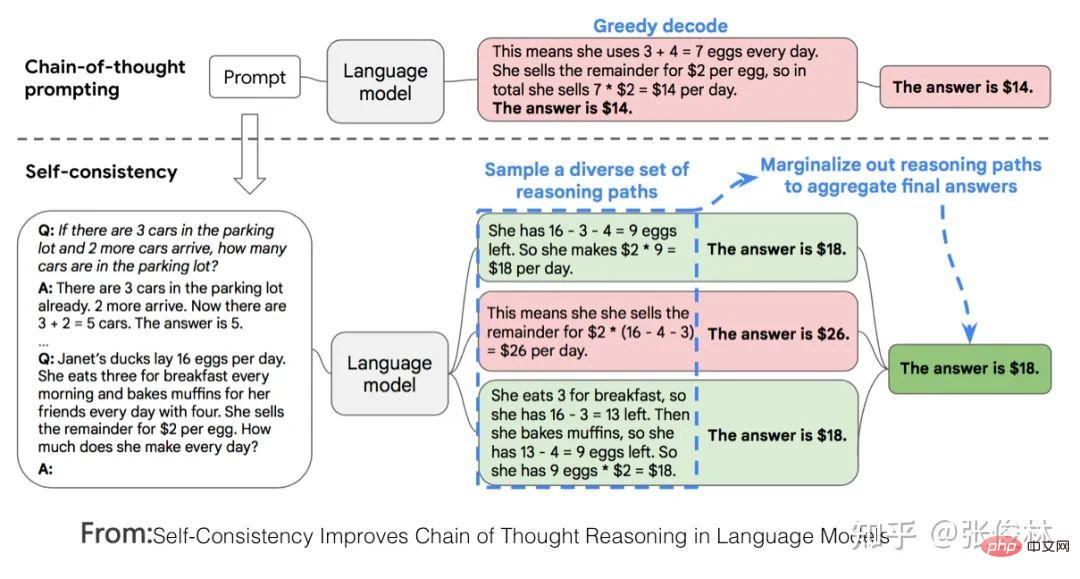

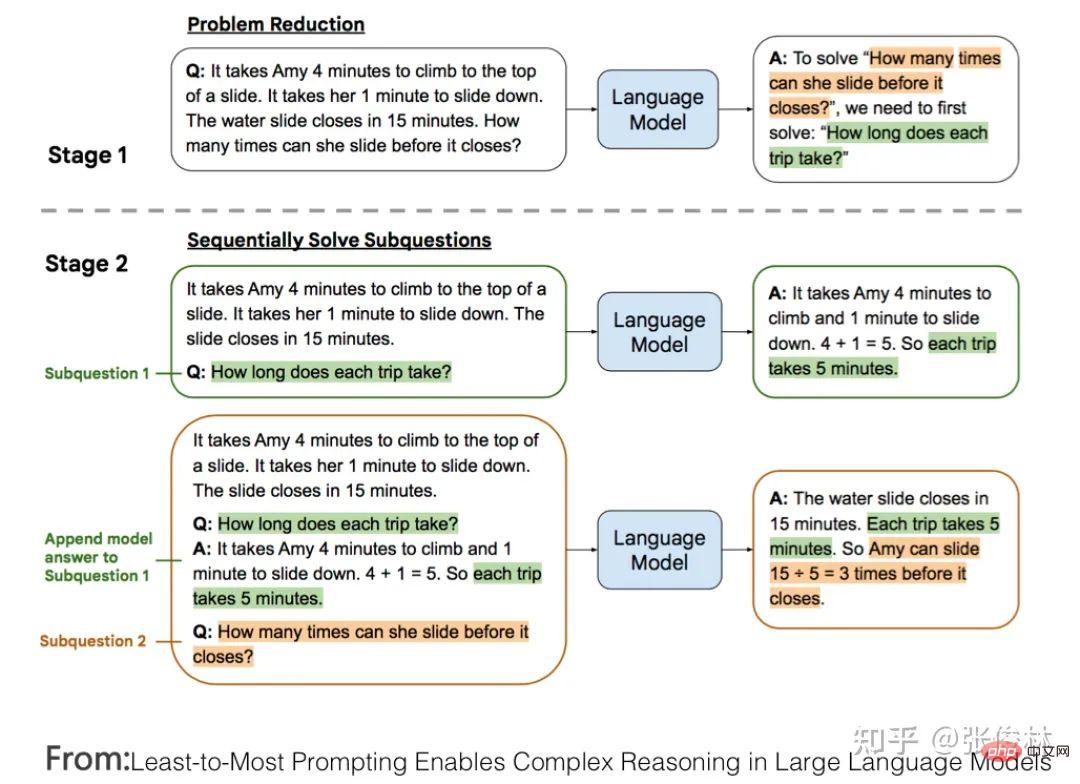

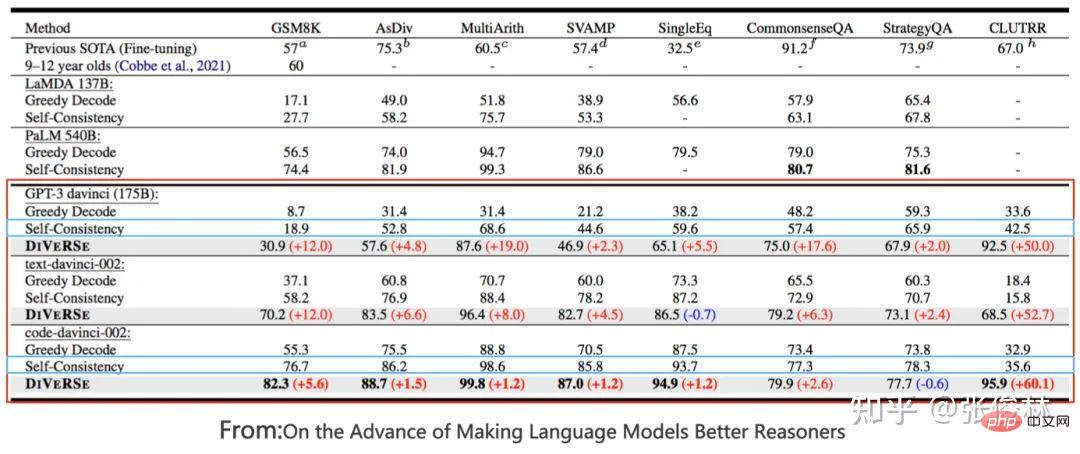

Deuxièmement, qu'il s'agisse d'une invite de tir zéro, d'une invite de tir peu ou même d'une invite de chaîne de pensée (CoT, Chain of Thought) qui favorise la capacité de raisonnement LLM, c'est la couche d'interface existante dans l'image ci-dessus Technologie . Plus précisément, l'intention initiale de l'invite de tir zéro est en fait l'interface idéale entre les humains et LLM. Elle utilise directement la méthode d'expression de tâches à laquelle les humains sont habitués pour laisser LLM faire les choses. Cependant, il a été constaté que LLM ne pouvait pas bien la comprendre et. l'effet n'était pas bon. Après des recherches continues, nous avons découvert que pour une certaine tâche, si nous donnons quelques exemples à LLM et utilisons ces exemples pour représenter la description de la tâche, l'effet sera meilleur que l'invite de tir zéro, de sorte que tout le monde étudie mieux la technologie d'incitation à quelques tirs. On peut comprendre que nous espérions à l'origine que LLM pourrait effectuer une certaine tâche en utilisant des commandes couramment utilisées par les humains, mais la technologie actuelle n'est pas en mesure de le faire, nous avons donc opté pour la meilleure solution et avons utilisé ces technologies alternatives pour exprimer la tâche humaine. exigences.

Si vous comprenez la logique ci-dessus, il est facile de tirer la conclusion suivante : l'incitation à quelques tirs (également connue sous le nom d'apprentissage en contexte) n'est qu'une technologie de transition. Si nous pouvons décrire une tâche plus naturellement et que LLM peut la comprendre, alors nous abandonnerons définitivement ces technologies de transition sans hésitation. La raison est évidente : utiliser ces méthodes pour décrire les exigences d'une tâche n'est pas conforme aux habitudes humaines.

C'est aussi la raison pour laquelle j'ai répertorié GPT 3.0+Prompting comme technologie de transition. L'émergence de ChatGPT a changé ce statu quo et a remplacé Prompting par Instruct, ce qui a entraîné un nouveau changement de paradigme technologique et produit plusieurs suivis. ups.

Impact 1 : Adapter le LLM à une nouvelle interface interactive pour les gens

Dans le cadre d'un LLM idéal, regardons ChatGPT pour mieux comprendre son apport technique. ChatGPT devrait être la méthode technique la plus proche du LLM idéal parmi toutes les technologies existantes. Si je résume les fonctionnalités les plus importantes de ChatGPT, j'utiliserais les huit mots suivants : "Puissant, prévenant ".

"Puissant" Ceci, je crois, devrait être principalement attribué au LLM GPT3.5, la fondation sur laquelle repose ChatGPT. Bien que ChatGPT ait ajouté des données annotées manuellement, ce n'est que par dizaines de milliers. Par rapport aux centaines de milliards de données au niveau des jetons utilisées pour entraîner le modèle GPT 3.5, cette quantité de données contient moins de connaissances mondiales (faits contenus dans les données). ) et le bon sens) peut être décrit comme une goutte d'eau dans l'océan, presque négligeable, et ne jouera fondamentalement aucun rôle dans l'amélioration des capacités de base de GPT 3.5. Par conséquent, ses puissantes fonctions devraient provenir principalement du GPT 3.5 caché derrière lui. GPT 3.5 compare le modèle géant parmi les modèles LLM idéaux.

Alors, ChatGPT injecte-t-il de nouvelles connaissances dans le modèle GPT 3.5 ? Il faut l’injecter. Cette connaissance est contenue dans des dizaines de milliers de données étiquetées manuellement, mais ce qui est injecté n’est pas la connaissance du monde, mais la connaissance des préférences humaines. La « préférence humaine » a plusieurs significations : premièrement, il s’agit d’une manière habituelle pour les humains d’exprimer une tâche. Par exemple, les gens ont l'habitude de dire : « Traduisez la phrase suivante du chinois vers l'anglais » pour exprimer un besoin de « traduction automatique ». Cependant, LLM n'est pas un humain, alors comment peut-il comprendre ce que signifie cette phrase ? Vous devez trouver un moyen de faire comprendre à LLM la signification de cette commande et de l'exécuter correctement. Par conséquent, ChatGPT injecte ce type de connaissances dans GPT 3.5 via l'annotation manuelle des données, ce qui permet à LLM de comprendre plus facilement les commandes humaines. C'est la clé de son « empathie ». Deuxièmement, les humains ont leurs propres normes quant à ce qui constitue une bonne réponse et ce qui est une mauvaise réponse. Par exemple, une réponse plus détaillée est bonne, une réponse au contenu discriminatoire est mauvaise, et ainsi de suite. C'est la préférence humaine pour la qualité des réponses. Les données que les gens renvoient à LLM via le modèle de récompense contiennent ce type d'informations. Dans l'ensemble, ChatGPT injecte des connaissances sur les préférences humaines dans GPT 3.5 pour obtenir un LLM qui comprend la parole humaine et est plus poli.

On peut voir que la plus grande contribution de ChatGPT est qu'il réalise essentiellement la couche d'interface du LLM idéal, permettant à LLM de s'adapter aux expressions de commande habituelles des gens, plutôt que l'inverse. Laissez les gens s'adapter au LLM et se creuser la tête pour trouver une commande qui peut fonctionner (c'est ce que faisait la technologie d'invite avant la sortie de la technologie d'instruction), et cela augmente la facilité d'utilisation et l'expérience utilisateur de. LLM. C'est InstructGPT/ChatGPT qui a été le premier à comprendre ce problème et à fournir une bonne solution, qui constitue également sa plus grande contribution technique. Par rapport aux invites de tir précédentes, il s'agit d'une technologie d'interface homme-machine qui est plus conforme aux habitudes d'expression humaine permettant aux gens d'interagir avec LLM.

Cela inspirera certainement les modèles LLM ultérieurs et continuera à travailler davantage sur des interfaces homme-machine faciles à utiliser pour rendre le LLM plus obéissant.

Impact 2 : De nombreux sous-domaines de la PNL n'ont plus de valeur de recherche indépendante

# 🎜 🎜#En ce qui concerne le domaine de la PNL, ce changement de paradigme signifie que de nombreux domaines de recherche en PNL qui existent actuellement de manière indépendante seront inclus dans le système technologique LLM, n'existeront plus de manière indépendante et disparaîtront progressivement. . Après le premier changement de paradigme, bien que de nombreuses « tâches intermédiaires » en PNL ne soient plus nécessaires pour continuer à exister en tant que domaines de recherche indépendants, la plupart des « tâches finales » existent toujours en tant que domaines de recherche indépendants, mais sont transférées vers la « pré-formation ». . + mise au point », face aux problématiques uniques du domaine, de nouveaux plans d'amélioration ont été proposés les uns après les autres.

Les recherches actuelles montrent que pour de nombreuses tâches PNL, à mesure que la taille du modèle LLM augmente, les performances seront grandement améliorées. Sur cette base, je pense que l'on peut tirer la conclusion suivante : la plupart des problèmes dits "uniques" dans un certain domaine ne sont probablement qu'une apparence externe causée par un manque de connaissances dans le domaine, à condition qu'il y ait suffisamment de connaissances dans le domaine. , ce soi-disant problème propre au domaine sera résolu. Il peut être très bien résolu. En fait, il n'est pas nécessaire de se concentrer sur un problème de terrain spécifique et de travailler dur pour trouver une solution spéciale. Peut-être que la vérité à propos de l'AGI est étonnamment simple : vous donnez simplement plus de données à LLM sur le terrain et vous le laissez apprendre davantage par lui-même.

Dans ce contexte, en même temps, ChatGPT prouve que nous pouvons désormais poursuivre directement le modèle LLM idéal. Ensuite, la future tendance de développement technologique devrait être : poursuivre des modèles LLM de plus en plus grands en augmentant le nombre de données de pré-formation. pour couvrir de plus en plus de domaines, LLM apprend de manière autonome les connaissances du domaine à partir des données du domaine grâce au processus de pré-formation. À mesure que la taille du modèle continue d'augmenter, de nombreux problèmes sont résolus. La recherche se concentrera sur la manière de construire ce modèle LLM idéal, plutôt que sur la résolution de problèmes spécifiques dans un domaine particulier. De cette manière, de plus en plus de sous-domaines de la PNL seront inclus dans le système technique LLM et disparaîtront progressivement.

Je pense que pour juger si la recherche indépendante dans un domaine spécifique doit être arrêtée immédiatement, la norme de jugement peut être l'une des deux méthodes suivantes : premièrement, juger si l'effet de la recherche du LLM sur une certaine tâche dépasse celui des humains Performance, pour les domaines de recherche où l'effet du LLM dépasse celui des humains, il n'est pas nécessaire de mener une recherche indépendante. Par exemple, pour de nombreuses tâches des ensembles de tests GLUE et SuperGLUE, l'effet LLM dépasse actuellement les performances humaines. En fait, il n'est pas nécessaire que les domaines de recherche étroitement liés à cet ensemble de données continuent d'exister de manière indépendante. Deuxièmement, comparez les effets des tâches de deux modes. Le premier mode est le réglage fin avec des données spécifiques à un domaine plus volumineuses, et le deuxième mode est constitué d'invites à quelques tirs ou de méthodes basées sur des instructions. Si l’effet de la deuxième méthode atteint ou dépasse celui de la première méthode, cela signifie qu’il n’est pas nécessaire que ce champ continue d’exister de manière indépendante. Si nous utilisons cette norme, en fait, dans de nombreux domaines de recherche, l'effet de réglage fin est toujours dominant (en raison de la grande quantité de données d'entraînement dans ce domaine de mode), et il semble qu'il puisse exister indépendamment. Cependant, étant donné que pour de nombreuses tâches, à mesure que la taille du modèle augmente, l'effet de quelques tirs continue de croître avec l'émergence de modèles plus grands, ce point d'inflexion est susceptible d'être atteint à court terme.

Si la spéculation ci-dessus est vraie, cela signifiera le fait cruel suivant : pour de nombreux chercheurs dans le domaine de la PNL, ils seront confrontés au choix de savoir où aller s'ils continuent à travailler sur des problèmes propres à ce domaine. ? Ou devrions-nous abandonner cette approche apparemment peu prometteuse et plutôt construire un meilleur LLM ? Si nous choisissons de nous tourner vers la construction de LLM, quelles institutions ont la capacité et les conditions pour le faire ? Quelle serait votre réponse à cette question ?

Impact 3 : Davantage de domaines de recherche autres que la PNL seront inclus dans le système technologique LLM

Si vous vous situez du point de vue de l'AGI et vous référez au modèle LLM idéal décrit précédemment, les tâches qu'il peut accomplir ne devrait pas être limité au domaine de la PNL, ou à un ou deux domaines. Le LLM idéal devrait être un modèle d'intelligence artificielle générale indépendant du domaine. Il fonctionne bien dans un ou deux domaines, mais cela ne signifie pas qu'il peut le faire. faites seulement ces tâches. L'émergence de ChatGPT prouve qu'il est possible pour nous de poursuivre l'AGI au cours de cette période, et qu'il est maintenant temps de mettre de côté les chaînes de la réflexion sur la « discipline de terrain ».

ChatGPT démontre non seulement la capacité à résoudre diverses tâches de PNL dans un format conversationnel fluide, mais possède également de solides capacités de codage. Il est naturel que de plus en plus d'autres domaines de recherche soient progressivement inclus dans le dispositif LLM et fassent partie de l'intelligence artificielle générale.

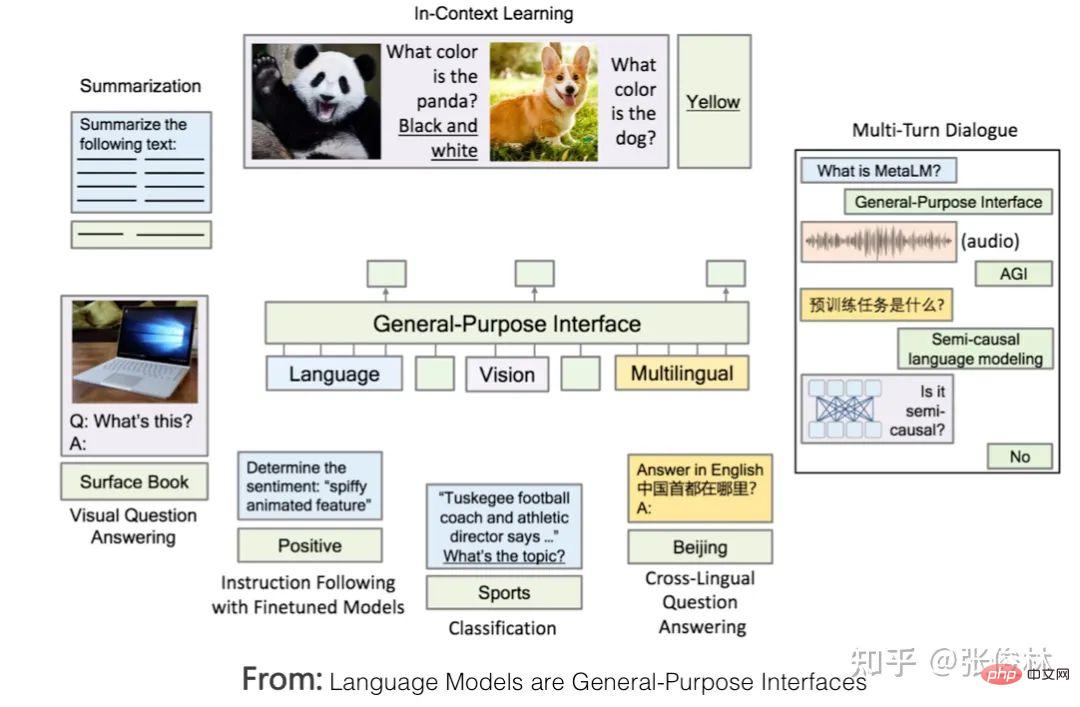

LLM étend son domaine de la PNL vers l'extérieur, et un choix naturel se porte sur le traitement d'images et les tâches associées multimodales. Il y a déjà des efforts pour intégrer la multimodalité et faire de LLM une interface homme-machine universelle qui prend en charge les entrées et sorties multimodales. Des exemples typiques incluent Flamingo de DeepMind et les « modèles de langage sont des interfaces à usage général », comme indiqué ci-dessus. L’approche est démontrée.

Mon jugement est que qu'il s'agisse d'images ou de multimodalité, la future intégration dans LLM pour devenir des fonctions utiles pourrait être plus lente qu'on ne le pense. La raison principale est que, bien que le domaine de l'image ait imité l'approche de pré-formation de Bert au cours des deux dernières années, il tente d'introduire un apprentissage auto-supervisé pour libérer la capacité du modèle à apprendre de manière indépendante des connaissances à partir de données d'image. Les technologies typiques sont « contrastées ». "apprentissage" et MAE. Il s'agit de deux voies techniques différentes. Cependant, à en juger par les résultats actuels, malgré les grands progrès technologiques, il semble que ce chemin ne soit pas encore terminé. Cela se reflète dans l'application de modèles pré-entraînés dans le domaine de l'image aux tâches en aval, ce qui apporte bien moins d'avantages que Bert. ou GPT. Il est appliqué de manière significative aux tâches PNL en aval. Par conséquent, les modèles de prétraitement d’images doivent encore être explorés en profondeur pour libérer le potentiel des données d’image, ce qui retardera leur unification dans de grands modèles LLM. Bien entendu, si cette voie est ouverte un jour, il y a une forte probabilité que la situation actuelle dans le domaine de la PNL se reproduise, c'est-à-dire que divers sous-domaines de recherche en traitement d'images pourraient progressivement disparaître et être intégrés dans des LLM à grande échelle pour effectuer directement les tâches du terminal.

En plus de l'image et de la multimodalité, il est évident que d'autres domaines seront progressivement inclus dans le LLM idéal. Cette direction est en plein essor et constitue un sujet de recherche à forte valeur ajoutée.

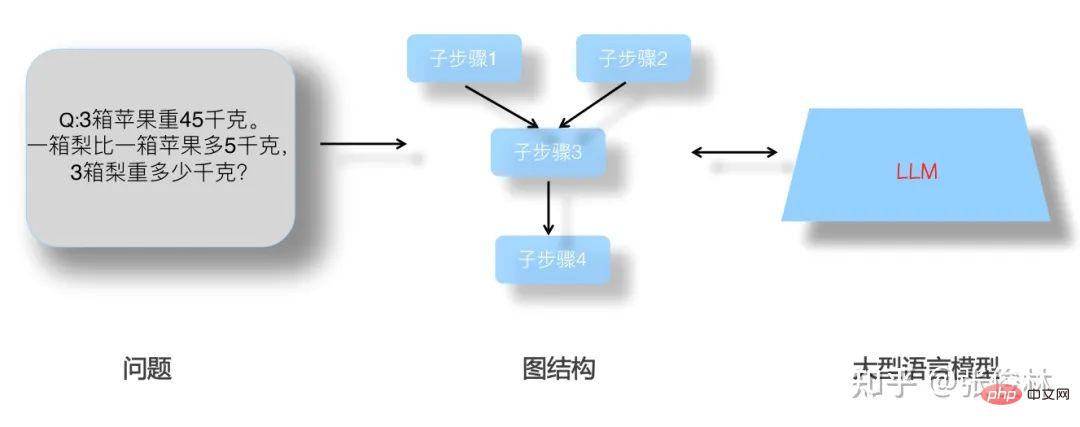

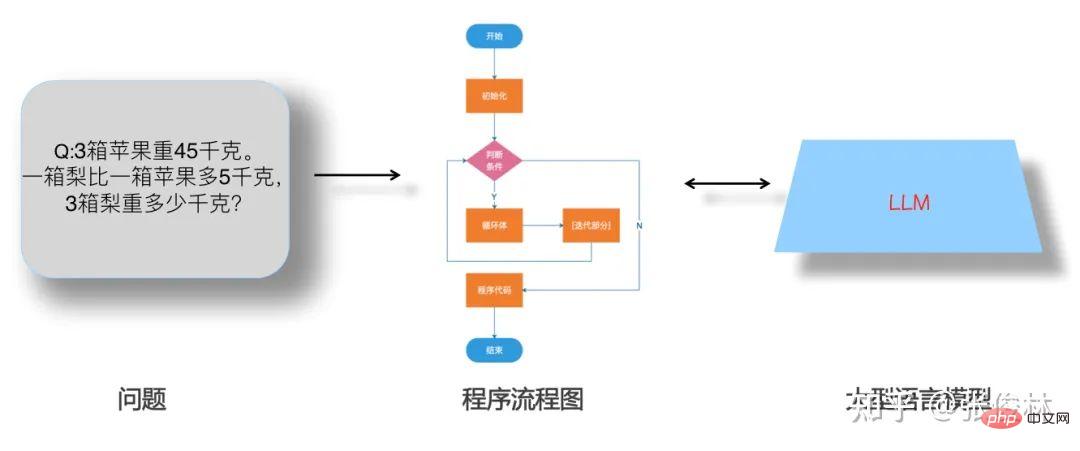

Ce qui précède sont mes réflexions personnelles sur le changement de paradigme. Ensuite, examinons les progrès technologiques traditionnels des modèles LLM après GPT 3.0. Comme le montre le modèle LLM idéal, les technologies associées peuvent en fait être divisées en deux catégories principales : l'une concerne la manière dont le modèle LLM absorbe les connaissances des données, et inclut également l'impact de la croissance de la taille du modèle sur la capacité du LLM à absorber les connaissances de la deuxième catégorie ; est une interface homme-machine expliquant comment les gens utilisent les capacités inhérentes de LLM pour résoudre des tâches, y compris les modes d'apprentissage en contexte et d'instruction. Les invites de chaîne de pensée (CoT), une technologie de raisonnement LLM, appartiennent essentiellement à l'apprentissage en contexte. Parce qu'elles sont plus importantes, j'en parlerai séparément. Apprenants : Des données infinies à des connaissances massives

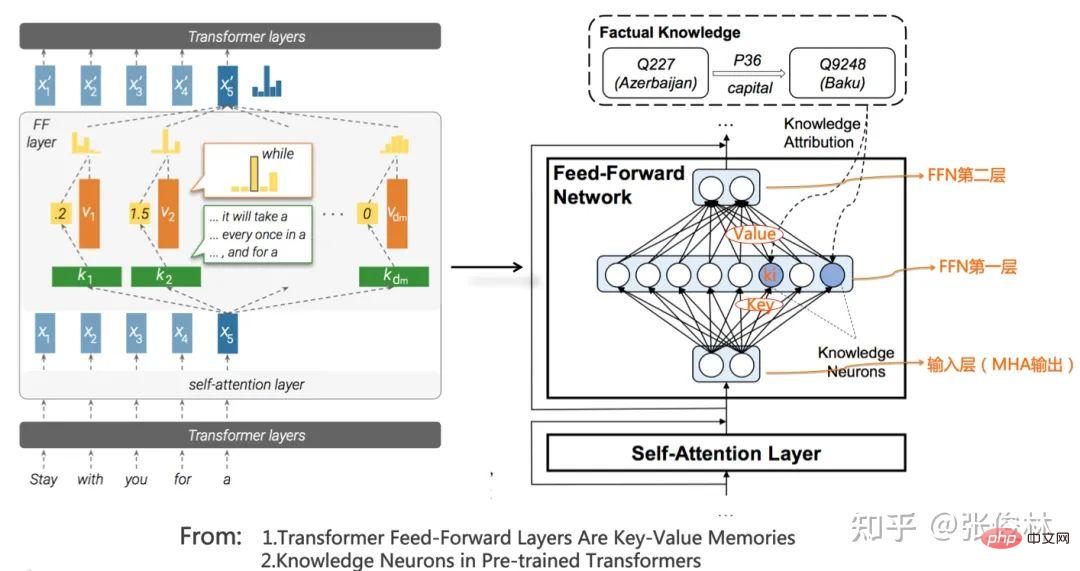

D'après les résultats de recherche actuels, Transformer est un extracteur de fonctionnalités suffisamment puissant et ne nécessite aucune amélioration particulière. Alors, qu’a appris Transformer lors du processus de pré-formation ? Comment accède-t-on à la connaissance ? Comment corriger des connaissances erronées ? Cette section décrit les progrès de la recherche dans ce domaine.

Parcours de la connaissance : quelles connaissances LLM a-t-il apprises

LLM a appris beaucoup de connaissances à partir de textes libres massifs. Si ces connaissances sont grossièrement classées, elles peuvent être divisées enconnaissances linguistiques et connaissances du monde. Deux grandes catégories.

Les connaissances linguistiques font référence aux connaissances lexicales, aux parties du discours, à la syntaxe, à la sémantique et à d'autres connaissances qui aident les humains ou les machines à comprendre le langage naturel. Il existe une longue histoire de recherches sur la capacité du LLM à capturer les connaissances linguistiques. Depuis l'émergence de Bert, les recherches pertinentes se sont poursuivies et des conclusions ont été tirées très tôt. C'est pourquoi il est utilisé. Après la pré-entraînement du modèle, l'une des raisons les plus importantes est que diverses tâches de compréhension du langage naturel ont obtenu des améliorations significatives des performances. En outre, diverses études ont également prouvé que les connaissances linguistiques superficielles telles que la morphologie, les parties du discours, la syntaxe et d'autres connaissances sont stockées dans les structures de bas et de niveau intermédiaire de Transformer, tandis que les connaissances linguistiques abstraites telles que les connaissances sémantiques sont largement distribuées. dans les structures de niveau intermédiaire et supérieur de Transformer.