Reconnaissance d'images : réseau de neurones convolutifs

Cet article est réimprimé du compte public WeChat "Vivre à l'ère de l'information". Pour réimprimer cet article, veuillez contacter le compte public Vivre à l’ère de l’information.

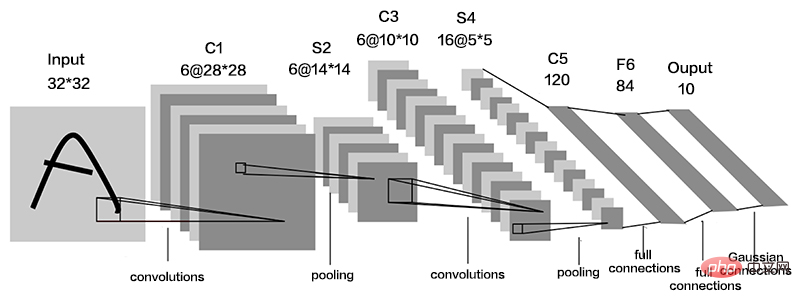

Le réseau neuronal convolutif (CNN) est un réseau spécial à rétroaction profonde, qui comprend généralement une couche d'entrée de données, une couche de convolution, une couche d'activation, une couche de sous-échantillonnage et une couche entièrement connectée.

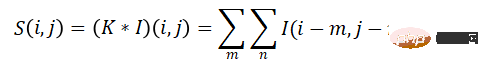

La couche convolutive est une unité importante du réseau neuronal convolutif. Elle se compose d'une série de noyaux de convolution qui filtrent les données. Son essence est le poids de la zone locale de l'image et. le noyau de convolution. Processus de superposition linéaire de sommation pondérée en valeurs. L'image I est utilisée comme entrée et le noyau de convolution bidimensionnel K est utilisé pour la convolution. Le processus de convolution peut être exprimé comme suit :

où I(i,j) est l'image dans. (i, j) La valeur de la position, S (i, j) est la carte des caractéristiques obtenue après l'opération de convolution.

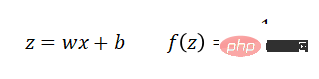

L'opération de convolution d'activation est linéaire, ne peut effectuer qu'un mappage linéaire et a une capacité d'expression limitée. Par conséquent, pour traiter les problèmes de cartographie non linéaire, il est nécessaire d’introduire une fonction d’activation non linéaire. Pour traiter différents problèmes non linéaires, les fonctions d'activation introduites sont également différentes. Les fonctions couramment utilisées sont sigmoïde, tanh, relu, etc.

L'expression de la fonction sigmoïde est :

L'expression de la fonction Tanh est : L'expression de la fonction

Relu est :

La couche de sous-échantillonnage est également appelée couche de pooling. Elle est généralement placée après plusieurs couches convolutives pour réduire la taille de l'image caractéristique. La fonction de pooling utilise les caractéristiques statistiques globales des sorties voisines à une certaine position pour remplacer la sortie du réseau à cette position. Généralement, la couche de pooling a trois fonctions : Premièrement, elle réduit la dimension des fonctionnalités. L'opération de pooling est équivalente à un autre processus d'extraction de fonctionnalités, qui peut supprimer les informations redondantes et réduire le volume de traitement des données de la couche suivante. Deuxièmement, afin d'éviter le surajustement, l'opération de mise en commun obtient des informations plus abstraites et améliore la généralisation. La troisième consiste à maintenir l'invariance des fonctionnalités, et l'opération de pooling conserve les fonctionnalités les plus importantes.

La couche entièrement connectée est généralement placée à la fin du réseau neuronal convolutif, et tous les neurones entre les couches sont connectés avec des poids. Le but est de mapper toutes les fonctionnalités apprises dans le réseau à l'espace d'étiquettes de l'échantillon pour porter des jugements de catégorie. La fonction Softmax est généralement utilisée dans la dernière couche du réseau neuronal comme sortie du classificateur. Chaque valeur émise par la fonction softmax est comprise entre (0, 1).

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

YOLO est immortel ! YOLOv9 est sorti : performances et vitesse SOTA~

Feb 26, 2024 am 11:31 AM

YOLO est immortel ! YOLOv9 est sorti : performances et vitesse SOTA~

Feb 26, 2024 am 11:31 AM

Les méthodes d'apprentissage profond d'aujourd'hui se concentrent sur la conception de la fonction objectif la plus appropriée afin que les résultats de prédiction du modèle soient les plus proches de la situation réelle. Dans le même temps, une architecture adaptée doit être conçue pour obtenir suffisamment d’informations pour la prédiction. Les méthodes existantes ignorent le fait que lorsque les données d’entrée subissent une extraction de caractéristiques couche par couche et une transformation spatiale, une grande quantité d’informations sera perdue. Cet article abordera des problèmes importants lors de la transmission de données via des réseaux profonds, à savoir les goulots d'étranglement de l'information et les fonctions réversibles. Sur cette base, le concept d'information de gradient programmable (PGI) est proposé pour faire face aux différents changements requis par les réseaux profonds pour atteindre des objectifs multiples. PGI peut fournir des informations d'entrée complètes pour la tâche cible afin de calculer la fonction objectif, obtenant ainsi des informations de gradient fiables pour mettre à jour les pondérations du réseau. De plus, un nouveau cadre de réseau léger est conçu

La fondation, la frontière et l'application du GNN

Apr 11, 2023 pm 11:40 PM

La fondation, la frontière et l'application du GNN

Apr 11, 2023 pm 11:40 PM

Les réseaux de neurones graphiques (GNN) ont réalisé des progrès rapides et incroyables ces dernières années. Le réseau neuronal graphique, également connu sous le nom d'apprentissage profond graphique, d'apprentissage de représentation graphique (apprentissage de représentation graphique) ou d'apprentissage profond géométrique, est le sujet de recherche qui connaît la croissance la plus rapide dans le domaine de l'apprentissage automatique, en particulier de l'apprentissage profond. Le titre de ce partage est « Bases, frontières et applications du GNN ». Il présente principalement le contenu général du livre complet « Bases, frontières et applications des réseaux de neurones graphiques » compilé par les chercheurs Wu Lingfei, Cui Peng, Pei Jian et Zhao. Liang. 1. Introduction aux réseaux de neurones graphiques 1. Pourquoi étudier les graphiques ? Les graphiques sont un langage universel pour décrire et modéliser des systèmes complexes. Le graphe en lui-même n’est pas complexe, il se compose principalement d’arêtes et de nœuds. Nous pouvons utiliser des nœuds pour représenter n'importe quel objet que nous voulons modéliser et des arêtes pour représenter deux

Un aperçu des trois architectures de puces traditionnelles pour la conduite autonome dans un seul article

Apr 12, 2023 pm 12:07 PM

Un aperçu des trois architectures de puces traditionnelles pour la conduite autonome dans un seul article

Apr 12, 2023 pm 12:07 PM

Les puces IA actuelles sont principalement divisées en trois catégories : GPU, FPGA et ASIC. Les GPU et les FPGA sont des architectures de puces relativement matures à un stade précoce et sont des puces à usage général. ASIC est une puce personnalisée pour des scénarios d'IA spécifiques. L’industrie a confirmé que les processeurs ne sont pas adaptés au calcul de l’IA, mais qu’ils sont également essentiels dans les applications d’IA. Comparaison de l'architecture de la solution GPU entre le GPU et le CPU Le CPU suit l'architecture von Neumann, dont le cœur est le stockage des programmes/données et l'exécution séquentielle en série. Par conséquent, l'architecture du CPU nécessite une grande quantité d'espace pour placer l'unité de stockage (Cache) et l'unité de contrôle (Control). En revanche, l'unité de calcul (ALU) n'occupe qu'une petite partie, le CPU est donc performant à grande échelle. calcul parallèle.

'Le propriétaire de Bilibili UP a créé avec succès le premier réseau neuronal au monde basé sur la pierre rouge, qui a fait sensation sur les réseaux sociaux et a été salué par Yann LeCun.'

May 07, 2023 pm 10:58 PM

'Le propriétaire de Bilibili UP a créé avec succès le premier réseau neuronal au monde basé sur la pierre rouge, qui a fait sensation sur les réseaux sociaux et a été salué par Yann LeCun.'

May 07, 2023 pm 10:58 PM

Dans Minecraft, la redstone est un élément très important. C'est un matériau unique dans le jeu. Les interrupteurs, les torches de redstone et les blocs de redstone peuvent fournir une énergie semblable à l'électricité aux fils ou aux objets. Les circuits Redstone peuvent être utilisés pour construire des structures permettant de contrôler ou d'activer d'autres machines. Ils peuvent eux-mêmes être conçus pour répondre à une activation manuelle par les joueurs, ou ils peuvent émettre des signaux à plusieurs reprises ou répondre à des changements provoqués par des non-joueurs, tels que le mouvement des créatures. et des objets. Chute, croissance des plantes, jour et nuit, et plus encore. Par conséquent, dans mon monde, Redstone peut contrôler de nombreux types de machines, allant des machines simples telles que les portes automatiques, les interrupteurs d'éclairage et les alimentations stroboscopiques, aux énormes ascenseurs, aux fermes automatiques, aux petites plates-formes de jeu et même aux machines intégrées aux jeux. Récemment, la station B UP principale @

Un drone capable de résister aux vents violents ? Caltech utilise 12 minutes de données de vol pour apprendre aux drones à voler dans le vent

Apr 09, 2023 pm 11:51 PM

Un drone capable de résister aux vents violents ? Caltech utilise 12 minutes de données de vol pour apprendre aux drones à voler dans le vent

Apr 09, 2023 pm 11:51 PM

Lorsque le vent est suffisamment fort pour souffler sur le parapluie, le drone est stable, comme ceci : voler dans le vent fait partie du vol dans les airs. À un niveau élevé, lorsque le pilote fait atterrir l'avion, la vitesse du vent peut être élevée. Ce qui leur pose des défis ; à un niveau moindre, les rafales de vent peuvent également affecter le vol des drones. Actuellement, les drones volent dans des conditions contrôlées, sans vent, ou sont pilotés par des humains à l’aide de télécommandes. Les drones sont contrôlés par les chercheurs pour voler en formations à ciel ouvert, mais ces vols sont généralement effectués dans des conditions et des environnements idéaux. Cependant, pour que les drones puissent effectuer de manière autonome des tâches nécessaires mais routinières, comme la livraison de colis, ils doivent être capables de s'adapter aux conditions de vent en temps réel. Pour rendre les drones plus maniables lorsqu'ils volent face au vent, une équipe d'ingénieurs de Caltech

Multi-chemin, multi-domaine, tout compris ! Google AI publie le modèle général d'apprentissage multi-domaines MDL

May 28, 2023 pm 02:12 PM

Multi-chemin, multi-domaine, tout compris ! Google AI publie le modèle général d'apprentissage multi-domaines MDL

May 28, 2023 pm 02:12 PM

Les modèles d'apprentissage profond pour les tâches de vision (telles que la classification d'images) sont généralement formés de bout en bout avec des données provenant d'un seul domaine visuel (telles que des images naturelles ou des images générées par ordinateur). Généralement, une application qui effectue des tâches de vision pour plusieurs domaines doit créer plusieurs modèles pour chaque domaine distinct et les former indépendamment. Les données ne sont pas partagées entre différents domaines. Lors de l'inférence, chaque modèle gérera un domaine spécifique. Même s'ils sont orientés vers des domaines différents, certaines caractéristiques des premières couches entre ces modèles sont similaires, de sorte que la formation conjointe de ces modèles est plus efficace. Cela réduit la latence et la consommation d'énergie, ainsi que le coût de la mémoire lié au stockage de chaque paramètre du modèle. Cette approche est appelée apprentissage multidomaine (MDL). De plus, les modèles MDL peuvent également surpasser les modèles simples.

1,3 ms prend 1,3 ms ! La dernière architecture de réseau neuronal mobile open source de Tsinghua, RepViT

Mar 11, 2024 pm 12:07 PM

1,3 ms prend 1,3 ms ! La dernière architecture de réseau neuronal mobile open source de Tsinghua, RepViT

Mar 11, 2024 pm 12:07 PM

Adresse papier : https://arxiv.org/abs/2307.09283 Adresse code : https://github.com/THU-MIG/RepViTRepViT fonctionne bien dans l'architecture ViT mobile et présente des avantages significatifs. Ensuite, nous explorons les contributions de cette étude. Il est mentionné dans l'article que les ViT légers fonctionnent généralement mieux que les CNN légers sur les tâches visuelles, principalement en raison de leur module d'auto-attention multi-têtes (MSHA) qui permet au modèle d'apprendre des représentations globales. Cependant, les différences architecturales entre les ViT légers et les CNN légers n'ont pas été entièrement étudiées. Dans cette étude, les auteurs ont intégré des ViT légers dans le système efficace.

Savez-vous que les programmeurs seront en déclin dans quelques années ?

Nov 08, 2023 am 11:17 AM

Savez-vous que les programmeurs seront en déclin dans quelques années ?

Nov 08, 2023 am 11:17 AM

Le magazine "ComputerWorld" a écrit un article disant que "la programmation disparaîtra d'ici 1960" parce qu'IBM a développé un nouveau langage FORTRAN, qui permet aux ingénieurs d'écrire les formules mathématiques dont ils ont besoin, puis de les soumettre à l'ordinateur pour que la programmation se termine. Picture Quelques années plus tard, nous avons entendu un nouveau dicton : tout homme d'affaires peut utiliser des termes commerciaux pour décrire ses problèmes et dire à l'ordinateur quoi faire. Grâce à ce langage de programmation appelé COBOL, les entreprises n'ont plus besoin de programmeurs. Plus tard, il est dit qu'IBM a développé un nouveau langage de programmation appelé RPG qui permet aux employés de remplir des formulaires et de générer des rapports, de sorte que la plupart des besoins de programmation de l'entreprise puissent être satisfaits grâce à lui.