Périphériques technologiques

Périphériques technologiques

IA

IA

Interprétation du dernier article HuggingGPT de Microsoft, qu'avez-vous appris ?

Interprétation du dernier article HuggingGPT de Microsoft, qu'avez-vous appris ?

Interprétation du dernier article HuggingGPT de Microsoft, qu'avez-vous appris ?

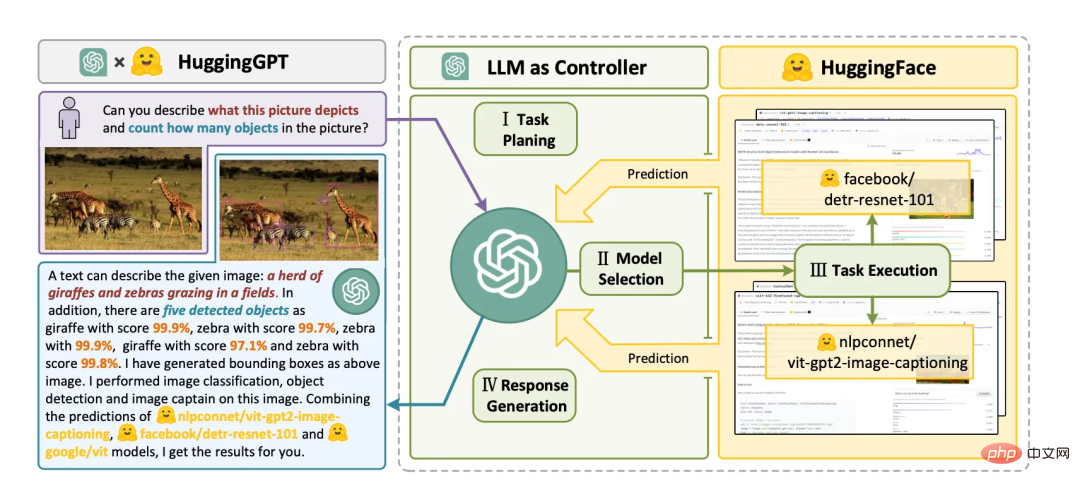

Microsoft a récemment publié un article sur HuggingGPT. Adresse d'origine : HuggingGPT : Résoudre les tâches d'IA avec ChatGPT et ses amis dans Hugging Face[1]. Cet article est une interprétation de l’article.

HuggingGPT : résoudre des tâches d'IA avec ChatGPT et ses amis en Hugging Face Traduit en chinois : HuggingGPT : résoudre des tâches d'IA avec ChatGPT et ses amis en Hugging Face.

Quels sont ses amis ? Après avoir lu l'article, il devrait s'agir du grand modèle de langage représenté par GPT4 et de divers modèles experts. Le modèle expert évoqué dans cet article est relatif au modèle général et est un modèle dans un domaine précis, comme un modèle dans le domaine médical, un modèle dans le domaine financier, etc.

Hugging Face est une communauté et une plateforme d'apprentissage automatique open source.

Vous pouvez rapidement comprendre le contenu principal de l'article en répondant aux questions suivantes.

- Quelle est l'idée derrière HuggingGPT et comment ça marche ?

- L'idée derrière HuggingGPT est d'utiliser de grands modèles de langage (LLM) comme contrôleurs pour gérer les modèles d'IA et résoudre des tâches d'IA complexes. HuggingGPT fonctionne en tirant parti des atouts de LLM en matière de compréhension et de raisonnement pour disséquer les demandes des utilisateurs et les décomposer en plusieurs sous-tâches. Ensuite, sur la base de la description du modèle expert, HuggingGPT attribue le modèle le plus adapté à chaque tâche et intègre les résultats des différents modèles. Le flux de travail de HuggingGPT comprend quatre étapes : la planification des tâches, la sélection du modèle, l'exécution des tâches et la génération de réponses. Vous pouvez trouver plus d’informations aux pages 4 et 16 du fichier PDF.

- Quelle est l'idée derrière HuggingGPT et comment ça marche ?

- L'idée derrière HuggingGPT est d'utiliser de grands modèles de langage (LLM) comme contrôleurs pour gérer les modèles d'IA et résoudre des tâches d'IA complexes. Le principe de fonctionnement de HuggingGPT est de profiter des avantages de LLM en matière de compréhension et de raisonnement pour analyser les intentions des utilisateurs et décomposer les tâches en plusieurs sous-tâches. Ensuite, sur la base de la description du modèle expert, HuggingGPT attribue le modèle le plus adapté à chaque tâche et intègre les résultats des différents modèles. Le flux de travail de HuggingGPT comprend quatre étapes : la planification des tâches, la sélection du modèle, l'exécution des tâches et la génération de réponses. Vous pouvez trouver plus d’informations aux pages 4 et 16 du fichier PDF.

- Comment HuggingGPT utilise-t-il le langage comme interface commune pour améliorer les modèles d'IA ?

- HuggingGPT utilise le langage comme interface commune pour améliorer les modèles d'IA en utilisant un grand modèle de langage (LLM) comme contrôleur pour gérer l'IA modèle. LLM peut comprendre et raisonner les demandes en langage naturel des utilisateurs, puis décomposer la tâche en plusieurs sous-tâches. Sur la base de la description du modèle expert, HuggingGPT attribue le modèle le plus adapté à chaque sous-tâche et intègre les résultats des différents modèles. Cette approche permet à HuggingGPT de couvrir des tâches d'IA complexes dans de nombreuses modalités et domaines différents, notamment le langage, la vision, la parole et d'autres tâches difficiles. Vous pouvez trouver plus d’informations aux pages 1 et 16 du fichier PDF.

- Comment HuggingGPT utilise-t-il de grands modèles de langage pour gérer les modèles d'IA existants ?

- HuggingGPT utilise de grands modèles de langage comme interfaces pour acheminer les demandes des utilisateurs vers des modèles experts, combinant efficacement les capacités de compréhension linguistique des grands modèles de langage et d'autres expertises de modèles experts. Le grand modèle de langage agit comme le cerveau de la planification et de la prise de décision, tandis que le petit modèle agit comme l'exécuteur de chaque tâche spécifique. Ce protocole de collaboration entre modèles offre de nouvelles façons de concevoir des modèles généraux d’IA. (Page 3-4)

- Quels types de tâches d'IA complexes HuggingGPT peut-il résoudre ?

- HuggingGPT peut résoudre un large éventail de tâches couvrant diverses modalités telles que le langage, l'image, l'audio et la vidéo, y compris la détection, la génération, Diverses formes de tâches telles que la classification et les questions et réponses. Des exemples de 24 tâches que HuggingGPT peut résoudre incluent la classification de texte, la détection d'objets, la segmentation sémantique, la génération d'images, la réponse aux questions, la synthèse vocale et la synthèse texte-vidéo. (Page 3)

- HuggingGPT peut-il être utilisé avec différents types de modèles d'IA, ou est-il limité à des modèles spécifiques ?

- HuggingGPT n'est pas limité à des modèles d'IA ou à des tâches de perception visuelle spécifiques ? Il peut résoudre des tâches dans n'importe quelle modalité ou domaine en organisant la coopération entre les modèles via de grands modèles de langage. Grâce à la planification de grands modèles de langage, les processus de tâches peuvent être spécifiés efficacement et des problèmes plus complexes peuvent être résolus. HuggingGPT adopte une approche plus ouverte, en attribuant et en organisant les tâches selon les descriptions de modèles. (Page 4)

peut être compris par analogie avec le concept d'architecture de microservices et d'architecture cloud native, qui sont très populaires actuellement. HuggingGPT est le contrôleur, qui peut être implémenté avec GPT4 et est responsable du traitement des entrées et de la décomposition du langage naturel. , planification et planification. Ce que l'on appelle la planification signifie la planification pour les travailleurs, c'est-à-dire d'autres grands modèles de langage (LLM) et des modèles experts (modèles de domaine spécifiques). Enfin, le travailleur renvoie les résultats du traitement au contrôleur et au contrôleur. intègre les résultats, les convertit en langage naturel et les restitue à l'utilisateur.

Le flux de travail de HuggingGPT se compose de quatre étapes :

- Planification des tâches : utilisez ChatGPT pour analyser les demandes des utilisateurs, comprendre leurs intentions et les décomposer en tâches résolubles.

- Sélection de modèles : pour résoudre les tâches planifiées, ChatGPT sélectionne les modèles d'IA hébergés sur Hugging Face en fonction de leurs descriptions.

- Exécution de la tâche : appelez et exécutez chaque modèle sélectionné et renvoyez les résultats à ChatGPT.

- Générer une réponse : Enfin, utilisez ChatGPT pour intégrer les prédictions de tous les modèles et générer une réponse.

Lien de citation

[1] HuggingGPT : Résoudre les tâches d'IA avec ChatGPT et ses amis dans Hugging Face : https://arxiv.org/pdf/2104.06674.pdf

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Sujets chauds

Comment résoudre le problème de l'interface tiers renvoyant 403 dans l'environnement Node.js?

Mar 31, 2025 pm 11:27 PM

Comment résoudre le problème de l'interface tiers renvoyant 403 dans l'environnement Node.js?

Mar 31, 2025 pm 11:27 PM

Résolvez le problème de l'interface tiers renvoyant 403 dans l'environnement Node.js. Lorsque nous utilisons Node.js pour appeler des interfaces tierces, nous rencontrons parfois une erreur de 403 à partir de l'interface renvoyant 403 ...

Dans Laravel, comment gérer la situation où les codes de vérification ne sont pas envoyés par e-mail?

Mar 31, 2025 pm 11:48 PM

Dans Laravel, comment gérer la situation où les codes de vérification ne sont pas envoyés par e-mail?

Mar 31, 2025 pm 11:48 PM

La méthode de traitement de l'échec de l'e-mail de Laravel à envoyer le code de vérification est d'utiliser Laravel ...

Comment définir automatiquement les autorisations d'UnixSocket après le redémarrage du système?

Mar 31, 2025 pm 11:54 PM

Comment définir automatiquement les autorisations d'UnixSocket après le redémarrage du système?

Mar 31, 2025 pm 11:54 PM

Comment définir automatiquement les autorisations d'UnixSocket après le redémarrage du système. Chaque fois que le système redémarre, nous devons exécuter la commande suivante pour modifier les autorisations d'UnixSocket: sudo ...

Pourquoi une erreur se produit-elle lors de l'installation d'une extension à l'aide de PECL dans un environnement Docker? Comment le résoudre?

Apr 01, 2025 pm 03:06 PM

Pourquoi une erreur se produit-elle lors de l'installation d'une extension à l'aide de PECL dans un environnement Docker? Comment le résoudre?

Apr 01, 2025 pm 03:06 PM

Causes et solutions pour les erreurs Lors de l'utilisation de PECL pour installer des extensions dans un environnement Docker Lorsque nous utilisons un environnement Docker, nous rencontrons souvent des maux de tête ...

Comment implémenter le tri et ajouter des classements dans des tableaux bidimensionnels PHP?

Apr 01, 2025 am 07:00 AM

Comment implémenter le tri et ajouter des classements dans des tableaux bidimensionnels PHP?

Apr 01, 2025 am 07:00 AM

Explication détaillée du tri et de la mise en œuvre du tableau bidimensionnel PHP Cet article expliquera en détail comment trier un tableau bidimensionnel PHP et utiliser chaque sous-tableau en fonction des résultats de tri ...

Comment PHP implémente-t-il le cryptage AES et le décryptage conformément à Java?

Apr 01, 2025 am 07:15 AM

Comment PHP implémente-t-il le cryptage AES et le décryptage conformément à Java?

Apr 01, 2025 am 07:15 AM

Comment implémenter le cryptage et le déchiffrement AES avec Java ...

Comment obtenir le code de retour lorsque l'envoi par e-mail échoue à Laravel?

Apr 01, 2025 pm 02:45 PM

Comment obtenir le code de retour lorsque l'envoi par e-mail échoue à Laravel?

Apr 01, 2025 pm 02:45 PM

Méthode pour obtenir le code de retour lorsque l'envoi par e-mail de Laravel échoue. Lorsque vous utilisez Laravel pour développer des applications, vous rencontrez souvent des situations où vous devez envoyer des codes de vérification. Et en réalité ...

Comment implémenter la fonction de dialogue liée au contexte dans l'API d'Openai?

Apr 01, 2025 am 08:33 AM

Comment implémenter la fonction de dialogue liée au contexte dans l'API d'Openai?

Apr 01, 2025 am 08:33 AM

Comment implémenter les paramètres de l'interface contextuelle de Chatgpt? Lorsque vous utilisez l'interface d'Openai, la fonction de mise en œuvre d'une fonction de questions-réponses est relativement simple et la documentation officielle fournit également des détails ...