Périphériques technologiques

Périphériques technologiques

IA

IA

L'Université du Wisconsin-Madison et d'autres ont publié conjointement un article ! Le dernier grand modèle multimodal LLaVA est sorti et son niveau est proche de GPT-4

L'Université du Wisconsin-Madison et d'autres ont publié conjointement un article ! Le dernier grand modèle multimodal LLaVA est sorti et son niveau est proche de GPT-4

L'Université du Wisconsin-Madison et d'autres ont publié conjointement un article ! Le dernier grand modèle multimodal LLaVA est sorti et son niveau est proche de GPT-4

Le réglage fin des commandes visuelles est populaire.

Cet article s'appelle Visual Instruction Tuning et est produit conjointement par l'Université du Wisconsin-Madison, Microsoft Research et l'Université de Columbia.

Les auteurs incluent Haotian Liu, Chunyuan Li, Qingyang Wu et Yong Jae Lee.

Dans le même temps, les chercheurs ont également ouvert leur code, leurs modèles et leurs ensembles de données sur GitHub. Le document est également publié sur Arxiv.

Explication

Alors quelle est exactement la fonction de LLaVA ? Si vous vous plongez dans le journal, cela peut paraître un peu étrange à ceux qui ne le connaissent pas.

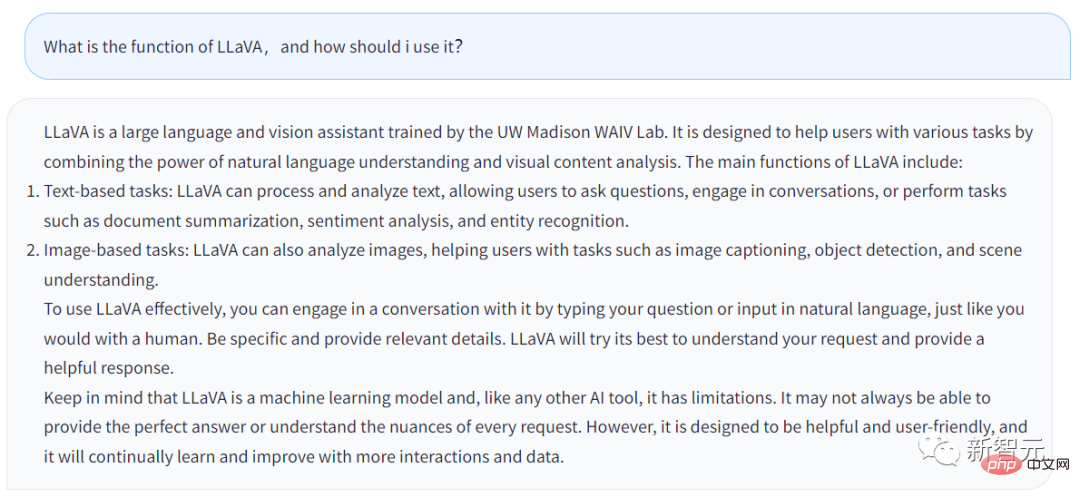

Voyons d'abord ce que dit LLaVA.

La réponse ci-dessus est générée à partir du chatbot de LLaVA. La question que j'ai posée est la suivante : quelle est la fonction de LLaVA et comment les utilisateurs peuvent-ils en profiter ?

La réponse est la suivante :

LLaVA est une grande assistante linguistique et visuelle formée au laboratoire UW Madison WAIV. LLaVA est conçu pour aider les utilisateurs à gérer diverses tâches en tirant parti de ses capacités de compréhension du langage naturel et de ses capacités d'analyse de contenu visuel.

Les principales fonctionnalités de LLaVA incluent :

· Tâches basées sur du texte : LLaVA peut traiter et analyser du texte, permettant aux utilisateurs de poser des questions, LLaVA peut parler aux utilisateurs ou effectuer des tâches saisies par les utilisateurs, telles que Talk. sur l'affinement des résumés de documents, l'analyse des sentiments, la reconnaissance des entités, etc.

· Tâches basées sur l'image : LLaVA peut analyser des images, décrire des images, effectuer une reconnaissance d'objets, ainsi qu'analyser et comprendre des scènes.

Si les utilisateurs souhaitent mieux utiliser LLaVA, ils peuvent parler directement à LLaVA, tout comme parler aux humains. Fournissez autant de détails que possible et LLaVA générera une réponse plus complète.

En même temps, vous devez vous rappeler qu'après tout, LLaVA est un modèle d'apprentissage automatique et un outil d'IA. Tant qu’il s’agit d’un outil, il a ses limites. LLaVA peut ne pas être en mesure de répondre parfaitement aux questions saisies par les utilisateurs à chaque fois.

Bien sûr, LLaVA apprend et s'améliore également constamment, et ses fonctions deviendront de plus en plus puissantes.

De manière générale, il ressort de la réponse de LLaVA que les fonctions du Chatbot ne sont pas très différentes de celles du GPT. Mais LLaVA peut gérer certaines tâches liées aux images.

Exhibiting Color

Les chercheurs ont détaillé les détails techniques de LLaVA dans un article sur Arxiv.

Il est important de savoir que l'utilisation d'instructions générées par la machine pour suivre les données afin d'affiner les instructions des grands modèles de langage (LLM) améliore les capacités du point zéro pour les nouvelles tâches, mais cette idée a été moins explorée dans le multi- champ modal.

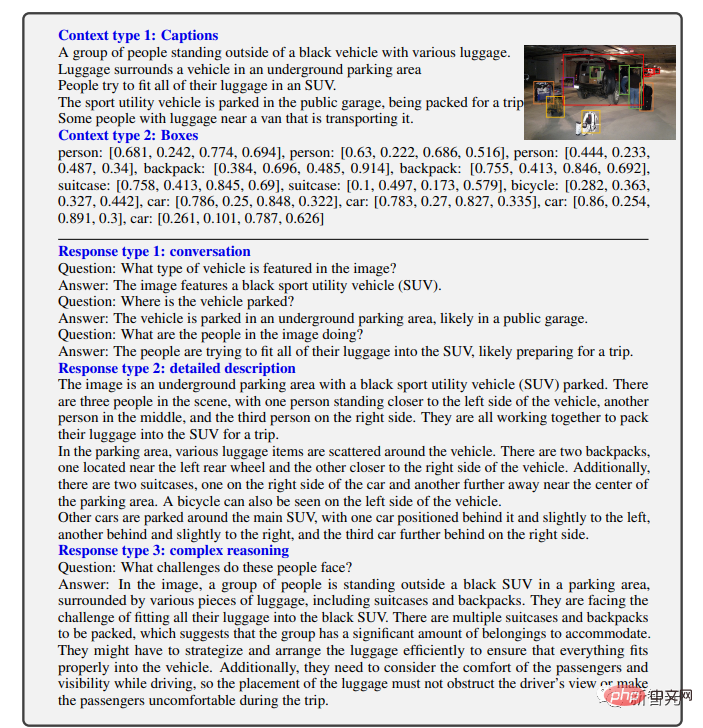

Dans cet article, les chercheurs ont d'abord tenté d'utiliser GPT-4 uniquement en langage pour générer des données de suivi de commande pour des images en langage multimodal.

En conditionnant les instructions sur ces données générées, les chercheurs introduisent LLaVA : un assistant de langage et de vision à grande échelle, un modèle multimodal à grande échelle formé de bout en bout qui connecte des encodeurs visuels et des LLM pour la vision générale et compréhension du langage.

Les premières expériences montrent que LLaVA démontre des capacités de chat multimodales impressionnantes, produisant parfois des performances GPT-4 multimodales sur des images/instructions invisibles et suivant des instructions multimodales synthétiques. Par rapport à GPT-4 sur l'ensemble de données, il a atteint un score relatif de 85,1%.

Une fois affinée pour le magazine Science, la synergie de LLaVA et GPT-4 a atteint une nouvelle précision de pointe de 92,53 %.

Les chercheurs ont divulgué les données, les modèles et la base de code pour les ajustements de commandes visuelles générés par GPT-4.

Modèle multimodal

Clarifiez d’abord la définition.

Le modèle multimodal à grande échelle fait référence à un modèle basé sur la technologie d'apprentissage automatique qui peut traiter et analyser plusieurs types d'entrée, tels que du texte et des images.

Ces modèles sont conçus pour gérer un plus large éventail de tâches et sont capables de comprendre différentes formes de données. En prenant du texte et des images en entrée, ces modèles améliorent leur capacité à comprendre et à compiler des explications pour générer des réponses plus précises et pertinentes.

Les humains interagissent avec le monde à travers de multiples canaux tels que la vision et le langage, car chaque canal individuel présente des avantages uniques pour représenter et transmettre certains concepts du monde, propices ainsi à une meilleure compréhension du monde.

L'une des principales aspirations de l'intelligence artificielle est de développer un assistant universel capable de suivre efficacement des instructions visuelles et linguistiques multimodales, cohérentes avec les intentions humaines, et d'effectuer une variété de tâches du monde réel.

En conséquence, la communauté des développeurs constate un regain d'intérêt pour le développement de modèles de vision fondamentaux améliorés par le langage et dotés de puissantes capacités de compréhension visuelle en monde ouvert, telles que la classification, la détection, la segmentation, la description, ainsi que la génération et l'édition de vision.

Dans ces fonctionnalités, chaque tâche est résolue indépendamment par un seul grand modèle visuel, avec des instructions de tâche implicitement prises en compte dans la conception du modèle.

De plus, le langage n'est utilisé que pour décrire le contenu de l'image. Cela permet au langage de jouer un rôle important dans la cartographie des signaux visuels avec la sémantique linguistique – un canal commun pour la communication humaine. Mais cela aboutit à des modèles qui ont souvent des interfaces fixes avec une interactivité et une adaptabilité limitées aux instructions de l'utilisateur.

Et les grands modèles de langage (LLM) montrent que le langage peut jouer un rôle plus large : une interface commune pour un assistant universel, diverses instructions de tâches peuvent être explicitement exprimées dans le langage et guider de bout en bout le changement d'assistant neuronal formé. Go à la tâche qui vous intéresse et la résoudre.

Par exemple, le récent succès de ChatGPT et GPT-4 a prouvé la capacité de ce LLM à suivre les instructions humaines et a stimulé un énorme intérêt pour le développement de LLM open source.

LLaMA est un LLM open source dont les performances sont équivalentes à GPT-3. Les travaux en cours exploitent diverses instructions de haute qualité générées par la machine à la suite d'échantillons pour améliorer les capacités d'alignement du LLM, rapportant des performances impressionnantes par rapport aux LLM propriétaires. Il est important de noter que cette ligne de travail est uniquement composée de texte.

Dans cet article, les chercheurs proposent le réglage des commandes visuelles, qui est la première tentative d'étendre le réglage des commandes dans un espace multimodal et ouvre la voie à la création d'un assistant visuel universel. Plus précisément, le contenu principal de l'article comprend :

Instruction multimodale suivant les données. Un défi majeur est le manque d’instructions visuelles pour suivre les données. Nous présentons une perspective et un pipeline de réforme des données qui utilisent ChatGPT/GPT-4 pour convertir les paires image-texte en formats de suivi de commande appropriés.

Grand modèle multimodal. Les chercheurs ont développé un grand modèle multimodal (LMM) en connectant l'encodeur visuel ouvert de CLIP et le décodeur de langage LaMA, et les ont peaufinés de bout en bout sur les données pédagogiques visuelles-verbales générées. Des études empiriques vérifient l'efficacité du réglage des instructions LMM à l'aide des données générées et fournissent des suggestions pratiques pour créer un agent visuel général suivant les instructions. Avec GPT 4, l’équipe de recherche a atteint des performances de pointe sur l’ensemble de données d’inférence multimodale Science QA.

Open source. L'équipe de recherche a rendu public les éléments suivants : les données d'instructions multimodales générées, une bibliothèque de codes pour la génération de données et la formation de modèles, des points de contrôle de modèles et une démonstration de chat visuel.

Affichage des résultats

On peut voir que LLaVA peut gérer toutes sortes de problèmes, et les réponses générées sont à la fois complètes et logiques.

LLaVA présente des capacités multimodales proches du niveau du GPT-4, avec un score relatif GPT-4 de 85% en termes de chat visuel.

En termes de questions et réponses de raisonnement, LLaVA a même atteint le nouveau SoTA-92,53%, battant la chaîne de pensée multimodale.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Le modèle MoE open source le plus puissant au monde est ici, avec des capacités chinoises comparables à celles du GPT-4, et le prix ne représente que près d'un pour cent de celui du GPT-4-Turbo.

May 07, 2024 pm 04:13 PM

Le modèle MoE open source le plus puissant au monde est ici, avec des capacités chinoises comparables à celles du GPT-4, et le prix ne représente que près d'un pour cent de celui du GPT-4-Turbo.

May 07, 2024 pm 04:13 PM

Imaginez un modèle d'intelligence artificielle qui non seulement a la capacité de surpasser l'informatique traditionnelle, mais qui permet également d'obtenir des performances plus efficaces à moindre coût. Ce n'est pas de la science-fiction, DeepSeek-V2[1], le modèle MoE open source le plus puissant au monde est ici. DeepSeek-V2 est un puissant mélange de modèle de langage d'experts (MoE) présentant les caractéristiques d'une formation économique et d'une inférence efficace. Il est constitué de 236B paramètres, dont 21B servent à activer chaque marqueur. Par rapport à DeepSeek67B, DeepSeek-V2 offre des performances plus élevées, tout en économisant 42,5 % des coûts de formation, en réduisant le cache KV de 93,3 % et en augmentant le débit de génération maximal à 5,76 fois. DeepSeek est une entreprise explorant l'intelligence artificielle générale

KAN, qui remplace MLP, a été étendu à la convolution par des projets open source

Jun 01, 2024 pm 10:03 PM

KAN, qui remplace MLP, a été étendu à la convolution par des projets open source

Jun 01, 2024 pm 10:03 PM

Plus tôt ce mois-ci, des chercheurs du MIT et d'autres institutions ont proposé une alternative très prometteuse au MLP – KAN. KAN surpasse MLP en termes de précision et d’interprétabilité. Et il peut surpasser le MLP fonctionnant avec un plus grand nombre de paramètres avec un très petit nombre de paramètres. Par exemple, les auteurs ont déclaré avoir utilisé KAN pour reproduire les résultats de DeepMind avec un réseau plus petit et un degré d'automatisation plus élevé. Plus précisément, le MLP de DeepMind compte environ 300 000 paramètres, tandis que le KAN n'en compte qu'environ 200. KAN a une base mathématique solide comme MLP est basé sur le théorème d'approximation universelle, tandis que KAN est basé sur le théorème de représentation de Kolmogorov-Arnold. Comme le montre la figure ci-dessous, KAN a

La fenêtre contextuelle plein écran de Microsoft exhorte les utilisateurs de Windows 10 à se dépêcher et à passer à Windows 11

Jun 06, 2024 am 11:35 AM

La fenêtre contextuelle plein écran de Microsoft exhorte les utilisateurs de Windows 10 à se dépêcher et à passer à Windows 11

Jun 06, 2024 am 11:35 AM

Selon l'actualité du 3 juin, Microsoft envoie activement des notifications en plein écran à tous les utilisateurs de Windows 10 pour les encourager à passer au système d'exploitation Windows 11. Ce déplacement concerne les appareils dont les configurations matérielles ne prennent pas en charge le nouveau système. Depuis 2015, Windows 10 occupe près de 70 % des parts de marché, établissant ainsi sa domination en tant que système d'exploitation Windows. Cependant, la part de marché dépasse largement la part de marché de 82 %, et la part de marché dépasse largement celle de Windows 11, qui sortira en 2021. Même si Windows 11 est lancé depuis près de trois ans, sa pénétration sur le marché est encore lente. Microsoft a annoncé qu'il mettrait fin au support technique de Windows 10 après le 14 octobre 2025 afin de se concentrer davantage sur

Microsoft publie la mise à jour cumulative Win11 août : amélioration de la sécurité, optimisation de l'écran de verrouillage, etc.

Aug 14, 2024 am 10:39 AM

Microsoft publie la mise à jour cumulative Win11 août : amélioration de la sécurité, optimisation de l'écran de verrouillage, etc.

Aug 14, 2024 am 10:39 AM

Selon les informations de ce site du 14 août, lors de la journée d'événement Patch Tuesday d'aujourd'hui, Microsoft a publié des mises à jour cumulatives pour les systèmes Windows 11, notamment la mise à jour KB5041585 pour 22H2 et 23H2 et la mise à jour KB5041592 pour 21H2. Après l'installation de l'équipement mentionné ci-dessus avec la mise à jour cumulative d'août, les changements de numéro de version attachés à ce site sont les suivants : Après l'installation de l'équipement 21H2, le numéro de version est passé à Build22000.314722H2. le numéro de version est passé à Build22621.403723H2. Après l'installation de l'équipement, le numéro de version est passé à Build22631.4037. Le contenu principal de la mise à jour KB5041585 pour Windows 1121H2 est le suivant : Amélioration : Amélioré.

Les robots Tesla travaillent dans les usines, Musk : Le degré de liberté des mains atteindra 22 cette année !

May 06, 2024 pm 04:13 PM

Les robots Tesla travaillent dans les usines, Musk : Le degré de liberté des mains atteindra 22 cette année !

May 06, 2024 pm 04:13 PM

La dernière vidéo du robot Optimus de Tesla est sortie, et il peut déjà fonctionner en usine. À vitesse normale, il trie les batteries (les batteries 4680 de Tesla) comme ceci : Le responsable a également publié à quoi cela ressemble à une vitesse 20 fois supérieure - sur un petit "poste de travail", en sélectionnant et en sélectionnant et en sélectionnant : Cette fois, il est publié L'un des points forts de la vidéo est qu'Optimus réalise ce travail en usine, de manière totalement autonome, sans intervention humaine tout au long du processus. Et du point de vue d'Optimus, il peut également récupérer et placer la batterie tordue, en se concentrant sur la correction automatique des erreurs : concernant la main d'Optimus, le scientifique de NVIDIA Jim Fan a donné une évaluation élevée : la main d'Optimus est l'un des robots à cinq doigts du monde. le plus adroit. Ses mains ne sont pas seulement tactiles

Aucune donnée OpenAI requise, rejoignez la liste des grands modèles de code ! UIUC publie StarCoder-15B-Instruct

Jun 13, 2024 pm 01:59 PM

Aucune donnée OpenAI requise, rejoignez la liste des grands modèles de code ! UIUC publie StarCoder-15B-Instruct

Jun 13, 2024 pm 01:59 PM

À la pointe de la technologie logicielle, le groupe de l'UIUC Zhang Lingming, en collaboration avec des chercheurs de l'organisation BigCode, a récemment annoncé le modèle de grand code StarCoder2-15B-Instruct. Cette réalisation innovante a permis une percée significative dans les tâches de génération de code, dépassant avec succès CodeLlama-70B-Instruct et atteignant le sommet de la liste des performances de génération de code. Le caractère unique de StarCoder2-15B-Instruct réside dans sa stratégie d'auto-alignement pur. L'ensemble du processus de formation est ouvert, transparent et complètement autonome et contrôlable. Le modèle génère des milliers d'instructions via StarCoder2-15B en réponse au réglage fin du modèle de base StarCoder-15B sans recourir à des annotations manuelles coûteuses.

Surpassant largement le DPO : l'équipe de Chen Danqi a proposé une optimisation simple des préférences SimPO et a également affiné le modèle open source 8B le plus puissant.

Jun 01, 2024 pm 04:41 PM

Surpassant largement le DPO : l'équipe de Chen Danqi a proposé une optimisation simple des préférences SimPO et a également affiné le modèle open source 8B le plus puissant.

Jun 01, 2024 pm 04:41 PM

Afin d'aligner les grands modèles de langage (LLM) sur les valeurs et les intentions humaines, il est essentiel d'apprendre les commentaires humains pour garantir qu'ils sont utiles, honnêtes et inoffensifs. En termes d'alignement du LLM, une méthode efficace est l'apprentissage par renforcement basé sur le retour humain (RLHF). Bien que les résultats de la méthode RLHF soient excellents, certains défis d’optimisation sont impliqués. Cela implique de former un modèle de récompense, puis d'optimiser un modèle politique pour maximiser cette récompense. Récemment, certains chercheurs ont exploré des algorithmes hors ligne plus simples, dont l’optimisation directe des préférences (DPO). DPO apprend le modèle politique directement sur la base des données de préférence en paramétrant la fonction de récompense dans RLHF, éliminant ainsi le besoin d'un modèle de récompense explicite. Cette méthode est simple et stable

Yolov10 : explication détaillée, déploiement et application en un seul endroit !

Jun 07, 2024 pm 12:05 PM

Yolov10 : explication détaillée, déploiement et application en un seul endroit !

Jun 07, 2024 pm 12:05 PM

1. Introduction Au cours des dernières années, les YOLO sont devenus le paradigme dominant dans le domaine de la détection d'objets en temps réel en raison de leur équilibre efficace entre le coût de calcul et les performances de détection. Les chercheurs ont exploré la conception architecturale de YOLO, les objectifs d'optimisation, les stratégies d'expansion des données, etc., et ont réalisé des progrès significatifs. Dans le même temps, le recours à la suppression non maximale (NMS) pour le post-traitement entrave le déploiement de bout en bout de YOLO et affecte négativement la latence d'inférence. Dans les YOLO, la conception de divers composants manque d’une inspection complète et approfondie, ce qui entraîne une redondance informatique importante et limite les capacités du modèle. Il offre une efficacité sous-optimale et un potentiel d’amélioration des performances relativement important. Dans ce travail, l'objectif est d'améliorer encore les limites d'efficacité des performances de YOLO à la fois en post-traitement et en architecture de modèle. à cette fin