La liste des recherches sur l'IA les plus populaires en juillet est sortie !

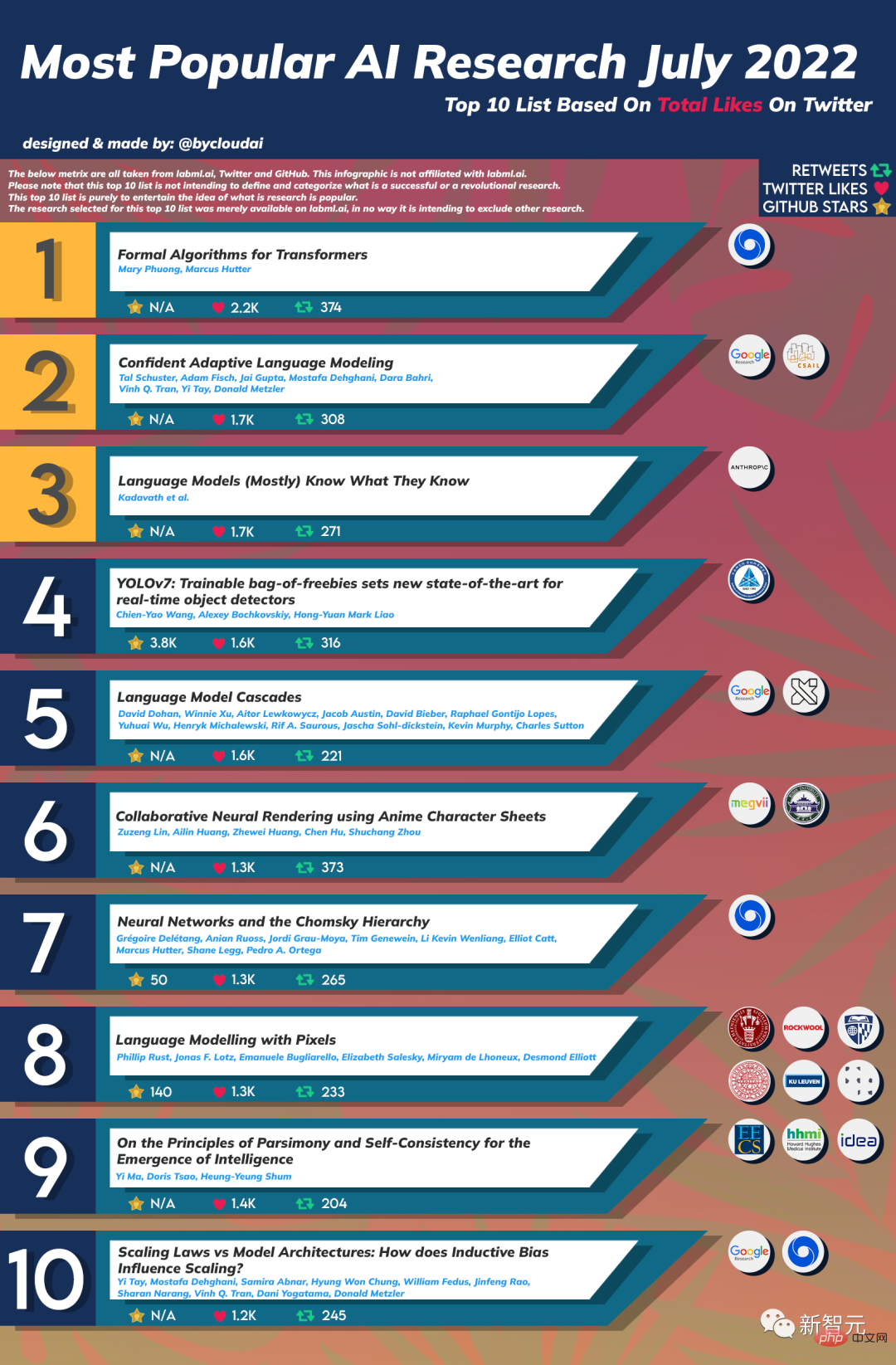

Cette liste compilée par l'utilisateur de Reddit @bycloudai est classée parmi les dix meilleures recherches sur l'IA en juillet 2022 sur la base des likes sur Twitter, des retweets et des stars de Github, notamment DeepMind, Google, MIT CSAIL et d'autres mécanismes bien connus.

Voyons qui sont les grands sur la liste ~

Auteur : Mary Phuong, Marcus Hutter

Organisation : DeepMind

Résumé : Objectif de cet article avant de devenir un aperçu autonome et mathématiquement précis de l'architecture et des algorithmes de Transformer. Il couvre ce que sont les Transformers, comment ils sont formés, leurs utilisations, leurs composants architecturaux clés et un aperçu des modèles les plus importants.

Auteurs : Tal Schuster, Adam Fisch, Jai Gupta, Mostafa Dehghani, Dara Bahri, Vinh Q Tran, Yi Tay, Donald Metzler

Institution : Google, MIT CSAIL

Résumé : Les progrès récents dans les grands modèles de langage (LLM) basés sur Transformer ont entraîné des améliorations significatives des performances sur de nombreuses tâches. Cependant, même si les performances s'améliorent, la taille du modèle augmente également considérablement, ce qui peut entraîner des processus d'inférence complexes et une augmentation des coûts. En pratique, cependant, les grands modèles de langage produisent une série d’itérations comportant différents degrés de difficulté.

Dans ce travail, nous introduisons le Confident Adaptive Language Model-ing (CALM), un cadre qui alloue dynamiquement différentes quantités d'entrées informatiques et la durée de génération.

Le décodage de sortie anticipée implique plusieurs problèmes que nous abordons ici, tels que : (1) quelle métrique de confiance utiliser ; (2) relier les contraintes au niveau de la séquence aux décisions de sortie pour les jetons locaux ; (3) le retour en arrière en raison du masquage avancé des jetons précédents ; représentation perdue à la sortie. Grâce à une analyse théorique et à des expériences sur trois tâches de génération de texte différentes, nous démontrons l'efficacité de notre cadre pour réduire le calcul - en l'accélérant potentiellement jusqu'à 3x tout en maintenant des performances élevées.

Auteurs : Saurav Kadavath, Tom Conerly, Amanda Askell, Tom Henighan, etc.

Institution : Anthropic

Résumé : Cet article étudie si les modèles linguistiques peuvent évaluer eux-mêmes la validité des affirmations et prédire à quelles questions ils seront capables de répondre correctement. Nous montrons d’abord que lorsque des modèles plus grands sont fournis dans le format correct, ils se calibrent bien à une variété de questions à choix multiples et de questions vrai/faux. Par conséquent, nous pouvons auto-évaluer la tâche d’échantillonnage ouvert en demandant au modèle de proposer d’abord une réponse, puis d’évaluer la probabilité P(Vrai) que sa réponse soit correcte.

Nous trouvons les performances, l’étalonnage et la mise à l’échelle de P(True) passionnants dans une variété de tâches. Les performances de l’auto-évaluation s’améliorent encore lorsque nous permettons au modèle de considérer plusieurs de ses propres échantillons avant de prédire la validité d’une possibilité particulière. Ensuite, nous étudions si nous pouvons entraîner un modèle pour prédire P(IK), la probabilité de « Je connais la réponse à la question », sans référence à une réponse spécifique suggérée.

Auteur : Chien-Yao Wang, Alexey Bochkovskiy, Hong-Yuan Mark Liao

Institution : Institut d'information Science, Academia Sinica

Auteur : David Dohan, Winnie Xu, Aitor Lewkowycz, etc.

Institution : Google

Institution : DeepMind

Top8 : Modélisation du langage avec Pixels

Top8 : Modélisation du langage avec PixelsAuteur : Phillip Rust, Jonas F. Lotz, Emanuele Bugliarello, etc.

Institution : Université de Copenhague, Université Johns Hopkins, Université d'Uppsala

Auteurs : Ma Yi, Cao Ying, Shen Xiangyang

Institution : Université de Californie, Berkeley, Guangdong-Hong Kong-Macao Greater Bay Area Institut de recherche sur l'économie numérique

Cet article est une revue de recherche sur l'émergence et le développement de l'intelligence artificielle publiée par le professeur Ma Yi, l'informaticien Dr Shen Xiangyang et le neuroscientifique professeur Cao Ying. du développement de l’IA au cours des 70 dernières années.

Auteur : Yi Tay, Mostafa Dehghani, Samira Abnar

Institution : Google, DeepMind

Après avoir lu les articles des 10 meilleurs experts, parlons de quelques détails intéressants de cette liste.

Comme nous le savons tous, les likes Twitter peuvent être générés par des robots. L’utilisation par l’auteur du nombre de likes comme indicateur clé de la liste est en effet sujette à caution.

De plus, le "Infinite Visual Generation Model NUWA-Infinity", précédemment très demandé, ne s'est classé que 12e en termes de nombre de likes sur Twitter, mais son nombre d'étoiles Github a dépassé 2,4k.

Depuis que NUWA Infinity a publié sa première version dès novembre 2021, cette liste ne compte que le nombre de likes pour la deuxième version suivante, elle n'est donc classée que 12ème.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Comment envoyer votre position à quelqu'un d'autre

Comment envoyer votre position à quelqu'un d'autre

Méthode de requête de nom de domaine de deuxième niveau

Méthode de requête de nom de domaine de deuxième niveau

Comment exécuter cmd en tant qu'administrateur

Comment exécuter cmd en tant qu'administrateur

accéder à la base de données

accéder à la base de données

Formule de la loi de conservation de l'énergie mécanique

Formule de la loi de conservation de l'énergie mécanique

Quelle devise est MULTI ?

Quelle devise est MULTI ?

Explication détaillée de la commande dd

Explication détaillée de la commande dd

La différence entre nohup et &

La différence entre nohup et &