Périphériques technologiques

Périphériques technologiques

IA

IA

La fonction d'inversion fait passer le modèle de ré-identification de 88,54 % à 0,15 %

La fonction d'inversion fait passer le modèle de ré-identification de 88,54 % à 0,15 %

La fonction d'inversion fait passer le modèle de ré-identification de 88,54 % à 0,15 %

La première version de cet article a été rédigée en mai 2018, et elle a été récemment publiée en décembre 2022. J'ai reçu beaucoup de soutien et de compréhension de la part de mes patrons au cours des quatre dernières années.

(J'espère aussi que cette expérience encouragera les étudiants qui soumettent des articles. Si vous rédigez bien l'article, vous gagnerez certainement, n'abandonnez pas facilement !)

La première version de arXiv est : Attaque de requête via la fonctionnalité de direction opposée : vers une récupération d'images robuste

Lien papier : https://link.springer.com/article/10.1007/s11263-022-01737-y

Lien de sauvegarde papier : https://zdzheng.xyz/files/IJCV_Retrieval_Robustness_CameraReady.pdf

Code : https://github.com/layumi/U_turn

Thor : Zhedong Zheng, Liang Zheng, Yi Yang et Fei Wu

Par rapport aux versions précédentes,

- Nous avons apporté quelques ajustements à la formule

- Ajout de nombreuses nouvelles discussions sur les travaux connexes ; Attaque de requête multi-échelle/attaque par boîte noire / Défendre les expériences sous trois angles différents ;

- Ajouter de nouvelles méthodes et de nouvelles méthodes de visualisation sur Food256, Market-1501, CUB, Oxford, Paris et d'autres ensembles de données.

- Attaqué la structure PCB dans reid et WiderResNet dans Cifar10.

- Cas réels

En utilisation réelle. Par exemple, nous voulons attaquer le système de récupération d'images de Google ou de Baidu pour faire de la grande actualité (brouillard). Nous pouvons télécharger une image d'un chien, calculer les caractéristiques via le modèle imagenet (ou d'autres modèles, de préférence un modèle proche du système de récupération), et calculer le bruit adverse plus en retournant les caractéristiques (la méthode dans cet article). Revenons au chien. Utilisez ensuite la fonction de recherche d'images pour le chien après l'attaque. Vous pouvez voir que Baidu et le système de Google ne peuvent pas renvoyer de contenu lié au chien. Bien que nous, les humains, puissions toujours reconnaître qu’il s’agit d’une image d’un chien.

P.S. J'ai également essayé d'attaquer Google pour rechercher des images. Les gens peuvent toujours reconnaître qu'il s'agit d'une image de chien, mais Google renvoie souvent des images liées à une « mosaïque ». J'estime que Google n'utilise pas tous des fonctionnalités profondes, ou alors c'est assez différent du modèle imagenet. Du coup, après une attaque, on a souvent tendance à être "mosaïque" à la place d'autres catégories d'entités (avions, etc.). Bien sûr, la mosaïque peut être considérée dans une certaine mesure comme une réussite !

Quoi

1. L'intention initiale de cet article est en fait très simple. Le modèle Reid existant ou modèle de récupération de paysage a atteint un taux de rappel Rappel-1 de plus de 95 %, pouvons-nous donc concevoir un moyen d'attaquer. récupération ? D'une part, explorons le contexte du modèle REID. D'autre part, l'attaque vise une meilleure défense.

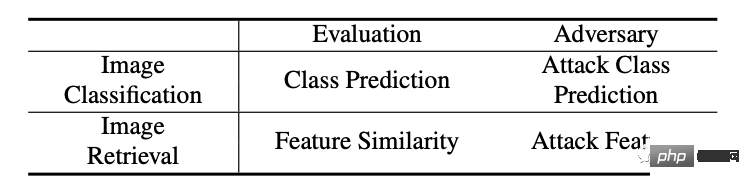

2. La différence entre le modèle de récupération et le modèle de classification traditionnel est que le modèle de récupération utilise les caractéristiques extraites pour comparer les résultats (tri), ce qui est assez différent du modèle de classification traditionnel, comme le montre le tableau ci-dessous.

4. Lors du test du modèle de récupération, il y a deux parties de données : l'une est la requête d'image et l'autre est la galerie d'images (la quantité de données est importante et généralement inaccessible). Compte tenu de la faisabilité pratique, notre méthode ciblera principalement l’image de la requête d’attaque pour provoquer des résultats de récupération erronés.

Comment

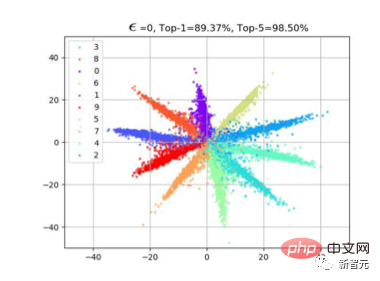

1. Une idée naturelle est celle des caractéristiques d'attaque. Alors comment attaquer les fonctionnalités ? Sur la base de nos observations précédentes sur la perte d'entropie croisée (veuillez vous référer à l'article Perte softmax à grande marge). Souvent, lorsque nous utilisons la perte de classification, la caractéristique f aura une distribution radiale. En effet, la similarité cos est calculée entre la caractéristique et le poids W de la dernière couche de classification lors de l'apprentissage. Comme le montre la figure ci-dessous, une fois l'apprentissage du modèle terminé, les échantillons de la même classe seront distribués près de W de cette classe, afin que f*W puisse atteindre la valeur maximale.

2 Nous avons donc trouvé une méthode très simple, qui consiste à inverser les fonctionnalités. Comme le montre la figure ci-dessous, il existe en fait deux méthodes d'attaque de classification courantes qui peuvent également être visualisées ensemble. Par exemple (a), il s'agit de supprimer la catégorie avec la probabilité de classification la plus élevée (telle que Fast Gradient), en donnant -Wmax, il y a donc une direction de propagation du gradient rouge le long de l'inverse de Wmax, comme (b), il y en a une autre ; moyen de supprimer la catégorie la moins probable. Les caractéristiques des catégories possibles sont affichées (telles que la moins probable), de sorte que le dégradé rouge est le long de Wmin.

3. Ces deux méthodes d'attaque de classification sont bien entendu très directes et efficaces dans les problèmes de classification traditionnels. Cependant, puisque les ensembles de tests dans le problème de récupération sont tous des catégories invisibles (espèces d'oiseaux invisibles), la distribution de f naturelle ne correspond pas étroitement à Wmax ou Wmin. Par conséquent, notre stratégie est très simple. Puisque nous avons f, alors nous pouvons simplement. déplacez f vers -f, comme le montre la figure (c).

De cette façon, dans l'étape de correspondance des caractéristiques, les résultats avec un classement élevé, idéalement, seront classés les plus bas lorsqu'ils sont calculés en tant que similarité cos avec -f, de proche de 1 à proche de -1.

Obtention de l'effet de notre tri de récupération d'attaque.

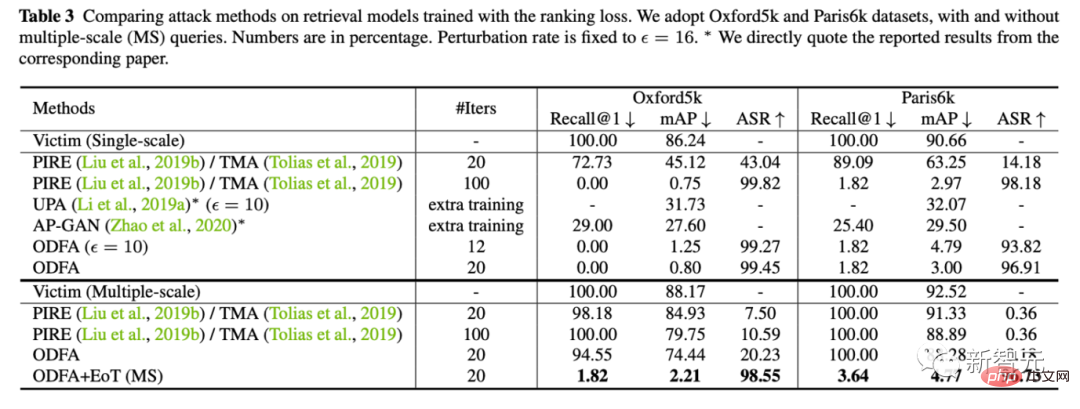

4. Une petite rallonge. Dans les problèmes de récupération, nous utilisons également souvent le multi-échelle pour l'augmentation des requêtes, nous avons donc également étudié comment maintenir l'effet d'attaque dans ce cas. (La principale difficulté est que l'opération de redimensionnement peut atténuer certaines instabilités petites mais critiques.)

En fait, notre méthode pour y faire face est également très simple, tout comme l'ensemble de modèles, nous faisons la moyenne des gradients contradictoires de plusieurs échelles. dans un ensemble. Très bien.

Expérience

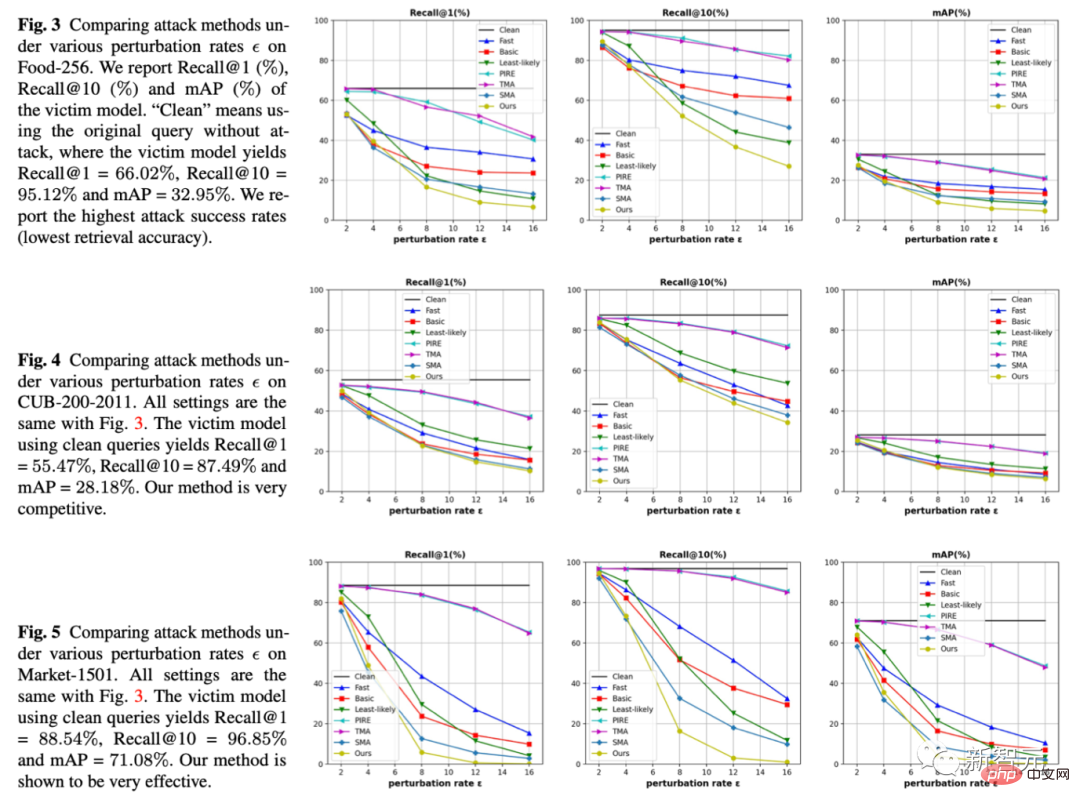

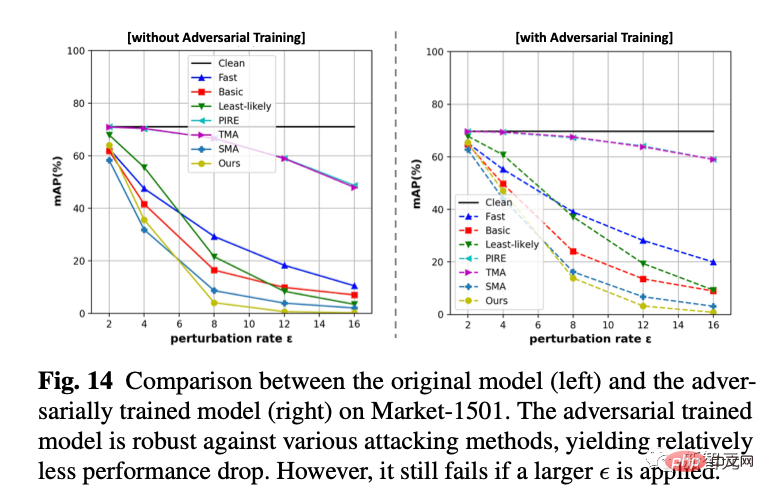

1. Sous trois ensembles de données et trois indicateurs, nous avons fixé l'amplitude de gigue, qui est l'epsilon de l'abscisse, et comparé quelle méthode peut amener le modèle de récupération à commettre plus d'erreurs sous la même amplitude de gigue. Notre méthode est que les lignes jaunes sont toutes en bas, ce qui signifie que l'effet d'attaque est meilleur.

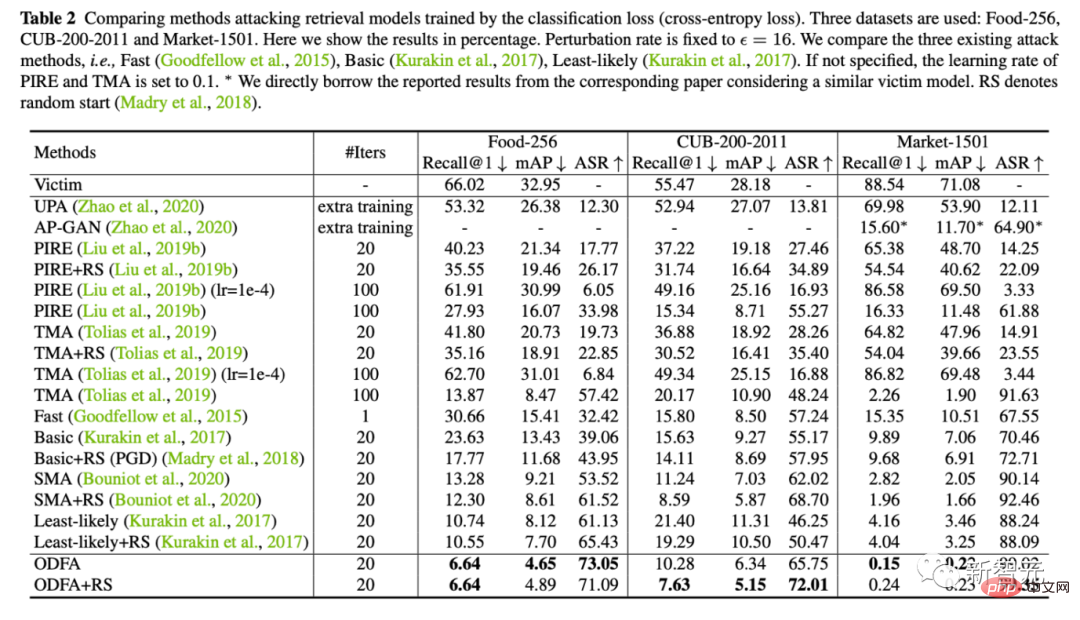

2. Nous fournissons également des résultats expérimentaux quantitatifs sur 5 ensembles de données (Alimentation, CUB, Marché, Oxford, Paris)

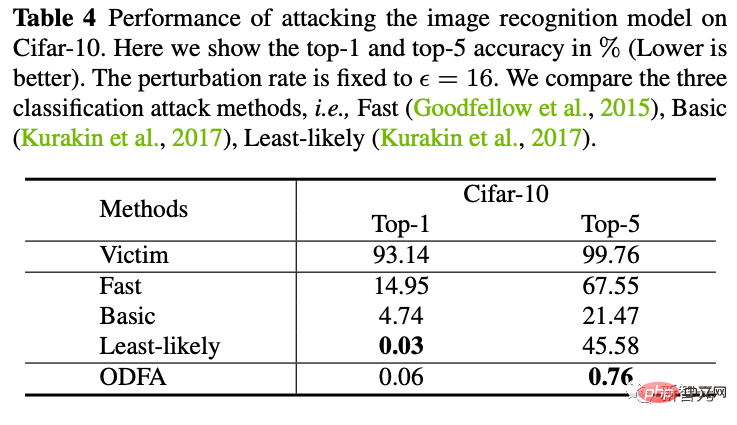

3. Pour démontrer le mécanisme du modèle, nous avons également essayé d'attaquer le modèle de classification sur Cifar10.

Vous pouvez voir que notre stratégie de modification de la dernière couche de fonctionnalités a également un fort pouvoir de suppression contre le top 5. Pour le top-1, puisqu’il n’y a pas de catégorie candidate, ce sera légèrement inférieur au moins probable, mais c’est presque pareil.

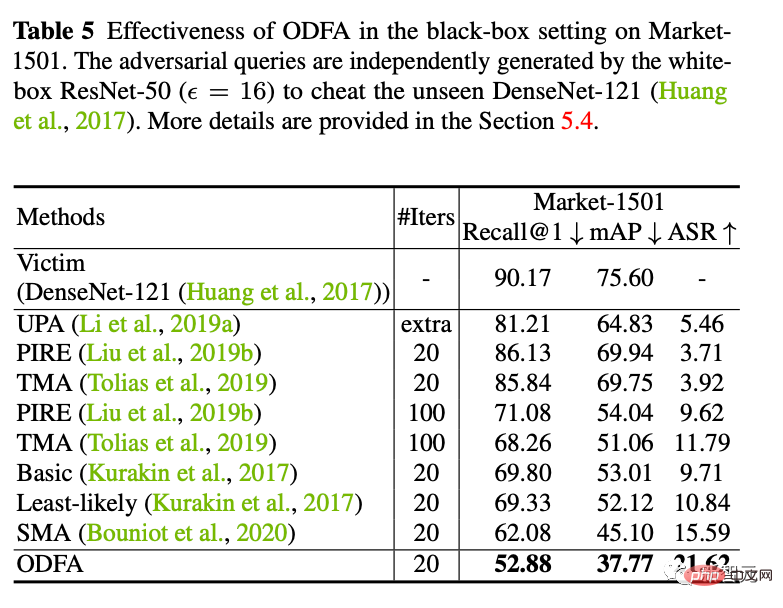

4. Attaque de boîte noire

Nous avons également essayé d'utiliser l'échantillon d'attaque généré par ResNet50 pour attaquer un modèle DenseNet de boîte noire (les paramètres de ce modèle ne nous sont pas disponibles). Il s’avère que de meilleures capacités d’attaque par migration peuvent également être obtenues.

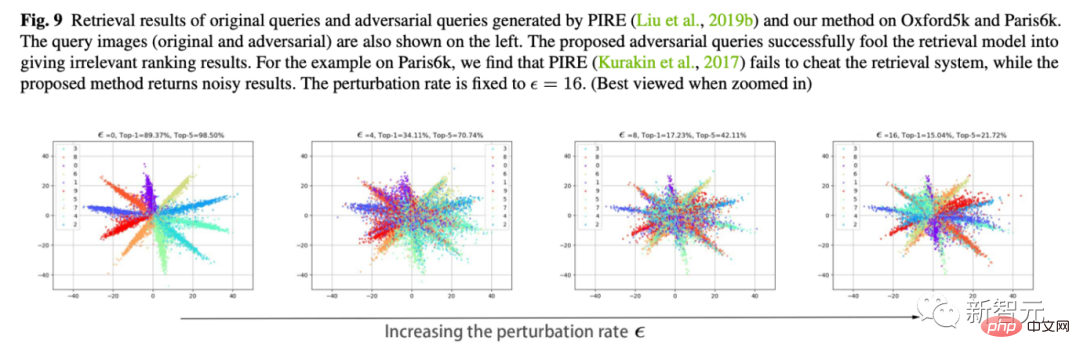

5. Nous utilisons la formation contradictoire en ligne pour former un modèle de défense. Nous avons constaté qu'il est toujours incapable d'accepter de nouvelles attaques en boîte blanche, mais il est plus stable dans les petites secousses (perd moins de points) qu'un modèle complètement sans défense. 6. Visualisation du mouvement des fonctionnalités C'est aussi mon expérience préférée. Nous utilisons Cifar10 pour changer la dimension de la dernière couche de classification à 2 afin de tracer les changements dans les caractéristiques de la couche de classification. Comme le montre la figure ci-dessous, à mesure que l'amplitude de gigue epsilon augmente, nous pouvons voir que les caractéristiques de l'échantillon "se retournent" lentement. Par exemple, la plupart des entités oranges se sont déplacées vers le côté opposé.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Le modèle MoE open source le plus puissant au monde est ici, avec des capacités chinoises comparables à celles du GPT-4, et le prix ne représente que près d'un pour cent de celui du GPT-4-Turbo.

May 07, 2024 pm 04:13 PM

Le modèle MoE open source le plus puissant au monde est ici, avec des capacités chinoises comparables à celles du GPT-4, et le prix ne représente que près d'un pour cent de celui du GPT-4-Turbo.

May 07, 2024 pm 04:13 PM

Imaginez un modèle d'intelligence artificielle qui non seulement a la capacité de surpasser l'informatique traditionnelle, mais qui permet également d'obtenir des performances plus efficaces à moindre coût. Ce n'est pas de la science-fiction, DeepSeek-V2[1], le modèle MoE open source le plus puissant au monde est ici. DeepSeek-V2 est un puissant mélange de modèle de langage d'experts (MoE) présentant les caractéristiques d'une formation économique et d'une inférence efficace. Il est constitué de 236B paramètres, dont 21B servent à activer chaque marqueur. Par rapport à DeepSeek67B, DeepSeek-V2 offre des performances plus élevées, tout en économisant 42,5 % des coûts de formation, en réduisant le cache KV de 93,3 % et en augmentant le débit de génération maximal à 5,76 fois. DeepSeek est une entreprise explorant l'intelligence artificielle générale

Bonjour, Atlas électrique ! Le robot Boston Dynamics revient à la vie, des mouvements étranges à 180 degrés effraient Musk

Apr 18, 2024 pm 07:58 PM

Bonjour, Atlas électrique ! Le robot Boston Dynamics revient à la vie, des mouvements étranges à 180 degrés effraient Musk

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas entre officiellement dans l’ère des robots électriques ! Hier, l'Atlas hydraulique s'est retiré "en larmes" de la scène de l'histoire. Aujourd'hui, Boston Dynamics a annoncé que l'Atlas électrique était au travail. Il semble que dans le domaine des robots humanoïdes commerciaux, Boston Dynamics soit déterminé à concurrencer Tesla. Après la sortie de la nouvelle vidéo, elle a déjà été visionnée par plus d’un million de personnes en seulement dix heures. Les personnes âgées partent et de nouveaux rôles apparaissent. C'est une nécessité historique. Il ne fait aucun doute que cette année est l’année explosive des robots humanoïdes. Les internautes ont commenté : Les progrès des robots ont fait ressembler la cérémonie d'ouverture de cette année à des êtres humains, et le degré de liberté est bien plus grand que celui des humains. Mais n'est-ce vraiment pas un film d'horreur ? Au début de la vidéo, Atlas est allongé calmement sur le sol, apparemment sur le dos. Ce qui suit est à couper le souffle

KAN, qui remplace MLP, a été étendu à la convolution par des projets open source

Jun 01, 2024 pm 10:03 PM

KAN, qui remplace MLP, a été étendu à la convolution par des projets open source

Jun 01, 2024 pm 10:03 PM

Plus tôt ce mois-ci, des chercheurs du MIT et d'autres institutions ont proposé une alternative très prometteuse au MLP – KAN. KAN surpasse MLP en termes de précision et d’interprétabilité. Et il peut surpasser le MLP fonctionnant avec un plus grand nombre de paramètres avec un très petit nombre de paramètres. Par exemple, les auteurs ont déclaré avoir utilisé KAN pour reproduire les résultats de DeepMind avec un réseau plus petit et un degré d'automatisation plus élevé. Plus précisément, le MLP de DeepMind compte environ 300 000 paramètres, tandis que le KAN n'en compte qu'environ 200. KAN a une base mathématique solide comme MLP est basé sur le théorème d'approximation universelle, tandis que KAN est basé sur le théorème de représentation de Kolmogorov-Arnold. Comme le montre la figure ci-dessous, KAN a

L'IA bouleverse la recherche mathématique ! Le lauréat de la médaille Fields et mathématicien sino-américain a dirigé 11 articles les mieux classés | Aimé par Terence Tao

Apr 09, 2024 am 11:52 AM

L'IA bouleverse la recherche mathématique ! Le lauréat de la médaille Fields et mathématicien sino-américain a dirigé 11 articles les mieux classés | Aimé par Terence Tao

Apr 09, 2024 am 11:52 AM

L’IA change effectivement les mathématiques. Récemment, Tao Zhexuan, qui a prêté une attention particulière à cette question, a transmis le dernier numéro du « Bulletin de l'American Mathematical Society » (Bulletin de l'American Mathematical Society). En se concentrant sur le thème « Les machines changeront-elles les mathématiques ? », de nombreux mathématiciens ont exprimé leurs opinions. L'ensemble du processus a été plein d'étincelles, intense et passionnant. L'auteur dispose d'une équipe solide, comprenant Akshay Venkatesh, lauréat de la médaille Fields, le mathématicien chinois Zheng Lejun, l'informaticien de l'Université de New York Ernest Davis et de nombreux autres universitaires bien connus du secteur. Le monde de l’IA a radicalement changé. Vous savez, bon nombre de ces articles ont été soumis il y a un an.

Google est ravi : les performances de JAX surpassent Pytorch et TensorFlow ! Cela pourrait devenir le choix le plus rapide pour la formation à l'inférence GPU

Apr 01, 2024 pm 07:46 PM

Google est ravi : les performances de JAX surpassent Pytorch et TensorFlow ! Cela pourrait devenir le choix le plus rapide pour la formation à l'inférence GPU

Apr 01, 2024 pm 07:46 PM

Les performances de JAX, promu par Google, ont dépassé celles de Pytorch et TensorFlow lors de récents tests de référence, se classant au premier rang sur 7 indicateurs. Et le test n’a pas été fait sur le TPU présentant les meilleures performances JAX. Bien que parmi les développeurs, Pytorch soit toujours plus populaire que Tensorflow. Mais à l’avenir, des modèles plus volumineux seront peut-être formés et exécutés sur la base de la plate-forme JAX. Modèles Récemment, l'équipe Keras a comparé trois backends (TensorFlow, JAX, PyTorch) avec l'implémentation native de PyTorch et Keras2 avec TensorFlow. Premièrement, ils sélectionnent un ensemble de

Nouveaux travaux sur la prédiction de séries chronologiques + grand modèle NLP : générer automatiquement des invites implicites pour la prédiction de séries chronologiques

Mar 18, 2024 am 09:20 AM

Nouveaux travaux sur la prédiction de séries chronologiques + grand modèle NLP : générer automatiquement des invites implicites pour la prédiction de séries chronologiques

Mar 18, 2024 am 09:20 AM

Aujourd'hui, j'aimerais partager un travail de recherche récent de l'Université du Connecticut qui propose une méthode pour aligner les données de séries chronologiques avec de grands modèles de traitement du langage naturel (NLP) sur l'espace latent afin d'améliorer les performances de prévision des séries chronologiques. La clé de cette méthode consiste à utiliser des indices spatiaux latents (invites) pour améliorer la précision des prévisions de séries chronologiques. Titre de l'article : S2IP-LLM : SemanticSpaceInformedPromptLearningwithLLMforTimeSeriesForecasting Adresse de téléchargement : https://arxiv.org/pdf/2403.05798v1.pdf 1. Modèle de fond de problème important

Les robots Tesla travaillent dans les usines, Musk : Le degré de liberté des mains atteindra 22 cette année !

May 06, 2024 pm 04:13 PM

Les robots Tesla travaillent dans les usines, Musk : Le degré de liberté des mains atteindra 22 cette année !

May 06, 2024 pm 04:13 PM

La dernière vidéo du robot Optimus de Tesla est sortie, et il peut déjà fonctionner en usine. À vitesse normale, il trie les batteries (les batteries 4680 de Tesla) comme ceci : Le responsable a également publié à quoi cela ressemble à une vitesse 20 fois supérieure - sur un petit "poste de travail", en sélectionnant et en sélectionnant et en sélectionnant : Cette fois, il est publié L'un des points forts de la vidéo est qu'Optimus réalise ce travail en usine, de manière totalement autonome, sans intervention humaine tout au long du processus. Et du point de vue d'Optimus, il peut également récupérer et placer la batterie tordue, en se concentrant sur la correction automatique des erreurs : concernant la main d'Optimus, le scientifique de NVIDIA Jim Fan a donné une évaluation élevée : la main d'Optimus est l'un des robots à cinq doigts du monde. le plus adroit. Ses mains ne sont pas seulement tactiles

DualBEV : dépassant largement BEVFormer et BEVDet4D, ouvrez le livre !

Mar 21, 2024 pm 05:21 PM

DualBEV : dépassant largement BEVFormer et BEVDet4D, ouvrez le livre !

Mar 21, 2024 pm 05:21 PM

Cet article explore le problème de la détection précise d'objets sous différents angles de vue (tels que la perspective et la vue à vol d'oiseau) dans la conduite autonome, en particulier comment transformer efficacement les caractéristiques de l'espace en perspective (PV) en vue à vol d'oiseau (BEV). implémenté via le module Visual Transformation (VT). Les méthodes existantes sont globalement divisées en deux stratégies : la conversion 2D en 3D et la conversion 3D en 2D. Les méthodes 2D vers 3D améliorent les caractéristiques 2D denses en prédisant les probabilités de profondeur, mais l'incertitude inhérente aux prévisions de profondeur, en particulier dans les régions éloignées, peut introduire des inexactitudes. Alors que les méthodes 3D vers 2D utilisent généralement des requêtes 3D pour échantillonner des fonctionnalités 2D et apprendre les poids d'attention de la correspondance entre les fonctionnalités 3D et 2D via un transformateur, ce qui augmente le temps de calcul et de déploiement.