Périphériques technologiques

Périphériques technologiques

IA

IA

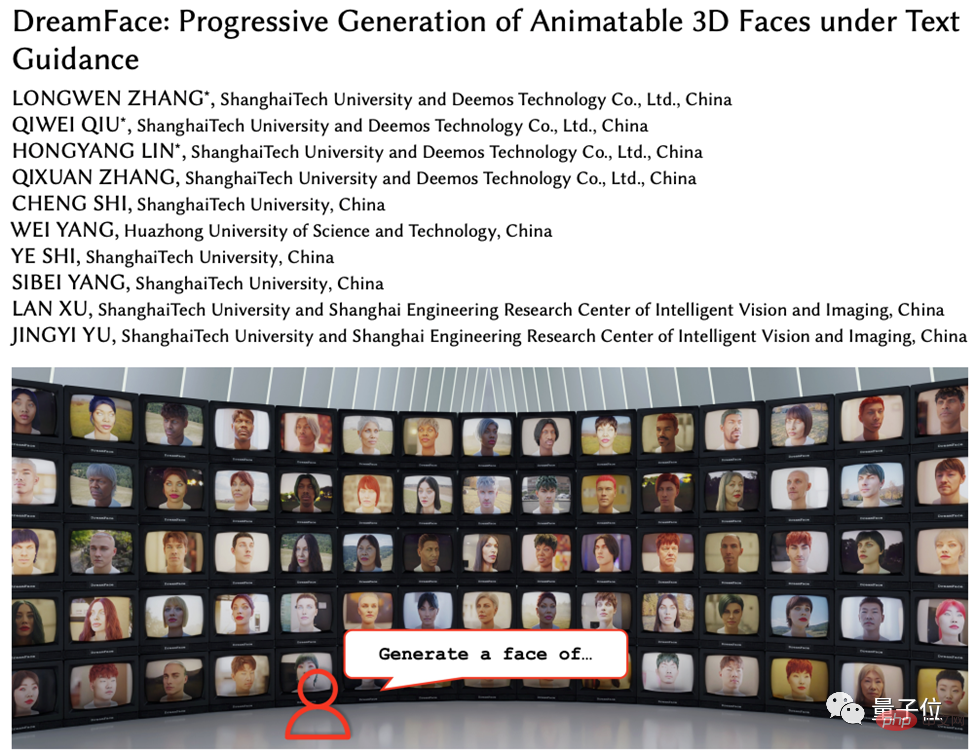

Générez un humain numérique Marvel 3D en cinq minutes ! L'American Spider-Man et le Joker peuvent tous le faire, et les détails du visage sont restitués en haute définition.

Générez un humain numérique Marvel 3D en cinq minutes ! L'American Spider-Man et le Joker peuvent tous le faire, et les détails du visage sont restitués en haute définition.

Générez un humain numérique Marvel 3D en cinq minutes ! L'American Spider-Man et le Joker peuvent tous le faire, et les détails du visage sont restitués en haute définition.

Avec le développement de l'infographie, la technologie de génération 3D devient progressivement un haut lieu de la recherche. Cependant, la génération de modèles 3D à partir de texte ou d’images reste encore confrontée à de nombreux défis.

Récemment, des entreprises telles que Google, NVIDIA et Microsoft ont lancé des méthodes de génération 3D basées sur les champs de rayonnement neural (NeRF), mais ces méthodes sont incompatibles avec les logiciels de rendu 3D traditionnels (tels que Unity, Unreal Engine , Maya, etc.) Il existe des problèmes de compatibilité qui limitent son utilisation généralisée dans des applications pratiques.

À cette fin, l'équipe R&D de Yingmo Technology et de l'Université des sciences et technologies de Shanghai a proposé un cadre de génération 3D progressive guidé par texte conçu pour résoudre ces problèmes.

Générer des actifs 3D basés sur des descriptions textuelles

Le cadre de génération 3D progressive guidé par texte (appelé DreamFace) proposé par l'équipe de recherche combine des modèles de langage visuel et une diffusion implicite La technologie de diffusion de modèles et de matériaux basés sur la physique génère des actifs 3D conformes aux normes de production d'infographie.

L'innovation de ce framework réside dans ses trois modules : génération de géométrie, génération de diffusion de matériaux basée sur la physique et génération de capacités d'animation.

Ce travail a été accepté par la grande revue Transactions on Graphics et sera présenté à la plus grande conférence internationale d'infographie SIGGRAPH 2023.

Site du projet : https://sites.google.com/view /dreamface

Papier préimprimé : https://arxiv.org/abs/2304.03117

Démo Web : https://hyperhuman .top

HuggingFace Space : https://huggingface.co/spaces/DEEMOSTECH/ChatAvatar

Comment implémenter DreamFace three Big fonctions

DreamFace comprend principalement trois modules, la génération de géométrie, la diffusion de matériaux basée sur la physique et la génération de capacités d'animation. Par rapport aux travaux de génération 3D précédents, les principales contributions de ce travail comprennent :

- propose DreamFace, un nouveau schéma de génération qui combine des modèles de langage visuel récents avec des actifs faciaux matériels animables et physiques. avec un apprentissage progressif pour séparer les capacités de géométrie, d'apparence et d'animation.

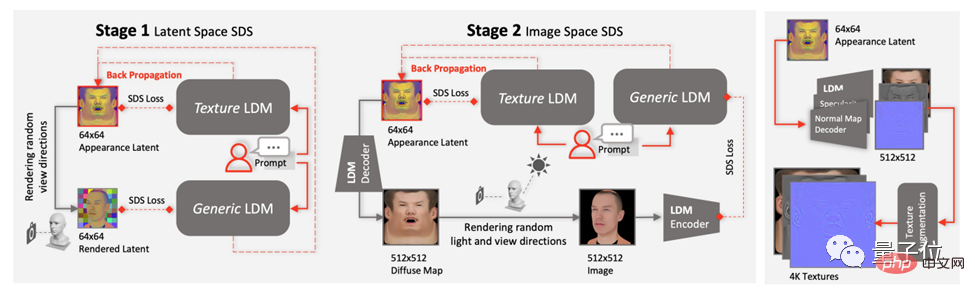

- Présente la conception de la génération d'apparences à double canal, combinant un nouveau modèle de diffusion de matériaux avec un modèle pré-entraîné, tout en effectuant une optimisation en deux étapes dans l'espace latent et l'espace image.

- Les éléments du visage utilisant des BlendShapes ou des BlendShapes personnalisés générés sont animés et démontrent davantage l'utilisation de DreamFace pour la conception de personnages naturels.

Génération de géométrie : Ce module génère un modèle géométrique basé sur des invites de texte via le cadre de sélection CLIP (Contrastive Language-Image Pre-Training).

Commencez par échantillonner au hasard les candidats dans l'espace des paramètres géométriques du visage, puis sélectionnez le modèle géométrique approximatif avec le score de correspondance le plus élevé en fonction des invites textuelles.

Ensuite, les détails du visage et les cartes normales détaillées sont ajoutés au modèle de géométrie grossière à l'aide d'un modèle de diffusion implicite (LDM) et d'un traitement d'échantillonnage par distillation séquentielle (SDS) pour générer une géométrie de haute précision. Génération de diffusion de matériaux basée sur la physique

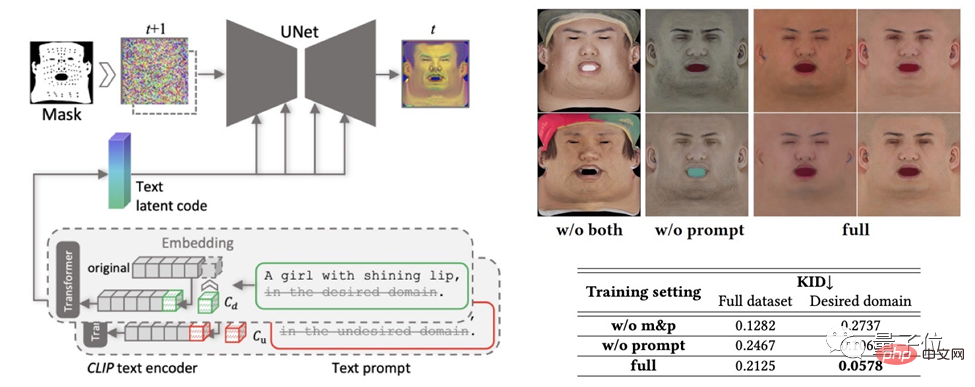

: Ce module génère des textures faciales pour la géométrie prédite et les indices textuels. Premièrement, le LDM est affiné pour obtenir deux modèles de diffusion.Les deux modèles sont ensuite coordonnés au travers d'un programme de formation commun, l'un pour le débruitage direct des cartes de texture U et l'autre pour le rendu supervisé des images. De plus, une stratégie d'apprentissage d'indices et un masquage de zones non faciales sont utilisés pour garantir la qualité des cartes diffuses générées.

Génération de capacité d'animation

: Le modèle généré par DreamFace a une capacité d'animation. Différent des méthodes traditionnelles basées sur BlendShapes, ce framework anime le modèle Neutre en prédisant des déformations uniques pour générer des animations personnalisées.

Le générateur géométrique est d'abord entraîné pour apprendre l'espace latent de l'expression, puis l'encodeur d'expression est entraîné pour extraire les caractéristiques d'expression des images RVB. Enfin, des animations personnalisées sont générées à l'aide d'images RVB monoculaires.

Générer des actifs 3D spécifiés en 5 minutes

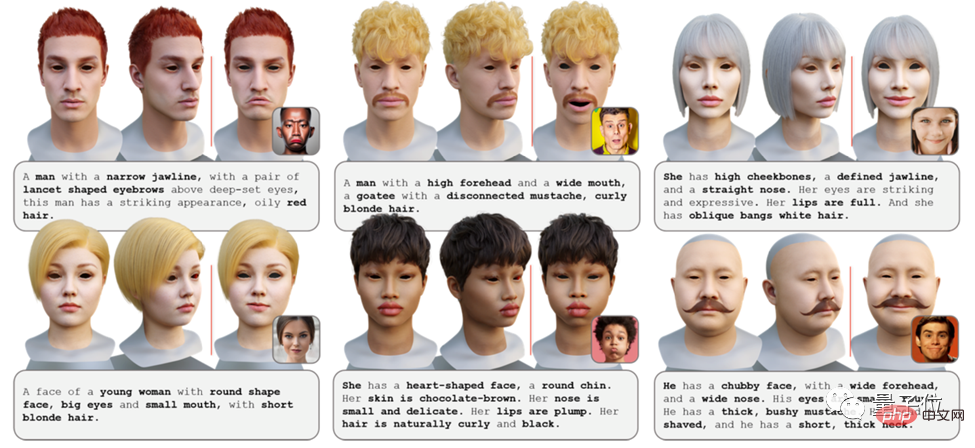

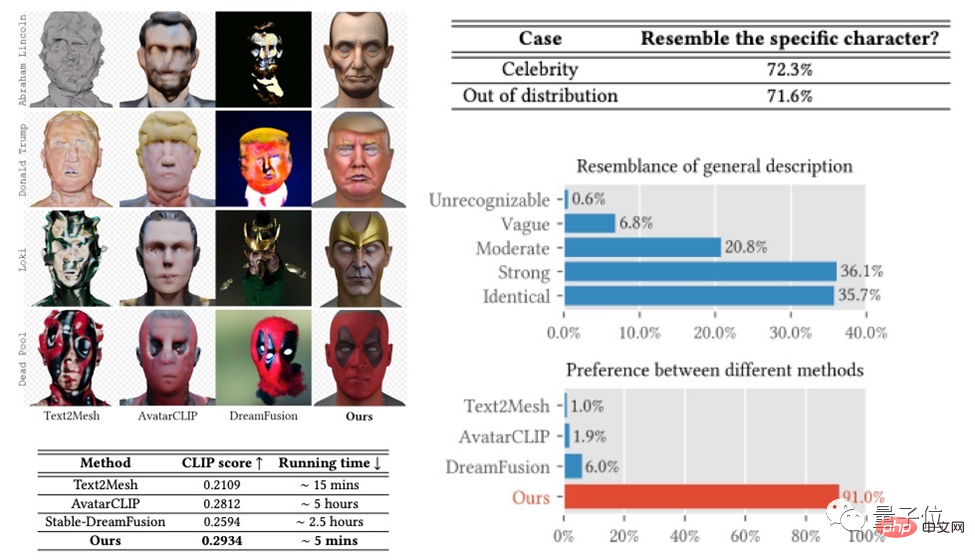

Le framework DreamFace a obtenu de bons résultats dans des tâches telles que la génération de célébrités et la génération de descriptions, et a obtenu des résultats dépassant les travaux précédents dans les évaluations des utilisateurs.

En même temps, elle présente des avantages évidents en termes de temps d'exécution par rapport aux méthodes existantes.

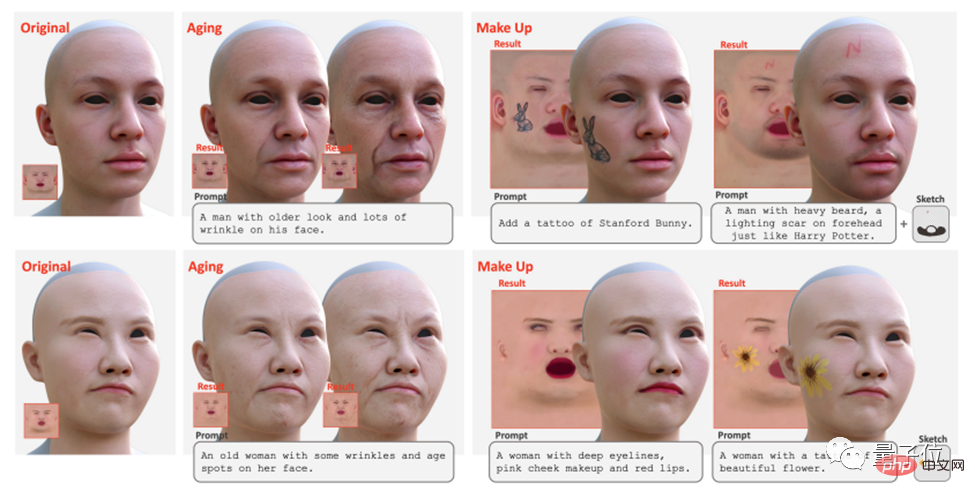

De plus, DreamFace prend en charge l'édition de textures à l'aide de conseils et de croquis pour obtenir des effets d'édition globaux (tels que le vieillissement, le maquillage) et des effets d'édition locaux (tels que les tatouages, la barbe, les taches de naissance).

Peut être utilisé dans le cinéma, la télévision, les jeux et d'autres industries

En tant que cadre de génération 3D progressive guidé par texte, DreamFace combine le modèle de langage visuel, le modèle de diffusion implicite et la technologie de diffusion matérielle basée sur la physique pour réaliser une génération 3D avec une haute précision, une efficacité et une bonne compatibilité.

Ce cadre fournit une solution efficace pour résoudre des tâches complexes de génération 3D et devrait promouvoir davantage de recherches et de développements technologiques similaires.

De plus, la génération de diffusion de matériaux physiques et la génération de capacités d'animation favoriseront l'application de la technologie de génération 3D dans la production cinématographique et télévisuelle, le développement de jeux et d'autres industries connexes.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Pourquoi le Gaussian Splatting est-il si populaire dans la conduite autonome que le NeRF commence à être abandonné ?

Jan 17, 2024 pm 02:57 PM

Pourquoi le Gaussian Splatting est-il si populaire dans la conduite autonome que le NeRF commence à être abandonné ?

Jan 17, 2024 pm 02:57 PM

Écrit ci-dessus et compréhension personnelle de l'auteur Le Gaussiansplatting tridimensionnel (3DGS) est une technologie transformatrice qui a émergé dans les domaines des champs de rayonnement explicites et de l'infographie ces dernières années. Cette méthode innovante se caractérise par l’utilisation de millions de gaussiennes 3D, ce qui est très différent de la méthode du champ de rayonnement neuronal (NeRF), qui utilise principalement un modèle implicite basé sur les coordonnées pour mapper les coordonnées spatiales aux valeurs des pixels. Avec sa représentation explicite de scènes et ses algorithmes de rendu différenciables, 3DGS garantit non seulement des capacités de rendu en temps réel, mais introduit également un niveau de contrôle et d'édition de scène sans précédent. Cela positionne 3DGS comme un révolutionnaire potentiel pour la reconstruction et la représentation 3D de nouvelle génération. À cette fin, nous fournissons pour la première fois un aperçu systématique des derniers développements et préoccupations dans le domaine du 3DGS.

En savoir plus sur les emojis 3D Fluent dans Microsoft Teams

Apr 24, 2023 pm 10:28 PM

En savoir plus sur les emojis 3D Fluent dans Microsoft Teams

Apr 24, 2023 pm 10:28 PM

N'oubliez pas, surtout si vous êtes un utilisateur de Teams, que Microsoft a ajouté un nouveau lot d'émojis 3DFluent à son application de visioconférence axée sur le travail. Après que Microsoft a annoncé des emojis 3D pour Teams et Windows l'année dernière, le processus a en fait permis de mettre à jour plus de 1 800 emojis existants pour la plate-forme. Cette grande idée et le lancement de la mise à jour des emoji 3DFluent pour les équipes ont été promus pour la première fois via un article de blog officiel. La dernière mise à jour de Teams apporte FluentEmojis à l'application. Microsoft affirme que les 1 800 emojis mis à jour seront disponibles chaque jour.

Choisir une caméra ou un lidar ? Une étude récente sur la détection robuste d'objets 3D

Jan 26, 2024 am 11:18 AM

Choisir une caméra ou un lidar ? Une étude récente sur la détection robuste d'objets 3D

Jan 26, 2024 am 11:18 AM

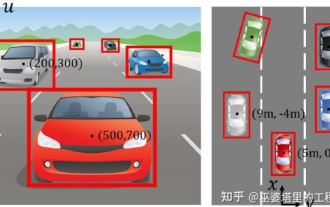

0. Écrit à l'avant&& Compréhension personnelle que les systèmes de conduite autonome s'appuient sur des technologies avancées de perception, de prise de décision et de contrôle, en utilisant divers capteurs (tels que caméras, lidar, radar, etc.) pour percevoir l'environnement et en utilisant des algorithmes et des modèles pour une analyse et une prise de décision en temps réel. Cela permet aux véhicules de reconnaître les panneaux de signalisation, de détecter et de suivre d'autres véhicules, de prédire le comportement des piétons, etc., permettant ainsi de fonctionner en toute sécurité et de s'adapter à des environnements de circulation complexes. Cette technologie attire actuellement une grande attention et est considérée comme un domaine de développement important pour l'avenir des transports. . un. Mais ce qui rend la conduite autonome difficile, c'est de trouver comment faire comprendre à la voiture ce qui se passe autour d'elle. Cela nécessite que l'algorithme de détection d'objets tridimensionnels du système de conduite autonome puisse percevoir et décrire avec précision les objets dans l'environnement, y compris leur emplacement,

CLIP-BEVFormer : superviser explicitement la structure BEVFormer pour améliorer les performances de détection à longue traîne

Mar 26, 2024 pm 12:41 PM

CLIP-BEVFormer : superviser explicitement la structure BEVFormer pour améliorer les performances de détection à longue traîne

Mar 26, 2024 pm 12:41 PM

Écrit ci-dessus et compréhension personnelle de l'auteur : À l'heure actuelle, dans l'ensemble du système de conduite autonome, le module de perception joue un rôle essentiel. Le véhicule autonome roulant sur la route ne peut obtenir des résultats de perception précis que via le module de perception en aval. dans le système de conduite autonome, prend des jugements et des décisions comportementales opportuns et corrects. Actuellement, les voitures dotées de fonctions de conduite autonome sont généralement équipées d'une variété de capteurs d'informations de données, notamment des capteurs de caméra à vision panoramique, des capteurs lidar et des capteurs radar à ondes millimétriques pour collecter des informations selon différentes modalités afin d'accomplir des tâches de perception précises. L'algorithme de perception BEV basé sur la vision pure est privilégié par l'industrie en raison de son faible coût matériel et de sa facilité de déploiement, et ses résultats peuvent être facilement appliqués à diverses tâches en aval.

Paint 3D sous Windows 11 : guide de téléchargement, d'installation et d'utilisation

Apr 26, 2023 am 11:28 AM

Paint 3D sous Windows 11 : guide de téléchargement, d'installation et d'utilisation

Apr 26, 2023 am 11:28 AM

Lorsque les rumeurs ont commencé à se répandre selon lesquelles le nouveau Windows 11 était en développement, chaque utilisateur de Microsoft était curieux de savoir à quoi ressemblerait le nouveau système d'exploitation et ce qu'il apporterait. Après de nombreuses spéculations, Windows 11 est là. Le système d'exploitation est livré avec une nouvelle conception et des modifications fonctionnelles. En plus de quelques ajouts, il s’accompagne de fonctionnalités obsolètes et supprimées. L'une des fonctionnalités qui n'existe pas dans Windows 11 est Paint3D. Bien qu'il propose toujours Paint classique, idéal pour les dessinateurs, les griffonneurs et les griffonneurs, il abandonne Paint3D, qui offre des fonctionnalités supplémentaires idéales pour les créateurs 3D. Si vous recherchez des fonctionnalités supplémentaires, nous recommandons Autodesk Maya comme le meilleur logiciel de conception 3D. comme

Obtenez une femme virtuelle en 3D en 30 secondes avec une seule carte ! Text to 3D génère un humain numérique de haute précision avec des détails de pores clairs, se connectant de manière transparente à Maya, Unity et d'autres outils de production.

May 23, 2023 pm 02:34 PM

Obtenez une femme virtuelle en 3D en 30 secondes avec une seule carte ! Text to 3D génère un humain numérique de haute précision avec des détails de pores clairs, se connectant de manière transparente à Maya, Unity et d'autres outils de production.

May 23, 2023 pm 02:34 PM

ChatGPT a injecté une dose de sang de poulet dans l’industrie de l’IA, et tout ce qui était autrefois impensable est devenu aujourd’hui une pratique de base. Le Text-to-3D, qui continue de progresser, est considéré comme le prochain point chaud dans le domaine de l'AIGC après la diffusion (images) et le GPT (texte), et a reçu une attention sans précédent. Non, un produit appelé ChatAvatar a été mis en version bêta publique discrète, recueillant rapidement plus de 700 000 vues et attention, et a été présenté sur Spacesoftheweek. △ChatAvatar prendra également en charge la technologie Imageto3D qui génère des personnages stylisés en 3D à partir de peintures originales à perspective unique/multi-perspective générées par l'IA. Le modèle 3D généré par la version bêta actuelle a reçu une large attention.

Les dernières nouvelles de l'Université d'Oxford ! Mickey : correspondance d'images 2D en 3D SOTA ! (CVPR\'24)

Apr 23, 2024 pm 01:20 PM

Les dernières nouvelles de l'Université d'Oxford ! Mickey : correspondance d'images 2D en 3D SOTA ! (CVPR\'24)

Apr 23, 2024 pm 01:20 PM

Lien du projet écrit devant : https://nianticlabs.github.io/mickey/ Étant donné deux images, la pose de la caméra entre elles peut être estimée en établissant la correspondance entre les images. En règle générale, ces correspondances sont 2D à 2D et nos poses estimées sont à échelle indéterminée. Certaines applications, telles que la réalité augmentée instantanée, à tout moment et en tout lieu, nécessitent une estimation de pose des métriques d'échelle, elles s'appuient donc sur des estimateurs de profondeur externes pour récupérer l'échelle. Cet article propose MicKey, un processus de correspondance de points clés capable de prédire les correspondances métriques dans l'espace d'une caméra 3D. En apprenant la correspondance des coordonnées 3D entre les images, nous sommes en mesure de déduire des métriques relatives.

Une interprétation approfondie de l'algorithme de perception visuelle 3D pour la conduite autonome

Jun 02, 2023 pm 03:42 PM

Une interprétation approfondie de l'algorithme de perception visuelle 3D pour la conduite autonome

Jun 02, 2023 pm 03:42 PM

Pour les applications de conduite autonome, il est finalement nécessaire de percevoir des scènes 3D. La raison est simple : un véhicule ne peut pas conduire sur la base des résultats de perception obtenus à partir d’une image. Même un conducteur humain ne peut pas conduire sur la base d’une image. Étant donné que la distance de l'objet et les informations sur la profondeur de la scène ne peuvent pas être reflétées dans les résultats de perception 2D, ces informations sont la clé permettant au système de conduite autonome de porter des jugements corrects sur l'environnement. De manière générale, les capteurs visuels (comme les caméras) des véhicules autonomes sont installés au-dessus de la carrosserie du véhicule ou sur le rétroviseur intérieur. Peu importe où elle se trouve, la caméra obtient la projection du monde réel dans la vue en perspective (PerspectiveView) (du système de coordonnées mondiales au système de coordonnées de l'image). Cette vue est très similaire au système visuel humain,