Nouvelle du 2 mai, la plupart des chatbots IA actuels doivent être connectés au cloud pour le traitement, et même ceux qui peuvent être exécutés localement ont des exigences de configuration extrêmement élevées. Alors existe-t-il des chatbots légers qui ne nécessitent pas de connexion Internet ?

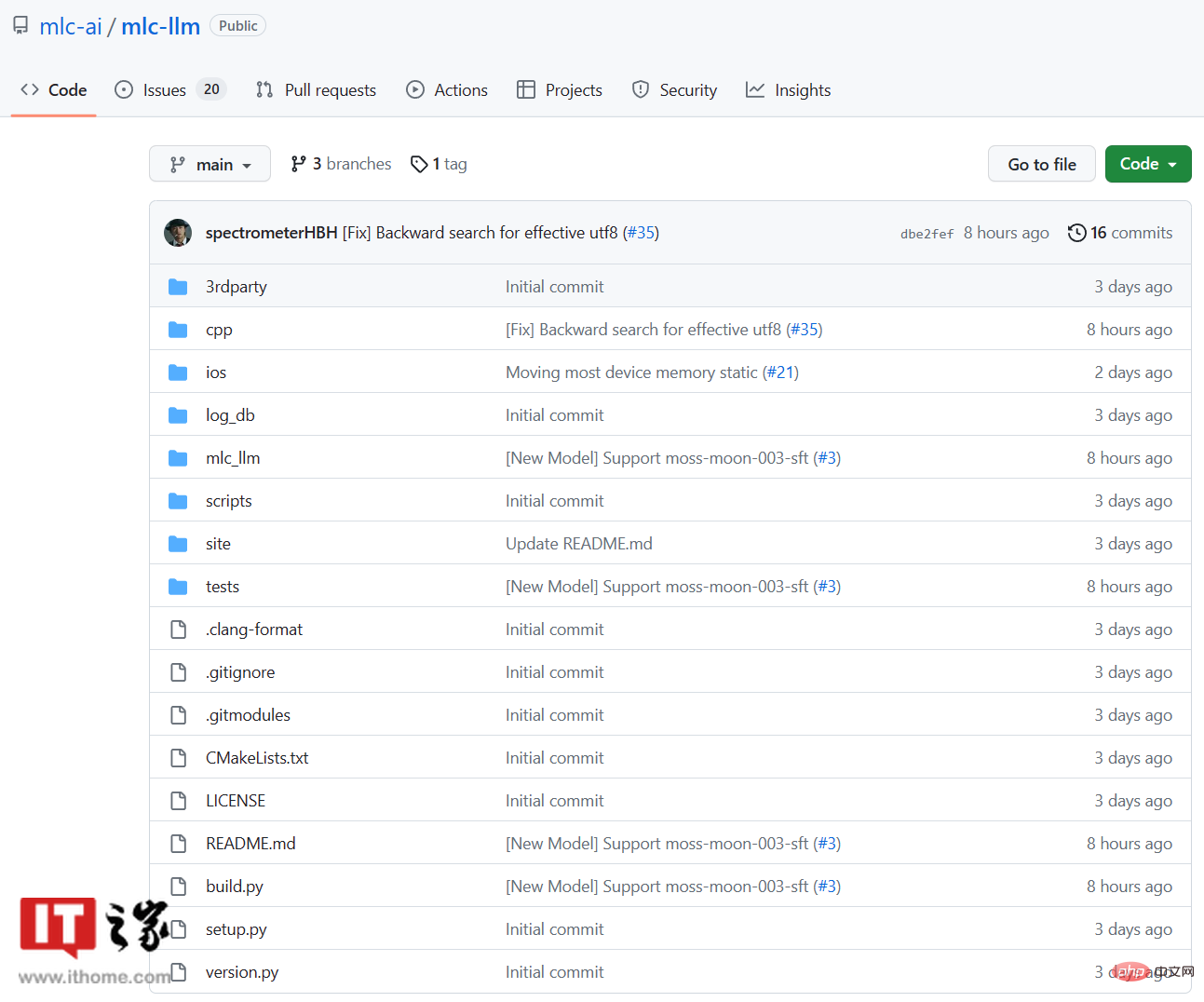

Un nouveau projet open source appelé MLC LLM a été lancé sur GitHub. Il fonctionne entièrement localement sans avoir besoin d'une connexion Internet. Il peut même fonctionner sur d'anciens ordinateurs et téléphones mobiles Apple iPhone. L'introduction du projet

MLC LLM indique : « MLC LLM est une solution universelle qui permet le déploiement local de n'importe quel modèle de langage sur un ensemble de différents backends matériels et d'applications natives, en plus d'un framework efficace, pour que chacun puisse optimiser davantage le modèle. performances pour leurs propres cas d'utilisation. Tout fonctionne localement, sans support de serveur, et est accéléré par les GPU locaux sur les téléphones mobiles et les ordinateurs portables. Notre mission est de permettre à chacun de développer et d'optimiser localement sur ses appareils et de déployer des modèles d'IA.

▲ Démo officielle du projet MLC LLM

▲ Démo officielle du projet MLC LLM

La page GitHub de requête de l'IT House a révélé que les développeurs de ce projet sont issus du programme Catalyst de l'université Carnegie Mellon, du groupe de recherche sur l'apprentissage automatique SAMPL et de l'université de Washington, de l'université Jiao Tong de Shanghai et d'OctoML, etc. Ils disposent également d'un outil appelé Web LLM

▲ MLC est l'abréviation de Machine Learning Compilation

▲ MLC est l'abréviation de Machine Learning Compilation

MLC LLM utilise Vicuna-7B-V1.1, qui est un LLM léger basé sur LLaMA de Meta, bien que l'effet ne soit pas le cas. aussi bon que GPT3.5 ou GPT4, il est plus avantageux en termes de taille.

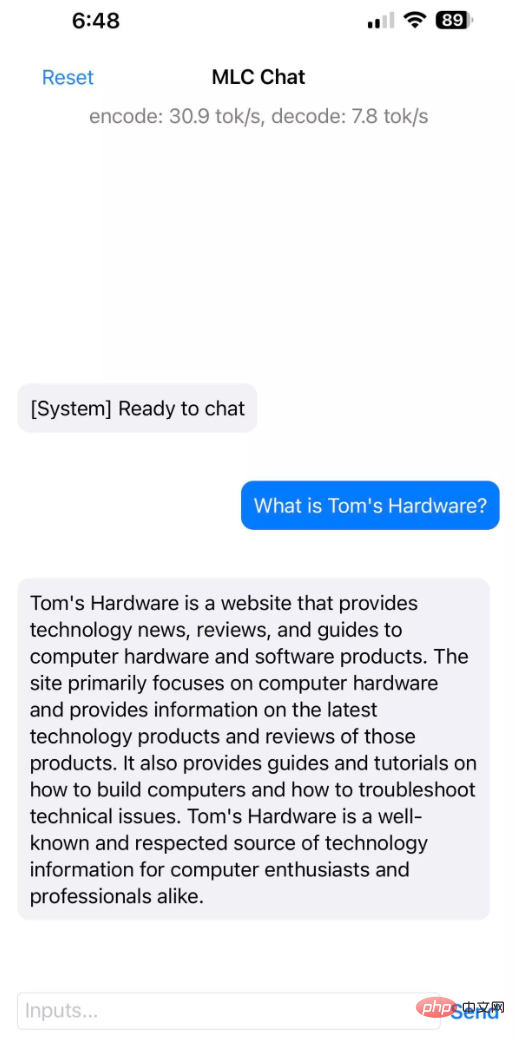

Actuellement, MLC LLM est disponible pour les plateformes Windows, Linux, macOS et iOS. Aucune version n'est encore disponible pour

Android. Selon les tests effectués par les médias étrangers tomshardware, les téléphones Apple

iPhone 14 Pro Maxet iPhone 12 Pro Max avec 6 Go de mémoire ont exécuté avec succès MLC LLM, avec une taille d'installation de 3 Go. L'Apple iPhone 11 Pro Max avec 4 Go de mémoire ne peut pas exécuter MLC LLM.

▲ Source d'image tomshardware

▲ Source d'image tomshardware

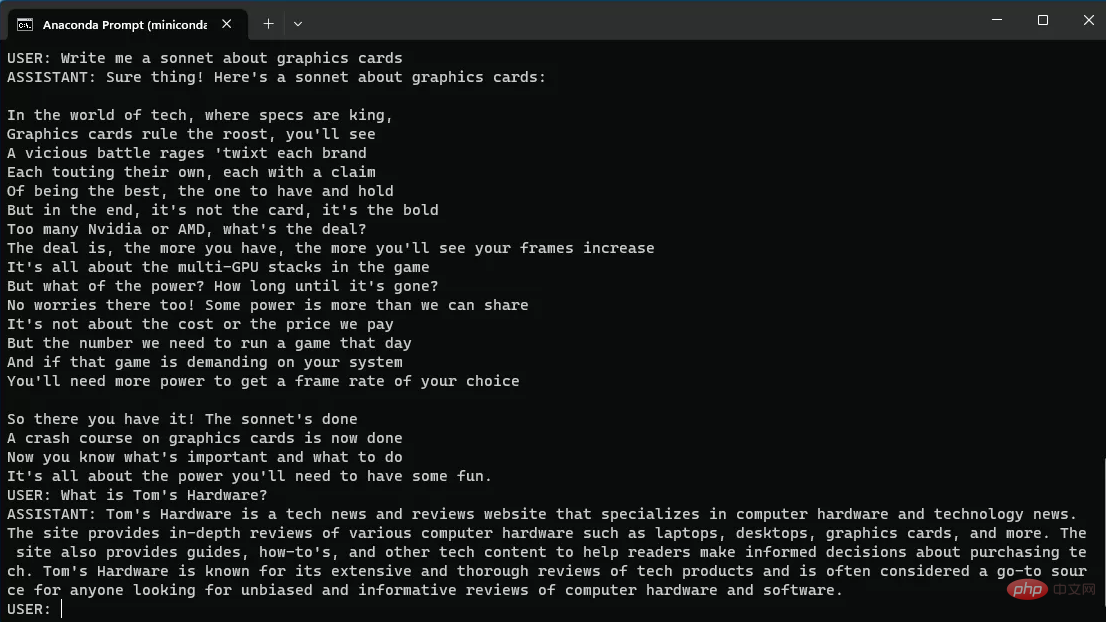

De plus, le ThinkPad X1 Carbon (6e génération) a également testé avec succès l'exécution de MLC LLM. Il s'agit d'un ordinateur portable équipé d'un processeur i7-8550U, sans carte graphique indépendante et équipé d'Intel UHD 620. GPU. MLC LLM doit être exécuté via la ligne de commande sur la plate-forme PC. Les performances du test des médias étrangers étaient moyennes, le temps de réponse a pris près de 30 secondes et il n'y avait presque aucune capacité de dialogue continu. J'espère qu'il pourra être amélioré par la suite. versions.

▲ Source de l'image tomshardware

▲ Source de l'image tomshardware

Page GitHub de MLC LLM :

Cliquez ici pour voirCe qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Application de l'intelligence artificielle dans la vie

Application de l'intelligence artificielle dans la vie

Quel est le concept de base de l'intelligence artificielle

Quel est le concept de base de l'intelligence artificielle

Que faire si la prise chinoise est brouillée ?

Que faire si la prise chinoise est brouillée ?

Comment vérifier l'adresse Mac

Comment vérifier l'adresse Mac

Que dois-je faire si mon ordinateur ne s'allume pas ?

Que dois-je faire si mon ordinateur ne s'allume pas ?

Introduction à la monnaie numérique du concept Dex

Introduction à la monnaie numérique du concept Dex

Comment supprimer des pages vierges dans Word

Comment supprimer des pages vierges dans Word

Site officiel d'Okex

Site officiel d'Okex

Utilisation de la balise embed

Utilisation de la balise embed