Périphériques technologiques

Périphériques technologiques

IA

IA

L'abandon amélioré peut être utilisé pour atténuer les problèmes de sous-ajustement.

L'abandon amélioré peut être utilisé pour atténuer les problèmes de sous-ajustement.

L'abandon amélioré peut être utilisé pour atténuer les problèmes de sous-ajustement.

En 2012, Hinton et al. ont proposé l'abandon dans leur article « Améliorer les réseaux de neurones en empêchant la co-adaptation des détecteurs de caractéristiques ». La même année, l’émergence d’AlexNet ouvre une nouvelle ère d’apprentissage profond. AlexNet utilise l'abandon pour réduire considérablement le surapprentissage et a joué un rôle clé dans sa victoire au concours ILSVRC 2012. Il suffit de dire que sans abandon, les progrès que nous constatons actuellement dans le domaine de l’apprentissage profond auraient pu être retardés de plusieurs années.

Depuis le lancement de dropout, il a été largement utilisé comme régularisateur pour réduire le surapprentissage dans les réseaux de neurones. L'abandon désactive chaque neurone avec une probabilité p, empêchant différentes fonctionnalités de s'adapter les unes aux autres. Après avoir appliqué l'abandon, la perte de formation augmente généralement tandis que l'erreur de test diminue, comblant ainsi l'écart de généralisation du modèle. Le développement de l’apprentissage profond continue d’introduire de nouvelles technologies et architectures, mais le décrochage existe toujours. Il continue de jouer un rôle dans les dernières réalisations de l’IA, telles que la prédiction des protéines AlphaFold, la génération d’images DALL-E 2, etc., démontrant sa polyvalence et son efficacité.

Malgré la popularité continue du décrochage scolaire, son intensité (exprimée en taux d'abandon p) a diminué au fil des années. L’effort d’abandon initial a utilisé un taux d’abandon par défaut de 0,5. Cependant, ces dernières années, des taux d'abandon plus faibles sont souvent utilisés, tels que 0,1. Des exemples connexes peuvent être vus dans la formation BERT et ViT. Le principal moteur de cette tendance est l’explosion des données d’entraînement disponibles, rendant le surapprentissage de plus en plus difficile. En combinaison avec d’autres facteurs, nous pourrions rapidement nous retrouver avec davantage de problèmes de sous-apprentissage que de surapprentissage.

Récemment, dans un article intitulé « Le décrochage réduit le sous-ajustement », des chercheurs de Meta AI, de l'Université de Californie à Berkeley et d'autres institutions ont démontré comment utiliser le décrochage pour résoudre le problème du sous-ajustement.

Adresse papier : https://arxiv.org/abs/2303.01500

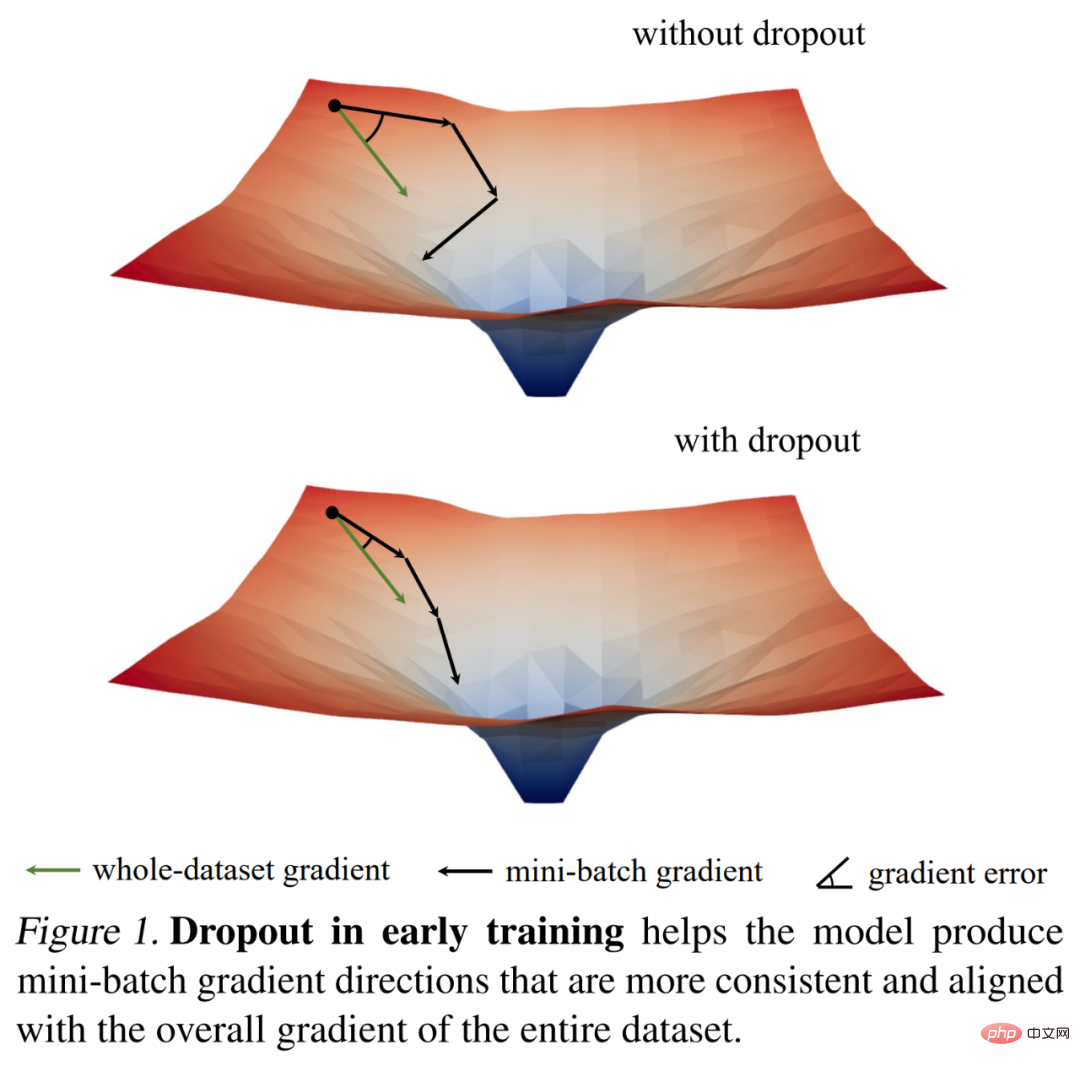

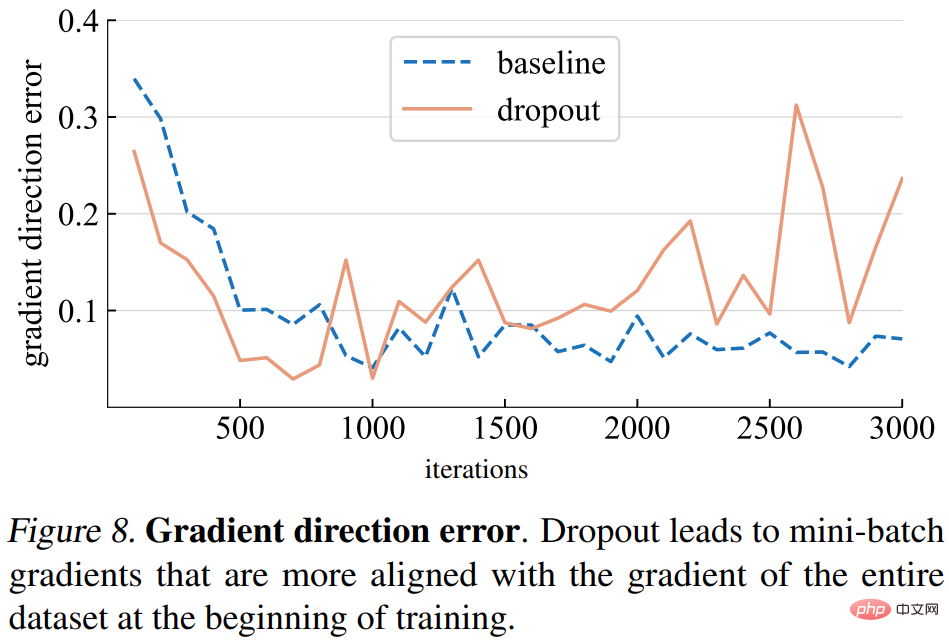

Ils ont d'abord étudié la dynamique de formation du décrochage à travers des observations intéressantes sur la norme de gradient, puis en ont tiré une découverte empirique clé : Étape initiale de la formation, l'abandon réduit la variance de gradient du mini-lot et permet au modèle de se mettre à jour dans une direction plus cohérente. Ces directions sont également plus cohérentes avec les directions de gradient sur l'ensemble de l'ensemble de données, comme le montre la figure 1 ci-dessous.

Ainsi, le modèle peut optimiser plus efficacement la perte d'entraînement sur l'ensemble de l'entraînement sans être affecté par des mini-lots individuels. En d’autres termes, l’abandon neutralise la descente de gradient stochastique (SGD) et empêche la régularisation excessive causée par le caractère aléatoire des mini-lots échantillonnés au début de la formation.

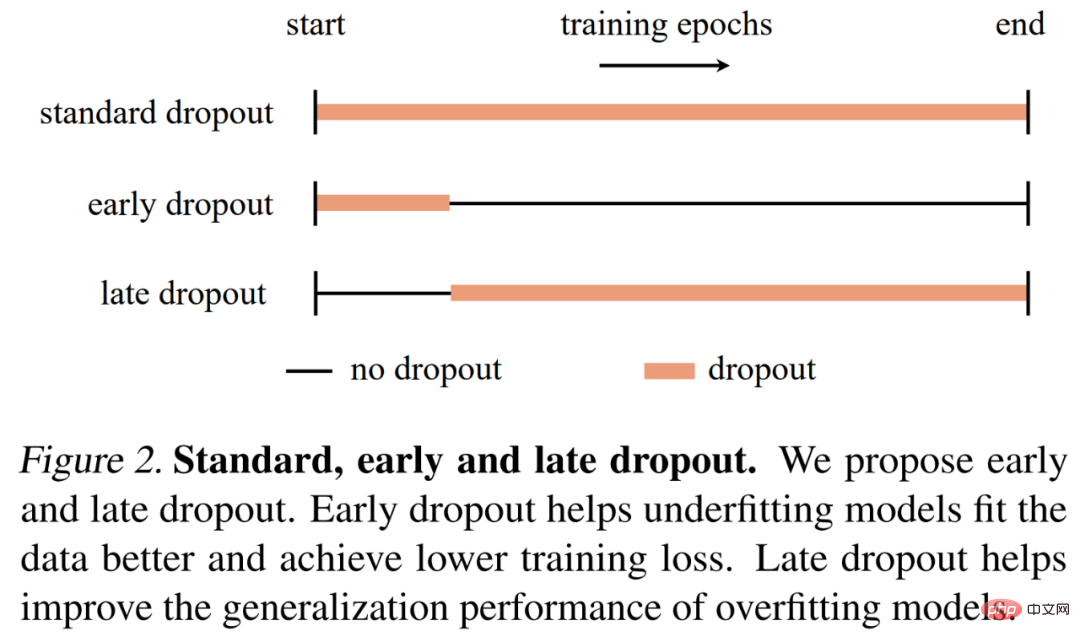

Sur la base de ces résultats, les chercheurs ont proposé un abandon précoce (c'est-à-dire que l'abandon n'est utilisé que dans les premiers stades de la formation) pour aider les modèles sous-adaptés à mieux s'adapter. L'abandon précoce réduit la perte d'entraînement finale par rapport à l'absence d'abandon et à l'abandon standard. En revanche, pour les modèles qui utilisent déjà l’abandon standard, les chercheurs recommandent de supprimer l’abandon dès les premières périodes d’entraînement afin de réduire le surapprentissage. Ils ont qualifié cette méthode d’abandon tardif et ont montré qu’elle pouvait améliorer la précision de généralisation des grands modèles. La figure 2 ci-dessous compare l'abandon standard, l'abandon précoce et l'abandon tardif.

Les chercheurs ont utilisé différents modèles pour évaluer l'abandon précoce et l'abandon tardif dans la classification d'images et les tâches en aval, et les résultats ont montré que les deux produisaient systématiquement de meilleurs résultats que l'abandon standard et l'absence d'abandon. Ils espèrent que leurs découvertes pourront fournir de nouvelles informations sur l’abandon et le surapprentissage et inspirer le développement ultérieur de régularisateurs de réseaux neuronaux.

Analyse et validation

Avant de proposer l'abandon précoce et l'abandon tardif, cette étude a exploré si l'abandon scolaire pouvait être utilisé comme un outil pour réduire le sous-apprentissage. Cette étude a effectué une analyse détaillée de la dynamique de formation des abandons à l'aide des outils et des mesures proposés, et a comparé les processus de formation de deux ViT-T/16 sur ImageNet (Deng et al., 2009) : un sans abandon comme référence ; L'autre One a un taux d'abandon de 0,1 tout au long de la formation.

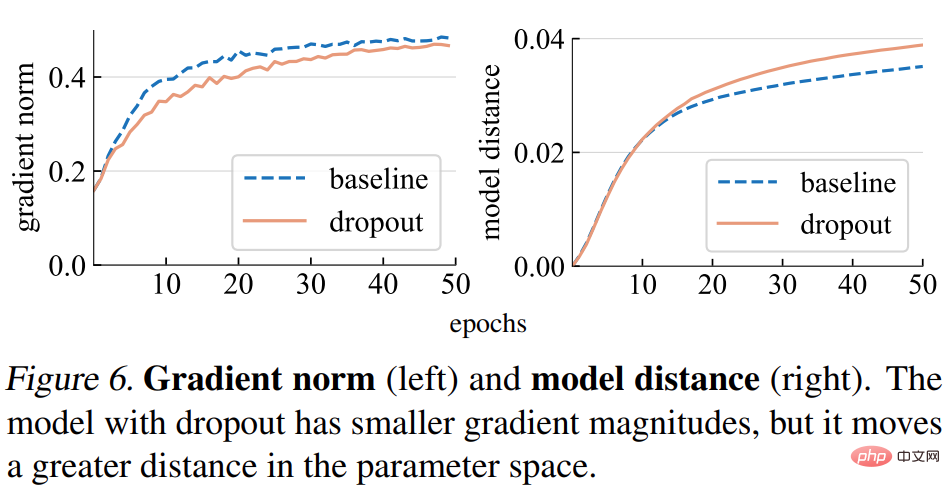

Norme de dégradé (norme). Cette étude analyse d’abord l’impact du décrochage scolaire sur la force du gradient g. Comme le montre la figure 6 (à gauche) ci-dessous, le modèle d'abandon produit des gradients avec des normes plus petites, indiquant qu'il effectue des étapes plus petites à chaque mise à jour du gradient.

Distance du modèle. Étant donné que la taille du pas de gradient est plus petite, nous nous attendons à ce que le modèle d'abandon se déplace sur une distance plus petite par rapport à son point initial que le modèle de base. Comme le montre la figure 6 (à droite) ci-dessous, l'étude a tracé la distance entre chaque modèle et son initialisation aléatoire. Cependant, de manière surprenante, le modèle d’abandon a en fait parcouru une plus grande distance que le modèle de base, contrairement à ce que l’étude attendait initialement sur la base de la norme de gradient.

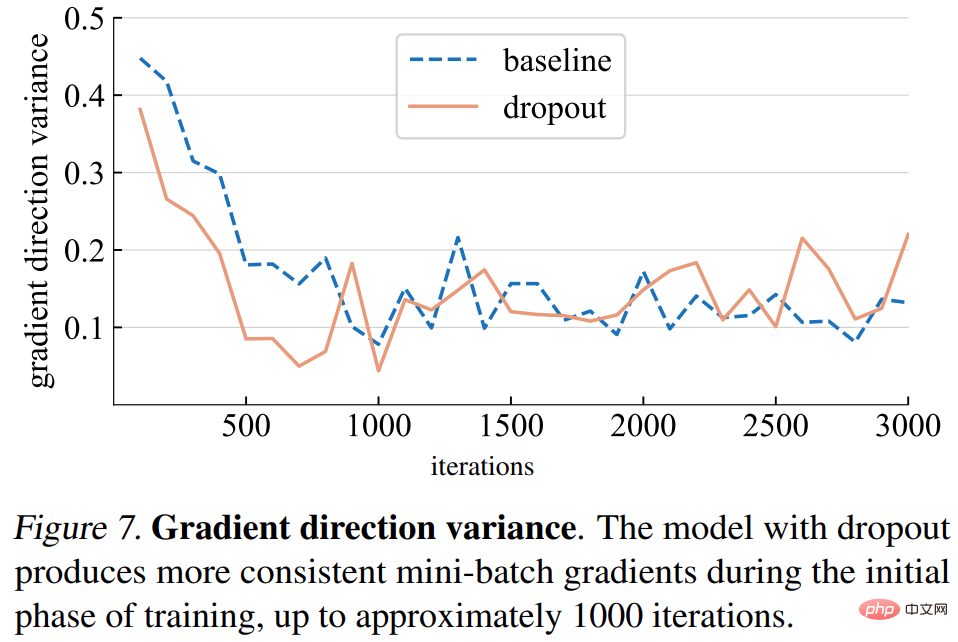

Variation de direction du dégradé. L’étude émet d’abord l’hypothèse que les modèles d’abandon produisent des directions de gradient plus cohérentes entre les mini-lots. Les écarts présentés dans la figure 7 ci-dessous sont généralement conformes aux hypothèses. Jusqu'à un certain nombre d'itérations (environ 1 000), les variances de gradient du modèle d'abandon et du modèle de base fluctuent à un faible niveau.

Erreur de direction du dégradé. Cependant, quelle devrait être la bonne direction du dégradé ? Pour adapter les données d'entraînement, l'objectif fondamental est de minimiser la perte de l'ensemble de l'entraînement, et pas seulement la perte d'un mini-lot. L'étude calcule le gradient d'un modèle donné sur l'ensemble de l'ensemble d'entraînement, avec un abandon défini en mode d'inférence pour capturer le gradient du modèle complet. L'erreur de direction du gradient est illustrée à la figure 8 ci-dessous.

Sur la base de l'analyse ci-dessus, cette étude a révélé que l'utilisation de l'abandon le plus tôt possible peut potentiellement améliorer la capacité du modèle à s'adapter aux données d'entraînement. La nécessité d'un meilleur ajustement aux données d'entraînement dépend du fait que le modèle soit sous-ajusté ou surajusté, ce qui peut être difficile à définir avec précision. L'étude a utilisé les critères suivants :

- Si un modèle se généralise mieux en cas d'abandon standard, il est considéré comme un surapprentissage ;

- Si le modèle fonctionne mieux sans abandon, alors il est considéré comme un sous-apprentissage ;

L'état du modèle dépend non seulement de l'architecture du modèle, mais également de l'ensemble de données utilisé et d'autres paramètres d'entraînement.

Ensuite, l'étude a proposé deux méthodes, l'abandon précoce et l'abandon tardif

l'abandon précoce. Par défaut, les modèles sous-équipés n'utilisent pas de décrochage. Pour améliorer sa capacité d'adaptation aux données d'entraînement, cette étude propose un abandon précoce : utiliser l'abandon avant une certaine itération, puis désactiver l'abandon pendant le reste du processus de formation. Les expériences de recherche montrent qu'un abandon précoce réduit la perte finale d'entraînement et améliore la précision.

abandon tardif. L'abandon standard est déjà inclus dans les paramètres de formation pour les modèles de surajustement. Aux premiers stades de la formation, l’abandon peut par inadvertance provoquer un surapprentissage, ce qui n’est pas souhaitable. Pour réduire le surapprentissage, cette étude propose un abandon tardif : l'abandon n'est pas utilisé avant une certaine itération, mais est utilisé dans le reste de la formation.

La méthode proposée dans cette étude est simple dans son concept et sa mise en œuvre, comme le montre la figure 2. L'implémentation nécessite deux hyperparamètres : 1) le nombre d'époques à attendre avant d'activer ou de désactiver l'abandon 2) le taux d'abandon p, qui est similaire au taux d'abandon standard ; Cette étude montre que ces deux hyperparamètres peuvent assurer la robustesse de la méthode proposée.

Expériences et résultats

Les chercheurs ont mené une évaluation empirique sur l'ensemble de données de classification ImageNet-1K avec 1 000 classes et 1,2 million d'images d'entraînement, et ont signalé une précision de validation de premier ordre.

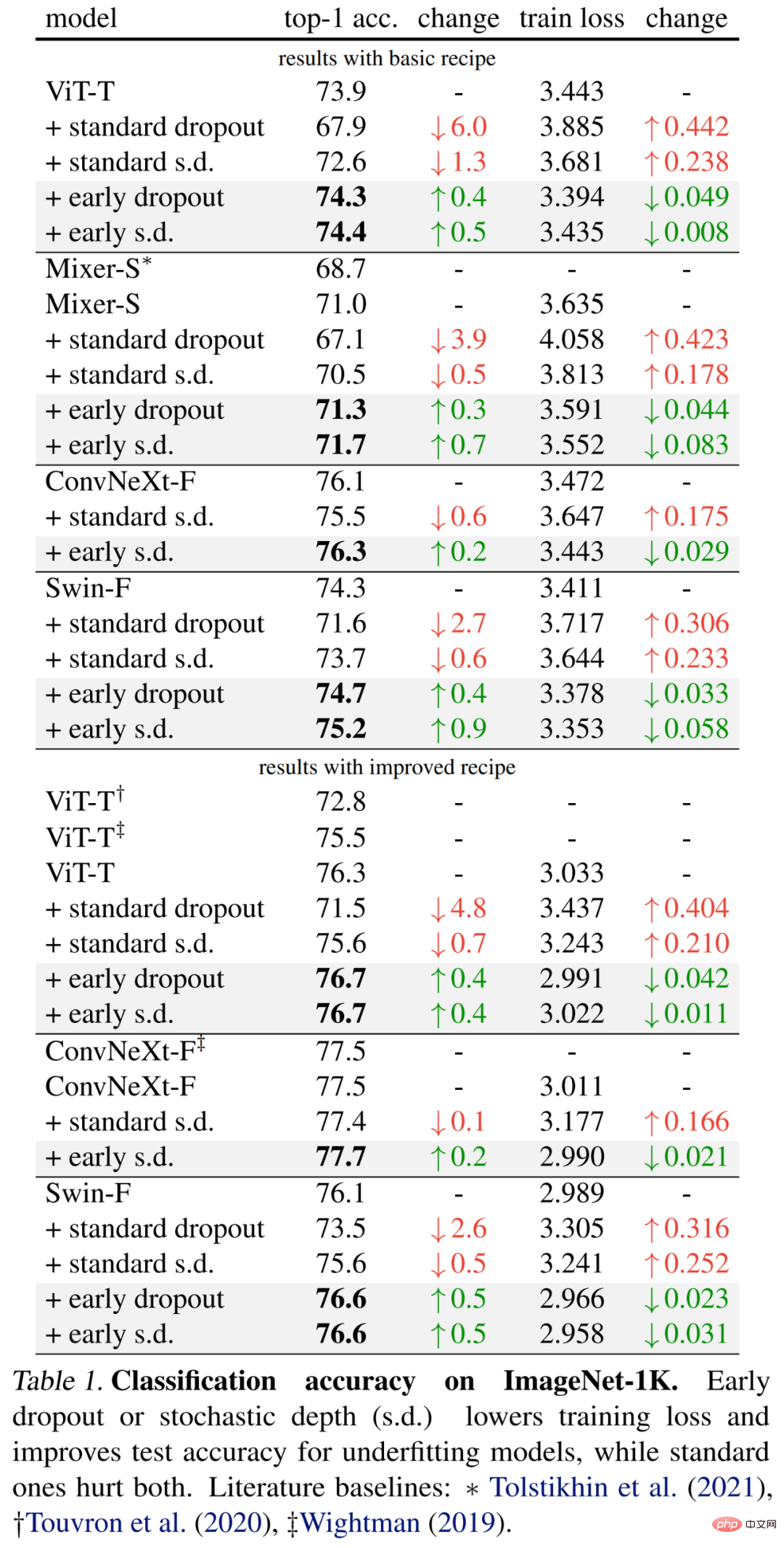

Les résultats spécifiques sont présentés pour la première fois dans le tableau 1 (partie supérieure) ci-dessous. L'abandon précoce continue d'améliorer la précision des tests et de réduire la perte d'entraînement, ce qui indique que l'abandon précoce aide le modèle à mieux s'adapter aux données. Les chercheurs montrent également des résultats de comparaison utilisant un taux de chute de 0,1 par rapport à la profondeur stochastique (SD) d’abandon standard, qui ont tous deux un impact négatif sur le modèle.

De plus, les chercheurs ont amélioré la méthode pour ces petits modèles en doublant les époques d'entraînement et en réduisant l'intensité du mixup et du cutmix. Les résultats du tableau 1 ci-dessous (en bas) montrent des améliorations significatives de la précision de base, dépassant parfois largement les résultats des travaux antérieurs.

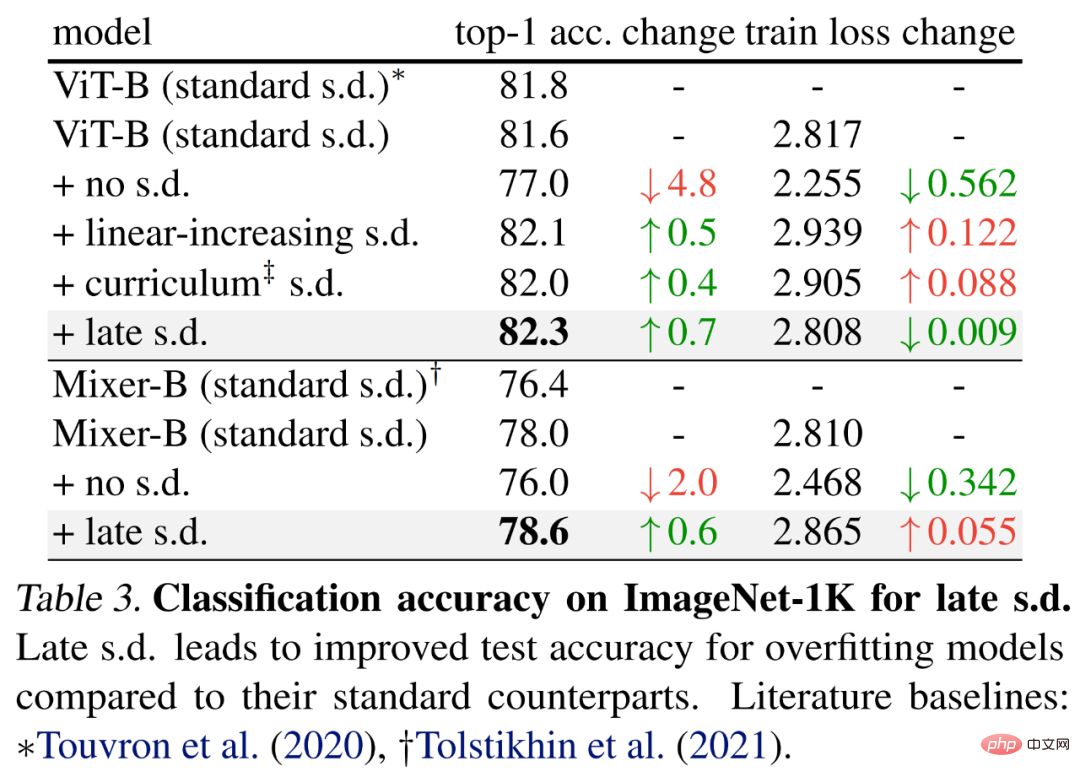

Pour évaluer l'abandon tardif, les chercheurs ont choisi des modèles plus grands, à savoir ViT-B et Mixer-B avec respectivement 59M et 86M de paramètres, en utilisant la méthode d'entraînement de base.

Les résultats sont présentés dans le tableau 3 ci-dessous. Par rapport au s.d. standard, le s.d tardif améliore la précision du test. Cette amélioration est obtenue tout en maintenant ViT-B ou en augmentant la perte d'entraînement du Mixer-B, ce qui indique que le sd tardif réduit efficacement le surapprentissage.

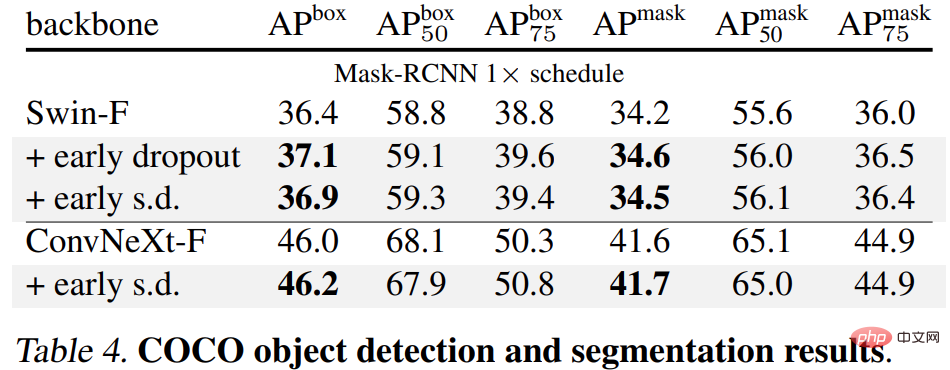

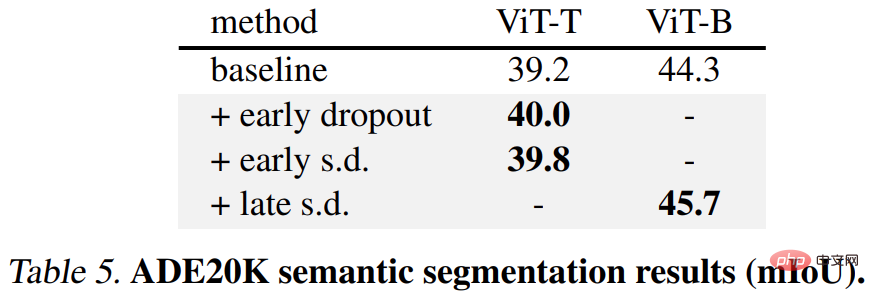

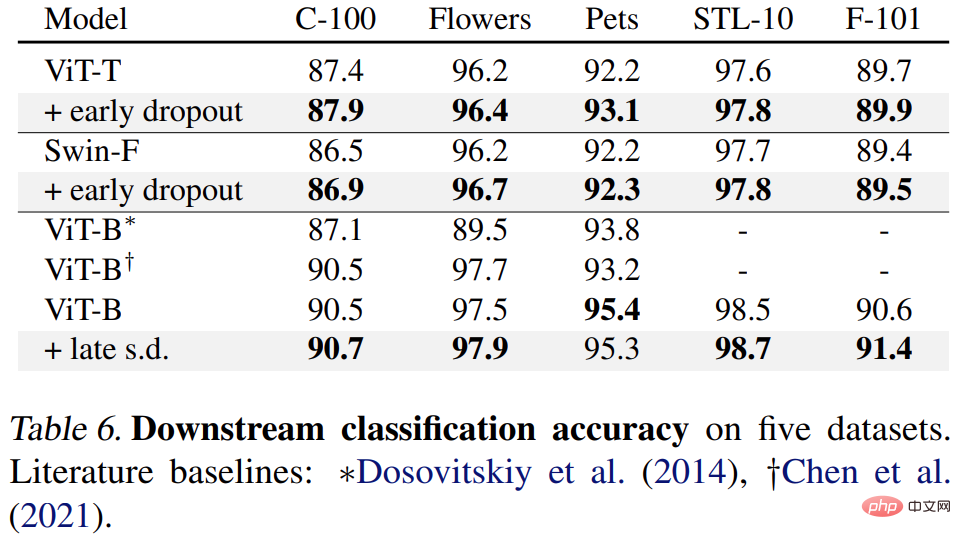

Enfin, les chercheurs ont affiné les modèles ImageNet-1K pré-entraînés sur les tâches en aval et les ont évalués. Les tâches en aval incluent la détection et la segmentation d'objets COCO, la segmentation sémantique ADE20K et la classification en aval sur cinq ensembles de données, dont C-100. L’objectif est d’évaluer la représentation apprise lors de la phase de réglage fin sans utiliser d’abandon précoce ou d’abandon tardif.

Les résultats sont présentés dans les tableaux 4, 5 et 6 ci-dessous. Premièrement, lorsqu'il est affiné sur COCO, le modèle pré-entraîné à l'aide d'un abandon précoce ou s.d. conserve toujours un avantage.

Deuxièmement, pour la tâche de segmentation sémantique ADE20K, le modèle pré-entraîné à l'aide de cette méthode est meilleur que le modèle de base.

Enfin, il existe des tâches de classification en aval. Cette méthode améliore les performances de généralisation sur la plupart des tâches de classification.

Veuillez vous référer à l'article original pour plus de détails techniques et de résultats expérimentaux.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Sujets chauds

Méthodes et étapes d'utilisation de BERT pour l'analyse des sentiments en Python

Jan 22, 2024 pm 04:24 PM

Méthodes et étapes d'utilisation de BERT pour l'analyse des sentiments en Python

Jan 22, 2024 pm 04:24 PM

BERT est un modèle de langage d'apprentissage profond pré-entraîné proposé par Google en 2018. Le nom complet est BidirectionnelEncoderRepresentationsfromTransformers, qui est basé sur l'architecture Transformer et présente les caractéristiques d'un codage bidirectionnel. Par rapport aux modèles de codage unidirectionnels traditionnels, BERT peut prendre en compte les informations contextuelles en même temps lors du traitement du texte, de sorte qu'il fonctionne bien dans les tâches de traitement du langage naturel. Sa bidirectionnalité permet à BERT de mieux comprendre les relations sémantiques dans les phrases, améliorant ainsi la capacité expressive du modèle. Grâce à des méthodes de pré-formation et de réglage fin, BERT peut être utilisé pour diverses tâches de traitement du langage naturel, telles que l'analyse des sentiments, la dénomination

Analyse des fonctions d'activation de l'IA couramment utilisées : pratique d'apprentissage en profondeur de Sigmoid, Tanh, ReLU et Softmax

Dec 28, 2023 pm 11:35 PM

Analyse des fonctions d'activation de l'IA couramment utilisées : pratique d'apprentissage en profondeur de Sigmoid, Tanh, ReLU et Softmax

Dec 28, 2023 pm 11:35 PM

Les fonctions d'activation jouent un rôle crucial dans l'apprentissage profond. Elles peuvent introduire des caractéristiques non linéaires dans les réseaux neuronaux, permettant ainsi au réseau de mieux apprendre et simuler des relations entrées-sorties complexes. La sélection et l'utilisation correctes des fonctions d'activation ont un impact important sur les performances et les résultats de formation des réseaux de neurones. Cet article présentera quatre fonctions d'activation couramment utilisées : Sigmoid, Tanh, ReLU et Softmax, à partir de l'introduction, des scénarios d'utilisation, des avantages, Les inconvénients et les solutions d'optimisation sont abordés pour vous fournir une compréhension complète des fonctions d'activation. 1. Fonction sigmoïde Introduction à la formule de la fonction SIgmoïde : La fonction sigmoïde est une fonction non linéaire couramment utilisée qui peut mapper n'importe quel nombre réel entre 0 et 1. Il est généralement utilisé pour unifier le

Au-delà d'ORB-SLAM3 ! SL-SLAM : les scènes de faible luminosité, de gigue importante et de texture faible sont toutes gérées

May 30, 2024 am 09:35 AM

Au-delà d'ORB-SLAM3 ! SL-SLAM : les scènes de faible luminosité, de gigue importante et de texture faible sont toutes gérées

May 30, 2024 am 09:35 AM

Écrit précédemment, nous discutons aujourd'hui de la manière dont la technologie d'apprentissage profond peut améliorer les performances du SLAM (localisation et cartographie simultanées) basé sur la vision dans des environnements complexes. En combinant des méthodes d'extraction de caractéristiques approfondies et de correspondance de profondeur, nous introduisons ici un système SLAM visuel hybride polyvalent conçu pour améliorer l'adaptation dans des scénarios difficiles tels que des conditions de faible luminosité, un éclairage dynamique, des zones faiblement texturées et une gigue importante. Notre système prend en charge plusieurs modes, notamment les configurations étendues monoculaire, stéréo, monoculaire-inertielle et stéréo-inertielle. En outre, il analyse également comment combiner le SLAM visuel avec des méthodes d’apprentissage profond pour inspirer d’autres recherches. Grâce à des expériences approfondies sur des ensembles de données publiques et des données auto-échantillonnées, nous démontrons la supériorité du SL-SLAM en termes de précision de positionnement et de robustesse du suivi.

Intégration d'espace latent : explication et démonstration

Jan 22, 2024 pm 05:30 PM

Intégration d'espace latent : explication et démonstration

Jan 22, 2024 pm 05:30 PM

L'intégration d'espace latent (LatentSpaceEmbedding) est le processus de mappage de données de grande dimension vers un espace de faible dimension. Dans le domaine de l'apprentissage automatique et de l'apprentissage profond, l'intégration d'espace latent est généralement un modèle de réseau neuronal qui mappe les données d'entrée de grande dimension dans un ensemble de représentations vectorielles de basse dimension. Cet ensemble de vecteurs est souvent appelé « vecteurs latents » ou « latents ». encodages". Le but de l’intégration de l’espace latent est de capturer les caractéristiques importantes des données et de les représenter sous une forme plus concise et compréhensible. Grâce à l'intégration de l'espace latent, nous pouvons effectuer des opérations telles que la visualisation, la classification et le regroupement de données dans un espace de faible dimension pour mieux comprendre et utiliser les données. L'intégration d'espace latent a de nombreuses applications dans de nombreux domaines, tels que la génération d'images, l'extraction de caractéristiques, la réduction de dimensionnalité, etc. L'intégration de l'espace latent est le principal

Comprendre en un seul article : les liens et les différences entre l'IA, le machine learning et le deep learning

Mar 02, 2024 am 11:19 AM

Comprendre en un seul article : les liens et les différences entre l'IA, le machine learning et le deep learning

Mar 02, 2024 am 11:19 AM

Dans la vague actuelle de changements technologiques rapides, l'intelligence artificielle (IA), l'apprentissage automatique (ML) et l'apprentissage profond (DL) sont comme des étoiles brillantes, à la tête de la nouvelle vague des technologies de l'information. Ces trois mots apparaissent fréquemment dans diverses discussions de pointe et applications pratiques, mais pour de nombreux explorateurs novices dans ce domaine, leurs significations spécifiques et leurs connexions internes peuvent encore être entourées de mystère. Alors regardons d'abord cette photo. On constate qu’il existe une corrélation étroite et une relation progressive entre l’apprentissage profond, l’apprentissage automatique et l’intelligence artificielle. Le deep learning est un domaine spécifique du machine learning, et le machine learning

Super fort! Top 10 des algorithmes de deep learning !

Mar 15, 2024 pm 03:46 PM

Super fort! Top 10 des algorithmes de deep learning !

Mar 15, 2024 pm 03:46 PM

Près de 20 ans se sont écoulés depuis que le concept d'apprentissage profond a été proposé en 2006. L'apprentissage profond, en tant que révolution dans le domaine de l'intelligence artificielle, a donné naissance à de nombreux algorithmes influents. Alors, selon vous, quels sont les 10 meilleurs algorithmes pour l’apprentissage profond ? Voici les meilleurs algorithmes d’apprentissage profond, à mon avis. Ils occupent tous une position importante en termes d’innovation, de valeur d’application et d’influence. 1. Contexte du réseau neuronal profond (DNN) : Le réseau neuronal profond (DNN), également appelé perceptron multicouche, est l'algorithme d'apprentissage profond le plus courant lorsqu'il a été inventé pour la première fois, jusqu'à récemment en raison du goulot d'étranglement de la puissance de calcul. années, puissance de calcul, La percée est venue avec l'explosion des données. DNN est un modèle de réseau neuronal qui contient plusieurs couches cachées. Dans ce modèle, chaque couche transmet l'entrée à la couche suivante et

Comment utiliser les modèles hybrides CNN et Transformer pour améliorer les performances

Jan 24, 2024 am 10:33 AM

Comment utiliser les modèles hybrides CNN et Transformer pour améliorer les performances

Jan 24, 2024 am 10:33 AM

Convolutional Neural Network (CNN) et Transformer sont deux modèles d'apprentissage en profondeur différents qui ont montré d'excellentes performances sur différentes tâches. CNN est principalement utilisé pour les tâches de vision par ordinateur telles que la classification d'images, la détection de cibles et la segmentation d'images. Il extrait les caractéristiques locales de l'image via des opérations de convolution et effectue une réduction de dimensionnalité des caractéristiques et une invariance spatiale via des opérations de pooling. En revanche, Transformer est principalement utilisé pour les tâches de traitement du langage naturel (NLP) telles que la traduction automatique, la classification de texte et la reconnaissance vocale. Il utilise un mécanisme d'auto-attention pour modéliser les dépendances dans des séquences, évitant ainsi le calcul séquentiel dans les réseaux neuronaux récurrents traditionnels. Bien que ces deux modèles soient utilisés pour des tâches différentes, ils présentent des similitudes dans la modélisation des séquences.

Algorithme RMSprop amélioré

Jan 22, 2024 pm 05:18 PM

Algorithme RMSprop amélioré

Jan 22, 2024 pm 05:18 PM

RMSprop est un optimiseur largement utilisé pour mettre à jour les poids des réseaux de neurones. Il a été proposé par Geoffrey Hinton et al. en 2012 et est le prédécesseur de l'optimiseur Adam. L'émergence de l'optimiseur RMSprop vise principalement à résoudre certains problèmes rencontrés dans l'algorithme de descente de gradient SGD, tels que la disparition de gradient et l'explosion de gradient. En utilisant l'optimiseur RMSprop, le taux d'apprentissage peut être ajusté efficacement et les pondérations mises à jour de manière adaptative, améliorant ainsi l'effet de formation du modèle d'apprentissage en profondeur. L'idée principale de l'optimiseur RMSprop est d'effectuer une moyenne pondérée des gradients afin que les gradients à différents pas de temps aient des effets différents sur les mises à jour de poids. Plus précisément, RMSprop calcule le carré de chaque paramètre