Périphériques technologiques

Périphériques technologiques

IA

IA

L'équipe de Zhu Jun a ouvert le premier modèle de diffusion multimodale à grande échelle basé sur Transformer à l'Université Tsinghua, et il a été complètement achevé après la réécriture du texte et des images.

L'équipe de Zhu Jun a ouvert le premier modèle de diffusion multimodale à grande échelle basé sur Transformer à l'Université Tsinghua, et il a été complètement achevé après la réécriture du texte et des images.

L'équipe de Zhu Jun a ouvert le premier modèle de diffusion multimodale à grande échelle basé sur Transformer à l'Université Tsinghua, et il a été complètement achevé après la réécriture du texte et des images.

Il est rapporté que GPT-4 sera publié cette semaine et que la multimodalité sera l'un de ses points forts. Le grand modèle de langage actuel devient une interface universelle pour comprendre diverses modalités et peut donner des textes de réponse basés sur différentes informations modales. Cependant, le contenu généré par le grand modèle de langage se limite uniquement au texte. En revanche, les modèles de diffusion actuels DALL・E 2, Imagen, Stable Diffusion, etc. ont déclenché une révolution dans la création visuelle, mais ces modèles ne supportent qu'une seule fonction crossmodale du texte à l'image, et sont encore loin à partir d’un modèle génératif universel. Le grand modèle multimodal sera capable d'ouvrir les capacités de diverses modalités et de réaliser une conversion entre toutes les modalités, ce qui est considéré comme l'orientation future du développement des modèles génératifs universels.

L'équipe TSAIL dirigée par le professeur Zhu Jun du Département d'informatique de l'Université Tsinghua a récemment publié un article "One Transformer Fits All Distributions in Multi-Modal Diffusion at Scale", qui a été le premier à publier des travaux d'exploration sur des modèles génératifs multimodaux sont réalisés.

Lien papier : https://ml.cs.tsinghua.edu.cn/diffusion/unidiffuser.pdf

Code source ouvert : https://github com/thu-ml/unidiffuser

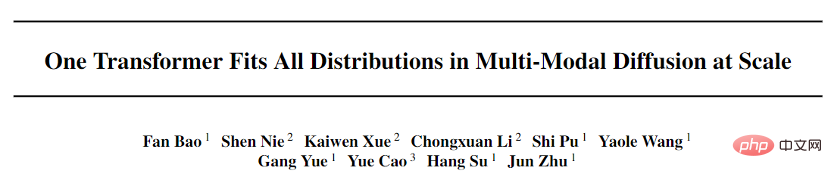

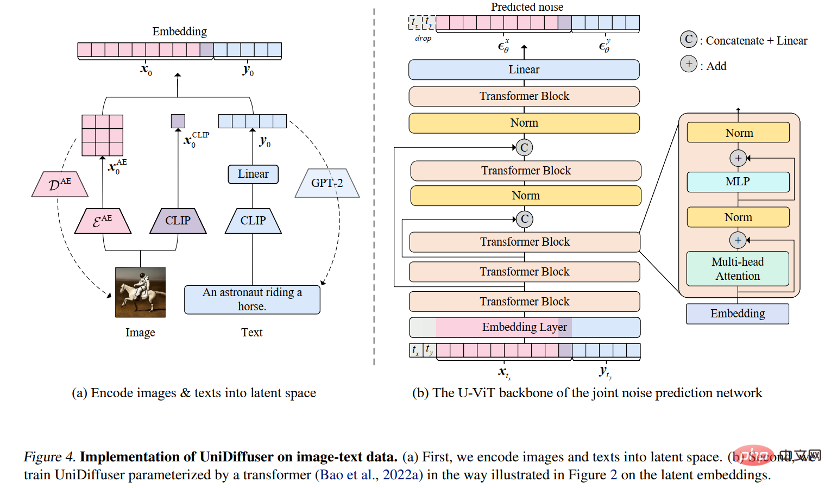

Cet article propose UniDiffuser, un cadre de modélisation probabiliste conçu pour la multimodalité, et adopte l'architecture de réseau basée sur les transformateurs proposée par l'équipe U-ViT, dans le grand format open source. graphique à l'échelle Un modèle avec un milliard de paramètres a été formé sur l'ensemble de données de la littérature LAION-5B, permettant à un modèle sous-jacent d'accomplir une variété de tâches de génération avec une haute qualité (Figure 1). Pour faire simple, en plus de la génération de texte unidirectionnelle, il peut également réaliser de multiples fonctions telles que la génération d'images, la génération conjointe d'images et de texte, la génération inconditionnelle d'images et de texte, la réécriture d'images et de texte, etc., ce qui améliore considérablement la production. l'efficacité du contenu du texte et des images et améliore encore la génération de texte et de graphiques. L'imagination de l'application du modèle de formule.

Bao Fan, le premier auteur de cet article, est actuellement étudiant en doctorat. Il était le précédent proposant d'Analytic-DPM. Il a remporté le prix d'article exceptionnel de l'ICLR 2022 (actuellement le seul article primé de manière indépendante). complété par une unité continentale) pour son travail remarquable en matière de modèles de diffusion).

De plus, Machine Heart a déjà rendu compte de l'algorithme rapide DPM-Solver proposé par l'équipe TSAIL, qui reste l'algorithme de génération le plus rapide pour les modèles de diffusion. Le grand modèle multimodal est un affichage concentré de l'accumulation approfondie à long terme d'algorithmes et de principes de modèles probabilistes profonds par l'équipe. Parmi les collaborateurs de ce travail figurent Li Chongxuan de la Hillhouse School of Artificial Intelligence de l’Université Renmin, Cao Yue de l’Institut de recherche Zhiyuan de Pékin et d’autres.

Il est à noter que les documents et le code de ce projet ont été open source.

Affichage des effets

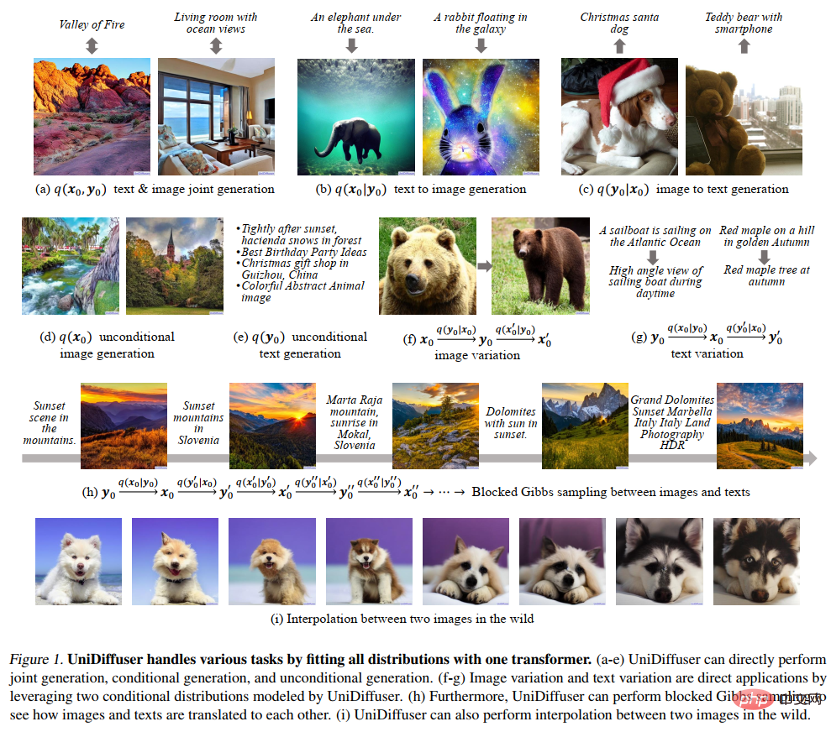

La figure 8 suivante montre l'effet d'UniDiffuser sur la génération conjointe d'images et de textes :

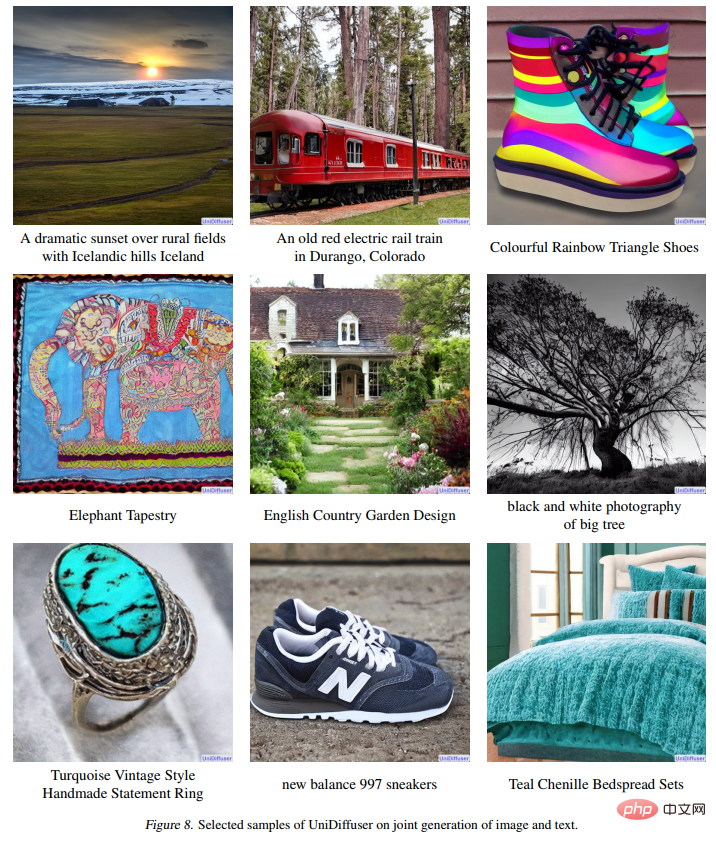

La figure 9 suivante montre l'effet d'UniDiffuser sur le texte à image génération :

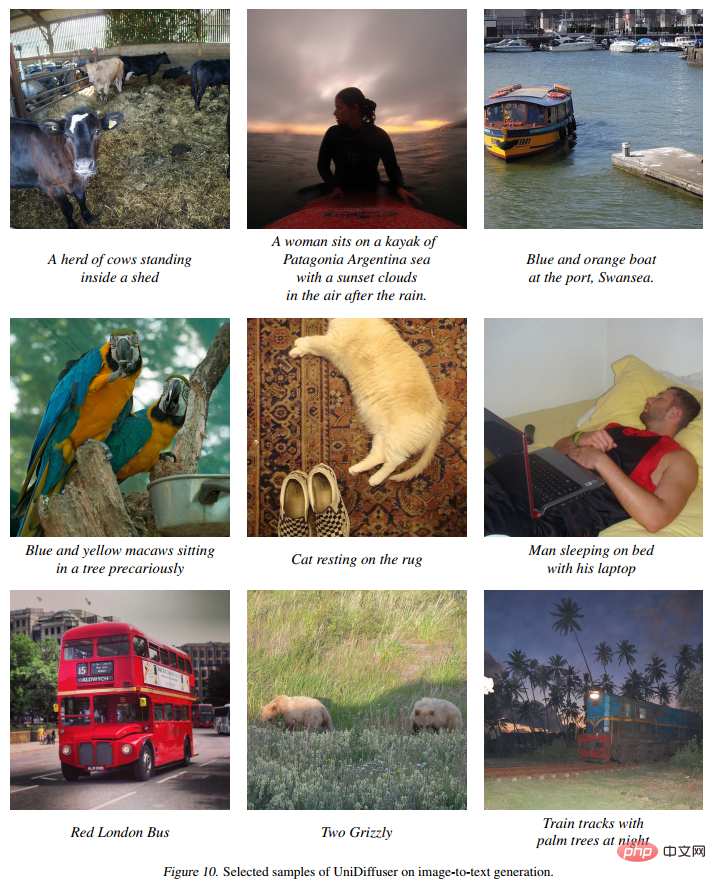

La figure 10 suivante montre l'effet d'UniDiffuser sur l'image en texte :

La figure 11 suivante montre l'effet d'UniDiffuser sur la génération d'images inconditionnelles :

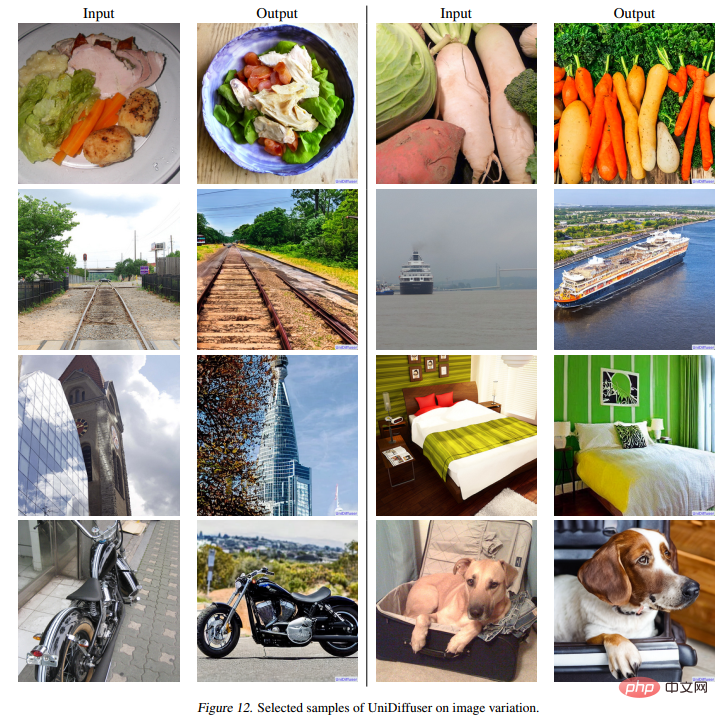

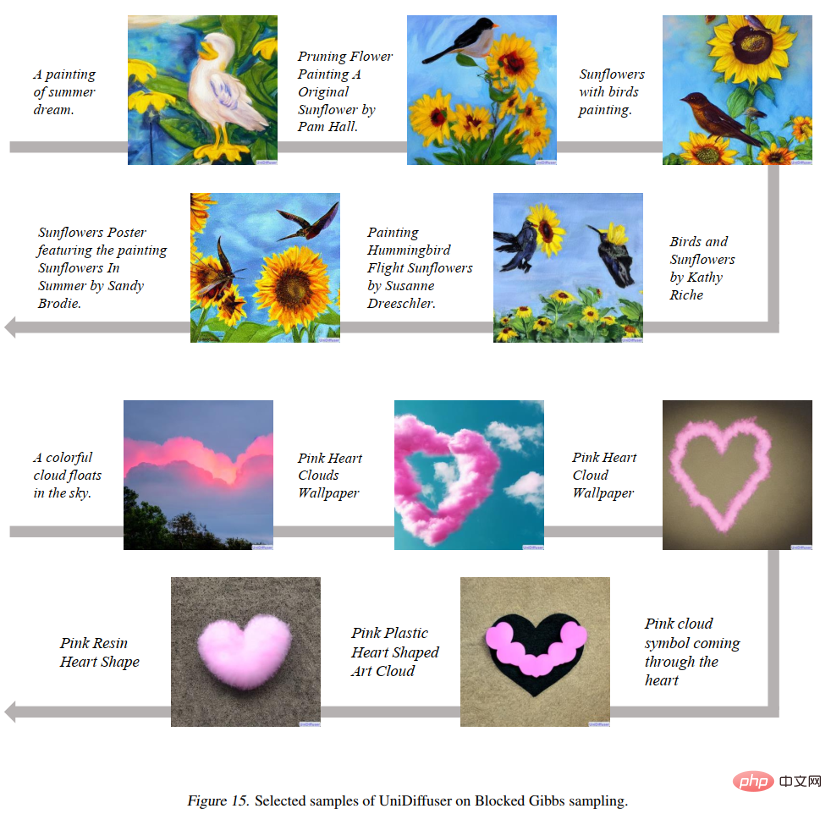

La figure 12 ci-dessous montre l'effet d'UniDiffuser sur la réécriture d'images : 🎜# La figure 15 ci-dessous montre qu'UniDiffuser peut passer d'un mode graphique à un mode texte :

La figure 16 ci-dessous montre qu'UniDiffuser peut interpoler deux images réelles :

L'équipe de recherche a divisé la conception du modèle génératif général en deux sous-problèmes :

Architecture réseau : une architecture réseau unifiée peut-elle être conçue pour prendre en charge diverses modalités d'entrée ?

Cadre de modélisation probabiliste

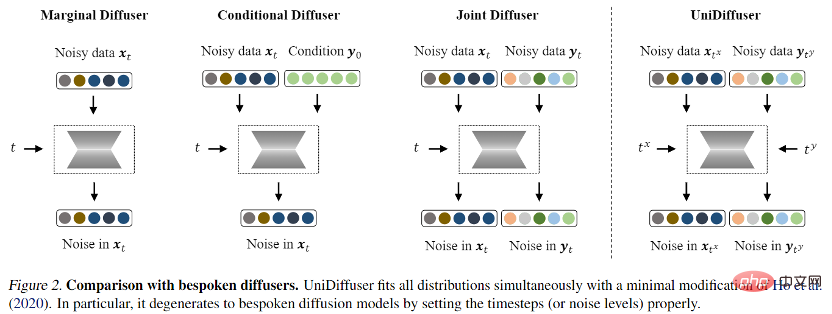

- pour la modélisation de probabilités cadre, l'équipe de recherche propose UniDiffuser, un cadre de modélisation probabiliste basé sur le modèle de diffusion. UniDiffuser peut modéliser explicitement toutes les distributions dans des données multimodales, y compris les distributions marginales, les distributions conditionnelles et les distributions conjointes. L'équipe de recherche a découvert que l'apprentissage du modèle de diffusion sur différentes distributions peut être unifié dans une seule perspective : d'abord ajouter une certaine taille de bruit aux données des deux modalités, puis prédire le bruit sur les données des deux modalités. La quantité de bruit sur les deux données modales détermine la distribution spécifique. Par exemple, régler la taille du bruit du texte à 0 correspond à la distribution conditionnelle du diagramme vincentien ; régler la taille du bruit du texte à la valeur maximale correspond à la distribution de la génération d'image inconditionnelle et ; un texte de même valeur correspond à la répartition de la génération inconditionnelle d'images. Distribution conjointe d'images et de textes. Selon cette perspective unifiée, UniDiffuser n'a besoin que d'apporter de légères modifications à l'algorithme d'entraînement du modèle de diffusion d'origine pour apprendre toutes les distributions ci-dessus en même temps - comme le montre la figure ci-dessous, UniDiffuser ajoute du bruit à tous les modes en même temps. au lieu d'un seul mode, saisissez l'amplitude du bruit correspondant à tous les modes et le bruit prédit sur tous les modes.

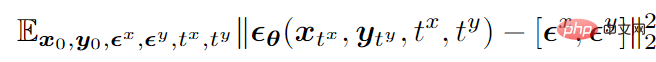

En prenant le mode bimodal comme exemple, la fonction objectif final de l'entraînement est la suivante suit Afficher:

où

représente les données,

# 🎜 🎜#

représente le bruit gaussien standard ajouté aux deux modes,

représente la quantité de bruit ajoutée par les deux modes (c'est-à-dire le temps). Les deux sont échantillonnés indépendamment à partir de {1,2,…,T},

#🎜. 🎜#

est un réseau de prédiction du bruit qui prédit le bruit sur deux modes en même temps.

Après la formation, UniDiffuser est capable de réaliser une génération inconditionnelle, conditionnelle et conjointe en définissant l'heure appropriée pour les deux modes sur le réseau de prédiction du bruit. Par exemple, définir l'heure du texte sur 0 peut réaliser une génération de texte à image ; définir l'heure du texte sur la valeur maximale peut obtenir une génération d'image inconditionnelle ; génération conjointe d’images et de textes.

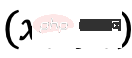

Les algorithmes de formation et d'échantillonnage d'UniDiffuser sont répertoriés ci-dessous. On peut voir que ces algorithmes n'ont apporté que des modifications mineures par rapport au modèle de diffusion d'origine et sont faciles à mettre en œuvre.

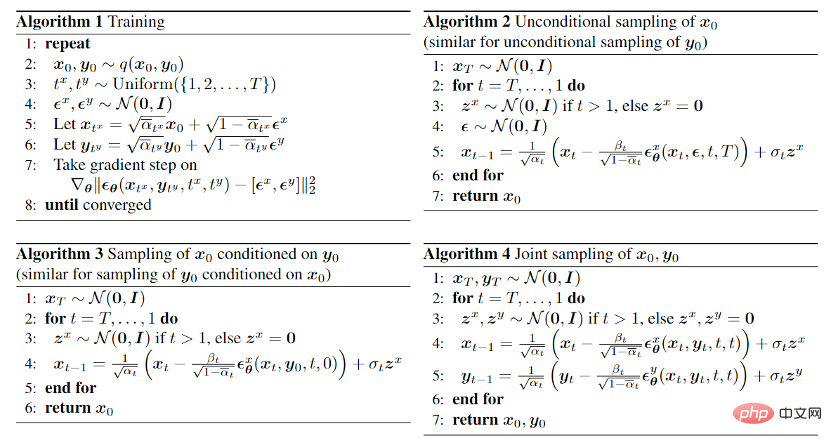

De plus, étant donné qu'UniDiffuser modélise à la fois les distributions conditionnelles et inconditionnelles, UniDiffuser prend naturellement en charge le guidage sans classificateur. La figure 3 ci-dessous montre l'effet de la génération conditionnelle et de la génération conjointe d'UniDiffuser sous différentes échelles de guidage :

Architecture de réseau

Pour l'architecture de réseau, l'équipe de recherche a proposé d'utiliser une architecture basée sur un transformateur. paramétrer les réseaux de prédiction du bruit. Plus précisément, l’équipe de recherche a adopté l’architecture U-ViT récemment proposée. U-ViT traite toutes les entrées comme des jetons et ajoute des connexions en forme de U entre les blocs de transformateur. L’équipe de recherche a également adopté la stratégie de diffusion stable pour convertir les données de différentes modalités en espace latent, puis modéliser le modèle de diffusion. Il convient de noter que l'architecture U-ViT provient également de cette équipe de recherche et est open source sur https://github.com/baofff/U-ViT.

Résultats expérimentaux

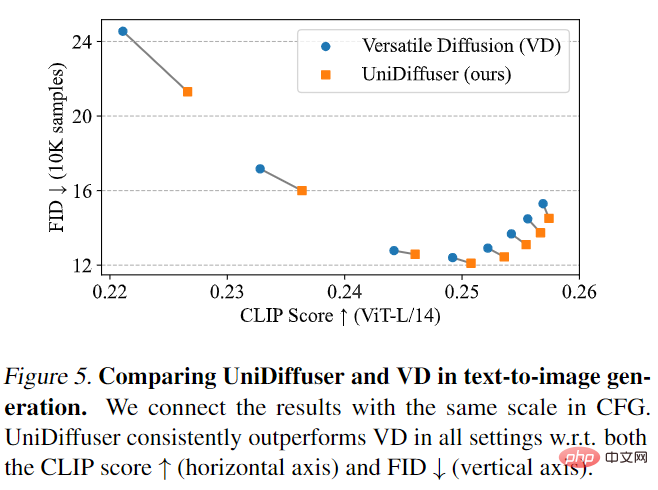

UniDiffuser d'abord comparé à Versatile Diffusion. Versatile Diffusion est un ancien modèle de diffusion multimodale basé sur un cadre multitâche. Tout d’abord, UniDiffuser et Versatile Diffusion ont été comparés sur les effets texte-image. Comme le montre la figure 5 ci-dessous, UniDiffuser est meilleur que Versatile Diffusion en termes de score CLIP et de métriques FID selon différentes échelles de guidage sans classificateur.

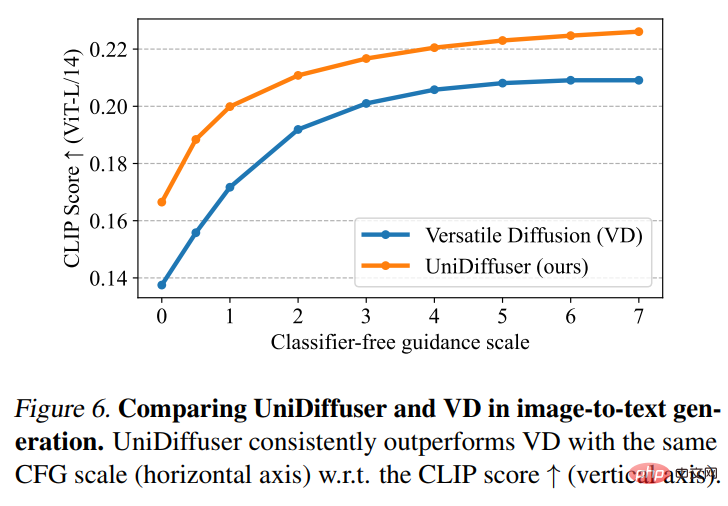

Ensuite, UniDiffuser et Versatile Diffusion ont effectué une comparaison des effets image-texte. Comme le montre la figure 6 ci-dessous, UniDiffuser a un meilleur score CLIP en matière de conversion image-texte.

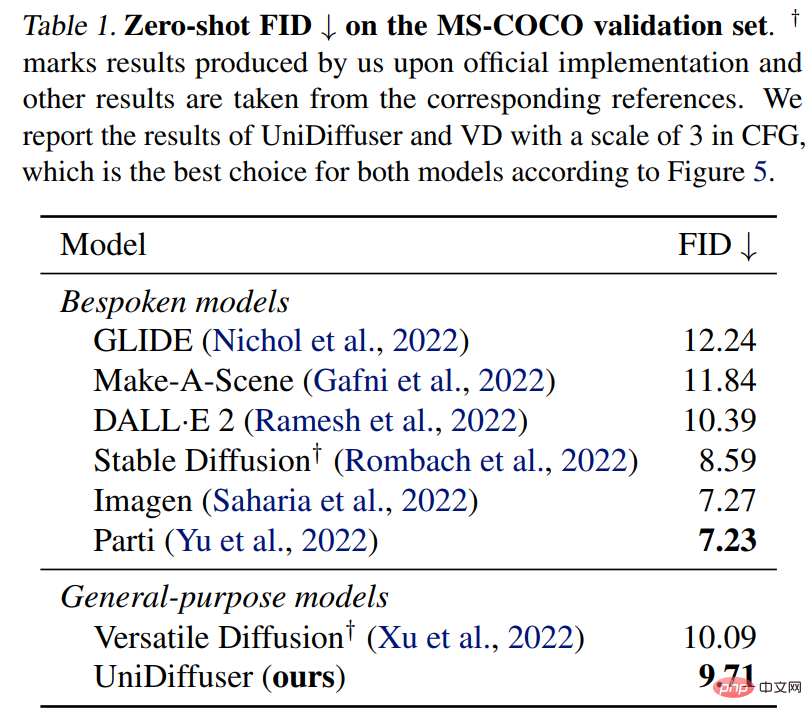

UniDiffuser est également comparé à un modèle texte-graphique dédié pour le FID zéro tir sur MS-COCO. Comme le montre le tableau 1 ci-dessous, UniDiffuser peut obtenir des résultats comparables à ceux des modèles texte-graphique dédiés.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Aucune donnée OpenAI requise, rejoignez la liste des grands modèles de code ! UIUC publie StarCoder-15B-Instruct

Jun 13, 2024 pm 01:59 PM

Aucune donnée OpenAI requise, rejoignez la liste des grands modèles de code ! UIUC publie StarCoder-15B-Instruct

Jun 13, 2024 pm 01:59 PM

À la pointe de la technologie logicielle, le groupe de l'UIUC Zhang Lingming, en collaboration avec des chercheurs de l'organisation BigCode, a récemment annoncé le modèle de grand code StarCoder2-15B-Instruct. Cette réalisation innovante a permis une percée significative dans les tâches de génération de code, dépassant avec succès CodeLlama-70B-Instruct et atteignant le sommet de la liste des performances de génération de code. Le caractère unique de StarCoder2-15B-Instruct réside dans sa stratégie d'auto-alignement pur. L'ensemble du processus de formation est ouvert, transparent et complètement autonome et contrôlable. Le modèle génère des milliers d'instructions via StarCoder2-15B en réponse au réglage fin du modèle de base StarCoder-15B sans recourir à des annotations manuelles coûteuses.

Yolov10 : explication détaillée, déploiement et application en un seul endroit !

Jun 07, 2024 pm 12:05 PM

Yolov10 : explication détaillée, déploiement et application en un seul endroit !

Jun 07, 2024 pm 12:05 PM

1. Introduction Au cours des dernières années, les YOLO sont devenus le paradigme dominant dans le domaine de la détection d'objets en temps réel en raison de leur équilibre efficace entre le coût de calcul et les performances de détection. Les chercheurs ont exploré la conception architecturale de YOLO, les objectifs d'optimisation, les stratégies d'expansion des données, etc., et ont réalisé des progrès significatifs. Dans le même temps, le recours à la suppression non maximale (NMS) pour le post-traitement entrave le déploiement de bout en bout de YOLO et affecte négativement la latence d'inférence. Dans les YOLO, la conception de divers composants manque d’une inspection complète et approfondie, ce qui entraîne une redondance informatique importante et limite les capacités du modèle. Il offre une efficacité sous-optimale et un potentiel d’amélioration des performances relativement important. Dans ce travail, l'objectif est d'améliorer encore les limites d'efficacité des performances de YOLO à la fois en post-traitement et en architecture de modèle. à cette fin

L'Université Tsinghua a pris le relais et YOLOv10 est sorti : les performances ont été grandement améliorées et il figurait sur la hot list de GitHub

Jun 06, 2024 pm 12:20 PM

L'Université Tsinghua a pris le relais et YOLOv10 est sorti : les performances ont été grandement améliorées et il figurait sur la hot list de GitHub

Jun 06, 2024 pm 12:20 PM

La série de référence YOLO de systèmes de détection de cibles a une fois de plus reçu une mise à niveau majeure. Depuis la sortie de YOLOv9 en février de cette année, le relais de la série YOLO (YouOnlyLookOnce) a été passé entre les mains de chercheurs de l'Université Tsinghua. Le week-end dernier, la nouvelle du lancement de YOLOv10 a attiré l'attention de la communauté IA. Il est considéré comme un cadre révolutionnaire dans le domaine de la vision par ordinateur et est connu pour ses capacités de détection d'objets de bout en bout en temps réel, poursuivant l'héritage de la série YOLO en fournissant une solution puissante alliant efficacité et précision. Adresse de l'article : https://arxiv.org/pdf/2405.14458 Adresse du projet : https://github.com/THU-MIG/yo

Rapport technique Google Gemini 1.5 : prouvez facilement les questions de l'Olympiade mathématique, la version Flash est 5 fois plus rapide que GPT-4 Turbo

Jun 13, 2024 pm 01:52 PM

Rapport technique Google Gemini 1.5 : prouvez facilement les questions de l'Olympiade mathématique, la version Flash est 5 fois plus rapide que GPT-4 Turbo

Jun 13, 2024 pm 01:52 PM

En février de cette année, Google a lancé le grand modèle multimodal Gemini 1.5, qui a considérablement amélioré les performances et la vitesse grâce à l'ingénierie et à l'optimisation de l'infrastructure, à l'architecture MoE et à d'autres stratégies. Avec un contexte plus long, des capacités de raisonnement plus fortes et une meilleure gestion du contenu multimodal. Ce vendredi, Google DeepMind a officiellement publié le rapport technique de Gemini 1.5, qui couvre la version Flash et d'autres mises à jour récentes. Le document fait 153 pages. Lien du rapport technique : https://storage.googleapis.com/deepmind-media/gemini/gemini_v1_5_report.pdf Dans ce rapport, Google présente Gemini1

Comment évaluer la rentabilité du support commercial des frameworks Java

Jun 05, 2024 pm 05:25 PM

Comment évaluer la rentabilité du support commercial des frameworks Java

Jun 05, 2024 pm 05:25 PM

L'évaluation du rapport coût/performance du support commercial pour un framework Java implique les étapes suivantes : Déterminer le niveau d'assurance requis et les garanties de l'accord de niveau de service (SLA). L’expérience et l’expertise de l’équipe d’appui à la recherche. Envisagez des services supplémentaires tels que les mises à niveau, le dépannage et l'optimisation des performances. Évaluez les coûts de support commercial par rapport à l’atténuation des risques et à une efficacité accrue.

Revoir! Résumer de manière exhaustive le rôle important des modèles de base dans la promotion de la conduite autonome

Jun 11, 2024 pm 05:29 PM

Revoir! Résumer de manière exhaustive le rôle important des modèles de base dans la promotion de la conduite autonome

Jun 11, 2024 pm 05:29 PM

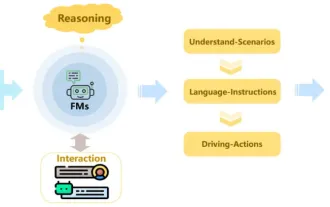

Écrit ci-dessus et compréhension personnelle de l'auteur : Récemment, avec le développement et les percées de la technologie d'apprentissage profond, les modèles de base à grande échelle (Foundation Models) ont obtenu des résultats significatifs dans les domaines du traitement du langage naturel et de la vision par ordinateur. L’application de modèles de base à la conduite autonome présente également de grandes perspectives de développement, susceptibles d’améliorer la compréhension et le raisonnement des scénarios. Grâce à une pré-formation sur un langage riche et des données visuelles, le modèle de base peut comprendre et interpréter divers éléments des scénarios de conduite autonome et effectuer un raisonnement, fournissant ainsi un langage et des commandes d'action pour piloter la prise de décision et la planification. Le modèle de base peut être constitué de données enrichies d'une compréhension du scénario de conduite afin de fournir les rares caractéristiques réalisables dans les distributions à longue traîne qui sont peu susceptibles d'être rencontrées lors d'une conduite de routine et d'une collecte de données.

Comment la courbe d'apprentissage des frameworks PHP se compare-t-elle à celle d'autres frameworks de langage ?

Jun 06, 2024 pm 12:41 PM

Comment la courbe d'apprentissage des frameworks PHP se compare-t-elle à celle d'autres frameworks de langage ?

Jun 06, 2024 pm 12:41 PM

La courbe d'apprentissage d'un framework PHP dépend de la maîtrise du langage, de la complexité du framework, de la qualité de la documentation et du support de la communauté. La courbe d'apprentissage des frameworks PHP est plus élevée par rapport aux frameworks Python et inférieure par rapport aux frameworks Ruby. Par rapport aux frameworks Java, les frameworks PHP ont une courbe d'apprentissage modérée mais un temps de démarrage plus court.

Comment les options légères des frameworks PHP affectent-elles les performances des applications ?

Jun 06, 2024 am 10:53 AM

Comment les options légères des frameworks PHP affectent-elles les performances des applications ?

Jun 06, 2024 am 10:53 AM

Le framework PHP léger améliore les performances des applications grâce à une petite taille et une faible consommation de ressources. Ses fonctionnalités incluent : une petite taille, un démarrage rapide, une faible utilisation de la mémoire, une vitesse de réponse et un débit améliorés et une consommation de ressources réduite. Cas pratique : SlimFramework crée une API REST, seulement 500 Ko, une réactivité élevée et un débit élevé.