Périphériques technologiques

Périphériques technologiques

IA

IA

La conférence EMNLP 2022 est officiellement terminée, le meilleur article long, le meilleur article court et d'autres récompenses sont annoncées

La conférence EMNLP 2022 est officiellement terminée, le meilleur article long, le meilleur article court et d'autres récompenses sont annoncées

La conférence EMNLP 2022 est officiellement terminée, le meilleur article long, le meilleur article court et d'autres récompenses sont annoncées

Récemment, l'EMNLP 2022, la plus grande conférence dans le domaine du traitement du langage naturel, s'est tenue à Abu Dhabi, la capitale des Émirats arabes unis.

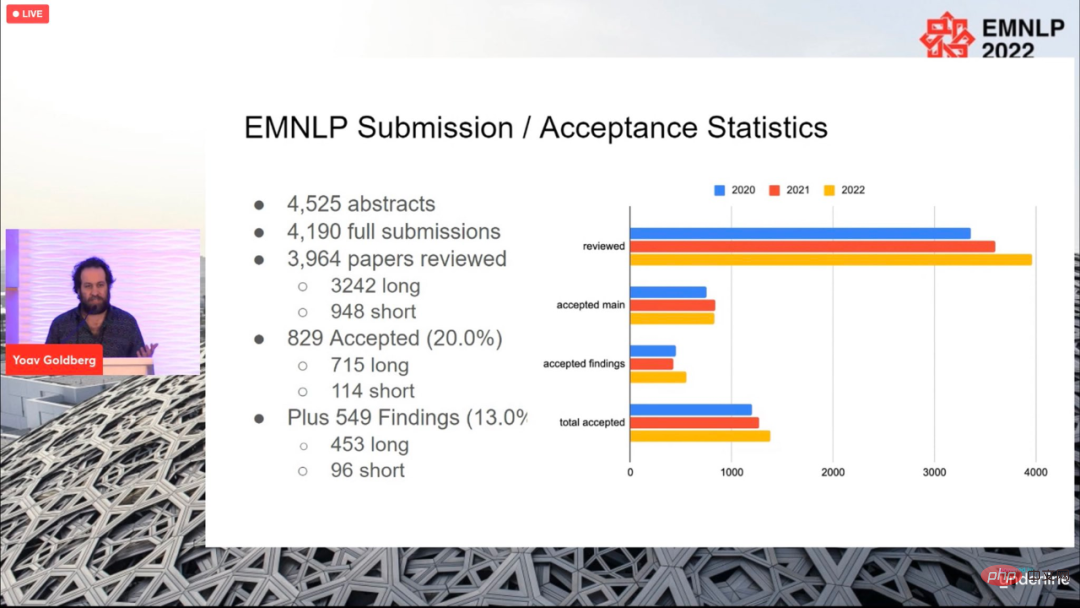

Au total, 4190 articles ont été soumis à la conférence de cette année, et 829 articles ont finalement été acceptés (715 articles longs, 114 articles), avec un taux d'acceptation global de 20 %, ce qui n'est pas très différent des précédents. années.

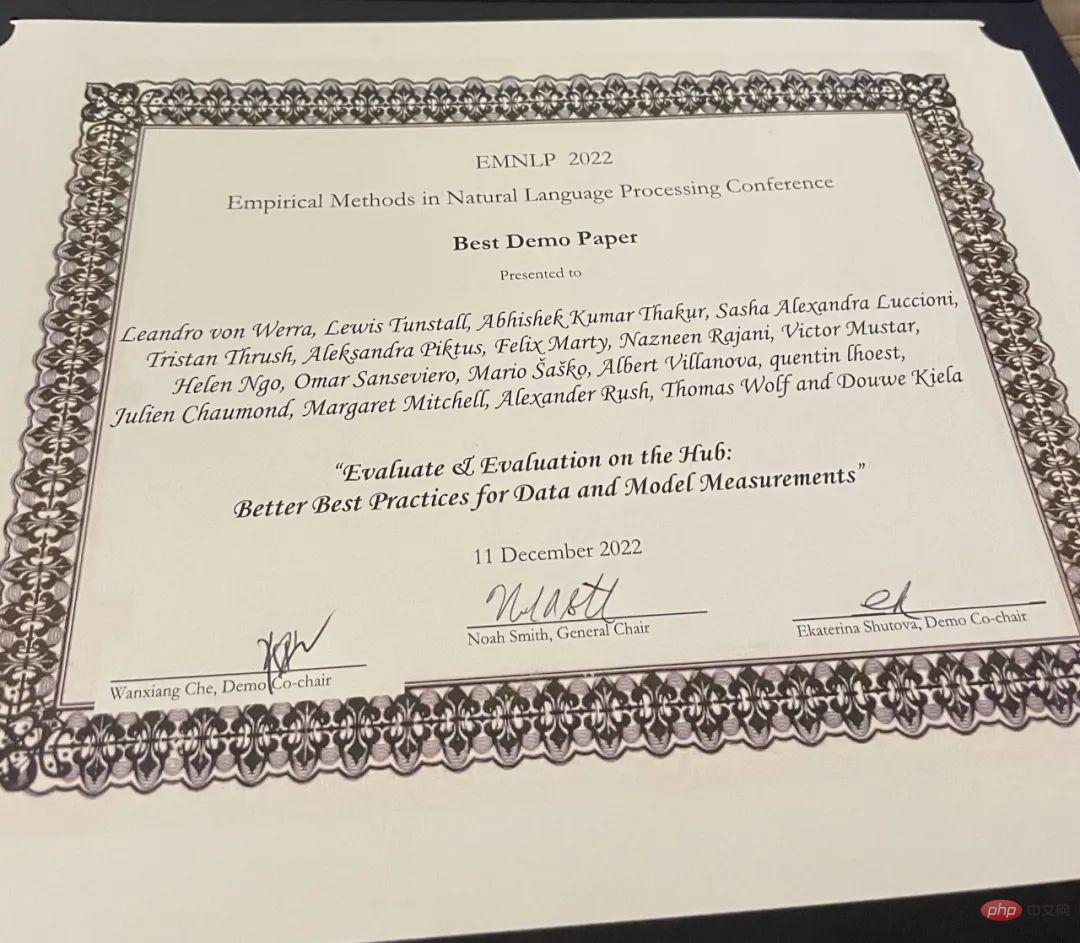

La conférence s'est terminée le 11 décembre, heure locale, et les prix des articles de cette année ont également été annoncés, notamment le meilleur article long (1 pièce), le meilleur article court (1 pièce) et le meilleur article de démonstration (1 article).

Meilleur long article

Article : Raisonnement visuel abstrait avec des formes de Tangram

- Auteurs : Anya Ji, Noriyuki Kojima, Noah Rush, Alane Suhr, Wai Keen Vong, Robert D. Hawkins, Yoav Artzi

- Institutions : Cornell University, New York University, Allen Institute, Princeton University

- Lien papier : https://arxiv.org/pdf/2211.16492.pdf

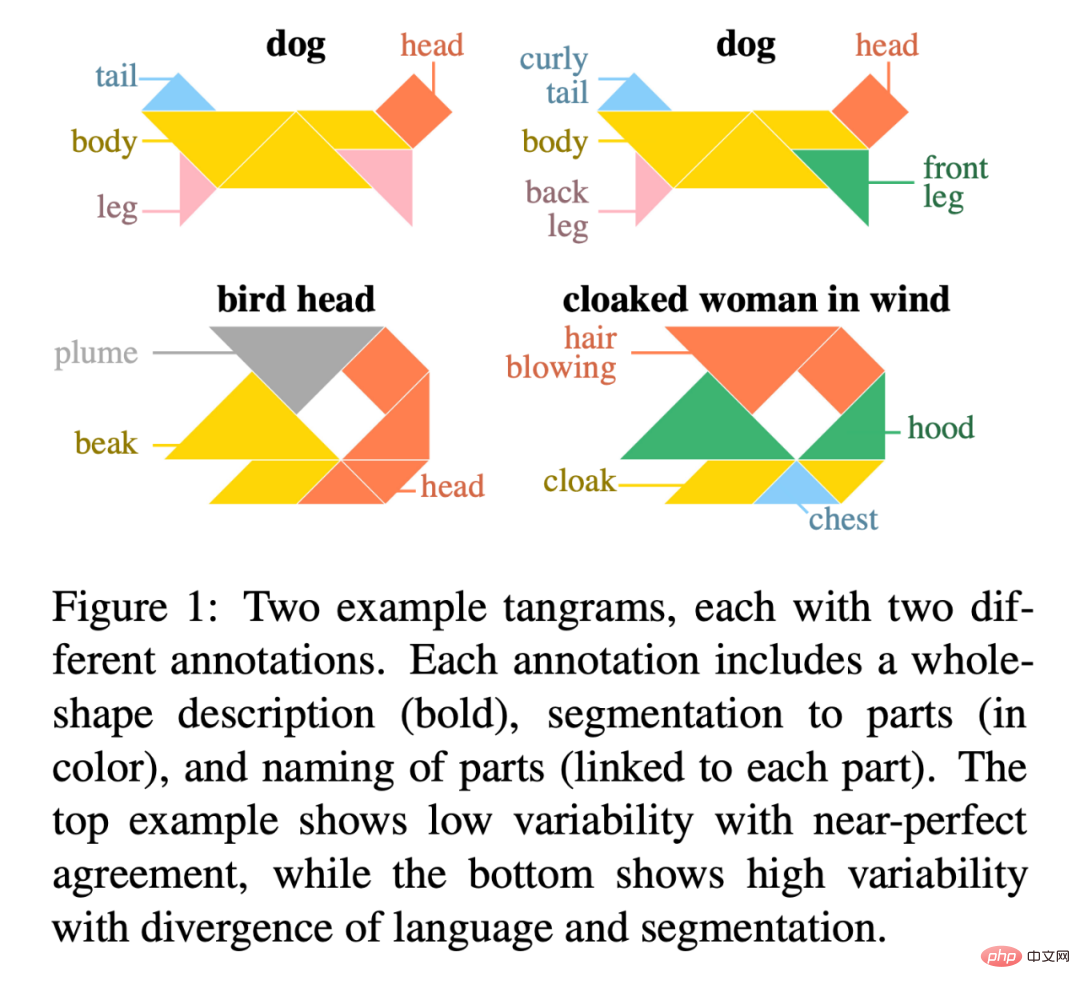

Paper résumé : Dans cet article, les chercheurs présentent "KiloGram", une bibliothèque de ressources pour étudier le raisonnement visuel abstrait des humains et des machines. KiloGram améliore considérablement les ressources existantes de deux manières. Tout d’abord, les chercheurs ont conservé et numérisé 1 016 formes, créant ainsi une collection deux fois plus grande que celles utilisées dans les travaux existants. Cette collection augmente considérablement la couverture de toute la gamme des variations de dénomination, offrant une perspective plus complète sur le comportement humain en matière de dénomination. Deuxièmement, la collection traite chaque tangram non pas comme une forme globale unique, mais comme une forme vectorielle composée des pièces du puzzle original. Cette décomposition permet de raisonner sur des formes entières et leurs parties. Les chercheurs ont utilisé cette nouvelle collection de graphiques de puzzles numériques pour collecter une grande quantité de données de description textuelle, reflétant la grande diversité des comportements de dénomination.

Les chercheurs ont exploité le crowdsourcing pour étendre le processus d'annotation, en collectant plusieurs annotations pour chaque forme afin de représenter la distribution des annotations qu'elle a suscitées plutôt qu'un seul échantillon. Au total, 13 404 annotations ont été collectées, chacune décrivant un objet complet et ses parties divisées. Le potentiel de

KiloGram est vaste. Nous avons utilisé cette ressource pour évaluer les capacités de raisonnement visuel abstrait des modèles multimodaux récents et avons observé que les poids pré-entraînés présentaient des capacités de raisonnement abstrait limitées qui s'amélioraient considérablement avec un réglage fin. Ils ont également observé que les descriptions explicites facilitent le raisonnement abstrait à la fois par les humains et les modèles, en particulier lors du codage conjoint du langage et de l'entrée visuelle.

La figure 1 est un exemple de deux tangrams, chacun avec deux annotations différentes. Chaque annotation comprend une description de la forme entière (en gras), une segmentation des parties (en couleur) et un nom pour chaque partie (liée à chaque partie). L'exemple supérieur montre une faible variabilité pour un accord presque parfait, tandis que l'exemple inférieur montre une forte variabilité pour la divergence de langue et de segmentation.

Adresse KiloGram : https://lil.nlp.cornell.edu/kilogram

Les nominations pour les meilleurs articles longs pour cette conférence sont de Kayo Yin et Graham Neubig Obtenu par deux chercheurs.

Article : Interprétation des modèles linguistiques avec des explications contrastées

- Auteur : Kayo Yin, Graham Neubig

Résumé de l'article : La méthode d'interprétabilité du modèle est souvent utilisée pour expliquer la PNL Modélisez les décisions sur des tâches telles que la classification de texte, où l'espace de sortie est relativement petit. Cependant, lorsqu’elle est appliquée à la génération de langage, l’espace de sortie est souvent constitué de dizaines de milliers de jetons, et ces méthodes ne peuvent pas fournir d’explications informatives. Les modèles linguistiques doivent prendre en compte diverses caractéristiques pour prédire un jeton, telles que sa partie du discours, son nombre, son temps ou sa sémantique. Étant donné que les méthodes explicatives existantes combinent les preuves de toutes ces caractéristiques en une seule explication, cela est moins interprétable pour la compréhension humaine.

Pour distinguer les différentes décisions en matière de modélisation du langage, les chercheurs explorent des modèles de langage qui se concentrent sur des explications contrastées. Ils recherchent des jetons d'entrée qui se démarquent et expliquent pourquoi le modèle a prédit un jeton mais pas un autre. La recherche démontre que les explications contrastées sont bien meilleures que les explications non contrastées pour valider les phénomènes grammaticaux majeurs et qu'elles améliorent considérablement la simulatabilité du modèle contrastif pour les observateurs humains. Les chercheurs ont également identifié des groupes de décisions contrastées pour lesquels le modèle a utilisé des preuves similaires et ont pu décrire les jetons d'entrée utilisés par le modèle dans diverses décisions de génération de langage.

Adresse du code : https://github.com/kayoyin/interpret-lm

Meilleur article court

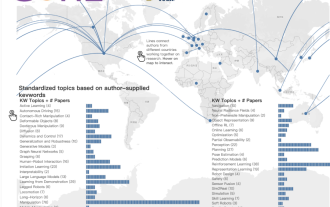

Article : Apprentissage de la représentation de la paternité par sujet régularisé

- Auteur : Jitkapat Sawatphol, Nonthakit Chaiwong, Can Udomcharoenchaikit, Sarana Nutanong

- Institution : VISTEC Institute of Science and Technology, Thaïlande

Résumé : Dans cette étude, les chercheurs ont proposé la représentation de la paternité régulière isation, un cadre de distillation qui améliore les performances multi-sujets et peut également gérer des auteurs invisibles. Cette approche peut être appliquée à n’importe quel modèle de représentation de la paternité. Les résultats expérimentaux montrent que dans un contexte multi-sujets, les performances 4/6 sont améliorées. Dans le même temps, l'analyse des chercheurs montre que dans les ensembles de données comportant un grand nombre de sujets, les fragments de formation répartis sur plusieurs sujets présentent des problèmes de fuite d'informations sur les sujets, affaiblissant ainsi leur capacité à évaluer les attributs inter-sujets. "Meilleur article de démonstration" Luccioni et al

Institution : Hugging Face

Lien papier : https://arxiv.org/pdf/2210.01970.pdf

- Résumé papier : L'évaluation est un machine Élément clé de l'apprentissage (ML), cette étude présente Evaluate and Evaluation on Hub - un ensemble d'outils qui aident à évaluer les modèles et les ensembles de données en ML. Evaluate est une bibliothèque permettant de comparer différents modèles et ensembles de données, prenant en charge diverses métriques. La bibliothèque Evaluate est conçue pour prendre en charge la reproductibilité des évaluations, documenter le processus d'évaluation et étendre la portée des évaluations pour couvrir davantage d'aspects des performances du modèle. Il comprend plus de 50 implémentations efficaces de spécifications pour une variété de domaines et de scénarios, une documentation interactive et la possibilité de partager facilement les résultats de mise en œuvre et d'évaluation.

- Adresse du projet : https://github.com/huggingface/evaluate De plus, le chercheur a également lancé Évaluation on the Hub, une plateforme qui permet d'évaluer gratuitement plus de 75 000 modèles sur Hugging Face. Hub et 11 000 ensembles de données pour une évaluation à grande échelle en un seul clic.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Le papier Stable Diffusion 3 est enfin publié, et les détails architecturaux sont révélés. Cela aidera-t-il à reproduire Sora ?

Mar 06, 2024 pm 05:34 PM

Le papier Stable Diffusion 3 est enfin publié, et les détails architecturaux sont révélés. Cela aidera-t-il à reproduire Sora ?

Mar 06, 2024 pm 05:34 PM

L'article de StableDiffusion3 est enfin là ! Ce modèle est sorti il y a deux semaines et utilise la même architecture DiT (DiffusionTransformer) que Sora. Il a fait beaucoup de bruit dès sa sortie. Par rapport à la version précédente, la qualité des images générées par StableDiffusion3 a été considérablement améliorée. Il prend désormais en charge les invites multithèmes, et l'effet d'écriture de texte a également été amélioré et les caractères tronqués n'apparaissent plus. StabilityAI a souligné que StableDiffusion3 est une série de modèles avec des tailles de paramètres allant de 800M à 8B. Cette plage de paramètres signifie que le modèle peut être exécuté directement sur de nombreux appareils portables, réduisant ainsi considérablement l'utilisation de l'IA.

Prix papier ICCV'23 'Combat des Dieux' ! Meta Divide Everything et ControlNet ont été sélectionnés conjointement, et un autre article a surpris les juges.

Oct 04, 2023 pm 08:37 PM

Prix papier ICCV'23 'Combat des Dieux' ! Meta Divide Everything et ControlNet ont été sélectionnés conjointement, et un autre article a surpris les juges.

Oct 04, 2023 pm 08:37 PM

ICCV2023, la plus grande conférence sur la vision par ordinateur qui s'est tenue à Paris, en France, vient de se terminer ! Le prix du meilleur article de cette année est simplement un « combat entre dieux ». Par exemple, les deux articles qui ont remporté le prix du meilleur article incluaient ControlNet, un travail qui a bouleversé le domaine de l'IA graphique vincentienne. Depuis qu'il est open source, ControlNet a reçu 24 000 étoiles sur GitHub. Qu'il s'agisse des modèles de diffusion ou de l'ensemble du domaine de la vision par ordinateur, le prix de cet article est bien mérité. La mention honorable du prix du meilleur article a été décernée à un autre article tout aussi célèbre, le modèle SAM « Séparez tout » de Meta. Depuis son lancement, « Segment Everything » est devenu la « référence » pour divers modèles d'IA de segmentation d'images, y compris ceux venus de derrière.

NeRF et le passé et le présent de la conduite autonome, résumé de près de 10 articles !

Nov 14, 2023 pm 03:09 PM

NeRF et le passé et le présent de la conduite autonome, résumé de près de 10 articles !

Nov 14, 2023 pm 03:09 PM

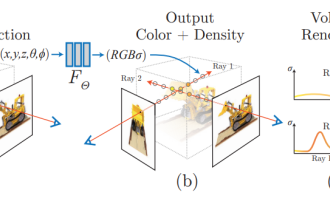

Depuis que Neural Radiance Fields a été proposé en 2020, le nombre d'articles connexes a augmenté de façon exponentielle. Il est non seulement devenu une branche importante de la reconstruction tridimensionnelle, mais est également progressivement devenu actif à la frontière de la recherche en tant qu'outil important pour la conduite autonome. . NeRF a soudainement émergé au cours des deux dernières années, principalement parce qu'il ignore l'extraction et la mise en correspondance des points caractéristiques, la géométrie et la triangulation épipolaires, le PnP plus l'ajustement du faisceau et d'autres étapes du pipeline de reconstruction CV traditionnel, et ignore même la reconstruction du maillage, la cartographie et le traçage de la lumière. , directement à partir de la 2D L'image d'entrée est utilisée pour apprendre un champ de rayonnement, puis une image rendue qui se rapproche d'une photo réelle est sortie du champ de rayonnement. En d’autres termes, supposons qu’un modèle tridimensionnel implicite basé sur un réseau neuronal s’adapte à la perspective spécifiée.

Les captures d'écran du chat révèlent les règles cachées de l'examen de l'IA ! AAAI 3000 yuans, c'est fort accepté ?

Apr 12, 2023 am 08:34 AM

Les captures d'écran du chat révèlent les règles cachées de l'examen de l'IA ! AAAI 3000 yuans, c'est fort accepté ?

Apr 12, 2023 am 08:34 AM

Alors que la date limite de soumission des articles pour l'AAAI 2023 approchait, une capture d'écran d'une discussion anonyme dans le groupe de soumission d'IA est soudainement apparue sur Zhihu. L'un d'eux a affirmé qu'il pouvait fournir un service « 3 000 yuans par acceptation forte ». Dès que la nouvelle est sortie, elle a immédiatement suscité l’indignation du public parmi les internautes. Cependant, ne vous précipitez pas encore. Le patron de Zhihu, "Fine Tuning", a déclaré qu'il s'agissait probablement simplement d'un "plaisir verbal". Selon "Fine Tuning", les salutations et les délits de gangs sont des problèmes inévitables dans tous les domaines. Avec l'essor de l'openreview, les différents inconvénients du cmt sont devenus de plus en plus évidents. L'espace laissé aux petits cercles pour fonctionner deviendra plus petit à l'avenir, mais il y aura toujours de la place. Parce qu'il s'agit d'un problème personnel, pas d'un problème avec le système et le mécanisme de soumission. Présentation de l'open r

Les illustrations papier peuvent également être générées automatiquement, en utilisant le modèle de diffusion, et sont également acceptées par l'ICLR.

Jun 27, 2023 pm 05:46 PM

Les illustrations papier peuvent également être générées automatiquement, en utilisant le modèle de diffusion, et sont également acceptées par l'ICLR.

Jun 27, 2023 pm 05:46 PM

L'IA générative a pris d'assaut la communauté de l'intelligence artificielle. Les particuliers et les entreprises ont commencé à s'intéresser à la création d'applications de conversion modale associées, telles que les images Vincent, les vidéos Vincent, la musique Vincent, etc. Récemment, plusieurs chercheurs d'institutions de recherche scientifique telles que ServiceNow Research et LIVIA ont tenté de générer des graphiques dans des articles basés sur des descriptions textuelles. À cette fin, ils ont proposé une nouvelle méthode de FigGen, et l’article correspondant a également été inclus dans ICLR2023 sous le nom de TinyPaper. Adresse du document illustré : https://arxiv.org/pdf/2306.00800.pdf Certaines personnes peuvent se demander : pourquoi est-il si difficile de générer les graphiques dans le document ? En quoi cela aide-t-il la recherche scientifique ?

L'équipe chinoise a remporté les prix du meilleur article et du meilleur article système, et les résultats de la recherche CoRL ont été annoncés.

Nov 10, 2023 pm 02:21 PM

L'équipe chinoise a remporté les prix du meilleur article et du meilleur article système, et les résultats de la recherche CoRL ont été annoncés.

Nov 10, 2023 pm 02:21 PM

Depuis sa première tenue en 2017, CoRL est devenue l'une des conférences universitaires les plus importantes au monde à l'intersection de la robotique et de l'apprentissage automatique. CoRL est une conférence à thème unique pour la recherche sur l'apprentissage des robots, couvrant plusieurs sujets tels que la robotique, l'apprentissage automatique et le contrôle, y compris la théorie et l'application. La conférence CoRL 2023 se tiendra à Atlanta, aux États-Unis, du 6 au 9 novembre. Selon les données officielles, 199 articles provenant de 25 pays ont été sélectionnés pour CoRL cette année. Les sujets populaires incluent les opérations, l’apprentissage par renforcement, etc. Bien que CoRL soit à plus petite échelle que les grandes conférences universitaires sur l'IA telles que l'AAAI et le CVPR, à mesure que la popularité de concepts tels que les grands modèles, l'intelligence incarnée et les robots humanoïdes augmente cette année, des recherches pertinentes dignes d'attention seront également

Classement CVPR 2023 publié, le taux d'acceptation est de 25,78% ! 2 360 articles ont été acceptés et le nombre de soumissions a grimpé à 9 155

Apr 13, 2023 am 09:37 AM

Classement CVPR 2023 publié, le taux d'acceptation est de 25,78% ! 2 360 articles ont été acceptés et le nombre de soumissions a grimpé à 9 155

Apr 13, 2023 am 09:37 AM

Tout à l'heure, le CVPR 2023 a publié un article disant : Cette année, nous avons reçu un nombre record de 9 155 articles (12 % de plus que le CVPR2022) et accepté 2 360 articles, avec un taux d'acceptation de 25,78 %. Selon les statistiques, le nombre de soumissions au CVPR n'a augmenté que de 1 724 à 2 145 au cours des 7 années allant de 2010 à 2016. Après 2017, il a grimpé en flèche et est entré dans une période de croissance rapide. En 2019, il a dépassé les 5 000 pour la première fois, et en 2022, le nombre de candidatures avait atteint 8 161. Comme vous pouvez le constater, un total de 9 155 articles ont été soumis cette année, ce qui constitue un record. Une fois l’épidémie atténuée, le sommet CVPR de cette année se tiendra au Canada. Cette année, il s'agira d'une conférence à voie unique et la traditionnelle sélection orale sera annulée. recherche Google

Le nouveau papier brûlant de Microsoft : Transformer s'étend à 1 milliard de jetons

Jul 22, 2023 pm 03:34 PM

Le nouveau papier brûlant de Microsoft : Transformer s'étend à 1 milliard de jetons

Jul 22, 2023 pm 03:34 PM

Alors que chacun continue de mettre à niveau et d'itérer ses propres grands modèles, la capacité du LLM (grand modèle de langage) à traiter les fenêtres contextuelles est également devenue un indicateur d'évaluation important. Par exemple, le modèle vedette GPT-4 prend en charge 32 000 jetons, ce qui équivaut à 50 pages de texte ; Anthropic, fondée par un ancien membre d'OpenAI, a augmenté les capacités de traitement des jetons de Claude à 100 000, soit environ 75 000 mots, soit environ équivalent à résumer "Harry Potter" en un clic 》Première partie. Dans les dernières recherches de Microsoft, ils ont cette fois directement étendu Transformer à 1 milliard de jetons. Cela ouvre de nouvelles possibilités pour modéliser des séquences très longues, comme par exemple traiter un corpus entier ou même l'ensemble d'Internet comme une seule séquence. A titre de comparaison, commun