Java

Java

javaDidacticiel

javaDidacticiel

Analyse de l'instance de caféine des performances du cache local intégré SpringBoot

Analyse de l'instance de caféine des performances du cache local intégré SpringBoot

Analyse de l'instance de caféine des performances du cache local intégré SpringBoot

引言

使用缓存的目的就是提高性能,今天码哥带大家实践运用 spring-boot-starter-cache 抽象的缓存组件去集成本地缓存性能之王 Caffeine。

大家需要注意的是:in-memeory 缓存只适合在单体应用,不适合与分布式环境。

分布式环境的情况下需要将缓存修改同步到每个节点,需要一个同步机制保证每个节点缓存数据最终一致。

Spring Cache 是什么

不使用 Spring Cache 抽象的缓存接口,我们需要根据不同的缓存框架去实现缓存,需要在对应的代码里面去对应缓存加载、删除、更新等。

比如查询我们使用旁路缓存策略:先从缓存中查询数据,如果查不到则从数据库查询并写到缓存中。

伪代码如下:

public User getUser(long userId) {

// 从缓存查询

User user = cache.get(userId);

if (user != null) {

return user;

}

// 从数据库加载

User dbUser = loadDataFromDB(userId);

if (dbUser != null) {

// 设置到缓存中

cache.put(userId, dbUser)

}

return dbUser;

}我们需要写大量的这种繁琐代码,Spring Cache 则对缓存进行了抽象,提供了如下几个注解实现了缓存管理:

@Cacheable:触发缓存读取操作,用于查询方法上,如果缓存中找到则直接取出缓存并返回,否则执行目标方法并将结果缓存。

@CachePut:触发缓存更新的方法上,与 Cacheable 相比,该注解的方法始终都会被执行,并且使用方法返回的结果去更新缓存,适用于 insert 和 update 行为的方法上。

@CacheEvict:触发缓存失效,删除缓存项或者清空缓存,适用于 delete 方法上。

除此之外,抽象的 CacheManager 既能集成基于本地内存的单体应用,也能集成 EhCache、Redis 等缓存服务器。

最方便的是通过一些简单配置和注解就能接入不同的缓存框架,无需修改任何代码。

集成 Caffeine

码哥带大家使用注解方式完成缓存操作的方式来集成,完整的代码请访问 github:在 pom.xml 文件添加如下依赖:

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-cache</artifactId>

</dependency>

<dependency>

<groupId>com.github.ben-manes.caffeine</groupId>

<artifactId>caffeine</artifactId>

</dependency>使用 JavaConfig 方式配置 CacheManager:

@Slf4j

@EnableCaching

@Configuration

public class CacheConfig {

@Autowired

@Qualifier("cacheExecutor")

private Executor cacheExecutor;

@Bean

public Caffeine<Object, Object> caffeineCache() {

return Caffeine.newBuilder()

// 设置最后一次写入或访问后经过固定时间过期

.expireAfterAccess(7, TimeUnit.DAYS)

// 初始的缓存空间大小

.initialCapacity(500)

// 使用自定义线程池

.executor(cacheExecutor)

.removalListener(((key, value, cause) -> log.info("key:{} removed, removalCause:{}.", key, cause.name())))

// 缓存的最大条数

.maximumSize(1000);

}

@Bean

public CacheManager cacheManager() {

CaffeineCacheManager caffeineCacheManager = new CaffeineCacheManager();

caffeineCacheManager.setCaffeine(caffeineCache());

// 不缓存空值

caffeineCacheManager.setAllowNullValues(false);

return caffeineCacheManager;

}

}准备工作搞定,接下来就是如何使用了。

@Slf4j

@Service

public class AddressService {

public static final String CACHE_NAME = "caffeine:address";

private static final AtomicLong ID_CREATOR = new AtomicLong(0);

private Map<Long, AddressDTO> addressMap;

public AddressService() {

addressMap = new ConcurrentHashMap<>();

addressMap.put(ID_CREATOR.incrementAndGet(), AddressDTO.builder().customerId(ID_CREATOR.get()).address("地址1").build());

addressMap.put(ID_CREATOR.incrementAndGet(), AddressDTO.builder().customerId(ID_CREATOR.get()).address("地址2").build());

addressMap.put(ID_CREATOR.incrementAndGet(), AddressDTO.builder().customerId(ID_CREATOR.get()).address("地址3").build());

}

@Cacheable(cacheNames = {CACHE_NAME}, key = "#customerId")

public AddressDTO getAddress(long customerId) {

log.info("customerId:{} 没有走缓存,开始从数据库查询", customerId);

return addressMap.get(customerId);

}

@CachePut(cacheNames = {CACHE_NAME}, key = "#result.customerId")

public AddressDTO create(String address) {

long customerId = ID_CREATOR.incrementAndGet();

AddressDTO addressDTO = AddressDTO.builder().customerId(customerId).address(address).build();

addressMap.put(customerId, addressDTO);

return addressDTO;

}

@CachePut(cacheNames = {CACHE_NAME}, key = "#result.customerId")

public AddressDTO update(Long customerId, String address) {

AddressDTO addressDTO = addressMap.get(customerId);

if (addressDTO == null) {

throw new RuntimeException("没有 customerId = " + customerId + "的地址");

}

addressDTO.setAddress(address);

return addressDTO;

}

@CacheEvict(cacheNames = {CACHE_NAME}, key = "#customerId")

public boolean delete(long customerId) {

log.info("缓存 {} 被删除", customerId);

return true;

}

}使用 CacheName 隔离不同业务场景的缓存,每个 Cache 内部持有一个 map 结构存储数据,key 可用使用 Spring 的 Spel 表达式。

单元测试走起:

@RunWith(SpringRunner.class)

@SpringBootTest(classes = CaffeineApplication.class)

@Slf4j

public class CaffeineApplicationTests {

@Autowired

private AddressService addressService;

@Autowired

private CacheManager cacheManager;

@Test

public void testCache() {

// 插入缓存 和数据库

AddressDTO newInsert = addressService.create("南山大道");

// 要走缓存

AddressDTO address = addressService.getAddress(newInsert.getCustomerId());

long customerId = 2;

// 第一次未命中缓存,打印 customerId:{} 没有走缓存,开始从数据库查询

AddressDTO address2 = addressService.getAddress(customerId);

// 命中缓存

AddressDTO cacheAddress2 = addressService.getAddress(customerId);

// 更新数据库和缓存

addressService.update(customerId, "地址 2 被修改");

// 更新后查询,依然命中缓存

AddressDTO hitCache2 = addressService.getAddress(customerId);

Assert.assertEquals(hitCache2.getAddress(), "地址 2 被修改");

// 删除缓存

addressService.delete(customerId);

// 未命中缓存, 从数据库读取

AddressDTO hit = addressService.getAddress(customerId);

System.out.println(hit.getCustomerId());

}

}大家发现没,只需要在对应的方法上加上注解,就能愉快的使用缓存了。需要注意的是, 设置的 cacheNames 一定要对应,每个业务场景使用对应的 cacheNames。

另外 key 可以使用 spel 表达式,大家重点可以关注 @CachePut(cacheNames = {CACHE_NAME}, key = "#result.customerId"),result 表示接口返回结果,Spring 提供了几个元数据直接使用。

| 名称 | 地点 | 描述 | 例子 |

|---|---|---|---|

| methodName | 根对象 | 被调用的方法的名称 | #root.methodName |

| method | 根对象 | 被调用的方法 | #root.method.name |

| target | 根对象 | 被调用的目标对象 | #root.target |

| targetClass | 根对象 | 被调用的目标的类 | #root.targetClass |

| args | 根对象 | 用于调用目标的参数(作为数组) | #root.args[0] |

| caches | 根对象 | 运行当前方法的缓存集合 | #root.caches[0].name |

| 参数名称 | 评估上下文 | 任何方法参数的名称。如果名称不可用(可能是由于没有调试信息),则参数名称也可在#a where#arg代表参数索引(从 开始0)下获得。 | #iban或#a0(您也可以使用#p0或#p表示法作为别名)。 |

| result | 评估上下文 | 方法调用的结果(要缓存的值)。仅在unless 表达式、cache put表达式(计算key)或cache evict 表达式(when beforeInvocationis false)中可用。对于支持的包装器(例如 Optional),#result指的是实际对象,而不是包装器。 | #result |

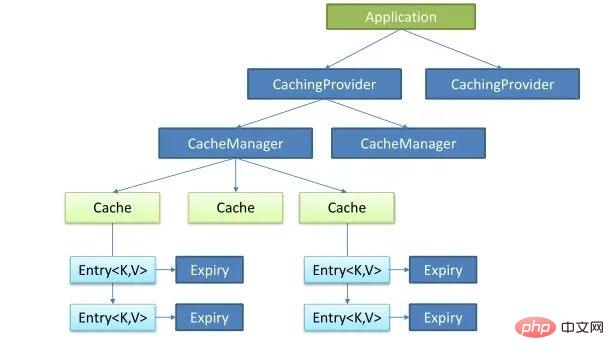

CorePrincipe

Java Caching définit 5 interfaces principales, à savoir CachingProvider, CacheManager, Cache, Entry et Expiry.

Diagramme des classes de base :

- #🎜 🎜#Cache : abstrait les opérations de cache, telles que get(), put();

- CacheManager : gère le Cache, qui peut être compris comme la gestion de la collection de Cache So. il existe plusieurs caches car différents délais d'expiration du cache et limites de quantité peuvent être utilisés selon différents scénarios.

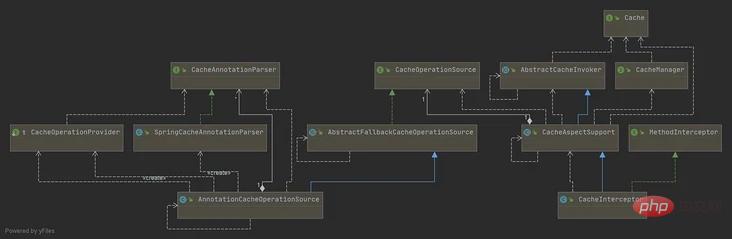

- CacheInterceptor, CacheAspectSupport, AbstractCacheInvoker : CacheInterceptor est un intercepteur de méthode AOP qui effectue une logique supplémentaire avant et après la méthode, telle que des opérations de requête, en vérifiant d'abord le cache, et non les données peuvent être trouvées Ensuite, exécutez la méthode et écrivez le résultat de la méthode dans le cache, etc. Il hérite de CacheAspectSupport (la logique principale de l'opération de cache) et AbstractCacheInvoker (encapsule la lecture et l'écriture du cache).

- CacheOperation, AnnotationCacheOperationSource, SpringCacheAnnotationParser : CacheOperation définit le nom du cache, la clé du cache, la condition du cache, CacheManager, etc. de l'opération de cache. AnnotationCacheOperationSource est une méthode qui obtient le cache. annotations correspondant à la classe CacheOperation, et SpringCacheAnnotationParser est une classe qui analyse les annotations, elle sera encapsulée dans une collection CacheOperation pour qu'AnnotationCacheOperationSource puisse la trouver.

- Obtenir toutes les listes CacheOperation via CacheOperationSource # 🎜 🎜#S'il y a une annotation @CacheEvict et qu'elle est marquée pour être exécutée avant l'appel, supprimez/effacez le cache

- S'il y a une annotation @Cacheable, interrogez le cache #🎜 🎜#

- Si le cache manque (le résultat de la requête est nul), il sera ajouté à cachePutRequests et le cache sera écrit dans le cache après l'exécution ultérieure de l'original method

- #🎜 🎜#

Lorsque le cache arrive, utilisez la valeur du cache comme résultat ; lorsque le cache manque ou est annoté avec @CachePut, vous devez appeler la méthode d'origine et utiliser la valeur de retour de la méthode d'origine comme résultat

#🎜 🎜# - S'il y a une annotation @CachePut, elle sera ajoutée à cachePutRequests#🎜 🎜# Si le cache manque, la valeur du résultat de la requête sera écrite dans le cache ; s'il y a une annotation @CachePut, écrit également le résultat de l'exécution de la méthode dans le cache

- # 🎜🎜#S'il y a une annotation @CacheEvict et qu'elle est marquée pour être exécutée après l'appel, supprimez/videz le cache# 🎜🎜#

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Comment Springboot intègre Jasypt pour implémenter le chiffrement des fichiers de configuration

Jun 01, 2023 am 08:55 AM

Comment Springboot intègre Jasypt pour implémenter le chiffrement des fichiers de configuration

Jun 01, 2023 am 08:55 AM

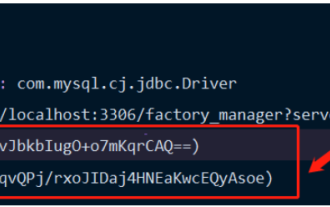

Introduction à Jasypt Jasypt est une bibliothèque Java qui permet à un développeur d'ajouter des fonctionnalités de chiffrement de base à son projet avec un minimum d'effort et ne nécessite pas une compréhension approfondie du fonctionnement du chiffrement. Haute sécurité pour le chiffrement unidirectionnel et bidirectionnel. technologie de cryptage basée sur des normes. Cryptez les mots de passe, le texte, les chiffres, les binaires... Convient pour l'intégration dans des applications basées sur Spring, API ouverte, pour une utilisation avec n'importe quel fournisseur JCE... Ajoutez la dépendance suivante : com.github.ulisesbocchiojasypt-spring-boot-starter2 1.1. Les avantages de Jasypt protègent la sécurité de notre système. Même en cas de fuite du code, la source de données peut être garantie.

Comment SpringBoot intègre Redisson pour implémenter la file d'attente différée

May 30, 2023 pm 02:40 PM

Comment SpringBoot intègre Redisson pour implémenter la file d'attente différée

May 30, 2023 pm 02:40 PM

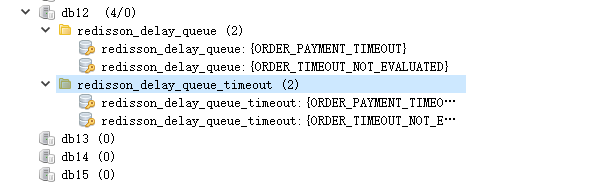

Scénario d'utilisation 1. La commande a été passée avec succès mais le paiement n'a pas été effectué dans les 30 minutes. Le paiement a expiré et la commande a été automatiquement annulée 2. La commande a été signée et aucune évaluation n'a été effectuée pendant 7 jours après la signature. Si la commande expire et n'est pas évaluée, le système donne par défaut une note positive. 3. La commande est passée avec succès. Si le commerçant ne reçoit pas la commande pendant 5 minutes, la commande est annulée. 4. Le délai de livraison expire et. un rappel par SMS est envoyé... Pour les scénarios avec des délais longs et de faibles performances en temps réel, nous pouvons utiliser la planification des tâches pour effectuer un traitement d'interrogation régulier. Par exemple : xxl-job Aujourd'hui, nous allons choisir

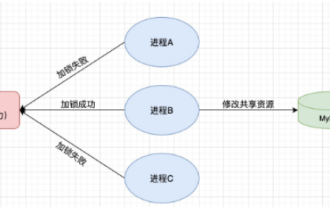

Comment utiliser Redis pour implémenter des verrous distribués dans SpringBoot

Jun 03, 2023 am 08:16 AM

Comment utiliser Redis pour implémenter des verrous distribués dans SpringBoot

Jun 03, 2023 am 08:16 AM

1. Redis implémente le principe du verrouillage distribué et pourquoi les verrous distribués sont nécessaires. Avant de parler de verrous distribués, il est nécessaire d'expliquer pourquoi les verrous distribués sont nécessaires. Le contraire des verrous distribués est le verrouillage autonome. Lorsque nous écrivons des programmes multithreads, nous évitons les problèmes de données causés par l'utilisation d'une variable partagée en même temps. Nous utilisons généralement un verrou pour exclure mutuellement les variables partagées afin de garantir l'exactitude de celles-ci. les variables partagées. Son champ d’utilisation est dans le même processus. S’il existe plusieurs processus qui doivent exploiter une ressource partagée en même temps, comment peuvent-ils s’exclure mutuellement ? Les applications métier d'aujourd'hui sont généralement une architecture de microservices, ce qui signifie également qu'une application déploiera plusieurs processus si plusieurs processus doivent modifier la même ligne d'enregistrements dans MySQL, afin d'éviter les données sales causées par des opérations dans le désordre, les besoins de distribution. à introduire à ce moment-là. Le style est verrouillé. Vous voulez marquer des points

Comment résoudre le problème selon lequel Springboot ne peut pas accéder au fichier après l'avoir lu dans un package jar

Jun 03, 2023 pm 04:38 PM

Comment résoudre le problème selon lequel Springboot ne peut pas accéder au fichier après l'avoir lu dans un package jar

Jun 03, 2023 pm 04:38 PM

Springboot lit le fichier, mais ne peut pas accéder au dernier développement après l'avoir empaqueté dans un package jar. Il existe une situation dans laquelle Springboot ne peut pas lire le fichier après l'avoir empaqueté dans un package jar. La raison en est qu'après l'empaquetage, le chemin virtuel du fichier. n’est pas valide et n’est accessible que via le flux Read. Le fichier se trouve sous les ressources publicvoidtest(){Listnames=newArrayList();InputStreamReaderread=null;try{ClassPathResourceresource=newClassPathResource("name.txt");Input

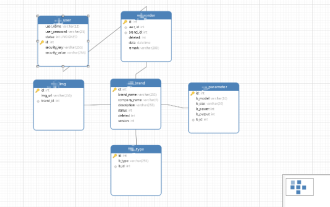

Comment implémenter Springboot+Mybatis-plus sans utiliser d'instructions SQL pour ajouter plusieurs tables

Jun 02, 2023 am 11:07 AM

Comment implémenter Springboot+Mybatis-plus sans utiliser d'instructions SQL pour ajouter plusieurs tables

Jun 02, 2023 am 11:07 AM

Lorsque Springboot+Mybatis-plus n'utilise pas d'instructions SQL pour effectuer des opérations d'ajout de plusieurs tables, les problèmes que j'ai rencontrés sont décomposés en simulant la réflexion dans l'environnement de test : Créez un objet BrandDTO avec des paramètres pour simuler le passage des paramètres en arrière-plan. qu'il est extrêmement difficile d'effectuer des opérations multi-tables dans Mybatis-plus. Si vous n'utilisez pas d'outils tels que Mybatis-plus-join, vous pouvez uniquement configurer le fichier Mapper.xml correspondant et configurer le ResultMap malodorant et long, puis. écrivez l'instruction SQL correspondante Bien que cette méthode semble lourde, elle est très flexible et nous permet de

Comparaison et analyse des différences entre SpringBoot et SpringMVC

Dec 29, 2023 am 11:02 AM

Comparaison et analyse des différences entre SpringBoot et SpringMVC

Dec 29, 2023 am 11:02 AM

SpringBoot et SpringMVC sont tous deux des frameworks couramment utilisés dans le développement Java, mais il existe des différences évidentes entre eux. Cet article explorera les fonctionnalités et les utilisations de ces deux frameworks et comparera leurs différences. Tout d’abord, découvrons SpringBoot. SpringBoot a été développé par l'équipe Pivotal pour simplifier la création et le déploiement d'applications basées sur le framework Spring. Il fournit un moyen rapide et léger de créer des fichiers exécutables autonomes.

Comment SpringBoot personnalise Redis pour implémenter la sérialisation du cache

Jun 03, 2023 am 11:32 AM

Comment SpringBoot personnalise Redis pour implémenter la sérialisation du cache

Jun 03, 2023 am 11:32 AM

1. Personnalisez RedisTemplate1.1, mécanisme de sérialisation par défaut RedisAPI. L'implémentation du cache Redis basée sur l'API utilise le modèle RedisTemplate pour les opérations de mise en cache des données. Ici, ouvrez la classe RedisTemplate et affichez les informations sur le code source de la classe. Déclarer la clé, diverses méthodes de sérialisation de la valeur, la valeur initiale est vide @NullableprivateRedisSe

Comment obtenir la valeur dans application.yml au Springboot

Jun 03, 2023 pm 06:43 PM

Comment obtenir la valeur dans application.yml au Springboot

Jun 03, 2023 pm 06:43 PM

Dans les projets, certaines informations de configuration sont souvent nécessaires. Ces informations peuvent avoir des configurations différentes dans l'environnement de test et dans l'environnement de production, et peuvent devoir être modifiées ultérieurement en fonction des conditions commerciales réelles. Nous ne pouvons pas coder en dur ces configurations dans le code. Il est préférable de les écrire dans le fichier de configuration. Par exemple, vous pouvez écrire ces informations dans le fichier application.yml. Alors, comment obtenir ou utiliser cette adresse dans le code ? Il existe 2 méthodes. Méthode 1 : Nous pouvons obtenir la valeur correspondant à la clé dans le fichier de configuration (application.yml) via le ${key} annoté avec @Value. Cette méthode convient aux situations où il y a relativement peu de microservices. Méthode 2 : En réalité. projets, Quand les affaires sont compliquées, la logique