Comment construire un arbre de décision en Python

Arbres de décision

Les arbres de décision font partie intégrante des méthodes d'apprentissage supervisé les plus puissantes disponibles aujourd'hui. Un arbre de décision est essentiellement un organigramme d'un arbre binaire dans lequel chaque nœud divise un ensemble d'observations en fonction d'une variable caractéristique.

Le but d'un arbre de décision est de diviser les données en groupes de telle sorte que chaque élément d'un groupe appartient à la même catégorie. Les arbres de décision peuvent également être utilisés pour approximer des variables cibles continues. Dans ce cas, l’arbre sera divisé de telle sorte que chaque groupe ait la plus petite erreur quadratique moyenne.

Une propriété importante des arbres de décision est qu'ils sont facilement interprétables. Vous n'avez pas du tout besoin d'être familier avec les techniques d'apprentissage automatique pour comprendre ce que font les arbres de décision. Les diagrammes d’arbre de décision sont faciles à interpréter.

Avantages et inconvénients

Les avantages de la méthode de l'arbre de décision sont :

Les arbres de décision peuvent générer des règles compréhensibles.

Les arbres de décision effectuent une classification sans nécessiter beaucoup de calculs.

Les arbres de décision peuvent gérer à la fois des variables continues et catégorielles.

Les arbres de décision fournissent une indication claire quels champs sont les plus importants.

Les inconvénients de la méthode de l'arbre de décision sont :

Les arbres de décision ne sont pas très adaptés aux tâches d'estimation où le but est de prédire des valeurs d'attributs continues.

Les arbres de décision sont sujets à des erreurs dans les problèmes de classification avec de nombreuses classes et peu d'échantillons de formation.

La formation des arbres de décision peut être coûteuse en termes de calcul. Le processus de génération d’arbres de décision est très coûteux en termes de calcul. À chaque nœud, chaque champ de division candidat doit être trié pour trouver sa meilleure division. Dans certains algorithmes, utilisant des combinaisons de champs, il faut rechercher la meilleure combinaison de poids. Les algorithmes d’élagage peuvent également être coûteux car de nombreux sous-arbres candidats doivent être formés et comparés.

Python Decision Tree

Python est un langage de programmation à usage général qui fournit de puissants packages et outils d'apprentissage automatique pour les scientifiques des données. Dans cet article, nous utiliserons scikit-learn, le package d'apprentissage automatique le plus célèbre de Python, pour créer un modèle d'arbre de décision. Nous allons créer le modèle à l'aide de l'algorithme "DecisionTreeClassifier" fourni par scikit learn puis visualiser le modèle à l'aide de la fonction "plot_tree".

Étape 1 : Importer le package

Les principaux logiciels que nous utilisons pour construire le modèle sont pandas, scikit learn et NumPy. Suivez le code pour importer les packages requis en python.

import pandas as pd # 数据处理 import numpy as np # 使用数组 import matplotlib.pyplot as plt # 可视化 from matplotlib import rcParams # 图大小 from termcolor import colored as cl # 文本自定义 from sklearn.tree import DecisionTreeClassifier as dtc # 树算法 from sklearn.model_selection import train_test_split # 拆分数据 from sklearn.metrics import accuracy_score # 模型准确度 from sklearn.tree import plot_tree # 树图 rcParams['figure.figsize'] = (25, 20)

Après avoir importé tous les packages nécessaires à la construction de notre modèle, il est temps d'importer les données et d'effectuer une EDA dessus.

Étape 2 : Importer des données et EDA

Dans cette étape, nous utiliserons le package "Pandas" fourni en python pour importer et faire de l'EDA dessus. Nous construirons notre modèle d'arbre de décision sur un ensemble de données de médicaments prescrits aux patients en fonction de critères spécifiques. Importons les données en utilisant Python !

Implémentation Python :

df = pd.read_csv('drug.csv') df.drop('Unnamed: 0', axis = 1, inplace = True) print(cl(df.head(), attrs = ['bold']))Sortie :

Age Sex BP Cholesterol Na_to_K Drug 0 23 F HIGH HIGH 25.355 drugY 1 47 M LOW HIGH 13.093 drugC 2 47 M LOW HIGH 10.114 drugC 3 28 F NORMAL HIGH 7.798 drugX 4 61 F LOW HIGH 18.043 drugY

Maintenant, nous avons une idée claire de l'ensemble de données. Après avoir importé les données, utilisons la fonction "info" pour obtenir des informations de base sur les données. Les informations fournies par cette fonction incluent le nombre d'entrées, le numéro d'index, le nom de la colonne, le nombre de valeurs non nulles, le type d'attribut, etc.

Implémentation Python :

df.info()

Sortie :

<class> RangeIndex: 200 entries, 0 to 199 Data columns (total 6 columns): # Column Non-Null Count Dtype --- ------ -------------- ----- 0 Age 200 non-null int64 1 Sex 200 non-null object 2 BP 200 non-null object 3 Cholesterol 200 non-null object 4 Na_to_K 200 non-null float64 5 Drug 200 non-null object dtypes: float64(1), int64(1), object(4) memory usage: 9.5+ KB</class>

Étape 3 : Traitement des données

Nous pouvons voir que des attributs tels que le sexe, la tension artérielle et le cholestérol sont de nature catégorielle et de type objet. Le problème est que l'algorithme d'arbre de décision dans scikit-learn ne prend pas en charge, par nature, les variables X (caractéristiques) étant de type « objet ». Il est donc nécessaire de convertir ces valeurs « objets » en valeurs « binaires ». Utilisons python pour implémenter

Implémentation Python :

for i in df.Sex.values: if i == 'M': df.Sex.replace(i, 0, inplace = True) else: df.Sex.replace(i, 1, inplace = True) for i in df.BP.values: if i == 'LOW': df.BP.replace(i, 0, inplace = True) elif i == 'NORMAL': df.BP.replace(i, 1, inplace = True) elif i == 'HIGH': df.BP.replace(i, 2, inplace = True) for i in df.Cholesterol.values: if i == 'LOW': df.Cholesterol.replace(i, 0, inplace = True) else: df.Cholesterol.replace(i, 1, inplace = True) print(cl(df, attrs = ['bold']))

Sortie :

Age Sex BP Cholesterol Na_to_K Drug 0 23 1 2 1 25.355 drugY 1 47 1 0 1 13.093 drugC 2 47 1 0 1 10.114 drugC 3 28 1 1 1 7.798 drugX 4 61 1 0 1 18.043 drugY .. ... ... .. ... ... ... 195 56 1 0 1 11.567 drugC 196 16 1 0 1 12.006 drugC 197 52 1 1 1 9.894 drugX 198 23 1 1 1 14.020 drugX 199 40 1 0 1 11.349 drugX [200 rows x 6 columns]

Nous pouvons observer que toutes les valeurs « objet » sont traitées en valeurs « binaires » pour représenter des données catégorielles. Par exemple, dans l'attribut cholestérol, les valeurs indiquant « faible » sont traitées comme 0 et les valeurs « élevées » sont traitées comme 1. Nous sommes maintenant prêts à créer les variables dépendantes et indépendantes à partir des données.

Étape 4 : Divisez les données

Après avoir traité nos données dans la structure correcte, nous configurons maintenant la variable "X" (variable indépendante), la variable "Y" (variable dépendante). Implémentons-le en python

Implémentation Python :

X_var = df[['Sex', 'BP', 'Age', 'Cholesterol', 'Na_to_K']].values # 自变量 y_var = df['Drug'].values # 因变量 print(cl('X variable samples : {}'.format(X_var[:5]), attrs = ['bold'])) print(cl('Y variable samples : {}'.format(y_var[:5]), attrs = ['bold']))Sortie :

X variable samples : [[ 1. 2. 23. 1. 25.355] [ 1. 0. 47. 1. 13.093] [ 1. 0. 47. 1. 10.114] [ 1. 1. 28. 1. 7.798] [ 1. 0. 61. 1. 18.043]] Y variable samples : ['drugY' 'drugC' 'drugC' 'drugX' 'drugY']

Nous pouvons maintenant utiliser l'algorithme « train_test_split » dans scikit learn pour diviser les données en un ensemble d'entraînement et un ensemble de test, qui contiennent le X et Oui, nous avons défini la variable. Suivez le code pour diviser les données en python.

Implémentation Python :

X_train, X_test, y_train, y_test = train_test_split(X_var, y_var, test_size = 0.2, random_state = 0) print(cl('X_train shape : {}'.format(X_train.shape), attrs = ['bold'], color = 'black')) print(cl('X_test shape : {}'.format(X_test.shape), attrs = ['bold'], color = 'black')) print(cl('y_train shape : {}'.format(y_train.shape), attrs = ['bold'], color = 'black')) print(cl('y_test shape : {}'.format(y_test.shape), attrs = ['bold'], color = 'black'))Sortie :

X_train shape : (160, 5) X_test shape : (40, 5) y_train shape : (160,) y_test shape : (40,)

Nous avons maintenant tous les composants pour construire un modèle d'arbre de décision. Alors, allons-y et construisons notre modèle en python.

Étape 5 : Construire un modèle et une prédiction

Avec l'aide de l'algorithme "DecisionTreeClassifier" fourni par le package scikit-learn, il est possible de construire un arbre de décision. Ensuite, nous pouvons utiliser notre modèle entraîné pour prédire nos données. Enfin, la précision de nos résultats de prédiction peut être calculée à l'aide de la métrique d'évaluation « Précision ». Utilisons Python pour terminer ce processus !

Implémentation de Python :

model = dtc(criterion = 'entropy', max_depth = 4) model.fit(X_train, y_train) pred_model = model.predict(X_test) print(cl('Accuracy of the model is {:.0%}'.format(accuracy_score(y_test, pred_model)), attrs = ['bold']))Sortie :

Accuracy of the model is 88%

在代码的第一步中,我们定义了一个名为“model”变量的变量,我们在其中存储DecisionTreeClassifier模型。接下来,我们将使用我们的训练集对模型进行拟合和训练。之后,我们定义了一个变量,称为“pred_model”变量,其中我们将模型预测的所有值存储在数据上。最后,我们计算了我们的预测值与实际值的精度,其准确率为88%。

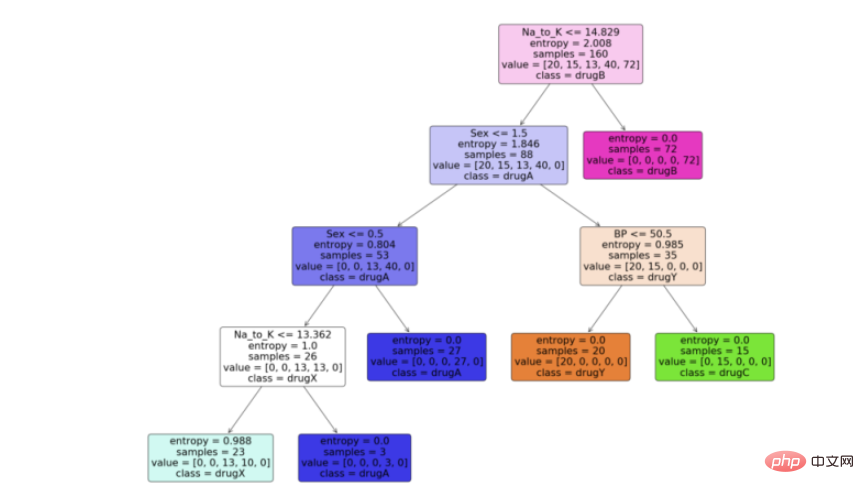

步骤6:可视化模型

现在我们有了决策树模型,让我们利用python中scikit learn包提供的“plot_tree”函数来可视化它。按照代码从python中的决策树模型生成一个漂亮的树图。

Python实现:

feature_names = df.columns[:5] target_names = df['Drug'].unique().tolist() plot_tree(model, feature_names = feature_names, class_names = target_names, filled = True, rounded = True) plt.savefig('tree_visualization.png')输出:

结论

有很多技术和其他算法用于优化决策树和避免过拟合,比如剪枝。虽然决策树通常是不稳定的,这意味着数据的微小变化会导致最优树结构的巨大变化,但其简单性使其成为广泛应用的有力候选。在神经网络流行之前,决策树是机器学习中最先进的算法。其他一些集成模型,比如随机森林模型,比普通决策树模型更强大。

决策树由于其简单性和可解释性而非常强大。决策树和随机森林在用户注册建模、信用评分、故障预测、医疗诊断等领域有着广泛的应用。我为本文提供了完整的代码。

完整代码:

import pandas as pd # 数据处理 import numpy as np # 使用数组 import matplotlib.pyplot as plt # 可视化 from matplotlib import rcParams # 图大小 from termcolor import colored as cl # 文本自定义 from sklearn.tree import DecisionTreeClassifier as dtc # 树算法 from sklearn.model_selection import train_test_split # 拆分数据 from sklearn.metrics import accuracy_score # 模型准确度 from sklearn.tree import plot_tree # 树图 rcParams['figure.figsize'] = (25, 20) df = pd.read_csv('drug.csv') df.drop('Unnamed: 0', axis = 1, inplace = True) print(cl(df.head(), attrs = ['bold'])) df.info() for i in df.Sex.values: if i == 'M': df.Sex.replace(i, 0, inplace = True) else: df.Sex.replace(i, 1, inplace = True) for i in df.BP.values: if i == 'LOW': df.BP.replace(i, 0, inplace = True) elif i == 'NORMAL': df.BP.replace(i, 1, inplace = True) elif i == 'HIGH': df.BP.replace(i, 2, inplace = True) for i in df.Cholesterol.values: if i == 'LOW': df.Cholesterol.replace(i, 0, inplace = True) else: df.Cholesterol.replace(i, 1, inplace = True) print(cl(df, attrs = ['bold'])) X_var = df[['Sex', 'BP', 'Age', 'Cholesterol', 'Na_to_K']].values # 自变量 y_var = df['Drug'].values # 因变量 print(cl('X variable samples : {}'.format(X_var[:5]), attrs = ['bold'])) print(cl('Y variable samples : {}'.format(y_var[:5]), attrs = ['bold'])) X_train, X_test, y_train, y_test = train_test_split(X_var, y_var, test_size = 0.2, random_state = 0) print(cl('X_train shape : {}'.format(X_train.shape), attrs = ['bold'], color = 'red')) print(cl('X_test shape : {}'.format(X_test.shape), attrs = ['bold'], color = 'red')) print(cl('y_train shape : {}'.format(y_train.shape), attrs = ['bold'], color = 'green')) print(cl('y_test shape : {}'.format(y_test.shape), attrs = ['bold'], color = 'green')) model = dtc(criterion = 'entropy', max_depth = 4) model.fit(X_train, y_train) pred_model = model.predict(X_test) print(cl('Accuracy of the model is {:.0%}'.format(accuracy_score(y_test, pred_model)), attrs = ['bold'])) feature_names = df.columns[:5] target_names = df['Drug'].unique().tolist() plot_tree(model, feature_names = feature_names, class_names = target_names, filled = True, rounded = True) plt.savefig('tree_visualization.png')Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

Video Face Swap

Échangez les visages dans n'importe quelle vidéo sans effort grâce à notre outil d'échange de visage AI entièrement gratuit !

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Sujets chauds

1393

1393

52

52

1205

1205

24

24

PHP et Python: différents paradigmes expliqués

Apr 18, 2025 am 12:26 AM

PHP et Python: différents paradigmes expliqués

Apr 18, 2025 am 12:26 AM

PHP est principalement la programmation procédurale, mais prend également en charge la programmation orientée objet (POO); Python prend en charge une variété de paradigmes, y compris la POO, la programmation fonctionnelle et procédurale. PHP convient au développement Web, et Python convient à une variété d'applications telles que l'analyse des données et l'apprentissage automatique.

Choisir entre PHP et Python: un guide

Apr 18, 2025 am 12:24 AM

Choisir entre PHP et Python: un guide

Apr 18, 2025 am 12:24 AM

PHP convient au développement Web et au prototypage rapide, et Python convient à la science des données et à l'apprentissage automatique. 1.Php est utilisé pour le développement Web dynamique, avec une syntaxe simple et adapté pour un développement rapide. 2. Python a une syntaxe concise, convient à plusieurs champs et a un écosystème de bibliothèque solide.

Le code Visual Studio peut-il être utilisé dans Python

Apr 15, 2025 pm 08:18 PM

Le code Visual Studio peut-il être utilisé dans Python

Apr 15, 2025 pm 08:18 PM

VS Code peut être utilisé pour écrire Python et fournit de nombreuses fonctionnalités qui en font un outil idéal pour développer des applications Python. Il permet aux utilisateurs de: installer des extensions Python pour obtenir des fonctions telles que la réalisation du code, la mise en évidence de la syntaxe et le débogage. Utilisez le débogueur pour suivre le code étape par étape, trouver et corriger les erreurs. Intégrez Git pour le contrôle de version. Utilisez des outils de mise en forme de code pour maintenir la cohérence du code. Utilisez l'outil de liaison pour repérer les problèmes potentiels à l'avance.

Peut-on exécuter le code sous Windows 8

Apr 15, 2025 pm 07:24 PM

Peut-on exécuter le code sous Windows 8

Apr 15, 2025 pm 07:24 PM

VS Code peut fonctionner sur Windows 8, mais l'expérience peut ne pas être excellente. Assurez-vous d'abord que le système a été mis à jour sur le dernier correctif, puis téléchargez le package d'installation VS Code qui correspond à l'architecture du système et l'installez comme invité. Après l'installation, sachez que certaines extensions peuvent être incompatibles avec Windows 8 et doivent rechercher des extensions alternatives ou utiliser de nouveaux systèmes Windows dans une machine virtuelle. Installez les extensions nécessaires pour vérifier si elles fonctionnent correctement. Bien que le code VS soit possible sur Windows 8, il est recommandé de passer à un système Windows plus récent pour une meilleure expérience de développement et une meilleure sécurité.

L'extension VScode est-elle malveillante?

Apr 15, 2025 pm 07:57 PM

L'extension VScode est-elle malveillante?

Apr 15, 2025 pm 07:57 PM

Les extensions de code vs posent des risques malveillants, tels que la cachette de code malveillant, l'exploitation des vulnérabilités et la masturbation comme des extensions légitimes. Les méthodes pour identifier les extensions malveillantes comprennent: la vérification des éditeurs, la lecture des commentaires, la vérification du code et l'installation avec prudence. Les mesures de sécurité comprennent également: la sensibilisation à la sécurité, les bonnes habitudes, les mises à jour régulières et les logiciels antivirus.

Python vs JavaScript: la courbe d'apprentissage et la facilité d'utilisation

Apr 16, 2025 am 12:12 AM

Python vs JavaScript: la courbe d'apprentissage et la facilité d'utilisation

Apr 16, 2025 am 12:12 AM

Python convient plus aux débutants, avec une courbe d'apprentissage en douceur et une syntaxe concise; JavaScript convient au développement frontal, avec une courbe d'apprentissage abrupte et une syntaxe flexible. 1. La syntaxe Python est intuitive et adaptée à la science des données et au développement back-end. 2. JavaScript est flexible et largement utilisé dans la programmation frontale et côté serveur.

PHP et Python: une plongée profonde dans leur histoire

Apr 18, 2025 am 12:25 AM

PHP et Python: une plongée profonde dans leur histoire

Apr 18, 2025 am 12:25 AM

PHP est originaire en 1994 et a été développé par Rasmuslerdorf. Il a été utilisé à l'origine pour suivre les visiteurs du site Web et a progressivement évolué en un langage de script côté serveur et a été largement utilisé dans le développement Web. Python a été développé par Guidovan Rossum à la fin des années 1980 et a été publié pour la première fois en 1991. Il met l'accent sur la lisibilité et la simplicité du code, et convient à l'informatique scientifique, à l'analyse des données et à d'autres domaines.

Comment exécuter des programmes dans Terminal Vscode

Apr 15, 2025 pm 06:42 PM

Comment exécuter des programmes dans Terminal Vscode

Apr 15, 2025 pm 06:42 PM

Dans VS Code, vous pouvez exécuter le programme dans le terminal via les étapes suivantes: Préparez le code et ouvrez le terminal intégré pour vous assurer que le répertoire de code est cohérent avec le répertoire de travail du terminal. Sélectionnez la commande Run en fonction du langage de programmation (tel que Python de Python your_file_name.py) pour vérifier s'il s'exécute avec succès et résoudre les erreurs. Utilisez le débogueur pour améliorer l'efficacité du débogage.